基于互信息的多模态医学图像融合

2016-07-22李加恒戴文战李俊峰

李加恒,戴文战,李俊峰

(1.浙江理工大学自动化研究所,杭州 310012; 2.浙江工商大学信息与电子工程学院,杭州 310012)

基于互信息的多模态医学图像融合

李加恒1,戴文战2,李俊峰1

(1.浙江理工大学自动化研究所,杭州 310012; 2.浙江工商大学信息与电子工程学院,杭州 310012)

摘要:目前已知的医学图像融合算法未充分考虑源图像间差异性的大小,针对该不足提出了一种基于互信息特征的多模态融合算法。算法引入提升小波变换,将目标图像分解为高、低频子带,根据高频子带的互信息量不同,对低互信息子带采用区域梯度能量与区域标准差相结合的融合规则,对高互信息子带采用边缘强度取大的融合规则。通过多组目标图像融合对比的实验进行验证,算法融合得到的图像信息丰富,边缘清晰,具有良好的视觉特性和优秀的评价指标。

关键词:医学图像融合;提升小波变换;互信息;区域梯度能量;区域标准差

0引言

医学图像融合是一种将多源信道采集的图像进行科学融合,从而得到高质量图像的方法,对临床医学诊断具有重要意义。CT、MRI、PETCT等先进的医学成像设备广泛应用于临床诊断中[1-2]。由于成像原理的差异,不同设备呈现的医学图像具有各自的特点。例如,CT图像主要用来反映密度较大的组织,如骨骼;MRI图像主要用来反映密度较小的组织,如血管、软组织等;SPECT图像主要用来定位病变组织的位置和程度[3]。为了弥补由于单一模式图像成像机理不同造成的图像信息缺失,需要进行多模态医学图像的融合,以实现优势互补,帮助医生对疾病准确、快速地诊断和治疗。

近年来,小波多尺度分解在医学图像融合领域得到了大量应用。Kavitha等[4]提出的基于传统小波变换的医学图像融合,但是小波运算较为复杂、处理速度较慢,需要大量的存储空间。Liu等[5]采用图像锐度和互信息相结合后加权的融合算法,但是图像的锐度反映的是图像的“清晰度”,对于两张较模糊的医学源图像进行融合,融合效果不令人满意。Tian等[6]采用基于边缘信息的小波医学图像融合算法,采用选取边缘强度阈值的算法,但是对于源图像差异较大的图像组,图像间互信息较小时,融合效果并不理想。王昕等[7]采用低频分量取大、高频分量梯度能量比加权的算法,虽然高频保留了图像的大部分细节信息,但是忽视了低频子带中的大部分信息,对于高互信息的源图像,在一定程度上削弱了梯度能量比加权的作用效果[8]。林卉等[9]采用方向对比度方法,虽该方案更加符合人的生理视觉,但是牺牲了某些真实有用信息,无法提高准确性。

本文在基于提升小波变换的基础上[10],引入互信息原理,提出了基于互信息特征的医学图像融合新算法。通过互信息量将高频子带进行区分:互信息量低的高频子带,说明同位置的区域纹理相差较大,采用区域标准差与能量梯度相结合的方法,能更好地表现出边缘化程度和更微小的细节变化;互信息量高的高频子带[11],说明同位置的区域纹理相似度较高,采用边缘强度取大的融合规则,以取得更好的融合效果。

1提升小波变换

传统的多尺度小波变换是指空间和频率的局部变换,它能够快速有效的从图像信号中获取信息。提升小波变换是在传统的小波变换基础上改进而来的,传统小波变换通常在频域中构造,而提升小波是在空域中构造,其优点是获取高频信息不需要通过复杂的卷积计算[12-13]。提升小波主要由4个步骤组成,分别为:分解、对偶提升、更新和重构[14],其流程如图1所示。图1中:ai-1矩阵为初始信号;ai和bi为初始信号剖分的两个子集;P为预测值;U为构造的算子。

图1 提升小波示意

2基于互信息特征的医学图像融合算法

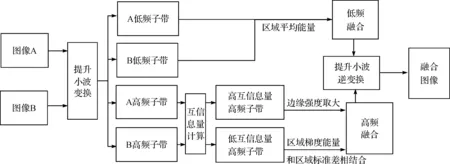

图2 医学图像融合算法流程

2.1低频区域平均能量加权融合

由于医学图像经过提升小波变换分解后,源图像的大量基础信息都在低频子带中。同时,相邻的低频子带系数间具有相关性的特性。因此,本文通过在低频子带中采用区域平均能量加权的融合规则,可以更好地保留低频子带中的信息。

低频子带系数矩阵中以(i,j)为中心及其相邻区域的均值能量表示为[18]:

(1)

式(1)中:S、H为图像区域行和列的数值,cL为低频子带的系数。

定义K(i,j)为A图像与B图像的区域均值能量差别系数,即:

(2)

(3)

(4)

2.2基于互信息的高频子带融合规则

图像的细节信息主要包含在图像的高频子带中,纹理边缘代表了图像的细节特性。通常人们对图像高频子带融合采用单一的融合算法,但是对于待融合的源图像,图像差异的大小对图像融合效果影响较大。互信息量是两张图像相似性的一种测度,可以用信息熵来计算互信息。已完成配准待融合的图像来源于不同的成像设备,两幅图像相互表达的信息量很多。根据高频子带互信息量的不同,将高频子带分为高互信息量子带和低互信息量子带[15]。

对于区域互信息量低的高频子带,说明同位置的区域纹理相差较大;互信息量值高的高频子带,说明同位置的区域纹理相似度较高。互信息量远大于0时,说明图像A与图像B关联强度强,互信息量趋近于0时,说明图像A与图像B关联强度弱。本文提出通过选定互信息阈值为25,将待融合的高频子带分为两类,分别采取不同的融合规则保证保存图像有效信息最大化。

2.2.1低互信息量高频子带融合规则

对于低互信息量高频子带,说明同位置区域都包含重要信息并区别很大。比如A图像只有少量的骨骼的纹理特征,B图像有大量的血管、肌肉等纹理特征。A与B图像间相似度较小,互信息相对较低。由于图像的局部特征通常并不是某一个像素或几个像素就能所表现出来的,它是由某一区域内多个像素共同表现出来的。图像信号变化强弱可以通过梯度能量值表示出来。区域的灰度离散情况可以通过区域的标准差体现出来[16]。本文采用基于区域梯度能量和区域标准差相结合的融合规则,不仅能保证图像的整体细节,还能保持图像的清晰度,提高融合图像的质量[17]。

定义PX为图像的区域标准差:

(5)

令∂A、∂B分别表示图像A和图像B区域标准差所占的权重,公式如下所示:

(6)

(7)

定义QX为图像的区域梯度能量:

(8)

(9)

(10)

低互信息量高频子带融合规则为

(11)

2.2.2高互信息量高频子带融合规则

区域互信息量大的高频子带,说明同位置的区域纹理相似度较高。对于含有相似的纹理特征的两高频子带,若仍采用加权的融合规则,却削弱了各图像特有的纹理信息。要使融合的图像更好的保留源图像的纹理信息,本文对于高互信息量的高频子带采用边缘强度取大的融合规则。

边缘强度的如式(12)所示:

(12)

式(12)中,f(x+m,y+n)为领域像素的灰度,窗口的大小为M×N,大小取3×3;mean(x-m:x+m,y-n:y+n)为区域均值。

分别计算出图像高互信息高频子带的边缘强度值,通过采用边缘强度取大,计算得到融合后高互信息量高频子带的系数:

(13)

3实验结果与分析

为了验证本文算法,在Matlab环境下实现本文算法。选取CT、MRI、SPECT 3种类型图像进行融合对比。根据特征的不同可分为CT/MRI图像融合、MR-T1/MR-T2图像融合和MRI/SPECT图像融合3种类型。

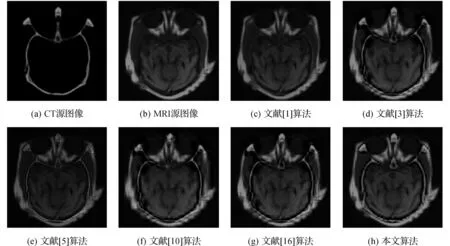

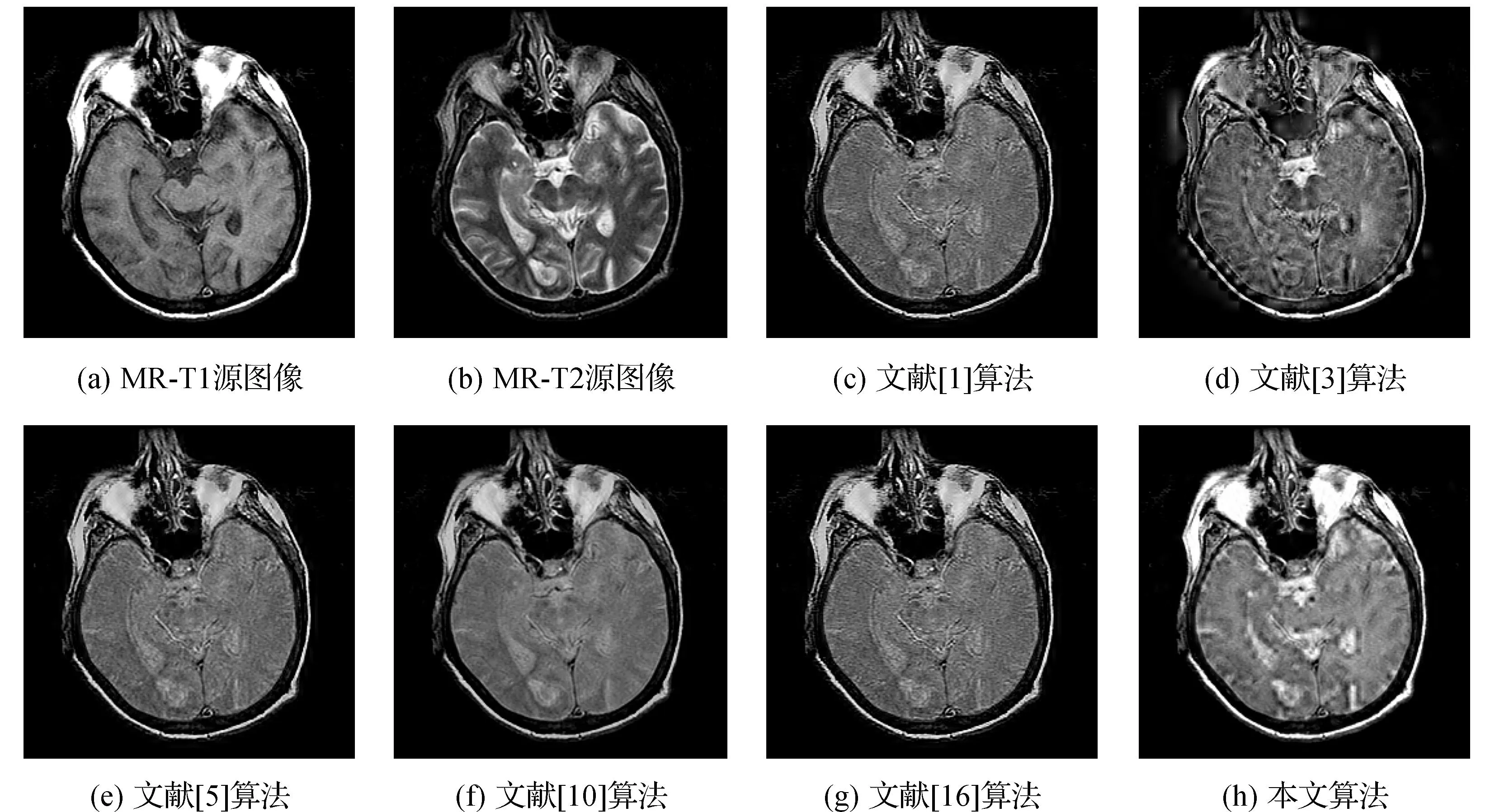

为了检测本算法的有效性,选用5组经配准后的人脑组织作为源图像。图3-图5的(c)图为文献[1]采用脉冲耦合神经网络模型的融合算法的融合图像;图3-图5的(d)图为文献[3]提出的高频部分采用结构相似度与图像边缘算子相结合的融合图像;图3-图5的(e)图为文献[5]提出的基于压缩感知的算法的融合图像;图3-图5的(f)图为文献[10]提出的平均梯度和图像熵系数加权融合图像;图3-图5的(g)图为文献[16]提出的根据高频子带中噪声含量的不同,对噪声含量较低的低层高频子带采用基于计盒分维法获取分维数,而对噪声含量较高的高层高频子带提出了基于区域梯度能量加权融合规则的融合图像;图3-图5的(h)图为本文提出的融合新算法。

3.1灰度图像融合

正常脑部CT/MRI融合图像如图3所示。急性脑卒中CT/MRI融合图像如图4所示。多发性脑梗塞MR-T1/MR-T2融合图像如图5所示。

图3 正常脑部CT/MRI医学图像融合结果

图4 急性脑卒中CT/MRI医学图像融合结果

图5 多发性脑梗塞MR-T1/MR-T2医学图像融合结果

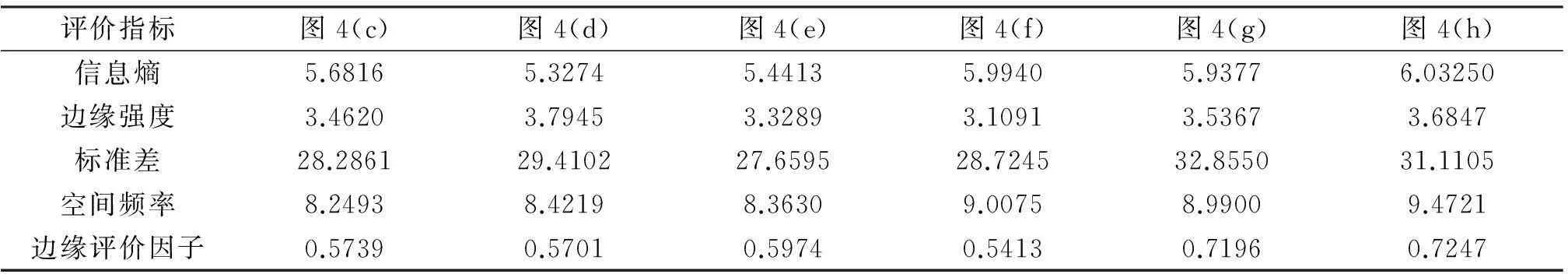

表1列出图3中正常脑部CT/MRI图像应用不同融合算法产生的医学融合的质量评价指标。表2列出图4中急性脑卒中CT/MRI图像应用不同融合算法产生的医学融合的质量评价指标。表3列出图5中多发性脑梗塞MR-T1/MR-T2图像应用不同融合算法产生的医学融合的质量评价指标。

表1 图3中应用不同融合算法产生的医学融合的质量评价

表2 图4中应用不同融合算法产生的医学融合的质量评价

表3 图5中应用不同融合算法产生的医学融合的质量评价

在图3中,相对于其它算法,本文算法融合后的图像文理清晰,不仅保留源图像较为清晰的脑部组织信息,而且骨骼的组织边缘依然明显,不同组织间差异明显;在图4(b)中,脑部右侧有较为明显的组织病变阴影,通过本文算法融合后,正常组织与病变组织在图像上有着明显差异;图5(a)和图5(b)的图像为不同时间的成像的加权像。图5(d)图像采用的融合算法虽然融合后图像的信息丰富,但是图像轮廓模糊,融合效果并不好。而采用本文算法融合的图像,亮度高,图像细节纹理明显,融合效果较好。从评价指标上看,信息熵值最好,图像边缘评价因子也较好。信息熵值越高,说明图像提取的信息越丰富,边缘评价因子越高,说明融合后的图像与源图像差异越小。从主观上还是客观数据上都可以看出图像融合质量上都较好。

通过图6(从图3截取出部分区域放大图)可以看出,本文算法得出的图像纹理信息保留得更好,边缘更加清晰,图像信息更为丰富。

图6 图3中融合图像局部区域比较

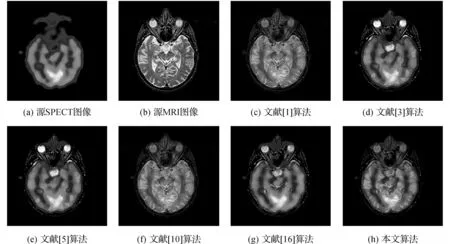

3.2彩色图像融合

彩色图像信息丰富,人眼对彩色图像分辨率远高于灰度图像,彩色图像与灰度图像进行融合同样非常重要,彩色图像与灰度图像融合过程如图7所示。实验结果如图8、图9所示。图8为正常脑部SPECT/MRI融合图像。图9为转移性脑癌脑部SPECT/MRI融合图像。

图7 MRI/SPECT图像融合流程

图8 正常脑部SPECT/MRI医学图像融合结果

图9 转移性肺癌SPECT/MRI医学图像融合结果

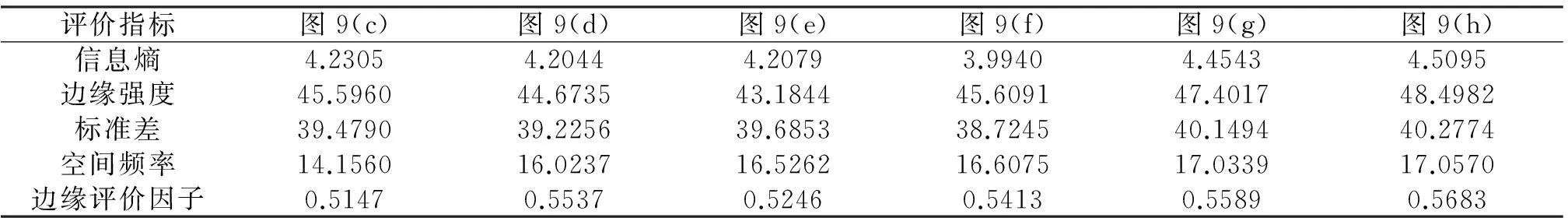

对于彩色图像的评价的最终的性能指标如表4和表5所示。

表4 图8中应用不同融合算法产生的医学图像融合的质量评价

表5 图9中应用不同融合算法产生的医学图像融合的质量评价

在图8中,相对于其它算法,本文算法融合的图像在保留了SPECT彩色图像主要信息的同时,脑部组织纹理理和头部轮廓依然表现清晰,病变组织与正常组织间差异明显;在图9中,本文算法的融合图像在视觉感官上相对于其它算法相差不多,但是从评价指标上看,本文算法在各个指标方面表现较好。综合以上实验结果,通过对比,采用本文融合算法得到的图像在空间频率和边缘强度上有所提升,表明融合图像有效保留了源图像的重要信息。基于互信息特征的选取能够使高频融合规则更加有效;在质量评价中,信息熵的提高说明融合图像所含的信息更为丰富,灰度级更为分散,对比度更好,在视觉上相比其他算法也较好。

4结语

医学图像融合在医学图像分析和诊断上具有重要的应用价值。本文重点研究了基于提升小波变换的图像融合技术。在低频子带选取上,采用基于区域平均能量加权融合规则。在高频子带系数选取上,根据高频子带区域互信息量的不同,将高频子带分为高互信息量高频子带和低互信息量高频子带,高频子带间互信息高,说明子带间差异性较小,图像纹理较为接近,通过边缘的边缘强度值取大,能够将源图像间细节边缘信息最大化得保留。高频子带间互信息小,说明子带间差异性较大,为了更好的融合图像,区域梯度能量的值体现的是图像整体亮度,区域标准差的值体现的是图像的纹理强度,采用两种方法相结合得出方法保证了图像的亮度和纹理强度间的平衡。实验结果表明:本文算法引入互信息有效提高了图像融合的质量,图像细节和评价指标较好。后续工作将对互信息类型特征进行进一步划分,更好的提升图像的融合效果。

参考文献:

[1] SINGH S, GUPTA D, ANAND R S, et al. Nonsubsampled shearlet based CT and MR medical image fusion using biologically inspired spiking neural network[J]. Biomedical Signal Processing & Control,2015,18(1):91-101.

[2] ISLAM M S, CHONG U P. Improvement in moving target detection based on hough transform and wavelet[J]. Iete Technical Review, 2015, 32(1):46-51.

[3] 江泽涛,杨阳,郭川.基于提升小波变换的图像融合改进算法的研究[J].图像与信号处理,2015,4(2):12-19.

[4] KAVITHA C T, CHELLAMUTHU C. Fusion of SPECT and MRI images using integer wavelet transform in combination with curvelet transform[J].The Imaging Science Journal,2015,63(1):17-23.

[5] LIU Z, YIN H, CHAI Y, et al. A novel approach for multimodal medical image fusion[J]. Expert Systems with Applications,2014,41(16):7425-7435.

[6] TIAN J, CHEN L. Adaptive multi-focus image fusion using a wavelet-based statistical sharpness measure[J]. Signal Processing,2012,92(9):2137-2146.

[7] 王昕,李玮琳,刘富.小波域CT/MRI医学图像融合新方法[J].吉林大学学报(工学版),2013,43(1):25-28.

[8] DAS S, KUNDU M K. NSCT-based multimodal medical image fusion using pulse-coupled neural network and modified spatial frequency[J]. Medical & Biological Engineering & Computing,2012,50(10):1105-1114.

[9] 林卉,RuiliangPu,梁亮,等.方向对比度和区域标准差相结合的图像融合[J].计算机工程与应用,2014,6(1):31-34.

[10] CHO H J, Park T H. Wavelet transform based image template matching for automatic component inspection[J]. International Journal of Advanced Manufacturing Technology,2010,50(9-12):1033-1039.

[11] ZHANG B, ZHANG C, WU J, et al. A medical image fusion method based on energy classification of BEMD components[J]. Optik - International Journal for Light and Electron Optics,2014,125(1):146-153.

[12] NICHOL J, MAN S W. Modeling urban environmental quality in a tropical city[J]. Landscape & Urban Planning,2005,73(1):49-58.

[13] XU Z H, LIAO F X, HE Z Q, et al. PET and CT cross-modality medical image fusion based on out-location frame[J]. Journal of Southern Medical University,2010,30(6):1304-1306.

[14] HIREMATH P S, AKKASALIGAR P T, BADIGER S. Visual enhancement of digital ultrasound images using multiscale wavelet domain[J]. Pattern Recognition & Image Analysis,2010,20(3):303-315.

[15] CHENG B S, CHEN H, BEATTY R E, et al. Multimodality image fusion and planning and dose delivery for radiation therapy[J]. Medical Dosimetry,2008,33(2):149-155.

[16] 李俊峰,姜晓丽,戴文战.基于提升小波变换的医学图像融合[J].中国图象图形学报,2014,19(11):1639-1648.

[17] 刘贵喜,陈文锦,刘纯虎.基于方向对比度和区域标准差的图像融合方法[J].仪器仪表学报,2005,26(6):628-631.

[18] ZHANG B, ZHANG C, LIU Y, et al. Multi-focus image fusion algorithm based on compound PCNN in Surfacel et domain[J]. Optik- International Journal for Light and Electron Optics,2014,125(1):296-300.

(责任编辑: 陈和榜)

Multi-modality Medical Image Fusion Based on Mutual Information

LIJiaheng1,DAIWenzhan2,LIJunfeng1

(1. Institute of Automation, Zhejiang Sci-Tech University, Hangzhou 310012, China; 2. School of Information and Electronic, Zhejiang Gongshang University, Hangzhou 310012, China)

Abstract:The known algorithms of medical image fusion do not consider the difference among different source images. In view of this problem, a multi-modality fusion algorithm based on mutual information was proposed. The algorithm introduces lifting wavelet transform and decomposes the target image into high frequency sub-bands and low frequency sub-bands. According to different mutual information amount of high frequency sub-bands, the fusion rule of combining local gradient energy and local standard deviation was adopted for low mutual information sub-bands, while fusion rule of bigger edge strength is applied for frequency mutual information sub-bands. Experimental results of multi-group target image fusion show the method proposed in this paper is much better because of its rich image information, clear edge, good visual features and excellent evaluation indexes.

Key words:medical image fusion; lifting wavelet transform; mutual information; local gradient energy; local standard deviation

DOI:10.3969/j.issn.1673-3851.2016.07.022

收稿日期:2015-09-19

基金项目:国家自然科学基金项目(61374022)

作者简介:李加恒(1990-),男,江苏连云港人,硕士研究生,主要从事图像处理方面的研究。

通信作者:戴文战,E-ail:dwz@zjsu.edu.cn

中图分类号:TP391

文献标志码:A

文章编号:1673- 3851 (2016) 04- 0607- 08 引用页码: 070602