基于特定韵母发音事件分析的语音唇动一致性判决方法

2020-02-12朱铮宇邱华愉杨春玲王泳

朱铮宇 邱华愉 杨春玲 王泳†

(1.华南理工大学 电子与信息学院,广东 广州 510640;2.广东技术师范大学 电子与信息学院,广东 广州 510665)

语音唇动一致性判决是通过发音过程中唇部运动与音频变化之间的联系来判断音视频是否同时录制、是否出自同一人、是否为同一句话。这是多模态信号处理领域的研究热点,在多说话人视频中的当前说话人定位[1]、身份认证中的活体检测[2]、人眼注意机制中的显著性区域检测[3]等方面有着广泛的应用。

当前,音唇一致性判决的方法主要有4类:互信息法(Mutual Information,MI)[4]、多元统计分析法(Multivariate Statistical Analysis,MSA)[5- 6]、相关系数法[7- 8]、双模态稀疏表示法[9- 10]。其中,前两类方法通过对句中的音视频对应帧特征建立不同的统计模型来分析音唇间的关联度,并以此判断两者的一致性;而相关系数法是分析句中各帧音视频特征各维间的相关系数,并以此为新特征结合分类模型等方式进行一致性判决。由于语言由音节组成,各音节的音频及口型序列会在不同语句中反复出现,稀疏表示类方法将移不变稀疏表示中原子的概念引入到表征发相同音时音唇变化存在的共性及对应关系中,通过联合字典学习无监督地训练出时空移不变的双模态字典,作为表征不同音节音唇同步变化关系的模板进行一致性判决。但现有判决方法主要对整句(段)话进行分析,并无对分析内容加以筛选或限制。如稀疏类方法对字典学习内容缺乏限制,使得原子表征范围过大且数量庞大,并出现无意义原子(如噪声、静音),导致字典学习及一致性分析过程繁琐。实际上,句子各部分的重要性有所不同,由统计类算法求音唇相关度,会发现静音、噪音及部分辅音等嘴型变化不明显的片段,由于音频幅度和唇宽高的正比关联性[11],其音唇关联度并不显著,为弱相关片段,这类似于噪声成分会给一致性分析带来一定影响。汉语由声母、韵母加声调构成。其中,韵母发音时长最长,音频能量高于声母,即使搭配不同声母,韵母的唇动规律也非常稳定[12],是句中具有代表性的成分。但汉语39个韵母的音唇相关度是否也具有一定差异性,它们之中是否存在更有代表性的发音单元,却少有文献报道。同时,现有一致性评分机制往往忽略了两者在自然时延上的差异,而时延在一致性分析中的重要性逐渐受到关注[13]。

因此,本研究以汉语韵母为研究重心,寻求以更具代表性的特定韵母单元为分析对象,代替整句分析实现一致性判决,提出基于特定韵母发音事件分析的音唇一致性判决方法。先根据多帧口型序列特征对韵母进行聚类,再对各类韵母的音唇相关度进行分析,选出更具代表性的韵母发音单元。在一致性判决时,先分割并识别出选定的韵母单元,求出这些韵母事件的音唇相关度,并对各韵母出现位置的时延分布进行评分,提出特定韵母发音事件音唇相关度得分与位置时延分析评分相融合的一致性评分机制,由融合后的最终得分判断一致性。

1 特定发音单元音唇关联性分析

1.1 韵母动态视素聚类

不同韵母虽在发音机理和听觉上会有所差异,但部分韵母发音时口型的变化过程相似,因此分析音唇关联度前先根据口型对韵母进行归类。现有的发音口型聚类多数是以唇形关键帧的静态视位为特征,但口型变化是连贯的动态过程,单帧静态视位所能提供的信息量有限,为此引入动态视位的概念,利用多帧特征组合而成的超向量,通过凝聚法的层次聚类方式[14]对口型序列进行聚类分析。聚类过程中利用类间距离最小的原则将各类两两合并,而类间距离以欧氏距离衡量。设某一唇部特征的样本矩阵G∈RM×F包含F个待分类动态口型序列样本,每个样本gn(n=1,2,…,F)为M维的唇部特征超向量,唇形层次聚类的步骤如下。

(1)将待分类样本集G的每行视为一类,则共有F类,计算F类中两两之间的欧式距离并组成距离矩阵O,矩阵各元素为

(1)

(3)重新计算新类与各旧类之间的欧氏距离,即通过式(1)更新矩阵O中对应位置的元素,将矩阵O中之前与k和j相关的行列删除,加入与新类相关的行和列。

(4)重复步骤(1)-(3)直到所有对象合并为一类停止。

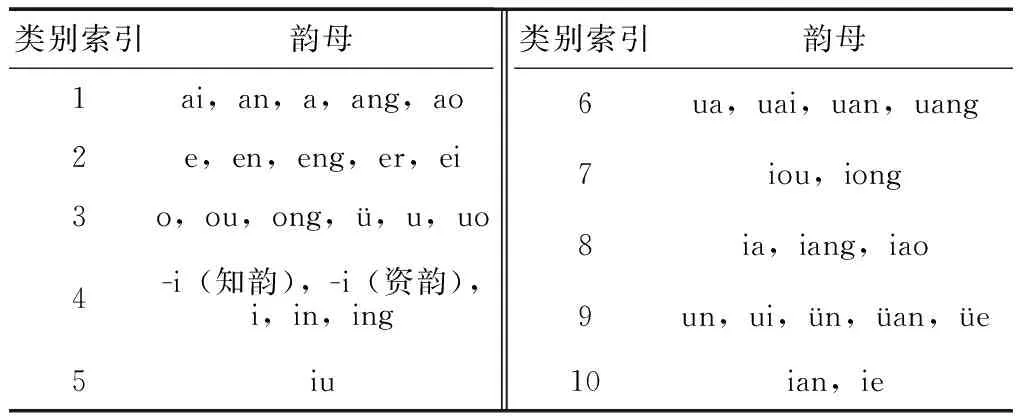

逐次合并项的索引可得描述聚类过程的聚类树,最终分类数量可根据树结构从枝叶节点向根节点方向回溯,并由XiE-Beni指标确定最有效的聚类结果[15]。唇型数据取自公开数据库——汉语听觉视觉双模态语料库,提取各人(共20人)各韵母发音序列的单帧口型特征参数。唇型特征的选取如图1所示,Ld(d=1,2,…,8)为各对应点间的连线距离,加上唇面积可得9维的唇部几何特征。对选取的韵母视频序列进行尺寸和时间归一化,使得各韵母帧数统一为10帧,再拼接成90维的长时特征。为减少个体发音差异的影响,通过统计各人各韵母的数据,得到所有人同一韵母口型特征参数的均值,并以此进行聚类,聚类结果如表1所示。

图1 唇部形状特征参数

表1 韵母聚类结果

Table 1 Vowel clustering result

类别索引韵母1 ai,an,a,ang,ao2e,en,eng,er,ei3o,ou,ong,ü,u,uo4-i(知韵),-i(资韵),i,in,ing5iu类别索引韵母6ua,uai,uan,uang7iou,iong8ia,iang,iao9un,ui,ün,üan,üe10ian,ie

1.2 韵母类发音单元相关度分析

由于韵母的音视频数据时长较短,采用小样本数据分析效果较优的CoIA(Co-inertia Analysis)算法[6],对表1各组韵母进行相关度分析。设音频和视频多元随机向量a=[a1a2…ap]T∈Rp和v=[v1v2…vq]T∈Rr各有N个样本,分别组成矩阵A∈Rp×N与V∈Rr×N,CoIA算法从两类多维异构特征中求出使两者协方差最大的一对映射向量。一对正交映射向量为ui∈Rp×1和zi∈Rr×1(i=1,2,…,R;R=rank(CAV),rank(·)为秩函数),分别为映射矩阵U、Z的列向量,则有:

(2)

式中,CAV=E{AVT}=cov(A,V)为协方差矩阵(CAV∈Rp×r)。求解得映射矩阵U和Z后,将待分析数据分别投影到映射向量上以获得两者的相关度,这里分别采用皮尔逊相关系数(pci)和RV系数[16]作为度量:

(3)

(4)

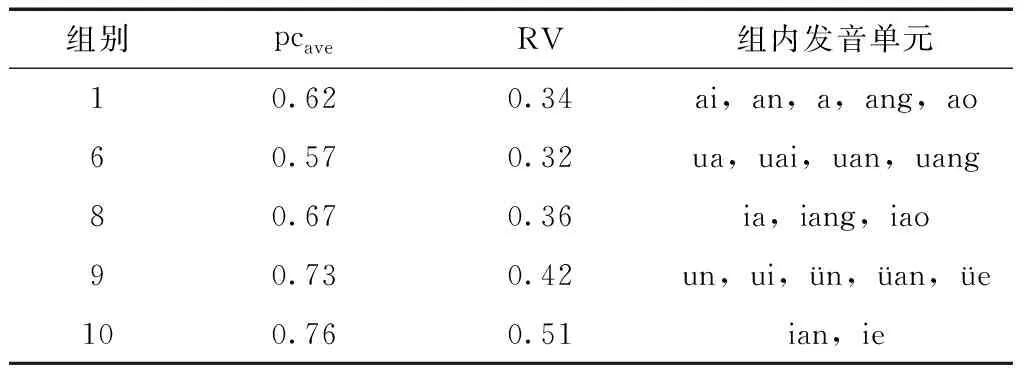

1.3 特定韵母发音单元选取

由表2可知,部分组别如第8、9、10组的两种相关系数均值明显高于其他组别,而且以复合韵为验证表3韵母单元的代表性,将包含表中韵母的分段与整句(共110句,包含声母)的相关度进行比较。整句统计的pcave平均为0.48,RV平均为 0.24,表3中韵母段统计的pcave平均为0.53,RV平均为0.27。分析以上数据可知,特定韵母发音段的相关度很多时候均大于或等于整句的相关度,有时甚至比整句的相关系数高出0.15以上。CoIA是统计类分析方法,可见这些韵母在发音过程中音频与唇部变化之间呈现更强的关联性,更能体现两者同步变化的关系,包含了更为突出和丰富的音唇关联性信息,因此选以上5组韵母为特定发音单元。

表2 各类韵母相关度分析结果

母类居多。表2中所有类别的pcave和RV系数的均值分别为0.54和0.29,从表中选取相关度大于以上均值的组别作为特定发音单元类别作进一步分析,共5组,如表3所示。

表3 特定韵母发音单元选取结果

2 语音唇动一致性判决

2.1 韵母分割与识别

在句子中检测并切分出包含表3中特定发音单元的韵母片段,通过分析这些片段代替分析整句话判断一致性。这里以音频为参考模态进行韵母切分与识别。传统听觉事件韵母切分法直接在0~400 Hz内区分清浊音,在401~4 000 Hz内检测浊音段内的浊辅音,切分结果易受复合韵母韵腹或韵尾的音变(如变调、儿化等)影响。因此本研究采用先检测浊音段,再在其段前段后进行听觉事件检测的方法切分韵母并进行识别,具体步骤如下。

(1)清浊音分类 先通过幅度压缩基音估计滤波法(Pitch Estimation Filter with Amplitude Compression,PEFAC)削弱语音中的低频噪声并提取基音谐波,然后采用基于对称平均幅度和函数的脉冲序列加权算法确定谐波数量,再由3元素特征建立高斯混合模型对清浊音进行分类[17]。预处理后第t帧语音信号的对数频域功率谱密度为st(q),包含纯净语音xt(q)和噪声成分wt(q):

st(q)=xt(q)+wt(q)=

(5)

式中,f0为基音频率,ak为第k(k=1,2,…,K)个谐波的功率,δ为单位冲激函数,归一化可得:

(6)

(7)

在60~1 250 Hz频域内,对φt(q)的幅值从大到小排序,选前3中频率最大者为基音谐波。最后,以各语音帧的3元素——归一化后的对数平均功率谱LPt、φt(q)前3个幅值之和与平均功率谱的比值βt、显著峰值点宽度的对数Vt,构成特征矢量[LPtEtβt],以此分别建立清音和浊音的高斯混合模型(Gaussian Mixture Model,GMM)进行分类,各GMM均采用6个单高斯模型。由于短非浊音帧不可能出现在连续的浊音段中[18],可依此对分类中因误判而出现的孤立帧进行修正,如判决结果为“…VVVVUVVVV…”(“V”为浊音帧,“U”为清音帧),其中的“U”应修正为“V”。

(2)韵母分割 检测出连续浊音段后,在当前浊音段的段前段后,以文献[19]的检测策略结合听觉事件检测法进行韵母切分。设索引为c的频段内第t帧语音信号St(n)的正突变听觉事件eon定义为

(8)

若eon=1,表示出现正突变听觉事件,阈值θon(c)由下式确定:

θon(c)=μ(c)+para×σ(c)

(9)

其中,para为待定系数,μ(c)和σ(c)分别为第t帧差分信号St(n+1)-St(n)各采样点幅值的均值和方差。

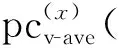

(3)韵母识别 对切分后的各段韵母提取音频特征,并由矢量量化器根据训练生成的码书进行量化,使得每个韵母信号对应一个代码序列。经过预识别后,比较该代码序列由各个HMM模型产生的概率分布参数,从而根据最大后验概率原则作出识别决策。韵母识别流程如图2所示。对[ê]音以外的38个韵母分别训练HMM模型,模型状态数为3,每个状态8个高斯分量。

图2 韵母识别流程

2.2 一致性判决

(10)

(11)

式中:Tv为视频帧间间隔,ms。

X个特定韵母发音事件的时延分布得分α2定义为

(12)

(13)

式(12)合理时延范围δLeft和δRight均取50 ms。最后,通过基于GMM的贝叶斯融合方法融合两类得分以获得最终的判决得分。设语音唇动事件的状态为Λy(y=0,1),其中Λ0表示音唇不一致,Λ1表示一致,而α=(α1,α2)为包含两种得分的得分向量,由条件概率P{α|Λ0}和P{α|Λ1}结合贝叶斯准则可得一致性评判标准:

P{α|Λ1}/P{α|Λ0}≥θ, 判为Λ1

(14)

P{α|Λ1}/P{α|Λ0}<θ, 判为Λ0

(15)

分别采用两个高斯模型描述上述两个条件分布:

(16)

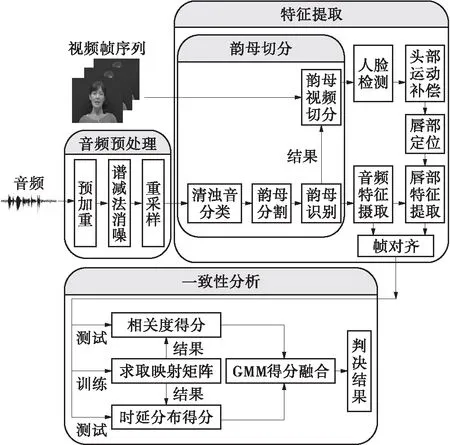

2.3 算法流程

文中一致性判决方法的流程如图3所示。

图3 基于特定韵母发音事件分析的音唇一致性判决流程图

Fig.3 Schematic diagram of lip motion and voice consistency recognition method based on specific vowel pronunciation events analysis

其中,时延估计部分以DCT系数和图1的9维唇部几何特征为视觉特征,取Dleft=Dright=100 ms。对定位出的唇部区域(56*32)进行分块二维DCT变换,各块Zig-Zag排序后取最大的系数并拼接上其一二阶差分组成DCT特征。音频帧长为20 ms,帧间重叠为10 ms。每帧提取对数能量及13维 MFCC系数也同样拼接其一二阶差分组成42维特征,韵母识别过程也采用相同的音频特征。

3 实验与结果分析

3.1 实验设置

实验使用的汉语听觉视觉双模态语料库,共包含20人的数据,每人取15句,每句录音3次。将一致数据分为测试集600句和训练集300句,训练集主要用于字典和映射矩阵的训练。通过集内数据中不同句子的音频和视频交叉组合合成出4类不一致数据(见表4所示),各类样本均为1 200句。其中,第三类数据由不同录制者同一语句的音视频数据交叉组合得到;第四类数据则由同一录制者不同次录制的同一语句的音视频数据交叉组合得到。

表4 语音唇动不一致数据类别

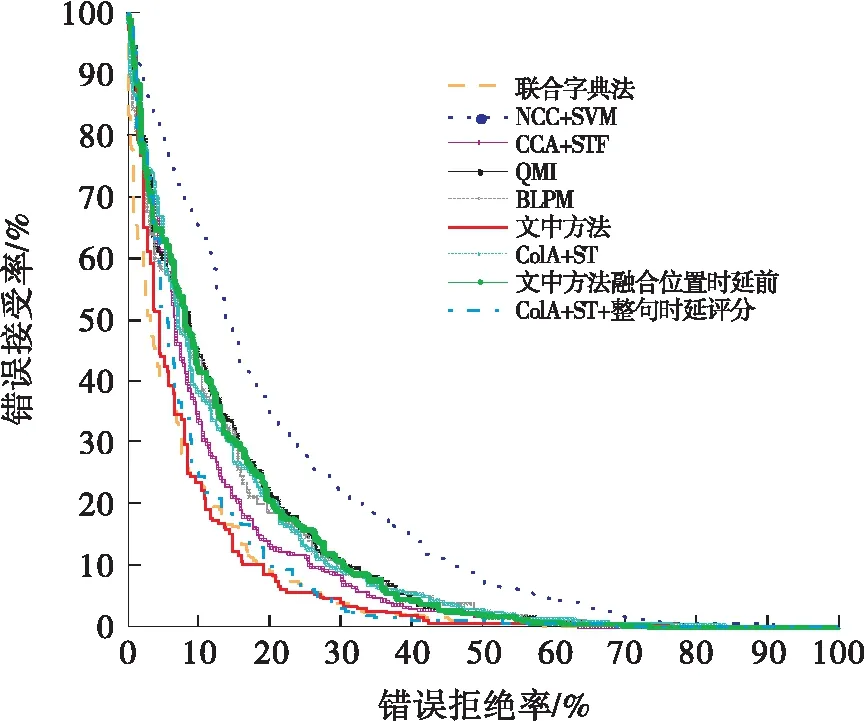

对文中方法的结果、文中方法融合位置时延分析前的结果、文献[6]方法(CoIA+ST训练方式整句分析)的结果,以及文献[6]方法增加文献[20]整句时延评分机制后的结果进行对比,以比较采用不同时延分析方法的识别性能,并验证特定韵母单元代替整句分析的可行性。同时,也与其他整句分析的方法进行了比较:相关法中的NCC+SVM[7]和BLPM[8]法,MI类算法中的QMI[4],另一种多元统计分析法CCA[5]结合时空视觉特征(CCA+STF),还有联合字典法[9](原子数为225)。实验以等误识率(Equal Error Rate,EER)作为算法的性能评价指标。

3.2 实验结果分析

文中方法及各种比较方法的总体错误接受率(FRA)和错误拒绝率(FRR)的变化曲线如图4所示,通过原点的45度斜线与各曲线相交处FAR=FRR,此时的FAR或FRR就是EER,不同方法对各类不一致数据的总体和独立统计EER见表5。

图4 不同算法的FRA和FRR变化曲线

由图4和表5可知,MSA类和稀疏表示类方法总体上优于MI类和相关系数类算法,文中方法与联合字典算法性能较为接近,稍优于后者,总体上优于其他比较算法。联合字典法对音节较少的语料有很好的识别性能,但音节数量增加时需以增加原子数量为代价,对大词汇量数据集字典的规模会很大;同时,实验发现不同音节的出现频率难以一致,部分音节可能在训练集中出现过少,没在原子中得以表达而影响识别性能。文中方法在融合韵母位置时延分布得分前的总体EER为20.7%,与整句分析(CoIA+ST)的性能接近,其中对一到三类不一致数据的分析结果略优于采用整句分析的方法,EER分别下降了1.2、0.9、和0.4个百分点。

表5 不同算法各类数据EER结果比较

这表明从韵母中选取特定发音单元代替整句话进行一致性分析的可行性和有效性。虽然文中方法融合韵母位置时延分布得分前对第四类数据的性能稍低于CoIA+ST方法,但融合后对各类不一致数据的总体EER较融合前下降了4.8个百分点,其中对第三和第四类数据的性能提升较为明显,分别较融合前下降了4.9个百分点和10.6个百分点。一致性判决方法其总体运算时间受样本帧数及图像尺寸等因素影响,文中算法人脸定位及唇部感兴趣区域提取部分的耗时约为60 ms一帧,与其他主流算法接近。但由于文中方法只分析特定韵母部分的音视频数据,而这部分数据平均只占整句时长的34%,因此不像整句分析方法那样须事先对每帧视频进行唇部定位等预处理,一定程度上降低了系统的运算量。实验中文中算法的平均速率约为23帧/s左右,接近实时性的要求。文中方法和表5中第二种方法均考虑了时延的差异,但文中方法通过结合多个韵母位置的时延分布进行分析稍优于采用整句时延进行相关度得分修订的方式。本研究中对特定韵母识别的准确率约为84%,虽然会有集外信息的引入,但与整句分析相比这类影响会相对较小。

4 结论

通过多帧口型序列特征对韵母进行聚类,并深入分析各类韵母的音唇关联度,选出更具代表性的韵母发音单元为分析对象,结合韵母出现位置的时延分布分析,提出基于特定韵母发音事件分析的音唇一致性判决方法。实验结果表明,该方法对不同类型不一致数据的识别性能与常用的多种整句分析方法相比均有一定提升。同时,融合特定韵母位置时延分析后一定程度上提升了总体识别性能,其中对第三和第四类数据的性能提升最为明显。