基于联合多特征直方图的Mean Shift行人跟踪方法研究

2016-05-08王爱丽董宝田孙远运

王爱丽,董宝田,孙远运,武 威

(1.中国铁路信息技术中心 信息工程部,北京 100038;2.北京交通大学 交通运输学院,北京 100044)

信息是智能交通系统(ITS)的灵魂,实时准确地获取交通流中运动目标的信息可以提高ITS的实施效果,对交通规划、设计、管理和控制等意义重大。近年来,计算机视觉技术的发展为ITS提供了有力工具,运动目标跟踪技术是其重要的组成部分[1-2],是获取交通场景内交通信息的主要途径,也是对行人的行为进行分析和理解的基础。

目前,国内外对基于计算机视觉的行人跟踪技术开展了广泛的研究,提出了许多新的跟踪方法[3-6],主要有基于特征的跟踪、基于模板匹配的跟踪、基于运动预测的跟踪等。其中,基于模板匹配的均值漂移(Mean Shift)跟踪算法因其计算量小、简单、易于实现等优点得到广泛应用,然而,该算法采用的颜色直方图对目标特征描述能力不强,抗遮挡能力弱,容易在跟踪过程中发生目标定位漂移。因此出现了很多改进的均值漂移算法。文献[7]提出一种自适应多特征融合均值漂移目标跟踪算法,利用局部均值对比度和灰度特征表征目标,能有效适应场景变化和目标形变,但此方法未考虑目标的运动特性,当目标严重遮挡时,算法的稳定性降低。文献[8-9]提出了融合颜色和形状纹理特征的跟踪算法,并假设特征相互独立,忽略了每个特征的贡献和目标的运动特性,易受运动噪声干扰。文献[10]将红外图像的灰度特征、可见光图像的颜色和纹理特征融入到模板跟踪框架中,该方法需对多传感器间进行同步测算和设置,计算复杂,不利于算法的推广应用。文献[11]提出一种新的核窗口大小和方向可自适应调整的均值漂移跟踪算法,构建了目标模型更新机制,可以对大小、方向和颜色变化明显的目标进行准确、稳定的跟踪,但忽略了运动目标间的干扰和遮挡等问题,所涉及的算法实验场景单一,在实际运用中受到较大限制。

本文提出一种基于联合多特征直方图的Mean Shift行人跟踪方法,在Mean Shift跟踪框架中,采用颜色、轮廓直方图分布描述目标外观、空间特征,且利用运动信息修正颜色、边缘直方图;提出四步搜索策略法,克服目标遮挡丢失问题。试验结果表明,该方法具有较高的准确性,能实时准确地跟踪目标,提取出的行人速度、加速度、轨迹等交通信息与实际相匹配。

1 目标模型的建立

传统Mean Shift算法将核函数加权的目标颜色特征直方图作为目标模型,用同样的方法迭代计算候选目标模型,以两个分布相似性最大为原则使跟踪窗口沿直方图分布密度变化最快的方向移动,从而定位目标[8]。在跟踪过程中,构建目标模型和候选目标模型是最重要的一个环节,为后期的目标位置搜索奠定了基础。

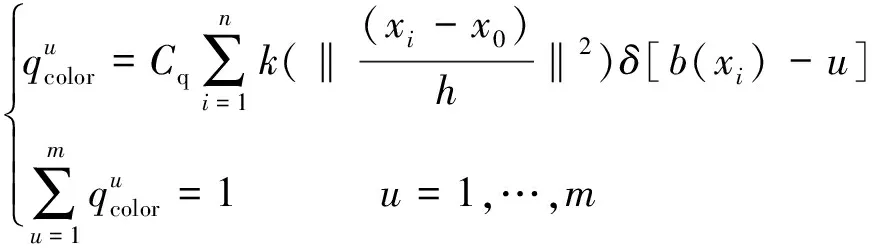

1.1 颜色直方图

(1)

图1为采集到的行人目标模板颜色直方图分布。

(a)行人目标颜色模板

图1 行人颜色直方图分布

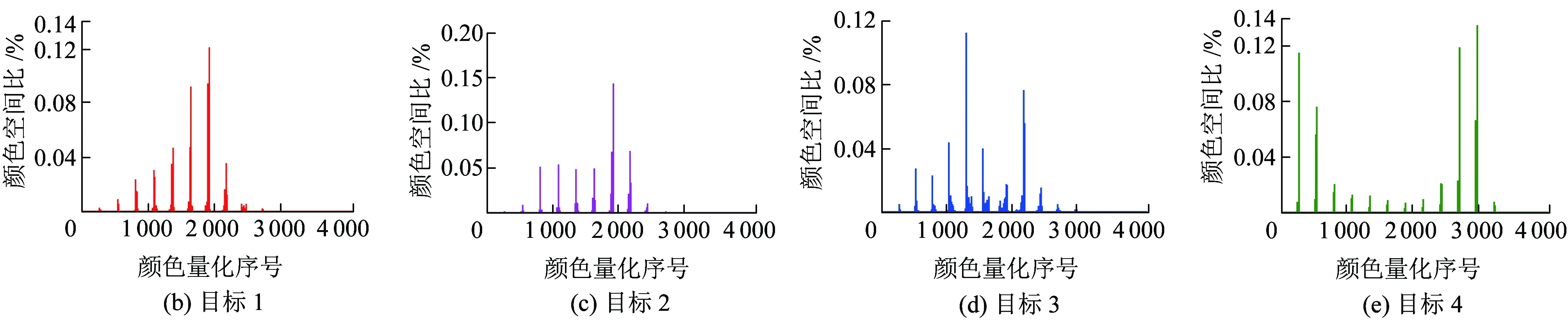

1.2 边缘直方图

边缘特征对光照、颜色变化依赖程度低,能够弥补颜色信息的缺陷。文中采用边缘直方图EH(Edge Histogram)作为第二个跟踪模型,计算过程如下。

步骤1使用Sobel算子[12]对平滑后的图像f(x,y)进行逐像素卷积,求出各点的水平、垂直边缘梯度Gx(x,y)和Gy(x,y)为

(2)

步骤2在水平和垂直方向基础上,引人45°和135°两个斜方向上的梯度信息,采用对角模板对图像中的像素求加权平均,获得两个斜方向上的边缘梯度幅值G45°(x,y)和G135°(x,y)。

(3)

步骤3综合斜方向与原梯度信息计算边缘梯度幅值G(x,y)和方向θ(x,y)。

(4)

对边缘方向进行滤波,保留边缘强度大的信息,剔除伪边缘,得到边缘梯度幅值为

(5)

步骤4采用形态学[13]对边缘图像进行修正,完成对断裂边缘的连接,获得高信噪比和低均方差的边缘。

(6)

式中:⊕和⊙为膨胀和细化运算,实现边缘的膨胀连接和细化;⊗表示击中或击不中变换运算符。

(7)

图2给出了采集到的行人边缘直方图分布。

(a)行人目标边缘模板

图2 行人边缘直方图分布

1.3 候选目标模型

(8)

(9)

2 多特征融合的行人跟踪

2.1 关联特征描述

2.1.1 特征修正

前文提取的颜色和边缘信息较好地描述了目标的外观、空间特征,但在实际交通环境内,易受相似背景颜色和背景轮廓的噪声干扰。一般情况下背景是固定的,而目标是运动的,因此,本文利用目标的运动特征,来修正目标的颜色、边缘特征,从而剔除背景噪声的干扰。

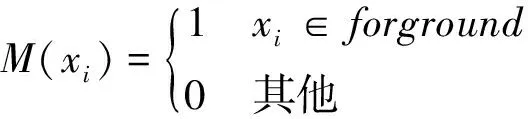

采用背景差分法检测出运动前景点,生成运动概率分布图M(xi),属于前景目标的像素点运动概率为1,反之为0。

前景运动信息描述模型为

(10)

(11)

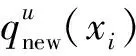

同理,候选目标的直方图描述模型为

(12)

式中:xi为目标模型像素级;yi为候选目标像素级。

2.1.2 自适应融合

(13)

(14)

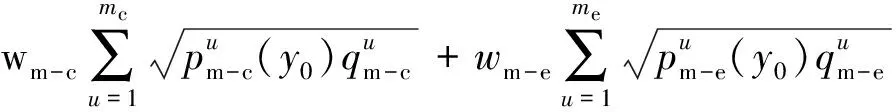

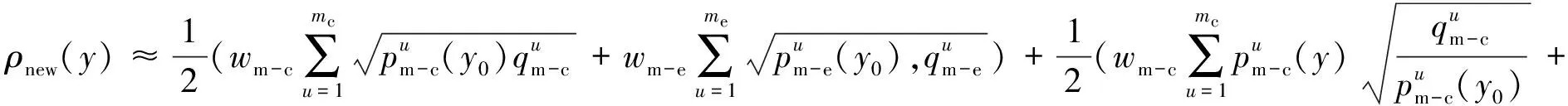

2.2 位置匹配

本文采用运动-颜色和运动-边缘直方图分布的联合相似性Bhattacharyya系数来度量候选目标和目标模型的相似性。联合相似性度量ρnew为

(15)

Mean shift 目标定位就是在每一帧中寻找使ρ(y)最大的位置y,因此,本文将式(15)进行泰勒展开,略去高次项,只保留线性部分,则联合特征相似性系数ρnew近似为

(16)

式中:y0为前一帧目标中心的坐标;{yi}(i=1,…,n′)为候选目标归一化后的像素坐标;y为当前帧候选目标中心坐标。

基于Mean shift算法[8]的跟踪原理,本文对融合相似性系数ρnew(y)求最大值,推导出被跟踪行人的新位置为

(17)

式中:g(y)=-k′(y),k′(y)为核函数k(y)的导数。

3 丢失目标处理

在运动过程中,多目标可能发生严重遮挡甚至完全遮挡,对跟踪算法的连续性和稳定性影响较大,最终导致目标丢失,此时上述跟踪算法失效。为解决该问题,本文引入跟踪状态因子,判别目标间的跟踪状态,若发生严重遮挡或丢失状态,则采用四步搜索策略法,对丢失目标进行重新定位。

3.1 跟踪状态判断

当运动目标发生变化时,前后两帧中运动物体之间的相似性也会发生相应变化,且其计算简单,运算速度快。因此,本文采用相似性Bhattacharyya系数来判别行人之间的跟踪状态。假设当前目标模型和候选目标模型分别为qu和pu,计算Bhattacharyya系数,对目标跟踪状态进行判定。

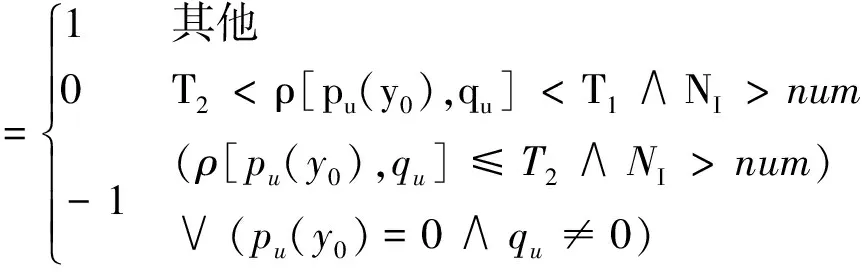

(18)

式中:Cflag为跟踪状态因子,Cflag=1表示目标处于正常跟踪状态,Cflag=0表示当前目标发生局部遮挡,Cflag=-1表示当前目标发生严重遮挡或全部遮挡,目标处于丢失状态;ρ[pu,qu]为Bhattacharyya系数;T1和T2是判断阈值;NI为迭代次数;num为迭代次数判别阈值。

3.2 丢失目标位置搜索

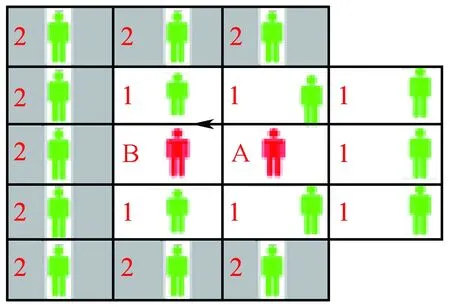

当目标处于遮挡丢失状态时,跟踪系统转入目标搜索状态,通过相邻区域信息搜索目标位置。在搜索前,需根据目标在丢失前的运动状态设置搜索区域,如图3所示(根据运动方向设定)。图3中A表示目标在丢失前的位置,B表示目标在下一时刻的预测位置,用1标记的区域为一级候选区域(考虑了目标后退情况),用2标记的区域为二级候选区域。本文假设目标的运动形式为“小运动”,一般二级搜索范围便能解决问题,若目标一直没有捕获到,则认为目标未出现。

(a)向左运动

(b)向右运动图3 搜索区域示意图

采用四步搜索策略法,对丢失目标进行处理的基本步骤如下。

步骤1搜索区域设置:对目标遮挡状态进行判断,若目标跟踪状态Cflag=-1,则根据目标丢失前的周围环境、运动状态和距离系数w(设w=2)设置搜索区域,以目标丢失前的位置A为中心,将目标可能出现的周围区域进行分块。

步骤2启动一级搜索:搜索所有的一级候选区域,一级候选块包括A、B和其他一级搜索块,匹配的条件设定为

步骤4目标搜索:把搜索到的候选目标存入cdfound集合,对集合内的候选目标块执行Mean Shift跟踪过程,若找到的目标满足ρ[cdfound(i),qu]>Tf,则记录Bhattacharyya系数,匹配系数最大的候选目标块,即为丢失目标,对目标当前信息进行更新。

4 实验结果

为验证该方法的有效性,采用在北京市门头沟区某街道处采集的2段视频,分别对不同行人目标进行跟踪实验。实验中,每帧图像目标实际的中心位置(x,y)是通过手工逐帧标记获取的。

4.1 单行人跟踪实验

图4给出了在视频序列I中基于本文跟踪方法对单个行人进行跟踪的结果。图4(a)~图4(f)依次为第268帧、360帧、368帧、375帧、390帧、476帧的跟踪结果,黄色矩形框内是跟踪到的目标。从图4可以看出,黄色框内的行人上衣颜色与背景颜色相近,而从整个跟踪过程中可以看出,行人目标跟踪表现稳定,未受相似背景颜色噪声的干扰,可见本文构建的多特征联合目标模型,对于目标的跟踪有较好的适用性。

同时,从图4可以看出,监控场景中出现了行人局部遮挡和完全遮挡丢失的情况,图4(b)~图4(e)分别显示了目标遮挡前、局部遮挡、完全遮挡丢失和恢复正常跟踪状态的效果图。图4(b)是行人发生遮挡前的跟踪图像;图4(c)为局部遮挡中的跟踪效果图;图4(d)为跟踪目标被其他目标所遮挡,目标信息丢失(如图中红色框所示);图4(e)为遮挡结束后,目标被重新捕获后的图像。从图4(b)和图4(c)可以看出,本文提出的多特征融合算法在一定程度上可以抵制局部遮挡。同时从图4(d)和图4(e)可以看出,本文提出的四步搜索策略法通过将目标丢失前的模板与预设的候选区域进行匹配搜索,实现了遮挡丢失目标的重新定位,当遮挡结束后,能够恢复对丢失目标的跟踪。

(a)第268帧 (b)第360帧 (c)第368帧

(d)第375帧 (e)第390帧 (f)第476帧图4 单目标跟踪

图5给出了本文所提算法和原始Mean Shift算法对上述场景的跟踪轨迹拟合结果。从图5(b)和图5(d)可以看出本文所提算法明显优于传统的基于单一特征的算法。在整个跟踪过程中,由于原始算法目标特征单一,造成在X、Y方向上跟踪轨迹误差较大,最大误差值达到31.7 px和22.39 px,平均误差值达到17.694 5 px和12.266 6 px,且随着时间的积累误差越来越大。同时,也可以看出由于本文跟踪算法为多特征信息,故采集到的X、Y方向上的目标位置信息与实际坐标轨迹变化状态基本一致,均保持稳定的较小误差,最大误差值分别为9.194 8 px和5.490 4 px,平均误差值分别为3.358 4 px和2.450 6 px。显然,本文所提算法误差相对较小,具有一定的显示优越性。

(a)X方向跟踪轨迹

(b)X方向跟踪误差

(c)Y方向跟踪轨迹

(d)Y方向跟踪误差图5 X、Y方向上跟踪轨迹拟合结果

4.2 多行人跟踪实验

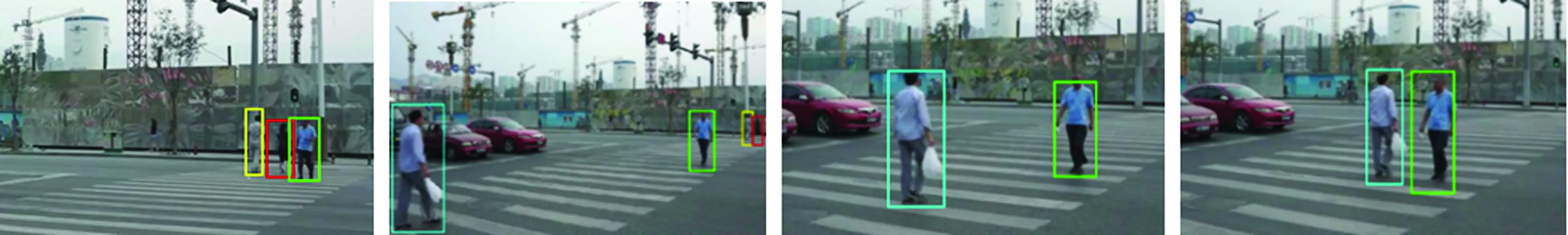

图6给出了在视频序列Ⅱ中基于本文跟踪方法对多个行人进行定位跟踪的结果,实验中存在目标颜色和背景颜色相似的问题(如黄色和青色框内行人)。依次给出了第58帧、210帧、318帧、360帧、400帧、530帧、580帧、610帧、620帧、628帧、635帧、670帧的跟踪结果。图6中跟踪到的行人ID编号依次为P1(黄色框内行人)、P2(红色)、P3(绿色)、P4(青色)。从图6可以看出,多运动行人的跟踪效果较好,行人运动轨迹基本都能够成功跟踪到,未受背景颜色的干扰,可见本文所提算法融入边缘和运动信息对背景颜色干扰具有较强的鲁棒性。同时,从图6(j)可以看出,在第628帧发生完全遮挡,行人P4被行人P3完全遮挡,则在P3周围搜索目标P4,直至第635帧时目标重新出现,停止搜索。

(a)第58帧 (b)第210帧 (c)第318帧 (d)第360帧

(e)第400帧 (f)第530帧 (g)第580帧 (h)第610帧

(i)第620帧 (j)第628帧 (k)第635帧 (l)第670帧图6 多行人跟踪

图7为上述场景整个跟踪过程中4个行人的跟踪误差。在整个跟踪过程中,各个目标的跟踪误差基本稳定,P1、P2、P3、P4的最大误差分别为10.883 3、10.367 5、11.653 6、11.775 5 px,平均误差分别为4.405 4、4.867 2、4.274 1、4.202 3 px。从实验中可以看出,本文所提算法可准确跟踪监控场景内出现的4个行人,多个目标的平均总跟踪误差为4.437 2 px。

图7 多行人跟踪误差

同时,在实验结果中发现,本文在引入颜色和运动特征、增加跟踪算法鲁棒性的同时,也带来了算法计算复杂度变高、耗时变长的问题,由原来的O(mcolor)增加到O(mcolor+medge+mmove)。平均每帧的运算耗时从只跟踪颜色特征的传统算法的0.015 s增大至0.26 s,但是考虑视频采集设备的帧率,通过合理间隔取样,对于一般的跟踪任务而言,基本能够满足实时性要求。

4.3 交通参数的提取

本文在准确跟踪行人的基础上,借助于基于计算机视觉的平面测量技术,建立交通视频图像和实际空间物理距离的映射关系,将图像中的参数进行映射[2],计算出实际的行人位置信息,进而计算出行人位移。通过记录位移信息,得到行人的运动速度和加速度。

图8为图6中跟踪到的4个行人P1、P2、P3、P4的速度和加速度变化曲线。文中速度采用跟踪位置的瞬时速度。通过图8(a)数据分析发现行人的行走速度主要分布在0.7~1.8 m/s,4个行人P1、P2、P3、P4的平均速度分别为1.199 7、1.252 9、1.283 9、1.241 4 m/s。此结果与美国《道路通行能力手册》[14]HCM (Highway Capacity Manual)推荐采用1.2 m/s作为行人步行速度结果基本一致。

图8(b)为行人加速度变化曲线,反映了行人的速度变化情况。可以看出,行人的启动加速度较大,平均为1.09 m/s2。行进过程中,加速度分布范围为0.05~0.90 m/s2,4个行人的平均加速度分别为0.353 3、0.323 7、0.260 3、0.324 3 m/s2。实验结果表明:本文所提算法因融入了多特征直方图信息,在整个跟踪过程中,跟踪目标的误差波动不明显,基本保持稳定的较小误差,目标跟踪效果比原始算法更准确;能够有效处理目标严重遮挡丢失问题,保证了跟踪的持续性,且提取的交通信息与实际情况相匹配。

(a)速度

(b)加速度图8 变化曲线

5 结论

本文提出一种基于联合多特征直方图的Mean Shift行人跟踪方法。综合颜色特征对旋转、变形不敏感,以及边缘特征对光照、颜色不敏感的优点来描述目标模型。利用运动信息改进颜色、边缘直方图核函数,克服了背景颜色、轮廓对跟踪效果的影响,自适应融合法生成的目标关联特征直方图分布实现简单,保证了跟踪性能的充分发挥。采用Bhattacharyya系数判别跟踪状态,有效标识出了目标的运动状态,提出的四步搜索策略法,解决了目标遮挡丢失问题,保证了跟踪的持续性。不同交通场景下的跟踪实验表明,本文所提算法颜色、轮廓特征的鉴别性较高,且融入了运动特征,进一步避免了单一特征的不稳定,对颜色相似区域、运动背景干扰和局部遮挡等均具有较高的鲁棒性,比传统Mean Shift算法的误差小,且能够有效判断并处理目标间遮挡丢失问题,检测到的目标速度、加速度、轨迹等交通信息与实际情况相匹配。

参考文献:

[1]常发亮,马丽,乔谊正. 视频序列中面向行人的多目标跟踪算法[J]. 控制与决策, 2007, 22(4):418-422.

CHANG Faliang, MA Li, QIAO Yizheng. Human Oriented Multi-target Tracking Algorithm in Video Sequence[J]. Control and Decision, 2007, 22(4): 418-422.

[2]LI J, SHAO C F, WANG T X. A Real-time System for Tracking and Classification of Pedestrian and Bicycles[J]. Journal of Transportation Research Board, 2010(2198): 83-92.

[3]YAO A B, LIN X G. A Compact Association of Particle Filtering and Kernel Based Object Tracking[J]. Pattern Recognition, 2012, 45(7): 2 584-2 597.

[4]SHAN C F, TAN T N, WEI Y C. Real-time Hand Tracking Using a Mean Shift Embedded Particle Filter[J]. Pattern Recognition, 2007, 40(7):1 958-19 70.

[5]MENEZES P, LERASLE F, DIAS J. Data Fusion for 3D Gestures Tracking Using a Camera Mounted on a Robot[C]// 18th International Conference on Pattern Recognition.New York:IEEE Press,2006: 464-467.

[6]RUI Y, CHEN Y. Better Proposal Distributions: Object Tracking Using Unscented Particle Filter[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.New York:IEEE Press, 2001: 786-793.

[7]刘晴,唐林波,赵宝军,等. 基于自适应多特征融合的均值迁移红外目标跟踪[J]. 电子与信息学报, 2012, 34(5):1 138-1 141.

LIU Qing, TANG Linbo, ZHAO Baojun, et al. Infrared Target Tracking Based on Adaptive Multiple Features Fusion and Mean Shift[J]. Journal of Electronics & Information Technology, 2012, 34(5): 1 138-1 141.

[8]贾松敏,王爽,王丽佳. 多特征自适应均值漂移算法的目标跟踪[J]. 光电子·激光, 2014, 25(10): 2 018-2 024.

JIA Songmin, WANG Shuang, WANG LiJia. Human Tracking Based on Adaptive Multi-feature Mean-shift Algorithm[J]. Journal of Optoelectronics·Laser, 2014, 25(10):2 018-2 024.

[9]WANG J Q, YAGI Y S. Integrating Color and Shape-texture Features for Adaptive Real-time Object Tracking[J]. IEEE Transactions on Image Processing, 2008, 17 (2):235-240.

[10]赵高鹏, 薄煜明,陈益. 多特征提取的红外和可见光目标跟踪方法[J]. 兵工学报, 2011, 32(4) : 445-451.

ZHAO Gaopeng, BO Yuming, CHEN Yi. A Method for Tracking Object in Infrared and Visible Image Based on Multiple Features[J]. Journal of China Ordnance, 2011, 32(4):445-451.

[11]李琦,邵春福,岳昊. 核窗口尺寸和目标模型自适应的均值漂移跟踪 [J]. 华南理工大学学报:自然科学版, 2013,41(2):75-81.

LI Qi, SHAO Chunfu, YUE Hao. Mean Shift Tracking with Adaptive Kernel Window Size and Target Model[J]. Journal of South China University of Technology :Natural Science Edition, 2013,41 (2):75-81.

[12]王鑫, 徐立中. 图像目标跟踪技术[M]. 北京: 人民邮电出版社, 2012.

[13]RAFAEL C G, RICHARD E W, STEVEN L E. Digital Image Processing Using MATLAB [M]. 北京: 电子工业出版社, 2005: 260-280.

[14]任福田, 刘小明. 道路通行能力手册[M]. 北京: 人民交通出版社, 2008.