自我调节学习理论下的LLM自我纠错路径构建研究

2024-09-30袁睿廷杨优娜施浩然

摘要:通过对ChatGPT等大语言模型的发展及其存在问题的梳理,如AI“幻觉”,探讨了自我调节学习(Self-Regulated Learning, SRL)理论与大语言模型(LLM)自我纠错技术在国际中文教育中的应用。对基于人类反馈的强化学习(RLHF)作为优化模型交互表现的方法进行分析,指出其依赖人类指导和自我调节能力不足的问题,回顾自我调节学习理论的发展历程,讨论了该理论在智慧学习环境中的应用前景。以SRL理论为核心,提出了基于SRL的LLM自我纠错新技术框架路径,讨论了LLM自我纠错路径在国际中文教育中的应用,包括自我监督与对比学习、元认知分析、对学习者的个性化纠错与辅导等方面。通过将SRL理论与LLM自我纠错技术相结合,为LLM自我纠错提供理论框架指导,促进ChatGPT深度融入国际中文教育。

关键词:自我调节学习;LLM;人机交互;国际中文教育;ChatGPT

中图分类号:H195;G434" " "文献标识码:" A" " " 文章编号:2095-7734(2024)04-0116-09

一、引言

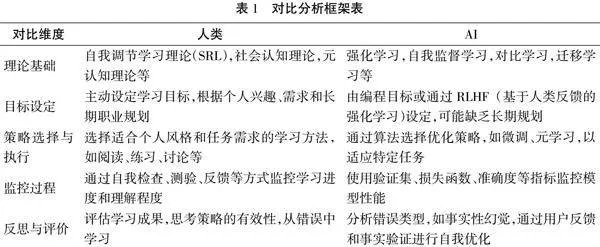

2022年ChatGPT的问世标志着人工智能技术领域取得了又一次重大飞跃,它展现了强大的文本生成与理解能力,但也暴露出一个核心问题:目标性输入与随机性输出的非一致性,即AI“幻觉”。与此同时,基于人类反馈的强化学习(RLHF)作为ChatGPT等大语言模型的关键训练机制,借鉴了行为主义心理学中的正负反馈原则来优化AI的交互表现,对于提高交流质量、减少AI的非理性推断,以及快速适应新兴在线学习场景具有重要价值。然而,这一过程仍旧高度依赖于人类的指导,AI虽能基于海量数据自我优化,但在无外部引导下的自我调节能力仍显不足,从而引发了关于学习主体自主性与外部引导机制之间关系的讨论。

" 不同于行为主义理论,自我调节学习理论(SRL)基于社会认知理论构建,主张学习目标与个体内部动机并重,旨在培养学习者的主动性和策略性学习习惯。遗憾的是,当前大语言模型在处理幻觉问题时,缺乏高效的自我监测机制、动态适应的学习策略,以及深层次的认知反思能力,这限制了其在教育等垂直领域的应用潜力。随着大语言模型在教育领域的深度整合与个性化应用落地及AI辅助语言教学的日益普及,智慧教育正逐步重塑传统教育的格局,挑战着既有教学模式的局限性,催生新的教学范式变革。

" 鉴于此,本研究聚焦于国际中文教育领域,依托自我调节学习理论框架,探索在大语言模型时代下减轻AI“幻觉”影响的技术途径,旨在不仅提升AI辅助教学的精准度与有效性,同时也为未来AI在语言教育中的角色定位与功能拓展开辟新的思路与实践路径,以期在技术创新与教育实践的深度融合中推动国际中文教育迈向智能化的新纪元。

二、文献综述

(一)自我调节学习(SRL)理论演变

" 自我调节学习理论(SRL)源自20世纪后半叶,强调学习者在学习过程中的主动性和自主性。[1]早期研究聚焦于个体如何通过设定目标、监控进度、部署策略和自我反思来控制学习过程。随着时间的推进,SRL理论经历了从Zimmerman模型到Pintrich、Boekaerts和Winne等模型的发展。[2]Pintrich在其模型中,尤为注重元认知和动机的复杂性,将自我调节过程进一步细分,强调动机信念、目标定向、自我效能感等因素对学习行为的影响。[3]Winne从社会文化理论出发,发展自我调节交互观。[4]SRL模型发展过程中的一大特点是强调自我调节学习的动态性和发展性,不同于早期较为静态地看待学习者的能力和策略,这些研究展示了自我调节能力是如何随时间发展,如何在不同情境中变化,以及如何受到情绪、社会互动等多方面因素的影响。[5]

" 随着技术的发展,SRL理论逐渐融入智慧学习环境的应用。[6]研究开始探索智慧学习环境如何影响学习者的自我调节能力,例如MOOC混合式教学与传统课堂的比较。[7]智能学习环境为校园内外和在线学生提供了技术服务,促进了学生与教师以及学生之间的本地和远程互动。[8]探索SRL如何在智慧学习环境背景下支持学习者发展思维策略、元认知和动机以实现学习目标,成为了该领域较为重要的研究方向。[9]生成式AI由感知智能向认知智能的跨越进一步促进了SRL的智能化应用,使个性化学习路径设计成为可能,生成式AI不仅能够感知和处理各种形式的信息(如文本、图像、声音),还能通过深度学习技术理解和产生具有较高语义复杂度的内容。这正是从感知智能向认知智能转变的表现,AI增强了学习适应性与反馈的有效性,并推动了学习干预策略的自动化实施。[10]由此可知,SRL理论在智能教育技术的辅助下,正面临的数字化与智能化转型。

(二)生成式AI幻觉的自我纠错机制

" 大语言模型幻觉,特别是事实性幻觉,指的是模型在生成内容时可能出现的不准确或错误信息的表达。[11]针对这一问题,大语言模型的自我纠错技术应运而生。具体而言,现有研究主要有以下特点:增强模型的自我监督学习能力,让模型能够在生成过程中自我检测并修正潜在的错误;[12]集成实时的事实验证系统,通过与权威数据库或知识图谱的比对,即时纠正错误信息;[13]引入用户反馈循环,利用用户的标记或评价作为额外的学习信号,不断优化模型的输出逻辑和内容质量,[14]但依然存在理论缺乏、实践应用有限、跨领域泛化不足等挑战。

" 综上所述,自我调节学习(SRL)虽然在智慧教学环境下能有效促进学习者自我管理与高效学习能力的提升,但同时面临着如何有效融合人工智能技术以实现个性化学习路径的优化挑战。而生成式AI幻觉的自我纠错机制由于技术成熟度与数据依赖性的问题,也面临准确性与效率之间的平衡、用户信任度建立等挑战。二者相互影响,共同构成了未来教育技术发展的核心议题,为教育创新与智能化转型开辟新径。深化SRL与AI技术的整合策略,不仅能够拓展SRL理论的应用边界,还能够为AI幻觉自我纠错技术提供新颖的理论视角。基于此,本研究拟提出以下三个研究问题:

(1)自我调节学习理论与大语言模型自我纠错技术有何共性?

(2)怎样结合SRL原理,优化大语言模型的自我监督学习机制,减少生成内容的错误率?

(3)如何在智慧学习环境中构建基于自我调节学习理论的大语言模型自我纠错技术路径?

三、LLM纠错技术的自我性

" 人工智能作为学习与适应的综合体,通过模拟人类的自我反思和调整机制,目前正处于从被动反应到主动学习,从依赖人工指导到实现自我调节的新发展阶段。[15]这一转变不仅标志着技术的进步,更是向自主性和高效性的一大迈进,预示着AI系统能够自我优化并适应复杂多变的环境。与此同时,技术如何逐步推动模型的自动化与智能化水平提升,关键在于融合自我调节学习策略,以及不断优化的算法支持和大数据的高效利用。在此基础上,建立一套能够促进AI自我进化、自我纠错的机制,成为了推动AI教育应用深度发展的核心。通过持续监测学习成效、灵活调整学习策略,并结合情境理解与情感感知能力,AI系统正逐步逼近能够提供更加人性化、精准教育辅导的目标。

(一)理论层面人工智能理论演变脉络

" “符号主义”与“联结主义”的根本分歧凸显了语言学习与智能理解问题的理论基础差异,也标示了大语言模型(Large Language Models, LLMs)迈向通用人工智能(Artificial General Intelligence,AGI)发展路径上的核心争议。[16]前者基于规则与逻辑推理,强调符号操作和明确的知识表示,以分解和程序化方式解构智能,典型代表为专家系统;后者则模仿生物神经网络结构与学习机制,侧重数据驱动与模式识别,以分布式、并行处理的连接主义方式模拟智能,典型代表为人工神经网络(ANN)。[17]而在提升AI学习能力的发展路径上,尤其是在训练数据特征方式的获取上,前者依赖于手动设计的特征和规则集,强调先验知识的编码;后者则通过端到端学习直接从原始数据中自动提取特征,表现出了类似于行为主义的被动学习,即通过大量试错和奖励机制进行优化,而非预先定义行为。[18]因此,如何推动被动学习向主动认知的转变,成为推动现代AI技术,尤其是大语言模型向更高水平发展的关键所在。

(二)智能化进程的自我驱动演变

" 机器翻译作为自然语言处理领域的一项基础应用,不仅扮演着沟通不同语言桥梁的角色,而且随着技术迭代,它逐渐成为了展示人工智能从规则驱动向数据驱动转变的典范。统计机器学习模型,作为这一进程的早期推手,诸如线性回归、逻辑回归、决策树以及支持向量机(SVM)等,通过在数据中挖掘统计规律和模式,成功应用于分类、回归等任务,为后续技术奠定了基础。[16]尽管这些模型在处理简单关系时表现稳健,但在面对高维度和非线性数据时的局限性凸显,促使技术向更高层次的自我调节和适应性跃进。传统神经网络的出现,尤其是多层感知机(MLP),[19]标志着AI开始尝试模拟人脑的非线性处理能力,通过多层结构捕捉数据中的复杂关联,而柯尔莫哥洛夫-阿诺德网络KAN深度架构的引入,进一步加深了模型的抽象层次,提高了对复杂数据分布的学习能力。尽管如此,它们在深度和规模上的扩展受限于当时的技术条件,直到预训练语言模型(PLM)的兴起,如BERT和GPT系列,通过自注意力机制捕获上下文依赖,实现了模型在大规模数据上的自我学习与优化,这与自我调节学习理论中的自我监控和策略调整过程不谋而合。[20]LLM通过数十亿乃至数千亿参数的规模,进一步提升了NLP任务的完成度,不仅能够生成内容丰富、逻辑连贯的文本,还展现出了一定程度的通用智能,体现了AI系统从依赖外部指令向内在驱动、自我优化的转变。这一转变与自我调节学习理论的核心——学习者主动设定目标、监控进度、调整策略和进行自我反思的过程相呼应,两者均强调了内在动力和动态调整的重要性。

(三)关键技术的自我强化作用

" 海量数据的累积不仅触发了大语言模型的涌现效应,这现象可以视为模型自我性初露端倪的一部分,尤其是在模型训练遵循的scaling law框架下,[12]数据量与性能提升之间的非线性关系,进一步强调了预训练阶段作为自我调节学习根基的重要性。有限的监督微调策略展示了对下游任务的高适应性,这是否标志着通过微调有限的监督数据,模型能够巧妙地扩展至无限多变的实际应用情景,是自我性发展不可或缺的一环。[21]自注意力机制,作为大型语言模型(LLM)的核心组件,不仅管理着对训练数据中知识的高效存储与访问,是否也可视作人工智能展示智能特性的关键标志,甚至是迈向“自我性”的一步。[22]该机制允许模型根据当前任务的即时需求,在庞大的信息中精准聚焦,有效应对长期依赖问题,极大地提升了模型在复杂环境下的自我调节和深入理解语境的能力。

" RLHF(基于人类反馈的强化学习)机制的引入,揭示了AI如何通过与人类的互动学习深化其自我性。[14][23]从交互的维度审视,这一过程涵盖了人类反馈的精密收集、奖励模型的精心训练以及强化学习策略的持续优化。尽管此方法通过正向激励促使模型行为更贴近人类预期,模拟了自我调节学习中至关重要的外界反馈,但它也暴露了现有AI训练技术的局限性——对AI内部认知过程的探索尚显不足。尽管AI可解释性研究已取得一定进展,但在处理LLM训练时,我们仍忽视了对情感认知等抽象层面的深入理解。

(四)自我性与认知智能的交融

" 基于统计学习理论的模式匹配技术侧重于在数据中发现重复出现的模式,这在计算智能阶段至关重要。[16]技术进步推动了注意力逐渐转向文本统计特征的深入发掘,比如信息熵用来衡量文本的不确定性,困惑度评估模型的预测难度,以及流畅度确保生成文本的自然度。这些指标不仅优化了基础的文本处理任务,也为后续更复杂的认知层面任务打下了坚实的基础。迁移至语言学领域,研究开始专注于文本的深层语义理解和生成,[17]其中涉及词汇、句法乃至篇章结构的精妙把握。通过模式识别与深度学习的融合,这些技术不仅支撑了机器翻译的准确性,提高了文本分类的精确度,还使得命名实体识别更为高效,情感分析更加细腻,均是基于模型表征的迁移学习与应用的直接体现。

" 认知智能的探索进一步将焦点扩大到了多模态大语言模型的构建,这种框架不仅局限于文本,而是将视觉、听觉等多种信息渠道整合起来,形成了对世界更全面的理解方式。[24]这不仅仅意味着模型能处理更多类型的数据,更重要的是它学会了像人类一样从多个感官获取信息并综合理解。在这一过程中,非言语线索,如说话者的语调、面部表情,以及文字间隐含的情绪色彩,[13]都成为模型理解情境的重要组成部分,进而使得AI的判断和反应更加贴近人类的真实交流情境。这一发展路径最终导向了对大语言模型自我性与认知智能交融的深刻认识。这种跨通道的信息整合能力,要求AI具备更高级别的自我调节和认知协调机制,以确保在复杂多变的交流场景中,能够灵活、恰当地响应,甚至预测交互伙伴的需求和反应。

(五)LLM纠错技术的自我性

LLM的性能优化核心在于系统性地规避错误,尤其关注于跨越文本、图像、语音乃至视频等多模态数据处理时的复杂错误形态。我们从人类认知过程中的错误分析策略汲取灵感,聚焦于生成式文本中的偏差现象,并将其精炼为显性偏差与隐性偏差两大维度,作为审视LLM自我纠错机制的双重视角。

" 显性偏差主要显现在文本生成的直接成果中,诸如由AI幻觉触发的信息失真,[25]以及对抗性文本测试中暴露的语法与拼写失误。AI幻觉揭示了输入-输出间存在的非决定性冲突,凸显算法内在的随机性特征;而对抗性文本则暴露了外部攻击者利用模型漏洞,蓄意引导错误输出的安全隐患,[26]对模型稳健性构成严峻考验。相比之下,隐性偏差,例如AI偏见,在文本及图像等多个层面上暗流涌动,其隐蔽特性大大提升了探测与修正的复杂度。

" 针对目前AI偏差类型的响应策略呈现出分散性与碎片化状态,亟需一个统一且综合的语言学和心理学理论分析框架,以系统化整合各类偏差研究,催化出更精确的纠错技术发展。[12]鉴于此,我们深入探索了AI技术自我进化与智能提升的路径,强调大语言模型纠错机制亦需具备更强的自主性与高效进化能力。[27]因此,本项研究采纳自我调节学习(Self-Regulated Learning, SRL)理论为核心,旨在构筑一个严谨的LLM自我纠错技术架构。

" 自我监督学习(SSL)实现:可以补充在提到AI系统从被动反应到主动学习的段落之后,具体描述如何使用未标记的大量文本数据进行自我验证和动态生成正负样本对。

" 对比学习(CL)实现:可以插入在讨论模型自我优化与适应性调整机制的段落中,解释如何通过对比学习方法构建正反例学习机制,并优化模型生成策略。

" 元认知分析与策略调整:应当在关于AI如何监测学习成效和调整学习策略的段落之后,增加详细描述,解释如何利用元认知策略来分析生成错误的根源并动态调整模型的生成策略。

动态学习策略:补充在“动态调整与自我优化”部分,进一步阐明如何通过元学习和动态架构调整技术,使模型能够自动调整学习路径,实现更有效的自我改进。

四、建构符号表征形式下的LLM自我纠错路径

(一)自我调节学习的不同阶段

" 自我调节学习是一个多阶段、动态的进程,涉及学习者在学习旅程中的主动规划、执行、监控、反思与自我评价。[1]具体而言,这一过程可细分为以下几个核心阶段:

" 1.目标设定(G):在计划阶段,学习者确立清晰、可度量的学习目标G,这些目标以向量形式展现,每个分量指示不同学习维度(如理论知识、实践技能)的期望成就水平,为学习活动指明方向。[2]

" 2.策略选择与执行(S):紧接着,学习者依据任务特性和个人偏好,选取并实施一组策略S={S1, S2, ..., Sn},每种策略Si针对特定学习挑战,旨在优化学习路径与效率。

" 3.监控过程与适应性调整(M):在学习过程中,持续的自我监控M充当了一个动态调节器,基于当前学习状态P(包括认知负担、情感体验和学习进度等)来决定必要的行动A,确保学习活动与既定目标保持一致。

4.反思与评价(R):反思与评价阶段是自我调节循环中的关键转折点,通过映射学习成果O(如测验分数、任务完成质量)到学习者从中汲取的经验教训L,促进认知深化与策略优化,为下一轮学习设定新的起点。

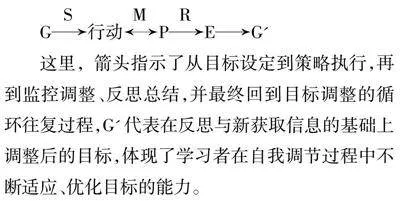

" 5. 自我效能感的培养与强化(E):自我效能作为自我调节的动力源泉,以标量E衡量,反映了学习者对达成目标信心的强度,对维持学习动力、克服挑战具有决定性影响。[21]整合上述要素,自我调节学习模型可抽象为一个紧密相连的流程图,其中各阶段相互作用、循环迭代:

" G行动PE→G'

" 这里,箭头指示了从目标设定到策略执行,再到监控调整、反思总结,并最终回到目标调整的循环往复过程,G'代表在反思与新获取信息的基础上调整后的目标,体现了学习者在自我调节过程中不断适应、优化目标的能力。

(二)LLM的自我纠错或自我优化过程

" 1.目标定义(G): 首先明确模型训练或微调的目标,比如提高语义理解的准确性、增强生成文本的连贯性等,这等同于自我调节学习中的目标设定。

2.初始化与预训练(I): 大语言模型通常基于大量无标注文本进行预训练,学习通用的语言结构和模式。这一步可以看作是自我调节学习开始前的“背景知识”积累。

" 3.任务适应与微调(T): 针对特定NLP任务,模型会通过微调过程适应新目标,调整权重参数以最小化特定任务的损失函数。此过程可以类比自我调节学习中的策略选择与执行,即学习者根据任务需求调整学习策略。[12]

" 4.性能监控与调整(M): 在微调过程中,通过验证集监控模型性能,根据评估结果调整学习率、提前终止训练或采用其他正则化手段,确保模型不会过拟合且持续优化。这类似于自我调节学习中的监控和策略调整。

" 5.动态学习策略(DLS): 引入元学习或动态架构调整等技术,使模型能够基于过去的学习经验,自动调整学习路径或网络结构,以更好地应对新任务。这是自我调节中自我反思与策略优化的体现。

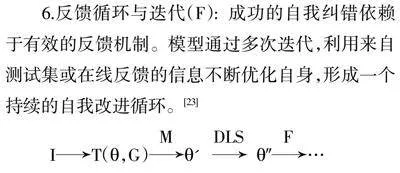

" 6.反馈循环与迭代(F): 成功的自我纠错依赖于有效的反馈机制。模型通过多次迭代,利用来自测试集或在线反馈的信息不断优化自身,形成一个持续的自我改进循环。[23]

I→T(,G)" ″…

五、基于SRL的LLM自我纠错新技术框架路径

" 从自我调节学习(SRL)到大语言模型(LLM)的自我纠错技术的过渡,实现了学习理论与人工智能技术的有效融合。这一过程包括:

" (1)目标设定转化为LLM训练中的目标定义,即从设定明确的学习目标转变为设定明确的优化目标;(2)策略选择与执行映射为LLM的初始化与预训练过程,通过构建基础语言理解能力来模拟学习者选择合适学习方法的行为;(3)监控过程与适应性调整对应于LLM的任务适应与微调,确保模型能够针对特定任务进行调整;(4)反思与评价环节转化为LLM的性能监控与调整,通过对模型性能的评估来不断优化其参数。通过上述映射,SRL的核心指导理论将应用于LLM的自我纠错技术中,构建出一套完整的自我优化流程。

(一)错误检测与初步分类(E→C)

LLM运用自我监督学习(SSL)与对比学习(CL)技术,自动识别生成文本中的错误,形成初步分类。[15]这涵盖语法错误ge、逻辑不一致性li以及事实谬误fm等,数学表示为E={ge,li,fm,...},并转化为纠正需求C。

(二)元认知分析与错误根源定位(C→A)

" 采用元认知策略,LLM进行深入的自我分析,归因错误产生之源,包括数据偏斜db、算法缺陷ad或任务理解不足tu等,A={db,ad,tu,...}。这一过程类似于学习者进行深度自我反思,数学表达为C→元认知分析→A

(三)策略性调整与优化路径(A→S′)

" 基于错误根源分析,模型动态调整其内部参数p和生成策略s,形成优化后的策略集合S′,即S′=(p′, s′),反映了学习者遭遇障碍时策略变更的逻辑,A→策略调整→S′。

(四)效果验证、反馈整合与闭环优化(S′→F→E′)

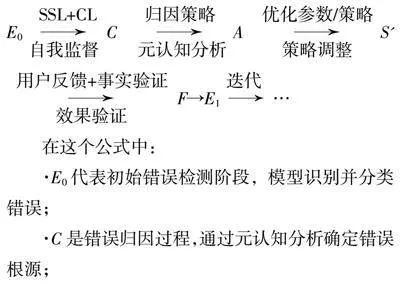

" 此阶段集成用户反馈uf与实时事实验证vf,形成综合反馈F=uf∪vf,用于验证纠正效果并作为新的学习信号。[28]模型通过F对纠正策略的效果进行评估E′,形成S′→效果验证E′的反馈回路。这不仅闭合了自我优化的循环E→C→A→S′→F→E′,还促进了模型的持续进化,体现了SRL中的自我评估与调整。基于上述流程描述,我们可以用一个概括性的公式来表示整个自我纠错机制的流程:

E0CAS' F→E1 …

" 在这个公式中:

·E0代表初始错误检测阶段,模型识别并分类错误;

·C是错误归因过程,通过元认知分析确定错误根源;

·A表示错误归因分析得出的具体原因;

·S′为根据归因分析调整后的优化策略;

·F代表反馈循环,包括用户反馈与实时事实验证的整合,作为新的学习信号;

·E1表示经过一次纠错循环后的错误状态,理论上应优于E0E0;

·迭代符号(...\)表示这一过程是循环往复的,每次迭代都在前一次的基础上进一步减少错误,直至达到理想的自我纠错效果。

六、研究讨论

(一)自我监督与对比学习

" 在国际中文教育的背景下,LLM通过自我监督学习(SSL)与对比学习(CL)技术,能够自动识别生成内容中的语法、逻辑和事实性错误,这为构建一个智能且灵敏的反馈系统奠定了基础。[29]当模型生成中文文本时,SSL和CL技术会自动对比模型输出与正确的语言结构和文化背景,确保输出内容的准确性与适宜性,这对于非母语学习者尤为重要,因为它们能够提供即时的反馈,帮助学习者迅速识别并纠正语言错误。[30]

(二)元认知分析与策略调整

" 元认知分析使LLM能够深入探究错误产生的根源,无论是数据偏斜、算法缺陷还是对中文语言结构理解的不足,都能够被精准定位。基于这些分析,模型会动态调整其参数和生成策略,形成一套优化后的策略集合,以更有效地应对国际中文教育中的语言挑战。[31]例如,如果模型识别到对某些汉字或成语使用不当的倾向,它会针对性地加强相关领域的学习和练习,从而提高语言输出的质量,进而提升学习者的语言理解和运用能力。

(三)对学习者的个性化纠错与辅导

" 在智慧教学的国际中文教育场景下,自我调节学习(SRL)理论为学习者提供了强有力的自主学习框架。[32]SRL强调学习者主动设定目标、监控进度、选择策略并进行自我反思,这对于自学环境尤为重要。当学习者在学习中文时,他们可以借助SRL理论设定具体的学习目标,比如掌握一定数量的汉字或提升口语流利度。随后,学习者通过在线平台进行自我监控,跟踪自己的学习进度和技能掌握情况,适时调整学习策略,以克服遇到的困难或挑战。这一过程中,学习者可以利用智能学习工具进行自我测试,获得即时反馈,这有助于他们及时识别和改正错误,促进语言技能的稳步提升,同时,LLM的自我纠错机制也能根据学习者的具体需求,提供更加个性化的辅导和支持。

(四)赋能国际中文教育智慧教学场景

" 在实际应用中,LLM的自我纠错机制和SRL理论的结合创造了多种智慧教学场景。例如,通过智能对话平台,学习者可以与LLM进行模拟对话,模型不仅能理解学习者的意图,还能识别并纠正语法错误,提供正确表达的示范。[33]在写作辅助方面,LLM作为写作助手,实时检查作业中的错误,提出修改建议,促进学习者的语言精进。[34]此外,LLM还能根据学习者的反馈进行自我优化,通过强化学习策略的持续调整,使模型的行为更贴合学习者的需求,提升教学效果,从而使整个学习过程更加流畅和高效。

(五)深化自我调节学习与AI技术的融合

" 深化自我调节学习(SRL)与AI技术的融合是提升AI辅助教学质量的关键。将SRL理论的原理融入AI的自我监督学习机制中,可以增强AI的教学适应性和内容准确性,减少生成内容的错误率,从而提升教学效果。构建基于SRL的大语言模型自我纠错技术路径,意味着要将学习者的目标设定、进度监控、策略部署和自我反思等过程,映射到AI模型的自我优化流程中。这意味着AI不仅要具备自我监测和修正错误的能力,还要能够根据学习者的反馈和需求,灵活调整教学策略,实现个性化教学路径的设计。这种路径的构建,将使得AI能够更好地理解学习者的学习风格和需求,提供更为精准和个性化的教学支持,最终实现教育智能化的全面升级。

七、结语

" 自我调节学习(SRL)理论与大语言模型(LLM)自我纠错技术的结合,为LLM自我纠错技术提供了具体的理论指导,也为国际中文教育智慧教学打开了新的研究思路。在SRL的框架下,LLM的自我纠错路径不再局限于传统的错误检测与修正,而是向着一个更加自主、动态、自我适应的系统演进。这一路径不仅要求模型能够自我监督、自我分析并调整策略,还强调了模型在反思与迭代中不断优化自身能力的重要性。通过SRL理论的指导,我们构建了一个基于符号表征的LLM自我纠错技术路径,它涵盖了从错误检测到根源分析,再到策略调整与效果验证的完整闭环。这一路径不仅能够提升LLM在国际中文教育中的应用效果,减少生成内容的错误率,还能够促进模型的持续进化,使其更贴近人类学习者的需求。SRL与LLM自我纠错技术的融合将成为推动教育智能化的关键力量。它不仅能够促进学习者自我管理与高效学习能力的提升,还将为AI在教育中的角色定位与功能拓展开辟新的道路。在智慧教学的背景下,国际中文教育将迈入一个全新的智能化纪元,LLM将以更加人性化、精准的方式辅助教学,实现国际中文教育的个性化与全球化。

参考文献:

[1]" Zimmerman, Barry J..A social cognitive view of self-" regulated academic learning.[J].J Educ Psychol,1989,81(03):329-339.

[2]" Monique Boekaerts.Self-regulated learning: a new concept embraced by researchers, policy makers,educators,teachers, and students[J].Learning and Instruction,1997,7(02):161-186.

[3]" Pintrich P R.Chapter 14 - the role of goal orientation in self-regulated learning[J].[s.n.],2000:451-502.

[4]" Hacker D J,Dunlosky J,Graesser A C.Metacogni tion in educational theory and practice[J].[s.n.],1998:277-304.

[5]" Panadero Ernesto.A review of self-regulated learning: six models and four directions for research.[J].Front Psychol,2017,8:422.

[6]" 韩中美,田甜,何涛,等.在线环境中自我调节学习和同伴互动水平的关系研究[J].中国电化教育,2022,(05):99-106.

[7]" 张成龙,李丽娇.基于MOOC的混合式教学对网络自我调节学习的影响[J].现代教育技术,2018,28(06):88-94.

[8]" 李月,姜强,赵蔚.数字化时代在线学习行为结构及其作用机理研究——自我调节理论视角[J].现代远距离教育,2023,(01):61-70.

[9]" 徐晓青,赵蔚,姜强.学习分析支持自我调节学习的效能分析框架研究[J].电化教育研究,2023,44(02):114-120+128.

[10] 杨淼,董永权,胡玥.基于学习者建模和数据挖掘的个性化学习路径推荐研究[J].上海教育评估研究,2019,8(05):58-61.

[11] Lei Huang, Weijiang Yu, Weitao Ma, et al. A Survey on Hallucination in Large Language Models: Principles,"Taxonomy, Challenges, and Open Questions [J]. arXiv,2023, 2311.05232.

[12] Tao Z, Lin T-E, Chen X, et al. A Survey on Self-Evolution of Large Language Models [J]. arXiv, 2024, 2404.14387.doi:10.48550/arXiv.2404.14387.

[13] Yue S, Song S, Cheng X, et al. Do Large Language Models"Understand Conversational Implicature–A case study with a Chinese sitcom [J].arXiv,2024,2404.19509. doi:10.48550/arXiv.2404.19509.

[14] Järvelä S, Nguyen A. Human and artificial intelligence"collaboration for socially shared regulation in learning[J].British Journal of Educational Technology, 2023, 54(5):1057-1076.

[15] Bommasani R, Hudson D, Adcock A, et al. On the opportunities and risks of foundation models [J]. arXiv,2021, 2108.07258.

[16] Bishop C M. Pattern recognition and machine learning [M]."Springer, 2006.

[17] Goodfellow I, Bengio Y, Courville A. Deep learning [M].MIT Press, 2016.

[18] Murphy K P. Machine learning: A probabilistic perspective[M]. MIT Press, 2012.

[19] Hochreiter S, Schmidhuber J. Long short-term memory [J]."Neural Computation, 1997, 9(8): 1735-1780.

[20] Devlin J, Chang M W, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding"[J]. arXiv, 2019, 1810.04805.

[21] Kaiyan Chang, Songcheng Xu, Chenglong Wang, et al.Efficient Prompting Methods for Large Language Models: A Survey [J]. arXiv, 2024,2404.01077.

[22] Liu Y, Ott M, Goyal N, et al. RoBERTa: A robustly optimized BERT pretraining approach [J]. arXiv, 2019,1907.11692.

[23] Christiano P F, Leike J, Brown T, et al. Deep reinforcement"learning from human preferences [J]. Advances in Neural Information Processing Systems, 2017.

[24] OpenAI. GPT-4 technical report [R]. OpenAI, 2023.

[25] Huang J, Chen X, Mishra S, Zheng HS, Yu AW, Song X,Zhou D. Large language models cannot self-correct"reasoning yet[J]. arXiv, 2023, 2310.01798,

[26] Cheng R, Ma H,Cao S,Shi T.RLRF:Reinforcement learning"from reflection through debates as feedback for bias"mitigation in LLMs[J]. arXiv, 2024, 2404.10160.

[27] Peng H. A brief summary of interactions between meta-"learning and self-supervised learning[J]. arXiv, 2021,"2103.00845.

[28] Chen M, Tworek J, Jun H, et al. Evaluating large language"models trained on code [J]. arXiv, 2021, 2107.03374.

[29] 韩悦,赵晓伟,沈书生.人机协同调节:复合脑视角下自我调节学习的新路径[J].电化教育研究,2024,45(05):20-26+34.

[30] 刘红霞,李士平,姜强,等.智能技术赋能自我调节学习的内涵转型、制约瓶颈与发展路径[J].远程教育杂志,2020,38(04):105-112.

[31] 戴岭,赵晓伟,祝智庭.智慧问学:基于ChatGPT的对话式学习新模式[J].开放教育研究,2023,29(06):42-51+111.

[32] Li J, Ren X, Jiang X, et al. Exploring the Use of ChatGPT in Chinese Language Classrooms [J].International Journal of Chinese Language Teaching,2023,4(03):36-55.

[33] 金旋.ChatGPT深度融入国际中文教育的应然功能、实践困境和应用策略[J].云南师范大学学报(哲学社会科学版),2023,55(04):52-58.

[34] 宋飞,郭佳慧,曲畅.ChatGPT在汉语作为外语教学中的应用体系及实践[J].北京第二外国语学院学报,2023,45(06):110-128.

Research on Constructing Self-Correction Paths for Large Language Models under the Theory of Self-Regulated Learning

YUAN Ruiting,YANG Youna,SHI Haoran

(Editorial Department of the Journal,Pu’er university,Pu’er" 665000,Yunnan;Pu’er Youth Extracurricular Activity Center,Pu’er" 665000,Yunnan;School of International Chinese Language Education,Yunnan University,Kunming 650000,Yunnan,China)

Abstract:This paper explores the application of Self-Regulated Learning (SRL) theory and Large Language Model (LLM) self-correction techniques in international Chinese education. It reviews the development and existing issues of large language models such as ChatGPT, including AI “hallucinations.” The paper analyzes Reinforcement Learning from Human Feedback (RLHF) as a method to optimize model interaction performance, highlighting its reliance on human guidance and insufficient self-regulation capabilities. It traces the development of SRL theory and discusses its application prospects in intelligent learning environments. Centered on SRL theory, the paper proposes a new framework for LLM self-correction based on SRL, discussing its application in international Chinese education, including self-supervision and contrastive learning, metacognitive analysis, and personalized error correction and tutoring for learners. By integrating SRL theory with LLM self-correction techniques, this paper provides a theoretical framework to guide LLM self-correction, promoting the deep integration of ChatGPT into international Chinese education.

Keywords:self-regulated learning;large language model;human-computer interaction;international chinese education;chatGPT

基金项目:普洱学院2023年度校级一般项目:自我调节学习理论下的chatGPT人机交互学习方案研究(PEXYXJYB202344)。

作者简介:袁睿廷(1996-),男,云南曲靖,硕士,研究方向:国际中文教育人工智能智慧教学;

" " " "杨优娜(1991-),女,云南普洱,本科,二级教师,研究方向:教育学和小学教育教学;

" " 施浩然(2000-),男,浙江温州,在读研究生,研究方向:人工智能与国际中文教育。