基于多层感知机和近端策略优化的滚动轴承故障诊断方法

2024-02-20吕渊张西良

吕渊,张西良

(江苏大学 机械工程学院,江苏 镇江 212013)

滚动轴承是工业生产中应用广泛且极其重要的部件,研究滚动轴承工作状态及其故障诊断方法有利于提升设备的稳定性,预防设备发生严重故障。滚动轴承在运行过程中出现磨损、腐蚀,甚至损坏等异常情况时,其振动信号幅值将逐渐升高。传统的轴承故障诊断方法通过提取振动信号的时、频域特征进行分析并判断轴承性能是否衰退以及是否发生故障:文献[1]提出基于自适应自相关谱峭度图的滚动轴承故障诊断方法,通过谱峭度对振动信号进行人工判别;文献[2]提出基于改进变分模态分解的滚动轴承故障诊断方法,采用模态分解进行故障判别。以上基于人工判别的方法需要专业的专家知识,面对庞大数据时低效且无法满足要求,人工智能算法的优势逐渐凸显:文献[3]提出基于变学习率多层感知机的轴承故障诊断方法,在不同学习率下观测了多层感知机的诊断效果;文献[4]采用深度学习卷积神经网络结合支持向量机进行故障诊断;文献[5]提出基于BP神经网络的滚动轴承故障诊断。

然而,深度学习模型的泛化能力不强。强化学习具有自主学习以及强大的数据处理能力,能够充分挖掘数据中的有效信息,从而准确诊断滚动轴承的故障类型,是目前主流的滚动轴承故障诊断方法[6]。基于价值函数的强化学习方法中比较典型的为Q 学习、深度Q 学习:文献[7]提出基于深度Q 学习策略的旋转机械故障诊断,利用深度学习提取信号特征,拟合当前状态对应的Q 值,形成深度Q 学习模型完成对信号的诊断,识别准确率达到78%;文献[8]将深度Q 学习和连续小波变换结合,通过卷积神经网络拟合Q 函数,将环境返回的状态输入深度Q 网络中学习故障数据具体的状态特征表示,并据此表征学习策略,在样本量有限的旋转机械故障中诊断优势突出;另外,文献[9]提出了基于多尺度注意力深度强化学习网络的行星齿轮箱智能诊断方法,文献[10]提出了多Agent 深度Q 学习和模糊积分的行星齿轮箱故障诊断方法,文献[11]提出了基于SAE 与深度Q网络的旋转机械故障诊断方法,文献[12]提出了基于改进DQN网络的滚动轴承故障诊断方法。以上基于价值函数的方法能够较好的实现滚动轴承故障诊断,但仍存在策略固定,无法应对随机策略、策略微弱变化导致的维度爆炸等问题,直接影响模型的稳定性和泛化能力。

强化学习的本质是学习策略,基于价值函数的方法通过学习价值函数或动作函数间接学习策略,导致其在连续空间和维度上存在很大缺点,同时动作的微弱变化直接影响策略函数是否选取动作,存在一定弊端;基于策略函数的方法直接建立策略函数模型,采用策略优化方式进行学习,文献[13]提出了基于策略梯度的智能体,解决了因动作空间过大而无法收敛的问题,文献[14]进一步解决了步长带来的学习过程过缓问题,但仍存在难以选取惩罚系数的问题,文献[15]提出的近端策略优化(Proxi⁃mal Policy Optimization,PPO)方法则消除了步长带来的影响并解决了系数选取问题。因此,本文基于多层感知机(Multi−Layer Perceptron,MLP)网络构建强化学习智能体以增强特征提取能力,基于近端策略优化方法进行策略梯度优化并对故障诊断目标进行函数拟合,从而实现滚动轴承故障诊断。

1 近端策略优化

1.1 强化学习

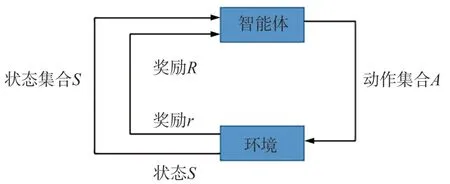

强化学习是智能体不断与环境进行交互,通过反馈奖励更新策略的马尔可夫决策过程,主要由集合{S,A,P,R}组成,其原理为:智能体利用转移概率矩阵P选择动作集合A,动作A选择与环境交互后改变状态集合S,同时智能体获取环境给出正负奖励R并更新状态转移矩阵P[16],如图1所示。

图1 强化学习原理图Fig.1 Schematic diagram of reinforcement learning

图2 基于AC(Actor−Critic)框架的学习网络Fig.2 Learning network based on AC(Actor−Critic)framework

1.2 策略梯度及其评估函数

策略梯度是一种基于策略函数,函数π采用神经网络π(s|θ) =a将状态s映射到动作a。π代表策略,a代表概率值,a值越大,代表对应动作被选中的概率越高。在学习过程中,学习对象为一组动作序列τ =(s0,a0,s1,a1,…,sT,aT),其发生的概率为

对该完整序列,经过环境与智能体交互获得的奖励总和记为R(τ)。对于给定参数θ的策略,其加权和的奖励为

在环境与智能体交互中,每次奖励的大小会通过权重参数η更新θ,即

由于θ同样会影响奖励的大小,需要求解最佳的策略参数θ以获得最大奖励。因此,以奖励函数的期望公式作为目标函数对θ进行求导,即

基于策略函数的优势在于:当动作集合A越来越大时,能够高效找出此刻对应的动作, 进而与环境进行下一步参数更新,从而有效解决滚动轴承故障诊断数据量大,特征提取困难等问题。

1.3 近端策略优化

近端策略优化是一种策略梯度算法,对步长较敏感,因此选择合适的步长是算法的关键。在训练过程中,新旧策略的差异过大或过小均不利于学习。近端策略优化提出的新目标函数可以在多个训练步骤中实现小批量的更新,从而解决了策略梯度算法中步长难以确定的问题。与信任区域策略优化(Trust Region Policy Optimization,TRPO)算法使用自然梯度下降计算参数不同,PPO−Clip 算法通过裁切动作似然比例实现KL 散度的约束,其目标函数可表示为

式中:ε为超参数,通常设为0.1 或0.2;rt(θ)的加入是基于重要性采样,保证数据的充分利用和学习效率的提升,用于生成策略的数据可以重复利用且同时保证数据的一致性,使策略参数由θ′向θ更新;Ât为优势函数;Vϕ(st)为st时刻的期价值;γ为折扣系数。

近端策略优化方法在实际训练过程中基于AC(Actor−Critic)框架,需要引入一个价值网络,单独于环境进行互动,策略网络利用价值网络生成的参数进行训练,从而达到数据的重复利用并提高训练效率,进而快速准确地找到最佳策略。

2 基于多层感知机和近端策略优化的滚动轴承故障诊断方法

设训练数据集为T={(x1,y1),(x2,y2),…,(xn,yn)},xn为第n个训练样本,yn为第n个样本的真实标签,采用AC 框架并基于多层感知机网络构建强化学习智能体,将滚动轴承故障诊断看作智能体的识别过程,即由集合{S,A,P,R}组成一个序列决策任务[17−19],采用近端策略优化方法进行真实标签拟合。

2.1 AC框架网络

近端策略优化算法基于AC 框架,即智能体由策略网络(Actor−network)和价值网络(Critic−network)组成[20],策略网络负责与环境互动收集样本,包含2 个多层感知机网络,一个与环境进行交互,另一个进行参数更新;价值网络负责评判动作好坏,包含1 个多层感知机网络,输入为环境的状态,输出为该状态的价值。

由(7)式可知,价值网络对当前序列进行评估并给出当前评估的价值结果Vϕ(st),策略网络则获取当前序列的平均。为提高训练的准确性,将二者的结果进行结合,即将当前序列相对于价值网络评价结果的优势记为实际奖励。

2.2 基于MLP-PPO的故障诊断模型

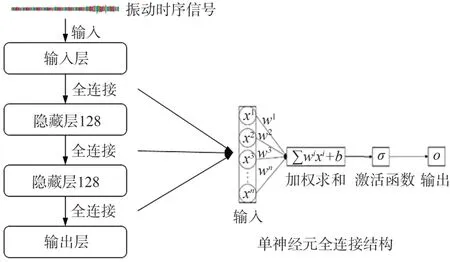

基于多层感知机的智能体内部神经网络结构主要包含输入层、2层隐藏层和输出层,各层之间为全连接结构,每层都有自己的权重系数,如图3所示。

图3 基于多层感知机的智能体网络结构Fig.3 Structure of agent network based on multi−layer perceptron

网络各层均包含多个神经元,输入神经元X=[x1,x2,…,xn],神经元权重W=[w1,w2,…,wn],对神经元添加偏移量可得其隐式特征值,即

特征值通过激活函数运算后输出。

本方法包含2个多层感知机神经网络,价值网络输出当前价值至策略网络并用于奖励期望计算,策略网络依据期望大小更新策略。

2.3 滚动轴承故障诊断的主要步骤

滚动轴承故障诊断流程如图4所示,主要步骤如下:

图4 基于MLP−PPO的故障诊断流程Fig.4 Flowchart of fault diagnosis based on MLP−PPO

1)对网络输入数据进行滤波处理,采用小波变换去除噪声,同时对数据进行重整后分成训练集和测试集。

2)构建交互环境,设置多层感知机智能体中策略网络、价值网络的层数和神经元个数。

3)设置智能体与环境迭代次数、奖励大小以及单次数据训练的步长。

4)在智能体与环境交互中,智能体获取当前最新数据并由策略网络生成策略参数和平均奖励总和,策略网络数据同时批量更新至价值网络并由其当前参数更新评价结果,与策略网络生成的带权重奖励结合从而生成当前序列的实际奖励。

5)完成单次更新后,由价值网络进行重要性采样,获取新一批数据并进行计算,当达到训练次数后完成第一批数据训练,智能体再次更新数据源。

6)当所有数据训练完成后,计算当前策略的损失函数是否满足要求。

7)模型训练完成后,利用测试集进行效果验证并保存生成的结果。

3 试验分析

试验基于Windows10 系统,CPU 为Intel Core i7−9700f,GPU 为NVIDA RTX308016G,采用python 编程以及深度学习框架pytorch,基于Ope⁃nAI gym搭建环境。

MLP−PPO 模型包含3 个多层感知机网络,每个网络包含2 层大小均为128 的隐藏层并采用全连接方式进行连接,策略网络中隐藏层的丢弃率为0.2,各层间采用ReLU激活函数,价值网络输出层的激活函数为Softmax,用于策略网络中更新参数θ的学习率参数α为0.0003,权重λ为0.95,动量γ为0.99,迭代次数为1000,单步更新参数为3,单步输入数据量为16,原始数据被切割为单份1024大小的样本。

3.1 试验数据集

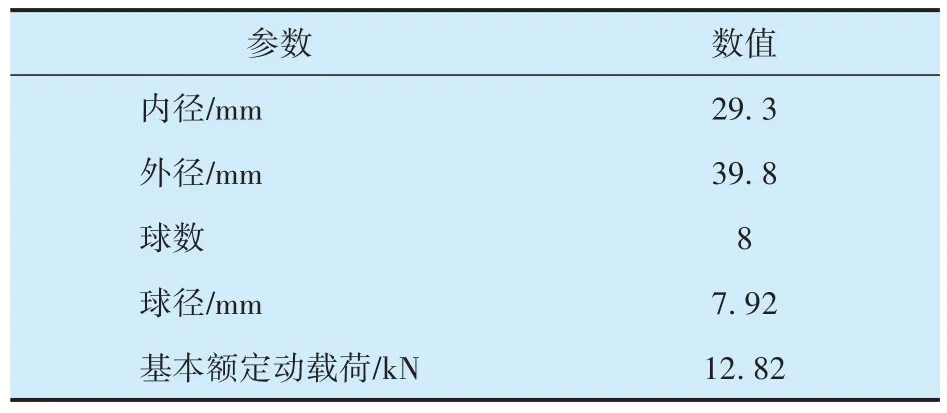

采用西安交通大学滚动轴承加速寿命试验数据集XJTU−SY[21]验证MLP−PPO 模型的有效性,选取工况1(转速2100 r/min,径向载荷12 kN)的数据进行试验,试验轴承型号为LDK UER204,其具体参数见表1;采样频率为25.6 kHz,采样间隔为1 min,每次采样时长为1.28 s,具体工况信息见表2。

表1 LDK UER204轴承参数Tab.1 Parameters of LDK UER204 bearing

表2 XJTU−SY数据集工况1具体信息Tab.2 Specific information of condition 1 in XJTU−SY dataset

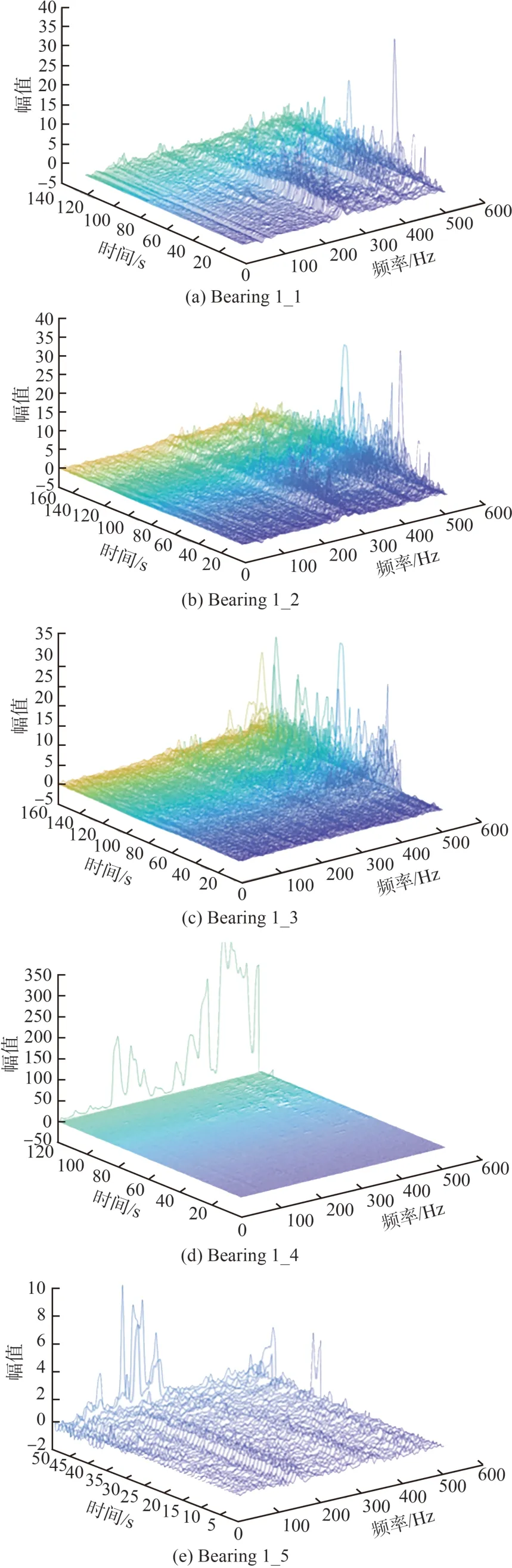

工况1 各轴承振动信号的时频域波形如图5所示:在相同工况下,轴承不同位置出现故障时,其振动信号呈现不同的趋势,发生故障的时间以及振动幅值存在差异;随着时间变化,轴承出现损伤时对应的故障特征频率处能量加强,不同故障轴承的故障特征频率及振幅均存在差异。

图5 工况1各故障轴承的振动信号Fig.5 Vibration signals of each faulty bearing in condition 1

3.2 试验过程

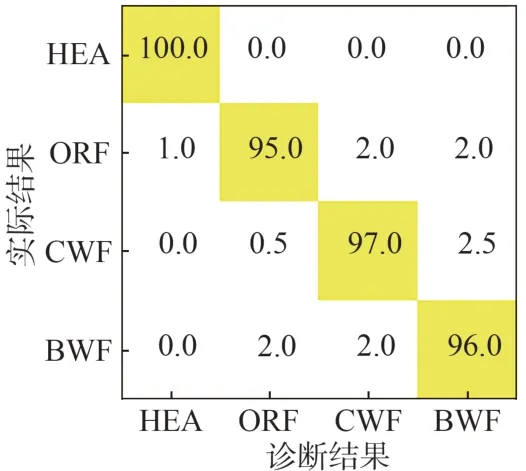

本次试验对数据集进行故障分类,其中包括1类健康状态(HEA),3类滚动轴承故障:外圈故障(ORF)、内外圈复合磨损故障(CWF)、保持架故障(BWF)。

实际训练中选取每个故障类型的最后2次采样数据作为训练对象,原始数据中单个样本的数据格式为1*32768, 数据量较大且需要在训练过程中添加标签,为有利于数据迭代训练并尽可能使用完整数据,通过拆分重组将数据格式重整为30*1024,即输入动作空间的数据格式为N*1024,N为实际所需训练的样本数量。实际训练得到的模型准确率如图6所示。

图6 MLP−PPO模型训练准确率Fig.6 Training accuracy of MLP−PPO model

3.3 试验结果

从传统机器学习、深度学习、强化学习中选取代表性的方法进行对比分析,各网络的参数设置如下:

1) 支持向量机(SVM),利用主成分分析将振动信号降维至4个特征,利用SVM 进行识别,其采用高斯径向基核函数,核系数为 0.01;

2) 卷积神经网络(CNN),设置2 个卷积层,2 个池化层和1 个全连接层,卷积核尺寸为3*3,激活函数为ReLU;

3) 深度Q 学习(DQN),智能体采用多层感知机,设置一层隐藏层,激活函数为ReLU,迭代次数为20000。

各模型在训练集、测试集上的故障诊断准确性以及训练耗时见表3:本文所提MLP−PPO 模型的准确率为96%(混淆矩阵如图7 所示),与SVM,CNN 和DQN 模型相比准确率分别提升了31%,24%和18%;MLP−PPO 模型中智能体与环境之间需进行大量数据信息交互,因此其训练耗时大于其他模型,但模型训练完成后的实际诊断耗时仅1 s,能够较快速的完成故障诊断任务。

表3 基于不同模型的故障诊断结果Tab.3 Fault diagnosis results based on different models

图7 MLP−PPO对测试集诊断结果的混淆矩阵Fig.7 Confusion matrix of test set diagnostic results of MLP−PPO model

4 结束语

基于强化学习策略函数理论,提出了基于多层感知机和近端策略优化的滚动轴承故障诊断方法,利用多层感知机构建强化学习智能体并通过近端策略优化算法,实现对不同工况下滚动轴承的故障诊断,其具备以下优点:

1) 利用强化学习自主挖掘信息优势,充分挖掘数据特征,结合策略梯度优势可以很好地拟合故障诊断目标函数,无需人工干预且自主完成滚动轴承故障诊断。

2) 结合AC 框架,充分利用多层感知机网络完成智能体与环境的互动,自主学习的模式充分提升了滚动轴承故障诊断的准确性。

3) 与传统的SVM,CNN 以及基于价值函数的DQN方法相比,MLP−PPO的故障诊断准确率更高。