小型数据中心混合冷却系统节能改造探究

2023-11-09郑洪斌陈以乐黄林生

郑 亮, 郑洪斌, 陈以乐, 黄林生

(1. 澳门科技大学 人文艺术学院, 澳门 999078;2. 广州志广信息科技有限公司, 广东 广州 510425;3. 莆田学院 土木工程学院, 福建 莆田 351100 )

0 引言

数据中心作为网络活动的硬件支柱和建筑设备的细分领域, 其节能降耗是绿色建筑可持续发展的主要研究方向之一。 在数据中心的各个设备中, 冷却系统的能耗占比高、 可优化空间大, 通过改善数据中心的制冷系统, 进而降低能耗, 实现电源利用效率(power usage effectiveness,PUE)的目标是目前数据中心可持续发展的必要措施[1]。 此外, 随着电力检测技术的持续升级和完善, 智能电网建设与节能改造逐渐成为城市发展的重点之一[2]。

数据中心液冷技术现已衍生出冷板式、 浸没式和喷淋式3 种主要类型, 但因技术门槛高, 目前大部分项目仍在试验阶段, 面临众多挑战[3]。冷板式虽能应对大温差散热, 但液体残留问题明显[4]; 直接蒸发式可能导致设备性能下降[5];浸没式要求氟化液(冷却液)纯度高, 且设备焊接处无残留, 以防长期腐蚀[6]; 相变冷却技术缺乏统一标准, 并且环保问题也有待解决[7];喷淋式液冷技术通过将特殊冷却液直接喷淋到高热负荷设备上实现高效散热, 虽具备高集成度和节能优势, 但也面临冷却液选择与维护成本高,系统复杂及潜在泄漏风险的挑战[8]。 综上, 数据中心液冷技术仍存优化空间。 混合冷却却系统结合了风冷与液冷的优势, 能耗较低, 无需大型风冷系统和大量氟利昂冷却剂。 混合冷却系统制冷效率高, 其温水(60℃)废热可直接作为热源[9]。 自2020 年技术改进后, 数据中心液冷系统采用此混合冷却模式后节能效果显著[10]。

本文以广东某数据中心为例, 需解决的问题包括: 1)亚热带湿热气候限制了自然冷却的利用, 小型数据中心需要灵活利用夏冬季的气候条件; 2)拥有该数据中心的企业在广东共有890 多个小型数据中心, 单个面积为20 ~50 m2, 建造成本低, 因此需要更经济的改造策略来达到收支平衡; 3)基于经济适用的原则, 原有的服务器等贵重设备应尽可能地保留和重复利用, 空间上避免大拆大建, 因此需要场地干扰较小、 经济效益较高的改造方案。 为此, 高效的混合冷却系统是本文的研究重点。

1 混合冷却系统技术概况

数据中心风冷散热的方法受限于空气本身低密度和低散热的属性, 基本上属于低效的冷却方法。 随着高性能微处理器在服务器机架内的安装越来越密集, 风冷散热的缺点变得越发明显。 采用风冷散热的数据中心, 按其散热能力上限, 只能容纳15~20 kW 负载的单机柜, 而现在超算数据中心的单机柜一般负载超过65 kW。 更高性能的数据中心需要更高效率的散热方法, 液冷是有效的方法之一。

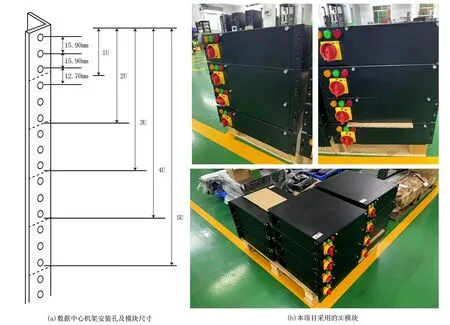

考虑到我国数据中心正处于新旧过渡期, 本研究采用混合冷却系统, 目标是将年均PUE 优化至1.3 及以下, 以实现绿色机房标准。 具体策略包括: 尽量利用老旧设施以降低成本; 确保新旧设施兼容以提高数据安全性; 采用低噪音设计以减少干扰; 室内外系统采用无污染冷却液; 优化面板设计以便运维; 推荐模块化设计, 如3U或5U 模块(参见图1, 图1(a)为不同U 型模块的尺寸说明, 图1(b)为本项目所采用的3U 模块)。

图1 数据中心模块尺寸及实物图(自绘及自摄)

采用混合冷却的数据中心需要在封闭和受限的环境中运行, 以避免灰尘、 污垢、 液体、 湿度、 温度以及电磁干扰等对数据中心中高精密设备的影响。 同时还要考虑工程师日常维护的便利性, 尽可能降低能源消耗。 在广东某数据中心这个项目中, 为了使采用混合冷却的数据中心在适宜的环境中稳定运行, 采取了以下3 个主要策略: 1)设计兼容性强的系统, 能适应多样化的计算设备安装需求, 并能与新购及原有设备兼容。 系统中冷却液可视化, 并选用电子氟化液以降低成本。 液冷模块输出温水的温度大于45℃,有助于热能回收利用。 此外, 由于采用密闭的箱子安装设备, 不存在机房空调加湿用自来水的问题, 可以节省自来水, 减少了水资源的浪费。2)在能源利用效率方面, 系统通过局部处理,即液冷环境局限于液冷模块中, 而不是整个机房环境, 同时取消了设备内部的电子风扇耗能, 尽量将制冷需求限制在局部系统内, 提高了电能效率, 并减少了运营成本。 系统封闭式的计算空间装置增强了设备的安全性, 减少了外部灾害及电磁泄漏的影响。 设备在干净、 温度稳定的环境中运行, 不受环境的灰尘、 水分、 热量、 电磁电场的影响, 延长了设备使用寿命, 也降低了维护清理的需求。 此外, 该系统实现了机房内设备的静音运行, 减少了噪音对操作员及附近居民的影响。 3)在灵活性和可维护性方面, 系统“即插即用” 的设计支持根据业务需求灵活增减和拆装, 易于技改, 确保了现有机柜布局和线缆位置的兼容性, 减少了操作和维护的工作量。 同时,系统对零部件供应和耗材采购采取开放制度, 便于维修和维护。 最后, 系统不仅能冷却机房设备, 还能冷却包括机架式不间断电源(uninterruptible power supply, UPS)在内的整体设备, 满足小型机房设备的多样性及整体年均PUE 的要求, 并提供了多种规格以满足各设备需求。

2 混合冷却系统节能设计

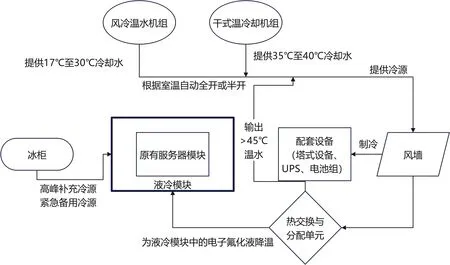

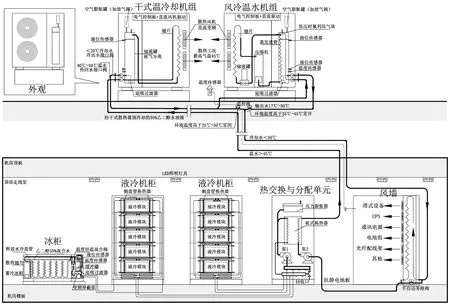

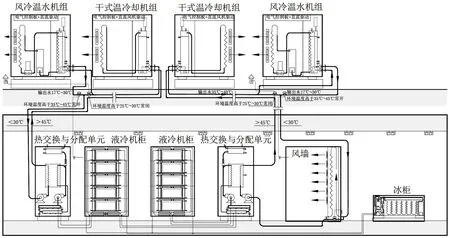

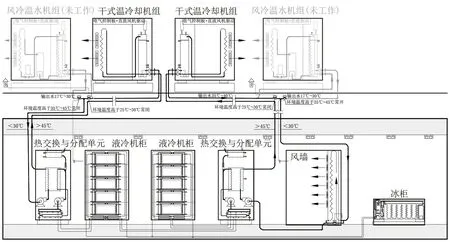

数据中心混合冷却系统主要由液冷模块、 冰柜、 风墙、 室外机组4 个部分组成, 其逻辑流程如图2 所示, 节能原理如图3 所示, 下文将具体分析其主要技术节点。

图2 数据中心混合冷却系统逻辑流程图(作者自绘)

图3 数据中心混合冷却系统节能原理图(作者自绘)

(1)液冷模块。 在最大程度上保留原有设备的基础上, 将现有的服务器模块整合并密封于液冷模块中。 此过程涉及以电子氟化液为冷却液的半浸没液冷技术, 该技术允许电子氟化液直接与服务器硬件接触, 实现高效直接冷却(若原有服务器中含有非密封的机械硬盘应替换为固态硬盘或密封机械硬盘, 以保障系统的安全性和稳定性)。 电子氟化液是一种具有优越热传导性能的化合物, 在遇到高温时会迅速挥发。 挥发后的气态分子通过冷凝系统与冷却液进行热交换后再度液化, 形成一个闭合的冷却循环。 这一独特的冷却循环系统不仅大大增强了数据中心的冷却效率,还优化了能源利用, 实现了显著的节能效果。

(2)冰柜。 普通冰柜经过改造后即可投入使用。 与专门定制的制冷机组(通常价格超过50 万元)相比, 改造后的普通冰柜(价格大约1 万元)不仅具有成本低廉、 维护简单的优势, 还极具实用价值和灵活性。 改造后的普通冰柜在液冷系统中主要发挥3 个方面的重要作用: 1)在夏季高温时期, 由于室外温度升高, 常规室外机组的制冷效率会大大降低。 这时, 可以利用冰柜内储存的冷盐水为液冷模块提供辅助冷却, 以应对高温带来的附加冷却需求。 2)可在夜间低电价时段让冰柜制冰, 在日间高电价时段利用夜间制好的冰辅助冷却相关设备, 以此达到平滑电网负荷、节省电费开支的目的。 这种智能化的能源管理策略, 有助于降低数据中心的运行成本, 提高数据中心的能源效率。 3)在遇到意外停电或其他紧急情况时, 冰柜内储存的冷盐水和冰块能够满足服务器0.5~2.0 h 的冷却需求, 确保数据中心的正常运行, 避免因温度过导致硬件损坏和数据丢失。

(3)风墙。 除了对主要的服务器模块采用液冷技术进行高效散热外, 本研究还综合考虑数据中心内其他设备的冷却需求。 一些大型塔式设备、 UPS 以及耗能小于50 W 的低能耗设备, 发热量相对较低且具有较好的耐热性能, 纳入液冷系统中会显著增加改造成本, 因此选择采用更为经济实用的高效风墙进行集中散热。 与传统的风冷系统相比, 优化设计后的风墙系统更为高效且环保。 该风墙系统由室外冷却机组提供冷源, 与外部环境空气隔离开来, 不会直接将外部空气引入数据中心。 这一设计减少了外部空气污染物对数据中心设备的潜在损害, 避免了因空气质量问题导致设备损耗, 产生维护难题, 亦避免了室内的噪声污染。

(4)室外机组。 由风冷温水机组和干式温冷却机组构成。 这两种机组的主要区别体现在功耗和制冷效率上, 风冷温水机组的功耗相对较大,而干式温冷却机组的功耗则较低。 在制冷效率方面, 风冷温水机组能够提供17 ~30℃的冷却水,而干式温冷却机组所提供的冷却水温度则是35~40℃。 鉴于这两种机组在功耗和制冷效率上的不同特性, 可以根据实际需要动态调整它们的运行模式以实现最优的冷却效果: 1)当环境温度>25℃时, 干式温冷却机组和风冷温水机组将协同运作, 以确保数据中心内的温度稳定, 并通过优化能耗实现更加经济高效的运行(图4)。 2)当环境温度<20℃时, 系统将主要依靠干式温冷却机组, 实现零水消耗制冷(图5)。 此模式利用自然通风进行冷却, 最大程度上降低了能源消耗,推动了数据中心的绿色可持续发展。

图4 环境温度>25℃时数据中心混合冷却系统运行状况(作者自绘)

图5 环境温度<20℃时数据中心混合冷却系统运行状况(作者自绘)

在小型数据中心混合冷却系统高效运行与管理的进程中, 液冷模块和相关装置发挥了关键作用, 下面具体说明相关模块与装置的设计与配置。

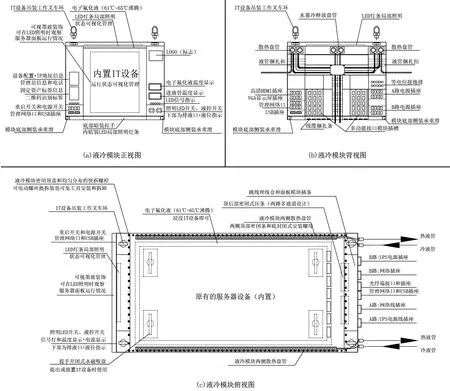

(1)液冷模块设计。 适配主流IT 设备, 深度适配不同服务器, 布局紧凑, 减少电子氟化液的用量。 系统输入电源功率为220 V, 标准双路配置为输220 V 和32 A, 高功率配置为220 V 和63 A 双路。 液体管路采用1.5 寸(5.0 cm)输入输出接口, 水冷液体输入温度控制在40~45℃, 输出温度为60 ~65℃, 电子氟化液体气化温度为61~65℃, 外部配有热交换与分配单元。 单个液冷模块尺寸为3U 所示或5U, 流量分别为1~8 L·min-1或1~15 L·min-1。 内循环液体为3M 电子氟化液或变压器油, 外循环液体为含35%乙二醇的3M 缓和蒸馏水或工业去离子蒸馏水。 前门钢化玻璃和前面板设计便于维护、 检查、 隔离和保持温度稳定。 液冷模块相关部件及其分布情况如图6 所示。

图6 液冷模块三视图(作者自绘)

(2)热交换和分配单元设计。 该单元连接系统室内外两部分, 利用35%乙二醇混合液实现高效热交换, 为液冷模块的电子氟化液降温; 将>45℃的乙二醇混合液输送至户外干式温冷却机组,待乙二醇混合冷却却(<30℃)后回收。 该单元采用50 kW 的永磁高速泵进行自适应调节, 还回收和过滤电子氟化液以减少资源浪费; 通过前门触控屏实时监控设备温度和运行状态, 并与室内水冷空调兼容, 调节机房温度, 达到优良的节能效果。

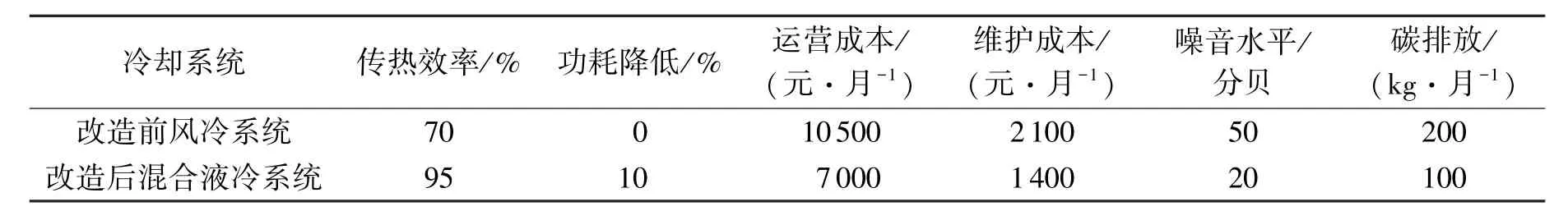

(3)液冷机柜设计。 机柜尺寸为高2200mm,宽600 或800 mm, 深1 300 或1 400 mm, 适应19英寸(48.26 cm)设备, 便于维护。 取消内置风扇以降低能源消耗, 前后配置转接跳线和插接端口以提高操作便利性。 采用3U 和5U 设计, 兼容1U 至5U 设备, 内置12 个3U 机架箱和8 个5U机架箱。 整个机柜承载重量>800 kg, 抗震设防烈度7 度。 电子氟化液浸没冷却传热效率可达95%, 能效高。 去除风扇使功耗降低10%, 也降低了噪音。 见表1。

表1 液冷机柜改造前后参数比较

(4)干式温冷却机组设计。 干式温冷却机组由冷冻机、 蒸发器、 压缩机和冷凝器组成, 采用低噪音直流变频永磁风机, 35 ~50℃液体自调速散热, 自动调节冷却模式; 利用风机降低乙二醇混合液温度并回收该混合液, 进而实现数据中心的冷却; 安装灵活, 适合轻量化设计, 满足<50 kW 设备的冷却需求。

3 混合冷却系统配套设备改造

为了提高数据中心混合冷却系统的能效, 节约能源, 降低运行成本, 提高数据中心的稳定性和可靠性, 特进行供能设备改造、 耗能设备改造、配线区域改造和塔式设备改造。

(1)供能设备改造。 数据中心的供能设备改造可显著提高能源效率, 降低运营成本, 同时降低对环境的不良影响。 其改造策略包括: 采用有自动灭火功能的锂电池包以增强安全性; 采用机架式20 kVA 的UPS 以提高供电可靠性, 循序渐进地更新塔式UPS 设备并逐渐“锂进铅退”, 推广使用超级旁路的UPS 设备并考虑采用天然气发电机组来实现快速应急供电; 以及利用谷价电力进行夜间蓄冷、 白天释放冷源, 实现节省运营成本的效果。

(2)耗能设备改造。 为了有效冷却数据中心, 采用了有针对性的耗能设备改造策略。 首先, 通过液冷技术, 确保核心电子设备如GPU和CPU 在61 ~65℃以下稳定运行, 同时使用不锈钢板式换热器和循环变速水泵将热量高效传导到外部的干式温冷却机组。 这不仅能有效降低机房温度, 而且通过连接壳管换热器, 还能为建筑内的办公活动提供了余热, 进一步实现环保节能。 此外, 为了高效散热和平稳运行, 户外风冷温水机组要设计得便于安装, 并采用低噪音技术, 配置冷凝器补液和膨胀液箱, 确保系统平稳、 低噪音运行。

(3)配线区域改造。 配线区域的改造旨在为液冷技术的应用预留液管布线空间, 提高布局灵活性, 同时让混合冷却系统相关设备尽量靠近耗能设备, 减少线缆传输损失, 在确保冷却效果的同时节省电力。 改造策略还包括: 采用高效的MPO/MTP 光纤配线架, 实现高密度FTTX 和40/100 G SFP 连接; MTP/MPO 光纤跳线广泛应用于高密度布线系统, 利用其小空间占有率, 节省安装时间和成本; 采用封闭式安装, 配置G4空气过滤器, 以提高光纤界面的洁净度, 从而实现更高效、 节能的布线管理。

(4)塔式设备改造。 为适应液冷工作方式,改造塔式设备(纵向排列的高密度计算机服务器)。 主要改造策略有: 1)合理配置, 如在小型机房功率为12 kVA 的情况下避免配置100 kVA的UPS 设备, 减少能源浪费; 2)减少冗余, 例如使用10U 或15U 的定制箱体配备浸没式液冷散热系统, 对大体积的交换设备采用有机玻璃封闭的温水行间级空调系统, 并逐步淘汰大体积交换机。

4 结语

小型数据中心的能效与其运行成本、 环境成本密切相关。 混合冷却系统不仅能成功降低数据中心的温度, 确保硬件正常运行, 还能提高能效。 通过对数据中心内部的供能设备、 耗能设备、 配线区域和塔式设备进行有针对性的改造,进一步优化了混合冷却系统的性能, 实现了液冷机柜的节能效果。

本文探讨了液冷技术的各种类型, 提出了多种针对性的改造策略, 为数据中心混合冷却系统的进一步研究和应用提供了参考。 综合考虑, 混合冷却系统在数据中心的应用展现出强大的性能优势和实用性, 可以满足数据中心高效、 节能且环保的冷却需求。