基于光照感知的多光谱融合行人检测方法

2023-10-07彭沛然任术波李佳男周鸿伟许廷发

彭沛然, 任术波, 李佳男, 周鸿伟, 许廷发*

(1.北京理工大学 光电学院, 北京 100081; 2.中国空间技术研究院 通信与导航卫星总体部, 北京 100094)

0 引言

行人检测是计算机视觉领域的重要任务之一,其主要研究目标是准确识别和定位图像中的行人目标。该技术已广泛应用于自动驾驶[1]、无人机智能巡航[2]和机器人智能控制[3]等多种实际场景,并为人体行为识别和人体动作理解等研究提供了理论基础[4]。然而,传统基于可见光图像的行人检测方法受到光照、天气变化或遮挡物等因素的干扰,从而降低了智能装备的可靠性[5]。为了解决这一问题,热红外图像被广泛用作补充信息,以提高在低光照条件下的检测精度。此外,将可见光与红外图像进行融合可以进一步提升在复杂光照环境下的检测性能,使其具有全天候应用价值和重要的学术意义。韩国科学技术院(KAIST)提出了一个多光谱行人数据集[6],其包含大量完全重叠的可见光和热红外图像对。因此,该数据集作为基准数据集,被广泛使用于相关研究中[6-13]。

尽管现有方法在可见光图像与热红外图像融合任务上取得了一定进展,但大多数方法仍未能切实解决两个显著的挑战。首先,可见光图像和热红外图像在目标属性上存在内在差异,前者与颜色相关,后者与温度相关。因此,如何准确、高效地利用两种光谱特征表达仍然具有一定难度。其次,在可见光与热红外图像中,普遍存在由于传感器差异所引起的光谱特异性噪声问题。当使用可见光传感器采集图像时,低照度环境会限制传感器对光线的敏感度,从而产生传感器噪声。这种噪声容易导致背景与目标之间提取的特征产生混淆。另一方面,使用热成像传感器进行图像采集时,可能出现热量与周围环境相近所导致的目标与背景特征相混淆的情况,同时热成像目标与可见光目标相比缺少大量的边缘特征。因此,通过提取并融合两种光谱图像的内在独特特征进行检测,比单一光谱检测具有更大的优势。

针对上述问题,目前大多数方法主要集中在解决第一个问题。通常情况下,标准的融合网络会使用两个分支的卷积神经网络(CNN)分别提取两种光谱图像的特征,并通过设计融合方法将这些特征信息直接合并。例如,文献[12]和文献[13]为确定最佳的融合阶段,提出了在不同阶段进行融合的网络结构。文献[11]提出了一个区域特征对齐模块,通过对齐两种光谱图像中相应的特征区域,以提高融合的质量。文献[14]针对模态不平衡的问题,提出了一种差异化模态感知融合模块。虽然上述方法提出了各种合理的解决方案,但这些方法忽略了不同模态特征内在的相关联系,限制了融合特征的表现潜力。同时,这些方法也没有考虑到可见光与热成像光谱图像中存在光谱特异性噪声的问题,这些噪声会降低特征融合的性能。

为了解决上述问题,本文提出一种全新的光照感知跨光谱融合行人检测网络。该网络能够利用多光谱图像中的特异性特征,同时辅助决策多光谱特征信息的选择。本文方法包含三个部分:交叉注意力特征提取模块、光照感知子网络和检测头。首先,将两种不同光谱的图像输入交叉注意力特征提取模块中,通过注意力机制提取光谱间的全局共性特征,并得到两组特征金字塔。其次,由于不同光照环境下两种光谱特征的置信程度不同,将两种光谱图像输入光照感知子网络中,获得两种光谱特征的光谱权重,以实现自适应校正。最后,通过检测头得到具有两种光谱特征优势的检测结果。本文提出的方法在行人检测任务上表现出色,并且可扩展到其他跨光谱应用领域。

本文的主要贡献有如下三方面:

1) 提出了一个新颖的光照感知跨光谱融合检测网络用于多光谱行人检测。通过提出的交叉注意力特征提取模块提取两种光谱的全局共性信息,获得表达更强的目标信息特征。

2) 提出了一个光照感知自网络,通过提取两种光谱的光照信息得到光谱权重,以根据光照条件的变化自适应校正融合特征。

3) 本文提出的光照感知跨光谱融合检测网络在KAIST多光谱行人检测数据集上进行验证,与多种现存网络进行比较,取得了令人满意的检测性能。

1 相关工作

1.1 多光谱行人检测

自从KAIST多光谱行人检测数据集[6]被提出以来,基于多光谱数据的算法取得了飞速的进展[8-14]。最早的基线网络由文献[6]提出,它将聚合通道特征(ACF)[15]算法扩展到了可见-红外图像对上,并在特征提取的最后阶段融合两个子网络进行检测。随后,Liu等[12]将两个基于CNN的子网络进行融合,并设计了4种不同的网络结构,以探究最佳的融合阶段。然而,由于可见光谱更容易受到光照条件的影响,Li等[9]提出了一种基于光照的权重分配机制,以更合理地融合两个光谱子网络。跨模态交互注意力网络(CIAN)[16]为了提取可见光与红外图像的相同特征,设计了一个交叉模态交互模块,以自适应地融合两种光谱的特征。此外,为了解决可见光与红外图像对中位置偏移的问题,弱对齐卷积网络(AR-CNN)[10]设计了一个区域特征对齐模块,来对齐两个光谱的区域特征。传统的特征融合方法通常基于两个独立的分支分别提取不同光谱特征,然后直接将它们合并在一起。然而,这些方法未能充分考虑不同光谱之间的相互关系,即不同光谱对同一目标的多方位表达,从而限制了目标特征的表达潜力。因此,本文提出了一个光照感知子网络,以实现在不同光照条件下的自适应调整,并进一步提升多光谱行人检测性能。

1.2 注意力机制

注意力机制最初在自然语言处理领域提出[17],由于其出色的性能,在计算机视觉领域得到了广泛应用,包括图像分类[18]、语义分割[19]、图像捕捉[20]等任务。例如,压缩与激励网络(SENet)[18]通过利用通道特征之间的相关性,重新校准通道特征图;选择性卷积网络(SKNet)[21]设计了不同的卷积核来自适应地融合不同分支的输入信息;通道注意力模块(CBAM)[22]则依次计算了通道和空间维度的注意力图,以自适应地完善特征。对于多光谱行人检测,其中一个关键的挑战是如何在两种模态之间存在本质区别的情况下,充分利用两种模态以及它们各自的特定噪声。为此,本文提出一种交叉注意力特征提取网络,结合注意力机制,充分利用多光谱的特异性特征。

2 基于光照注意感知的跨光谱融合行人检测方法

本文提出的行人检测网络以一组可见光和红外图像对作为输入,通过交叉注意力特征提取模块来利用两种光谱的潜在关系互相辅助地提取特征。同时本文设计了一个光照感知子网络,基于光照的差异提取目标的光谱特性来进一步提高检测的精度。总体架构如图1所示。图1中,Fri和Fti(i=1~5)分别表示可见光和红外第i层的特征图,Cri和Ctji分别表示经过交叉注意力模块融合后的可见光和热成像第i层的特征图(图中未显示第5个交叉注意力模块),wr和wt分别表示输入图像被预测属于白天或黑夜的概率。下面详细解释具体的网络结构。

2.1 交叉注意力特征提取网络

在行人检测中,提取并融合有效的可见与红外光谱特征,对于准确性至关重要。然而,由于两种光谱内都存在不可避免的特异性噪声,直接融合会对特征质量产生极大影响。具体地,可见光噪声是传感器噪声,由复杂的光照条件所产生,例如低照度下传感器只能采集微弱的图像;红外噪声是温度噪声,通常由复杂的温度环境所产生,例如与周围环境相似的物体容易与周围环境混淆。为了抑制光谱特异性噪声并充分利用光谱特征之间的内在关联性,本文提出了交叉注意力特征提取模块。通过聚合并提炼两种光谱的共性特征,该模块可以抑制特异性噪声并重新校准单一光谱特征提取,如图1灰色区域所示。

由于可见光与红外传感器的成像机制,光谱特异性噪声多表现为与目标亮度或热量近似的背景环境,即容易导致目标与背景的混淆。因此,在每阶段特征提取的过程中,需要对两种光谱的中间特征进行聚合与重新标定。为防止特异性噪声干扰另一光谱特征的提取,需要在特征聚合之前过滤置信度较低的特征。在实际操作中,如图1灰色区域所示,将输入的可见光与红外图像表示Ri∈RH×W×2(H为图像的高,W为图像的宽)和Ti∈RH×W×1,每一阶段的光谱提取特征为Fri∈RHi×Wi×Ci(i为任一阶段的序号)和Fti∈RHi×Wi×Ci,其中Hi=H/(4*2i),Wi=W/(4*2i),Ci为第i阶段特征的通道数。将每一阶段的光谱提取特征输入交叉注意力模块fcross中,得到两种光谱的去噪特征Cri∈RHi×Wi×Ci和Cti∈RHi×Wi×Ci。

交叉注意力模块如图2所示,其中fmlpr1、fmlpt1、fmlpr2、fmlpt2分别为可见与红外特征的转化函数,softmax为归一化指数函数。将输入的两种光谱特征Fri和Fti进行拼接并重置尺寸得到Fci∈R2HiWiCi×1×1,分别通过两个不同的多层感知机(MLP)层后得到两种光谱的噪声权重wri∈RHiWiCi×1×1和wti∈RHiWiCi×1×1,将其分别与输入光谱特征Fri和Fti相乘,得到两种光谱的去噪特征Vri∈RHi×Wi×Ci和Vti∈RHi×Wi×Ci,公式如下:

图2 交叉注意力模块架构图

Fci=reshape(Fri⊕Fti)

(1)

(2)

(3)

式中:reshape(·)表示矩阵变换操作;⊕表示拼接操作;⊗表示通道维乘法。

将两种去噪特征进行拼接,对拼接特征Vci∈RHi×Wi×2Ci分别输入到3个不同对卷积层中,分别得到Q∈RHi×Wi×2Ci,K∈RHi×Wi×2Ci和V∈RHi×Wi×2Ci,经过注意力操作,得到最终的增强特征Cri∈RHi×Wi×Ci,Cti∈RHi×Wi×Ci,公式如下:

Vci=Vri⊕Vti

(4)

(5)

(6)

(7)

最终的公式可以表示为

Fr1,Ft1=fca(Ri,Ti)

(8)

Cri,Cti=fca(Fri,Fti)

(9)

式中:fca表示交叉注意力模块。

2.2 光照感知子网络

针对可见光和红外光谱传感器的光谱特性不同以及昼夜光照情况明显差异的特点,本文提出一种基于光照强度加权子网络的检测模型优化方法,如图1所示。该方法在模型中引入橘色区域所示的自适应调整模块,实现了在不同光照条件下的鲁棒性提升和检测精度的提高。

在实际操作中,选取第一阶段的光谱提取特征Fr1和Ft1作为输入图像。这两个特征分别经过两层卷积,得到新的特征Fr2和Ft2。然后,将这两个特征拼接起来,并通过一个调整过的S型生长曲线(Sigmoid)函数进行加权平均,以获得最终的输入图像被预测属于白天或黑夜的概率。该Sigmoid函数的参数是可学习的,因此它可以适应白天或夜晚的不同情况。预测输入图像属于白天或夜晚的权重的运算公式如下:

(10)

式中:wd和wn分别为输入图像被预测属于白天或黑夜的概率;wt、wr分别为红外特征和可见光特征的权重。

光照感知子网络的损失函数为

(11)

2.3 检测头网络

通过扩展经典的聚焦网络(RetinaNet)[23]检测头结构,得到检测头网络,其中包括两个并行分支,分别为分类分支和回归分支。两个分支中设置了不同数量的模块。分类分支上有两个模块,回归分支上有4个模块,每个模块包含一个卷积层、一个批处理归一化层和一个线性整流(ReLU)层。将两种光谱的特征金字塔Fri和Fti作为输入,将结果与光照感知权重分别相乘并求和,得到最终的检测结果S,公式如下:

(12)

S=∑(Sri×wr+Sti×wt)

(13)

式中:Head(·)表示RetinaNet中的检测头网络层。则总损失函数L为

L=λL1+Lcls+Lreg

(14)

式中:λ为常量0.1;Lcls和Lreg分别为分类分支和回归分支的损失函数。

3 实验与结果分析

3.1 实验环境配置

3.1.1 参数设置

本文的检测网络通过扩展RetinaNet网络[23],并利用其在ImageNet上预训练模型的前5个卷积层和批归一化层作为可见光与红外图像分支的初始参数。其余卷积层按正态分布初始化,取标准差为0.01,模型其他参数采用Xavier方法初始化。因为绝大多数行人目标都可以用垂直边界框来表示,所以本文将长宽比设为1/1和1/2,尺度设为[20,21/3,22/3],尺寸设为40、80、160和240。在4个Nvidia GTX 1080Ti上训练网络,每个批次大小设定为8。使用随机梯度下降(SGD)作为优化器,初始学习率为1×10-4,动量为0.9,权值衰减为5×10-4。在数据增强方面,将输入图像的大小调整为512×640,并使用随机水平翻转、随机裁剪和马赛克增强来增加多样性。

3.1.2 评价指标

使用标准漏检率(MR-2)作为评估指标,这是行人检测任务中最常用的指标,分数越低表示性能越好。由于MR-2只关注高精度区域,它更适合于评估模型的应用部署能力。此外,为了更好地说明本文方法的性能,还遵循漏检率乘每帧图像的假阳性(FPPI)[15]的标准评价,采样范围为[10-2,100]。

3.2 检测结果分析

3.2.1 数据集分析

1) KAIST多光谱行人数据集

KAIST多光谱行人数据集[6]由95 328个在不同光照条件下完全重叠的可见光和红外图像组成。提供的真值框包含1 182个实例中的103 128个行人边界框。考虑到训练数据集中标注错误,遵循文献[10]提供的标准准则,共使用25 076帧进行训练。为了进行评估,使用文献[24]重新标注的注释,它包含2 252帧,其中白天1 455帧,夜间797帧,这是与近期相关工作进行公平比较的标准。此外,训练时仅考虑身高超过50像素的行人。

2) CVC-14行人数据集

CVC-14行人数据集[25]是一个用立体相机配置拍摄的多光谱行人数据集。该数据集包含可见光(灰度)和热成像配对的图像,其中7 085帧和1 433帧用于训练和测试集,并在每种模式下提供单独的注释。然而,该数据集的作者公布了裁剪后的图像对,但没有公布非重叠区域。因此,将这个数据集视为一个完全重叠的(成对的)数据集,但仍然受到像素级错位问题的影响。使用与KAIST数据集相同的参数配置进行实验,并利用在KAIST数据集上训练得到的模型作为CVC-14数据集的预训练模型进行微调。

3.2.2 实验结果分析

1) KAIST多光谱行人数据集实验结果分析

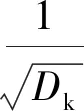

本文提出的光照感知跨光谱融合检测网络在KAIST行人检测数据集上进行了评估和比较,与目前流行的8种多光谱行人检测方法进行了对比。根据表1的数据,发现在KAIST数据集中,光照感知跨光谱融合检测网络表现最佳,综合性能排名第一。除了总漏检率、白天漏检率和夜晚漏检率外,还对其他6个评估指标进行了比较,包括近距离、中距离、远距离、无遮挡、部分遮挡和重度遮挡。在9个评估子集中,光照感知跨光谱融合检测网络占据7个第1名的位置。例如,在夜间子集中,光照感知跨光谱融合检测网络(5.99%)的准确率高于第2名MBNet(7.86%)1.87%,表明光照感知跨光谱融合检测网络在夜晚场景下具有优异的表现。此外,由于传感器与目标之间的距离变化会引起光照变化,光照感知子网络的有效性使得本文网络在不同距离下的漏检率最低。同时,本文的网络表现也在存在行人遮挡情况的所有子集中处于领先地位,证明了本文网络对遮挡问题具有显著的处理能力。交叉注意力特征提取网络能够有效筛选光谱特异性噪声,从而避免行人遮挡对检测结果的影响。每帧图像错误检测数量(FPPI)和MR-2的对数平均曲线如图3所示。

表1 KAIST多光谱行人数据集[6]的所有9个子集的漏检率比较

图3 在KAIST数据集上与8种方法FPPI曲线比较结果

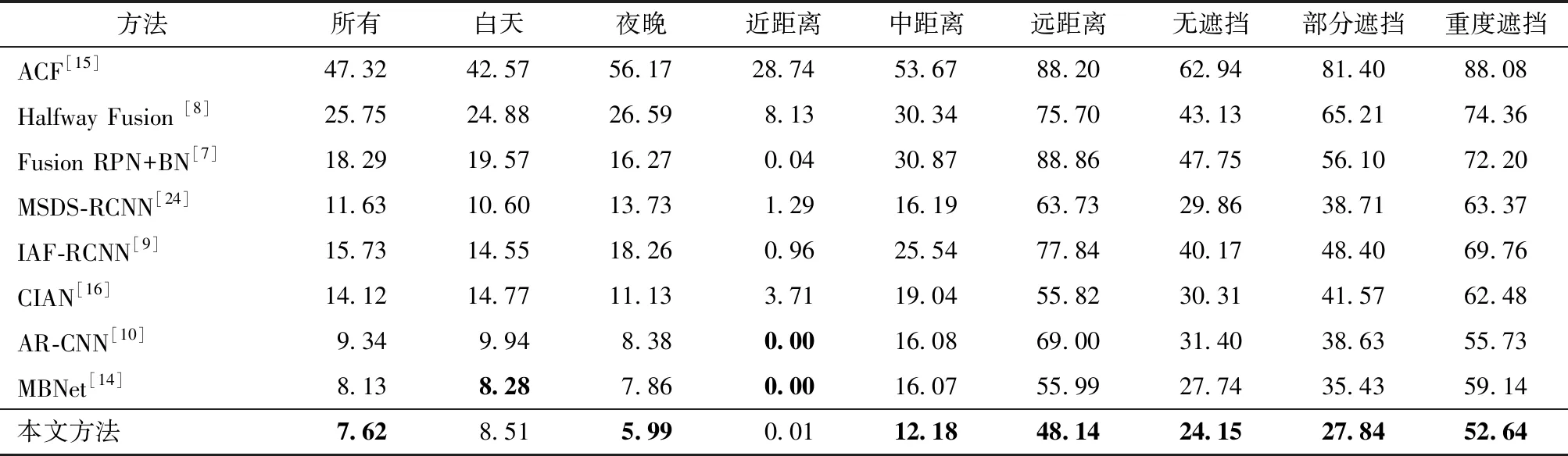

2) CVC-14行人数据集实验结果分析

在CVC-14数据集的训练中,对KAIST预训练模型进行微调。为了评估配对条件下的鲁棒性,在该数据集上与5种其他方法进行比较。如表2所示,本文的方法仍然取得了有竞争力的结果,证明了本文的模型具有鲁棒性,能够在现实问题中有效应对。

表2 CVC-14行人数据集[25]的漏检率比较

3.2.3 可视化分析

如表3所示,本文提出的光照感知跨光谱融合检测网络在白天和夜晚,都取得了优秀的检测表现。

表3 在KAIST数据集上的行人检测结果

尤其是在光照条件较差或者行人目标遮挡严重的情况下,该网络能够准确地定位行人位置。相比其他多光谱行人检测方法,在复杂场景中,本文的方法具有更低的漏检率和误检率。

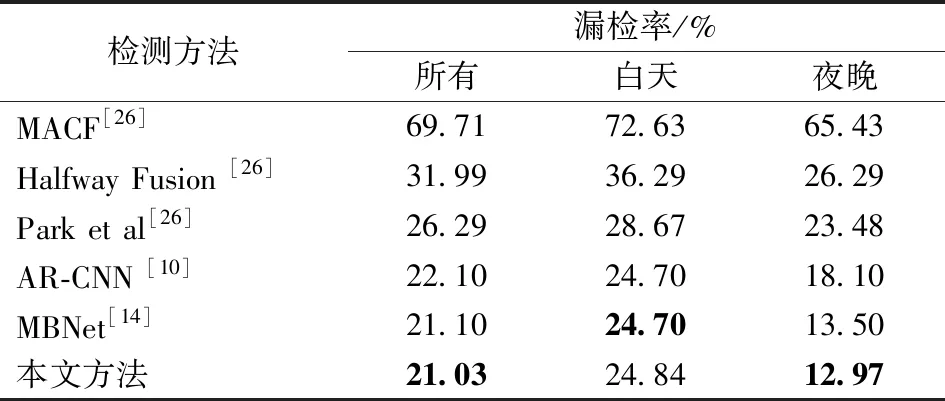

3.2.4 检测速度分析

光照感知跨光谱融合检测网络与其他多光谱行人检测方法的检测速度比较如表4所示。与其他探测器相比,本文的网络在相同漏检率水平下仍有令人满意的速度表现,可以看出本文提出的方法在平衡漏检率和速度方面表现出色。

表4 检测速度比较

3.2.5 消融实验

1) 模块有效性验证

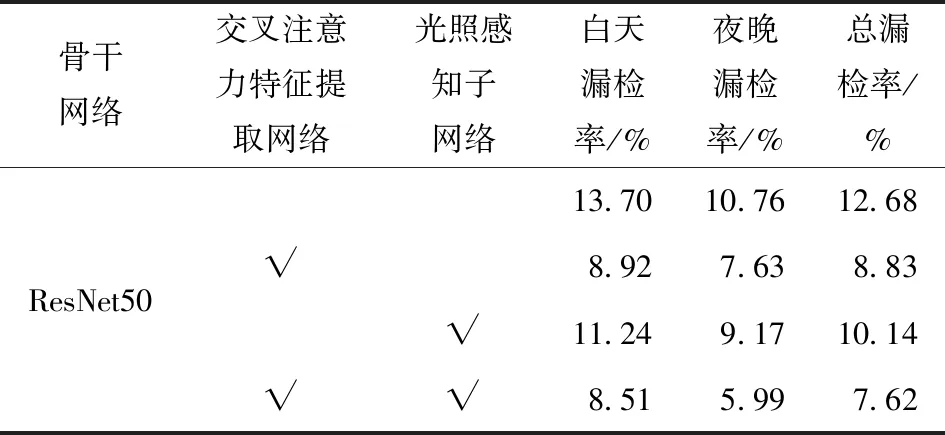

本节在KAIST多光谱行人检测数据集上进行

了消融实验,旨在展示光照感知跨光谱融合检测网络中本文提出的各个子网络的有效性。具体地,在表5中,选择以残差网络(ResNet50)为骨干网络,采用双分支独立提取特征,并使用简单拼接作为融合特征的检测网络作为基线网络。值得注意的是,使用能够过滤光谱特异性噪声并利用光谱内在关联增强单光谱特征提取能力的交叉注意力特征提取网络进行特征提取,可以显著地提高检测性能。实验结果表明,本文提出的两个子网络都能使基线网络的检测性能有所提升,从而证明了本文提出的两个子网络的有效性。

表5 模块有效性验证的消融实验

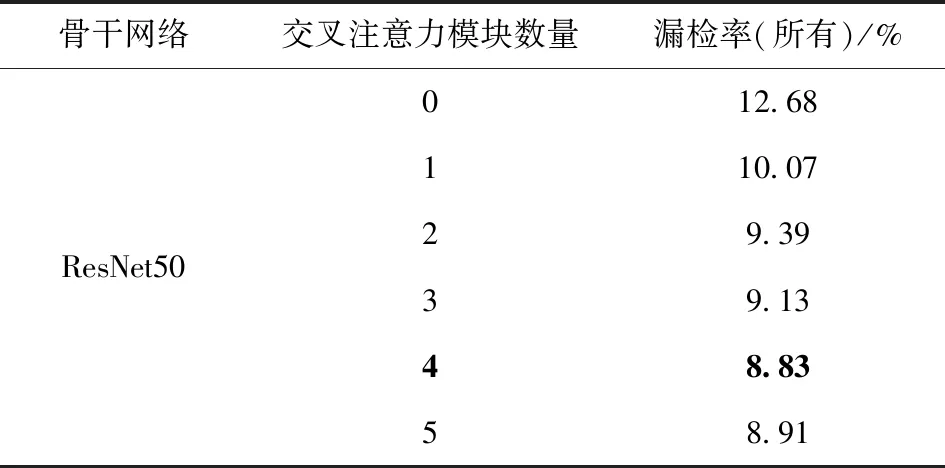

2) 交叉注意力模块数量验证

为了进一步验证交叉注意力模块在光照感知跨光谱融合检测网络中的有效性,进行了表6所示实验,研究不同数量的交叉注意力模块对网络性能的影响。将加入交叉注意力模块的ResNet50骨干网与基线网络进行比较,发现增加交叉注意力模块并不能保证更低的失误率(失误率越低越好)。适当的跨光谱交流可以消除特定光谱的噪声,但过多的层可能会导致特定光谱信息的丢失,从而进一步降低网络性能。特别是当应用4个交叉注意力模块时,性能达到8.83%,比基线网络高出3.85%。

表6 交叉注意力模块数量验证的消融实验

3) 交叉注意力模块的定性验证

表7中直观的注意力图,定性验证了交叉注意力模块的有效性。通过比较使用和不使用注意力机制得出的特征图可视化结果,显式地展现了两者之间的差别。这一对比结果直观地展示了本文提出的方法在光谱特异性噪声消除的有效性。

表7 交叉注意力模块在不同光照条件下的定性验证

4 结论

本文讨论了如何将具有本质差异的可见光和红外图像两种光谱特征进行融合,以及如何消除模态特异性遮挡的问题;提出了一种新颖的、适应性好的光照感知跨模态特征融合网络,通过注意力机制提取光谱内在特征并消除光谱特异性噪声。同时,提出了一个光照感知子网络,以自适应调整光谱特征权重,应对变化的光照条件。

本文方法通过整合混合引导注意模块和关联模态注意模块,使网络能够抑制模态特定的遮挡特征,并学习多模态特征的自适应融合。实验结果表明,本文提出的光照感知跨模态特征融合网络在精度和速度上均优于其他8种检测方法。下一步,希望能将此工作应用于多模态语义表达等领域。