基于图像的水稻纹枯病智能测报方法

2022-05-16韩晓彤杨保军李苏炫廖福兵刘淑华唐健姚青

韩晓彤,杨保军,李苏炫,廖福兵,刘淑华,唐健,姚青*

基于图像的水稻纹枯病智能测报方法

韩晓彤1,杨保军2,李苏炫1,廖福兵1,刘淑华2,唐健2,姚青1*

1浙江理工大学信息学院,杭州 310018;2中国水稻研究所水稻生物学国家重点实验室,杭州 311401

【目的】目前水稻纹枯病测报依赖人工调查水稻发病丛数、株数和每株严重度来计算其病情指数,操作专业性强,费时费力且数据难以追溯。本研究提出基于图像的水稻纹枯病病斑检测模型和发生危害分级模型,为水稻纹枯病智能测报提供理论依据。【方法】利用便携式图像采集仪采集田间水稻纹枯病图像,研究不同目标检测模型(Cascade R-CNN和RetinaNet)和特征提取网络(VGG-16和ResNet-101)对水稻纹枯病病斑的检测效果,筛选出具有较好检测效果的模型。针对Cascade R-CNN模型检测纹枯病病斑存在漏检现象,根据纹枯病病斑呈现形状不规则、大小和位置多变的复杂情况,对Cascade R-CNN进行改进,添加OHEM结构均衡难易样本,选择边框回归损失函数,通过精准率、漏检率、平均精度和P-R曲线来评价不同模型的检测效果。在改进的Cascade R-CNN-OHEM-GIOU模型检测结果基础上,分别建立基于病斑面积和病斑数的水稻纹枯病丛发生危害分级模型,通过决定系数(2)和Kappa值筛选分级模型。【结果】在相同主干网络条件下,Cascade R-CNN模型较RetinaNet模型对水稻纹枯病具有更好的检测效果,其中Cascade R-CNN-ResNet-101目标检测模型效果最佳,病斑检测准确率为92.4%,平均精度为88.2%,但漏检率为14.9%。改进的Cascade R-CNN-OHEM-GIOU检测模型有效解决了样本不均衡问题,添加边框回归损失函数有效降低了漏检率,较Cascade R-CNN-ResNet-101模型降低8.7%,平均精度提高到92.3%。以人工分级结果作为标准,基于病斑面积的水稻纹枯病发生危害分级模型在0—5级分级准确率分别为96.0%、90.0%、82.0%、76.0%、74.0%和96.0%,平均分级准确率为85.7%,Kappa系数为0.83,基于图像的水稻纹枯病丛发生危害分级与人工分级结果具有较高的一致性。【结论】基于图像的水稻纹枯病智能测报方法可实现病斑自动检测和发生危害自动分级,提高了测报的智能化水平,结果客观且可追溯,也可为其他农作物病害智能测报提供参考。

水稻纹枯病;病斑图像;智能测报;Cascade R-CNN模型;危害分级模型

0 引言

【研究意义】水稻纹枯病是世界性水稻三大病害之一,在我国每年引起巨大的水稻产量损失。该病是由立枯丝核菌()侵染引起的一种真菌病害,在水稻各生长期均可见,早期病斑初现于稻株基部叶鞘,在气候条件适宜时可迅速向株间或丛间(横向)扩展导致病株率和病丛率增加,或病斑自下位叶鞘向上位叶鞘(纵向)发展,同一叶鞘位有多个病斑时可融合成云纹状大斑甚至整个鞘叶连片成斑干枯。对纹枯病发生发展的准确测报是有效控制该病的基础,根据现行的测报技术规范[1],水稻纹枯病发病严重度主要根据发病丛数、株数、病斑在稻株上的位置来计算。如果仅考虑病斑在叶鞘的纵向发生位置,忽略病斑面积变化的动态信息,则会低估纹枯病发生严重度,易错过有效防治时间,造成危害加重。由于纹枯病常发病于水稻茎基部,稻丛进入分蘖期后逐渐封行,现有的智能监测设备(如遥感、无人机或固定图像采集设备等)难以对该病进行有效监测。测报人员一般需经过专门培训,在田间调查时弯腰拨动稻丛对每根稻株逐一进行上下查看,凭经验和目测完成调查任务,费时费力,使其调查结果存在一定的主观性且难以追溯。建立基于图像的水稻纹枯病病斑检测模型和发生危害分级模型,可减轻测报人员工作量,提高测报智能化,实现数据可追溯。【前人研究进展】随着图像处理和机器学习的发展与应用,许多学者开始利用模式识别方法识别农作物病害病斑,并进行病害等级的判断[2-6]。判断病害危害程度采取的步骤一般包括背景分割、病斑图像特征的提取与筛选、训练某个模式识别模型、识别病斑种类与大小、根据病斑数量和尺寸判断病害发生等级。如王献锋等[2]结合环境和病斑特征对3种黄瓜病害的识别进行研究,采用模糊数学对病斑特征进行分类,平均识别率达到90%以上;胡耀华等[3]将高光谱数据与模式识别相结合,训练的多光谱特征结合模型对马铃薯叶片晚疫病识别率达到94.87%;葛婧[4]利用颜色特征值与病情指数进行回归分析,建立了玉米病斑分级模型;马德贵等[5]利用椭圆模型计算单株水稻稻瘟病最大病斑轴长与人工检测的实际最大病斑的长度,建立了稻瘟病的危害程度分级模型,平均准确率在90%以上;袁媛等[6]利用R分量和中值滤波进行图像预处理,然后利用改进的图切割方法进行水稻纹枯病病斑分割,实现了一种基于支持向量机的水稻纹枯病识别方法,识别准确率达到95%。这种模式识别方法在简单的背景和有限的数据集中下一般能获得较高的准确率,但由于传统的模式识别模型存在鲁棒性弱和泛化能力差的问题,难以广泛应用于复杂农田环境下农作物病害的识别与诊断。近些年,随着深度学习在多个领域的目标识别与检测任务中获得成功应用,一些学者开始利用深度学习进行农作物病害的检测与测报[7-12]。Ramcharan等[8-10]等利用深度学习模型对农作物病斑进行识别检测,有效提高了不同农作物病斑的检测效果;Ramesh等[11]提出了一种深度神经网络算法,对水稻叶片上的稻瘟病、白叶枯病、鞘腐病和褐斑病4种病害进行识别与分类,平均识别率达到95%以上;曹英丽等[12]建立了基于改进YOLO的水稻纹枯病识别模型,该模型对纹枯病病斑识别的平均精度mAP为84.97%。基于深度学习的目标检测方法通过大量的训练样本可获得较高鲁棒性的目标检测模型。然而,上述文献仅给出了病斑的识别方法,没有给出病害发生危害等级的判断方法,无法直接应用于农作物病害的精准测报。另外,病斑图像仍需要测报人员下田手持相机或手机靠近农作物病斑区域进行拍摄,对发生在水稻茎基部的纹枯病则需要测报人员弯腰拍摄,并没有真正解决测报人员工作量大和效率低的问题。【本研究切入点】针对人工调查水稻纹枯病费时费力、客观性差、数据难以追溯等问题,而高空和近地遥感等技术难以监测到水稻冠层以下的病斑,本文利用俞佩仕等[13]的便携式图像采集仪采集水稻茎基部纹枯病图像,建立基于深度学习的纹枯病检测算法和发生危害分级模型,提高水稻纹枯病测报的智能化和准确率。【拟解决的关键问题】通过单阶段与双阶段的目标检测算法对比,筛选纹枯病病斑检测效果好的目标检测模型;针对Cascade R-CNN模型因训练样本不均衡、检测框不准确所导致的目标漏检率高的问题,通过融合OHEM算法和GIoU Loss损失函数,提高水稻纹枯病病斑的检测率,降低漏检率。通过分析病斑区域检测结果,建立基于病斑特征的纹枯病发生危害分级模型,实现水稻纹枯病发生危害严重度自动分级与测报。

1 材料与方法

1.1 图像采集与数据集建立

1.1.1 水稻纹枯病图像采集 利用俞佩仕等[13]研制的便携式图像采集仪(图1)采集水稻纹枯病病斑图像。该设备无需调查人员弯腰,只需要根据身高调整手持杆的长度,将图像采集仪前端相机靠近距离水稻基部约10—12 cm处,使每丛水稻茎基部位于图像中间,并通过手机App对相机进行调焦与拍照控制。

1.1.2 图像数据集建立 2019—2020年采集了田间水稻纹枯病图像1 767幅(图2),图像大小为4 000 ×2 250 像素,以JPEG格式保存。在采集图像的同时,根据水稻纹枯病测报技术规范[1],人工计算每丛稻株的发病率和严重度,然后计算10丛水稻纹枯病发生严重度的等级(即病情指数),并将其划分为无发生(病情指数=0)、轻发生(病情指数≤2.5)、偏轻发生(2.5<病情指数≤5)、中等发生(5<病情指数≤10)、偏重发生(10<病情指数≤15)和大发生(病情指数>15)6个等级,分别对应本文中的0、1、2、3、4、5等级。

图1 水稻纹枯病图像采集

图2 水稻纹枯病

将每个等级的图像随机抽取50幅作为测试样本,剩余图像作为训练样本。利用目标检测标注工具LabelImg将训练样本中水稻纹枯病病斑区域进行标注(图3),标注工具将原图中目标区域的左上角和右下角的坐标,以及标签和原图大小等信息写入到XML文件中,建立PASCAL VOC[14]格式数据集。

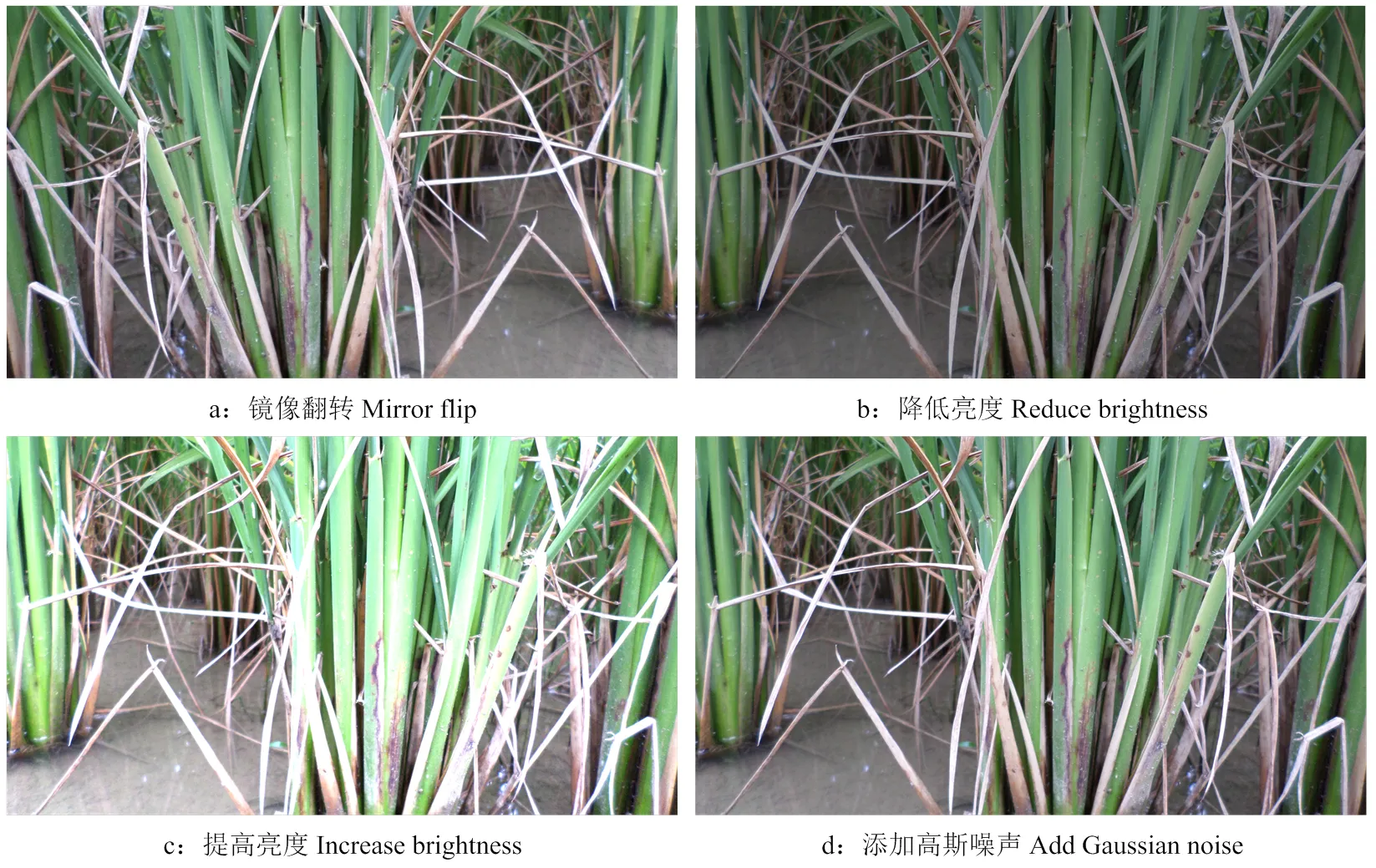

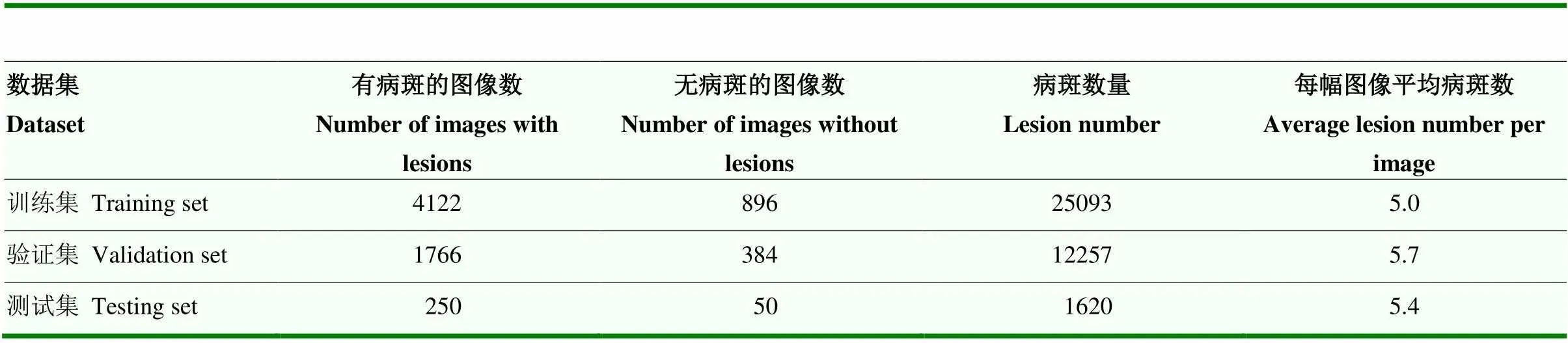

1.1.3 图像数据增强 自然条件下拍摄的水稻茎基部纹枯病图像光照强度和图像清晰度存在一定差异。为了提高模型的泛化能力和鲁棒性,采用镜像翻转、降低亮度、增加亮度、添加噪声4种方法扩大数据集,共获得训练样本数7 168幅,将其按照7﹕3的比例随机分成训练集和验证集。图4给出了图2的图像数据增强结果。表1列出了图像数与纹枯病病斑信息。

图3 标记水稻纹枯病病斑

图4 4种图像数据增强方法

表1 水稻纹枯病数据集信息

1.2 基于改进Cascade R-CNN的水稻纹枯病检测模型框架

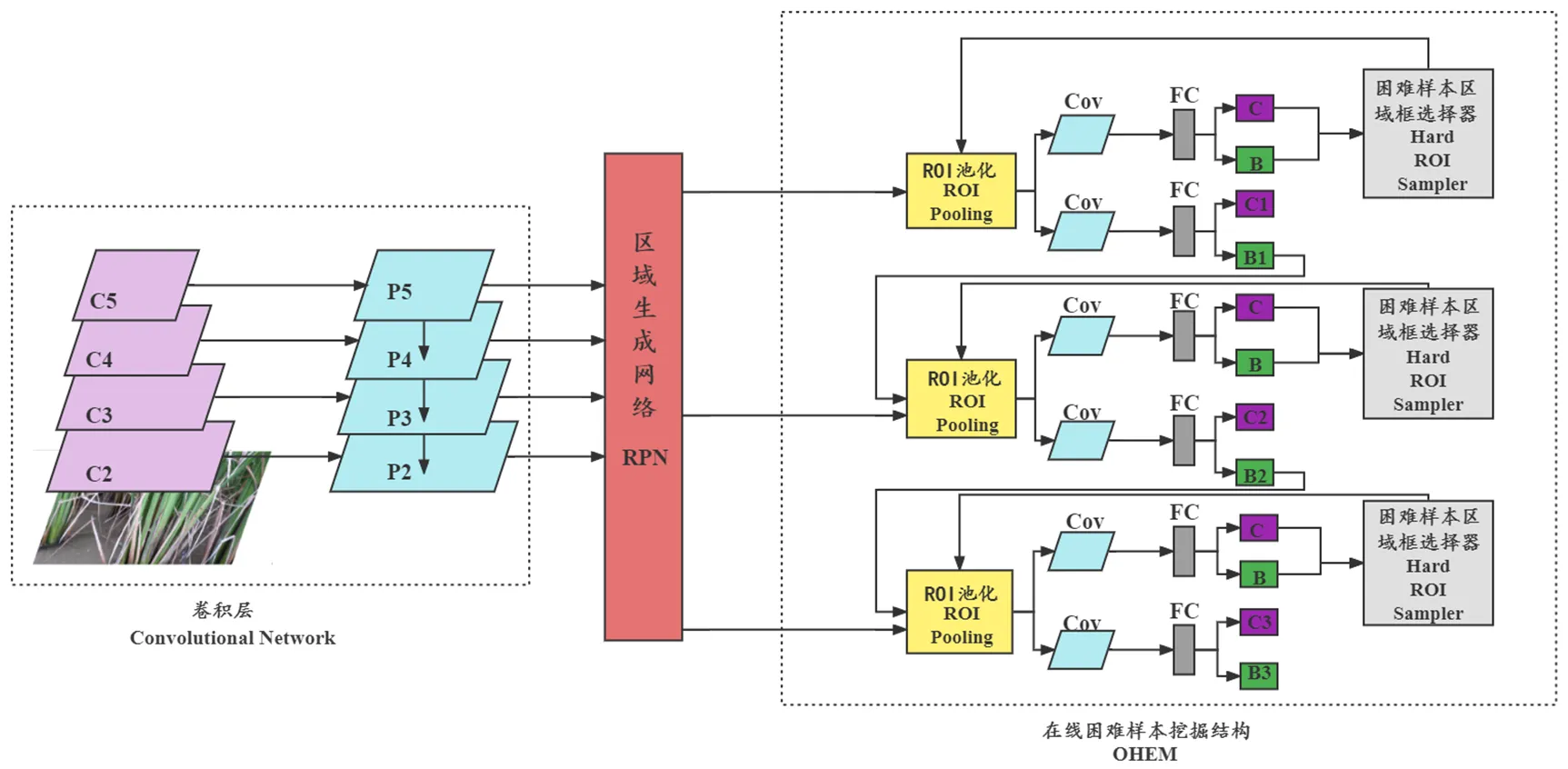

Cascade R-CNN[15]继承自Faster R-CNN[16],属于两阶段检测算法,采用级联结构,通过区域生成网络(region proposition networks,RPN)生成候选区域,再对候选区域计算分类损失和回归损失,具有网络输出精确度高的优点。本文采用该模型检测水稻纹枯病病斑,在此基础上添加在线困难样本挖掘(online hard example mining,OHEM)结构[17]来均衡难易样本,并采用边框回归损失函数GIOU Loss[18]提高水稻纹枯病检测率。改进的Cascade R-CNN水稻纹枯病检测模型网络框架如图5所示。

图5 Cascade R-CNN-OHEM-GIOU网络结构图

1.3 水稻纹枯病发生危害分级模型

为了减少人工调查时造成的主观误差,提高纹枯病发生危害等级判断的准确率,分别建立基于病斑面积和病斑数量的水稻纹枯病病害分级模型,筛选合适的水稻纹枯病发生危害等级判别模型。

1.3.1 病斑图像数据集 在训练样本中,随机选择0—5级纹枯病图像各100幅作为训练样本,并根据1.2节中检测模型所获得的数据,计算每幅图像中检测到的水稻纹枯病病斑数量和病斑面积(文中病斑面积近似等于病斑检测框面积)。

分别对病斑数量和面积数据进行Z-Score标准化[19],见公式1。

(1)

其中,为待标准化的变量个体,为总体变量均值,为总体变量标准差,为标准化处理之后的变量。

1.3.2 水稻纹枯病发生危害分级模型 根据标准化后病斑数量和病斑面积的数据特点,选择变型的Sigmoid 函数[20]建立病斑特征值与人工分级数据之间的回归方程,见公式2。

(2)

其中,是随机选择的10幅图像中标准化后的病斑数量或病斑面积,是这10幅图像中人工计算得到的纹枯病发生危害等级,、和为拟合参数。

1.4 模型评价方法

1.4.1 不同检测模型的比较 为了验证改进的Cascade R-CNN水稻纹枯病病斑检测模型的检测效果,选择单阶段的RetinaNet[21]与其比较,特征提取网络分别选用VGG-16[22]和ResNet-101[23]。将预训练模型权值通过参数微调避免过拟合,在相同的数据集和测试集上训练和测试这两类模型。

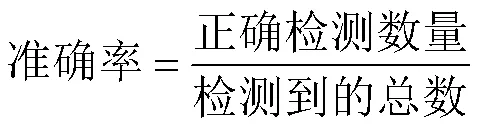

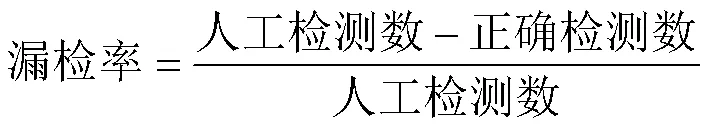

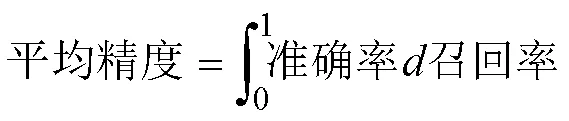

1.4.2 模型检测结果的评价方法 为了评估不同模型的水稻纹枯病病斑检测效果,分别利用病斑检测准确率(precision rate)、漏检率(missing rate)、平均精度(average precision,AP)[24]和P-R(precision-recall)曲线进行评价。

召回率=1-漏检率 (5)

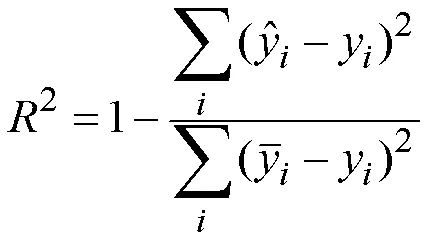

1.4.3 危害分级模型的评价方法 利用决定系数(2)[25]评价不同病斑特征值对纹枯病发生危害分级模型的拟合效果,见公式(7)。

其中,为第个危害等级,y为人工分级数据,为模型预测分级数据,为模型预测分级数据平均值。

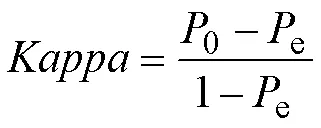

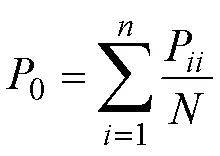

利用Kappa系数[26]对模型分级的准确性进行评价,计算公式如下:

其中,0为预测的准确率,e为偶然一致性,为图像中纹枯病病情第个等级,为分级数(6个等级),R、C分别为预测为等级的次数与实际为等级的数量,P为正确预测为等级的次数,为每个等级总数。

Kappa值一般落在-1到1之间。当Kappa>0时证明两组数据存在一致性,Kappa值越大一致性越高,评价标准准则可参考文献[26]。

1.5 模型运行环境

在ubuntu18.04系统下,使用3块GTX1080Ti英伟达GPU,显存为3×11GB,选取Intel Core i7-9800x CPU @ 3.8GHz×16,使用Pytorch框架构建目标检测模型。

2 结果

2.1 不同检测模型的检测结果

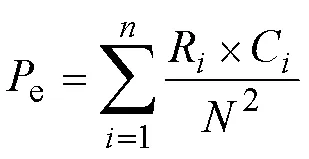

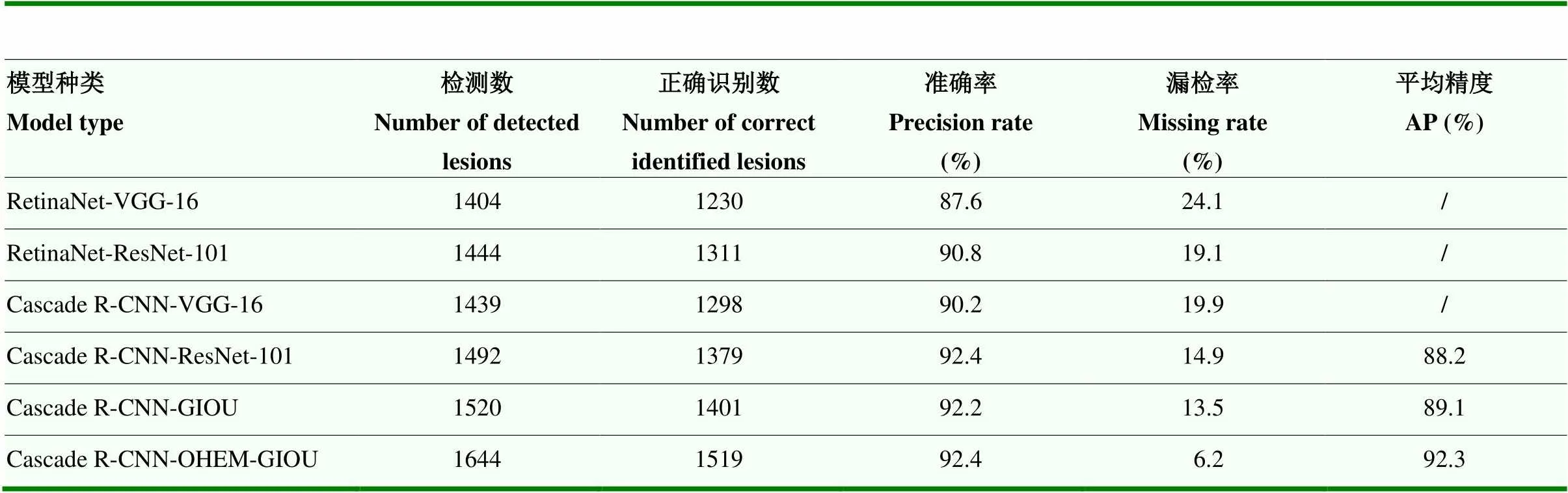

在同一个测试集上,对RetinaNet-VGG-16、RetinaNet- ResNet-101、Cascade R-CNN-VGG-16、Cascade R- CNN-ResNet-101、Cascade R-CNN-GIOU和Cascade R-CNN-OHEM-GIOU共6个模型进行测试。从表2可以看出,在相同的目标检测网络(RetinaNet或Cascade R-CNN)情况下,特征提取网络ResNet-101比VGG-16获得了更高的准确率和更低的漏检率,表明ResNet-101在提取纹枯病病斑图像特征上更具有优势。在相同的特征提取网络(ResNet-101或VGG-16)情况下,目标检测网络Cascade R-CNN在准确率和漏检率上的表现均优于RetinaNet。CascadeR-CNN-ResNet-101模型检测纹枯病病斑的准确率和漏检率分别为92.4%和14.9%,比RetinaNet-VGG- 16模型的检测准确率提高了4.8%,漏检率降低了9.2%。

由于水稻纹枯病病斑在图像中较为显著,数量相对较少,样本较为简单,采用Cascade R-CNN网络在训练过程中容易产生难易样本不均衡问题,造成目标区域漏检的情况。为了提高检测率,在原始模型中添加OHEM结构,利用前馈网络为所有的候选区域计算损失,通过Hard ROI Sampler结构,根据损失排序选出候选区域中误判样本(即困难样本),并利用后馈网络通过上一步骤产生的困难样本来反向传播更新参数,既提高了监督学习的效率,又有效解决了难易样本不均衡的问题。改进的Cascade R-CNN-GIOU模型相较于Cascade R-CNN模型,漏检率降低了1.4%,平均精度提升了0.9%(表2)。

表2 6个模型对水稻纹枯病的检测结果

原始的Cascade R-CNN网络使用Smoooh L1 Loss计算回归损失,该算法没有考虑坐标点的相关性,难以获取图像中目标的精确位置,导致原始模型在检测水稻纹枯病病斑时出现检测框无法将纹枯病病斑完整框住的问题。本文采用GIOU Loss[18]作为Cascade R-CNN网络的损失函数,将4个坐标点构成的边框看成一个整体进行回归,通过引入最小框,优化两框不相交的情况,提升边框回归的精确度。Cascade R-CNN- OHEM-GIOU模型相较于Cascade R-CNN-GIOU,准确率提升的同时,漏检率大幅下降,降低了7.3%,平均精度提升了3.2%,表明添加了样本均衡结构后的模型对纹枯病具有较好的检测效果(表2)。

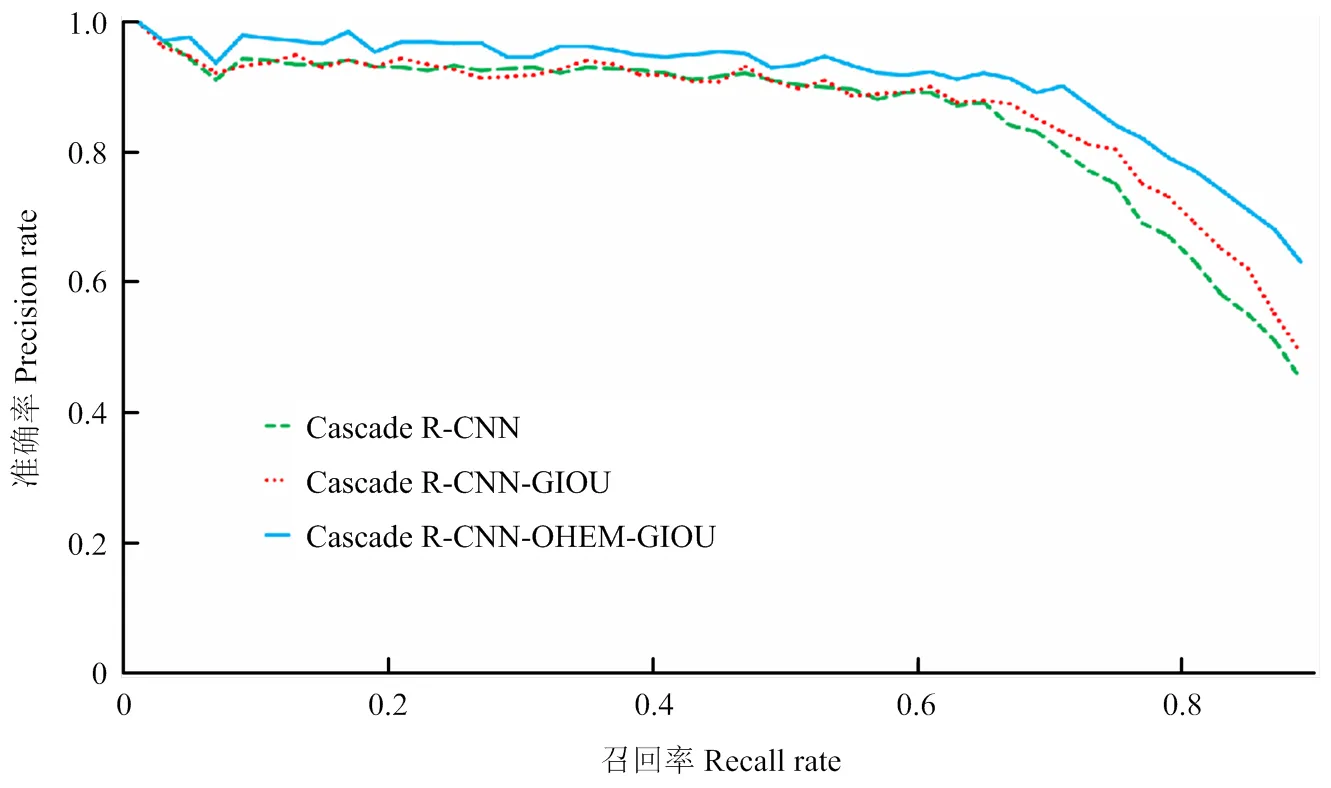

图6给出了Cascade R-CNN及其改进的检测模型的P-R曲线,随着召回率的不断提升,Cascade R-CNN-OHEM-GIOU模型整体表现优于其他两个模型。

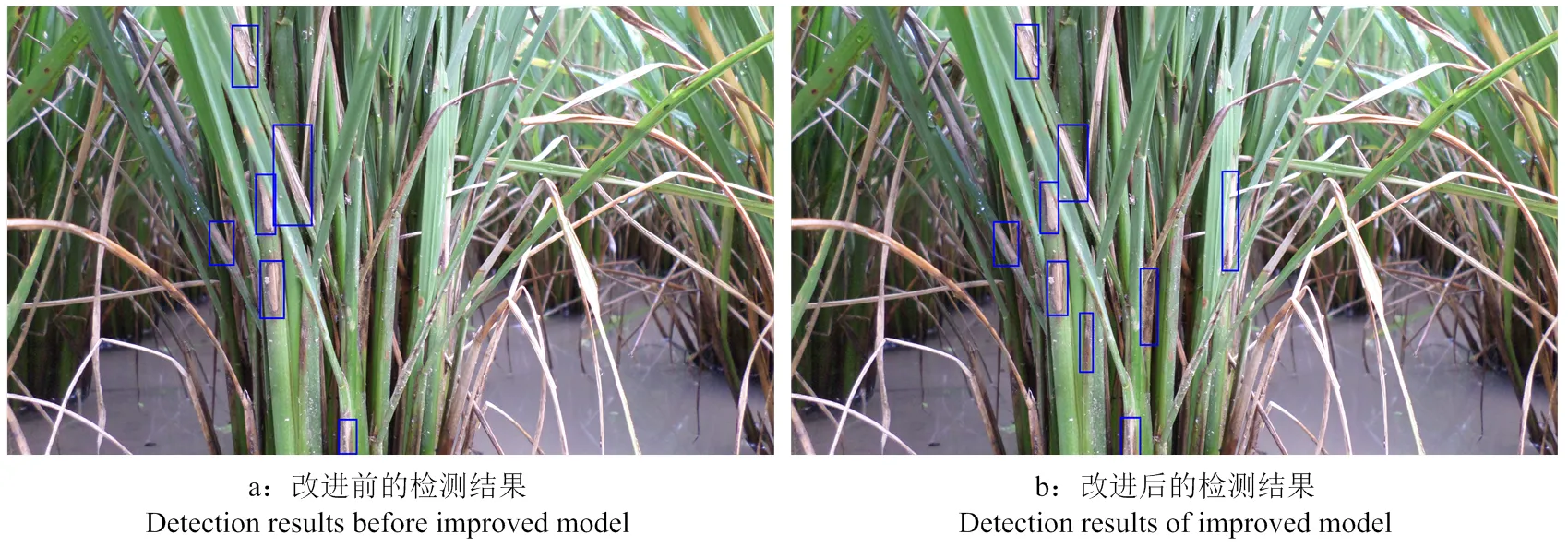

使用改进前后的Cascade R-CNN检测模型对同一幅图像中的纹枯病病斑进行检测。结果表明,改进前的模型检测出6个纹枯病病斑,而改进之后的模型共检测出9个纹枯病病斑(图7)。因此,改进后的Cascade R-CNN提高了水稻纹枯病病斑的检测率。

图6 3个Cascade R-CNN模型的P-R曲线

图7 改进前后模型对纹枯病病斑检测结果图

2.2 水稻纹枯病发生危害分级模型结果

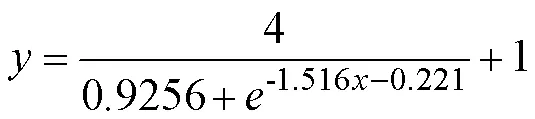

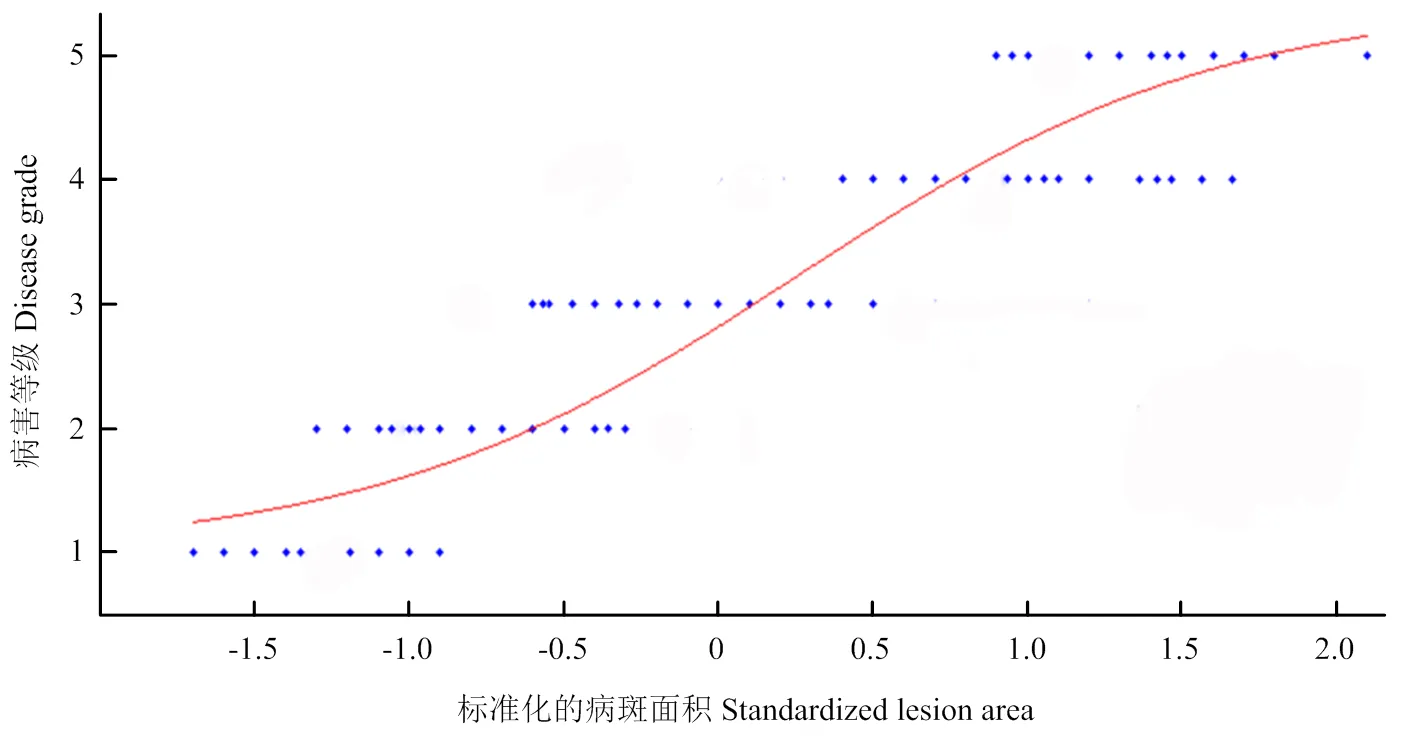

基于病斑面积的变型Sigmoid函数拟合结果如图8所示,回归方程表达式如下:

其中,决定系数2为0.8021,表明该模型能较好地拟合病斑面积特征与病害等级之间的关系。

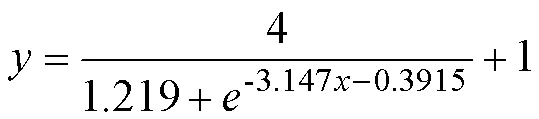

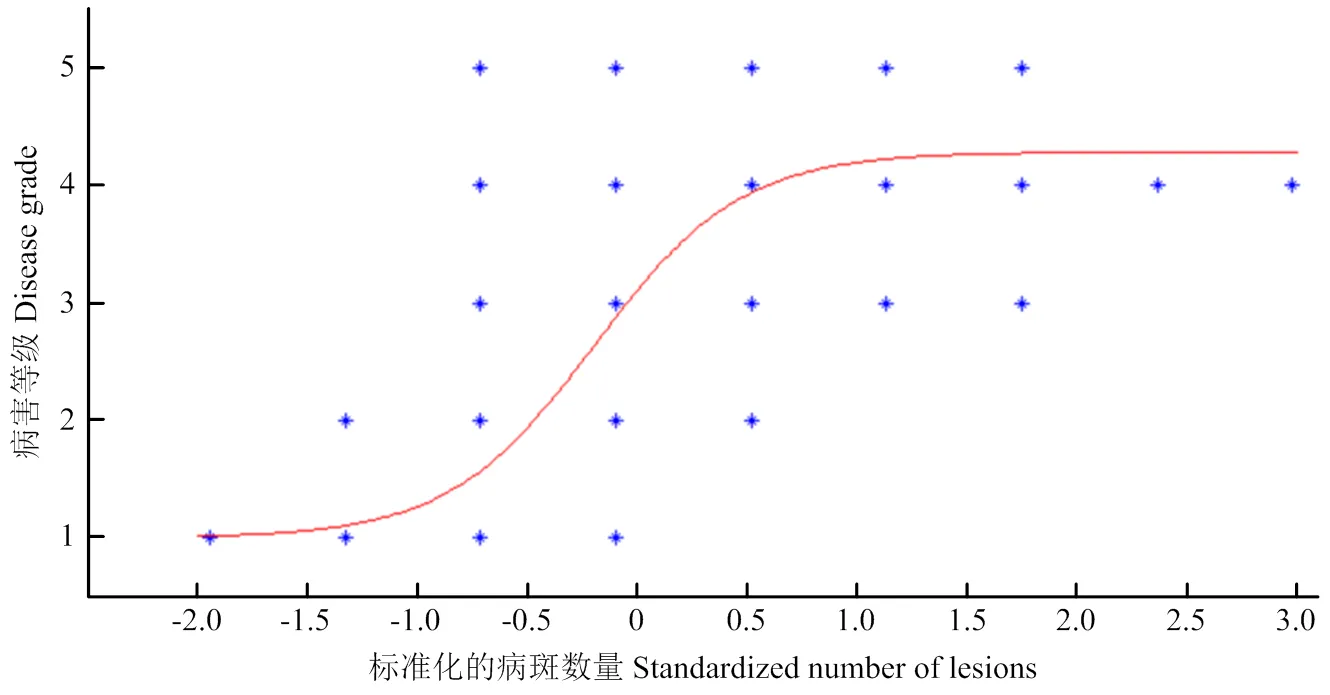

基于病斑数量的变型Sigmoid函数拟合结果如图9所示,回归方程表达式如下:

其中,决定系数2为0.4271,表明模型拟合表现欠佳。

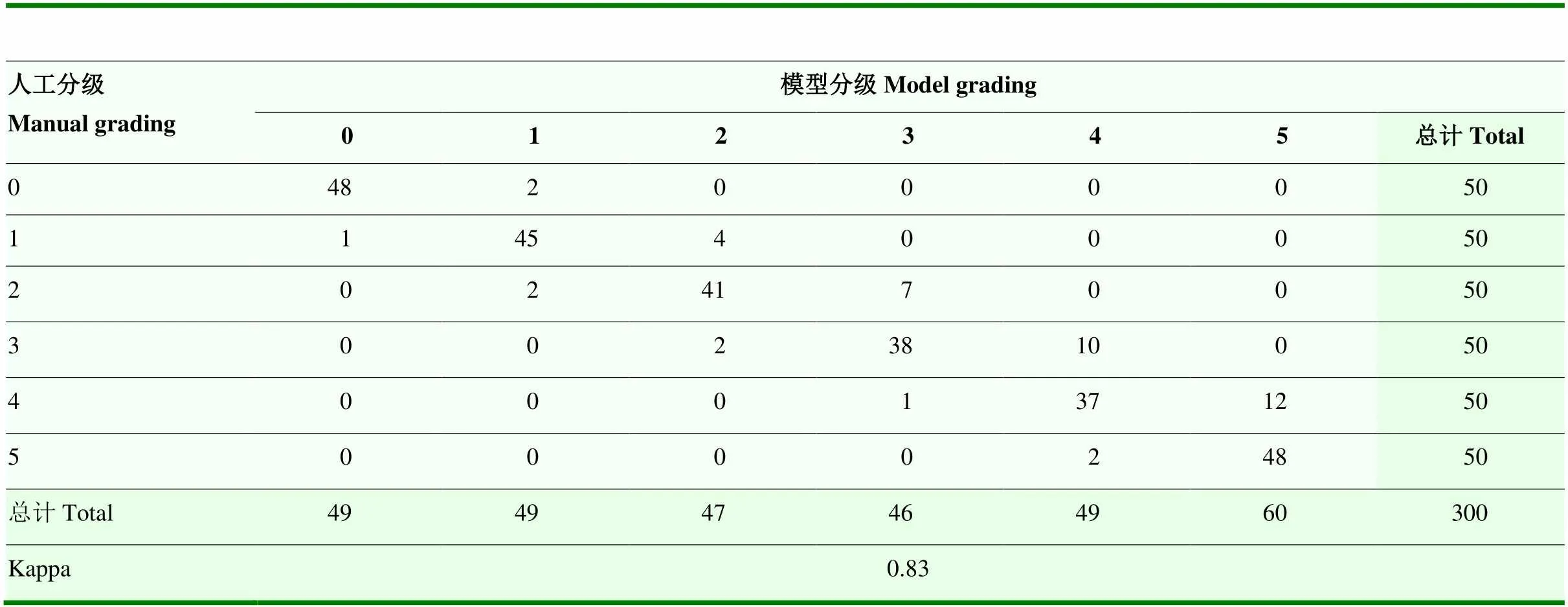

根据病斑图像分析得知,当纹枯病发生危害程度较轻时,病斑呈点状分布,面积小,但数量多;危害等级提高时,病斑相互连接形成云纹状大斑,病斑数量趋于减少,此时病害发生危害分级主要由病斑面积特征主导。因此,选择基于病斑面积的水稻纹枯病病害危害等级模型对测试样本集进行测试。表3给出了基于病斑面积的水稻纹枯病发生危害分级模型预测结果与人工识别结果的混淆矩阵。结果表明,分级模型预测结果与人工识别结果的Kappa系数为 0.83,呈较高的一致性。分级模型0—5级分级准确率分别为96.0%、90.0%、82.0%、76.0%、74.0%和96.0%,平均分级准确率为85.7%,表明分级模型在水稻纹枯病发生较轻等级时有较好的表现,在病害病情程度提高时,其病斑连成一片,检测框相互之间有相交部分,实际病斑面积比检测框面积小,分级结果较真实值偏大,因此分级模型准确率有所下降。

图8 基于病斑面积特征的病害等级预测模型

图9 基于病斑数量特征的病害等级预测模型

表3 水稻纹枯病分级混淆矩阵

3 讨论

3.1 水稻纹枯病图像的采集

水稻纹枯病常发生于水稻茎基部,现行的田间测报方法需要人工下田弯腰拨动稻丛查看,费时费力,调查数据难以追溯。由于现有的智能监测设备难以监测到水稻冠层下面的纹枯病,本文利用便携式图像采集仪[13],无需弯腰就可便捷地采集到水稻茎基部的纹枯病图像,大大减轻了测报人员的工作量,保存的图像可用于数据的追溯。图像拍摄质量将影响纹枯病病斑的检测与危害分级,因此,在拍摄的时候需要获取高质量的水稻纹枯病病斑图像。本文采集的水稻纹枯病图像数据量仍旧不足,需要进一步采集更多水稻品种和水稻不同生长期的纹枯病图像,提高模型的泛化能力,以适应更多的应用场景。

3.2 水稻纹枯病病斑检测模型

现行的水稻纹枯病测报标准中,测报人员主要通过目测病斑位置和发病稻株数来计算危害等级,这种方法依赖于经验,客观性差。为了提高农作物病害识别与危害分级的客观性和智能化,很多学者利用图像研究农业病害的识别与诊断。王献锋等利用病害特征向量和传统的模式识别方法实现了不同农作物病斑的识别[2-5];Ramesh等利用深度学习方法研究水稻不同病害的识别,在测试集上均取得了较好的识别效果[11-12],但研究结果仍无法直接应用于农作物病害的精准测报,主要原因是未能给出病害发生等级的智能判断。本文通过单阶段和双阶段目标检测算法的对比,证明双阶段的Cascade R-CNN模型具有更好的检测效果。由于Cascade R-CNN模型检测水稻纹枯病病斑时存在难易样本不均衡和检测框定位精度问题,本文对Cascade R-CNN-ResNet-101进行了改进,添加OHEM结构[17]并使用GIOU Loss回归函数[18],提高了纹枯病病斑的检测准确率,降低了漏检率,最终获得了较好的检测效果。

3.3 水稻纹枯病发生危害分级模型

为了实现水稻纹枯病发生危害分级的智能化,本文以Cascade R-CNN-OHEM-GIOU检测模型获得的病斑面积作为特征值,建立了纹枯病发生危害分级模型,平均准确率为85.7%。模型在0—2级分级的准确率较高,3—4级容易误判,主要是因为本文在计算病斑面积时直接利用了检测框面积,导致模型分级结果较真实值偏大。由于田间纹枯病0—2级(早期)危害是确定发病田块、制定防治计划的重要依据,因此本研究构建的方法用于田间纹枯病自动监测可促进防治决策的智能化水平,有较强的应用前景。而3—4级重度危害监测对于产量损失评估意义更强。下一步将提取检测框内病斑区域的面积,提高模型分级结果的准确率。

4 结论

利用便携式图像采集仪采集水稻纹枯病图像,建立了基于图像的水稻纹枯病病斑检测模型Cascade R-CNN-OHEM-GIOU,检测准确率为92.4%,漏检率为6.2%。在检测模型获得的纹枯病病斑区域基础上,建立了基于病斑面积的水稻纹枯病发生危害分级模型,各等级平均准确率达85.7%。提出的水稻纹枯病病斑检测模型和危害分级模型实现了水稻纹枯病智能测报,可减轻测报人员的工作量,避免危害分级的主观性,实现测报数据可追溯,并为其他农作物病害智能测报提供参考。

[1] 中华人民共和国国家标准.稻纹枯病测报技术规范: GB/T 15791— 2011.北京: 中国标准出版社, (2011-09-29) [2021-11-03].

National Standards of the People’s Republic of China.Rules of monitoring and forecasting for the rice sheath blight (Kukn): GB/T 15791—2011.Beijing: China Standards Press, (2011-09-29) [2021-11-03].(in Chinese)

[2] 王献锋, 张善文, 王震, 张强.基于叶片图像和环境信息的黄瓜病害识别方法.农业工程学报, 2014, 30(14): 148-153.

WANG X F, ZHANG S W, WANG Z, ZHANG Q.Recognition of cucumber diseases based on leaf image and environmental information.Transactions of the Chinese Society of Agricultural Engineering, 2014, 30(14): 148-153.(in Chinese)

[3] 胡耀华, 平学文, 徐明珠, 单卫星, 何勇.高光谱技术诊断马铃薯叶片晚疫病的研究.光谱学与光谱分析, 2016, 36(2): 515-519.

HU Y H, PING X W, XU M Z, SHAN W X, He Y.Detection of late blight disease on potato leaves using hyperspectral imaging technique.Spectroscopy and Spectral Analysis, 2016, 36(2): 515-519.(in Chinese)

[4] 葛婧.基于计算机图像处理技术的作物病害等级检测[D].合肥: 安徽农业大学, 2007.

GE J.Detection of crops plant disease rank based on computer image processing technology[D].Hefei: Anhui Agricultural University, 2007.(in Chinese)

[5] 马德贵, 邵陆寿, 葛婧, 丁克坚, 钱良存.水稻稻瘟病及水稻纹枯病病害程度图像检测.中国农学通报, 2008, 24(9): 485-489.

MA D G, SHAO L S, GE J, DING K J, QIAN L C.Detection of the harm degree of rice blast and rice sheath blight.Chinese Agricultural Science Bulletin, 2008, 24(9): 485-489.(in Chinese)

[6] 袁媛, 陈雷, 吴娜, 李淼.水稻纹枯病图像识别处理方法研究.农机化研究, 2016, 38(6): 84-87, 92.

YUAN Y, CHEN L, WU N, LI M.Recognition of rice sheath blight based on image procession.Journal of Agricultural Mechanization Research, 2016, 38(6): 84-87, 92.(in Chinese)

[7] Krishna R V V, Kumar S S.Computer vision based identification of nitrogen and potassium deficiency in FCV tobacco//Proceedings of the International Conference on Computational Science and Engineering, 2016: 105-111.

[8] Ramcharan A, Baranowski K, McCloskey P, Ahmed B, Legg J, Hughes D P.Deep learning for image-based cassava disease detection.Frontiers in Plant Science, 2017, 8: 1852.

[9] 苏婷婷, 牟少敏, 董萌萍, 时爱菊.深度迁移学习在花生叶部病害图像识别中的应用.山东农业大学学报(自然科学版), 2019, 50(5): 865-869.

SU T T, MU S M, DONG M P, SHI A J.Application of deep transfer learning in image recognition of peanut leaf diseases.Journal of Shandong Agricultural University (Natural Science Edition), 2019, 50(5): 865-869.(in Chinese)

[10] Fuentes A, Yoon S, Kim S C, Park D S.A robust deep- learning-based detector for real-time tomato plant diseases and pests recognition.Sensors, 2017, 17(9): 2022.

[11] Ramesh S, Vydeki D.Recognition and classification of paddy leaf diseases using optimized deep neural network with Jaya algorithm.Information Processing in Agriculture, 2020, 7(2): 249-260.

[12] 曹英丽, 江凯伦, 于正鑫, 肖文, 刘亚帝.基于深度卷积神经网络的水稻纹枯病检测识别.沈阳农业大学学报, 2020, 51(5): 568-575.

CAO Y L, JIANG K L, YU Z X, XIAO W, LIU Y D.Detection and recognition of rice sheath blight based on deep convolutional neural network.Journal of Shenyang Agricultural University, 2020, 51(5): 568-575.(in Chinese)

[13] 俞佩仕, 郭龙军, 姚青, 杨保军, 唐健, 许渭根, 陈渝阳, 朱旭华, 陈宏明, 张晨光, 段德康, 贝文勇, 彭晴晖.基于移动终端的稻田飞虱调查方法.昆虫学报, 2019, 62(5): 615-623.

YU P S, GUO L J, YAO Q, YANG B J, TANG J, XU W G, CHEN Y Y, ZHU X H, CHEN H M, ZHANG C G, DUAN D K, BEI W Y, PENG Q H.A survey method based on mobile terminal for rice planthoppers in paddy fields.Acta Entomologica Sinica, 2019, 62(5): 615-623.(in Chinese)

[14] Everingham M, Van Gool L, Williams C K I, WINN J, ZISSERMAN A.The pascal visual object classes (voc) challenge.International journal of computer vision, 2010, 88(2): 303-338.

[15] Cai Z, Vasconcelos N.Cascade r-cnn: Delving into high quality object detection//Proceedings of the IEEE conference on computer vision and pattern recognition, 2018: 6154-6162.

[16] Ren S, He K, Girshick R, Sun J.Faster r-cnn: Towards real-time object detection with region proposal networks.Advances in neural information processing systems, 2015, 28: 91-99.

[17] Shrivastava A, Gupta A, Girshick R.Training region-based object detectors with online hard example mining//Proceeding of the IEEE conference on computer vision and pattern recognition, 2016: 761-769.

[18] Rezatofighi H, Tsoi N, Gwak J Y, Sadeghian A, Reid I, Savarese S.Generalized intersection over union: A metric and a loss for bounding box regression//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 658-666.

[19] Altman E I, Finance M A.Predicting financial distress of companies: revisiting the Z-Score and ZETA models//Handbook of Research Methods & Applications in Empirical Finance.Edward Elgar Publishing, 2013.

[20] 刘明.支持向量机中Sigmoid核函数的研究[D].西安: 西安电子科技大学, 2009.

LIU M.The study on sigmoid kernel function in support vector machine[D].Xi’an: Xidian University, 2009.(in Chinese)

[21] Lin T Y, Goyal P, Girshick R, HE K, DOLLAR P.Focal loss for dense object detection//Proceedings of the IEEE international conference on computer vision, 2017: 2980-2988.

[22] LIU X, CHI M, ZHANG Y F, QIN Y Q.Classifying high resolution remote sensing images by fine-tuned VGG deep networks//IGARSS IEEE International Geoscience and Remote Sensing Symposium, 2018: 7137-7140.

[23] He K, Zhang X, Ren S.Deep residual learning for image recognition//Proceedings of the IEEE conference on computer vision and pattern recognition, 2016: 770-778.

[24] Bucklan M, Gey F.The relationship between recall and precision.Journal of the American society for information science, 1994, 45(1): 12-19.

[25] 赵松山.对拟合优度2的影响因素分析与评价.东北财经大学学报, 2003(3): 56-58.

ZHAO S S.Analysis and evaluation of influencing factors of goodness of fit2.Journal of Dongbei University of Finance and Economics, 2003(3): 56-58.(in Chinese)

[26] 许文宁, 王鹏新, 韩萍, 严泰来, 张树誉.Kappa系数在干旱预测模型精度评价中的应用——以关中平原的干旱预测为例.自然灾害学报, 2011, 20(6): 81-86.

XU W N, WANG P X, HAN P, YAN T L, ZHANG S Y.Application of Kappa coefficient in accuracy assessments of drought forecasting model: a case study of Guanzhong Plain.Journal of Natural Disasters, 2011, 20(6): 81-86.(in Chinese)

Intelligent Forecasting Method of Rice Sheath Blight Based on Images

HAN XiaoTong1, YANG BaoJun2, LI SuXuan1, LIAO FuBing1, LIU ShuHua2, TANG Jian2, YAO Qing1*

1School of Information Science and Technology, Zhejiang Sci-Tech University, Hangzhou 310018;2State Key Laboratory of Rice Biology, China National Rice Research Institute, Hangzhou 311401

【Objective】At present, the forecast of rice sheath blight relies on the number of diseased clusters, the number of rice plants and the severity of each plant to calculate the disease index based on manual surveys.The method is highly professional, time-consuming and laborious.The data is difficult to trace.The objective of this study is to propose a detection model of rice sheath blight lesions and a damage grading model of rice sheath blight based on images, and to provide a theoretical basis for the intelligent forecasting of rice sheath blight.【Method】Images of rice sheath blight in paddy field were collected by a portable image acquisition instrument.Different detection models (Cascade R-CNN and RetinaNet) and feature extraction networks (VGG-16 and ResNet-101) were developed to test the detection effect of disease lesions.The best model was chosen.However, the Cascade R-CNN model appeared some missing detection of sheath blight lesions.Because the sheath blight lesions are irregular in shape, and variable in size and location, the Cascade R-CNN model was improved through adding OHEM structure to balance the hard and easy samples in the network and choosing the bounding box regression loss function.The precision rate, missing rate, average precision and P-R curve were used to evaluate the detection effects of different models.Based on the detection results of the improved Cascade R-CNN-OHEM-GIOU model, two damage grading models based on the area and number of disease lesions were developed, respectively.The determination coefficient (2) and Kappa value were used to choose the damage level model of rice sheath blight.【Result】Under the same backbone network conditions, the Cascade R-CNN model had a better detection effect on rice sheath blight than the RetinaNet model.The Cascade R-CNN-ResNet-101 model had the best detection effect on sheath blight lesions.The precision rate was 92.4%, the average precision was 88.2% and the missing rate was 14.9%.The improved Cascade R-CNN-OHEM- GIOU model effectively solved the problem of sample imbalance, and effectively reduced the missing rate by adding a border regression loss function, which was 8.7% lower than the missing rate of the Cascade R-CNN-ResNet-101 model, and the average precision was increased to 92.3%.With the results of manual disease grading as the standard, the grading model of rice sheath blight at 0 to 5 grades based on the area of diseased lesions had the accurate rates of 96.0%, 90.0%, 82.0%, 76.0%, 74.0% and 96.0%, respectively.The average grading accuracy rate was 85.7%, and the Kappa coefficient was 0.83.The damage grade results of rice sheath blight based on images were consistent with the manual grading results.【Conclusion】The intelligent forecasting method of rice sheath blight based on images can automatically detect the disease lesions and calculate the damage grade.This method increases the intelligence level and the results are objective and traceable.It may also provide an idea for intelligent forecasting of other crop diseases.

rice sheath blight; disease lesion image; intelligent forecasting; Cascade R-CNN model; damage grading model

2021-11-03;

2021-12-23

国家重点研发计划(2021YFD1401100)、浙江省自然科学基金(LY20C140008)、所级统筹基本科研业务费项目(CPSIBRF-CNRRI-202123)

韩晓彤,E-mail:453116984@qq.com。通信作者姚青,E-mail:q-yao@126.com

(责任编辑 岳梅)