融合邻域色差的PSPNet对遥感影像的分割

2022-02-22袁伟许文波周甜

袁伟,许文波,周甜

1. 成都大学 建筑与土木工程学院,成都 610106 2. 电子科技大学 资源与环境学院,成都 610097

1 引言

传统的遥感影像语义分割是利用影像的光谱特性,依靠某种算法进行变换后,设定一个阈值,将具有相似值的像素进行归类[1-5],但由于同物异谱现象的存在,提取效果不够理想。深度学习出现以后,因其可以自动提取特征等优势,现已成为遥感图像语义分割的主流方法,如文献[6]将建筑物的轮廓信息、区域信息和建筑物区域内至边缘的距离信息作为标签内容进行多任务训练,提高了建筑物的分割精度。文献[7]对UNet++进行了改进,在房屋提取上取得了更好的效果。文献[8]将DSM作为辅助信息进行学习,效果比SVM、GBDT、FCN-8s模型更好。文献[9]将注意力机制引入深度学习网络,在ISPRS的在线竞赛中总体精度排名第一。文献[10]联合深度学习和条件随机场进行遥感影像的云检测,取得了不错的效果。

有时,辅助信息难以获得。本文通过挖掘图片自身的信息,提出一种融合色差的方法,将像素与邻域的色差信息作为第4通道,共同输入到PSPnet[11]网络中进行特征提取。

2 邻域的色差计算

对于一幅图像而言,邻近的像素如果颜色不同不一定是不同的物体;然而邻近的像素如果颜色相似,则往往是同一物体。根据这一原则,可以将图像中的每个像素与邻域像素之间的颜色相似程度,作为已完成预处理的特征,以第4通道的形式融合到原始图像中,以弥补卷积运算无法进行平方和开方这类复杂运算的缺点,增强深度学习网络提取特征的能力。为此,需要计算出每个像素的邻域色差。

RGB是使用最为普遍的颜色空间,分为红色、绿色、蓝色3个通道,每个通道的值是0~255的整数。将这3个通道以不同的值进行组合,共有约1 678万个值,几乎可以表达现实世界所有的颜色。然而RGB颜色空间却无法通过计算各个通道的欧氏距离来衡量颜色的相似程度,因为RGB中一个通道的一点改变,会导致颜色发生巨大变化,而如果3个通道同时改变,却只会使最后的明暗发生变化,色调并不会产生巨大变化。1976 年,国际照明委员会(CIE) 推荐基于LAB颜色空间建立的 CIELAB色差公式[12],后来又先后推出了改进的公式CIE94[13]、CIEDE2000[14]等。除CIE推荐的公式以外,还有一些其他公式,如CMC[15]、IP[16]等。但这些公式普遍计算较为复杂,为了简化计算,采用CIELAB色差公式:

(1)

式中:ΔE为色差;ΔL为两个颜色的明度差值;ΔA为两个颜色的红绿差值;ΔB为两个颜色的黄蓝差值。

将每个像素与其周围的8个邻域像素之间求出色差,然后取其平均值作为该像素的邻域色差值:

(2)

将图像的每个像素求出邻域色差,再映射到0~255,形成一个单通道的灰度图像,如图1所示。将该通道与原始图像的RGB通过进行拼接,形成4通道的图像,输入到PSPNet进行训练。

图1 原始图像和对应的色差灰度图像Fig.1 The original image and the corresponding color difference gray image

3 PSPNet

PSPNet是2017年提出的深度学习网络模型,该模型结构如图2所示。首先,利用经典的特征提取网络,如VGG16、ResNet101,对输入图像进行特征提取,然后将得到的特征进行不同尺度的池化,以增强每个像素的实际感受野。图2中,红色模块是将整个特征图整体池化成1个像素,再卷积运算成深度为原来的1/4;黄色模块是将整个特征图等分为4块,分别池化为1个像素,得到2×2像素大小的特征之后再卷积运算成深度为原来的1/4;蓝色模块是将整个特征图等分为9块,分别池化为1个像素,得到3×3像素大小的特征之后再卷积运算成深度为原来的1/4;绿色模块是将整个特征图等分为36块,分别池化为1个像素,得到6×6像素大小的特征之后再卷积运算成深度为原来的1/4。最后将4个不同尺度池化后的结果上采样到输入特征图的大小,然后与输入特征图拼接在一起,再进行卷积运算,得到预测结果。

图2 PSPNet网络模型结构Fig.2 Structure of PSPNet network model

通过以上网络结构的运算之后,输出的每个像素就包含了全局、1/4、1/9、1/36的池化特征,感受野大大增强,从而获得更好的预测效果。

4 试验数据与评价指标

为了避免因数据集的独特性给网络的对比结果带来偶然性的影响,本文采用两个公开的遥感影像语义分割数据集进行试验。两个数据集的标注精度、地面分辨率都不相同,可以在各种情况下对模型进行对比,得出的结论也更有说服力。

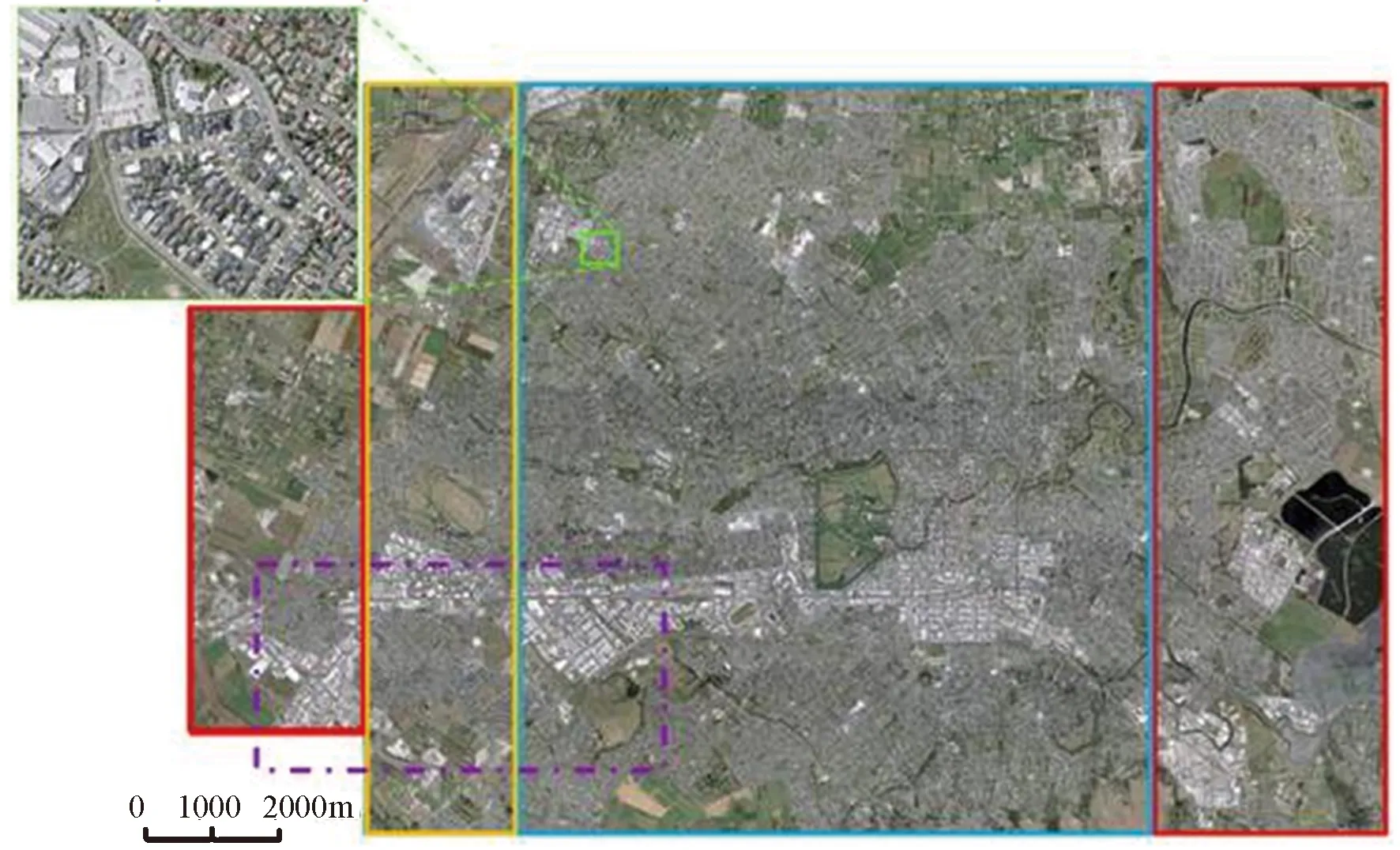

4.1 WHU building dataset

WHU building dataset[17]是由武汉大学季顺平教授团队用时近1年时间,人工制作的一套大场景、高分辨率的建筑物数据库,该数据库分为航空建筑物数据库和卫星建筑物数据库。如图3所示,本文选用的航空建筑物数据库影像来自新西兰Christchurch市,涵盖22万栋形式各异的建筑,覆盖面积约450 km2,地面分辨率0.075 m。原始影像大小为512×512像素,格式为tif,通道数为3,对应的标注影像为单通道tif格式数据。训练数据集为4 736幅分辨率为512×512像素的航空影像,测试数据集为1 036幅512×512像素的航空影像。

图3 WHU building datasetFig.3 WHU building dataset

4.2 Massachusetts building dataset

Massachusetts building dataset数据集也是航空影像,位于美国的麻省,覆盖面积约340 km2,地面分辨率为1 m 。原始影像大小为1 500×1 500像素,格式为tif,通道数为3,对应的标注影像为单通道tif格式数据。其中训练数据集包含137幅1 500×1 500像素的航空影像,按512×512像素的瓦片大小切割成1 233幅图像。测试数据集包含14幅1 500×1 500像素的航空影像,按512×512像素的瓦片大小切割成126幅图像。

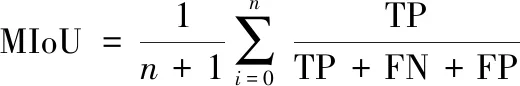

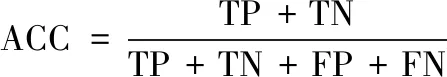

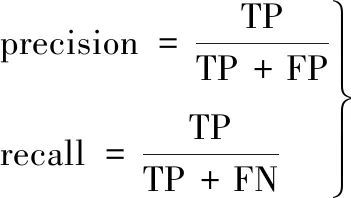

4.3 评价指标

为了更客观地验证本文方法的优势,采用平均交并比(MIoU)、准确度(ACC)、F1-score三个评价指标进行对比分析。

(3)

(4)

(5)

其中precision和recall的计算如下:

(6)

式中:n为前景分类数量,加上背景总共为n+1类;TP为真正,表示正确分为该类的像素个数;FP为假正,表示他类被分为该类的像素个数;TN为真负,表示正确分为他类的像素个数;FN为假负,表示该类被误分为他类的像素个数。式(3)先将背景和建筑物分别作为正样本求出的评价指标后,再取平均值便可得到所有类的平均评价指标。式(4)~(6)中正样本为建筑物。

5 试验与分析

本文试验的CPU型号是Intel I5-9400F,显卡为 NVIDIA GeForce RTX 2060 Super 8G,GPU 加速库采用 CUDA10.0。深度学习框架是TensorFlow和官方的高级封装库Estimator。

采用AdamOptimizer算法[18]寻找最优解,学习率为0.000 1。此外,采用文献[19]方法,对权重采用L2正则化,以防止过拟合,提高泛化能力。损失函数为交叉熵。迭代训练周期epoch最大值为100,每个epoch之后在测试集上进行评估,若连续10个epoch的评价指标都不再升高,则采用提前终止模型训练的策略(early stopping)结束模型训练[20]。

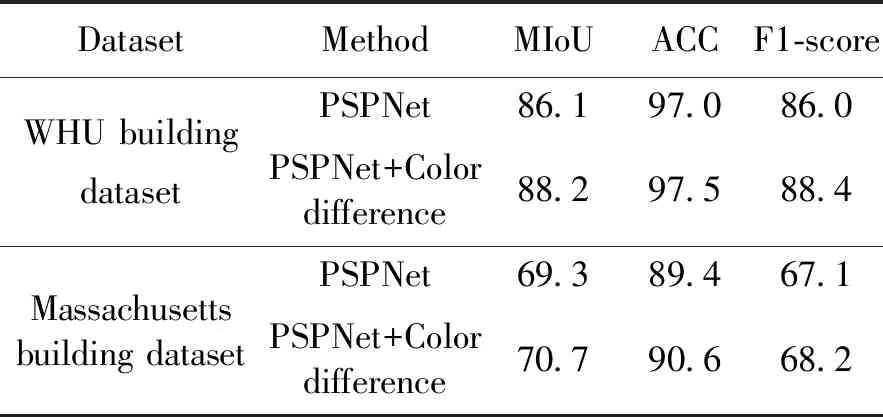

从评价指标来看,融入了邻域色差后的预测结果在两个数据集上的表现都更好一些,如表1所示。在WHU building dataset数据集上MIoU提高了2.1个百分点, ACC提高了0.5个百分点,F1-score提高了2.4个百分点。在Massachusetts building dataset数据集上,MIoU提高了1.4个百分点,ACC提高了1.2个百分点, F1-score提高了1.1个百分点。

表1 各数据集上网络模型评价指标对比Table 1 Comparison of network model evaluation indexes on each dataset

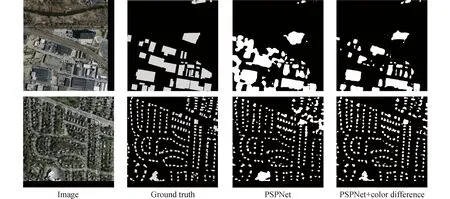

从两个数据集的测试数据上的预测图像来看,融入了邻域色差的预测结果效果更好,更接近于真实标签值。在具有相近颜色的像素上,融入了邻域色差预测结果更为一致,尤其在WHU building dataset的第2行图上更为明显,如图4第2行所示,原始图像中最右下角的房屋颜色都为灰白色,融入邻域色差后的预测像素大多预测为了房屋,只有中间个别像素预测为了背景,但是效果明显要好于没有融合邻域色差的预测结果。同时,在Massachusetts building dataset数据集上融入邻域色差前后的效果虽然说没有在WHU building dataset上区别这么大,但也可以看出,建筑物的训判情况要好很多,如图5第1行所示,水泥地被误判为建筑的情况大大减少。

图4 在WHU building dataset上的效果对比Fig.4 Effect comparison on WHU building dataset

图5 在Massachusetts building dataset上的效果对比Fig.5 Effect comparison on Massachusetts building dataset

6 结论

为了提高PSPNet网络的分割精度,本文提出一种融合邻域的色差信息的方法,先将整个图像RGB转换为LAB空间,然后分别计算每个像素与邻域8像素的色差值,最后取平均值作为该像素的色差信息。将色差信息与RGB值进行拼接形成4通过的图像,输入到PSPNet中进行训练和预测。

通过在两个公开的遥感语义分割数据集上进行对比试验,可以看出融合了色差信息值以后,在每个数据集上,几乎所有的指标均有所提高。并且从预测的图形上看,具有相似光谱信息的像素被预测成同一类地物的概率大大提高。

因此,本文提出的融合色差的方法,在一定程度上弥补了卷积运算的不足,是一种有效提高PSPNet预测精度的方法。