基于条件生成式对抗网络的CT金属伪影校正研究

2021-08-18钟发生刘丰林

马 燕, 钟发生, 刘丰林

(1.重庆大学 光电技术及系统教育部重点实验室, 重庆 400044;2.重庆大学 工业CT无损检测教育部工程研究中心, 重庆 400044)

0 引言

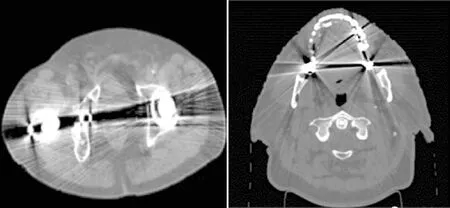

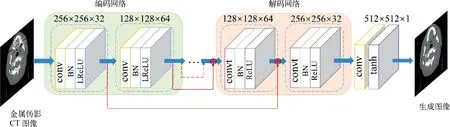

计算机断层成像 (Computed Tomography,CT)技术通过计算穿过被扫描物体的X射线衰减值,获取物体的断层结构信息[1]。在临床领域,CT技术提供比数字X射线成像技术更高的组织密度分辨率,使医生快速清楚地识别组织器官、准确诊断病变范围,进一步推动了病理研究和临床诊断的发展。在CT成像过程,若被扫描对象包含具有高衰减系数的金属物质时,会导致重建图像中出现金属伪影[2]。金属伪影的表现形式为金属物体的周围存在黑色的暗带缺失区域或黑白相间的放射状条纹[3],如图1所示。

图1 金属伪影CT图像

在临床诊断中,病人体内的金属固定修复体、金属矫治器、关节假体、金属钉等含金属成分的物体都会产生金属伪影[4]。金属伪影会阻碍组织类型的准确区分,影响后续诊断结果的准确性[5]。金属伪影校正的研究对提高重建图像清晰度和确保CT图像应用的准确性具有重要意义,对现有校正算法的改进与优化已成为学术研究和应用价值研究的重要课题之一。

近几十年,学者们提出大量金属伪影去除方法(Metal Artifact Reduction, MAR)。现阶段软件校正的方法分为五大类:基于物理效应的预处理、迭代重建、基于投影域的插值法、混合校正方法以及基于深度学习的校正方法[6-7]。一般可以通过设置CT扫描采集参数或改变获取扫描数据的方式减少金属伪影的生成,但在伪影情形复杂的情况下无法彻底将其消除,需要采用基于软件校正的处理技术。基于物理效应的预处理技术旨在对形成金属伪影的物理效应建立模型并拟和校正曲线,通过滤波、迭代等方法对数据进行校正以改进重建结果[8-9]。存在高原子序数金属的情况下,该方法误差较大。迭代重建法在迭代过程中引入适当的正则项以抑制金属伪影[10-11]。迭代法具有较强的抗噪性能,但由于算法步骤复杂耗时,其实用性受到限制。目前最常用、发展最广泛的MAR方法是投影插值法,其简单快速易实现,可以有效抑制大部分金属伪影[12-13]。实际应用中,在金属伪影校正时通常会结合不同校正机制的MAR方法达到理想的校正效果[14]。

随着计算机数据处理能力的提高,深度学习已广泛应用于图像分类[15]、图像检测[16]、图像去噪[17-18]等领域,在CT图像金属校正领域也展现出巨大潜力。2017年,Gjesteby[19]首次将深度学习的神经网络引入金属伪影校正领域,将卷积神经网络(Convolutional Neural Network,CNN)与传统的归一化金属伪影校正算法(Normalized MAR, NMAR)相结合,利用CNN网络完成从NMAR校正图像到无金属伪影图像的端到端映射,在视觉上取得较理想校正效果,结果表明深度学习是去除CT图像金属伪影的有力办法。2018年,Zhang[20]提出使用简单的CNN网络训练结合图像域后处理的伪影校正方法。该方法生成的图像质量优于传统MAR方法校正后的图像,伪影去除效果明显。2020年,我们提出一种基于残差编解码网络(Residual Encoder-Decoder Convolutional Neural Network,RED-CNN)的金属伪影校正(RED-CNN Metal Artifact Reduction,RED-CNN-MAR)算法[21]。将RED-CNN网络作为利用多种校正算法进行图像修复的工具,其三通道输入为原始图像和两幅不同的校正图像,并使用组织处理技术消除水当量组织的数据不一致性。该算法可以去除CT图像中微弱的金属伪影,提高伪影校正效果。

为进一步消除CT图像中平坦区域以及不同组织交界处残留的金属伪影,恢复原始真实的图像细节,本文提出了基于Pix2Pix网络的金属伪影校正(Pixel to Pixel Network Metal Artifact Reduction,Pix2Pix-MAR)算法。生成器模型选取RED-CNN网络框架来完成图像合成的工作,增强模型的拟合能力;在鉴别器的辅助下进一步约束目标图像与生成图像之间的相关性,并且鉴别器使用提取图像块进行加权求和计算平均值的方式进行判定,能够关注局部图像块之间的关联性,恢复出更细微的组织结构信息。

1 相关工作

1.1 基于RED-CNN网络的金属伪影校正方法

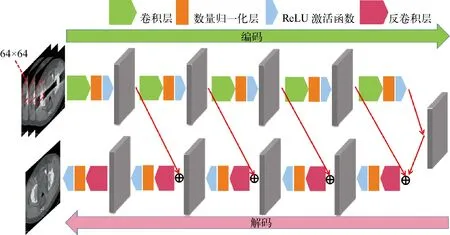

文献[21]提出采用RED-CNN网络初步完成金属伪影的修复工作,对网络训练所得图像使用组织处理技术进一步消除残留的微弱伪影,该方法中RED-CNN网络结构如图2所示。该网络主要包含两个模块:编码网络和解码网络。编码网络由实现特征提取的五层卷积层构成,其单元组成是Conv+BN+ReLU;解码网络由实现特征重组的五层反卷积层组成,其单元组成是Convt+BN+ReLU。在编码网络与解码网络之间加入跳跃连接结构形成残差网络以保护信息的完整性。卷积层提取不同层次的不同特征,反卷积层将提取的特征进行逆向求解重构输入。

图2 RED-CNN网络结构图

接着将RED-CNN网络训练后与图像域后处理的方法相结合,对RED-CNN输出图像进行二次修复。采用组织处理技术为水当量组织像素分配一个统一的值以达到消除伪影像素的目的。

用于伪影校正时,RED-CNN网络训练后的图像可消除大部分重度伪影,但是在平坦区域仍存在明暗相间的窄条带状伪影,为消除遗留的金属伪影,仍需要采用组织处理技术对图像进行二次修复。为更好地恢复图像细节并直接完成金属伪影CT图像到无金属伪影CT图像端到端的映射,本文考虑使用转换能力更强的生成式对抗网络模型进行图像训练,完成修复工作,并且舍弃神经网络训练之后的组织处理技术,使操作更为快捷、方便。

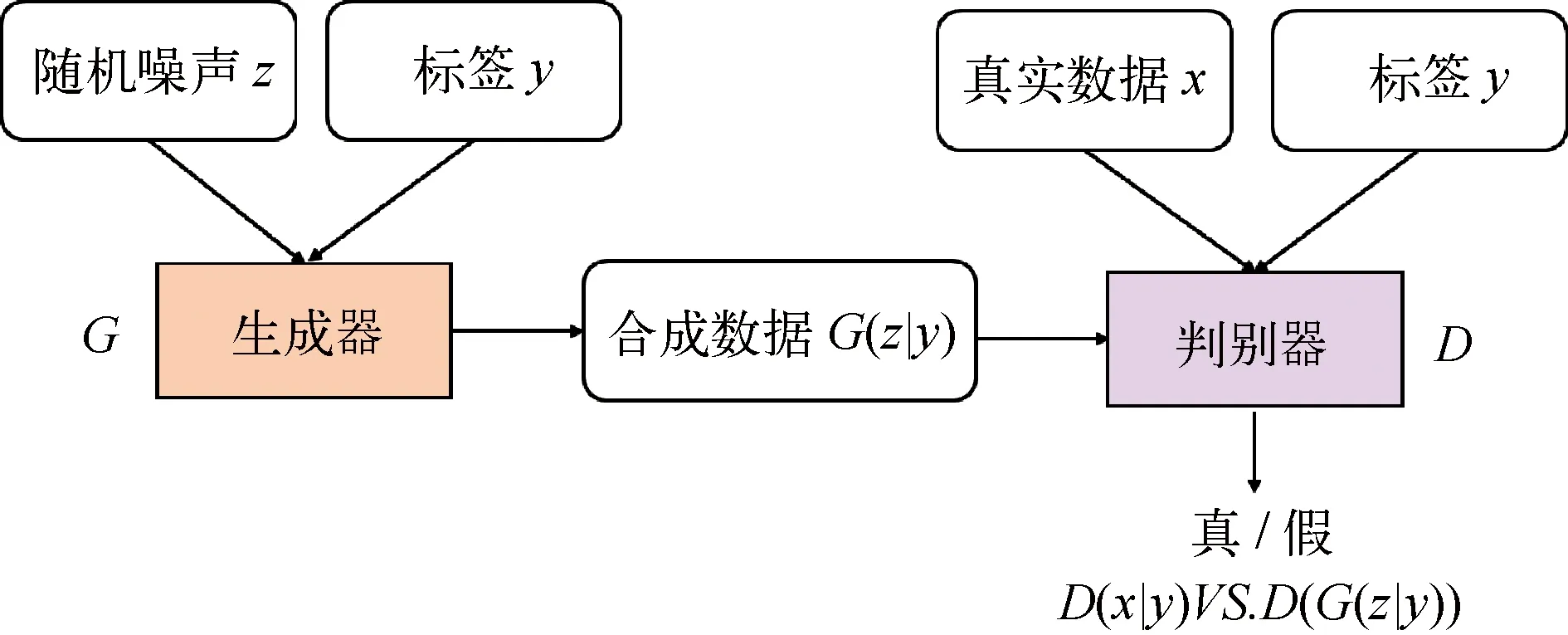

1.2 条件生成式对抗网络

相对于生成式对抗网络(Generative Adversarial Network, GAN)的生成器与鉴别器的输入,条件生成式对抗网络(Conditional Generative Adversarial Network, CGAN)[22]引入附加条件使模型可以在有监督的模式下进行训练,这个附加条件通常是理想条件下的目标图像,最终形成由输入图像到标签图像端到端的映射关系。图3所示为CGAN网络的组成结构图。

图3 CGAN网络结构图

CGAN的目标函数可以表述成如下形式:

Ez~pz(z)[log(1-D(G(z∣y)))]

(1)

式中,E(*)为分布函数的期望值;Pdata(x)为真实样本的数据分布;Pz(z)为输入的噪声变量标签;y为附加条件,用于约束网络的映射关系。在附加条件的约束下,生成器输入的训练图像随着特定的拟合方向合成新的图像,使得生成结果的方式不是完全无监督的。

2 方法

金属伪影的校正问题可以表述为金属伪影CT图像到无金属伪影CT图像的转换问题。本文将CGAN网络用于图像域以修复有金属伪影的CT图像。与残差网络相比,CGAN网络在图像修复领域具有更好的表现能力,基于博弈对抗思想的模型能充分地利用提取到的图像特征,在优化迭代的过程中生成接近参考图像的结果。

2.1 Pix2Pix网络结构设计

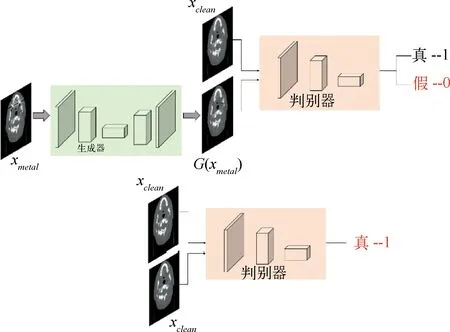

本文不使用CGAN网络的生成器与鉴别器的组成结构,使用改进型CGAN网络,即Pix2Pix网络[23]完成伪影校正工作。其生成器模型采用RED-CNN网络框架,鉴别器采用PatchGAN网络。

图4是本文Pix2Pix-MAR算法的网络模型结构图。生成器网络G的输入是金属伪影CT图像xmetal,生成的图像是网络训练后的校正图像G(xmetal);鉴别器D的输入是校正图像G(xmetal)或原始无金属伪影CT图像xclean。鉴别器的训练工作是在以原始无金属伪影CT图像xclean作为参考条件输入的情况下进行的。

图4 基于Pix2Pix-MAR网络的模型结构图

在优化生成器时,输入有金属伪影的CT图像,经过生成器网络G训练能够生成迷惑判别器模型的校正图像G(xmetal),使图像G(xmetal)尽可能地“骗过”判别器模型,判别为“真”。在优化判别器时,判别模型D在标签图像xclean存在的情况下,接受输入图像并判别该输入是来自真实无金属伪影CT图像xclean还是由生成器伪造的生成图像G(xmetal)。在有标签图像xclean的约束下,当输入图像来自生成器生成的校正图像G(xmetal)时,判别器判定结果为“假”;当输入图像取自真实图像xclean时,判别器判定结果为“真”。理想的优化结果是判别器与生成器达到平衡,鉴别器无法准确分辨生成图像和真实图像。

2.1.1 生成器网络

使用RED-CNN模型框架作为生成器网络,残差学习可以促进卷积层和相应反卷积层之间的信息传递。为加强生成器模型的合成效果,将无金属伪影CT图像作为条件约束加入到模型中,明确训练图像与参考图像之间端到端的映射关系,生成的图像结构细节更完善、分辨率更高。

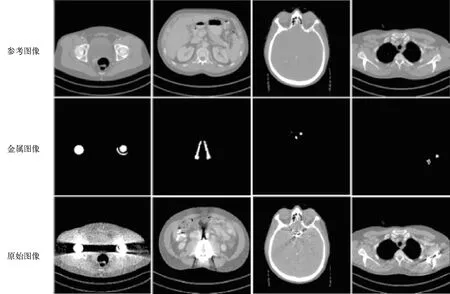

该网络的生成器部分使用文献[21]中的RED-CNN网络框架,结构深度为12层,包含6层卷积层与6层反卷积层,在卷积层与反卷积层之间引入残差映射机制形成残差网络。编码网络利用卷积层提取不同层次的不同特征数据,将特征组合映射到一个非线性空间。如图5所示,编码网络每一个小单元组成为Conv+BN+LReLU。在卷积之后,激活函数LReLU之前执行批量归一化操作(Batch Normalization,BN)。BN层可以解决训练过程中训练数据与测试数据偏离同分布的问题,改善梯度弥散、加快训练速度[24]。编码网络第一层的输入为尺寸大小是512×512的图像,每一层使用卷积核大小为4×4的滤波器进行特征提取,步幅和填充均设置为2,每层卷积运算之后输出特征向量大小变为原来的一半,而每层卷积核的数目增加为前一层的二倍,由第一层的32增加到最后一层的512,逐渐增多提取特征的种类。

解码网络利用反卷积层将提取的特征进行逆向求解重构输入。如图5所示,解码网络每一个小单元组成为Convt+BN+ReLU。在反卷积之后,激活函数ReLU之前执行BN层操作。第一层采用尺寸大小为3×3的反卷积核,步幅和填充设置为1;之后的层次均使用尺寸大小为4×4的反卷积核,步幅与填充设置为2。由于在编码网络与解码网络之间加入残差连接结构使得连接后特征向量维度加倍,所以卷积核的维度是从1024降为256,下一层是从512降为128,依次类推,最后一层得到大小为512×512×1的生成图像。

图5 Pix2Pix网络的生成器网络结构图

2.1.2 鉴别器网络

鉴别器网络的框架采用马尔科夫鉴别器PatchGAN[25],该鉴别器对输入图像取块区域进行预测,每个块输出一个预测概率值,最终的真伪判定概率值取所有块的平均值。采用基于局部图像块判别的PatchGAN判别器可以提高判别精度,加强图像中精细结构细节的恢复。对于某些特征差异大的局部图像特征,如金属伪影造成的暗带区域与组织的交界处能更好地识别处理,去除不同组织交界处残留的伪影,使最终生成的图像更接近真实的参考图像。

如图6所示,鉴别器网络每一层组成为Conv+BN+LReLU,每层卷积核尺寸大小为4×4,第一层数目为32,之后每层的卷积核个数依次为上一层的2倍,步幅和步长均设置为2。PatchGAN鉴别网络在整张图像中的若干个局部图像块基础上进行评价,首先输出一个N×N的矩阵,这个矩阵中的每一个元素代表每个局部图像块为真实图像的概率,将矩阵中所有元素求和取均值得到判别网络的最终输出。PatchGAN网络对局部图像块进行分析,元素之间较强的局部关联性更能关注到图像的局部细节,由于提取的图像块的大小远远小于整张图像的尺寸,多层次的卷积可以提取到不同位置不同层次的精细局部特征信息,在校正金属伪影的同时可以保持图像的细节和高分辨率。

图6 鉴别器PatchGAN网络结构图

2.2 损失函数

利用Pix2Pix网络对金属伪影CT图像进行训练时的优化目标包含两个部分:Pix2Pix网络的对抗损失函数Ladv与L1范数损失函数Ll1[22-23]。完整的损失函数如公式(2)所示:

L=Ladv+λLl1

(2)

式中,λ为用于控制L1范数损失函数的权重;λ设置为10。

2.2.1 对抗损失函数

Pix2Pix网络的目标函数是基于带有条件概率的极大极小值博弈理论,其对抗损失函数定义为:

Ladv=Exclean[logD(xclean,xclean)]+

Exmetal,xclean[log(1-D(xclean,G(xmetal))]

(3)

式中,xmetal为原始未校正图像;xclean为标签图像即无金属伪影图像;G为生成器网络;D为鉴别器网络;G(xmetal)为生成器根据输入图像生成的校正图像;D(xclean,xclean)为在有标签图像xclean的条件下,判断输入图像xclean的真伪;D(xclean,G(xmetal))为在有xclean的条件下,判断输入图像G(xmetal)的真伪。

判别器D的优化目标是使鉴别器能正确判定的概率最小化,即式(3)整体的期望值越大越好;而生成器G的优化目标是使鉴别器能正确判定的概率最小化,即式(3)整体的期望值越小越好。交替更新D和G的参数,直到判别器无法区分生成图像和真实图像为止。

2.2.2 L1范数损失函数

进一步引入L1范数损失函数以提高生成图像的质量,增强配对数据之间的一致性。L1范数损失函数定义为目标图像xclean与生成图像G(xmetal)之间的差值的绝对值:

(4)

式中,n为训练样本的数量。L1范数损失函数可以约束生成器生成的校正图像和目标图像之间的相关性,通过最小化该损失函数使得生成图像更接近于目标图像,提高校正图像质量。

3 实验结果与分析

3.1 实验环境及数据集

为确保Pix2Pix网络训练的有效性,需要采用与文献[21]相同的数据集和采用真实临床CT图像来生成金属伪影图像。从“The 2016 Low-dose CT Grand Challenge”数据集中收集大量DICOM格式的临床CT图像[26],并收集金属物体数据将其存储二值图像以代表真实情况下的典型金属物体,利用其生成各种金属植入物,如手术夹、钢钉、人工关节、种植牙等。将一个或多个二元金属物体放置到适当的解剖位置,调整金属植入物的位置、角度、大小与插入的金属材料种类,生成像素大小为512×512的金属伪影图像。该数据库中的代表性样本如图7所示,每一列代表一种金属伪影案例情形。将数据库中的图像进行旋转、翻转、放大、裁剪生成9500幅大小为512×512的图像。为保证训练所得模型的有效性,将数据集分成两部分,其中80%的数据用于训练,20%的数据用于测试。

图7 数据库中的代表性样本

本文算法在PyCharm平台上使用Tensorflow框架完成训练与测试,电脑硬件配置为Intel(R) Core(TM) i7-7800X CPU @ 3.50GHz,使用了两个型号为NVDIA GeForce GTX 1080 Ti的显卡配合CUDA9.0进行GPU加速,该显卡处理内存为11G。训练轮次(epoch)设置为1000,批处理参数(batchsize)设置为64,采用β=0.5的目标函数优化器Adam。初始学习率设为0.0001,模型训练过程中,在完成500个Epoch的迭代训练之后将学习率下降为0.000 01,经过约126 h后完成训练。

3.2 主观评价

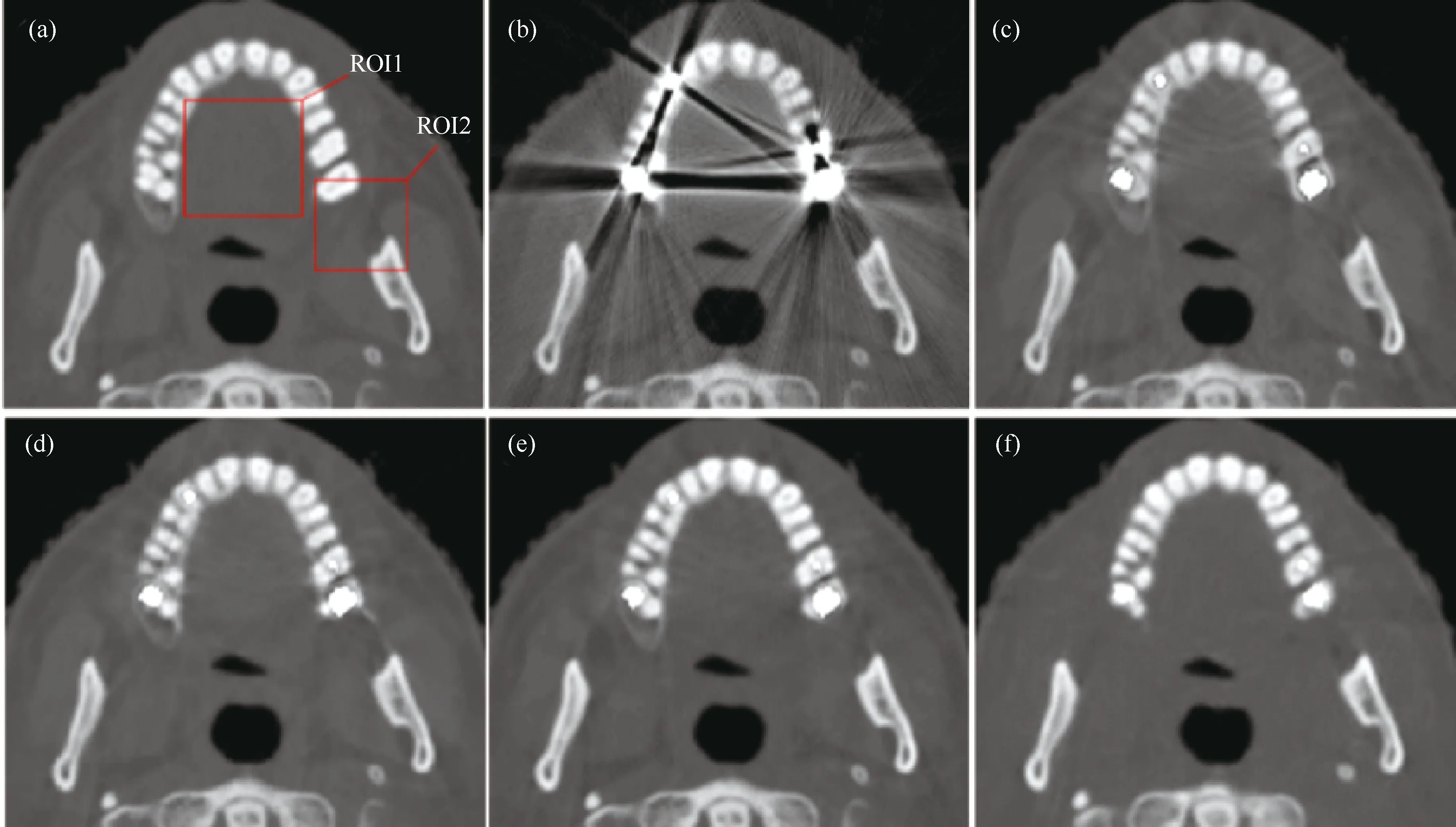

选取LI-NMAR算法[12]、CNN-MAR算法[20]和RED-CNN-MAR算法[21]作为本文实验的对比算法。其中LI-NMAR方法是将线性插值校正后的图像作为NMAR算法的初始图像进行校正。选取训练集外的三个案例进行测试,包括牙齿种植体、头部金属植入物和胸部金属植入物。

通过对伪影校正后的重建图像与未校正的金属伪影图像进行观察对比,从伪影去除、边缘恢复和细节保留三个方面进行评估。

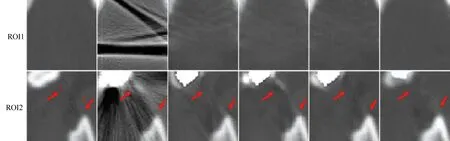

对(案例一)牙齿种植体进行测试,其校正效果图如图8所示。可以看出,不同算法校正后,伪影均得到有效抑制。相较于前几种方法,Pix2Pix-MAR方法的伪影消除效果较好。在图9的感兴趣区域1中,有效消除了明暗相间的条形伪影,且上颚区域的软组织区域恢复出的组织细节更平滑干净,图像清晰度明显提高。感兴趣区域2中恢复出的牙齿边缘轮廓更加清晰完整,但是由于图像平滑度增高在一定程度上造成少量低对比度组织的细节丢失。

图8 牙齿种植体的实验结果对比图(a)~(f)分别是参考图像、原始图像、LI-NMAR、CNN-MAR、RED-CNN-MAR、Pix2Pix-MAR图像

图9 图8(a)~(f)对应的ROI1、ROI2局部放大图

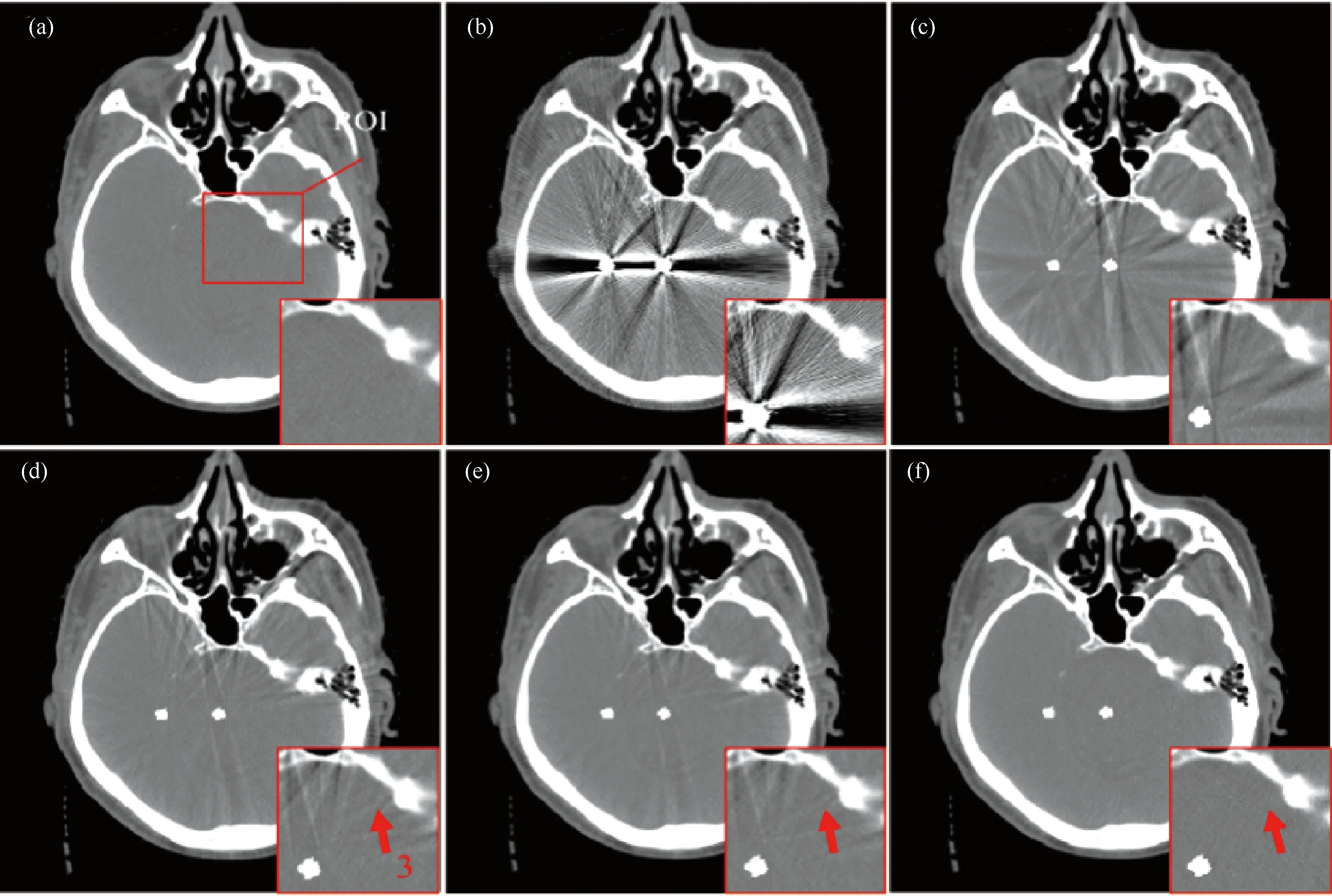

对(案例二)头部金属植入物进行测试。图10中给出头部金属植入物经过不同算法校正后的效果图。经过不同算法校正后伪影均得到有效抑制,在RED-CNN-MAR图像中金属周围的软组织区域结构恢复较为完整。Pix2Pix-MAR图像相较于前几种算法,伪影消除较彻底,前几种方法中在较为平缓的软组织区域均出现由伪影造成的轻微黑白相间的组织失真现象,而Pix2Pix-MAR方法校正后的图像软组织区域更完整清晰,结果更接近真实的参考图像。并且在箭头3所指处,即骨骼与软组织交界处伪影消除彻底,组织边缘和结构清晰,图像质量显著提升。

图10 头部金属植入物的实验结果对比图(a)~(f)分别是参考图像、原始图像、LI-NMAR、CNN-MAR、RED-CNN-MAR、Pix2Pix-MAR算法校正后的图像

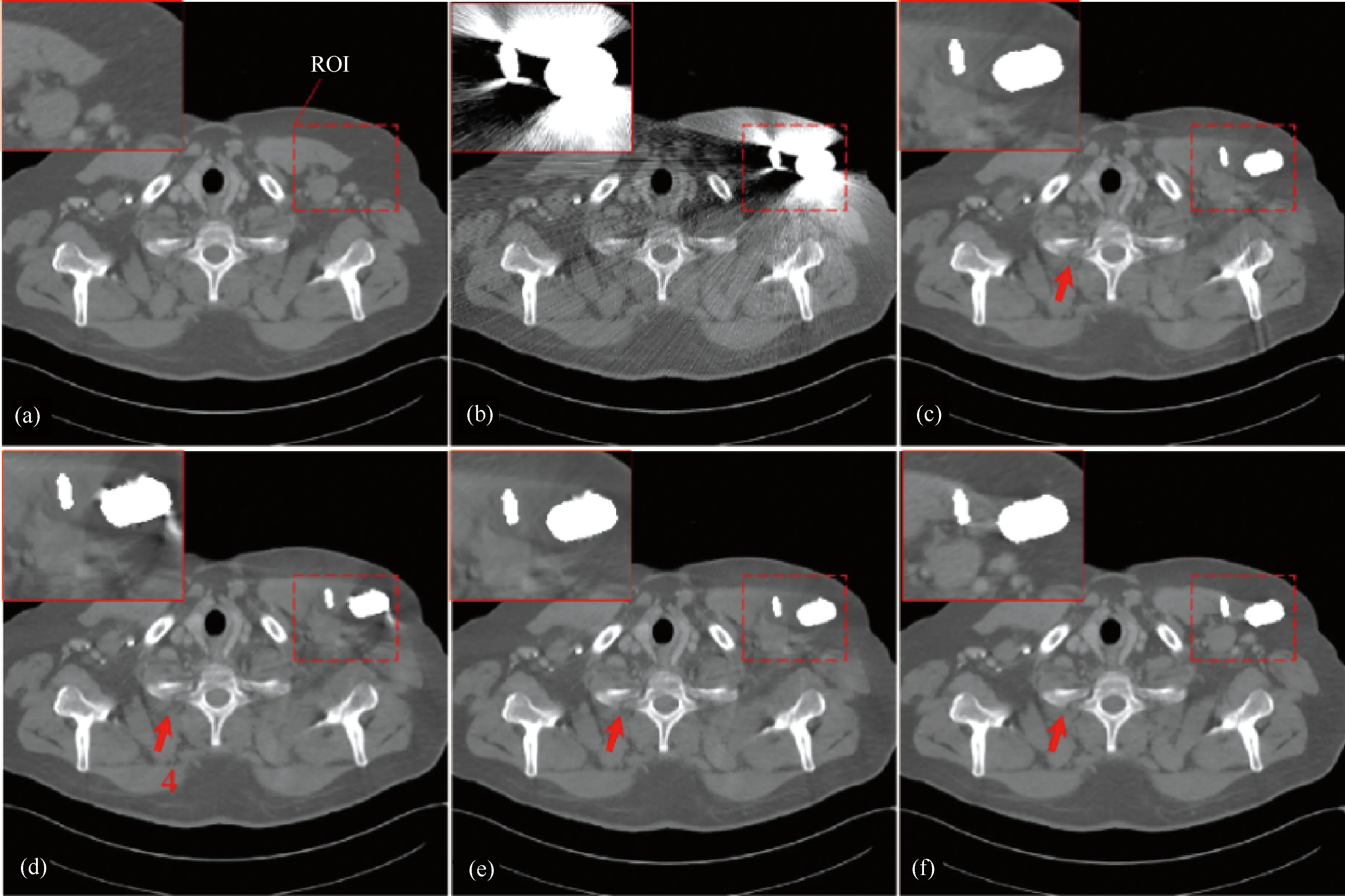

对(案例三)胸部金属植入物进行测试。如图11所示为各算法校正后的结果图。与前几种算法相比,Pix2Pix-MAR方法校正后,金属伪影得到有效抑制。金属与软组织交界处的金属伪影明显消失,金属的轮廓边缘更清晰完整;在箭头4所指处,恢复出了不同骨骼组织的轮廓边缘,组织间隙明显,生成的图像更近于真实无金属伪影图像。

图11 胸部金属植入物的实验结果对比图(a)~(f)分别是参考图像、原始图像、LI-NMAR、CNN-MAR、RED-CNN-MAR、Pix2Pix-MAR图像

3.3 客观评价

在数值分析方面验证该方法的可行性,采用客观评价指标采用结构相似性指数(Structural Similarity Index Measure, SSIM)、均方根误差(Root Mean Square Error, RMSE)和峰值信噪比(Peak Signal To Noise Ratio, PSNR)对不同算法校正后的图像进行评估。它们的定义如下:

(5)

(6)

(7)

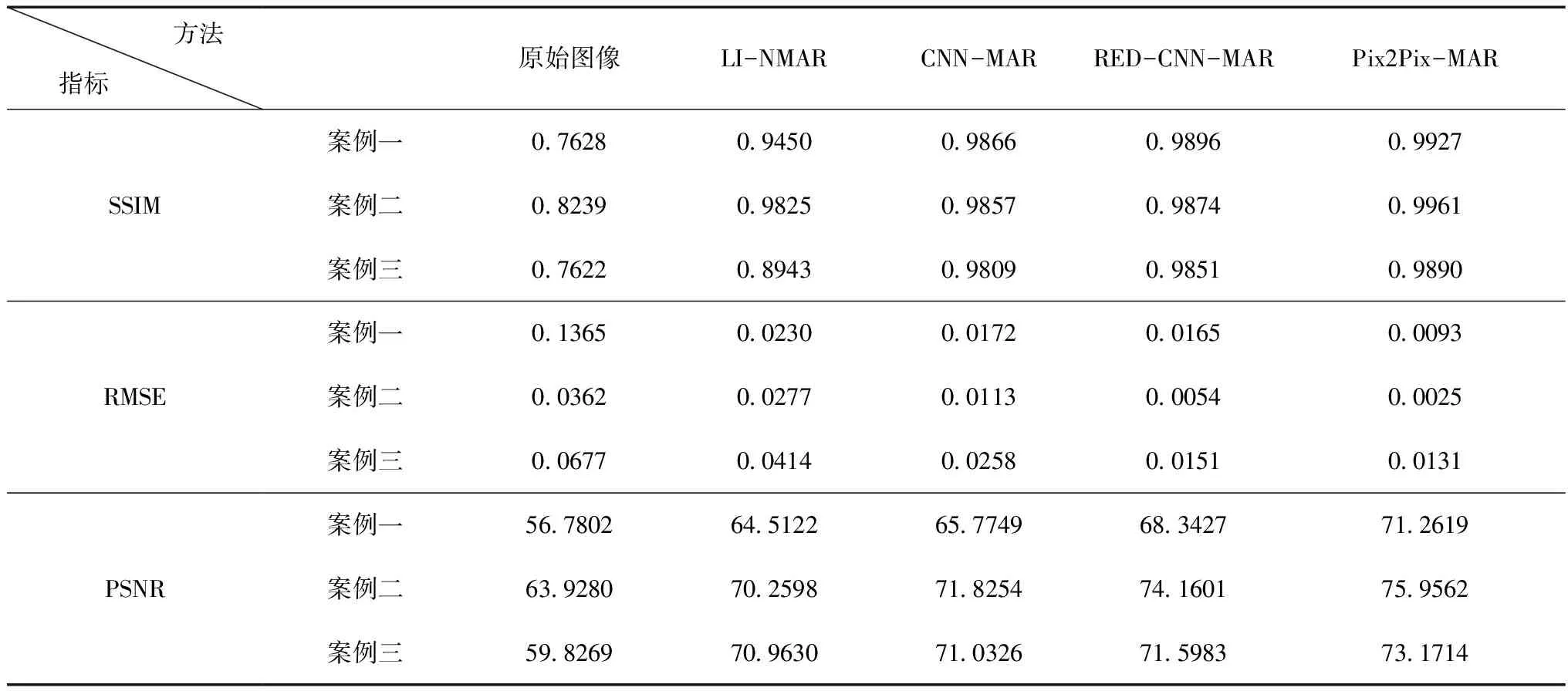

各校正图像的评价指标计算结果如表1所示。在案例一和案例二中,该算法相较于前两种算法质量评价指标显著提升。与RED-CNN-MAR方法相比,Pix2Pix-MAR图像的SSIM值分别提高0.0031和0.0087,PSNR值分别提升2.9192 dB和1.7961 dB;其次,RMSE值也分别减小0.0072和0.0029。在案例三中,该算法也取得了较高的SSIM值、PSNR值与较低的RMSE值。

表1 多种算法的定量评价结果

3.4 讨论

Pix2Pix-MAR算法校正后图像质量评价指标的提升验证了该算法的有效性和优异性,应用该算法对金属伪影的校正效果较好,且恢复出的组织结构细节更完整、准确。

与RED-CNN-MAR方法相比,加入条件标签后的Pix2Pix网络在监督训练的情况下合成图像,结合判别器的判定结果可以使生成图像更接近于目标图像,两者间的相互制衡进一步消除过渡区域组织结构的数据误差,提高图像分辨力。此外,鉴别器采用PatchGAN网络关注生成图像与目标图像之间局部图像块的相似性,与判定整张图像相比,局部图像块提取到的细节特征更丰富,能分辨生成图像与参考图像之间更加细微的差别,所以Pix2Pix-MAR方法具有较强的细节恢复能力。

综上所述,Pix2Pix-MAR方法生成图像的评价指标均有所提高,可以消除不同组织过渡区域残留的微弱金属伪影,并完整地恢复金属植入物所处的骨骼区域结构或软组织区域,生成的图像较清晰、真实。但是,由于其较强的平滑修复性能,导致少量低对比度的特征在算法校正后失去原有的细节。

4 结语

实际应用中,金属伪影校正技术的发展对CT诊断和图像分析起着至关重要的作用,深度学习为MAR算法的发展提供更多的可能性。针对现有MAR算法中图像细节恢复不完整、平坦区域或组织交界处伪影消除不彻底等问题,本文提出一种基于条件生成式对抗网络的金属伪影校正算法。该方法利用Pix2Pix网络直接完成金属伪影CT图像到无金属伪影CT图像的转换工作。其中,生成器模型采用RED-CNN网络框架,鉴别器模型采用基于判定局部图像块的PatchGAN网络,并将无金属伪影的CT图像作为标签图像加入到模型中监督映射关系。

本文提出的算法可消除不同组织交界处残留的微弱金属伪影,恢复出真实的组织细节与清晰的边缘轮廓,具有较强的伪影去除能力与较好的图像修复能力。实验结果表明,本文算法校正后的图像质量优于前几种算法,证明了该方法的有效性及优越性。但是由于图像平滑过度,导致图像中少量低对比度细节丢失。如何进一步提高图像质量、保留图像中更多的组织细节信息需进一步研究。