面向在线学习的多模态情感计算研究

2018-05-14薛耀锋杨金朋郭威李卓玮

薛耀锋 杨金朋 郭威 李卓玮

摘要:随着计算机网络技术和多媒体技术的快速发展,在线学习凭借其突破时间和空间限制的优势,越来越受到教育工作者和学习者的青睐,但是在线学习过程中学习者情感交互缺失的弊端也是教育研究中亟待解决的问题。针对此研究困境,在已有情感交互研究的基础上,结合情感计算理论,该研究提出了面向在线学习的多模态情感计算模型。该模型包括在线学习中学习者的情感数据收集、情感数据处理与分析、情感数据可视化以及在线学习反馈与干预等四个模块。基于此模型,研发了情感计算原型系统,通过记录和分析在线学习者脸部表情、语音和文本等信息,实现在线学习过程中的情感测量。在线学习实验中,通过比较和分析情感计算原型系统的测量记录,验证了该系统的可行性和有效性。

关键词:情感计算;在线学习;情感模型;多模态;学习干预

中图分类号:G434 文献标识码:A

一、引言

随着信息技术在教育领域的不断应用,教育模式和教育方法不断发生变革。在线学习以其独特的时空优势成为当代众多学习者的选择。随着可汗学院、慕课、网易云课堂等进入大众视野,在线学习平台如雨后春笋般相继涌出。但因其缺乏师生与人机之间的情感交互,导致在线学习者的情感得不到及时回应。很多文献研究表明,情感计算已成为在线学习研究中的重要课题。情感计算在教育中的应用可以使用户更舒适的进行情感交流。

针对在线学习过程中,学习者情感交互缺失的问题,本研究设计了面向在线学习的多模态情感计算模型,旨在实时记录与测量学习者的学习情感,并根据对学习情感的分析,给予学习者恰当的学习反馈与学习干预,从而提升学习者在线学习的学习效果。该模型在识别学习者的脸部表情、眼睛、姿态、语音和文本等情感信息的基础上,对学习者情感数据进行可视化处理,以便在线学习者和学习平台教学管理人员可以实时、直观地跟踪学习者的情感状态,从而为在线学习者提供过程性、总结性学习反馈与多种学习干预措施。基于此模型,我们开发了在线学习情感计算原型系统。该系统综合了人脸表情识别、语音识别和文本识别等三种技术分析在线学习者的实时情感状态。相较于使用单一识别技术的情感计算系统,本文所提出的系统具有更好的抗干扰性。

本研究的开展在现有的在线学习情感交互研究的基础上,提出了较为完整的面向在线学习的多模态情感计算模型,将情感计算在在线学习中的应用过程划分为学习情感测量、学习情感分析、情感数据可视化和在线学习反馈与干预四个环节,并且基于此模型研发了情感计算原型系统,通过实验检验在线学习过程中的情感计算,验证了该系统的有效性。

二、基于情感计算的在线学习系统理论支撑

近年来,情感计算在教育、认知科学等各大领域逐步受到重视。相关研究结果表明,积极的学习情感能够提高学习者的创造性水平、记忆以及推理能力等,进而提高在线学习者的学习效率。为了进一步研究人类情感的识别问题,国内外学者提出了多种情感建模方法,并基于认知生理学以及脑科学等多领域研究奠定情感计算的理论基础。

(一)情感模型

情感模型的建立可以使我们更容易理解情感产生的机制。目前国内外已有多种典型的情感模型,比如Picard等提出的隐马尔科夫模型、Onony等提出的OCC(Onony,Clore,Collins)模型、Roseman等提出的基于事件评价的情感模型、Plutchik提出的情感三维模式、魏哲华等基于人工心理学提出的状态空间情感模型、王巍等基于隐马尔可夫模型的改进模型以及Russell等提出的环形情感模型等。Pieard等提出的隐马尔科夫情感模型,其核心思想是人在任何时刻都会有一种情感状态,在不同时刻的情感状态能够以一定的概率进行转换。由于隐马尔科夫模型可能会因为情境变化而有所不同,所以不同情感状态的转变概率也会因为情境、主体和客体等的不同而发生改变。学习情感是特定情境下的一类情感状态集,其变化状态符合Picard的情感原型。本文以Picard的隐马尔科夫情感模型为基础,结合对学习情感特点的分析,提出了学习情感的隐马尔科夫模型(如图1所示)。伴随着学习过程的进行,不同学习情感状态以一定的概率进行转变,概率值会因学习情境、外界刺激和主体内部控制等多种因素发生变化。

(二)情感類别

学习情感是特定情境下的情感集合,实现在线学习情感计算的研究,首先要明确研究的情感类别及其特征描述。在情感研究中,不同的学者提出了很多情感类型,其中包括最常见的四种基本情感:害怕、生气、悲伤和开心和Ekman等提出的6中基本情感:高兴、惊讶、厌烦、悲伤、恐惧和愤怒,以及Plutchik提出的8种基本情感:害怕、生气、悲伤、开心、厌恶、信任、预期和惊讶。在学习情感研究中,北京师范大学孙波教授团队提出了7种基本学习情感类型:高兴、惊讶、厌烦、困惑、疲劳、专注及自信。本文在前者研究的基础上,结合对在线学习者的情感状态特征分析,以Plutehik和Ekman的情感理论为基础,将基本学习情感分为6类,分别是:高兴、惊奇、中性、生气、疲劳和困惑。

(三)情感识别

美国麻省理工学院的Picard教授提出,情感计算的流程一般包括情感数据获取、情感特征提取、情感特征分类以及情感识别四大部分。单一情感识别方法一般包括基于人脸表情、或语音语调、或文本信息、或肢体行为或生理信号识别。人脸表情多是基于人的面部动作进行识别;语音主要通过对人的音质、韵律等声音特征的提取以及分析上下语义等识别;文本识别主要通过关键词模糊匹配、词汇关联以及语义理解等技术实现;人的肢体行为(托下巴、擦眼、挠头、身体前倾等)可以作为肢体情感识别的关键特征。

(四)神经生理学

情感识别的关键是找出人们的情感和生理状态之间的联系。人类情感由大脑的情感中枢控制,当情感产生与变化时,机体的脑垂体、肾上腺以及甲状腺会分泌特定的激素,同时与情感相关的神经化学物质也会发生相应的变化。机体产生的情感生理信号相较于人类外显的情感行为,基本不受人主观因素的影响,因而能够更精确、客观的反映人类真实的情感。

随着可穿戴设备在学习、生活中的逐步应用,在线学习者的生理信号获取成为可能。通过提取、分析生理信号特征,能够识别多种情感。

三、基于多模态情感计算的在线学习模型

将情感计算嵌入到在线学习系统中,可以在一定程度上提高在線学习者的学习效率。本文从在线学习者角度出发,结合情感数据的采集、处理、分析与可视化,设计了如下页图2所示的面向在线学习的多模态情感计算研究模型。该模型强调学习情感变化路径对于学习干预的重要性,认为学习干预的存在形式应多种多样,以适应在线学习者的不同学习风格。

面向在线学习的多模态情感计算研究模型包括以下几个模块:

1.情感数据收集模块:在线学习过程中,学习者的学习情感可以通过多种方式反映出来。传统课堂教学中,教师可以通过学习者的面部表情、眼神交流、说话的音量音调、讲话内容以及身体姿态来确定学习者实时的情感状态。在当代技术和软硬件设备的支持下,能够收集在线学习者全方位的情感数据:深度摄像头技术不仅能够识别流媒体的彩色和灰度信息,还可以获得其深度数据,从而方便地采集到在线学习者的身体姿态和面部表情数据。人在一定的条件下,会做很多无意识的活动,而在进行在线学习时,头部和手臂动作在一定程度上也能反映当前学习者的情感状态;眼神状态主要是通过眼动仪等设备进行采集,采集的数据包括在线学习者的眼睛焦点等;通过学习终端自带的录音设备能够采集在线学习者的语音数据;在线学习者的文本输入内容,既可以通过在线学习系统后台实时监测、记录下每个学生的活动轨迹及文本信息,也可以通过爬虫等技术获取。而比较容易被忽略的是在线学习者的生理情感数据,一般来说当人处于愉悦、悲伤或其它情感时,心率等生理信号就会发生一定的变化,而基于可穿戴设备能够对这些数据进行实时的收集。近几年来,可穿戴设备的快速发展,也为基于生理信号的情感计算提供可能。

2.情感数据处理与分析模块:根据情感数据的来源,综合多种途径对在线学习者情感数据进行分析与处理。目前在线课程学习者的情感识别大多是采用单一识别技术,其识别精度存在提高空间。为了能够更准确地识别在线学习者的情感类型,本文提出了基于多情感识别技术的情感类型识别方法,即综合人的面部表情、眼部状态、人体姿态、语言和文本等多种情感特征识别在线学习者情感类型。

3.学习情感数据可视化模块:情感数据可视化模块可以帮助学习者、教师及相关教育人员更直观地了解学习者的学习情感状态。基于单个学习者某时间学习情感数据的可视化图像,可以直观地观察该学习者在该时间段每个节点的学习状态以及整体的情感变化状态,从而了解其学习困难点与整体学习效果,提供个性化服务支持;基于多个学习者学习同一资源的情感数据可视化图像,可以直观了解该学习团体的情感认知变化,从而在对学习资源的教学实用性进行分析与评价的基础上,调整教学策略以适应学习者整体认知状态。

4.学习反馈与干预模块:学习干预是将情感计算嵌入到在线学习系统的最终目的。很多文献中都采用情感助手(情绪助手1的形式实现在线学习中的人机交互,情感助手存在的形式多种多样,比如以文本对话框、虚拟人物表情变化等形式出现,增强学习者学习情感交互体验。本文根据干预出现的时间,将学习干预分为过程性干预和总结性干预。过程性干预是根据学习情感变化路径,在学习过程中实施的干预。理论上来说,每条学习情感路径,都应该有相对应的学习干预策略。但鉴于实际的可操作性,可以将基于多种学习路径的学习情感分为三种:积极情感、消极情感和中性情感。根据不同学习情感实施相应的学习干预,比如积极学习情感给予奖赏或不作为、消极情感给予鼓励,而对长时间处于消极情绪的学习者中断其原有学习路径并给予补偿性(替代性)学习资源。总结性干预是在阶段性学习结束后进行的干预,它主要是通过两种方式实现:一是对教学资源、教学策略等的更替,来适应学习者之后的学习;二是对学习者进行生理、心理上的教育,它既可以来自虚拟教师,也可以来自现实中的教师、家长和学习同伴。无论是过程性干预还是总结性干预,干预形式都不是一层不变的,它们既可以是文本框和虚拟人物的提示信息,也可以是现实世界的分享交流。

四、原型系统设计与开发

为了验证本文所提出的模型的可行性,我们设计和开发了面向在线学习的多模态情感计算原型系统。该原型系统综合了人脸面部表情识别、在线语音情感识别、文本情感识别三种方式对在线学习者6种基本情感进行了研究分析。除了学生登陆等基本模块外此原型系统包含四个模块:在线学习者数据采集模块、情感识别模块、情感数据可视化模块和辅助学习反馈/干预模块。原型系统的结构框架如图3所示。

1.在线学习者数据采集模块:该模块主要实现了对在线学习者的情感数据采集功能。此模块借助深度摄像头、语音输入输出设备等捕捉在线学习者的脸部表情和语音信息,基于爬虫技术采集在线学习者在平台发布的文本信息。

2.情感识别模块:原型系统的人脸表情识别是基于深度摄像头获取人脸面部运动单元,从而提取情感特征并进行隋感分类;文本情感分析是通过在线文本与情感词汇库模糊匹配技术实现;语音情感是基于在线学习者发表的语音内容等进行识别。基于文本、语音及人脸表情情感识别结果,计算在线学习者最终情感。

3.情感数据可视化模块:数据可视化能够更直观的反映在线学习者的情感变化状态。图4是一位在线学习者的情感数据可视化显示图。由图4可以看出,除中性情感状态外,该学习者的大部分时间的情感状态。虽然存在短时间的学习疲劳期和困惑期,但总体而言,该学习者在进行在线学习时,情感状态良好。

4.輔助学习反馈/干预模块:反馈与干预是面向在线学习的多模态情感计算系统最重要的部分。理想的辅助学习反馈/干预模块应该针对不同学习风格的在线学习者提供个性化的学习支持服务。鉴于系统开发等方面的因素,本文设计了两种学习反馈/干预形式:第一种是在阶段性学习过程中进行干预,根据每个在线学习者的实时学习情感可视化分析,提供含有文本和图片因子的个性化提醒服务;第二种是在阶段性学习过程结束后,针对在线学习者的学习情感状态分析,在线学习平台智能推送补偿性学习资源与测试服务。

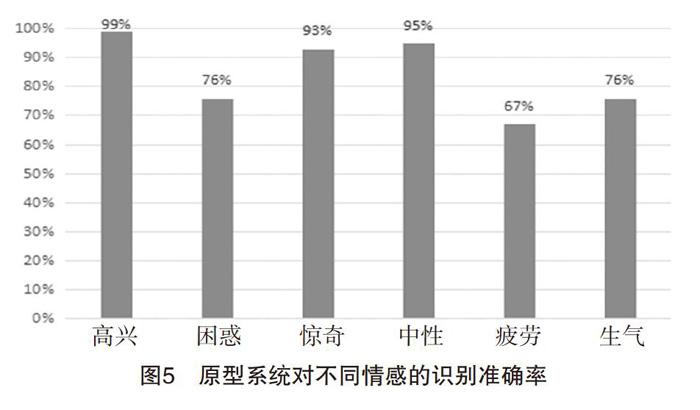

最后,为了分析该原型系统的可行性和有效性,我们借助知名慕课平台的在线学习课程开展了实验研究。实验过程中,34名志愿者参与了测试,测试人次为643,实验人员对志愿者进行情感观察和记录,同时使用多模态情感计算原型系统捕捉、记录、分析被试的学习情感。学习结束后,实验员和多模态情感计算原型系统分别同步采集到242022条情感记录。图4所示是多模态情感计算原型系统记录的一位被试人员的学习情感数据随时间变化的可视化折线图。在对其中21名志愿者,测试人次为630的测试记录结果进行分析,对比实验人员的观察记录,原型系统的平均识别正确率接近84.33%,如下页图5所示。其中高兴和惊奇等积极学习情感正确率较高,疲劳、困惑等消极学习情感识别率相对较低。我们分析可能的原因是,积极情感外显的表现比较明显,而消极情感表现形式往往各有不同且变化幅度较小。

五、总结与展望

目前基于情感计算的在线学习系统开发较其理论研究相对比较匮乏,而将理论转化为实践是发挥其价值至关重要的一步。本文在大量文献研究的基础上,设计了基于隋感计算的在线学习系统模型,并在此基础上开发了其原型系统,并通过实际测试分析了系统的可行性和有效性,为之后在线学习和情感计算的研究人员提供参考。但是,本研究仍然存在一定的不足和需要完善的地方。本研究提出的基于情感计算的在线学习系统模型描述了情感计算在在线学习中应用的完整过程,包括情感测量、情感分析、情感数据可视化和学习干预。在实验过程中所研发的多模态情感计算原型系统已初步具备情感测量、情感分析和情感数据可视化的功能,但是在语音情感识别、文本情感识别、学习干预等模块和环节,尚需进一步与在线学习平台进行整合,从而构建完整的基于情感计算的在线学习系统。本研究将针对目前存在的不足之处,继续开展相关研究工作。随着在线学习平台的广泛应用和教育大数据应用技术的不断发展,在线学习者的学习情感将会被更准确地识别和追踪。基于情感计算的在线学习平台将为学习者提供更加个性化、全方位的学习服务,实现智慧教育的理想目标。

收稿日期:2017年6月2日

责任编辑:赵云建