基于高斯混合模型和AdaBoost的夜间车辆检测

2018-03-20宋俊芳宋焕生

陈 艳,严 腾,宋俊芳,宋焕生

(1.长安大学 信息工程学院,西安 710064; 2.长安大学 外国语学院,西安 710064; 3.西藏民族大学 信息工程学院,陕西 咸阳 712082)(*通信作者电子邮箱373433788@qq.com)

0 引言

智能交通监控系统需构建一个准确、高效的交通信息采集系统,而夜间车辆检测是交通信息采集系统中不可或缺的组成部分,可为车型分类、交通事件检测、交通流调查等提供有效信息。近年来国内外诸多研究对车辆检测开展了深入的探索,建立了基于环形线圈、雷达[1-4]和机器视觉的车辆检测方法。基于环形线圈的检测精度高、检测简单但灵活性差、功能单一,基于雷达的检测虽不受天气光照的影响但维护复杂,基于机器视觉的检测方法具有丰富的信息含量且成本代价低,因此基于机器视觉的车辆检测方法应用最为广泛。

针对视频车辆检测的特征,基于机器视觉的车辆检测方法一般分为基于背景模型的检测、基于颜色亮度模型的检测和基于几何特征模型的检测。基于背景模型的车辆检测主要是通过背景差、帧差、混合高斯模型或ViBE(Video indexing and Browsing Environment)算法等全局图像检测车辆。Yang等[5]采用基于边缘的背景差分法和基于区域的背景差分法,利用支持向量机(Support Vector Machine, SVM)进行车辆检测分类。Zhang等[6]采用三帧图像差分法检测车辆,通过深度卷积神经网络识别车辆类型。Basri等[7]提出通过调整交通拥挤下检测的感兴趣区域,采用优化后的高斯混合模型(Gaussian Mixture Model, GMM)检测车辆,从而实现对车辆的计数分析。Wei等[8]利用ViBE背景模型提取背景,根据形态学图像处理方法检测运动车辆。St-Charles等[9]根据像素的空间特征,采用基于像素级的反馈环路的非参数模型,自适应背景更新检测车辆。于万霞等[10]提出在YCbCr(Luminance,Chrominance-blue,Chrominance-r)颜色空间上的背景差分方法,根据迭代处理确定提取背景的阈值。上述方法由于车辆遮挡和阴影等复杂因素的影响,导致背景提取不稳定,存在“鬼影”目标等问题,误检率高。基于颜色模型检测主要包括在RGB(Red-Green-Blue)、HSV(Hue-Saturation-Value)、YCbCr颜色空间中利用局部车灯的颜色分量来检测车辆。刘勃等[11]提出在RGB图像中搜索R颜色特征,结合车尾灯的运动信息检测跟踪车辆。O’Malley等[12]采用适合于HSV空间的红色阈值检测车尾灯,利用颜色互相关对称性确定车尾灯对。Swamy等[13]利用颜色空间模型,根据每个像素的颜色和亮度畸变检测车辆前景图像。由于夜间光线较暗和车尾转向灯等的影响,摄像机捕捉的车辆颜色信息不够准确,导致上述方法在检测颜色特征定位车灯时误差偏大。针对这两种方法,基于几何特征的检测是通过局部车灯部件的形状信息、对称特性等,初步确定车灯区域,利用车灯进一步检测车辆。Wang等[14]通过提取车灯信息,根据车灯的特征利用AdaBoost(Adaptive Boosting)分类器检测车辆。Juric等[15]通过粒子滤波器检测车灯,根据车灯的局部特征配对分类车灯,从而实现车辆的跟踪。欧志芳等[16]采用阈值法分割明亮块,通过车灯对的面积比、互相关值和长宽比的D-S(Dempster-Shafer)证据理论检测车辆。以上方法都是在二维交通场景下提取车灯信息,但因摄像机的透视关系,车灯图像存在尺度变换和几何形变,导致提取的车灯信息不准确,因此本文在Wang等[14]的方法上提出在逆投影图下提取车灯真实信息,根据车灯真实的空间几何关系,构建车灯对的高斯混合模型,初步检测车辆,设置逆投影图车辆样本,利用AdaBoost分类器进一步检测车辆,实现对夜间车辆的快速准确检测。

1 基于GMM和AdaBoost的夜间车辆检测

1.1 逆投影

智能交通监控系统采用固定单目摄像机拍摄视频图像,此视频图像是三维空间场景到二维平面图像的投影。因摄像机的透视关系,二维图像与真实三维场景物体存在巨大的差距,存在尺度变换和几何形变。本文将利用三维逆投影图恢复车头灯对的三维空间几何信息,通过对二维的车辆图像序列进行标定,形成三维重建图像,得到逆投影图像序列。该图像序列中车头灯对具有几何不变形,其位置、大小与真实车头灯对的位置、大小一一对应,从而为准确检测车头灯对提供基础。

首先在已标定的交通场景中预先确定一个逆投影面,设计的逆投影面依照夜间待检测的车前灯对的特征及空间位置确定。依不同的场景可设置平行于路面、垂直于路面或者与路面成一定角度的逆投影面,本文需实现对车头灯对的检测,因此在三维交通道路视频中设计垂直于路面而平行于车辆正面与车头灯对相贴合的逆投影面。

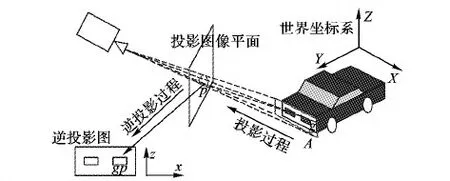

逆投影面按1 cm×1 cm的分辨率分割成若干网格,每个网格由对应的每个像素表示,由这些像素构成的图则为逆投影图。其逆投影图构建过程如图1所示,假设A表示设置的与垂直于路面的逆投影面,其中:g为逆投影面上的一个网格,p表示逆投影面A上的g网格投影到二维图像上的像素点,gp表示在逆投影图上与网格g对应的像素点,则逆投影就是将二维图像像素点p映射到逆投影图像素点gp的过程。逆投影图中每个像素点复制了逆投影面每个网格的信息,则每个像素点的信息就是逆投影面上每个网格的信息。因逆投影面上每个网格包含了对应三维空间中真实大小尺寸的网格信息,则逆投影图的二维图像上每个像素点同样代表了三维空间中真实大小尺寸的网格信息。

图1 逆投影构建过程

1.2 图像预处理

在夜间交通视频图像中,由于光线太弱,利用车头灯的显著特征粗定位车辆。根据在夜间车头灯像素值相对于邻域内其他像素是最大的,采用搜索窗原理寻找逆投影图像的局部极大值,粗定位车头灯对的区域。设置搜索窗的高度和宽度大小为5,其中定位的区域不仅包括车头灯对的位置,也包括亮度值比较大的车灯反光区域或其他干扰的非车灯区域。

当初步确定车头灯对的区域后,利用漫水填充算法进一步标记车头灯对的位置。设置漫水填充算法的起始点为图像局部极大值点,选择8邻域固定像素填充掩码方式,设置当前观察像素与邻域像素的上下限为[40,100]。

1.3 构造车灯对的高斯混合模型

根据车辆的车头灯对的空间几何先验知识可知,车头灯具有一些明显的特征,如车灯的高度、宽度、车灯对水平间距和垂直间距、面积相似度等。在2D图像检测中因为摄像机的成像原理,使得这些易于表述的空间几何特征在图像中发生尺度和形状变化,本文在逆投影图像下利用上述真实局部空间几何特征检测车灯。

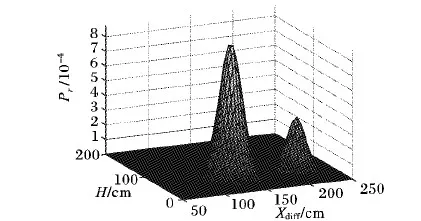

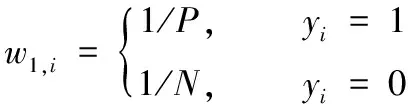

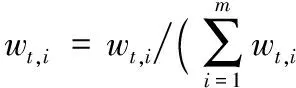

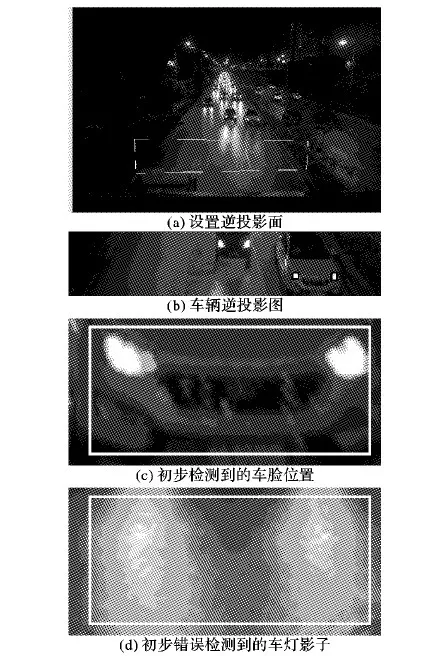

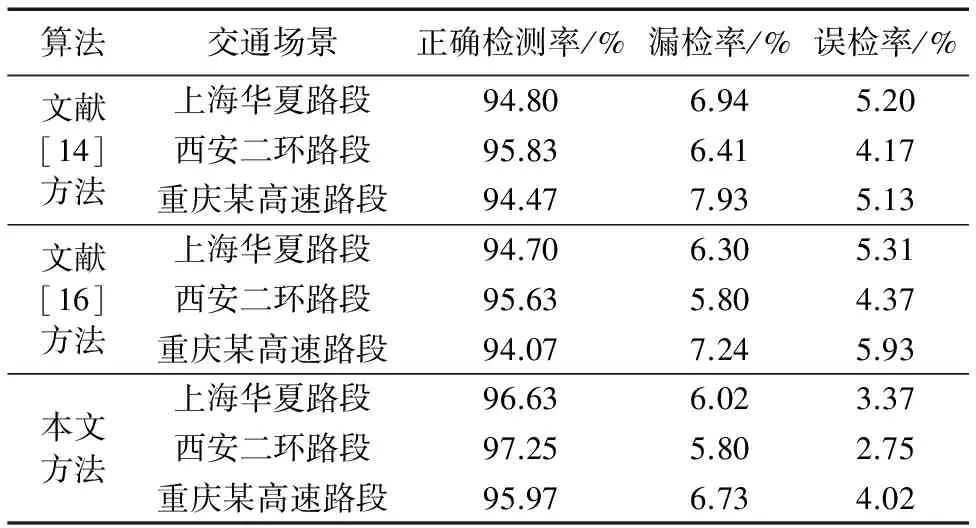

根据逆投影比例关系,计算车灯在逆投影图下的相对车灯宽度W和长度L。本文对车辆视频中采集的车辆样本进行统计,设置宽度上下限为Tw1和Tw2,高度上下限为Tl1和Tl2,若检测到的车灯宽度和高度满足Tw1 车灯面积A为: A=W*L (1) 面积比为: Aradio=As/Ab (2) 根据车辆局部几何特征可知,实际车辆的两个车头灯对具有相同的面积A,利用逆投影图恢复的目标形状,通过先验知识中车灯对的面积比Aradio趋于1的条件,剔除无法满足的伪区域。 但是在实验中存在并排相邻两辆车的车灯被误配对的现象。为了解决此问题,考虑车辆生产的通用性和普适性,规格尺寸大小集中在一定的范围之内,则设左右车灯对的中心坐标分别为(xl,yl),(xr,yr),车灯对的水平间距为Xdiff,垂直间距为Ydiff,车灯对相对于道路面的高度H,则车灯对之间的空间关系表达式如下: Xdiff=|xr-xl| (3) Ydiff=|yr-yl| (4) (5) 对采集到的大量车灯对样本分析可知车灯对特征变量Xdiff、Ydiff和H落在范围内样本数最多,落在范围边界的样本数较少,从数学角度分析,车灯对的每个空间特征关系分布符合高斯分布,则车灯对特征的空间变量分布概率模型呈现为高斯混合模型。由于车灯准直间距在真实场景中相差较小,为了建模简单,本文忽略不计。根据对车辆视频中采集的车灯对样本的空间特征变量Xdiff和H进行统计概率Pr建模,其结果如图2所示。 图2 车灯对样本的特征变量空间关系建模 其中得到的车灯对高斯概率模型为ψ,检测到车灯对特征的空间变量为D={Xdiff,H},则表示检测到的车灯对特征变量符合构建的高级混合模型的概率,称为模型ψ时D的似然度,则检测车灯对符合同一辆车的公式为: P(D|Ψ)>T (6) 根据设置的阈值T,当检测的车灯对的概率大于阈值时,则左右车灯对为同一辆车,进而解决车灯对误匹配的问题。 AdaBoost分类器是对同一个训练样本集训练不同的弱分类器,通过集合弱分类器构造一个强分类器。因AdaBoost分类器不需要任何关于弱分类器的先验知识[17],为了进一步剔除车灯影子、地面反射等的干扰,本文选用逆投影车辆样本,在逆投影图像下采用局部二值特征(Local Binary Pattern,LBP)的AdaBoost分类器分类车灯样本,其具体实现步骤[18-19]如下。 步骤1 给定车灯训练样本集{(x1,y1),(x2,y2),…,(xm,ym)},其中m为车灯样本数,xi为训练样本,yi为样本标识,yi∈{0,1},1表示正样本,即包含车前灯对的样本,0表示负样本,即不包含车前灯对的样本,其中正样本个数为P,负样本个数为N,则m=P+N。 步骤2 初始化正负样本xi的权重。 (7) 步骤3 设置弱分类器的个数为T。 1)权重归一化: (8) 2)对于LBP特征谱的统计直方图特征f,训练每个弱分类器cf,计算该特征的弱分类器的加权错误率: (9) 选取拥有最小错误率εf的弱分类器cf加入到强分类器中。 3)重新更新调整样本权重: (10) 其中:βt=εt/(1-εt)。 若样本xi被正确分类,则θi=0;否则θi=1。 步骤4 最强分类器为: (11) 其中:αt=log (1/βt)。 为了验证本文提出的基于AdaBoost的夜间逆投影车辆检测方法的性能,进行了测试。图3(a)中白色线框为在交通视频中设置的逆投影面大小。当车辆驶入逆投影面区域与逆投影面贴合时,根据投影关系计算出逆投影图,利用局部像素极大值和漫水填充算法粗定位车灯区域,根据车灯对的长宽、相似度和车灯对的空间关系的高斯混合模型等知识初步检测车灯对,在图3(b)中矩形框表示在逆投影图像下定位的车灯区域,图3(c)中矩形框为根据车灯对的先验知识构造的高斯混合模型正确检测到的车脸位置,图3(d)为因地面反光的影响,错误的将车灯影子检测为车辆的错误目标。 夜间中车灯检测经常会遇到影子干扰问题,尤其在雨雪天气下由于路面积水会引起车灯的反射,产生的镜像影子会使车灯的检测造成误判,因此为了消除路灯、交通信号灯、地面积水反光造成的镜像影子等影响,采用高速公路交通场景下车辆视频,分割出夜间逆投影车辆图像和非车辆图像,正样本图像尺寸为24 pixels×24 pixels,训练个数为1 092,负样本图像尺寸大于正样本尺寸,训练个数为2 024。正样本为逆投影图像下包括含有车头灯对的车脸图像,负样本包括车灯影子、路灯、交通信号灯等图像,图4为在雨天下根据正负样本在地面积水引起的反射的情况下正确检测到车辆的结果。 在上海华夏路段、西安二环路段和重庆某高速路段3个场景中对本文逆投影下的基于AdaBoost的夜间车辆检测进行测试。由表1可知,与文献[14]中D-S证据理论相比,检测率提高了2.03%,漏检率降低了17.83%,误检率降低了47.51%;与文献[16]中原始图像下的AdaBoost方法相比,检测率提高了1.931%,漏检率降低了7.58%,误检率降低了27.61%。文献[14]和[16]是在二维场景中获取车灯的信息,本文是通过三维逆投影图像获得真实车灯对的几何信息,构建高斯混合模型,采用了含有车灯影子、地面反光、路灯等的负样本,剔除了干扰因素的影响,因此检测率高,误检率低,满足了交通场景检测的准确性和可靠性的要求。 图3 初步检测车灯 图4 雨天下的检测结果 Tab. 1 Test results of vehicle detection 本文的方法是根据先验知识构造的车灯对的高斯混合模型初步检测车辆区域,当存在着无车灯、单车灯、车灯对面积相差太大或车灯粘连在一起的时候,无法根据先验知识和构造的高斯混合模型匹配车灯对,进而无法检测到车脸对象,因此出现漏检的情况,因此本文下一步需对此类情况进行分析解决。 因摄像机的透视关系,根据二维交通场景下的车灯存在尺度变换和几何形变,本文提出根据逆透视映射关系构建三维逆投影图像,在逆投影图像下采用局部极大值和漫水填充算法粗定位车灯区域,利用车头灯对的长宽、几何相似度和构建的车灯对的空间关系高斯混合模型,匹配车头灯对,获到包含车脸的逆投影图检测区域,最后设置逆投影车辆样本,利用AdaBoost算法分类检测车辆。本文采用逆投影车辆样本,降低了因摄像机透视变形的影响,使车辆样本更接近真实车辆图形,通过构建的高斯混合模型解决了车辆并排误检测的问题。实验结果表明,本文采用的方法提高了检测的精度,降低了误检率,解决了车灯影、地面反光等干扰因素的影响,满足了交通场景中车辆检测的精度要求。 References) [1] 靳璐,付梦印,王美玲,等.基于视觉和毫米波雷达的车辆检测[J].红外与毫米波学报,2014,33(5):465-471.(JIN L, FU M Y, WANG M L, et al. Vehicle detection based on vision and millimeter wave radar [J]. Journal of Infrared and Millimeter Waves, 2014, 33(5): 465-471.) [2] WANG X, XU L, SUN H, et al. On-road vehicle detection and tracking using MMW radar and monovision fusion [J]. IEEE Transactions on Intelligent Transportation Systems, 2016, 17(7): 2075-2084. [3] BURLET J, DALLA F M. Robust and efficient multi-object detection and tracking for vehicle perception systems using radar and camera sensor fusion [C]// Proceedings of the 2012 International Conference on Road Transport Information and Control. Stevenage, UK: IET, 2012: 1-6. [4] PAGE D, OWIRKA G, NICHOLS H, et al. Detection and tracking of moving vehicles with Gotcha radar systems [J]. IEEE Aerospace & Electronic Systems Magazine, 2014, 29(1): 50-60. [5] YANG C, DAI Z J. Vehicle-classification based on edge extraction and background difference [C]// Proceedings of the 4th International Conference on Measuring Technology and Mechatronics Automation. Clausthal-Zellerfeld: Trans Tech Publications, 2012: 1109-1113. [6] ZHANG W, CHEN L, GONG W, et al. An integrated approach for vehicle detection and type recognition [C]// Proceedings of the 2015 IEEE 12th International Conference on Ubiquitous Intelligence and Computing, 2015 IEEE 12th International Conference on Autonomic and Trusted Computing and 2015 IEEE 15th International Conference on Scalable Computing and Communications and Its Associated Workshops. Piscataway, NJ: IEEE, 2015: 798-801. [7] BASRI, INDRABAYU, ACHMAD A. Gaussian mixture models optimization for counting the numbers of vehicle by adjusting the region of interest under heavy traffic condition [C]// Proceedings of the 16th International Seminar on Intelligent Technology and Its Applications. Piscataway, NJ: IEEE, 2015: 245-250. [8] WEI P, LU X, TANG T, et al. A highway vehicle detection method based on the improved visual background extractor [C]// Proceedings of the 12th International Conference on Fuzzy Systems and Knowledge Discovery. Piscataway, NJ: IEEE, 2016:1519-1524. [9] ST-CHARLES P L, BILODEAU G A, BERGEVIN R. Flexible background subtraction with self-balanced local sensitivity [C]// Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2014: 414-419. [10] 于万霞,杜太行.基于彩色空间的背景帧差法视频车辆检测[J].计算机仿真,2010,27(1):285-287.(YU W X, DU T H. Video based vehicle detection based on background difference in color space [J]. Computer Simulation, 2010, 27(1): 285-287.) [11] 刘勃,周荷琴,魏铭旭.基于颜色和运动信息的夜间车辆检测方法[J].中国图象图形学报,2005,10(2):187-191.(LIU B, ZHOU H Q, WEN M X. Vehicle detection at night using color and motion information [J]. Journal of Image and Graphics, 2005, 10(2): 187-191.) [12] O’MALLEY R, JONES E, GLAVIN M. Rear-lamp vehicle detection and tracking in low-exposure color video for night conditions [J]. IEEE Transactions on Intelligent Transportation Systems, 2010, 11(2): 453-462. [13] SWAMY G N, SRILEKHA S. Vehicle detection and counting based on color space model [C]// Proceedings of the 2015 International Conference on Communications and Signal Processing. Piscataway, NJ: IEEE, 2015: 447-450. [14] WANG W, SHEN C, ZHANG J, et al. A two-layer night-time vehicle detector [C]// Proceedings of the 2009 International Conference on Digital Image Computing: Techniques and Applications. Piscataway, NJ: IEEE, 2009: 162-167. [15] JURIC D, LONCARIC S. A method for on-road night-time vehicle headlight detection and tracking [C]// Proceedings of the 2014 International Conference on Connected Vehicles and Expo. Piscataway, NJ: IEEE, 2014: 655-660. [16] 欧志芳,安吉尧,周芳丽.利用D-S证据理论的夜间车辆检测[J].计算机应用研究,2012,25(5):1943-1946.(OU Z F, AN J Y, ZHOU F L. Night-time vehicle detection using D-S evidence theory [J]. Application Research of Computers, 2012, 25(5): 1943-1946.) [17] ALEFS B, SCHREIBER D. Accurate speed measurement from vehicle trajectories using AdaBoost detection and robust template tracking [C]// Proceedings of the 10th International IEEE Conference on Intelligent Transportation Systems. Piscataway, NJ: IEEE, 2007: 405-412. [18] ZHU J, ZOU H, ROSSET S, et al. Multi-class AdaBoost [J]. Statistics & Its Interface, 2009, 2(3): 349-360. [19] YAN G, YU M, YU Y, et al. Real-time vehicle detection using histograms of oriented gradients and AdaBoost classification [J]. Optik—International Journal for Light and Electron Optics, 2016, 127(19): 7941-7951. This work is partially supported by the National Natural Science Foundation of China (61572083). CHENYan, born in 1989, Ph. D. candidate, engineer. Her research interests include image processing, intelligent transportation. YANTeng, born in 1992, M. S. candidate. His research interests include intelligent transportation. SONGJunfang, born in 1984, Ph. D. candidate. Her research interests include image processing. SONGHuansheng, born in 1964, Ph. D., professor. His research interests include image processing, artificial intelligence.

1.4 基于AdaBoost的车灯分类器检测

2 实验结果分析

3 结语