基于单目视频路径移动机器人导航方法研究*

2018-01-26张大伟孟森森邓计才

张大伟,王 佳,孟森森,邓计才

(郑州大学 信息工程学院,河南 郑州 450001)

0 引 言

移动机器人导航是机器人领域的一个研究热点[1]。视觉传感器作为最接近人类的环境感知工具,具有其他传感器无法比拟的优势。根据视觉传感器的数目,视觉导航分为3种:单目视觉、双目视觉、多目视觉[2]。单目视觉具有结构简单、适用范围广等优点,单目视觉导航分为3类:基于单视图[3]、双视图[4]、多视图[5]。双视图根据两帧图像所包含的目标物体的视差信息完成定位,两帧图像中对应点间存在一定的约束关系,根据这种约束关系可实现基础矩阵求解,三维重建,运动估计等,并且计算量较小。因此,在成本控制、性价比、实时性要求高的移动机器人领域,单目视觉中的双视图导航方式是一个较佳的选择。

本文以双视图定位为基础,提出了基于单目视频路径的导航方法。

1 导航原理

原理流程如图1所示。

图1 导航原理流程

1)人工驱动机器人沿参考路径移动,并通过自身的前置摄像机沿途拍摄视频序列,从中提取关键图像,并用一组有序的关键图像代表参考路径的视频序列;2)当机器人在参考路径附近移动时,可拍摄当前图像,利用摄像机中心间的最短欧氏距离,从关键图像序列中找出与当前图像最近似的图像,并提取其特征点,进行图像匹配,求出基础矩阵并优化,得到位姿参数,完成机器人定位;3)结合参考路径的视频序列,找出当前图像和关键图像共同包含的特征点,以其形心横坐标为参照,使机器人沿参考路径行走,实现自主导航。

1.1 定 位

1.1.1 关键图像获取

视频路径拍摄后,需要从视频序列中提取一组有序关键图像,目的是为机器人的定位及后续导航提供引导[6]。将视频序列的第一帧图像,始终作为第一帧关键图像,记作I1,然后,提取下一帧关键图像I2。关键图像提取原则如下:

1)关键图像In和In+1间存在尽可能多的视频图像;

2)关键图像In和In+1间至少有M个共同的特征点;

3)关键图像In-1和In+1间至少有N个共同的特征点,以保证图像的连续性。

1.1.2 最近似关键图像

(1)

从关键图像序列中,选择欧氏距离最短的图像,作为与当前图像I最近似的关键图像,并记作Ik,最近似关键图像的选择是一次粗匹配,为图像匹配奠定基础。

1.1.3 特征点提取

采用Harris 角点检测算法,寻找图像的特征点。算法思路:在图像中设置一个局部测试窗口,当该窗口沿任意方向作微小移动时,窗口的灰度值将发生变化。引入微分运算和自相关矩阵来检测灰度的变化情况,当该窗口的灰度变化值超过设定的阈值时,即将窗口的中心像素点作为角点。角点响应函数CFR定义为

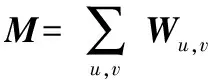

CFR=det(M)-k(traceM)2

(2)

式中

(3)

矩阵M为像素点的自相关矩阵;Wu,v为高斯平滑因子;X,Y分别为像素点在水平、垂直方向上的一阶导数;k为经验值常数,通常k=0.04。

1.1.4 图像匹配

(4)

1.1.5 对极几何与基础矩阵

当前图像I与最近似关键图像Ik为针对同一目标、不同角度拍摄得的2帧图像,其对极几何关系如图2所示。D为空间任一点,C和Ck分别为两摄像机的中心,C和Ck连接的直线称为基线,与图像I和Ik的交点分别为e,ek;d和dk为空间中点D分别在2帧图像上的投影,为一对匹配点;平面DCCk与图像I的交线为h,与图像Ik的交线为hk,d和dk分别在各自的交线上,称h为匹配点dk对应的极线,同理,hk为匹配点d对应的极线。

图2 对极几何

基础矩阵是对极几何的代数表示,可以由两帧图像之间的匹配点对进行求解。假设:d↔dk是当前图像I和最近似关键图像Ik之间的一对匹配点,坐标分别为d=(u,v,1)T,dk=(uk,vk,1)T,d和dk之间约束关系为

(5)

将式(5)整理可得线性方程组

Af=0

(6)

式中f为基础矩阵F的展开变形

f=(f11f12f13f21f22f23f31f32f33)T

(7)

(8)

求解基础矩阵F需要有9个参数,归一化,变为8个。因此,需要8对匹配点代入线性方程组(6),即可以完全确定基础矩阵。

1.1.6 基础矩阵优化

算法思路:两帧图像的一对匹配点,其中一个特征点对应的另一帧图像上的匹配点,必然在该特征点对应的极线上,利用这一特点,将匹配点到该极线的垂直距离作为选择最优匹配点对的标准。

具体做法:第一次迭代,任意选取8对匹配点,求出基础矩阵F1,然后分别计算8个特征点到极线F1d的垂直距离,剔除其中距离最大的特征点。第二次迭代,从众多剩余的特征点中任意选取一个特征点,求出基础矩阵F2,再分别计算这8个特征点到极线F2d的垂直距离,再次剔除其中距离最大的特征点。重复操作,直到获得最终8个特征点,由于该8个特征点在所有特征点中匹配精度最优,所以利用该8对特征点所求出的基础矩阵的准确性最好。

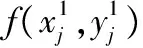

1.1.7 目标定位

空间中任一点D在当前图像I和最近似关键图像Ik中的投影点分别为d和dk,点d和dk是一对匹配点。设目标点D在图像I和Ik中的摄像机坐标分别为X=(x,y,z),Xk=(xk,yk,zk),图像坐标分别为(u,v),(uk,vk),像素。摄像机由最近似关键图像Ik到当前图像I,相当于做了一次运动。假设摄像机运动的旋转矩阵为R、平移向量为t,在摄像机坐标系下,两个坐标的关系可表示为

X=RXk+t

(9)

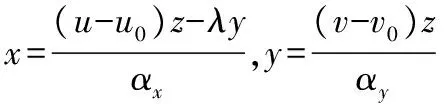

假设t=(tx,ty,tz)T,G为摄像机内参数矩阵,根据图像坐标系和摄像机坐标系间的转换关系有

(10)

式中αx,αy分别为u轴和v轴上的归一化焦距;u0,v0为图像的中心。

式(10)整理可得

(11)

式中

(12)

式中G,R,t为可求量;zk为可测量;z为目标点在当前摄像机坐标系下的深度值,可由最小二乘法计算得到,图像坐标(u,v)和(uk,vk)可以通过特征点的提取和匹配获得。将z代入式(10),可以求得x和y

(13)

点X=(x,y,z)即为摄像机坐标系下目标点的当前三维坐标,由此可以实现目标定位。

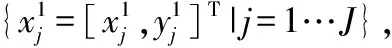

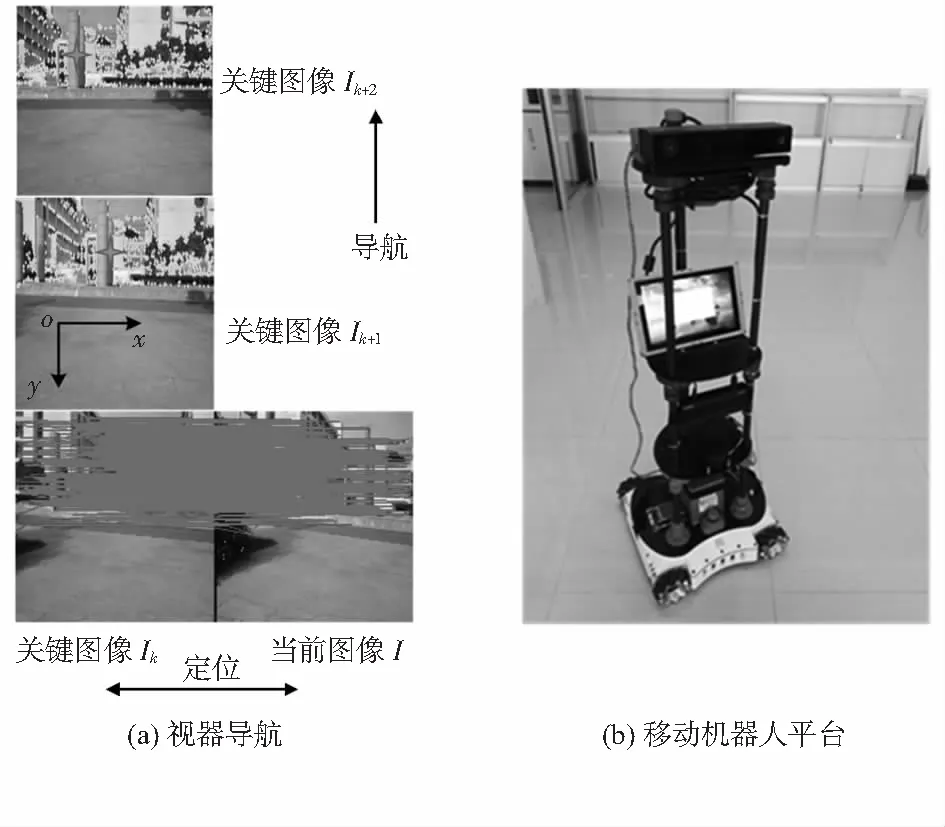

1.2 路径规划

具体做法为:首先,当前图像记为I,与当前图像最近似的关键图像记为Ik,记图像Ik的下一张关键图像为Ik+1∈{I1,I2,I3,…,In}。使用Harris算法分别提取图像I和Ik+1的特征点,求出2帧图像共同包含的特征点集的形心,用形心的横坐标X作为定位的参照[7,8]。当机器人沿参考路径移动,图像I与Ik+1共同包含的特征点集的形心横坐标X发生变化,由图像I的形心横坐标X1,不断趋向于图像Ik+1的形心横坐标Xk+1,当到达Xk+1时,即机器人到达关键图像Ik+1的位置。此时,下一张关键图像Ik+2变为目标位置,以此类推,直到到达关键图像In位置,完成自主导航,如图3(a)所示。

图3 视觉导航与移动机器人平台

2 实 验

实验验证在自主开发移动机器人平台上进行如图3(b)。该机器人采用基于4个麦克纳姆轮的全向移动机构,内部配备有一个微型电脑(英特尔Intel NUC 6i5SYH,处理器i5,内存8 GB),头部安装了一个用于单目视觉定位导航的摄像机(微软Kinect V2内部彩色摄像机)。所开发的定位导航算法基于Visual Studio 2015 和 OpenCV 3.0开发。

实验步骤如下:1)人工驱动机器人沿参考路径行走,用摄像机记录视频路径;2)提取图像特征点,从视频序列中提取一组有序关键图像{…,Ik,Ik+1,Ik+2,…}作为代表,算法如前所述,实验中,设定M=400,N=300;3)拍摄当前图像I,根据图像之间欧氏距离最短,从关键图像序列中选取最近似关键图像Ik,将图像I和Ik进行图像匹配,求出基础矩阵并优化,实现目标定位;4)根据已有路线,通过单目摄像机动态摄取路面图像,经计算机处理识别出关键图像,并判断关键图像特征点集形心的横坐标位置,使机器人的实际行驶路线与参考路线的偏差保持在允许的范围内,以此实现自主视觉导航。如图3(a)所示,机器人根据当前图像I和最近似的关键图像Ik,实现定位,并完成从Ik到Ik+1,Ik+2的导航。

机器人运动轨迹与参考路径如图4所示,其置信区间如图5所示。

图5 置信区间

3 结 论

实验结果表明:机器人实际轨迹与参考路径的误差始终控制在一定允许范围内(小于2 m)。在实验过程中,影响精度的原因主要有3个:1)镜头本身的畸变;2)标定误差;3)匹配误差;随着工艺技术的发展和各种算法的不断改进,误差的影响会越来越小。

[1] 谭 民,王 硕.机器人技术研究进展[J].自动化学报,2013,39(7): 963-972.

[2] 敬 泽,薛方正,李祖枢.基于单目视觉的空间目标位置测量[J].传感器与微系统,2011,30(3):125-131.

[3] 余厚云,张为公.基于单目视觉传感器的车距测量与误差分析[J].传感器与微系统,2012,31(9):10-13.

[4] 于天慧,孙金玮.面向复杂场景的未标定两视图三维重构方法[J].计算机辅助设计与图形学学报,2016,28(8):1232-1241.

[5] 姜翰青,赵长飞,章国锋,等.基于多视图深度采样的自然场景三维重建[J].计算机辅助设计与图形学学报,2015,27(10):1805-1815.

[6] Cherubini A,Chaumette F.Visual navigation of a mobile robot with laser-based collision avoidance[J].The International Journal of Robotics Research,2013,32(2):189-205.

[7] Charmette B,Royer E,Chausse F.Vision-based robot localization based on the efficient matching of planar features[J].Machine vision and Applications,2016,27(4): 415-436.

[8] Cherubini A,Spindler F,Chaumette F.Autonomous visual navigation and laser-based moving obstacle avoidance[J].IEEE Transactions on Intelligent Transportation Systems,2014,15(5):2101-2110.

邓计才(1974-),男,通讯作者,博士,教授,主要从事竞技机器人领域研究工作,E—mail:iejcdeng@zzu.edu.cn。