汽车辅助驾驶系统动态目标检测方法

2018-01-19,,,,

, ,, ,

(1.河南科技大学 车辆与交通工程学院,河南 洛阳 471003; 2.海军航空工程学院 电子信息工程系,山东 烟台 264001)

0 概述

基于计算机视觉的动态障碍物检测在汽车辅助驾驶系统中具有重要应用价值,其利用车载摄像机获取车前一定范围内的视频图像检测障碍物,从而估计出潜在的危险以便采取安全策略避免交通事故。但在行车过程中,车速和天气的变化以及开放的车行环境下视频背景的复杂多样性对障碍物检测的鲁棒性提出了较高的要求,同时由于摄像机随车体运行,因此运动背景下动态障碍物的检测以及检测的实时性要求进一步增加了算法的设计难度。

与背景差分法对背景模型的依赖和光流法的计算高复杂度相比,相邻帧间差分法用连续的2帧或者3帧图像逐像素差分消除背景的影响,对光线等环境因素有较强的适应性,对动态变化的场景非常有效。该方法包括背景全局运动补偿和目标检测2个主要步骤。文献[1]从理论上分析了全局背景补偿的优势,发现参数估计值直接决定帧间背景的配准精度,进而影响目标检测效果。

文献[2]方法采用图像灰度编码实现快速匹配,但对非线性变化的局部光照匹配容易发生错误。文献[3]方法基于块匹配减少计算量,但当摄像机有明显的非线性运动时,准确性受到影响。文献[4]采用固定阈值去除外点以提高参数估计的精度,但固定阈值在实际应用中受限。文献[5]提取残差均值代替固定阈值对文献[4]方法进行改进,但该方法不能准确地估计全局运动参数。文献[6]将Sobel边缘检测与小波变换结合,提出递推多模板匹配方法,虽然加快了速度,但该方法对图像的角度偏差不适应。文献[7]利用主成分分析法对SIFT算法改进,但需要先验知识,否则会增加计算量,且投影矩阵输入图像有限制。文献[8]提出的GLOH算子增加了SIFT算子的鲁棒性和独特性,但同样需要大量的先验样本。文献[9]方法利用全局信息来减少误匹配,对局部相似造成的错误配准效果明显,但计算较复杂,且丢失了SIFT算子的尺度不变性。文献[10]使用Gabor滤波器对SIFT描述符进行改进,但增加了算法的计算复杂度。

相比于块配准参数估计,基于特征点的全局补偿参数估计能够突破图像旋转、缩放及仿射变换等摄像机非平移运动的限制,更适合汽车辅助驾驶系统车前动态障碍物检测。为此,本文提出基于SIFT算子背景补偿和假设检验的目标检测方法,通过小波和动态帧间特征点位置估计改进SIFT算法,以增强参数估计的实时性,并利用改进假设检验方法提高动态目标的检测准确性。

1 基于改进SIFT特征配准的全局运动补偿

SIFT[11-12]特征点对图像的旋转、尺度缩放以及光照变化具有较好的稳定性,对目标的运动、遮挡、噪声等因素也有很好的鲁棒性[13],但其128维描述符和特征点一一比较的配准策略速度较慢。虽然研究者已提出了SURF[14]、PCASIFT、CSIFT[15]、ASIFT[16]、BIRSK[17]和FREAK[18]等很多改进算法,但针对本文的应用背景,改进算法的实时性和稳定性不满足要求。

为此,本节首先采用小波多分辨率分析和图像分块方法,使得算法可以根据行车环境的复杂性选择合适的分辨率,以减少特征点数并保持点数稳定;然后采用相邻帧特征点位置估计配准策略对算法进行改进,在保持算子对不同行车背景适应性的同时,提高算法的配准精度,使其满足实时性要求。

1.1 特征点数均衡

图像中的高频成分较多为噪声和边缘,利用小波变换多分辨率分析去除高频成分后,可以减少边缘点对计算SIFT算子的影响。Haar小波维度小、运算速度快且占用内存小,是典型的规范正交基。因此,本文使用Harr小波,如式(1)所示。

(1)

对图像进行两层小波分解,并对第2层分解图像进行分块,提取每个块的SIFT特征点。如果一个块中的特征维数达到预设阈值,则对当前块不再提取特征点,但如果块中特征点较少,则将第1层分解图像也用于特征点提取和配准。此种处理方法的优势在于:

1)当行车背景处于闹市区等复杂背景时,两层分解减少了每次参与匹配的像素点,而行车于高速路等简单背景时,上层分解可保证足够特征点,从而保持特征点数量的基本稳定。

2)利用图像分块进行特征点提取和配准,可避免特征点密集部分对全局背景补偿影响偏大的问题。

3)可避免DoG算子的边缘敏感性对匹配点的影响。

1.2 特征点描述符降维

本文根据文献[19]方法,采用如图1所示的邻域窗口来计算特征点描述符。以中央黑色点表示的特征点为中心,每两个像素的宽度范围为一层,建立4层邻域,该邻域范围可以增强距离近的像素点对特征描述符的贡献,一定程度上也避免了因分块且对特征点数限制带来的精度损失。

图1 特征描述符计算邻域

以45°为间隔均分空间,累加每层邻域内8个方向范围内的梯度值,则每个特征点描述向量为4×8=32维,并按区域位置对向量排序。在每个子区域内累加像素的梯度值并做归一化处理,以减少光照的影响:

(2)

最终计算得到的32维描述符向量为:

Fn=(fn1,fn2,…,fn32)

(3)

其中,n为特征点数。Fn兼顾向量降维和反映邻域像素的距离贡献特性,因而对特征点的描述更准确。

1.3 快速特征点配准

由于在特征点配准时,SIFT算子采用所有特征点比较的策略,运算量较大。考虑到车载摄像机视频图像的相邻帧间时间间隔较短,在帧率为25 frame/s时,两帧间时间间隔为40 ms,在该时间段内,车辆的行进、颠簸、转弯及外界环境的变化不会带来相邻帧间行车背景的大幅变化,即前一帧图像实际上包含了当前帧大量特征点的位置信息。因此,可以利用前一帧的全局背景补偿参数并通过前一帧图像特征点位置信息对当前帧图像中待配准特征点位置进行估计,并在估计位置的邻域内搜索当前帧的待配准特征点,从而缩小当前帧特征点的搜索范围,减少特征点配准时间。

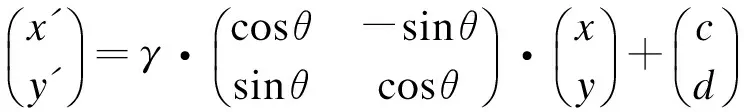

1.3.1 基于仿射变换的全局运动参数估计

摄像机随车运动,相邻帧间主要为图像缩放,但考虑到行车颠簸和转弯等过程影响,全局背景运动补偿的参数估计需要针对摄像机平移、旋转和缩放等进行。本文采用仿射参数模型计算补偿参数,其计算相对简单,对摄像机运动相对较小情况较适合。特征点(x′,y′)变换到下一帧特征点(x,y)的仿射变换关系如式(4)所示。

(4)

1.3.2 基于位置估计的特征点配准

车载摄像机视频图像的相邻帧间时间间隔较短,其摄像机运动参数变化不大。因此,可以利用这一特点,将前一帧的运动参数作为当前帧与下一帧的运动参数对特征点进行位置估计,然后在估计位置的一定邻域范围内对特征点进行配准,从而实现特征点的快速配准。具体过程如下:

步骤1根据1.1节和1.2节方法计算相邻两帧图像SIFT特征点及其描述符。由于行车环境复杂多变,因此相邻两帧图像中某些区域特征丰富,使得SIFT特征点较密集而其他部分特征点较少。为减小特征点分布不均对全局参数估计的影响,将当前帧图像分为矩形小块,块间不重叠,仅对每个块内的一定数量特征点进行配准。

步骤2对当前帧中每个块内的特征点(x′,y′),利用上一帧图像的全局运动参数,并根据式(4)计算其在下一帧图像中的对应像素位置(x″,y″),然后以(x″,y″)为中心,搜索半径为R像素的圆形邻域范围内,满足式(5)的特征点(x,y)为(x′,y′)配准点,同时对块内特征点对数设定阈值,当点对数达到该阈值后,该块内不再进行特征点配准。

(5)

其中:Emin为与(x′,y′)欧式距离最小的像素位置;Emax为与(x′,y′)欧式距离最大的像素位置。

步骤3当由于估计位置的邻域交叠等原因,使得配准过程中出现多对一的情况时,首先判断特征点与其邻域特征点的位置关系是否与下一帧的对应配准点之间的位置关系一致,然后采用式(6)所示的互相关系数进行重新配准,取相关系数最大的特征点进行配准。

(6)

其中,x(n)、y(n)为待配准描述符。采用分块和位置估计的配准过程,其优势一方面是通过位置估计缩小了特征点配准的搜索范围,提高了配准速度,另一方面是通过位置邻域约束,避免了2个位置相差较大的特征点因特征描述符相似而误配准,同时使得配准的特征点对在图像中分布较均匀。实验证明,当特征点在图像中均匀分布时,利用全局参数的准确计算,可使运动补偿效果最佳。

1.3.3 误配准特征点对剔除

由于背景与前景目标同时运动,在剔除错误配准点后,还必须去除前景目标之间的配准点。首先在配准的N对点对中随机选取5对,利用式(4)构建超定方程估计补偿参数,然后将参数代入式(7)计算估计残差。

(7)

迭代M次随机选取,得到E=(E1,E2,…,EM),取E的前L项残差对应的配准点对,用于最终补偿参数的估计。M与无错误点对的可能性p之间满足式(8)关系

p(ε,q,M)=1-(1-(1-ε)q)3)M

(8)

其中:ε(ε<0.5)表示误配准的点对比例;q为随机选取准确特征点的可能性。实验结果证明,当ε=0.2,q=0.75时,M=25,即得到p=0.975。

最后采用Levenberg-Marquardt算法进一步优化估计全局运动参量,并采用双线性插值方法计算补偿帧。

2 目标检测

本文利用三帧间差分法消除补偿后的背景区域,然后采用改进的假设检验方法检测目标。

2.1 三帧差分法

设ft-1,ft,ft+1为连续的3帧图像,利用帧差分法计算差分图像d1和d2后进行“与”运算,即:

d1=|ft(x,y)-ft-1(x,y)|

(9)

d2=|ft+1(x,y)-ft(x,y)|

(10)

d=d1⊗d2

(11)

三帧差分法能突出目标的位置和轮廓信息,但仍存在噪声像素干扰。为此,本文对差分图像进行自适应阈值分割和形态学处理,并采用改进的假设检测方法对目标进行精确检测。

2.2 基于改进假设检验方法的目标检测

(12)

其中,n1和n2为样本数。设定置信度为α,则若式(13)成立则拒绝假设H0,否则接受H0。

(13)

(14)

文献[20]采用假设检测方法取得了较好的目标检测效果,但由于其针对监控图像目标检测,目标主要集中在图像中间区域,因此通过取选定距上下边界10像素宽的区域作为背景区域可以取得较好的检测效果。但在行车视频图像中,动态目标可以出现在图像中的任何区域,且目标在图像边界位置和在中心等其他位置出现的概率相同,采用边界像素计算背景方差并不准确。为此,本文采用配准特征点对作为种子点计算背景方差,以提高准确率。具体步骤如下:

1)根据三帧差分法计算配准后的连续3帧图像的帧差图像,并取其绝对值。

3)以每个像素点为中心,计算判断窗口内像素的方差σx,根据式(14)检测目标像素点,并通过形态学运算和连通性检测方法检测最终的动态障碍物目标。

3 实验与结果分析

为验证本文算法的有效性,在Intel Core i5-6500M CPU,3.2 GHz,16 GB RAM环境下利用OPenCV 2.4库和C++进行仿真实验,应用于大量包含不同背景和多目标图像数据,对比算法改进前后的效果。实验分2个部分,一部分验证算法目标检测效果,另一部分检测算法的效率。实验中,特征点配准图像分块大小为45像素,假设检验方法取置信度为10-2,窗口宽度为5像素。实验引用4种方法进行对比实验:传统SIFT方法+未改进假设检验方法,记为SIFT-HT;改进SIFT方法+未改进假设检验方法,记为ISIFT-HT;本文方法,记为ISIFT-IHT;基于质点过滤的SIFT算子目标检测方法,记为PF-SIFT[21]。

3.1 检测性能对比

图2为采用SIFT-HT方法和本文方法对2种不同背景下目标检测的结果,其中,图2(a)为在原始图像中2种方法对目标的检测结果(实线框为本文算法检测的目标区域,虚线框为SIFT-HT方法检测的目标区域),图2(b)和图2(c)为帧间全局背景补偿后的检测结果。可以看出,本文方法在正确检测动态目标的同时,尽可能地消除背景干扰的影响,这主要是因为其采用图像分块的方法,使得配准的特征点较均匀地分布在整帧图像中,避免了特征点集中区域对参数结果造成一定的偏移。当背景中相似区域较多时,传统SIFT算法容易在相似区域出现较多的误配准特征点。从图2(b)检测结果可以看出,当图像中目标分布在边界部分时,传统原始假设检验方法会出现漏检,而本文方法通过改进背景方差计算方法,能较好地检测出图像中的动态目标。可以看出,在不同背景和不同目标分布情况下,本文方法都取得了较好的动态目标检测结果。

图2 不同背景和目标分布下的目标检测结果对比

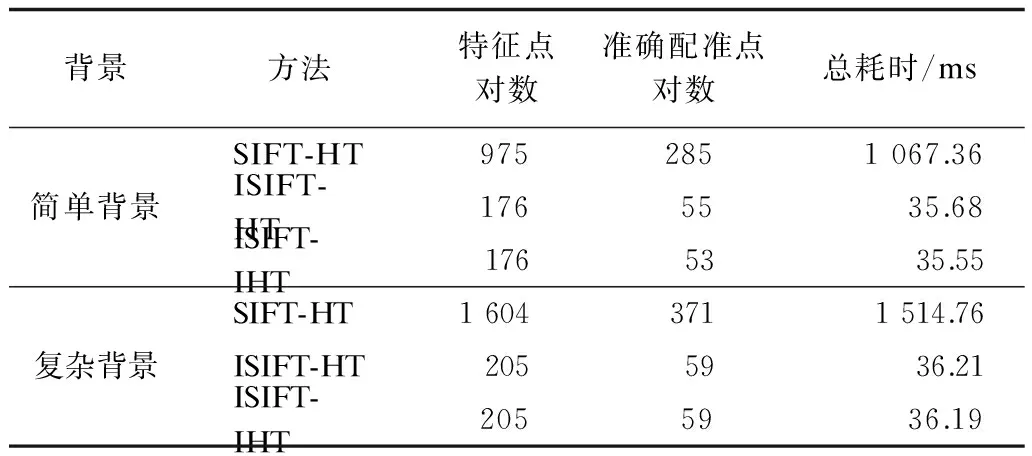

3.2 运行效率对比

为测试各方法的运行效率,取图2所示的背景相对简单(左图)和复杂(右图)的2组视频图像(1 024×776分辨率),实验中每帧图像进行50次运算并取平均值,计算每组实验目标检测的提取特征点对数、准确配准点对数、平均总耗时,表1为3种方法实验结果对比。

表1 3种方法的目标检测结果对比

从表1中提取的特征点对数可以看出,相比于传统SIFT算法,本文方法通过小波多分辨率控制和图像分块配准特征点对数约束,在不同背景下取得了稳定的特征点对数,从而确保配准准确和稳定运行。从算法运行效率可以看出,本文方法通过特征点对数约束和相邻帧特征点位置估计,大幅减少了运行时间,从实验结果看,在汽车辅助驾驶系统图像采集帧率为25 frame/s的情况下,本文方法满足行车状态时动态目标的实时检测要求。

在实验过程中,随着视频帧检测数的增加,即运动目标总量的增加,累加每帧中漏检和误检的目标数,并用检测错误率表示。图3所示为本文方法与PF-SIFT和ISIFT-HT方法的对比结果。

图3 目标检测错误率随目标数的变化曲线

可以看出,环境的复杂变化以及视频中目标数的增加对PF-SIFT方法的检测结果影响较大。分析实验结果发现,PF-SIFT方法在环境简单且每帧目标数较少时错误检测率较低,当环境复杂且目标较多时错误率较高。而本文检测方法在背景复杂和背景简单时都取得了较好的检测结果,虽然当每帧图像中目标较多时,对于较远处的低分辨率目标会出现漏检情况,而当背景复杂且车出现颠簸时,部分背景小目标会被错误检测为动态目标,但从整体实验结果看,本文方法错误率较小且比较稳定,其对行车环境具有较好的适应性。

4 结束语

针对汽车辅助驾驶系统动态目标检测面临的复杂背景和系统对检测的实时性要求,本文提出一种基于改进SIFT算子和改进假设检验的动态目标检测方法,在保持SIFT算子优点的同时,通过特征点对约束和相邻帧位置估计加快全局背景补偿参数的估计速度,并利用改进背景区域方差计算方法提高假设检验方法在行车环境下对背景方差的估计准确性。实验结果表明,本文方法在保证与传统方法相近性能的情况下,可实现快速解算,同时满足系统对算法实时性的要求。

由于本文仅对车前动态目标进行检测,因此下一步将针对短时静态目标或者目标运动相对缓慢,以及在障碍物遮挡下目标短暂消失的情况进行研究,从而完善对车前目标的检测,满足汽车辅助驾驶系统更多的实际应用需求。

[1] 游安清,程义民.基于背景运动补偿的红外运动分析[J].强激光与粒子束,2003,15(5):431-434.

[2] 李 强,张 钹.一种基于图像灰度的快速匹配算法[J].软件学报,2006,17(2):216-222.

[3] 施家栋,王建中.动态场景中运动目标检测与跟踪[J].北京理工大学学报,2009,29(10):858-891.

[4] RAATH G B,MAKUR A.Iterative Least Squares and Compression Based Estimations for a Four-parameter Linear Global Motion Model and Global Motion Com-pensation[J].IEEE Transactions on Circuits and Systems for Video Technology,2005,9(7):1075-1099.

[5] ALBU F,FLOREA C,ZAMFIR A,et al.Low Complexity Global Motion Estimation Techniques for Image Stabilization[C]//Proceedings of International Conference on Consumer Electronics.Washington D.C.,USA:IEEE Press,2008:1-2.

[6] 吴 强,侯树艳,李旭雯.融合图像灰度信息与边缘特征的快速匹配算法[J].信号处理,2013,29(2):268-273.

[7] YE K,SUKTANKAR R.PCA-SIFT:A More Distinctive Representation for Local Image Descriptors[C]//Proceedings of Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2004:506-513.

[8] MIKOLAJCZYK K,SCHMID C.A Performance Evaluation of Local Descriptors[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(10):1615-1630.

[9] MORTENSEN E N,DENG H,SHAPIRO L.A SIFT Descriptor with Global Context[C]//Proceedings of CVPR’05.Washington D.C.,USA:IEEE Press,2005:184-190.

[10] MORENO P,BERNARDINO A,VICTOR S J.Improving the SIFT Descriptor with Smooth Derivative Filters[J].Pattern Recognition Letters,2009,30(1):18-26.

[11] LOWE D G.Object Recognition from Local Scale-invariant Features[C]//Proceedings of International Conference on Computer Vision.Washington D.C.,USA:IEEE Press,1999:1150-1157.

[12] LOWE D G.Distinctive Image Features from Scale-invariant Key Points[J].International Journal of Computer Vision,2004,60(2):91-110.

[13] 何孝莹,岳建伟,张栩然.基于SIFT算法的无人机影像快速匹配[J].计算机工程,2011,37(7):216-218,230.

[14] BAY H,TUYTELAARS T,VAN G L.SURF:Speeded up Robust Features[C]//Proceedings of the 9th European Conference on Computer Vision.New York,USA:ACM Press,2006:404-417.

[15] ALAA E,FARAG A A.CSIFT:A SIFT Descriptor with Color Invariant Characteristics[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2006:1978-1983.

[16] MOREL J M,YU Guoshen.ASIFT:A New Framework for Full Affine Invariant Image Comparison[J].SIAM Journal on Imaging Sciences,2009,2(2):438-469.

[17] LEUTENEGGER S,CHLI M,SIEGWART R Y.BRISK:Binary Robust Invariant Scalable Key Points[C]//Proceedings of IEEE International Conference on Computer Vision.Washington D.C.,USA:IEEE Press,2011:2548-2555.

[18] ALAHI A,ORTIZ R.FREAK:Fast Retina Keypoint[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2012:510-517.

[19] 李 星,郭晓松,郭君斌.基于多特征融合的前向车辆检测方法[J].计算机工程,2014,40(2):203-207.

[20] 赖作镁,王敬儒,张启衡.背景运动补偿和假设检验的目标检测算法[J].光学 精密工程,2007,15(1):112-116.

[21] 吴 骏,李文杰,耿 磊,等.基于单目视觉的前方车辆检测与测距[J].计算机工程,2017,43(2):26-32.