融合视觉的智能车组合导航技术分析

2017-06-10曾庆喜冯玉朋杜金枝李中兵

曾庆喜,冯玉朋,杜金枝,方 啸,李中兵

(1.南京航空航天大学 无人驾驶车辆研究中心,南京 210016;2.奇瑞汽车股份有限公司 前瞻技术研究院,安徽 芜湖 241009;3.汽车仿真与控制国家重点实验室,长春 130012)

融合视觉的智能车组合导航技术分析

曾庆喜1,2,3,冯玉朋1,3,杜金枝2,方 啸2,李中兵2

(1.南京航空航天大学 无人驾驶车辆研究中心,南京 210016;2.奇瑞汽车股份有限公司 前瞻技术研究院,安徽 芜湖 241009;3.汽车仿真与控制国家重点实验室,长春 130012)

为了进一步研究无人驾驶智能车辆的导航定位技术,对视觉里程计技术在车载组合导航系统中的应用进行综述:首先对视觉里程计的原理进行概述;然后较为完整地分析了融合视觉里程计的车载组合导航系统的3个主要研究方向:视觉里程计与惯导系统组合、视觉里程计与卫星导航系统组合,以及融合视觉里程计的多传感器组合导航系统;最后对视觉里程计技术在智能车组合导航系统中的发展进行展望。

视觉里程计;组合导航;卫星导航;惯性导航;智能车

0 引言

组合导航是近代导航理论和技术发展的结果。通过将不同的导航方式组合在一起可以获得比单独使用任一系统时更高的导航性能,也因此组合导航系统得到了越来越广泛的研究和应用。对于无人驾驶智能车的导航来说,车辆在运动过程中的自主定位能力非常重要,是保障智能车完成自主行为的前提。传统的定位方法一般采用全球卫星导航系统(global navigation satellite system, GNSS)、惯性导航系统(inertial navigation system, INS)以及里程计等方法获得智能车的位置信息;然而各种定位技术都有不同的优缺点,在某些特殊环境下(如隧道、轮胎打滑等)会出现失误,不能确保得到精确的车辆位姿估计[1]。

随着计算机视觉技术的发展,视觉传感器越来越多地被用于进行车辆的定位和运动估计。视觉传感器相对于其他传感器来说具有成本低、体积小等优点,且视觉传感器可以提供丰富的感知信息,既可以满足车辆的自定位要求,又能够同时为其他重要的任务提供信息,如目标检测、避障等[2]。此外,视觉传感器具有较好的隐蔽性和抗干扰能力。融合视觉里程计的组合导航系统成为最近几年导航领域的一个新的研究热点。

1 视觉里程计概述

视觉里程计(visual odometry,VO)是以单个或多个摄像机在运动过程中釆集的图像为输入信息来估计摄像机旋转和平移运动的定位方法[3]。视觉里程计的作用与传统的轮式里程计类似,用以增量式地估计载体的运动参数。文献[4]最早运用视觉导航的方法,利用一个可滑动相机获取视觉信息作为输入项,完成了机器人室内导航。文献[5]提出了视觉里程计的概念,基本步骤包括特征提取、特征匹配、坐标变换和运动估计,当前大多数视觉里程计仍然基于此框架[6]。文献[7]于2004年提出一种基于双目立体视觉的里程计估计方法,它第一次实现了鲁棒地去除外点的实时视觉里程计系统,并进行了长距离的测试;同时也对单目视觉和双目视觉进行了比较,指出双目相机在尺度估计方面的优势,将视觉里程计的发展推到一个新的阶段。之后视觉里程计的研究主要围绕单目视觉和立体视觉各自进行,其中立体视觉里程计绝大多数指的是双目视觉。单目与立体视觉里程计系统各有优缺点;但大部分情况下立体视觉系统的效果要优于单目系统,最主要原因在于:使用单目视觉会碰到的尺度歧义问题,采用立体视觉便不复存在[8-11]。随着RGB-D摄像机的问世,特别是微软Kinect的发布,单目的深度信息得到补充,使得单目视觉得到更广泛的应用[12-13]。

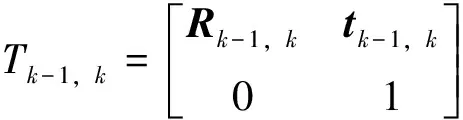

经典的视觉里程计系统大多是基于2帧计算框架[2],其工作流程一般包括特征的选择与关联,以及基于所获得的特征关联集合进行帧间位姿估计。以单目视觉为例,单目视觉相机安装在智能车平台上,以时间间隔k拍摄图像序列,记相机图像为I0:k={I0,…,Ik}。则在2个相邻时刻k-1和k,相机的位姿变化量可以通过刚体变换Tk-1,k∈R4×4关联,表示为

(1)

式中:Rk-1,k为3×3的旋转矩阵,代表姿态变化量; tk-1,k为3×1的平移向量,代表位置变化量。集合T0,…,M={T0,1,…,TM-1,M}包含了所有的总帧数为M的序列运动。最终,相机位姿的集合C0,…,M={C0,1,…,CM-1,M}包含了相机相对于初始时刻k=0时的变换。当前位姿CM可以通过累计所有的变换Tk-1,k(k=1,…,M)得到

(2)

并且C0是相机在k=0时的位姿。

计算帧间位姿变换的Tk-1,k主要有2种方法:基于表面的方法,需要利用所输入2帧图像所有像素的灰度信息;基于特征的方法,只利用所提取的显著和可重复的特征。基于特征的方法比表面方法更快也更准确,绝大部分的视觉里程计都是基于特征的[2]。基于特征的视觉里程计系统的详细流程如图1所示。

视觉里程计技术发展至今已经逐渐成熟,具备直接在实时系统中应用的可能;但是单纯依靠视觉的智能车辆定位与导航技术还不够成熟。视觉里程计技术目前仍然有许多问题存在,如特征检测与跟踪算法效率与精度的权衡、递归算法的累计误差缺陷,以及难以处理的复杂动态环境等。基于此,视觉里程计的研究一方面可以从算法的各个模块技术出发,以期改善整体系统性能;另一方面,可以通过融合其他传感器的方式来弥补视觉里程计的缺陷。下文对有望应用于无人驾驶车辆且融合了视觉里程计的组合导航系统进行介绍。

2 融合视觉的组合导航系统研究现状

组合导航是指将2种或2种以上的导航系统组合起来的导航方式[1]。相对于单独使用的导航系统,组合导航系统具有定位精度高、可靠性好,成本低等优点。近年来,基于视觉的组合导航系统的研究已经取得许多进展。下文从系统构成的角度对视觉里程计与惯导组合系统、视觉里程计与卫星组合导航系统,及多传感器组合导航系统进行分析,并介绍现有融合视觉的组合导航系统的研究进展。

2.1 视觉与惯导组合系统

自文献[14-15]提出视觉与惯性系统组合的方法后,视觉/惯性组合系统开始受到广泛关注。视觉/惯导组合导航系统虽然在精度上不及目前普遍使用的GNSS/INS组合导航,但其自主性更强,尤其是在卫星信号中断、被屏蔽或低置信度的隧道以及城市建筑物密集区域[16]。VO/INS系统框架如图2所示,根据组合系统中摄像机数量的不同,可以将组合系统主要分为单目视觉系统和双目视觉系统。

在单目视觉里程计与惯导组合导航系统中,由于单目视觉里程计只有方向信息是可恢复的,而平移的绝对尺度无法恢复[16];因此,一般算法都借助惯导的信息来实现绝对尺度的位姿估计。文献[17]提出了用于无人机控制的基于视觉和惯性组合的导航方法,利用摄像机从已知位姿信息的目标飞行器获得的导航参数与惯性传感器测量的导航参数融合,得到修正的导航参数。文献[18]提出了把惯性速率测量和基于一个特征信息的单目视觉测量相融合的算法,用于测量载体的相对运动。文献[19]提出基于多位置极点约束单目视觉/惯性组合导航算法,将多位置观测的摄像机位姿扩展为状态量,通过左零空间投影得到线性观测方程。为了克服单纯由视觉估计摄像机姿态精度低造成的长距离导航误差大的问题,文献[20]提出了一种基于单目视觉里程计/惯性组合导航定位算法,通过配准和时间同步,用INS解算的速度和视觉计算的速度之差作为组合导航的观测量,利用卡尔曼滤波修正导航信息。大部分单目视觉里程计与惯导组合系统都是紧组合系统,将视觉和惯导的的原始数据融合在一个优化的滤波器中,因此不同传感器间的耦合关系被考虑了;不足之处在于算法的实时性不够好,且不利于处理外部较大跃变的校正信息。松组合则相对比较容易实现,使用独立的视觉和惯导模块,这2个模块以不同的数据速率运算,然后再将它们的运算结果融合。如:文献[21]将单目视觉和惯导当成独立模块,然后用扩展卡尔曼滤波器估计位移的尺度,减少位置估计误差;文献[22]通过视觉里程计和惯导估计的速度差来计算系统位移尺度和重力加速度方向,使用间接滤波方法对误差进行最优估计,并利用误差估计,值对里程计系统进行校正,以提高系统的定位性能。

与单目视觉里程计的情况相反,双目视觉里程计能够实现高精度绝对尺度的六自由度位姿解算,松组合不会破坏它的模块特性且易于对其进行单独优化,所以双目视觉里程计与惯导组合系统多采用松组合方式。文献[23]使用一个滤波器来融合视觉与惯导的位姿信息,用惯导的位移、速度、姿态航向、陀螺仪零漂、加速度计零漂、重力加速度的模组成的状态矢量,研究用于无人机的视觉惯导融合定位算法。文献[24]用线性卡尔曼滤波器融合惯导的陀螺仪和加速度计来无漂移地估计惯导的姿态,然后用扩展卡尔曼滤波(extendedKalmanfilter,EKF)融合视觉与惯导的姿态航向信息,以姿态航向的单位四元数作为EKF的状态矢量,以视觉里程计的旋转运动估计做滤波器预测,以惯导的姿态方位估计做滤波器观测,没有考虑位移信息的融合,通过将视觉与一个高精度的导航级惯导融合,实现了数千米的高精度定位。文献[25]用一个滤波器将视觉里程计与惯导估计的姿态及高度计估计的高度进行融合,用于在GPS失效时对飞行器的位姿进行估计,其中视觉里程计有别于一般的从运动信息中恢复三维场景结构的视觉里程计,并非是基于特征的检测与匹配来实现位姿估计,而是基于对平面运动的若干假设来运算的。文献[26]将视觉里程计与惯导及多普勒计程仪进行融合,用于水下机器人的定位,其融合方式是用惯导和计程仪估计的运动来减小图像匹配的搜索区域,以提高算法的实时性。文献[27]使用一种“Delayed”卡尔曼滤波器融合视觉里程计与惯导,“Delayed”指的是将上一时刻的滤波结果加入到当前滤波器状态矢量中,这种滤波器方程略复杂,非线性程度高。惯导和视觉融合的里程计研究中,主要以开环的方式进行惯导和视觉的融合,缺乏一定的反馈控制,当遇到载体运动较为激烈时,惯导和视觉定位的不确定度增大后可能遇到无法收敛而导致姿态估计偏离,进而影响定位精度。因此对于智能车而言,利用更多的控制信息,并融合一定的先验控制参数,能够有效地对运动估计进行指导,从而使系统估计更加鲁棒。

2.2 视觉与卫星导航组合系统

在VO/GNSS组合导航系统中,鉴于视觉导航系统具有自主性好、信息全面、短期精度高等优点,一般以视觉导航作为组合导航系统的关键子系统,而利用GNSS长期稳定的输出修正视觉导航系统的误差。VO/GNSS组合系统的组合方式与经典的GPS/INS松组合系统具有一定的相似性;目前对于VO/GNSS的研究主要集中在松组合阶段。文献[28]借鉴GNSS/INS组合导航系统模型,提出一种类似于GPS/INS松组合的GPS/VO组合导航系统,利用卡尔曼滤波器对载体姿态进行可观测性分析,并通过MATLAB仿真实验验证系统的可行性。随后,其又在原有的基础上对比例因子是未知的单目视觉里程计系统进行了扩展研究;通过小型飞机采集的真实数据验证了系统误差可观测性分析的可靠性[29]。文献[30]采用松组合方式,结合基于载波相位差分技术的高精度GNSS和基于特征提取的视觉里程计,利用GNSS精准定位结果对视觉里程计初始化定位,降低系统的初始误差;当车辆处于GNSS信号受影响区域而只能接收到2~3颗卫星信号时,依旧可以有效地抑制视觉里程计的漂移误差。

与单目视觉里程计不同的是,双目视觉里程计与GNSS融合不仅可以抑制视觉里程计的漂移,而且可以有效降低导航角误差。文献[31]融合双目VO与GPS以平滑GPS的多路径误差,提高了导航角精度。文献[32]利用车道线与智能车的局部位置信息提高视觉里程计的精度,随后使用卡尔曼滤波器对GNSS的定位精度进行矫正。此外,双目视觉系统可以有效地避免单目视觉定位漂移的缺陷。文献[33]利用城市环境中路标的地理位置信息,通过双目视觉系统对车辆进行局部定位,实现每隔一段时间都能对GNSS定位误差进行校正;实验表明在路标可见范围内对GNSS定位精度有明显改善。相对于VO/GNSS松组合系统,紧组合系统是在原先GNSS辅助VO的基础上,利用VO数据对GNSS接收机进行辅助,即一方面利用GNSS和VO的导航数据进行组合滤波;另一方面,VO利用自身测得的载体位置和速度信息对GNSS载波跟踪环路进行辅助,从外部剔除由于载体和接收机之间相对运动引起的动态误差,使GNSS接收机在高动态环境下可以稳定工作,并可进一步压缩接收机载波跟踪环路带宽,抑制噪声,提高系统的抗干扰性能。紧组合系统是VO/GNSS组合系统的重要发展方向[28]。

2.3 多传感器组合系统

多传感器组合系统的设计原则需兼顾导航精度与鲁棒性最大、复杂性最小以及处理效率最优,且必须考虑不同导航技术的特点。如利用视觉里程计系统弥补GNSS/INS系统在GNSS受影响区域系统误差随时间积累的问题,传统的卫星/惯性/视觉组合导航信息融合框架和处理流程如图3所示。

文献[34]使用扩展卡尔曼滤波器融合视觉/IMU/GNSS以提高地面车辆在GNSS受影响区域的定位性能,并通过动态交通环境下采集的数据对多传感器系统进行了检测,实验结果显示该系统的性能优于GNSS/IMU紧组合导航系统。文献[35]基于惯导/GPS/视觉组合系统,采用层次化分散融合结构融合相对导航传感器数据,提高了相对导航精度、可靠性和容错性能。文献[36]实现了无人飞行器的GPS/INS/视觉组合导航,并给出了GPS失锁90s的组合导航结果,表明带有视觉导航辅助的导航系统具有良好的稳定性。除传统的卫星与惯性导航系统外,雷达导航系统也可以与视觉里程计系统组合。文献[37]针对星际探测器软着陆的进入下降和着陆段的组合导航问题,提出了一种多传感器融合及多推理系统决策融合算法,该算法将雷达、激光雷达和CCD相机所获得的地面信息进行智能融合,根据传感器信息对模糊集、贝叶斯概率和Dempster-Shafer置信3个子决策系统分别给出决策,通过分层融合选择算法获得最终决策,使星际探测器具备自主选择软着陆安全区域的能力。导航信息融合算法是组合导航系统的关键技术。文献[38]提出了一种改进的EKF算法,该算法针对非线性位置姿态观测方程,融合了惯导速率观测量和视觉观测量,通过观测已知坐标的特征目标物,来确定移动载体的位姿信息。文献[39]使用卡尔曼滤波将GPS数据与视觉特征跟踪算法进行融合,该算法利用彩色阈值分割等方法进行图像预处理,将方形区域的窗户特征作为提取目标,并通过持续跟踪该目标来实现城市内导航,算法具有较高实时性,在实测实验中获得了15帧/秒的视频图像处理速度。随着信息融合技术的发展,利用多传感器组合导航技术进行信息融合逐步成为国内外导航领域的重要发展方向[40]。

3 研究展望

融合视觉里程计的组合导航系统已经取得了较多研究进展;但是目前的研究仍然处于实验阶段,此项技术仍然存在一些问题亟待解决,如下研究方向或可作为下一步研究的重点:

1)更高效率、更高精度的特征检测与匹配算法。当前的研究中,鲁棒的特征提取与匹配本身计算量大,而快速的特征检测又会造成特征集噪声过大,使检测数据的计算量加大,这些都影响了系统的实时性;所以设计更鲁棒更快速的特征提取与匹配算法非常重要。

2)紧组合导航系统滤波算法研究。在紧组合系统中,需要直接融合传感器的原始数据,由于不同观测条件下的观测数据质量有所差异,针对不同的观测条件如何选择相应的滤波算法和配置相应的算法参数需要进一步研究。

3)低成本的组合导航信息融合技术。目前所提出的算法大多适用于高精度的仪器设备,相应的算例中的仪器设备精度也较高;而目前小型化和低成本是组合导航的一个重要发展趋势,低精度的惯导和相机在误差特性方面会有所区别,针对低成本组合导航信息融合还需要进一步深入研究。

4)加快组合系统的软件和硬件实现并进行工程应用。国内对于融合视觉的组合导航系统的研究大多处于仿真验证阶段,目前还没有松组合和紧组合方面较成熟的软件系统及硬件实现。

4 结束语

在当前智能车的车载计算机的运算能力和存储空间有限的情况下,是通过复杂的算法增加鲁棒性,还是通过降低复杂度提高实时性,抑或增加多种传感器提高精确度,融合视觉的组合导航系统在实现过程中往往面临着实时性、可靠性与鲁棒性等性能指标的取舍兼顾。在设计组合导航系统的过程中,需要根据不同的应用环境和需求选择合适的传感器,权衡多个性能指标,并根据需要进行改进。我国现有的无人驾驶车辆导航与环境感知技术水平距离世界前沿的关键技术还有一定的差距,还需要不断地改进和完善现有的传感器性能和信号融合技术,才能加快组合导航系统在无人驾驶车辆中实际应用的步伐。

[1] 秦永元,张洪钱,汪叔华.卡尔曼滤波与组合导航原理[M].3版.西安:西北工业大学出版社,2014:227-236.

[2] 江燕华,熊光明,姜岩.智能车辆视觉里程计算法研究进展[J].兵工学报,2012,33(2):215-219.

[3]SCARAMUZZAD,FRAUNDORFERF.Visualodometry(Part1:thefirst30yearsandfundamentals)[J].IEEERobotics&AutomationMagazine,2011,18(4):80-92.

[4]MORAVECH.Obstacleavoidanceandnavigationintherealworldbyaseeingrobotrover[D].Stanford:Univ.ofStanford,1980.

[5]MATTHIESL,SHAFERSA.Errormodelinginstereonavigation[J].IEEERoboticsandAutomation,1987,RA-3(3):239-250.

[6] 彭勃,周文晖,刘济林.基于Harris角点检测的立体视觉里程计[J].兵工学报,2007,28(12):1498-1502.

[7]NISTERD,NARODITSKYO,BERGENJ.Visualodometry[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe2004IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition.Washington:IEEE,2004: 652-659.

[8]BADINOH.Arobustapproachforego-motionusingamobilestereoplatform[J].IEEELectureNotesinComputerScience,2007,3417:198-208.

[9]AQELM,MARBABANM,SARIPANM,etal.Adaptive-searchtemplatematchingtechniquebasedonvehicleaccelerationformonocularvisualodometrysystem[J].IEEEElectricalandElectronicEngineering,2016,11(6):739-752.

[10]BERANL,CHMELARP,REJFEKL.Navigationofroboticsplatformusingmonocularvisualodometry[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe25thInternationalConferenceonRadioelectronica.Pardubice:IEEE,2015:213-216.

[11]GARCIA-GARCIAR,SOTELOM,PARRAI,etal.3Dvisualodometryforroadvehicles[J].IEEEIntelligent&RoboticSystems,2008,51(1):113-134.

[12]FUH,MAH,XIAOH.Real-timeaccuratecrowdcountingbasedonRGB-Dinformation[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe19thInternationalConferenceonImageProcessing.LakeBuenaVista:IEEE,2012:2685-2688.

[13]MINGY,RUANQ.ActivityrecognitionfromRGB-Dcamerawith3Dlocalspatio-temporalfeatures[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe19thInternationalConferenceonMultimediaandExpo.Melbourne,Australia:2012:344-349.

[14]DISSANAYAKEMWMG,NEWMANP,CLARKS,etal.Asolutiontothesimultaneouslocalizationandmapbuilding(SLAM)problem[J].IEEERoboticsandAutomation,2001, 17(3):229-241.

[15]KIMJ,SUKKARIEHS.6DoFSLAMaidedGNSS/INSnavigationinGNSSdeniedandunknownenvironments[J].IEEEGlobalPositioningSystems,2005,4 (1): 120-128.

[16]黄鸿.双目立体视觉与惯导融合里程估计方法[D].杭州:浙江大学,2013:2-15.

[17]ALLEND,JOHNSONN,ALISONA.Vision-aidedinertialnavigationforflightcontrol[J].IEEEAerospaceComputing,2005 (2): 348-360.

[18]HUSTERA,ROCKSM.Relativepositionsensingbyfusingmonocularvisionandinertialratesensors[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe11thInternationalConferenceonAdvancedRobotics.Coimbra.Portugal:IEEE,2003.

[19]MOURIKISA,ROUMELIOTISS.Amulti-stateconstraintKalmanfilterforvision-aidedinertialnavigation[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsof2007InternationalConferenceonRoboticsandAutomation.Roma,Italy:IEEE,2007.

[20]冯国虎,吴文启,曹聚亮,等.Algorithmformonocularvisualodometry/SINSintegratednavigation[J].中国惯性技术学报,2011,19 (3): 210-215.

[21]WEISSS,SIEGWARTR.Real-timemetricstateestimationformodularvision-inertialsystems[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsof20011InternationalConferenceonRoboticsandAutomation.Shanghai,China:IEEE,2011:4531-4537.

[22]KNEIPL,WEISSS,SIEGWARTR.Deterministicinitializationofmetricstateestimationfiltersforloosely-coupledmonocularvision-inertialsystems[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsof2011InternationalConferenceonIntelligentRobotsandsystems(IROS).SanFrancisco:IEEE,2011:2235-2241.

[23]KELLYJ,SARIPALIS,SUKHATMEGS.Combinedvisualandinertialnavigationforanunmannedaerialvehicle[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe6thInternationalConferenceonFieldandServiceRobotics.Chamonix,France:IEEE,2008:255-264.

[24]KONOLIGEK,AGRAWALM.Large-scalevisualodometryforroughterrain[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsofthe13thInternationalConferenceonRoboticsResearch.Hiroshima,Japan:IEEE,2011:201-212.

[25]READBB,TAYLORCN.InertiallyaidedvisualodometryforminiatureairvehiclesinGPS-deniedenvironments[J].JournalofIntelligentandRoboticSystems,2009,55(2-3):203-221.

[26]HILDEBRANDTM,KIRCHNERF.IMU-aidedstereovisualodometryforground-trackingAUVapplications[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsof2010InternationalConferenceonOceans.Sydney,Australia:IEEE,2010:1-8.

[27]TARDIFJ,GEORGEM,LAVEMEM,etal.Anewapproachtovision-aidedinertialnavigation[C]//TheInstituteofElectricalandElectronicEngineers(IEEE).Proceedingsof2010InternationalConferenceonIntelligentRobotsandSystems.Taipei:IEEE,2010:4161-4168.

[28]DUSHA D.Attitude observability of a loosely-coupled GPS/visual odometry integrated navigation filter[C]//The Institute of Electrical and Electronic Engineers(IEEE).Proceedings of 2010 International Conference on Robotics and Automation. Australia:IEEE, 2010.

[29]DUSHA D,MEJIAS L.Error analysis and attitude observability of a monocular GPS/visual odometry integrated navigation filter[J].IEEE Robotics Research,2012,31(6):714-737.

[30]ANDREY S.Integration of GPS and vision measurements for navigation in GPS challenged environments[C]//The Institute of Electrical and Electronic Engineers(IEEE).Proceedings of 2010 International Conference on Position Location and Navigation Symposium.Palm Springs:IEEE,2010 :826-833.

[31]WEI L, CAPPELLE C,RUICHEK Y,et al.GPS and stereovision-based visual odometry: application to urban scene mapping and intelligent vehicle localization[EB/OL].(2010-11-15)[2016-10-21].https://www.hindawi.com/journals/ijvt/2011/439074/.

[32]周莉.基于GNSS与视觉的道路监测与避障技术[D].成都:电子科技大学,2015:24-30.

[33]张奕然,郭承军,牛瑞朝.智能车双目视觉辅助GNSS定位方法研究[J].计算机工程与应用,2016,52(17):192-197.

[34]CHU T,GUO N,BACKEN S,et al.Monocular camera/IMU/GNSS integration for ground vehicle navigation in challenging GNSS environments[J].IEEE Sensors,2012,12(3):3162-3185.

[35]曲法义,王小刚,崔乃刚.基于惯导/GPS/视觉的无人机容错相对导航方法[J].中国惯性技术学报,2013,21(6):782-785.

[36]WANG J,GARRATT M,LAMBERT A,et al.Integration of GPS/INS/vision sensors to navigate unmanned aerial vehicle[J].Remote Sensing and Spatial Information Science,2008.

[37]SERAJI H,SERRANO N.A multisensor decision fusion system for terrain safety assessment[J]. IEEE Robotics,2009,25(1):99-108.

[38]HUSTER A,ROCK S M.Relative position sensing by fusing monocular vision and inertial rate sensors[C]//The Institute of Electrical and Electronic Engineers(IEEE).Proceedings of the 11th International Conference on Advanced Robotics.Coimbra,Portugal:IEEE, 2003:1562-1567.

[39]SARIPALLI S,SUKHATME G,MEJIAS L,et al.Detection and tracking of external features in an urban environment using an autonomous helicopter[C]//The Institute of Electrical and Electronic Engineers(IEEE).Proceedings of 2010 International Conference on Robotics and Automation.Barcelona. Spain:IEEE, 2005: 3972-3977.

[40]董明.卫星/惯性/视觉组合导航信息融合关键技术研究[D].郑州:信息工程大学,2014:10-15.

Analysis on integrated navigation technology for intelligent vehicles by integrating vision

ZENGQingxi1,2,3,FENGYupeng1,3,DUJinzhi2,FANGXiao2,LIZhongbing2

(1.Self-driving Vehicle Research Center, Nanjing University of Aeronautics and Astronautics,Nanjing 210016, China;2.Prospective Technology Research Institute of Chery Automobile Co., Ltd., Wuhu, Anhui 241009, China;3.State Key Laboratory of Automotive Simulation and Control, Changchun 130012, China)

In order to further study on the navigation and positioning technology for self-driving intelligent vehicles, the paper analyzed the application of the visual odometry in vehicle integrated navigation system: the principle of the visual odometry was introduced; and the three main research directions of the vehicle integrated navigation system based on the visual odometry were expounded, as INS/VO, GNSS/VO and multi-sensor system; finally the development of the visual odometry in the intelligent vehicle integrated navigation system was prospected

visual odometry; integrated navigation; GNSS; INS; intelligent vehicle

2016-12-18

中国博士后科学基金资助项目(171980);国家重点研发计划资助项目(2016YFB0501805);南京航空航天大学研究生创新基地(实验室)开放基金资助项目(kfjj20160216)。

曾庆喜(1980—),江苏南京人,博士,讲师,研究方向为无人驾驶车辆多传感器组合导航方法。

冯玉朋(1992—),安徽滁州人,硕士硕士生,研究方向为无人驾驶车辆视觉与卫星组合导航系统。

曾庆喜,冯玉朋,杜金枝,等.融合视觉的智能车组合导航技术分析[J].导航定位学报,2017,5(2):1-6,13.(ZENG Qingxi,FENG Yupeng,DU Jinzhi,et al.Analysis on integrated navigation technology for intelligent vehicles by integrating vision[J].Journal of Navigation and Positioning,2017,5(2):1-6,13.)

10.16547/j.cnki.10-1096.20170201.

P228

A

2095-4999(2017)02-0001-07