融合全局特性的SIFT特征在图像检索中的应用

2010-03-19李金,梁洪

李 金,梁 洪

(哈尔滨工程大学 自动化学院,哈尔滨 150001)

0 引 言

随着现代化信息技术以及多媒体技术的飞速发展,海量的多媒体信息数据出现在众多科研、应用领域中。多媒体信息中信息量最大且最主要的一种就是视觉信息 (包括静止图像信息、视频信息、序列图像信息以及计算机图形和动画信息等),而视觉信息中数量最大且最主要的就是图像信息[1]。因此,如何高效的管理如此庞大的图像库并使其为公众服务也就成为当前迫切需要解决的问题。

传统的图像检索主要是借用基于描述的文本索引技术,其优点是技术简单,易于实现。然而,这种检索技术存在着许多严重的问题:对图像的文本描述必须完全依赖于手工标注,这对于海量的图像数据显然不合适;手工描述往往是不准确或不完整的,同时还不可避免的受到个人主观因素的影响;图像中所包含的丰富的视觉特征往往无法用文本进行客观和完整的描述[2]。

鉴于以上原因,人们提出了基于内容的图像检索 (Content-Based Image Retrieval,CBIR)技术。CBIR的基本思想是对图像提取视觉特征,构成描述图像内容的特征向量,并以此作为查询索引,通过相似度匹配来实现较高层次上的图像检索[3]。

在图像检索中如何快速准确地提取视觉信息内容是最为关键的一步,即有效的提取图像的稳定特征在图像检索领域有着重要的作用。大多数图像都会受到光照条件、景物几何形状和物理特性、噪声干扰和畸变等影响,从而给图像检索增加了难度,因此,图像检索领域急需一种能够有效对目标直接进行检索的方法。为此,本文提出一种基于融合全局特性的SIFT特征的图像检索方法。

SIFT描述子是David Lowe于1999年提出的局部特征描述子,并于2004年进行了更深入的完善和发展[4-5]。SIFT特征对图像目标的旋转、尺度缩放、亮度变化能够保持不变,对视角变化、仿射变换、噪声也保持一定程度的稳定性。不同特征点的局部邻域信息差别较大时,SIFT特征匹配算法生成的描述子唯一,该算法可以得到满意的结果,但对于整幅图像中目标物体复杂的情况,该算法就会出现大量的误匹配点对。因此,本文对SIFT特征匹配算法进行改进,加入全局颜色信息,使得SIFT描述子能够与全局信息互相约束,从而可以降低误匹配的概率,提高检索的准确度。

1 SIFT特征提取

1.1 构建尺度空间

尺度空间的基本思想是通过对原始图像进行尺度变换,获得不同尺度空间的序列图像,这种方式称为图像的多尺度表示,在不同尺度下可以获取图像不同的特征,所以利用多尺度可有效的提取图像特征,获取图像内容。

要在多尺度下对图像进行处理,首先需要对图像进行多尺度表达,并建立各个尺度间的联系。金字塔是一种有效的多尺度表达结构,它是从原始图像出发导出一系列越来越平滑、分辨率逐步降低的图像。Lindeberg已经指出在现存各种各样的平滑函数中,唯一可以作为尺度空间核函数的就是高斯函数[6]。

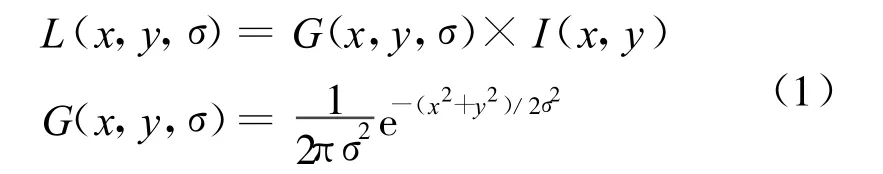

定义函数L(x,y,σ)为图像的高斯尺度空间,则不同尺度下的尺度空间表示可由输入图像I (x,y)与高斯函数G(x,y,σ)进行卷积而得到。

一幅图像为I(x,y),G(x,y,σ)是尺度可变的高斯函数(σ为可变尺度),则I(x,y)的高斯尺度空间L(x,y,σ)可以定义为:

其中σ为可变尺度空间因子,其值越小则表征该图像被平滑的越少,相应的尺度也就越小。大尺度对应于图像的概貌特征,小尺度对应于图像的细节特征。

为了有效的在尺度空间检测到稳定的关键点,利用高斯差分DOG(Difference of Gaussian)算子建立尺度空间,可利用不同尺度的高斯差分核与图像卷积生成。DOG算子的定义如下:

之所以使用DOG算子有两个主要原因:①DOG算子是一种比较有效的,计算方便快速的滤波算法;②DOG是尺度归一化LOG(Laplacion of Gaussian)算子的近似,具有很好的稳健性。事实上,DOG算子的原理就是由两个不同尺度的高斯滤波器相减之后再对原来的图像进行滤波。这种方法只是比原来的高斯滤波多做了一次减法而已,因此计算十分方便高效。

Gaussian金字塔和DOG尺度空间的建立过程见图1。

在尺度空间中,将初始图像与高斯函数不断卷积来产生一系列图像,这些图像都是由一个固定常量——相邻的两幅图像之间的尺度比例k来确定的。如图1左侧所示的堆集,尺度空间分为n阶,每一阶有s层,为了让后面的极值检测覆盖整个DOG尺度空间,需要产生s+3幅的Gaussian图像,这s+3幅的Gaussian图像从下到上尺度参数以k递增,也就是说,若当前的Gaussian图像的尺度参数为σ,则下一层Gaussian图像的尺度参数为kσ,k=21/s,相邻尺度的图像相减就得到了s+ 2幅的DOG图像,本文s值取3,如图1右侧所示。当所有的尺度阶都处理完,则重新采样产生一个新的高斯图像,而s则变为初始的2倍,大小则是它的1/2(也就是原来图像堆的下面第3层图像缩小2倍后的图像)。这个图像作为下一个图像堆的堆底图像来产生一个新的图像堆,在k和σ的取值保持不变的情况下,下一个图像堆的计算量大为减小。

图1 尺度空间建立过程Fig.1 Constructing process of scale space

1.2 SIFT特征提取

在成功构建尺度空间后,就要在该尺度空间中进行局部极值的检测。如果像素点的值在某位置能达到最大值或最小值,则定义这样的点为 “关键点”。极值检测得到的所有候选关键点,还必须通过两步检验才能确定是关键点:①它必须与周围的像素有明显的差异,也就是说低对比度的点不要;②它不能是边缘点。

1.2.1 空间极值点检测

为了检测D(x,y,σ)的局部最大值和最小值点,每个像素点都要与其邻近的26个像素点进行比较,这26个点包括同尺度的8个点,上下两个尺度的各9个点,如果这个点的像素值比它周围的这26个点的像素值都大或者都小,那么它就被选为特征点,并且选择DOG图像对应的尺度为该点的特征尺度,见图2。所有这样的局部极值点就构成了一个SIFT候选关键点的集合。

图2 空间局部极值点检测Fig.2 Extrema detection in DOG space

1.2.2 关键点确定

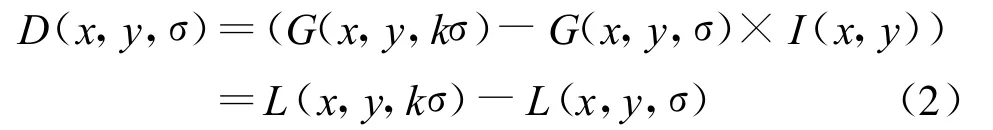

1)去除低对比度的点。对于低对比度的点来说,通过一个二次拟合可以精确确定极值点坐标。空间尺度函数D(x,y,σ)在局部极值点 (x0, y0,σ)处的二阶Taylor展开式为:

其中,X=(x,y,σ)T,表示采样点和特征点之间的位置、尺度偏移。令式 (3)的一阶导数为0,就可以得到函数D(x,y,σ)的极值点^X:

将式(4)代回到式(3),得到:

如果计算得到的|D(^X)|<0.03,就可以确定这个候选关键点是低对比度的点,应该从特征点中剔除。

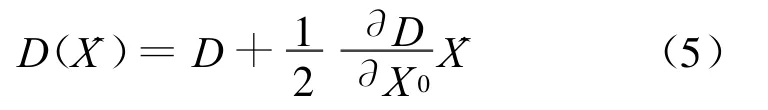

2)去除边缘点。此外还应舍去具有不稳定的边缘响应点,主要是排除边缘切向有较大的主曲率而在边缘的垂直方向有较小的主曲率的点。主曲率通过DOG函数的2×2Hessian矩阵H求出:

设矩阵H的最大特征值为α,最小特征值为β,计算Hessian矩阵的迹和行列式:

令α=rβ,则有:

本文中令r=10,如果候选关键点不满足式(10),则认为这个点是可能的边缘点,应该从特征点中剔除。

1.2.3 关键点大小及方向参数的确定

在DOG尺度空间检测到的局部极值点在经过精确化点的位置、剔除低对比度的点、消除边缘响应后所保留的点被称为关键点,此时的关键点信息包括位置信息及尺度信息。通过给每个关键点分配一个基于图像局部属性的一致性方向,关键点的描述符的表示就会跟该方向相关,此时,也就取得了图像旋转不变量。

为了使算子具备旋转不变性,需要给每个关键点指定一个方向参数,这个方向参数可以通过计算关键点的梯度大小和方向来获得。

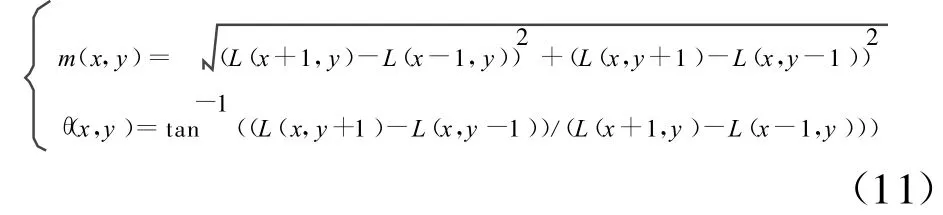

对于高斯空间中的每一个图像样本 L(x, y),计算每个像素点的梯度大小m(x,y)和方向θ(x,y):

得到了每个采样点的梯度大小和方向,接下来需要确定的是每个关键点梯度的大小和方向,本文采用的是梯度直方图统计法。

对于每一个关键点,考虑它邻近一个窗口内所有采样点的梯度的大小和方向,并用梯度直方图统计邻域像素的梯度方向,梯度直方图的范围是0~360°,其中每10°为一个方向,总共36个方向。然后将邻域内的每个采样点按梯度方向θ归入适当的bin,以梯度模m作为贡献的权重。最后选择直方图的主峰值作为特征点的主方向,选取量值达到主峰值80%以上的局部峰值作为辅助方向。这样一个特征点可能会被指定具有多个方向,可以增强匹配的鲁棒性。

1.2.4 SIFT特征向量描述子

在确定了每个关键点的位置、所处尺度和方向后,接下来是将关键点描述成特征向量。

在提取局部描述符之前,先将坐标轴旋转为关键点的方向,以确保旋转不变性。SIFT特征向量描述子生成的过程见图3。

图3 关键点特征向量描述Fig.3 Feature vector description of keypoint

特征向量的构造过程如下:

1)以关键点为中心取88的窗口,将这个窗口切成22的子窗口,利用式 (11)统计每个子窗口中的方向直方图。

2)将采样窗口中各像素点根据坐标按高斯加权后归入4×4的位置网格,窗口中所有点对同一网格的贡献之和作为描述子在该维的值,即可形成8个方向向量信息。

3)将采样点与特征点的相对方向按高斯加权后归入包含8个bin的方向直方图(每个bin同样作为描述子的一维),所有点对同一个bin的累加值作为描述子在该维的值。另外,为了使SIFT特征具有旋转不变性,创建方向直方图时使用的是采样点和特征点的相对方向。

4)由上述2)、3)即获得4×4×8共128维的SIFT描述子。标定了SIFT特征的一幅示例图像见图4。

2 利用全局特征进行修正

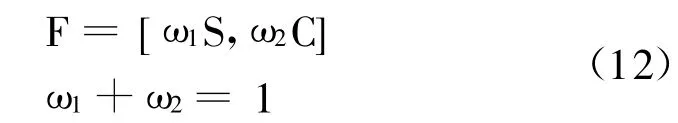

针对利用SIFT算子生成的每一个关键点进行全局向量约束,新的特征向量由两部分组成,一部分是SIFT特征向量,一部分是全局特征向量,可用下式表示:

图4 标定SIFT特征向量的示例图像Fig.4 Sample image with SIFT feature vector calibrated

其中S表示128维的SIFT局部向量;C表示64维的全局颜色向量;F表示192维的新的特征向量;表示向量的权重,权重的确定可以有以下3种方法:①设定为均等;②按经验人为设定;③利用相关反馈的方法确定,根据检索统计结果进行设定。

3 相似性度量

3.1 图像特征PCA降维

由于高维特征向量的引入,使得特征匹配计算量剧增,为了改善检索速度,提高检索效率,本文对所得到的原始特征利用PCA进行降维处理。主成分分析 (Principal Component Analysis,PCA)就是一种非常经典的寻找有效的线性变换的方法, PCA方法的目的就是寻找在最小均方误差意义下最能代表原始数据的投影方法[8]。

首先计算d维均值向量μ和大小为d×d的协方差矩阵∑。然后,计算 ∑的特征值及其对应的特征向量,每个特征向量ei都对应一个特征值λi。接下来,选出对应最大k个特征值对应的特征向量作为主成分方向。通常最大的特征值只有很少的几个,这意味着k取决于数据本身的子空间的内在维数,而剩下的d-k维往往由噪声引起。构造一个d×k的矩阵A,它的列由k个特征值对应的特征向量组成。那么原始数据投影到k维空间的降维数据表示为:

主成分分析是在最小均方误差准则下,找到一个k维的线性子空间,使其能够最好地表示原始高维数据。本文令k=48,使得特征向量的维数从192降到48。

3.2 特征匹配策略

当特征向量形成后,就要对特征点进行匹配,本文利用最近邻(NN)和次近邻(SCN)特征点的欧式距离之比作为相似性度量准则。如果最近的距离和次近距离的比值小于某个阈值,则认为该点对匹配成功。降低这个比例阈值,匹配点对数目就会减少,但精度会提高。

4 实验及分析

本文所采用的实验图像测试集来源于COREL图像库等网络数据资源[9-10],共计200幅彩色图像,分为船、北京古建筑、飞机、火箭和汽车等5大类型,其中,每类图像有40幅。

为有效测试本文算法,这里分别进行以下3种测试:

1)利用SIFT算子作为特征描述向量,不进行降维直接进行检索,其中一个检索结果的前10幅图像见图5(a);

2)利用本文提出的融合全局特征的SIFT算子作为特征描述向量,不进行降维直接进行检索,其中一个检索结果的前10幅图像见图5(b);

3)利用本文提出的融合全局特征的SIFT算子作为特征描述向量,进行PCA降维后进行检索。每一种实验各选取每类图像中的5幅图像作为示例图像进行检索,由于篇幅有限,本文仅给出北京古建筑图像一次的检索结果,见图5。

通过对一系列检索结果进行分析发现,利用SIFT特征描述图像内容,确实能够对旋转、平移、尺度缩放、亮度变化保持不变,对视角变化、仿射变换、噪声也保持一定程度的稳定性。对于含有示例图像中目标的侧面图像没能检出的原因在于该算法对性状的依赖性。

另外,应用融合全局特性的SIFT特征描述图像内容,除了能够保持上述的优良特性外,还能够从全局特征上约束图像特征的描述。由于本文采用的是颜色全局变量,因此,我们可以看到,在保证含有目标物体的图像被准确检出的同时,色调相近的图像排在了前方,这在一定程度上满足了人们的主观视觉需求。对于出现在检索结果中的不相关图像主要是由于目标形状的某些邻域内特征点能够匹配且在全局颜色特征与示例图像近似引起的。

此外,利用降维的方法对特征向量进行约减,虽然在一定程度上造成了特征信息的丢失,但是,实验表明,由于本文特征表达的有效性,其对相关图像的检出影响不是很大,与此同时,检索的速度提高了很多,因此,利用降维后的特征进行检索还是能够保证检索的有效性。

5 结 论

本文提出了一种基于融合全局特性的SIF T特征的图像检索方法。由于既利用了SIFT算子能够保持旋转、缩放、平移不变等强大的目标关键点描述能力,又考虑到了图像的全局特性,因此,本文的算法通过实验验证具有良好的可靠性。其不足之处在于SIFT特征对目标形状的敏感可能会降低查全率,对此,可进一步研究将其与形状特征融合进行检索;此外,融合更多更加有效的全局信息到SIFT特征描述当中来也是今后的一个研究思路。

[1]M.Belkhatir,H.C.Thiem.A M ultimedia Retrieval Framework Highlighting Agents and Coordinating Their Interactions to Address the Semantic Gap[J].Expert Systems with Applications,2010,37(12):8 903-8 909.

[2]章毓晋.基于内容的视觉信息检索[M].北京:科学技术出版社,2003.

[3]孟繁杰,郭宝龙.CBIR关键技术研究[J].计算机应用研究,2004,(7):21-24.

[4]Lowe D.G.Object Recognition Frim Local Scale-invariant Features[C]//Greece:Kerkyra,1999:1 150-1 157.

[5]Lowe D.G.Distincive Image Features from Scale-invariant Keypoints[J].International Journal of Computer,2004,60(2):91-110.

[6]Lindeberg,Tony.Scale-space Theory:A Basic Tool for Analyzing Structures at Different Scales[J].Journal of Applied Statistics.1994,21(2):224-270.

[7]刘相滨,邹北骥.一种基于主颜色表的图像检索算法[J].湖南大学学报:自然科学版,2001,28(1):98-102.

[8]Carlos Eduardo Thomaz,Gilson Antonio Giraldi.A New Ranking Method for Principal Components Analysis and Its Application to Face Image Analysis[J].Image and Vision Computing,2010,28(6):902-913.

[9]http://www.cs.sfu.ca/~colour/data.

[10]http://www.db.stanford.edu/~wangz/image. vary.jpg.tar.