欧美人工智能监管模式及政策启示

2025-02-20张文康薛周一

近年来,随着人工智能技术的快速更新迭代发展,尤其是以美国OpenAI公司为首的人工智能企业推出ChatGPT、Sora等生成式人工智能后,人工智能的工作效率、创造力与日俱增。然而,由高性能AI衍生出的人工智能风险,诸如对个人权利的僭越、草莽式的信息收集、愈发突出的伦理问题等,也带来了行政管理领域新的监管难题。由于欧美人工智能发展领先的客观原因,其监管模式也领先于其他国家。因此,期望通过详细讨论欧美人工智能监管模式,着重解析欧盟于2024年2月通过的《人工智能法》[1],从原则目标、监管模式、监督机制和促进发展等角度,总结欧美模式的优势,取长补短形成新式的人工智能监管的中国方案。

各国的人工智能监管模式往往是通过一个或多个法律性文件构建起来的,而中国在人工智能监管方面的相关法律较少,仅有2023年8月15日由国家互联网信息办公室牵头开始实施的《生成式人工智能服务管理暂行办法》这一法律法规以及《新一代人工智能治理原则》和《人工智能产业发展三年行动计划》两份倡导性文件,且《暂行办法》过于笼统,存在监管漏洞。为了促进中国现有人工智能产业规范化发展,未来孵化更多新兴的人工智能企业,吸收“穷举无遗”的欧盟监管模式和“大力推动创新”的美国监管模式的经验是必要的,期望在欧美各有侧重的监管模式之中探寻出一条适合中国本土的中庸之道。

人工智能发展及其监管的滥觞

人工智能(Artificial Intelligence,缩写为AI)是一门新兴的技术科学,旨在研究和开发能够模拟、延伸和扩展人类智能的理论、方法、技术及应用系统。它结合了计算机科学、数学、心理学、哲学等多学科的理论和技术,通过让计算机模拟人类的思考和行为过程,实现人机交互,提高计算机的智能水平,以更好地服务于人类社会。

人工智能的发展及其监管的演进是一个相辅相成的动态过程。随着人工智能技术的快速发展,其在各个领域的应用也愈发广泛,从而引发了对人工智能可能带来的风险和挑战的关注,进而推动了监管措施的制定和完善。有60多个国家发布了人工智能政策文件[2],重新审视这些人工智能政策并分析其差异是必要的,其可以帮助我国人工智能监管政策迅速渡过幼稚期。

(一)传统人工智能与生产式人工智能

欧盟委员会的《通信报告》将人工智能定义为:“人工智能(AI)是指通过分析环境并采取具有一定程度的自主性的行动来实现特定目标来展示智能行为的系统”[3]。传统人工智能主要依赖编程指令来执行特定的任务。例如,一个图像识别系统可能被训练成只识别特定的图像类型,如猫或狗。一旦这个系统遇到它从未见过的图像,它就无法做出正确的判断。这是因为传统AI的学习方式和能力有限,它们通常只能在其训练数据的范围之内进行工作,无法适应和处理新的或复杂的数据类型。

然而,生成式AI则展现出了完全不同的特性。国家网信办《生成式人工智能服务管理暂行办法》将生成式人工智能技术定义为具有文本、图片、音频、视频等内容生成能力的模型及相关技术[4]。它并不依赖于预先定义的规则或模式,而是通过自我学习和适应来改进其性能。即使面对从未见过的数据类型,生成式AI也可以通过分析大量的类似数据来学习如何处理这种数据。这种自我学习和适应的能力使得生成式AI在许多复杂的任务中表现出色。

随着人工智能的跨越式发展,基于人工智能的产品和服务的市场也在快速膨胀,人工智能赋能其他产业具有庞大的未来市场。据市场情报公司The International Data Corporation估计,全球人工智能市场将在2022-2026年期间达到18.6%的复合年增长率(CAGR),到2026年达到9000亿美元的峰值[5]。

(二)人工智能产品或服务潜在的风险

除了人工智能的潜力之外,它也正在成为具有威胁的技术应用的一个突出例子,尤以法律风险及伦理风险为甚。法律风险主要体现在“数据来源合法性问题、生成不良虚假或违法信息问题、数据泄露的法律风险等”[6];伦理风险主要来源于少数群体歧视问题、公民自由意志的不良诱导问题、无序监控与无端揣测问题等。

(三)欧美等国现行人工智能监管模式

欧盟《人工智能法案》秉持了欧洲一贯的法律的详尽性追求及对人权伦理的关切,该法案经国内法学领域相关学者翻译后长达14万字,《法案》对生产生活中的方方面面都进行了预演与讨论,力求构建出一个具体的、可持续的、可执行的人工智能监管模式。自人工智能兴起以来,欧洲学者对于人工智能伦理的争论不绝于耳,《法案》也能体现出欧洲学者的伦理追求,主要集中在如何确保人工智能技术的研发和应用过程中,能够充分尊重和保护人权、隐私,同时避免产生不公平、歧视等伦理问题。

美国的监管风格强调“弱”监管和“软”治理,旨在增强美国在人工智能领域的科技和经济领导地位,为人工智能技术的发展扫除不必要的障碍。这种策略允许更多的创新和灵活性,同时也为AI发展提供了更大的空间。美国的监管法案更加注重行业自律和自我监督。为此,美国政府鼓励企业制定自己的AI伦理准则并通过内部审核和自我监督的方式来减少人工智能的伦理风险,同时美国还注重与学术机构和非营利组织的合作,期望这些组织机构能够推动人工智能产业的系统性、透明性监管。

我国法律学者关于人工智能法律的观点可将其大致区分为“人工智能法律”(AI法律)和“法律人工智能”(法律AI)两大类型,厘清它们的不同立场、方向和路径,进而探讨“第三道路”的可行性,对推进当下人工智能与法律的深入研究无疑具有重要意义[7]。

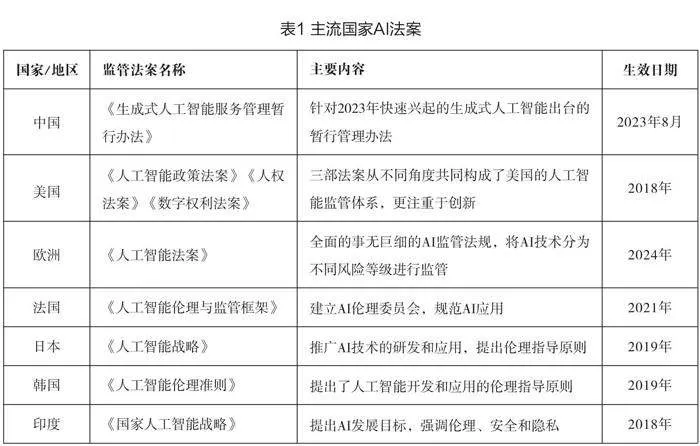

目前世界上一部分主流国家的人工智能监管法案(如表1):

欧美人工智能监管模式的内容

人工智能是恐惧的来源,特别是对人权的尊重需要一个非常精细的法律和道德环境,以避免减缓人工智能的发展[8],细致恰当的监管往往可以促进技术的发展。欧盟逐步形成《人工智能法》为核心的监管模式,美国则由《人工智能政策法案》《人权法案》《数字权利法案》共同构成了人工智能领域的监管框架。

(一)欧盟《人工智能法》

2024年1月19日,欧盟委员会、欧洲议会和欧盟理事会共同完成了《人工智能法》的定稿,对全球范围内人工智能乃至整个数字经济的发展来说,这一立法具有非同寻常的重要性[9]。

1、原则及目标

《人工智能法案》(以下简称《法案》)系为改善市场的运作而制定的统一的法律框架,欧盟期望该法案可促成遵循伦理原则,即透明度;正义、公平和平等;非恶意;责任和问责制的人工智能应用[10],同时确保对健康、安全和对《欧盟基本权利宪章》所规定的基本权利的高度保护,包括民主、法治以及环境的保护,防止人工智能系统在欧洲内产生有害的影响,并且支持人工智能领域的创新与就业,从而使得欧盟成为采用可信人工智能的领导者,使欧洲在AI浪潮中最大获利。

《法案》认为AI投放不应影响现有的法律法规,尤以数据保护、消费者保护、基本权利、就业与工人保护、产品安全为重。为了从人工智能中获利并实现民主的控制,“人工智能素养”应当为提供者、部署者、受影响者具备,以便他们就人工智能系统做出“知情”的决定。“人工智能素养”可包括了解人工智能系统开发阶段技术要素的正确应用、使用过程中应采取的措施、解释人工智能系统输出结果的适当方式,了解在人工智能协助下做出的决定将如何影响他们所需的知识。同时,为了确保正确地执行本条例,人工智能素养应是人工智能价值链中的所有相关参与者的必备素质。未来,人工智能赋能的信息检索将成为用户获取信息的主导模式[11]。可预见的是,广泛普及人工智能素养是公民在人工智能时代生活的必备素质,极大改变各行各业及居民的衣食起居。

本世纪以来,人工智能在军事领域最具革命性,被认为将推动新军事变革[12],欧盟为保证人工智能在国防军事领域的充分发展,被用于国防军事领域的AI不在本法案管理范围之内,但相关活动仍须遵守国际公法及其余法律条约。

《法案》同样注重科技创新,充分尊重学术自由,不应损害人工智能研发活动,因此,有必要将专门为科学研究和开发目的而开发和投入使用的人工智能系统和模型排除在其范围之外,为其适时适度“开绿灯”。

2、约束力规则

约束力规则系《法案》构建人工智能监管的核心,为了对人工智能系统采用一套成比例和有效的具有约束力的规则,应遵循明确界定的基于风险的方法。《法案》根据人工智能系统可能产生的风险的强度和范围,采用基于风险评估等级的方法,明确界定出三级具体的监管方法:(1)有必要明令禁止某些不可接受的人工智能实践活动。(2)规定高风险领域人工智能系统的要求和相关AI运营商的必须遵守的义务。(3)规定人工智能系统都应具有的透明度义务。

欧盟期望通过分级别的约束力规则促成值得人类信赖的、符合伦理道德的以人为本的人工智能,为此欧盟高级别专家组制定了七项人工智能伦理原则,包括:人类主体和监督;技术稳健性和安全性;隐私和数据治理;透明度;多样性、非歧视和公平;社会和环境福祉以及问责制。

一是明令禁止的人工智能活动。欧盟首先在法案中严令禁止了人工智能在多个领域的不当应用,具体包括:利用人工智能进行操纵、剥削及社会控制,这些活动严重侵犯人的尊严、自由、民主与法治等价值观;诱导人们做出违背自我意志的行为或决定,损害人们的自主决策和自由选择权;基于个人生物识别数据进行政治观点、宗教或哲学信仰、种族、性取向等方面的推断,严重侵害个人隐私权;为自然人提供社会评分,可能导致歧视性结果,侵犯人的尊严和不受歧视的权力;在公共场合对自然人进行“实时”生物鉴别,破坏个人隐私权及自由;在没有客观事实证明的情况下,使用人工智能对自然人进行犯罪风险评估,违反“无罪推定”原则;在教育、工作领域利用人工智能进行情绪推断,可能导致人们受到有害或不利的待遇。此外,还禁止了其他法律法规所禁止的实践行为。

在详尽无遗的狭义列举外,只有在相关部门审核授权后,才可在相关领域进行实践活动。例如实时生物监控,只能用于特定被事实验证的目标对象,并且对监控行为进行严格的规定。

二是高风险领域人工智能系统活动。高风险人工智能系统只有在符合特定的强制性要求的情况下才能投入市场或使用。高风险人工智能应用主要集中在可能对人的健康和安全产生不利影响及对《宪章》所保护的基本权利产生不利影响的领域。

具体的高风险人工智能应用场景,包括生物识别技术,特别是远程生物识别系统,以及基于敏感或受保护属性或特征进行生物鉴别分类和情感识别的人工智能系统。此外,还有服务于供水、供电、供暖管理和运行的安全组件,以及用于道路交通的人工智能系统,这些都被视为重要数字基础设施的关键组成部分。教育和职业培训、就业及工人管理、自然人获得和享受基本公共服务和福利等领域也广泛涉及高风险人工智能应用。同时,执法部门及移民、庇护和边境控制管理部门活动领域,以及司法和民主进程领域也是高风险人工智能应用的重要方面。

三是透明度义务。为了确保可追溯性与透明度,人工智能系统的开发者、部署者应当履行透明度义务,在人工智能系统投入使用前向行政主管机构提交此系统的评估文件、使用说明,且有义务在欧盟数据库中登记该系统,以便后续由人工智能委员会进行指导与监管。

非高风险领域的人工智能系统的提供者应确保将与自然人直接互动的人工智能系统的设计和开发方式应使有关自然人知道他们正在与一个人工智能系统互动。应确保从一个合理知情、善于观察和谨慎的自然人的角度来看,考虑到使用的情况和场景,使得自然人能够意识到“自己正与人工智能交互”。

高风险领域的人工智能系统应至少确保其操作具有足够的透明度,使部署者能够解释系统的输出并加以适当使用。同时应当提交使用说明,包括提供者及其授权代表的身份和联系方式;公布高风险人工智能系统的特点、能力和性能限制;其预期目的;所需的计算和硬件资源,高风险人工智能系统的预期寿命,以及任何必要的维护和保养措施,以确保该人工智能系统的正常运行;按规定适当地收集、储存和解释人工智能系统的工作日志。

3、各主体的监管措施

为了落实约束力规则的方方面面,真正实现对人工智能系统的监管,欧盟的监管模式主体分为各国政府或行政组织,人工智能系统价值链各参与者以及第三方监督。

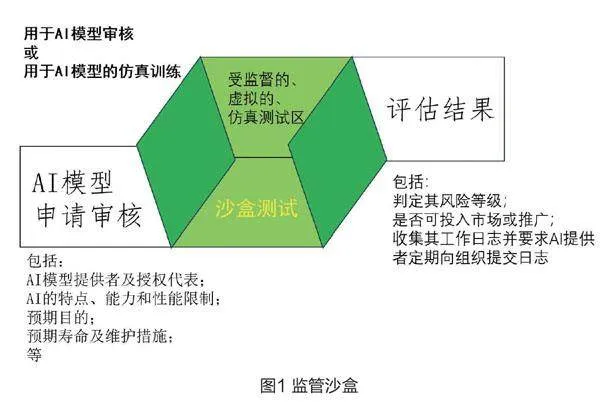

一是国家政府或行政组织的监督。各国政府应当设立一个专业的机构用以人工智能监管,包括审核人工智能系统的市场准入审查、长期监督、高风险领域人工智能使用场景许可的发放、公开数据的集中存储管理等等;建设“监管沙盒”,用于人工智能在开发和上市前阶段建立受控实验和测试环境来促进人工智能创新,以确保创新的人工智能系统符合本条例。“监管沙盒”模型起源于英国金融监督管理局在2015年提出的新监管理念,近年来英法等国已相继展开数据监管沙盒空间的尝试。“监管沙盒”可以真实地模拟人工智能的应用环境,进而为人工智能系统提供进行创新迭代实验及监督实验的安全的测试空间。发放“CE”标志。此行动类似于罗斯福行政时期推行《全国工业复兴法》时期的“蓝鹰标志”,符合《法案》要求的高风险人工智能系统应当悬挂“CE”标志,从而便于被人工智能系统受众辨别。标注“CE”也更有利于人工智能系统在市场中的流通,不得对带有“CE”标志的人工智能系统设置不合理的市场准入障碍。

二是人工智能系统价值链各参与者(即开发者、分销者、部署者等)。任何一个人工智能系统都需要一个自然人作为法人为其负责。人工智能系统价值链参与者应当在系统开发同时设计出风险管理系统,其应当是个长期的可重复的系统。风险管理系统需识别风险或不利影响,并针对已知和可预见的不利情况预设应急措施。保存记录和提供技术文件,尤其包含评估人工智能系统是否符合相关要求和促进市场后监测所需的信息。掌握关于高风险人工智能系统如何开发及其在整个生命周期中如何运行的信息,对于实现这些系统的可追溯性、核实是否符合本条例的要求以及监测其运行情况和市场后监测至关重要。

三是第三方监督。此处的第三方机构是较于行政机关与人工智能企业外的第三方监测机构,鉴于高风险人工智能系统的风险程度,需要为其制定一套适当的合格性评估程序,即所谓的第三方合格性评估。因此,作为一般规则,此类系统的合格性评估应由提供者自行负责进行。

(二)美国2018人工智能政策法案

2018年美国颁布了人工智能政策法案[13],旨在通过建立一个专门的人工智能中心来协调和推动联邦政府在人工智能领域的活动,并提供相关培训、资源和技术援助。

1、核心内容

一是新兴技术政策实验室。法案SEC.3授权在总务管理局(GSA)内设立新兴技术政策实验室来建议和促进联邦政府的努力,以确保政府使用新兴技术,包括人工智能,符合公众的最大利益以及提高联邦机构规则制定和新兴技术使用的凝聚力和能力。该部分第一条职责规定新兴技术政策实验室定期召集来自行政机构、工业界、联邦实验室、非营利组织、高等教育机构和其他实体的个人,讨论新兴技术的最新发展,包括传播有关联邦机构的项目、试点和其他倡议的信息,以及这些技术的最新趋势和相关信息。此举旨在促进不同部门和机构之间的合作和信息交流,以推动新兴技术的发展和应用。

二是咨询委员会。法案SEC.4要求署长设立一个咨询委员会,就与政策实验室的使命和职责相关的问题向署长提供咨询意见,并告知政策实验室的优先事项和项目。每年,该咨询委员会应在一个公开网站上公布一份清单,列出联邦政府内部需要改进的领域,这些领域将受益于额外的技术或技术政策专门知识。

三是职业体系。SEC.6向人事管理厅下达指令,其必须确定与人工智能相关职位所需的关键技能和能力,并且建立一个职业体系,或修改现有的职业体系,以包括与人工智能相关的主要职责的职位。

2、争议与策略

目前,美国关于人工智能监管的争论主要集中在是否需要成立一个全新的联邦机构来专门负责。OpenAI和微软支持成立一个新的监管机构,认为这有助于更系统、更全面地监管人工智能技术的发展和应用。而谷歌倾向于反对成立新机构,认为应该利用现有的机构来进行人工智能的监管。

《人工智能政策法案》旨在通过设立实验室来协调和促进联邦政府在人工智能领域的努力,强调增强已有机构的功能而非创造全新的管理机构实体。不难看出,对比欧盟采取的更为严格和全面的监管方法,美国政府在人工智能监管方面的立场仍然较为保守,强调采取非监管措施,如政策指南或框架、行业内自愿的共识标准等,而不是法律强制性措施。这种策略旨在保持技术创新的灵活性与自由,同时试图通过现有的机构和结构来应对新兴技术带来的挑战。

与联邦政府不干预的做法相反,一些美国城市已经推出了自己的措施来减轻人工智能的潜在道德危害。最近备受瞩目的例子包括旧金山弗朗西斯科2019年暂停政府使用面部识别技术,以及波特兰私营部门禁止使用相同的技术[14]。这些地方性法规的出台显示了各州在道德和安全方面的积极努力。然而,由于缺乏统一的国家法规,各州之间的标准存在巨大差距,人工智能监管力度在不同地区存在显著差异。

对中国的政策启示

2024年3月18日,中国初创公司月之暗面官宣其旗下的Kimi智能助手启动内测,该公司系2023年10月首次推出该助手,仅仅半年便成长为国内第一款AI大模型,中国本土人工智能公司迎头追上,相关鼓励与监管措施应当跟进。

(一)激励政策

人工智能大模型的算法编写、模型迭代、运行成本等每一步都需要多产业多资源配合,因此激励政策即基于人工智能模型投入运行的全过程提出。

一是鼓励大模型算法开发。对于人工智能模型而言,算法是其最根本的内核,算法的发展需要充足的技术沉淀。现阶段,国内的人工智能算法发展并不成熟,仍与世界一流水平存在差距。欧美的人工智能企业,如OpenAI、XAI,已经开始开源部分大模型算法,监管层面应当允许国内公司在保证算法安全的情况下使用国际开源的算法模型,以促进襁褓中的国内人工智能的算法迭代升级。同时,为追求算法安全,鼓励中国本土的算法发展,可以设置国家级奖金用以激励人工智能开发者。根据indeed统计的百份薪资报告为准,算法工程师年薪大约在30万元,可由国家级部委牵头,参考行业平均年薪设立激励基金,以推动国产大模型的发展。

二是建立国家级优质数据库。人工智能模型的运行需要算法,而人工智能的迭代进化则需要大量的数据。原始数据的准确性决定了产出结果的准确性,而产出结果的准确性还受到算法的影响。保障数据质量是正义的要求,保障正义能预防人工智能带来的极端分化[15]。人工智能初创企业与目前大型科技公司间最大的区别就在于获取优质数据的难易程度,大型科技公司有海量的数据可用以训练人工智能模型,而初创企业则面临获取数据数量少、质量差、成本高的困境。出于促进创新及反垄断的需要,应当建立国家统一的优质数据库,并且以低成本向人工智能初创公司开放,以发挥中国数据量庞大的优势,促进国内人工智能模型的快速迭代。

三是加大能源支持。荷兰国家银行数据科学家Alex de Vries估计,到2027年,整个人工智能行业每年将消耗85至134太瓦时(1太瓦时=10亿千瓦时)的电力,这个电量足以匹敌肯尼亚、危地马拉和克罗地亚三国的年总发电量[16]。人工智能的发展一定会消耗大量能源,为了跟上世界前沿脚步,应当对相关企业优先供能或优惠供能,在人工智能发展后期可以逐步取消这些优惠政策。人工智能发展需要能源,鼓励光伏、太阳能等清洁能源发展需要更大的市场,二者形成良性循环。

(二)监管措施

人工智能滥用的风险是不可承受的,然而过多的监管政策又会制约初创时期的人工智能发展,需要在风险与发展之间寻求公平。现阶段需要针对已出现的问题及时做出规制,同时降低执行成本,为企业减负。

一是设计用于人工智能数据监管的区块链系统,形成“数据账本”。区块链技术通过提供去中心化和防篡改的账本来安全地传输、存储和验证数据,为解决数据安全提供了强大且稳定的解决方案。[17]区块链的不变性功能通过创建无法更改或篡改的数据交易的永久记录来减轻这些风险。当数据记录在区块链上时,它被存储在网络中的所有节点上,形成一个去中心化和同步的账本。利用区块链的数据完整性,人工智能系统可以维护所用训练数据的可靠和可验证的记录,由此提供一种方法来验证AI大模型是否在准确且未篡改的数据上进行训练,此举将有力作用于数据安全、隐私权的监管。同时,区块链技术因其去中心化的不可篡改性,运行日志的记录将更加真实且可追溯,此举将提升相关部门对于AI大模型的监管效率,可及时对违反监管规则的AI模型进行查处求证。

二是为生成式人工智能的产出打上“机械水印”,以避免“以假乱真”式的误导。人工智能的生成内容愈发难以辨认,目前互联网社交媒体上已经陆续出现大量生产式人工智能产出的文字、图片、视频,其中不乏误导网民的内容。比如使用AI生成一段毫无根据的名人发表声明或接受采访的视频,极有可能在互联网上引起不利影响,误导不知情的普通网民,此类情况的根本原因在于难以辨认这些子虚乌有的生成视频。为了区分生成式内容与真实内容同时不影响生成内容的质量,给人工智能生成的文本添加标识符或是训练能够检测出人工智能生成内容的人工智能是可行的监管方案[18]。为提高识别效率,可要求生成式人工智能企业在其模型产出内容上作出一种可供电脑机器识别的水印,此水印将不影响生成内容的呈现,并且在企业将其投入至公开互联网时,投放者需要注明此内容系AI生成产品,从而为受众注明风险,保障受众的知情权、自由决定权。

三是设立专业的人工智能管理部门,建设“监管沙盒”。面对快速迭代、高不确定性的人工智能产业,设立一个专业的人工智能监管部门是必要的,当前许多人工智能算法存在黑箱操作的问题,缺乏透明度和可解释性。为增强算法透明度,同时实现准确的分级监管,“监管沙盒”是有效的措施,其本质是为了平衡科技的创新性和监管滞后性之间的矛盾[19]。作为一个基于可控环境构建而营造出的安全空间,监管沙盒营造了真实的市场环境,给予其中的主体进行迭代验证的空间及受监督的测试区域,在设立限制性条件并严防风险外溢的前提下,可以有效限制风险,并对人工智能系统进行风险等级划分,以便后续监管。[20]

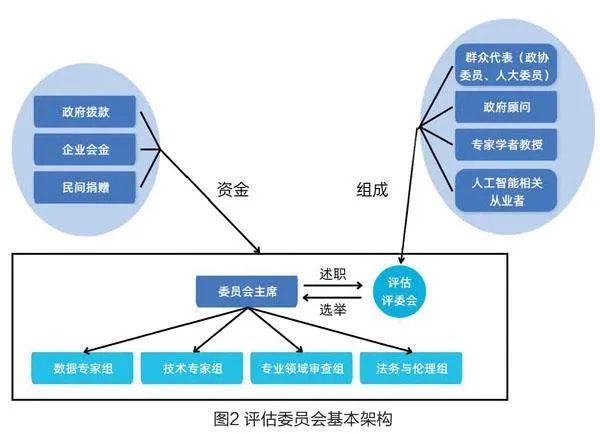

四是成立第三方评估机构,综合审查人工智能模型。建立独立的第三方评估机构对算法进行审查和评估,确保其公正性和准确性。同时,许多人工智能研究发生在大型科技公司中,这些公司通常没有适当的伦理审查流程[21],因此在行业环境中建立第三方评估机构是必要的。第三方评估机构的设计参考美国公共图书馆等级评价系统及我国慈善组织第三方评估框架[22][23],该机构应当被视为政府财政预算的“守门员”,即为了节省监督成本而对人工智能系统进行初筛,将明显不符合监管要求的AI拒之门外。

该委员会应当吸纳各个专业领域的专家学者,尤其是具有高大的学科壁垒的行业,例如医疗健康、教育、保险金融等。总之,尽管现阶段已有大量的规则对人工智能应用进行规范,但仍应当结合具体行业的要求进行更为细致的制度设计,从而将具体监管规则落地[24]。生命科学技术的高速发展常常在挑战人类伦理,因此该领域成立了许多伦理审查机构,同样在人工智能领域伦理审查组织也是不可或缺的。伦理委员会负责制定各类人工智能伦理原则和伦理指南,并根据这些原则和指南对各种机构拟开展的研究和机构用户的应用进行伦理审查。[25]

结束语

世界潮流浩浩汤汤,在人类社会的发展中,科技的重大突破往往带来整个社会的变革,人工智能的发展尤以生成式人工智能ChatGPT始,其更新迭代速度令人啧啧称奇,作为第四次工业革命的焦点,各主流国家都在积极介入AI领域。中国具有人工智能发展的后发优势,收集开源算法,迅速实现大模型的从无到有,总结已有监管模式,快速度过监管的幼稚期,寻找“规制”与“创新”的平衡点,刻不容缓。

“这里就是罗陀斯,就在这里跳吧!”

参考文献

[1]European Commission. (n.d.). Proposal for a Regulation of the European Parliament and of the Council Laying Down Harmonised Rules on Artificial Intelligence (Artificial Intelligence Act) and Amending Certain UnionLegalActs. https://artificialintelligenceact.eu/the-act/.

[2]OECD.AI. (n.d.). The OECD Artificial Intelligence (AI) principles. https://www.oecd.ai/ai-principles.

[3]European Commission's High-Level Expert Group on Artificial Intelligence.Definition of AI, 2018.

[4]《生成式人工智能服务管理暂行办法》,《中华人民共和国公安部公报》,2023(5):2-5页。

[5]IDC:Worldwide Semiannual Artificial Intelligence Tracker. 2022.

[6]邓建鹏、朱怿成:《ChatGPT模型的法律风险及应对之策》,《新疆师范大学学报(哲学社会学版)》,2023(5):91-101+2页。

[7]马长山:《AI法律、法律AI及“第三道路”》,《浙江社会科学》,2019(12):4-11+155页。

[8]Alain Duflot. Artificial intelligence in the french law of 2024. Legal Issues in the Digital Age, 2024(1):37-56.

[9]朱悦(译):《欧盟〈人工智能法〉定稿版本:全文中译本》,https://aisg.tongji.edu.cn/info/1005/1192.htm。

[10]Eleftherios Chelioudakis. Unpacking ai-enabled border management technologies in greece: to what extent their development and deployment are transparent and respect data protection rules? Computer Law amp; Security Review: The International Journal of Technology Law and Practice, 2024, 53:105967.

[11]陆婷婷:《从智慧图书馆到智能图书馆:人工智能时代图书馆发展的转向》,《图书与情报》,2017(3):98-101+140页。

[12]Thornton Rod, Miron Marina.Towards the 'third revolution in military affairs' . The RUSI Journal, 2020(3):12-21.

[13]U.S. Congress. AI in Government Act of 2018. 2018.

[14]Simonite, T. Portland's face-recognition ban is a new twist on 'smart cities'. https://www.wired.com/story/portlands-face-recognition-ban-twist-smart-cities/.

[15]李晓辉:《如何面对“无用阶层”:人工智能与未来正义》,《华东政法大学学报》,2019(6):68-77页。

[16]de Vries Alex. The growing energy footprint of artificial intelligence. Joule, 2023(10):2191-2194.

[17]Changqiang Zhang, Cangshuai Wu, Xinyi Wang. Overview of blockchain consensus mechanism. Big data Engineering, 2020:7-12.

[18]王悠然:《警惕人工智能的误导性风险》,《中国社会科学报》,2023-03-06(03)。

[19]江翠君:《浅析金融科技“监管沙盒”在我国的适用》,《中国价格监管与反垄断》,2023(2):69-72页。

[20]庞林源:《国外数据监管沙盒建设实践及启示》,《软件和集成电路》,2023(12):22-24页。

[21]Ufert F and Goldberg ZJ. How SMEs ought to operationalize AI risk assessments under the AI act. Proceeding of the workshops at the second international conference on hybrid human-artificial intelligence co-located with the second international confer ence on hybrid human-artificial intelligence, 2023.

[22]刘波、宋茂荣:《美国第三方教育评估机构治理现状与启示》,《上海教育评估研究》,2023(6):53-57+64页。

[23]任雯、李景平:《我国慈善组织第三方评估框架的理论构建》,《江苏师范大学学报(哲学社会科学版)》,2024(2):42-57+123-124页。

[24]Donnelly DustyLee. First do no harm: legal principles regulating the future of artificial intelligence in health care in south africa. Potchefstroom electronic law journal, 2022, 25.

[25]程新宇、杨佳:《人工智能时代人权的伦理风险及其治理路径》,《湖北大学学报(哲学社会科学版)》,2024(3):159-166页。

作者简介

张文康 北京化工大学文法学院本科生,研究方向为公共管理理论与实践

薛周一 昆明理工大学信息工程与自动化学院本科生,研究方向为人工智能