基于神经网络与注意力的任意图像风格迁移研究综述

2025-02-15王树声李文书

摘 要:随着神经网络的广泛应用,尤其是注意力机制的引入,风格迁移研究取得了显著进展。文章对基于卷积神经网络、注意力机制的图像风格迁移进行了综述。首先,分析了风格迁移的基本原理和传统方法,详细介绍了基于深度学习的风格迁移算法,尤其聚焦于那些通过引入注意力机制来强化模型风格表现与内容保持能力的创新方法。其次,通过比较不同算法的性能,探讨了现有方法在局部内容保留和风格控制精度方面的优点与缺点。最后,分析了任意图像风格迁移领域的发展趋势和潜在的研究方向。

关键词:图像风格迁移;深度神经网络;注意力机制;内容保留;风格化控制

中图分类号:TP391 文献标志码:A

0 引言(Introduction)

图像风格迁移旨在捕捉一幅图像的风格,并将其应用到另一幅图像上,从而在保留图像原始内容的同时,创造出具有新颖风格的视觉效果。早期的图像风格迁移方法[1-2]虽然在技术上取得了一定的突破,但是其处理图像特征只在像素层面,在一定程度上制约了风格化图像的质量与表现力。随着卷积神经网络(CNN)在图像处理领域的广泛应用与取得的显著成效,基于神经网络的图像风格迁移技术实现了质的飞跃。当前,任意风格迁移已经成为研究的前沿热点,其旨在对任何给定的风格和内容的图像进行风格转换,这要求模型具备更广泛的适用性和更细致的风格控制能力。近年来,注意力机制在自然语言处理领域取得了显著的成就,并成功迁移至图像风格迁移领域。注意力机制通过关注输入数据中的关键特征,极大地提升了风格迁移模型保留内容完整性和更准确地融合目标风格特征的能力。本文聚焦于基于注意力机制的任意图像风格迁移技术的最新进展,旨在全面审视现有技术的性能表现,并探讨当前该领域面临的挑战与未来的发展趋势。

1 图像风格迁移(Imagestyletransfer)

图像风格迁移,作为计算机视觉和图形领域的一种技术,其目的是将一幅图像的风格应用到另一幅图像上,同时保留后者的内容结构。这一过程通常涉及修改图像的颜色、纹理和形状等视觉元素,进而创造出具有新颖艺术风格的图像。尽管这一领域自20世纪末就受到研究人员的关注,但是早期的方法主要围绕特定的艺术风格而设计,难以扩展到其他风格。由于技术水平的限制,彼时的风格迁移方法只能处理笔触、纹理等低级图像特征。随着深度学习技术的兴起,尤其是GATYS等[3]利用卷积神经网络所取得的开创性成果,图像风格迁移效果获得巨大提升。此后,这一领域快速发展,众多研究者纷纷提出了不同的算法和技术,致力于提升风格迁移的质量、速度及多样性。

图像风格迁移经历了从传统方法到深度学习,再到生成模型的逐步演进,见证了技术的不断飞跃。深度学习的方法为风格迁移领域提供了一种强大的特征提取机制,使得模型能够更好地理解和抓取内容与风格之间的复杂关系。当前,图像风格迁移研究聚焦于任意风格迁移,即在不限定特定风格的情况下进行风格迁移,其挑战在于如何设计出能够灵活适配多种风格,并且在保持内容完整性的同时实现风格的高效转换的算法。在此背景下,注意力机制凭借其独特的优势,逐渐在图像风格迁移领域崭露头角。本文将主要关注基于神经网络和注意力机制的图像风格迁移方法,解析其原理,评估其性能,并探讨其相较于传统方法的优势及未来可能的改进方向。

1.1 卷积神经网络的应用

卷积神经网络(ConvolutionalNeuralNetwork,CNN)通过模拟人类视觉系统的工作原理,能够自动地学习图像中的层次化特征。与传统的全连接神经网络不同,CNN结合了卷积层和池化层,实现了对输入数据的局部特征提取。在风格迁移任务中,CNN通过不同层次的激活函数来区分图像的风格和内容。通常,网络较浅层次的特征负责捕捉图像的风格,如纹理、颜色等;而较深层次的特征则捕捉图像的内容,即形状、结构等。这一特点使得CNN特别适用于图像风格迁移任务。

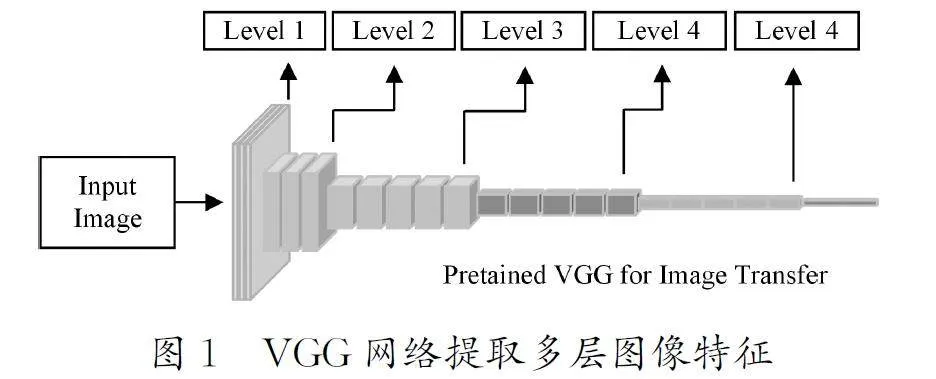

GATYS等[3]的研究验证了使用预训练的VGG(VisualGeometryGroup)网络提取输入图像特征的有效性,为后续研究奠定了坚实基础。通常,使用预训练的VGG-19网络提取图像特征,并按网络池化层的深度将中间特征分为5级,VGG网络提取多层图像特征如图1所示。

GATYS等[3]开创性地提出基于优化迭代的神经风格迁移。后续的方法按照对图像特征的处理方式大致可以分为两类:基于图像优化迭代的方法和基于模型生成的方法。这些方法在技术上各有侧重,但其共同目标是在实现图像风格化的同时,保持其内容的完整性。

1.2 基于图像迭代的方法

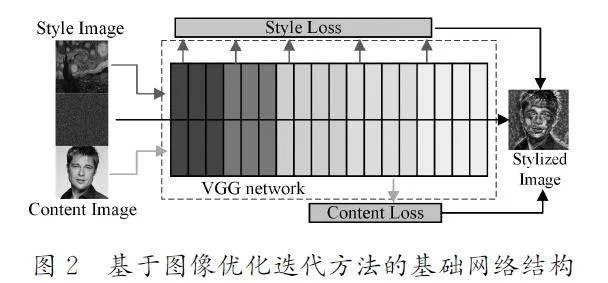

用基于图像优化迭代的方法来定义图像特征的损失函数,如在特征空间中迭代优化一张噪声图像并求解最小损失,在迭代过程中,噪声图像逐渐接近期望的风格与内容。基于图像优化迭代方法的基础网络结构如图2所示。

GATYS等[3]提出使用格拉姆矩阵计算图像特征的损失并表征与构建图像风格。该方法使用Gram 矩阵G(Fs)=[Fs][Fs]T 计算噪声图与给定图像之间的风格差异:

L=αΣ‖Fl(Ic)-Fl(I)‖2+βΣ‖G(Fl(Is))-G(Fl(I))‖2 (1)

对于给定内容图像Ic 和样式图像Is,在迭代中以最小化损失函数求解风格化图像:

I* =argIminL(Ic,Is,I) (2)

LI等[4]证明了使用二次多项式核来最小化风格间的最大均值差异,其效果等同于匹配格拉姆矩阵,从而证明如线性核、多项式核等用于计算最大均值差异的核函数也可用于图像风格迁移。为了进一步提升风格化的效果,研究者们还额外引入了多种损失函数如直方图损失、拉普拉斯损失[5]等,这些损失函数的融入使得风格迁移的结果既保持了内容的一致性,又使得风格特征更加鲜明、细腻。

在探索风格控制和高分辨率图像风格迁移方面,研究者们取得了显著进展。例如,GATYS等[6]提出由粗到细的图像优化方法,有效解决了高分辨率图像的风格迁移;JING等[7]尝试将样式特征映射到不同尺度,以实现笔触控制;CASTILLO等[8]尝试引入语义分割,以更好地控制样式转移。

虽然基于图像迭代的风格迁移方法已经能生成良好视觉效果的风格化图像,但是其对每幅图进行风格化时,需从噪声图开始重新进行优化迭代。这一过程不仅会耗费大量的计算资源,而且会在优化过程中陷入局部最小值,导致风格化效果不理想,难以在真实场景中应用。

1.3 基于模型生成的方法

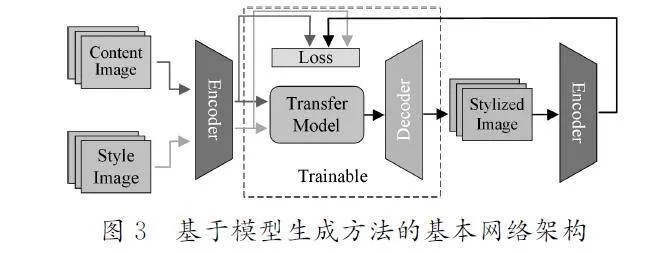

为提升图像风格迁移的速度与风格迁移网络的泛化能力,当前的研究趋势转向使用大规模数据集训练图像转换网络,其核心在于优化模型参数而不是优化图像本身。JOHNSON等[9]和LI等[10]使用MicrosoftCOCO[11]数据集作为模型的训练数据,验证了这种方法的可行性。基于模型生成的方法通常使用输入图像与风格化图像的特征计算损失函数,训练出的转换模块和解码器在风格化推理中不需要被更新。基于模型生成方法的基本网络架构如图3所示。

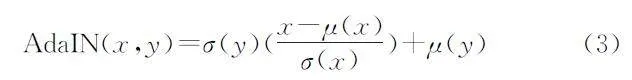

为了提升基于模型迭代的方法在风格化时的效率,HUANG等[12]提出一种基于自适应规范化(AdaIN)层的风格迁移模型。该方法对下采样的内容与风格特征进行自适应规范化操作:

其中,σ 和μ 分别代表传入图像特征的通道级标准差、方差。这种方法能直接处理图像的全局信息,效率较高,但存在局部信息丢失的问题。

LI等[10]的研究发现通过一对白化、彩化的变换(WCT),可以在保留图像结构的同时,去除图像风格并进行重建。该方法使用WCT操作替代AdaIN(自适应规范化)层,并将风格的传递扩展到编解码器的多个层级。

SHENG等[13]在多尺度上使用风格装饰器,在成功匹配图像整体特征分布的同时,还可以由深到浅地将更匹配的特征块迁移到目标图像上。

在风格迁移领域,研究者们不断在现有方法的基础上进行改进,以追求功能的增强或效率的提升。例如,LI等[14]提出将神经风格转移的问题建模为编码内容特征和学习的变换矩阵之间的线性变换,以降低模型的计算资源消耗;李文书等[15]使用高斯采样的匹配提升图像的风格化程度;WANG等[16]尝试使用模型蒸馏技术提取轻量级转换网络,以提升风格迁移速度。

1.4 注意力机制的应用

传统的图像风格迁移方法已经能实现较好的风格化效果,但在图像内容结构保持、特征语义匹配等方面仍有不足。注意力机制的引入为风格迁移领域的研究带来了全新的突破和活力

意力机制的思想是在深度学习中模拟人类注意力聚焦的特性,允许模型在处理信息时能够关注数据最重要的部分,从而提高模型的处理能力与最终效果。这一机制通过训练得到一个动态的权重分布,该分布精准地指导模型在数据处理过程中应“重点关注”哪些内容。注意力机制最初在自然语言处理(NLP)中广泛应用,其引导重要特征聚集的思想随后被引入计算机视觉领域、语音识别等领域。

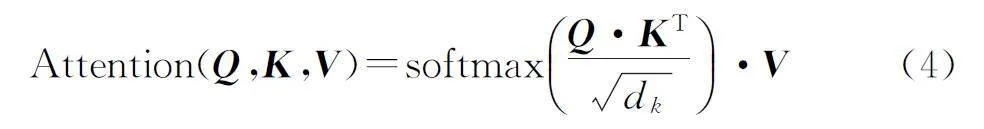

在图像风格迁移领域,注意力机制按其关注的信息来源、范围不同,可以分为自注意力、交叉注意力和多头注意力等。注意力机制的基本实现方式可表示为

其中:Q、K、V 分别代表注意力机制的3个核心组件,即查询、键和值;softmax(·)为归一化函数;dk 为键向量的维度。计算查询Q 和所有键K 之间的对齐分数,通常会除以一个缩放因子根号下dk ,以避免梯度消失问题;经过归一化后,得到的注意力权重与值进行加权求和,最终的输出可以反映不同值对于查询的重要性。根据注意力机制在不同风格迁移方法中的侧重,Q、K、V 与注意力图的计算方式有不同变体,但其核心思想是利用输入图像的特征引导网络更好地平衡风格化图像的内容结构与风格。

1.5 基于注意力机制的方法

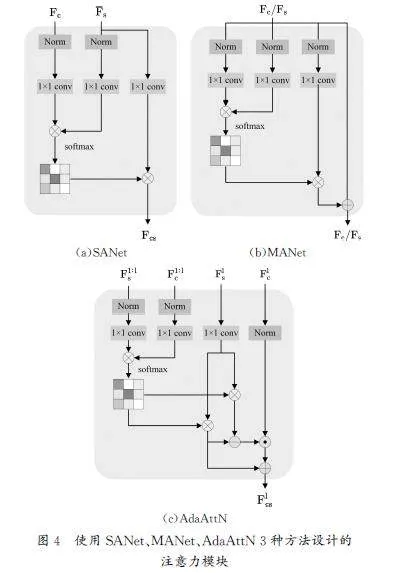

PARK等[17]率先将注意力机制用于图像风格迁移任务,提出基于注意力的网络(SANet),它将内容图像、风格图像的通道特征均值作为查询、键,风格特征作为值,从而构建注意力机制。该操作实现了用VGG网络抽取深层特征,改善了风格化图像的结构保留效果,为后续的研究提供了基础与灵感。分别使用SANet、MANet、AdaAttN3种方法设计的注意力模块如图4所示。

YAO等[18]将不同大小的感受区域视为图像风格的笔触,并使用自注意力机制引导不同笔触层次的特征交换。该方法能更好地捕捉图像中的细节和复杂纹理,实现了更加细腻的图像风格迁移效果。

DENG等[19]提出一种多级自适应网络(MANet),该方法在风格图像上使用通道间注意力、在内容图像上使用空间注意力,并设计了一个模块,用于融合解构图像特征。该方法通过对两幅输入图像做自注意力,增强对图像特征的分离效果,并设计解纠缠损失函数以引导更准确的特征匹配。

LIU等[20]受注意力机制与AdaIN[12]中自适应归一化内容的启发,提出自适应注意力归一化(AdaAttN),在注意力计算中同时考虑不同深度的图像特征,并添加可学习的卷积层自适应归一化内容特征。该方法改善了传入图像的低级特征匹配,改善了风格化效果。

LUO等[21]改进了计算注意力图之后的对齐方式,提出特征注意力流形对齐框架(PAMA)。该方法使用的注意力机制在计算注意力分数后,使用空间插值模块改变重新排列特征分数,并在串联的3个对齐模块中逐渐对齐不同层次的图像特征。

ZHU等[22]重新考虑注意力机制的作用,认为单一的逐像素计算的注意力分数会导致在特征对齐时单一风格特征的堆积,提出全键注意力风格迁移。该方法在不同颗粒度上构建注意力,将注意力查询中被匹配的特征分布到全特征空间,以推动网络为内容结构匹配更合适的风格特征。

还有一些方法在模型架构、损失函数方面有调整,例如PENG等[23]尝试简化AdaAttN[20]的结构,并引入直方图损失以改善风格化图像的色彩;YU等[24]提出协方差注意力网络与对比学习,用于鼓励风格化图像获得空间语义上更匹配的特征。

2 对比与分析(Comparisonandanalysis)

2.1 方法评价标准

评价任意图像风格迁移技术性能的标准通常包括以下几个方面:评价产生的图像是否具有高质量的视觉美感,包括风格的准确传达和内容的保留程度;衡量风格迁移的结果是否在保留内容的同时成功融合目标风格;评估风格迁移算法执行的速度和计算效率;评估在面对图像的不同质量和复杂性时的稳定性。为

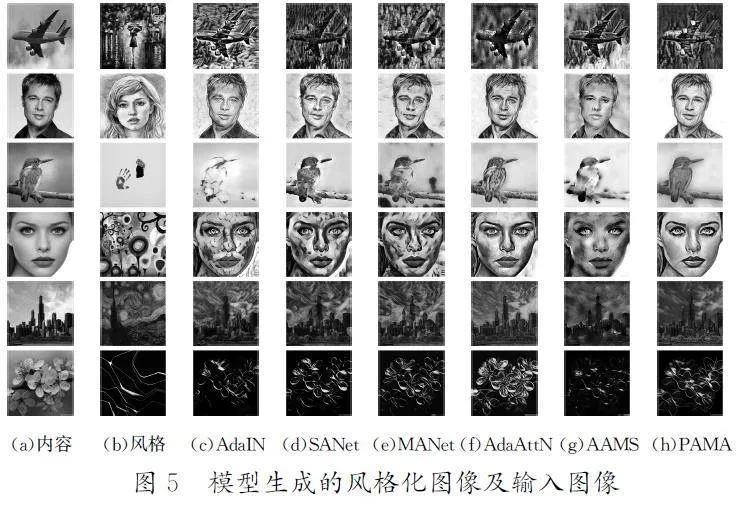

为了更全面地评估与对比现有的图像风格迁移技术,研究人员选择图像风格迁移经典方法AdaIN(AdaptiveInstanceNormalization)以及SANet(Style-AttentionalNetworks)、MANet(Multi-Adaptation Network)、AdaAttN(Adaptive AttentionNormalization)、AAMS(Attention-aware Multi-strokeStyleTransfer)、PAMA(ProgressiveAttentionalManifoldAlignment)5种最新的基于注意力的图像风格迁移方法进行实验。进行定性分析时,根据风格化程度、局部结构保留等方面进行主观评价。进行定量分析时,记录不同方法在运行时的资源消耗,并计算使用风格特征与原始内容结构的结构相似度(StructuralSimilarity,SSIM),其计算公式为

SSIM (x,y)= (2μxμy +k1)(2σxy +k2)/(μ2x+μ2y+k1)(σ2x+σ2y+k2) (5)

2.2 实验与分析

选定一组512×512分辨率的图像对,在单张NvidiaRTX1080Ti显卡上对选定模型进行对比实验。内容图像选自MicroSoftCOCO数据集,风格图像选自Wiki-Art数据集,它们在色彩复杂度、内容复杂度方面具有代表性。模型生成的风格化图像及输入图像如图5所示。

从图5中可以看出,相比于传统方法,基于注意力机制的几种方法在内容结构保持与风格化效果方面取得了较大的进步,但仍存在一些问题。在风格图像特征上使用了自注意力机制的SANet未在多层次上考虑内容结构与风格特征的适配性,面对复杂图像时易出现结构扭曲。MANet率先尝试多级自适应的网络结构,但其设计的特征融合算法在风格化时偏向风格特征,在一些局部可以实现别具一格的风格化效果,但在结构、风格语义不一致的区域可能出现局部扭曲与伪影。PAMA尝试在图像特征数据流中多次逐渐匹配特征,具有良好的结构保持能力,但风格化程度较弱,仅展现出了颜色方面的变化。AdaAttN在多级特征上结合全局自适应特征匹配和自注意力机制,并在进行风格注意力图计算时引入浅层的图像特征,风格化效果较好,但在面对局部特征相似但语义不相似的特征时,会引起不适合的特征堆积。

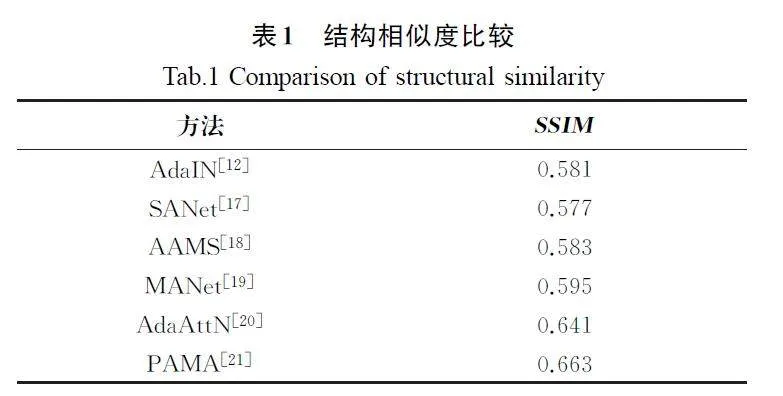

表1呈现的是图5中风格化图像与内容原图之间结构相似度的计算结果。从表1中数据可以看出,当前的基于注意力机制的图像风格迁移方法在内容图像结构保留方面相比于传统方法有较好的进展,在风格特征与内容结构的平衡方面也取得了显著的进步。

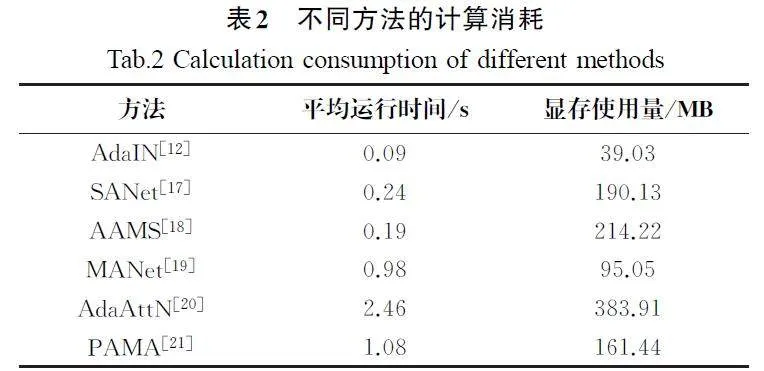

不同方法的计算消耗见表2。AdaIN基于参数统计,没有使用注意力机制,具有最小的计算资源占用。AdaAttN在多级特征上采用了更复杂的注意力机制,导致计算过程更为密集,尽管能提供较好的风格迁移效果,但是其高显存使用量和长运行时间,可能限制其需要快速响应的应用。其余方法在资源占用与风格化效果方面的表现较为均衡。

总体而言,当前基于注意力机制的方法可以较好地实现任意风格迁移任务,在保留内容结构的同时获得了较好的视觉效果。在面对极端输入图像时,现有方法仍存在结构扭曲与伪影问题。同时,现有方法在计算时资源占用适中,可以满足图像风格迁移在现实场景中的应用。

3 结论(Conclusion)

本文围绕卷积神经网络与注意力机制,对20余种图像风格迁移方法展开研究。首先,根据图像风格迁移任务技术的发展,将其归纳为4类方法,并分析各自的原理与优点。其次,深入研究最新的基于注意力方法的实现机制并进行实验对比。分析发现,结合卷积神经网络与先进注意力机制的方法能够捕捉和重现风格图像细节,并且不会破坏图像内容的完整性,在任意风格迁移领域展现出了巨大的潜力,但在面对语义与内容复杂程度差异较大的输入图像对时,难以保持风格特征与内容结构的平衡。同时,当前的研究还面临着处理高分辨率图像时的计算成本高和模型泛化能力有限等问题。未来的研究需探索更具泛化性与可控性的算法,并尝试降低计算成本,进一步提升图像风格迁移的质量。

参考文献(References)

[1]JING YC,YANG YZ,FENGZL,etal.Neuralstyletransfer:areview[J].IEEEtransactionsonvisualizationandcomputergraphics,2020,26(11):3365-3385.

[2]朱文浩,魏宝刚.基于样本的纹理合成技术综述[J].中国图象图形学报A,2008,13(11):2063-2069.

[3]GATYSL A,ECKER A S,BETHGE M.Imagestyletransferusingconvolutionalneuralnetworks[C]∥IEEE.Proceedingsofthe2016IEEEConferenceonComputerVisionandPatternRecognition.LosAlamitos:IEEE,2016:2414-2423.

[4]LIYH,WANGNY,LIUJY,etal.Demystifyingneuralstyletransfer[C]∥AAAIPress.ProceedingsoftheInternationalJointConferenceonArtificialIntelligence.PaloAlto:AAAI,2017:2230-2236.

[5]LISH,XUXX,NIELQ,etal.Laplacian-steeredneuralstyletransfer[C]∥ACM.Proceedingsofthe25thACMInternationalConferenceonMultimedia.NewYork:ACM,2017:1716-1724.

[6]GATYSLA,ECKERAS,BETHGEM,etal.Controllingperceptualfactorsinneuralstyletransfer[C]∥IEEE.ProceedingsoftheIEEE2017ConferenceonComputerVisionand Pattern Recognition.Los Alamitos:IEEE,2017:3985-3993.

[7]JINGYC,LIU Y,YANGYZ,etal.Strokecontrollablefaststyletransferwithadaptivereceptivefields[C]∥Springer.Proceedingsofthe European ConferenceonComputerVision.Heidelberg:Springer,2018:244-260.

[8]CASTILLOC,DES,HANX,etal.Targetedstyletransferusinginstance-awaresemanticsegmentation[C]∥IEEE.ProceedingsoftheIEEEInternationalConferenceonAcoustics,Speech,andSignal.Piscataway:IEEE,2017:1348-1352.

[9]JOHNSONJ,ALAHIA,LIFF.Perceptuallossesforrealtimestyletransferandsuper-resolution[C]∥Springer.ProceedingsoftheEuropeanConferenceonComputerVision.Heidelberg:Springer,2016:694-711.

[10]LIYJ,FANGC,YANGJM,etal.Universalstyletransferviafeaturetransforms[C]∥MITPress.ProceedingsoftheInternationalConferenceon NeuralInformationProcessingSystems.Cambridge:MIT,2017:386-396.

[11]LIN T Y,MAIRE M,BELONGIESJ,etal.MicrosoftCOCO:commonobjectsincontext[C]∥Springer.ProceedingsoftheEuropeanConferenceonComputerVision.Heidelberg:Springer,2014:740-755.

[12]HUANG X,BELONGIES.Arbitrarystyletransferinreal-timewithadaptiveinstancenormalization[C]∥IEEE.ProceedingsoftheInternationalConferenceonComputerVision.LosAlamitos:IEEE,2017:1510-1519.

[13]SHENGL,LINZY,SHAOJ,etal.Avatar-Net:multiscalezero-shotstyletransferbyfeaturedecoration[C]∥IEEE.ProceedingsoftheIEEEConferenceonComputerVisionand Pattern Recognition.Los Alamitos:IEEE,2018:8242-8250.

[14]LIX,LIUS,KAUTZJ,etal.Learninglineartransformationsforfastarbitrarystyletransfer[C]∥IEEE.ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.LosAlamitos:IEEE,2019:3809-3817.

[15]李文书,赵朋,尹灵芝,等.基于高斯采样的区域多元化图像风格迁移方法[J].计算机辅助设计与图形学学报,2022,34(5):743-750.

[16]WANGH,LIYJ,WANGYH,etal.Collaborativedistillationforultra-resolutionuniversalstyletransfer[C]∥IEEE.ProceedingsoftheIEEE/CVFConferenceonComputerVisionandPattern Recognition.Los Alamitos:IEEE,2020:1857-1866.

[17]PARKDY,LEEKH.Arbitrarystyletransferwithstyleattentionalnetworks[C]∥IEEE.ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.LosAlamitos:IEEE,2019:5880-5888.

[18]YAOY,RENJQ,XIEX,etal.Attention-awaremultistrokestyletransfer[C]∥IEEE.ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition.LosAlamitos:IEEE,2019:1467-1475.

[19]DENGYY,TANGF,DONGW M,etal.Arbitrarystyletransferviamulti-adaptationnetwork[C]∥ACM.ProceedingsoftheInternationalConferenceonMultimedia.NewYork:ACM,2020:2719-2727.

[20]LIUSH,LINTW,HEDL,etal.AdaAttN:revisitattentionmechanisminarbitraryneuralstyletransfer[C]∥IEEE.ProceedingsoftheIEEEInternationalConferenceonComputerVision.LosAlamitos:IEEE,2021:6649-6658.

[21]LUO X,HAN Z,YANG L K,etal.Consistentstyletransfer[J/OL].(2022-07-16)[2022-07-16].https:∥arxiv.org/abs/2201.02233.

[22]ZHU MR,HEX,WANGNJ,etal.All-to-keyattentionforarbitrarystyletransfer[C]∥IEEE.ProceedingsoftheInternationalConferenceonComputerVision.LosAlamitos:IEEE,2023:23109-23119.

[23]PENGHY,QIAN W H,CAOJD,etal.Arbitrarystyletransferbasedonattentionandcovariance-matching[J].Computersamp;graphic,2023,116:298-307.

[24]YUXM,ZHOUG.Arbitrarystyletransferviacontentconsistencyandstyleconsistency[J].Thevisualcomputer,2024,40(3):1369-1382.

作者简介:

王树声(1999-),男(汉族),金华,硕士生。研究领域:图像处

李文书(1975-),男(汉族),杭州,教授,博士。研究领域:图像