基于多分支增强和融合注意力机制的水下图像增强算法

2025-01-25姚斌韩典芝徐轩李婉

摘 要:由于水对光的折射和吸收,水下图像通常会出现严重的退化,如色偏、模糊、能见度低等.为了提高水下图像的可视性,提出了一种基于多分支增强和融合注意力机制的水下图像增强网络MBFA-GAN.首先,通过分析水下图像的色彩退化和模糊因素,设计了青品色温修复模块和模糊恢复模块对水下图像进行色彩矫正和模糊恢复.然后,基于对多个分支特征的互补性考虑,采用循环合并策略将多个分支增强的特征利用自适应融合模块进行融合,逐步增强图像细节.最后,设计了融合注意力模块,用于深度挖掘图像在通道维度和像素维度的相关性矩阵,以提高增强图像的真实性.实验结果表明,与现有算法相比,提出的水下图像增强算法去模糊效果较好且颜色更真实,可以有效改善水下图像色偏和模糊的问题.

关键词:水下图像增强; 多分支增强; 融合注意力; 生成对抗网络

中图分类号:TP391.4

文献标志码: A

Underwater image enhancement algorithm based on multi-branch enhancement and fusion attention mechanism

YAO Bin, HAN Dian-zhi, XU Xuan, LI Wan

(School of Electronic Information and Artificial Intelligence, Shaanxi University of Science amp; Technology, Xi′an 710021, China

)

Abstract:Due to the refraction and absorption of light by water,underwater images are often severely degraded,such as color deviation,blurring and low visibility.In order to improve the visibility of underwater images,an underwater image enhancement network MBFA-GAN based on multi-branch enhancement and fusion attention mechanism is proposed.Firstly,by analyzing the color degradation and blur factors of underwater images,a color temperature repair module and a blur recovery module are designed for color correction and blur recovery of underwater images.Then,considering the complementarity of multiple branch features,the cyclic merging strategy is used to fuse the features enhanced by multiple branches with adaptive fusion module to gradually enhance the image details.Finally,a fusion attention module is designed to deeply mine the correlation matrix in channel dimension and pixel dimension to improve the authenticity of enhanced images.The experimental results show that compared with the existing algorithms,the proposed underwater image enhancement algorithm has better deblurring effect and more real color,and can effectively improve the problem of underwater image color deviation and blurring.

Key words:underwater image enhancement; multi-branch enhancement; fusion attention; generative adversarial network

0 引言

水下成像在海洋科学考察、水下机器人和水下信息搜集等领域扮演着至关重要的角色.然而,光线的选择性吸收经常会导致水下图像的颜色失真,同时光线散射容易导致图像细节模糊和低对比度.为了解决这些问题,很多文献已经提出了不同类型的水下图像增强(Underwater Image Enhancement,UIE)方法.早期阶段出现的基于硬件的水下图像增强方法利用多张图像或偏振成像来提高水下图像的清晰度[1].然而,这些复杂设备难以捕捉图像序列.基于非物理模型方法不依赖水下成像物理模型,而是通过调整图像的像素值和局部特征来提高其视觉感知效果.具有代表性的方法包括基于Retinex理论的方法[2,3]、基于直方图均衡的方法[4-6]和基于图像融合的方法[7-9].例如,Ancuti等[10]提出了多尺度策略,并将其融合白平衡颜色校正和对比度增强方法来进行水下图像的增强.这种方法往往缺乏对复杂多变的水下成像物理过程的深入理解,可能会引入颜色失真、图像伪影或过度曝光等问题.基于物理模型的方法通过水下成像的先验知识估算出水下成像的物理模型参数,并利用逆向计算或矫正来恢复清晰的水下图像,如:自适应衰减曲线算法[11]、雾霾线先验算法[12]、水下暗信道先验算法[13]、模糊先验算法[14]、最小信息损失[15]等.例如,Berman等[16]引入了一个雾霾线模型来处理波长相关的衰减和重建水下图像.Akkaynak等[17]基于水下依赖性修改了水下成像模型.这些基于物理模型的方法虽然实现了一定程度的图像恢复,但过度依赖水下场景先验知识,只能对已知的物理参数进行建模和处理,无法处理其他未知的影响因素,如噪声、背景杂波等,对水下图像增强效果有待提升.

随着深度学习方法在图像处理领域的广泛应用,一些学者提出利用基于深度学习中强大的监督学习模型来进行水下图像的增强.Li等[18]提出了一种基于GAN的监督算法用于水下图像颜色校正,称为UWGAN.它具有循环结构,包括前向和后向网络来提取图像集的独特特征.此外,Li等[19]提出了一个在他们构建的水下成像改进数据库上训练的门控融合卷积神经网络(CNN)方法,融合生成对抗网络[20]可以接受多个输入,这些输入可以通过网络中的不同路径传递.Cao等[21]提出了一种基于经典恢复方法的图像恢复深度网络.Sun等[22]提出了一个pixel-to-pixel的网络,主要由对称的编码器-解码器网络组成,使用包含三个卷积层的编码器来过滤噪声,并且包含三个反卷积层的解码器来逐个像素地完善图像.邓步等[23]提出一种新颖的基于声呐信息融合的水下图像增强方法,利用声呐采集得到的信息与光学图像进行融合,实现图像增强.邱皖等[24]提出了一种基于非监督超分辨重构的方法(SR-CycleGAN)对水下图像进行增强,该方法采用超分辨网络和退化网络学习水下图像和陆地图像之间的跨域映射函数,提高了模型识别的准确率.基于深度学习的方法虽然都能够对水下图像的质量有所提升,但在一些异常情况下,如极端光照和强烈散射下,这些方法对色偏矫正和模糊恢复的处理能力有限,鲁棒性不强,存在一定的局限性.另外,这些深度学习方法在不同的水下场景和条件下,模型的表现可能有较大差异.这意味着训练得到的模型在一个特定场景下可能效果很好,但在其他场景下可能表现不佳,泛化能力较差.

本文对现有的水下图像增强算法进行了深入的分析,提出了一种基于多分支增强和融合注意力机制的水下图像增强网络(Multi-Branch and Fusion Attention GAN),称为MBFA-GAN.提出的MBFA-GAN探索了水下图像的颜色校正和对比度提升方法,构建并加入了融合注意力机制,在水下图像增强效果上表现良好.

本文方法的主要贡献如下:

(1)针对水下图像色偏严重以及模糊导致的低对比度问题,提出了多分支增强模块(Multi-Branch Enhancement,MBE).该模块主要包含四个模块:青品色温修复模块、模糊恢复模块、残差辅助模块、自适应融合模块.通过手动设计的多分支增强模块,该方法在恢复具有生动外观和实质内容的图像方面更为有效.

(2)为了进一步增强图像细节以及实现多个特征的合理融合,构建了一个融合注意力模块(Fusion Attention,FUA).通过计算通道维度和像素维度的相关性矩阵,并根据不同的潜在结果自适应地强调信息部分,以有效地提高网络在细节和阴影恢复方面的性能.

(3)进行了不同的实验以评估提出的MBFA-GAN的性能.定性和定量的结果证明了提出的方法在颜色校正、对比度提高和模糊恢复方面十分有效,对水下图像有较好的增强效果.

1 MBFA-GAN网络结构

针对现有方法存在的问题,本文提出了基于多分支增强与融合注意力机制的水下图像增强网络.网络设计过程中,增强结果需要同时考虑色差和模糊度.色差意味着不同的颜色偏移,而模糊度代表着图像的浑浊程度和对比度.因此,MBE模块整合多个分支潜在特征的方式决定了增强结果.对此,所提出的方法采用数据驱动的方式有目的地学习这两个退化特性.

本文通过设计的青品色温修复模块对色偏图像进行矫正并且提取特征,并通过模糊恢复模块和残差辅助模块对图像细节进行了完整的保留和有效恢复.随后将原始图像、模糊恢复模块和残差辅助模块输出的潜在特征放入自适应融合模块之中进行循环融合计算,再利用设计的融合注意力模块强调水下图像光照特征和颜色信息的相关性,平衡不同区域的光照情况.所提出的MBFA-GAN网络结构如图1所示.

此外,网络中引入了融合注意力(FUA)机制,通过考虑多个特征之间的关联性,将它们进行加权组合,生成特异性权重,并表征通道域和空间域中的相互依赖性,从而更好地捕捉水下图像中的重要信息.这样,可训练的权重映射可以自适应地强调来自不同模块的信息特征,并实现它们的合理融合.

1.1 生成器

本节将描述针对水下退化图像设计的多分支增强网络,包括所提出的MBFA-GAN的体系结构设计和各个模块的实现细节.

1.1.1 青品色温修复模块

由于光的吸收和折射,水下图像的色彩退化现象不可预测,水下图像会产生严重的色彩偏移.需要注意的是,水下图像的RGB空间值会以非线性的方式衰落,故现有的一些基于白平衡的颜色矫正算法直接应用于色偏图像会存在过度补偿和补偿不足等问题.针对上述问题,本文使用双解码器的U-Net架构对原始分辨率图像进行网络模块搭建,而不是使用传统的颜色通道补偿算法来矫正色偏.

提出的青品色温修复模块如图2所示.该模块使用了U-Net架构,并且在编码器和解码器之间引入了多尺度跳跃连接.它由两个主要单元组成:首先是一个4级编码器单元,负责提取输入图像的多尺度潜在特征;解码器单元采用了双解码器架构,包括了两个5级解码器,用以完成特征重建.其中,4级编码器的卷积核数量分别为24、48、96、192,各个解码器分支的卷积核分别为384、192、96、48、24.

使用双解码器的目的是通过两个不同分支来分别负责渲染青色温和品红色温的输出图像.为了模拟复杂的水下环境,需要在渲染的青色温图像和品红色温图像之间进行插值,以输出在视觉上令人满意的图像.实验中发现简单的线性插值对于矫正水下图像色偏是足够的,表述如下:

Icorrect=a×Dcy(fla)+(1-a)×Dmag(fla)

(1)

式(1)中:Icorrect是符合大脑皮层视觉感知美学的渲染结果,fla表示从共享编码器单元获得的潜在特征,Dcy和Dmag分别表示双解码器的青色温分支和品红色温分支.a是插值比,通过大量实验表明,a设为0.4具有较好的视觉效果.

这样,提出的MBFA-GAN通过青品色温修复模块对水下图像进行了重新渲染.模块中每个网络单元都有一个不同的瓶颈层和反卷积层.其中,瓶颈层的作用是将共享编码器中的输入数据进行降维压缩,然后再将其恢复到原始维度.这种压缩和恢复的过程有助于模块学习到数据的有效表示,并且可以降低计算成本.另外,提出的青品色温修复模块能够动态地调整退化的水下场景的图像色温,以消除各种波长的吸收,并促进水下场景的真实映射.

1.1.2 模糊恢复模块

所提出的模糊恢复模块如图3所示.该模块的目的是从模糊的水下图像中提取用于恢复清晰水下图像的潜在特征.

该模块使用非对称残差编解码器架构来扩大感受野.编码器由三个尺度组成,每个尺度有一个残差组[25],前两个残差组之后是一个步长卷积层,对特征图下采样1/2倍.该解码器有两个反卷积层,以恢复特征图的空间分辨率.最后,模块使用两个额外的卷积层来重建一个清晰的图像.其中,δblur表示解码器的输出特征,它们被输入到多分支自适应融合模块中进行特征融合.

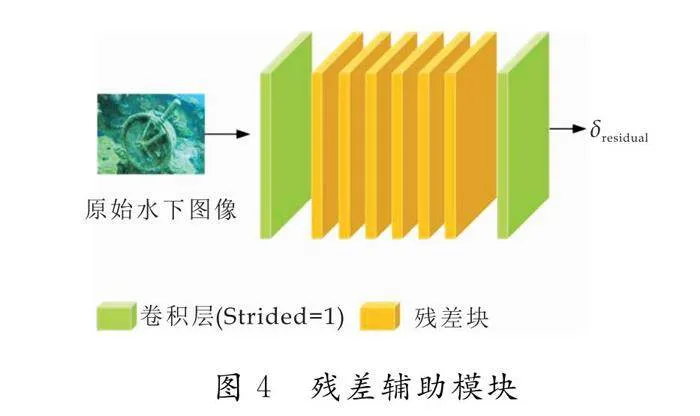

1.1.3 残差辅助模块

为了更好地从水下图像中提取基本特征和高级特征,提出的MBFA-GAN设计中引入了残差辅助模块.该模块使用8个残差块,如图4所示.为了保留空间信息,该模块不使用任何池化或步长卷积层.其中,δresidual来表示提取的基本特征.

1.1.4 自适应融合模块

考虑到多个独立分支的互补性,本实验通过学习一个自适应融合模块来自适应地合并模糊恢复的特征、色彩矫正的特征以及基本特征.该模块可以有效挖掘多模态融合的重要特征,更好的增强图像细节.本实验采用一种循环合并策略来逐步融合这些特征,如图5所示.

每个融合子模块由一个连接层,两个卷积核大小分别为3×3和1×1的卷积层,以及两个卷积层之间的一个改进的线性整流函数(LeakyReLU)组成.第一个融合子模块δmerge以δblur、δresidual 和水下图像Iraw作为输入,并生成像素级权值映射.融合的特征可以表述为式(2):

δmerge=δblurFmulti(δblur+Iraw+δresidual)+δresidual

(2)

随后,该模块使用串联式链接k个融合子模块,其中每个子模块作用相同,旨在自适应地将恢复的特征δblur合并到主分支δmerge.后续模块的融合特征可以表示为式(3):

δnmerge=δblurFmulti(δblur+Iraw+δn-1merge)+δn-1merge

(3)

这些参数在子模块之间共享,前一个块的δn-1merge输出将作为下一个块的输入,其中n=2,……,k.

1.1.5 融合注意力模块

在提出的MBFA-GAN中,来自不同模块的潜在结果对提高水下图像的质量有不同的贡献.如果简单地将这些结果串联或线性组合地结合起来,缺乏调节各个特征权重的灵活性.为了将颜色矫正后的潜在结果和多分支融合增强后的潜在结果更加有效地结合起来,网络中接入了融合注意力模块(FUA).该模块对现有的CBAM混合注意力模块[26]进行了改进,以自适应地强调不同结果中的信息区域.提出的FUA架构如图6所示.

首先,将多个模块增强后的潜在特征输入到密集块中,用以提取浅层特征,随后对这两个特征进行了concat操作,连接后的特征图M可以表示为:

M=concat(Icorrect,δnmerge)

(4)

随后,把特征图M输入到融合注意力模块中,在通道维度和空间维度对这些特征进行相关性矩阵计算,公式如下:

M*=FCA(M)FPA(M)M

(5)

式(5)中:FCA(M)代表通道注意力机制的输出,FPA(M)代表像素注意力机制的输出,M*代表融合注意力的输出.

所提出的FUA融合了通道注意力和像素注意力.通道注意力能够自动学习每个通道的重要性权重,并对不同通道的特征进行加权,这使得网络能够更加关注有帮助的特征通道,从而提升模型的表达能力和性能.像素注意力中的注意矩阵用于模拟特征中任意两个像素之间的空间关系,使每个像素点能够关注自身的重要性并获得相应的权重,从而实现对特征图中的每个像素点加权融合.实验表明,所提出的融合注意力模块有助于解决传统CBAM级联连接时两种注意力之间的相互干扰问题.两个并行注意模块可以直接学习青品色温修复模块和自适应融合模块的输入特征图,无需关心像素注意和通道注意的顺序,并将特征之间的关系结合起来形成更全面的表示.

通道维度的自注意力学习可以表示为:

FCA(M)=σ(FMLP(Pavg(M))+FMLP(Pmax(M)))=

σ(W1(W0(MCAavg))+W1(W0(MCAmax)))

(6)

像素维度的自注意力学习可以表示为:

FPA(M)=σ(Conv[Pavg(M);Pmax(M)])=

σ(Conv([MSAavg;MSAmax]))

(7)

式(6)、(7)中:σ表示Sigmoid激活函数,FMLP表示MLP操作,Pavg和 Pmax分别表示平均池化以及最大池化操作,W1和W0表示 MLP的权重,MCAavg和 MSAavg分别表示两种维度平均池化后的特征,MCAmax和MSAmax分别表示两种维度最大池化后的特征,Conv代表卷积核大小为7×7的卷积操作.

1.2 判别器

对于判别器,提出的MBFA-GAN采用了PatchGAN[27]的架构,它将图像分成多个重叠的patch,然后对每个patch进行独立的判别,如图7所示.该判别器的作用在于能够提供更细粒度的图像信息反馈,有助于生成模型更精细地学习图像的结构和纹理.

该判别器通过四个大小为4×4的跨步卷积层来实现下采样,从而减小特征图的大小.在这一过程中使用Instance Norm归一化和LeakyReLu激活函数,分别输出64、128、256和512个特征图.最终,通过一个1×1卷积层来组合这些特征.

1.3 损失函数

在原始GAN的训练过程中,梯度爆炸或消失是一种常见的问题.为了解决这一问题并使训练稳定,一些改进的GAN模型通过修改损失函数来提高性能,其中包括LSGAN、Wasserstein GAN(WGAN)以及带梯度惩罚的Wasserstein GAN(WGAN-GP).WGAN-GP是一种基于梯度惩罚机制改进的生成对抗网络模型,通过解决梯度不稳定性和引入梯度惩罚来提高训练稳定性和生成样本质量.为了惩罚判别器的梯度,该网络在真实样本和生成样本之间进行线性插值,然后通过计算这些插值点处的判别器梯度范数的平均值来引入梯度惩罚,这样可以使生成器和判别器的训练更加平稳和可靠.介于WGAN-GP在图像生成方面表现较好,因此本文选用WGAN-GP作为对抗损失来提升模型效果,如式(8)所示:

式(8)中:Pr 为真实样本分布,Pg为生成的假样本分布,P 为真假样本中随即插值采样得到的分布.

该网络还引入了感知损失,以测量真实图像和生成图像之间的感知相似性.它表示从VGG网络φ 获得的多层特征的像素距离,并且损失函数可以表示为式(9):

Lper=1CiHiWiφi(Ig)-φi(Ir)22

(9)

式(9)中:Ci,Hi,Wi表示第i层的通道数、高度和宽度,φi(Ig)和φi(Ir)为第i层增强结果和真实结果的潜在特征.在实验中,设置了i=1、3、5、9、13.

除此之外,该网络引入了MSE损失和SSIM损失,如式(10)、(11).MSE(Mean Square Error)损失用于最小化增强图像Ig与真实图像Ir之间的L2范数,而SSIM(Structural Similarity Index)损失考虑了亮度、对比度和结构三个方面的相似性,因此更能反映人眼对图像质量的感知.

LSSIM=1-FSSIM(Ir,Ig)

(11)

因此,提出的MBFA-GAN的损失函数如式(12)所示:

L*=λ1LMSE+λ2LSSIM+λ3Lper+λ4Ladv

(12)

式(12)中:λ1,λ2,λ3,λ4 为权重因子.

2 实验结果与讨论

2.1 数据集

水下图像增强基准(Underwater Image Enh-ancement Benchmark,UIEB)包含了各种水下场景中,以及水下各种特征退化(光线不足、模糊等)的情况.该数据集共有950张真实的水下图像,其中有890张图像给出了对应的高质量参考图.本文在UIEB上对训练集和测试集根据9∶1进行了随机性划分,训练集包含了790对图像,测试集包含了100对图像.

2.2 实验设置

本实验在Ubuntu 20.04系统上使用PyTorch框架完成了训练和测试.通过多次实验,设置权重λ=10,λ1=20,λ2=300,λ3=1,λ4=0.1.我们对生成器和判别器交替进行训练80个epoch.其中,BatchSize设置为10,优化器采用了Adam算法,初始学习率为0.001,并且在30个epoch后会线性递减至0.

2.3 评价指标

为了评价所提出的方法,本文采用水下图像质量测量(Underwater Image Quality Measurement,UIQM)、峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)、结构相似度(Structural Similarity Index Measurement,SSIM)作为所选数据集的评价指标.UIQM是一种基于人眼视觉系统的无参考水下图像质量评价指标,其针对水下图像的退化机理与成像特点,采用色彩测量指标(Underwater Image Colorfulness Measurement,UICM),清晰度测量指标(Underwater Image Sharpness Measurement,UISM),对比度测量指标(Underwater Image Contrast Measurement,UIConM)作为评价依据,将UIQM表示为三者的线性组合.其值越大,表示图像的颜色平衡、清晰度、对比度越佳.PSNR是一种用于衡量数字图像压缩质量的指标,通过测量原始图像与压缩图像之间的均方误差(Mean Squared Error,MSE)来计算.PSNR的值越大,说明增强后的图像失真越小,与对照图像越接近.SSIM是一种用于测量两幅图像之间的相似度的指标,它考虑了亮度、对比度和结构等方面的信息,将图像作为一个结构化的集合,从而更准确地衡量图像之间的相似性.SSIM指标的值在0~1之间,SSIM的值越高说明两张图像之间的相似度更高.

2.4 消融实验

为了验证各个模块的有效性,本文在UIEB 数据集上进行了消融实验,并选择了UIQM、PSNR、SSIM作为评价指标.在实验中,把网络各组成部分分为:A.青品色温修复模块;B.模糊恢复+自适应融合模块;C.CBAM模块;D.融合注意力模块.每个消融网络和本文提出方法的视觉效果如图8所示.评价指标数值结果如表1所示,加粗表示最优值.

从图8中可以观察到,使用青品色温修复模块基本上消除了水下原始图像中的蓝绿色偏问题,但依然存在稍微的颜色失真和模糊问题.以第一幅图像举例,红色框中石头边缘处仍存在模糊现象,图像颜色也稍微偏红色调.使用模糊恢复模块与自适应融合模块后,整体图像模糊现象得以改善.本文采用融合注意力模块结合了前两者增强后的特征,显著提高了增强图像的清晰度和对比度,使颜色更加真实逼真.相比于使用传统CBAM模块,采用融合注意力模块能让图像细节更加丰富,视觉效果更优.

从表1中可以观察到,提出的MBFA-GAN在各项指标均取得了最优值.尤其是在加入融合注意力机制后,图像的PSNR和SSIM值大幅度提升.不管是主观视觉分析还是客观指标分析,都证明了所提出的各个模块的有效性.

2.5 对比试验

为了进一步评估所提出的MBFA-GAN的有效性,本文进行了定性(主观评价)和定量(客观评价)分析.

2.5.1 主观评价

本文选取了UIEB作为数据集与经典水下增强方法进行了比较,包括4种传统方法HE [28],UDCP[29],UCM [30],RGHS [31]和4种深度学习方法FGAN [32] 、UGAN[33] 、UWCC[34]、UDnet [35].不同方法和本文提出方法的增强图像的视觉效果对比如图9所示.其中,HE和UCM可以增强图像的亮度和对比度,但加剧了颜色失真,整体色调偏红并且存在红色伪影.UCP和RGHS对偏色图像恢复效果不佳,整体图像表现过暗.FGAN和UGAN整体上改善了图像的偏色问题并且增强图像了的对比度,但对于偏色情况严重的处理效果不够理想.UWCC在提高图像明亮度和图像细节方面表现较好,但可能会引入其他色偏.UDnet方法去除色偏效果一般,但对于去除模糊遮挡的效果比较理想.相比之下,本文提出的方法在去除色偏、模糊遮挡和提高图像对比度3个方面都获得了不错的效果.

2.5.2 客观评价

本文选择了UIQM、PSNR、SSIM作为对比实验的客观评价指标.具体对比实验定量结果如表2所示,最好的结果加粗表示.

从表2中可以看出,本文提出的方法在PSNR和SSIM指标上均取得了最佳分数,PSNR和SSIM相较于次好结果分别提升了7.8%和1.4%.相比于传统方法HE、UDCP以及UCM,本方法的PSNR以及SSIM均有较大提升,取得了更好的表现.相比于近几年的深度方法,本方法的UIQM也取得了不错的表现,比最优结果仅仅低了1.6%.图9的主观视觉以及表2数据都很好地证明了本文算法能够有效恢复图像色彩、提高图像对比度和清晰度.

3 结论

针对水下图像存在噪声大、细节模糊和色偏严重等问题,本文提出了一种基于多分支增强与融合注意力机制的水下增强方法.该算法通过青品色温修复模块来矫正水下图像蓝绿色偏,然后通过模糊恢复模块去除图像中的噪点和模糊.随后,将多分支增强后的特征引入自适应融合模块中,发掘多模态融合的重要特征,并且平衡图像颜色信息和光照特征.最后设计了融合注意力模块,让图像更加专注于有用的通道特征与像素特征,使增强后的图像具有更高的对比度和清晰度.与其他水下图像增强算法相比,本文算法在主观和客观测评方面都展现出了良好的效果.实验结果表明,该算法能够有效去除噪声、校正水下图像的色偏,增强图像的细节特征,从而提升图像的视觉效果.另一方面,本文方法的时间复杂度略高,未来将进一步改进方法以满足水下图像实时处理的需求.

参考文献

[1] Roser M,Dunbabin M,Geiger A.Simultaneous underwater visibility assessment,enhancement and improved stereo[C]//2014 IEEE International Conference on Robotics and Automation (I-CRA).Hong Kong:IEEE,2014:3 840-3 847.

[2] Liu R,Ma L,Zhang J,et al.Retinex-inspired unrolling with cooperative prior architecture search for low-light image enhancement[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.Nashville:IEEE,2021:10 561-10 570.

[3] 刘卫东,李吉玉,张文博,等.基于Retinex和ADMM优化的水下光照不均匀图像增强算法[J].西北工业大学学报,2021,39(4):824-830.

[4] Dong L,Zhang W,Xu W.Underwater image enhancement via integrated RGB and LAB color models[J].Signal Processing:Image Communication,2022,104:116 684.

[5] Azmi K Z M,Ghani A S A,Yusof Z M,et al.Natural-based underwater image color enhancement through fusion of swarm intelligence algorithm[J].Applied Soft Computing,2019,85:105 810.

[6] Zhou J,Pang L,Zhang D,et al.Underwater image enhancement method via multi-intervalsubhistogram perspective equalization[J].IEEE Journal of Oceanic Engineering,2023,48(2):474-488.

[7] Ancuti C,Ancuti C O,Haber T,et al.Enhancing underwater images and videos by fusion[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition.Providence:IEEE,2012:81-88.

[8] 代成刚,林明星,王 震,等.基于亮通道色彩补偿与融合的水下图像增强[J].光学学报,2018,38(11):86-95.

[9] Guo P,Zeng D,Tian Y,et al.Multi-scale enhancement fusion for underwater sea cucumber images based on human visual system modelling[J].Computers and Electronics in Agriculture,2020,175:105 608.

[10] Ancuti C O,Ancuti C,De Vleeschouwer C,et al.Color balance and fusion for underwater image enhancement[J].IEEE Transactions on Image Processing,2017,27(1):379-393.

[11] Wang Y,Liu H,Chau L P.Single underwater imagerestoration using adaptive attenuation-curve prior[J].IEEE Transactions on Circuits and Systems I:Regular Papers,2017,65(3):992-1 002.

[12] Berman D,Levy D,Avidan S,et al.Underwater single image color restoration using haze-lines and a new quantitative dataset[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,43(8):2 822-2 837.

[13] Drews P L J,Nascimento E R,Botelho S S C,et al.Underwater depth estimation and image restoration based on single images[J].IEEE Computer Graphics and Applications,2016,36(2):24-35.

[14] Peng Y T,Cosman P C.Underwater image restoration based on image blurriness and light absorption[J].IEEE Transactions on Image Processing,2017,26(4):1 579-1 594.

[15] Li C Y,Guo J C,Cong R M,et al.Underwater image enhancement bydehazing with minimum information loss and histogram distribution prior[J].IEEE Transactions on Image Processing,2016,25(12):5 664-5 677.

[16] Berman D,Levy D,Avidan S,et al.Underwater single image color restoration using haze-lines and a new quantitativedataset[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,43(8):2 822-2 837.

[17] Akkaynak D,Treibitz T.Sea-thru:A method for removing water from underwater images[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach:IEEE,2019:1 682-1 691.

[18] Li C,Guo J,Guo C.Emerging from water:Underwater image color correction based on weakly supervised color transfer[J].IEEE Signal Processing Letters,2018,25(3):323-327.

[19] Li C,Guo C,Ren W,et al.An underwater image enhancement benchmark dataset and beyond[J].IEEE Transactions on Image Processing,2019,29:4 376-4 389.

[20] Li Hanyu,Jingjing Li,Wei Wang.A fusion adversarial underwater image enhancement network with a public test dataset[DB/OL].https://arxiv.org/abs/1906.06819,2019-06-30.

[21] Cao K,Peng Y T,Cosman P C.Underwater image restoration using deep networks to estimate background light and scene depth[C]//2018 IEEE Southwest Symposium on Image Analysis and Interpretation (SSIAI).LasVegas:IEEE,2018:1-4.

[22] Sun X,Liu L,Li Q,et al.Deep pixel-to-pixel network for underwater image enhancement and restoration[J].IET Image Processing,2019,13(3):469-474.

[23] 邓 步,李弘毅,顾亚平.一种基于声呐信息融合的水下图像增强方法[J].声学技术,2023,42(1):106-112.

[24] 邱 皖,李 然,郑睿谦.基于CycleGAN超分辨重构的水下图像增强算法[J].大连海洋大学学报,2023,38(1):149-157.

[25] Lim B,Son S,Kim H,et al.Enhanced deep residual networks for single image super-resolution[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops.Honolulu:IEEE,2017:136-144.

[26] Woo S,Park J,Lee J Y,et al.Cbam:Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision (ECCV).Munich:Springer,2018:3-19.

[27] Isola P,Zhu J Y,Zhou T,et al.Image-to-image translation with conditional adversarial networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Honolulu:IEEE,2017:1 125-1 134.

[28] Hummel R.Image enhancement by histogram transformation[J].Computer Graphics and Image Processing,1977,6(2):184-195.

[29] Drews P,Nascimento E,Moraes F,et al.Transmission estimation in underwater single images[C]//Proceedings of the IEEE International Conference on Computer Vision Workshops.Sydney:IEEE,2013:825-830.

[30] Iqbal K,Odetayo M,James A,et al.Enhancing the low quality images using unsupervised color correction method[C]//2010 IEEE International Conference on Systems,Man and Cybernetics.Istanbul:IEEE,2010:1 703-1 709.

[31] Huang D,Wang Y,Song W,et al.Shallow-water image enhancement using relative global histogram stretching based on adaptive parameter acquisition[C]//Proceedings of the Multi Media Modeling.Bangkok:Springer,2018:453-465.

[32] Islam M J,Xia Y,Sattar J.Fast underwater image enhancement for improved visual perception[J].IEEE Robotics and Automation Letters,2020,5(2):3 227-3 234.

[33] Fabbri C,Islam M J,Sattar J.Enhancing underwater imagery using generative adversarial networks[C]//2018 IEEE International Conference on Robotics and Automation (ICRA).Brisbane:IEEE,2018:7 159-7 165.

[34] Chen X,Zhang P,Quan L,et al.Underwater image enhancement based on deep learning and image formationmodel[DB/OL].https://arxiv.org/abs/2101.00991,2021-01-07.

[35] Saleh A,Sheaves M,Jerry D,et al.Adaptive uncertaintydistribution in deep learning for unsupervised underwater image enhancement[DB/OL].https://arxiv.org/abs/2212.08983,2022-12-18.

【责任编辑:陈 佳】