基于PPO算法的自动驾驶人机交互式强化学习方法

2024-11-04时高松赵清海董鑫贺家豪刘佳源

摘 要:针对当前自动驾驶领域中深度强化学习(deep reinforcement learning,DRL)所面临的高计算性能需求和收敛速度慢的问题,将变分自编码器(variational autoencoder,VAE)和近端策略优化算法(proximal policy optimization,PPO)相结合。通过采用VAE的特征编码技术,将Carla模拟器获取的语义图像有效转换为状态输入,以此应对DRL在处理复杂自动驾驶任务时的高计算负担。为了解决DRL训练中出现的局部最优和收敛速度慢的问题,引入了驾驶干预机制和基于驾驶员引导的经验回放机制,在训练初期和模型陷入局部最优时进行驾驶干预,以提升模型的学习效率和泛化能力。通过在交通路口左转场景进行的实验验证,结果表明,在驾驶干预机制的帮助下,训练初期模型的性能提升加快,且模型陷入局部最优时通过驾驶干预,模型的性能进一步提升,且在复杂场景下提升更为明显。

关键词:自动驾驶;深度强化学习;特征编码;驾驶干预;经验回放

中图分类号:TP181 文献标志码:A 文章编号:1001-3695(2024)09-023-2732-05

doi:10.19734/j.issn.1001-3695.2024.01.0018

Human-machine interactive reinforcement learning method for autonomous driving based on PPO algorithm

Shi Gaosong,Zhao Qinghai,Dong Xin,He Jiahao,Liu Jiayuan

(College of Mechanical & Electrical Engineering,Qingdao University,Qingdao Shandong 266071,China)

Abstract:To address the high computational demands and slow convergence faced by DRL in the field of autonomous driving,this paper integrated VAE with PPO algorithm.By adopting VAE’s feature encoding technology,it effectively transformed semantic images obtained from the Carla simulator into state inputs,thus tackling the high computational load of DRL in handling complex autonomous driving tasks.To solve the issues of local optima and slow convergence in DRL training,it introduced a driving intervention mechanism and a driver-guided experience replay mechanism.These mechanisms applied driving interventions during the initial training phase and when the model encounters local optima,so as to enhance the model’s learning efficiency and generalization capability.Experimental validation,conducted in left-turn scenarios at intersections,shows that with the aid of the driving intervention mechanism,the model’s performance improves more rapidly in the initial training phase.Moreover,driving interventions when encountering local optima further enhance the model’s performance,with even more significant improvements observed in complex scenarios.

Key words:autonomous driving;deep reinforcement learning;feature encoding;driving intervention;experience replay

0 引言

DRL作为集深度学习与强化学习于一体的前沿技术,在自动驾驶领域引起了广泛的关注和应用[1,2]。通过自动驾驶汽车与环境之间的交互学习,使得自动驾驶汽车能够自主优化驾驶策略,从而在复杂、未知的交通环境中高效安全地驾驶[3,4]。

DRL通过智能体与环境的交互学习,最大化累积奖励以从经验中优化驾驶策略[5]。Cui等人[6]使用改进的双偏差经验回放方法,使汽车能够选择驾驶学习倾向,提升了自动驾驶的鲁棒性。Yi等人[7]通过DQN方法实现了自动驾驶车辆的换道,提高了车辆在一定条件下自动驾驶模式的速度和稳定性,但难以应对复杂的环境。Tseng等人[8]使用自适应的DDPG算法,以减少状态行为值的过度估计,提高了驾驶经验的利用率。尽管DRL在处理复杂任务方面取得了良好的性能,但其与环境的交互效率相对较低[9]。使用强化学习来解决问题需要熟练的定义和设置,并消耗大量的计算资源[10]。鉴于人类在上下文理解和基于知识推理方面表现出的鲁棒性和高适应性,将人工指导与强化学习相结合是缓解上述缺点的一种方法[11,12]。

Li等人[13]提出了一种人在环强化学习方法下实现不需要奖励功能的自动驾驶车辆控制。Huang等人[14]利用神经网络模型模仿人类行为,并对actor-critic网络进行了模仿学习约束,该方法在无奖励交通场景下的自动驾驶任务中表现出色。Wu等人[15]通过评估人类指导相对于RL策略的优势,实现了从不完善的人类指导中学习的RL。然而,基于人类指导的方法需要处理大量来自自我探索的数据,而现有方法尚未充分优化人工指导数据的利用,仍需要大量人工工作来防止指导在探索数据中失效。

为解决上述问题,在DRL训练过程中动态地将驾驶员驾驶经验融入模型学习中。在模型学习阶段,通过实时监测模型学习效果并进行干预调整,利用驾驶员经验建立基于驾驶员引导的经验回放机制,使模型向理想状态持续优化。提高模型与环境的交互效率,同时保持DRL的探索功能,使模型不过分依赖专家驾驶经验,从而增强模型的可靠性和泛化性能。

1 算法实现

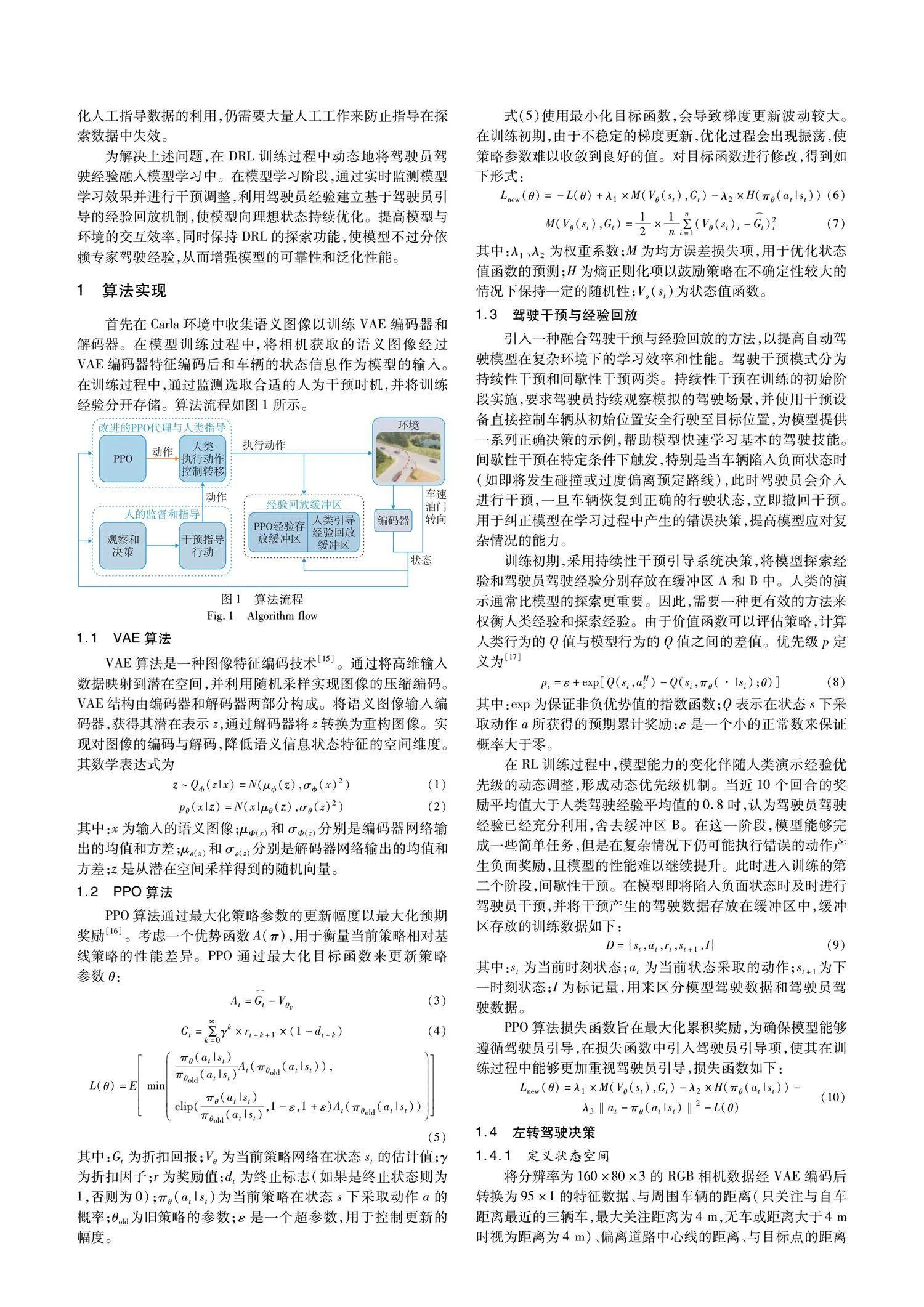

首先在Carla环境中收集语义图像以训练VAE编码器和解码器。在模型训练过程中,将相机获取的语义图像经过VAE编码器特征编码后和车辆的状态信息作为模型的输入。在训练过程中,通过监测选取合适的人为干预时机,并将训练经验分开存储。算法流程如图1所示。

1.1 VAE算法

VAE算法是一种图像特征编码技术[15]。通过将高维输入数据映射到潜在空间,并利用随机采样实现图像的压缩编码。VAE结构由编码器和解码器两部分构成。将语义图像输入编码器,获得其潜在表示z,通过解码器将z转换为重构图像。实现对图像的编码与解码,降低语义信息状态特征的空间维度。其数学表达式为

2 实验验证

驾驶干预通过外接驾驶设备实现,实验设备如表1所示。

通过对自动驾驶路口左转场景的训练,并与表2算法对比,验证提出算法的可行性和有效性。实验地图为Town07,为使模型能够适应多样化的场景,在路口两侧分别随机添加0~6个车辆,前后车辆间隔16 m放置,且车辆位于所在车道道路中心线位置,并将其设定为Carla的自动驾驶模式。

为使模型成功完成任务,每个训练回合自车需要从起始位置出发,保持在道路上,避免与任何障碍物碰撞,最终到达终点线(自车的横坐标达到目标位置的横坐标)。如果自车与道路边界或其他交通参与者发生碰撞,则立即终止该回合,并重置环境生成障碍车辆,训练场景如图2所示,红色车辆为自车。将训练好的模型在图3所示的6个左转场景进行测试。

2.1 图像获取与预处理

在训练自动驾驶左转任务前,需要先训练VAE编码器和解码器。手动驾驶汽车分别采样10 000和2 000张语义图像作为训练集和测试集。训练过程学习率调整规则如下:

τ=ξ(lold-l)(15)

其中:l和lold分别为当前时刻的损失函数和上一时期的损失函数,设定10个训练回合为1个时期;ξ表示阈值系数;τ为阈值。当τ大于学习率lr时,表明在当前学习率下模型没有显著改善。此时更新学习率为

lnewr=δlr(16)

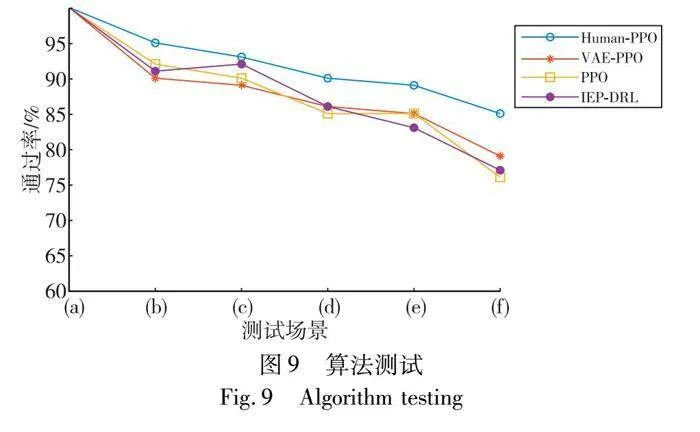

VAE算法训练结果如图4所示,根据学习率衰减规则,学习率表现出梯形下降的趋势。随着学习率的衰减,训练损失和测试损失也表现出相应的减小趋势,随着学习率的降低这种趋势逐渐减缓,且当学习率更新时损失值再次下降。随着训练次数的增加,模型逐渐学习到训练数据的特征和分布,从而使得训练损失逐渐减小。在测试数据上进行验证时,模型面临着未曾见过的样本,测试损失会高于训练损失。

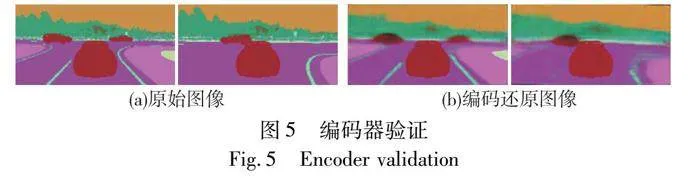

在仿真环境中采集新的图片,验证编码器的性能,如图5所示。将图像传递给编码器进行压缩编码后,还原图像的清晰度有所下降,但保留了环境的关键信息,如车道线和障碍物等重要元素。

2.2 对比实验

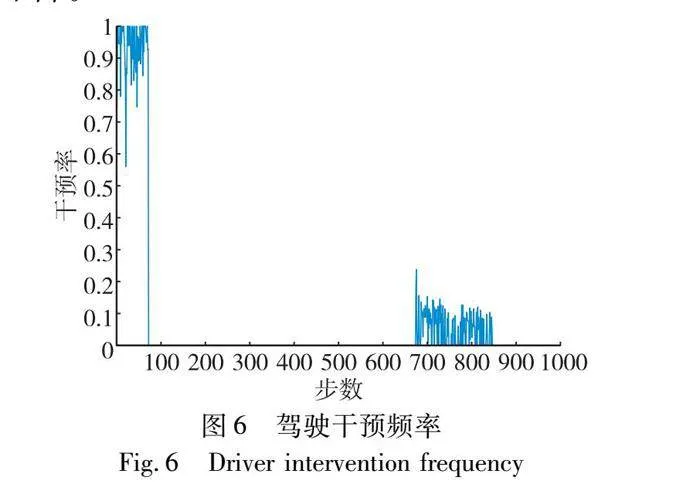

训练初始阶段,持续性干预80个回合,收集足够的驾驶数据,使模型在训练初期具有较好的学习经验。当模型性能接近驾驶员驾驶时(奖励值达到设定的临界条件),进行间歇性干预。当外接设备的输入不全为0时视为驾驶干预,否则为模型驾驶。训练过程的干预频率如图6所示。根据设定的驾驶规则,前80次的干预频率接近1。当训练次数达到663时,模型的性能达到设定的临界值,这时仅依靠起始给定的驾驶干预经验难以继续提升模型的性能。一些极端的情况下,如路口多辆车正在通行,模型难以学习到最优决策。此时,依赖驾驶员的经验指导,使模型能够作出更优的决策。随着训练次数的增加,模型的性能逐步提升,对驾驶员的依赖逐渐下降。

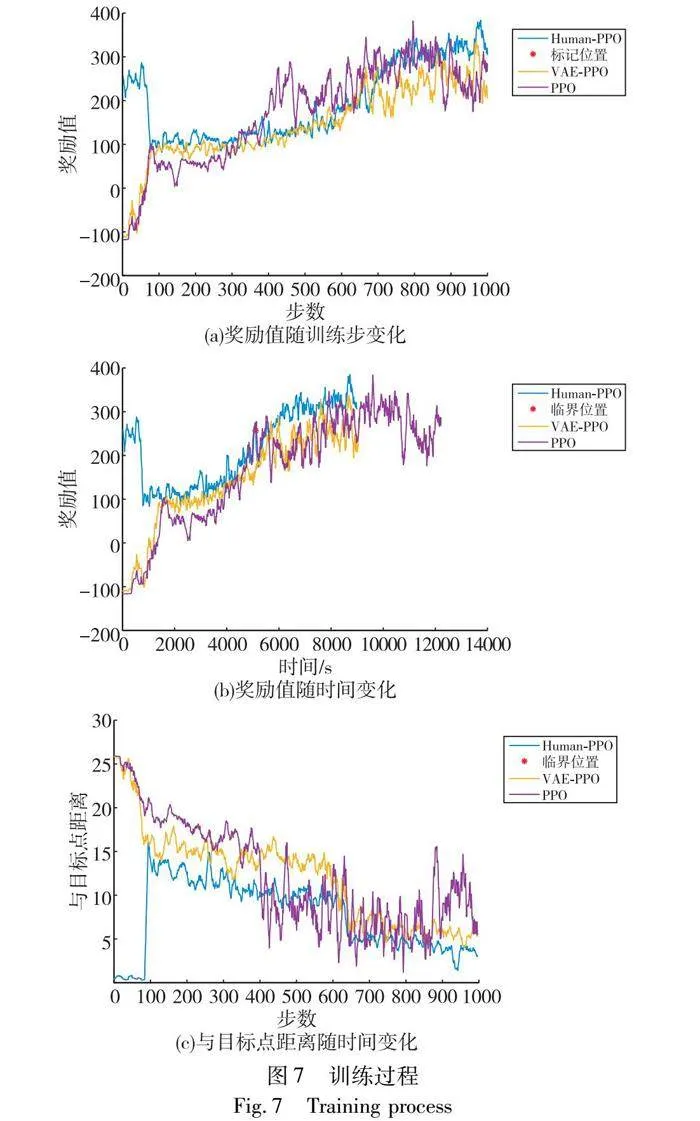

训练初期,Human-PPO模型处于驾驶干预状态时具有较高的奖励值(如图7(a)所示)。当撤回干预时,由于Human-PPO具备优质的学习数据,其奖励值依然高于VAE-PPO和PPO模型。当Human-PPO模型的奖励值达到设定的临界位置时,进行间歇性干预,模型的奖励值继续提高,最终达到高于驾驶员驾驶时的奖励值,且高于VAE-PPO和PPO模型的奖励值,表明人机交互式学习策略在自动驾驶强化学习中克服局部最优的有效性。

VAE-PPO算法训练初期需要不断探索收集驾驶经验,因此奖励值初始状态较低。随着训练的进行,奖励值不断提高,当奖励值达到280左右时,模型满足于当前的状态,难以探索到更好的状态,奖励值持续稳定在280附近。PPO模型在420步时达到相对较好的性能,之后奖励值在200~400波动。训练过程中,由于每回合场景的随机性,若当前训练回合为图3(a)所示场景,不存在干扰车辆,自车可以获得最大的安全奖励并保持目标车速行驶,若当前训练回合是图3(b)~(e)场景时,由于场景中干扰车辆的复杂性不同,处于不同场景时奖励值也波动较大,最终模型的奖励值波动范围较大。

当使用PPO算法时,模型在420步的奖励值高于Human-PPO和VAE-PPO模型。由于使用原始图像(160×80×3)相较于编码后的图像(95×1)内存占用扩大了384倍,增加了计算资源的消耗,延长了模型的学习周期。如图7(b)所示,从训练时间上看,PPO模型的训练进程显著缓慢。对比而言,Human-PPO模型展现了最短的训练时间,表明将人工干预机制与VAE和PPO算法结合使用,在降低状态空间维度、减少计算负担、提升模型学习效率方面具有显著优势。

Human-PPO模型驾驶干预初期,驾驶员能够准确地找寻到目标位置,回合结束时距离目标位置的距离接近于0(图7(c))。当撤回驾驶干预,回合结束时,模型与目标点的距离迅速增加,但仍然低于无干预时与目标点的距离。当训练达到临界条件实施间歇性干预,随着模型的训练,回合结束时,与目标点的距离呈减小的趋势,Human-PPO模型距离目标点的距离稳定在3附近,VAE-PPO稳定在5附近。相较于编码后的图像作为输入,由于PPO模型使用原始图像作为输入,对复杂场景的泛化性差,离目标点的距离波动较大。

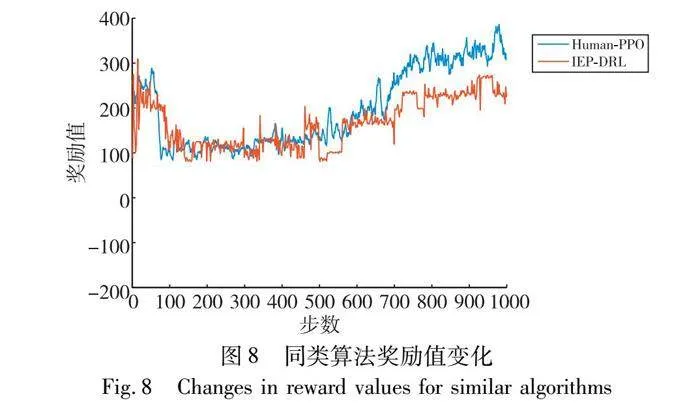

图8所示为模仿专家先验的强化学习(imitative expert priors)与IEP-DRL[14]的对比,撤回持续性干预后IEP-DRL的奖励值与Human-PPO接近,随着训练的进行,Human-PPO算法的奖励值逐渐高于IEP-DRL。由于训练前期模型的探索率比较高,难以比较出两种算法的优越性,随着训练的进行,模型探索率下降,此时的奖励值能够准确反映两种算法的训练情况。

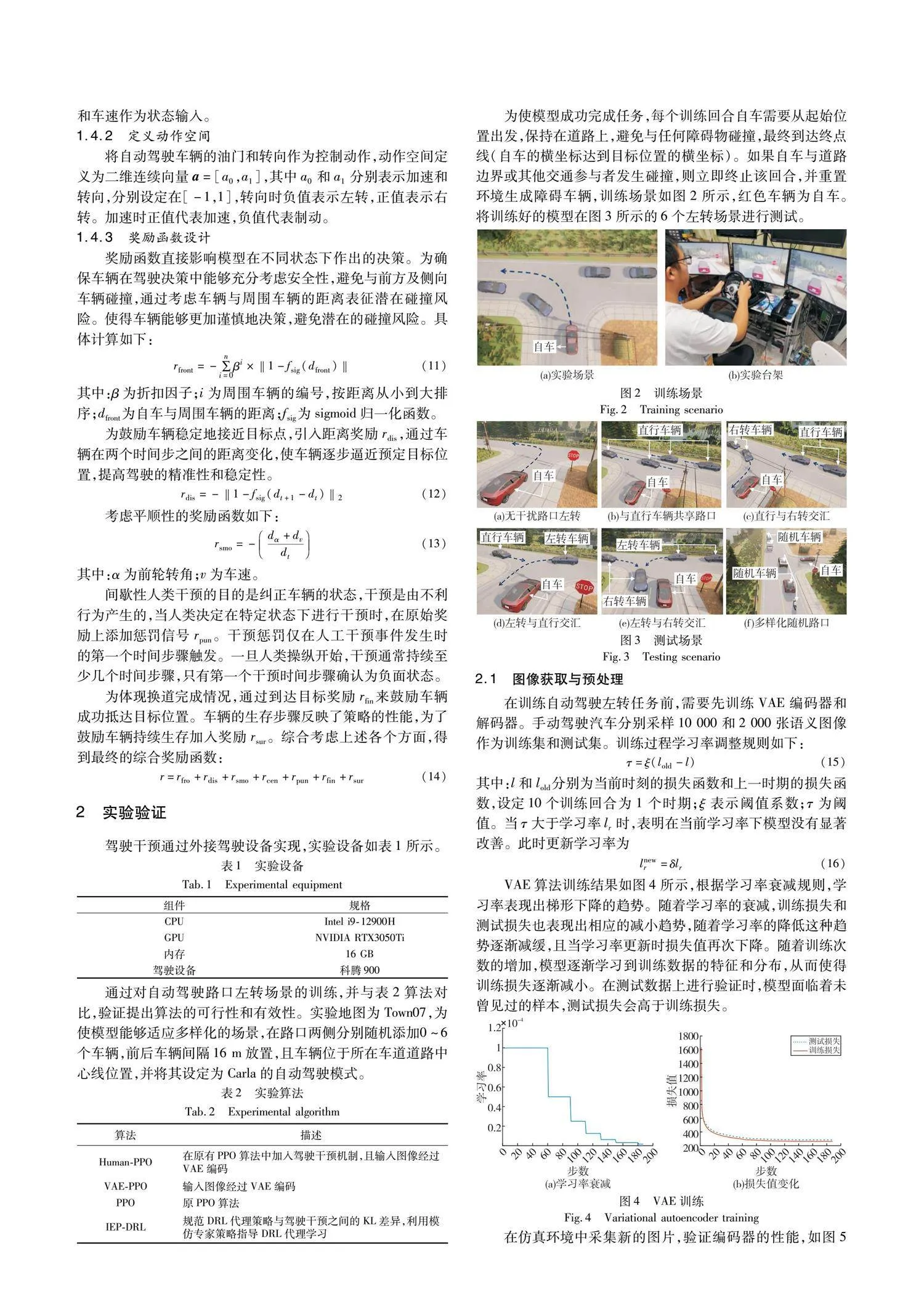

图9为模型在图3测试场景中测试100回合的结果。当没有其他交通参与者的情况下,各模型均能够顺利完成左转任务。在复杂场景时,VAE-PPO模型的表现能力明显下降,这主要是因为在复杂环境中,相比于模型自主探索而言,依赖驾驶员的引导来获得最优决策能够取得更好的效果。PPO模型的成功率随着场景复杂度的提高迅速下降,这表明经VAE编码后的图像特征转换对于提升模型的泛化性和鲁棒性具有显著作用。IEP-DRL算法在场景(f)下性能急剧下滑,表明模仿的专家策略在面对全新场景时鲁棒性较差。

3 结束语

在自动驾驶模型的训练过程中加入驾驶干预,使用了两种不同的干预模式。在初始阶段,采用手动驾驶方式积累的驾驶经验,能够更快地将模型引导到正确的驾驶决策,避免了训练初期长时间的静止状态。这有助于模型更快地掌握有效的驾驶技能,对于模型的性能提升具有显著作用,使模型在训练初期就具备较好的驾驶决策能力,从而加速学习过程。在模型接近驾驶员驾驶水平时,模型在一定程度上难以进一步提升性能。采用间歇性的干预调整策略,在必要时纠正模型的错误决策,帮助模型更好地适应复杂的驾驶场景,模型的性能进一步提升。这表明驾驶干预对于克服性能瓶颈具有积极的作用。通过在DRL中引入驾驶干预机制,自动驾驶模型在训练过程中能够更快、更有效地学习驾驶技能,提高在复杂驾驶情境下的性能表现。尽管驾驶干预在训练中有积极的影响,仍然需要注意一些潜在的挑战,例如,训练过程中实时的驾驶干预依赖于驾驶员的专业度,且连续的驾驶干预对驾驶员的静力和体力也是一项挑战。如何保留驾驶干预机制,而又不过于依赖驾驶员,将是后续研究的重点。

参考文献:

[1]Isele D,Rahimi R,Cosgun A,et al.Navigating occluded intersections with autonomous vehicles using deep reinforcement learning[C]//Proc of IEEE International Conference on Robotics and Automation.Piscataway,NJ:IEEE Press 2018:2034-2039.

[2]许宏鑫,吴志周,梁韵逸.基于强化学习的自动驾驶汽车路径规划方法研究综述[J].计算机应用研究,2023,40(11):3211-3217.(Xu Hongxin,Wu Zhizhou,Liang Yunyi.Reinforcement learning auto drive system based on visual feature extraction[J].Application Research of Computers,2023,40(11):3211-3217.)

[3]陈越,焦朋朋,白如玉,等.基于深度强化学习的自动驾驶车辆跟驰行为建模[J].交通信息与安全,2023,41(2):67-75,102.(Chen Yue,Jiao Pengpeng,Bai Ruyu,et al.Modeling of car following behavior in autonomous vehicles based on deep reinforcement learning[J].Traffic Information and Safety,2023,41(2):67-75,102.)

[4]段续庭,周宇康,田大新,等.深度学习在自动驾驶领域应用综述[J].无人系统技术,2021,4(6):1-27.(Duan Xuting,Zhou Yukang,Tian Daxin,et al.A review of the application of deep learning in the field of autonomous driving[J].Unmanned Systems Technology,2021,4(6):1-27.)

[5]赵星宇,丁世飞.深度强化学习研究综述[J].计算机科学,2018,45(7):1-6.(Zhao Xingyu,Ding Shifei.A review of research on deep reinforcement learning[J].Computer Science,2018,45(7):1-6.)

[6]Cui Jianping,Yuan Liang,He Li,et al.Multi-input autonomous driving based on deep reinforcement learning with double bias experience replay[J].IEEE Sensors Journal,2023,23(11):11253-11261.

[7]Yi Liming.Lane change of vehicles based on DQN[C]//Proc of the 5th International Conference on Information Science,Computer Technology and Transportation.Piscataway,NJ:IEEE Press,2020:593-597.

[8]Tseng K K,Yang Hong,Wang Haoyang,et al.Autonomous driving for natural paths using an improved deep reinforcement learning algorithm[J].IEEE Trans on Aerospace and Electronic Systems,2022,58(6):5118-5128.

[9]Neftci E O,Averbeck B B.Reinforcement learning in artificial and biological systems[J].Nature Machine Intelligence,2019,1(3):133-143.

[10]Littman M L.Reinforcement learning improves behaviour from evalua-tive feedback[J].Nature,2015,521(7553):445-451.

[11]Vecerik M,Hester T,Scholz J,et al.Leveraging demonstrations for deep reinforcement learning on robotics problems with sparse rewards[EB/OL].(2017-07-27)[2023-10-11].https://arxiv.org/abs/1707.08817.

[12]冯忠祥,李靖宇,张卫华,等.面向人机共驾车辆的驾驶人风险感知研究综述[J].交通信息与安全,2022,40(2):1-10.(Feng Zhongxiang,Li Jingyu,Zhang Weihua,et al.A review of research on driver risk perception for human-machine co driving vehicles[J].Traffic Information and Safety,2022,40(2):1-10.

[13]Li Quanyi,Peng Zhenghao,Zhou Bolei.Efficient learning of safe dri-ving policy via human-AI copilot optimization[EB/OL].(2022-02-17)[2023-10-11].https://arxiv.org/abs/2202.10341

[14]Huang Zhiyu,Wu Jingda,Lyu Chen.Efficient deep reinforcement learning with imitative expert priors for autonomous driving[J].IEEE Trans on Neural Networks and Learning Systems,2022,34(10):7391-7403.

[15]Wu Jingda,Huang Zhiyu,Huang Wenhui,et al.Prioritized experience-based reinforcement learning with human guidance for autonomous driving[J].IEEE Trans on Neural Networks and Learning Systems,2024,35(1):855-869.

[16]Ramachandran S,Horgan J,Sistu G,et al.Fast and efficient scene categorization for autonomous driving using VAEs[EB/OL].(2022-10-26)[2023-10-11].https://arxiv.org/abs/2210.14981.

[17]Schulman J,Wolski F,Dhariwal P,et al.Proximal policy optimization algorithms[EB/OL].(2017-07-20)[2023-10-11].https://arxiv.org/abs/1707.06347.

[18]Schaul T,Quan J,Antonoglou I,et al.Prioritized experience replay[EB/OL].(2015-11-18)[2023-10-11].https://arxiv.org/abs/1511.05952.

收稿日期:2024-01-03

修回日期:2024-03-14

基金项目:国家自然科学基金资助项目(52175236)

作者简介:时高松(1998—),男,河南南阳人,硕士研究生,CCF会员,主要研究方向为自动驾驶路径规划(2022020464@qdu.edu.cn);赵清海(1985—),男,山东潍坊人,副教授,硕导,博士,主要研究方向为轻量化车辆结构设计;董鑫(1999—),男,山东滨州人,硕士研究生,主要研究方向为自动驾驶路径规划;贺家豪(2003—),男,济宁嘉祥人,本科生,主要研究方向为自动驾驶路径规划;刘佳源(2004—),男,山东潍坊人,本科生,主要研究方向为自动驾驶路径规划.