基于时间分段和重组聚类的说话人日志方法

2024-11-04朱必松毛启容高利剑沈雅馨

摘 要:

当前的说话人日志方法大多采用标准的全局聚类的方式来区分不同说话人的语音片段,没有考虑到同一个人的声音在不同的噪声条件下具有不同的特征分布,而这会增大类内距离,从而降低聚类精度。鉴于相邻的语音片段往往包含相同的背景噪声,提出一种新的基于时间分段和重组聚类的说话人日志方法以解决上述问题。首先,将所有语音片段按时间连续性划分成多个独立的时间段,并在段内进行局部聚类;然后,将不同时间段中属于同一个说话人的语音片段重新合并。此外,在聚类时利用语音片段的邻域信息来校准它们之间的相似度。通过这种方式降低了直接在不同噪声条件下进行聚类的概率,提高了聚类精度。在公开数据集AMI SDM和VoxConverse上的实验结果表明,与基线方法相比,所提方法的日志错误率分别相对降低了34%和16%,充分证明了该方法的有效性。

关键词:说话人日志;聚类;噪声;邻域

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2024)09-012-2649-06

doi:10.19734/j.issn.1001-3695.2024.01.0017

Temporal-segment-and-regroup clustering for speaker diarization

Zhu Bisong1, Mao Qirong1, 2, Gao Lijian1, Shen Yaxin1

(1. School of Computer Science & Telecommunication Engineering, Jiangsu University, Zhenjiang Jiangsu 212013, China; 2. Jiangsu Province Big Data Ubiquitous Perception & Intelligent Agriculture Application Engineering Research Center, Zhenjiang Jiangsu 212013, China)

Abstract:

The current methods for speaker diarization commonly employ standard global clustering techniques to distinguish speech segments of different speakers, without considering that voice of the same individual may exhibit various feature distribution under varying background noise conditions, which enlarges the intra-class distances and impacts clustering heavily. Motivated by that adjacent speech segments often share the same background noise, this paper proposed a novel temporal-segment-and-regroup clustering (TSARC) pipeline for speaker diarization to address above issues. Firstly, TSARC partitions all speech segments into multiple independent intervals along their temporal continuity and conducted local clustering within each interval. Afterwards, it re-associated segments attributed to the same speaker across different intervals. Moreover, during the clustering process, the method actively employed neighborhood information from speech segments to calibrate their similarities. Through this way, TSARC reduced the likelihood of direct clustering under disparate noise conditions, effectively improving the accuracy of clustering. Experimental results on the public datasets AMI SDM and VoxConverse show that, compared with the baseline method, the proposed method has achieved relatively reductions in diarization error rate (DER) by 34% and 16% respectively, which proves the effectiveness of the proposed method.

Key words:speaker diarization; clustering; noise; neighborhood

0 引言

说话人日志(speaker diarization,SD)的目标是解决“谁在何时说话”的问题[1],即区分并定位出音频中不同说话人的语音活动。说话人日志技术可用于多种应用场景,如会议记录[2]、角色识别[3]及语音识别[4,5]等。目前,关于说话人日志的研究主要分为两类:一类方法[6~8]将说话人日志任务看作多标签分类问题,训练神经网络直接预测音频帧中每一个人说话的概率,称之为端到端的方法;另一类方法[9~25]依靠多个独立优化的模块,先将长音频切割成短片段并提取声纹嵌入(speaker embedding),再通过无监督的聚类方法来区分属于不同说话人的片段,称之为模块化的方法。相较于端到端的方法,模块化的方法可以更好地处理说话人数量未知和时长较长的音频记录[10]。大多数基于模块化方法的工作包含以下四个步骤:利用语音活动检测模块去除非语音片段;切割音频;提取声纹嵌入;聚类。本文重点研究模块化的方法,并遵循这四个步骤。

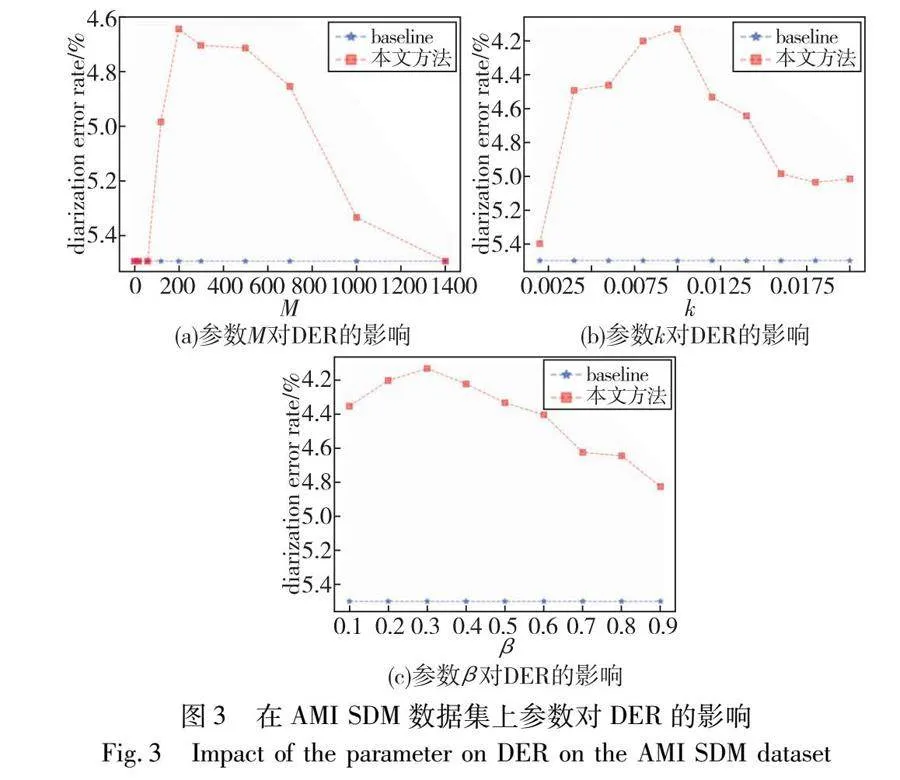

在模块化的方法中,聚类模块的性能至关重要[1]。目前的研究大多采用谱聚类(spectral custering,SC)[11~15]或凝聚层次聚类(agglomerative hierarchical clustering,AHC)[16,17]等聚类方法来区分不同说话人的语音片段。这些研究遵循一个标准的全局聚类流程,即在提取音频片段的声纹嵌入后,通过计算所有嵌入之间的成对相似性来构建一个N×N的亲和矩阵(affinity matrix),并使用整个亲和矩阵进行聚类。然而,如图1所示,由于大多数音频记录都是在不受控制的环境下录制的,同一条音频记录中可能存在不同的噪声干扰,而这些噪声都会对声纹嵌入的质量产生一定的影响,导致同一个说话人的声纹嵌入在不同的噪声条件下具有不同的特征分布。在此影响下,全局聚类方式在计算所有嵌入的相似性时,由于嵌入具有不同的特征分布扩大了类内距离,使得嵌入间呈现出错误的相似性,从而降低了聚类的准确率。为了解决这个问题,最近的研究利用自注意力机制(self-attention)[18,19]和图神经网络(graph neural network,GNN)[20~22]聚合来自同一个说话人的不同音频片段的声纹嵌入,以生成更具区分性的声纹嵌入。然而,这些方法重新引入了对标签的依赖。考虑到人工对音频记录进行精细化标注非常耗时,标注样本严重不足。因此,如何在无监督的条件下减少噪声对说话人日志系统性能的影响仍然是一个难题。

不同于传统的聚类任务,说话人日志任务中的数据是高度结构化的[18],数据间存在时序上的联系,相邻的音频片段中可能会包含相同的背景噪声,提取出声纹嵌入的特征分布相同。基于此,本文旨在充分利用此类数据的结构化特性,避免像全局聚类一样直接在不同的噪声条件下进行聚类分析,提出了一种新的基于时间分段和重组聚类(temporal-segment-and-regroup clustering,TSARC)的说话人日志方法。与全局聚类不同,该聚类方式包含两个步骤:a)时间分段和局部聚类,将所有声纹嵌入按时间连续性划分为多个组,将每一组视为一个时间段,然后分别在各个时间段内进行局部聚类,如图1所示,局部聚类仅关注某个时间段内的局部特征分布,避免像全局聚类一样直接比较不同噪声条件下的声纹嵌入的相似度,因此可以减轻噪声对聚类性能的影响;b)跨时间段重组,仅使用局部聚类无法获取最终结果,这是因为局部聚类的结果仅包含单个时间段内的说话人语音片段,而每一个说话人的语音片段可能分散在多个时间段。为了将不同时间段内属于同一个说话人的语音片段重新关联起来,TSARC进行一次全局聚类,并将全局聚类和局部聚类的结果进行集成,获取最终的结果。同时,由于简单的余弦相似度可能无法正确地反映两个声纹嵌入间的相似性,提出亲和矩阵校准模块,利用声纹嵌入的邻域信息来提高声纹嵌入间相似度的准确性,获取更加可靠的亲和矩阵。在计算每一对声纹嵌入的相似度时,在原始的余弦相似度的基础上引入杰卡德相似度(Jaccard similarity)。声纹嵌入间的杰卡德相似度通过计算其邻居的交并比获得,包含嵌入的上下文信息。属于同一个说话人的声纹嵌入的相似度会随着相似邻域结构的增加而增加,而不属于同一个说话人的则会相应地减少。因此,杰卡德相似度可以校准亲和矩阵。

本文的主要贡献如下:

a)提出一种新的基于时间分段和重组的聚类方式TSARC,针对噪声具有间歇性的特点,将语音片段分成多个时间段,在各个时间段内独立地进行局部聚类,并通过集成聚类的手段对结果进行重组合并,以减少噪声的影响。

b)提出一种新的相似度度量方法,引入杰卡德相似度来衡量声纹嵌入邻域的相似性,以校准原始的余弦相似度,从而提高了亲和矩阵的可靠性。

c)在AMI SDM和VoxConverse数据集上的实验结果表明,与基线方法相比,所提方法的日志错误率分别相对降低了34%和16%。相较于当前先进的模块化方法,TSARC仍表现出显著的性能优势,证明了所提方法的有效性。

2 实验与结果分析

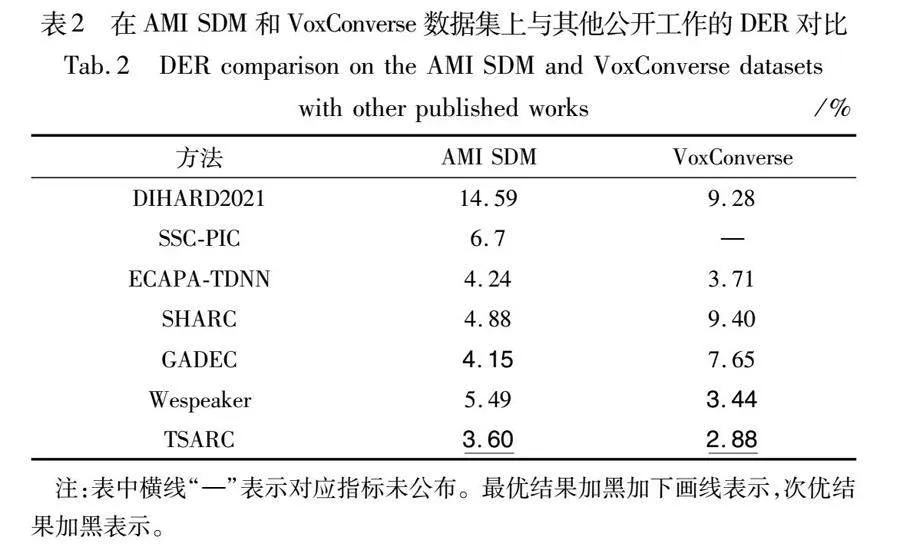

2.1 数据集

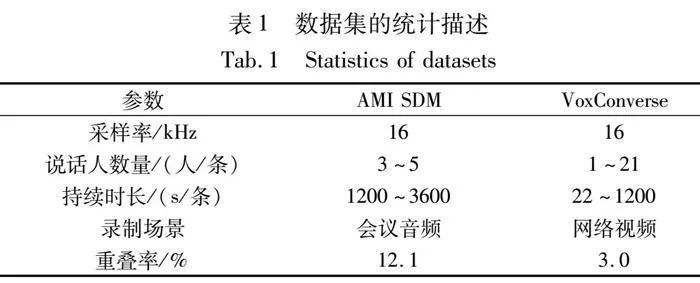

为验证方法的有效性,选用两个公开的通用数据集AMI SDM[31]和VoxConverse[32]进行相关实验。表1给出了这两个数据集的相关统计信息。

AMI数据集由在不同的地点(爱丁堡、伊蒂普亚研究学院、荷兰和布尔诺)录制的会议音频记录组成,音频采样频率为16 kHz。本文使用官方提供的脚本来划分数据集,选取单个远程麦克风(single distance microphone,SDM)条件下的验证集和测试集用于实验。其中,验证集包含18条录音记录,测试集包含16条录音记录。每条录音的持续时长约为20~60 min,包含3~5个说话人。数据集中多个说话人同时说话的时长约占总时长的12.1%。

VoxConverse数据集是从YouTube视频中提取的多说话人音频,这些视频包括政治辩论、小组讨论、名人采访、新闻片段和脱口秀节目,包含着大量的动态环境噪声,如笑声和掌声。数据集中包含验证集和测试集,分别由216条和232条录音组成。每条录音的持续时长为22~1200 s,包含1~21个说话人。数据集中多个说话人同时说话的时长约占总时长的3.0%。

2.2 评价指标

实验采用日志错误率(diarization error rate,DER)[33]作为评估指标来衡量说话人日志系统的性能,该指标被各大赛事广泛采用。DER是三种错误的总和,计算方式为

DER=FA+MS+SC(14)

其中:FA(false alarm)反映的是误报率,即该片段无人说话,但是系统预测有人说话的时长占音频记录总时长的百分比;MS(missed speech)反映的是漏检率,即该片段有人说话,但是系统预测无人说话的时长占音频记录总时长的百分比;SC(speaker confusion)则是反映系统将某个说话人误判成另一个说话人的情况。FA和MS这两个子指标和语音活动检测模块性能相关,若该模块错误地去除了语音片段,则会导致MS上升;相反,若未准确去除非语音片段,则会导致FA上升。SC指标则和聚类模块的性能息息相关。通常,在计算DER时会在说话人转换处设置0.25 s的不计分区域,以减轻符号不一致和人工标注错误带来的负面影响。本文使用dscore工具来计算DER指标,不计算有多说话人重叠的部分错误。

2.3 实验设置

实验服务器配置为Intel Xeon Silver 4316 CPU,主频为2.30 GHz,GPU采用GeForce RTX 3080Ti,显存12 GB,内存 64 GB。在此基础上,服务器采用Ubuntu 20.04.4操作系统,使用Python 3.9.17,CUDA 11.3和PyTorch 1.12.1 作为开发环境。

为消除由于语音活动检测模块的不确定性而可能引入的误差,以更好地验证本文所提方法的有效性,文中所有实验都根据真实标签来去除非语音片段。因此,本文中给出的DER结果仅反映SC错误。与主流方法一致,去除非语音片段后,实验中将录音切割成1.5 s的短片段,相邻的两个片段之间存在0.75 s的重叠。接着,从音频片段中提取出80维的FBank特征,并将这些特征送入到声纹嵌入提取器中提取声纹嵌入,声纹嵌入的维度为256维。本文使用Wenet官方提供的ResNet-34作为特征提取器,该模型使用VoxCeleb2[34]数据集进行预训练,详细设置可参考文献[15]。

实验在AMI SDM数据集上,参数M的最佳取值为200,由于数据集中录音记录的长短变化大,所以邻居数k的最佳取值为音频片段总数的1%,权衡参数β的最佳取值为0.3。在VoxConverse数据集上,参数M的最佳取值为80,邻居数k的最佳取值为片段总数的1%,权衡参数β的最佳取值为0.9。

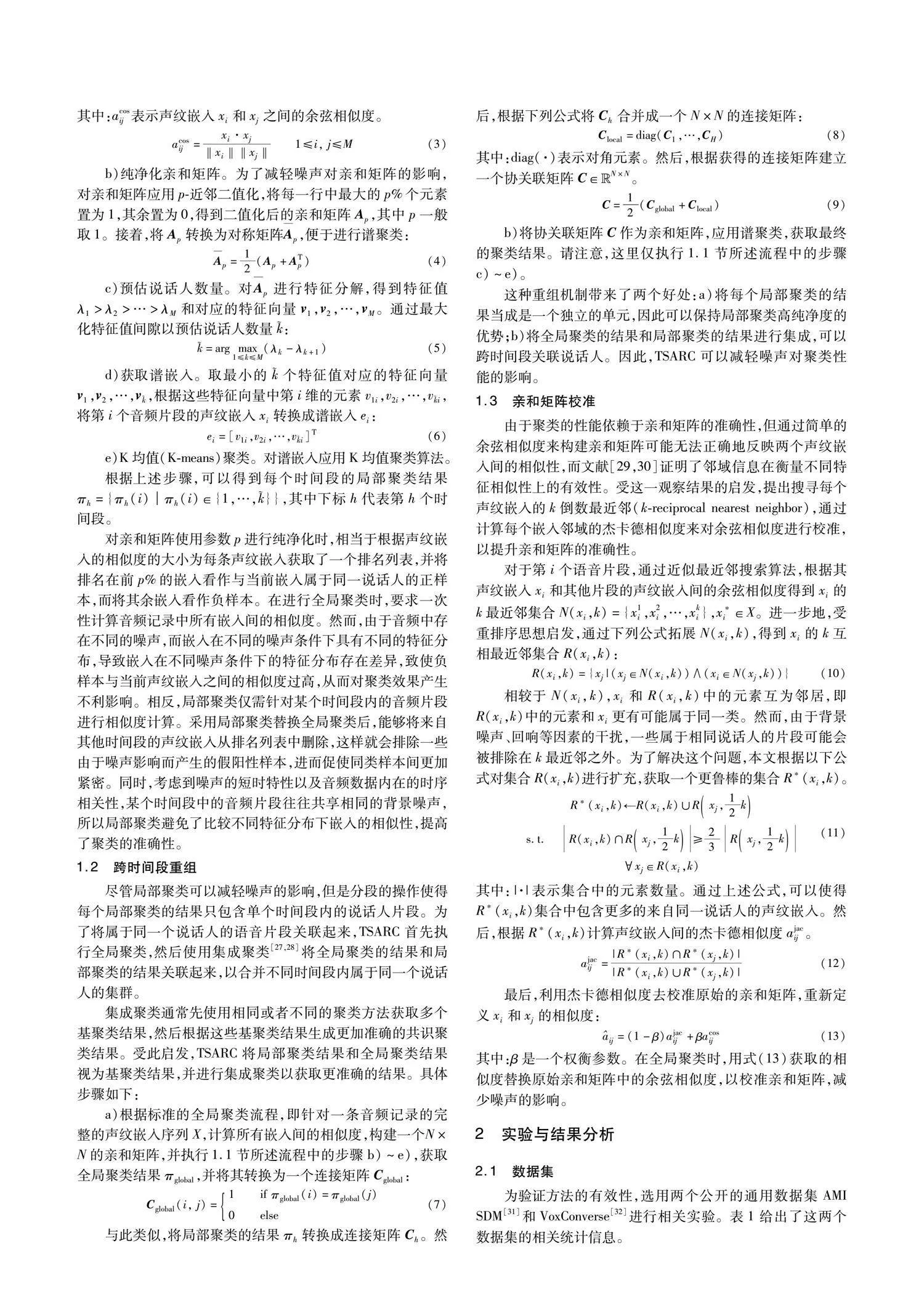

2.4 和现有方法比较

为充分验证TSARC的有效性,本节将选用以下具有代表性的模块化的方法,即DIHARD2021[23]、SSC-PIC[24]、ECAPA-TDNN[14]、Wespeaker[15]、SHARC[22]和GADEC[25]与本文方法进行比较。其中,前四种方法均未引入监督信息,而后两种方法使用了监督信息以训练图神经网络。表2给出了相关方法在AMI SDM和VoxConverse数据集上DER指标的评估结果。其中,DIHARD2021和ECAPA-TDNN的结果是通过文献中给出的开源代码复现获得的,其余方法结果均为各自文献中声明的结果。

结合表2中的实验数据可以观察到,DIHARD2021、ECAPA-TDNN、Wespeaker以及提出的TSARC这些无监督的方法在AMI SDM数据集上的表现不如在VoxConverse数据集上。这是由于AMI SDM数据集中不同说话人说话重叠率较高的原因,从同时包含多人说话的音频片段中提取的声纹嵌入区分性较差。与此相反,有监督的方法SHARC和GADEC在AMI SDM数据集上表现更优,主要是因为VoxConverse数据集中缺乏训练集,缺乏足够的真实数据训练神经网络,这些方法只能使用合成数据进行训练,从而导致模型学习的数据分布与真实分布之间存在偏差。本文方法在Wespeaker的基础上将全局聚类的方式替换成时间分段和重组的聚类方式,并利用邻域信息校准亲和矩阵,其余模块保持不变。在AMI SDM和VoxConverse数据集上,TSARC的DER和Wespeaker相比分别相对降低了约34%和16%。和现有的其他工作相比,TSARC也表现出了更优的结果。实验结果表明,通过采用局部聚类以关注局部的特征分布,并利用邻域信息校准亲和矩阵,能够有效降低噪声的影响,从而显著降低说话人日志的错误率。

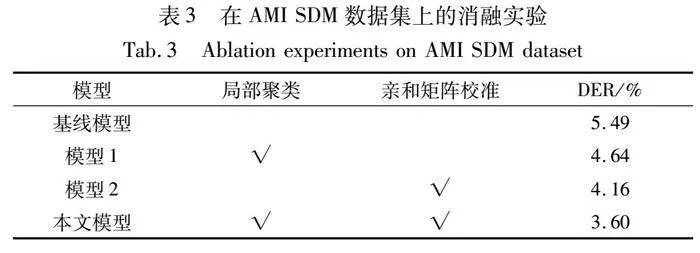

2.5 消融实验

为验证提出的时间分段和重组聚类以及亲和矩阵校准是否能够改善说话人日志的性能,本节在AMI SDM数据集上对所提方法进行消融实验,实验结果如表3所示,表中的“√”表示包含相应的组件,充分表明了所提模块的有效性。其中基线模型为Wespeaker。

1)时间分段和重组聚类的有效性 通过在基线模型中加入局部聚类的模块,由表3可以看出,相较于基线模型,模型1的DER相对降低了约15%,这证明了使用局部聚类可以有效减轻噪声对聚类性能的影响。

2)亲和矩阵校准的有效性 在对亲和矩阵使用邻域信息进行校准后,相较于基线模型,模型2的DER相对降低了约24%,这证明了使用邻域信息可以提高声纹嵌入间相似度的准确性。

通过将时间分段和重组的聚类方式和亲和矩阵校准这两种方式结合后,性能可以获得进一步提升,DER相对于基线模型可以降低约34%,充分证明了本文方法的有效性。

2.6 超参分析

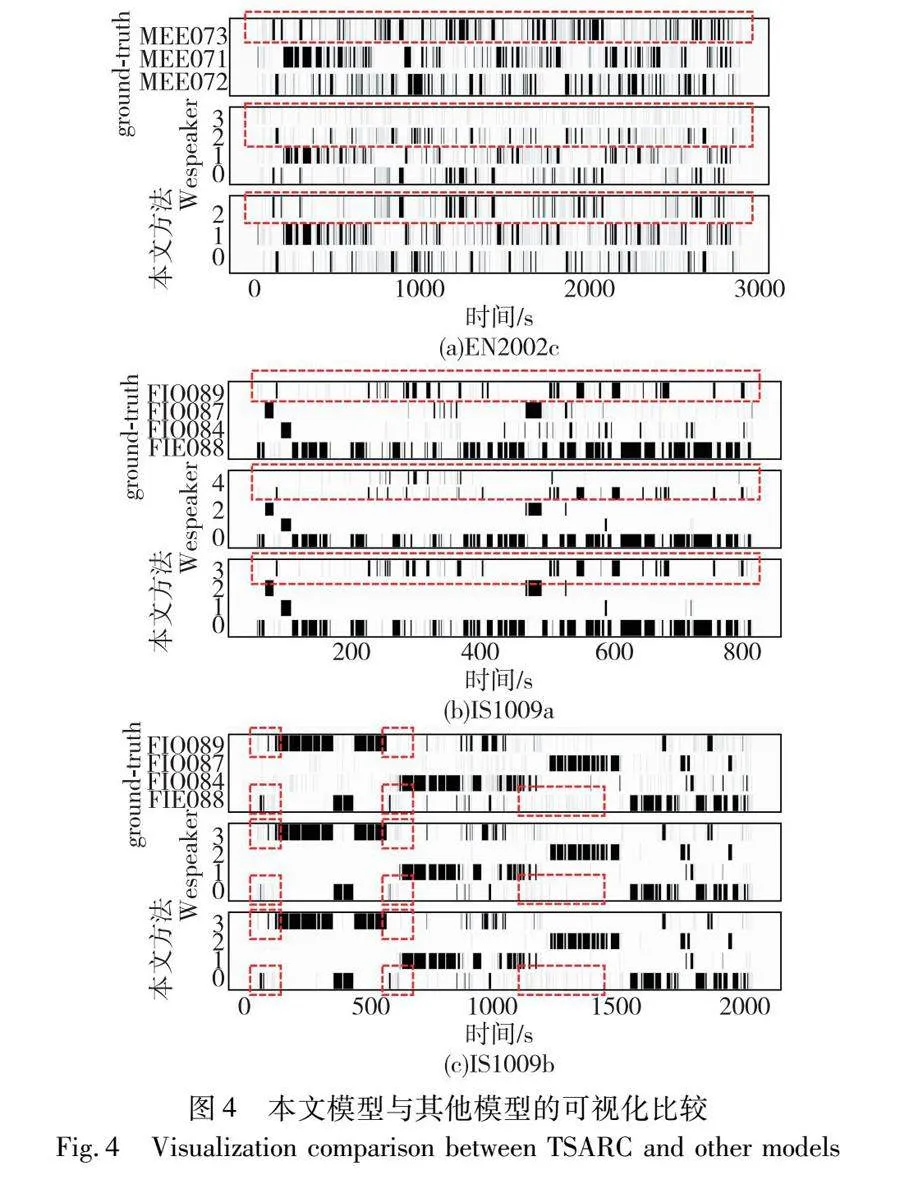

本节将对所提方法引入的参数进行分析,包括时间分段和局部聚类步骤中的参数M,以及亲和矩阵校准步骤中的邻居数k和权衡参数β。实验在AMI SDM数据集上进行。结果如图3所示。其中基线模型为Wespeaker。

每个时间段中音频片段个数M对DER的影响如图3(a)所示,在实验中,为防止其他参数对实验结果的影响,固定k和β的值为0。可以观察到,本文方法在不同的M值上始终优于基线模型。DER先随着M的增大而降低,然后在超过阈值后开始升高。在M值过小时,进行局部聚类的片段数太少,无法在集成聚类时提供有用的信息,而在M值过大时,局部聚类的结果接近全局聚类,此时也无法提供有用的信息。

邻居数k的影响如图3(b)所示,在实验中,为防止其他参数对实验结果的影响,固定M值为0,β值为0.3。横坐标表示邻居数和录音记录的片段总数的比例。可以看出,DER随着k在一个合理范围的增加而降低。需要注意的是,当为k分配一个较大的值时可能会引入噪声,从而导致性能的下降,但是仍然优于基线模型。

权衡参数β的影响如图3(c)所示,在实验中,为防止其他参数对实验结果的影响,固定M值为0,k值为0.01。请注意,当β为0时,仅考虑杰卡德相似度作为最终相似度;而当为1时,则仅使用余弦相似度。可以观察到,方法始终优于基线。这表明,使用邻域信息对亲和矩阵进行校准是有效的。

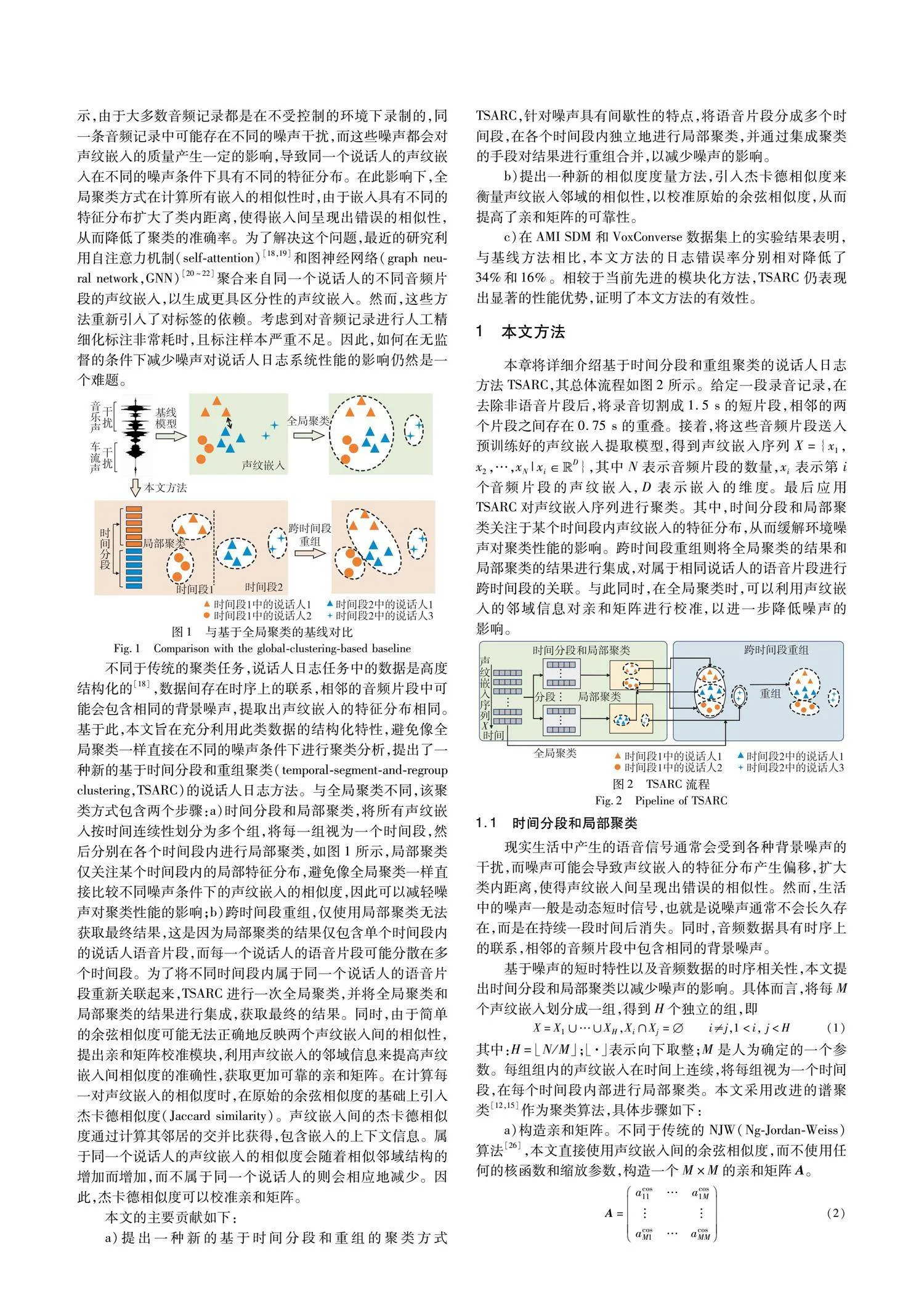

2.7 可视化分析

为直观地展现本文方法的有效性,本节给出TSARC和基线模型Wespeaker在AMI SDM数据集部分音频上的可视化结果对比图。其中,纵轴表示不同的说话人,横轴表示时间,以s为单位,图中的条形表示不同说话人的语音活动。

图4(a)(b)分别展示了编号为EN2002c和IS1009a的音频记录的说话人日志可视化结果,TSARC精准地预测了音频中给出的说话人数量并定位出了说话人的语音活动,而Wespeaker则将一个说话人的语音活动误判成两个说话人的语音活动。图4(c)展示了编号为IS1009b的音频记录的说话人日志可视化结果,在红框部分,TSARC有着更好的区分定位结果,误判率更低。通过对比可视化结果,证明了TSARC在说话人日志任务中的有效性。

3 结束语

本文致力于解决说话人日志任务中环境噪声导致聚类性能下降的问题,提出了一种基于时间分段和重组聚类的说话人日志方法TSARC。与现有方法相比,所提方法通过将所有语音片段划分成多个时间段,在每个时间段内独立地进行局部聚类,以关注局部的特征分布,再对局部聚类结果进行合并,从而降低了噪声对聚类性能的影响。与此同时,通过考虑声纹嵌入的邻域信息,对嵌入间的相似度进行了校准,提高了亲和矩阵的准确性,进一步减少了噪声的干扰。最后,在公开数据集AMI SDM和VoxConverse上的实验结果证明了所提方法的有效性和先进性。尽管所提方法在性能上取得了一定的提升,但是仍然存在一定的改进空间。后续工作中,将考虑如何自适应地进行分段以及如何自适应地确定邻居数等方面的问题。

参考文献:

[1]Park T J,Kanda N,Dimitriadis D,et al. A review of speaker diarization: recent advances with deep learning [J]. Computer Speech & Language,2022,72: 101317.

[2]Yu Fan,Zhang Shiliang,Fu Yihui,et al. M2MeT: the ICASSP 2022 multi-channel multi-party meeting transcription challenge [C]// Proc of the 47th International Conference on Acoustics,Speech and Signal Processing. Piscataway,NJ: IEEE Press,2022: 6167-6171.

[3]Li Yanxiong,Wang Qin,Zhang Xue,et al. Unsupervised classification of speaker roles in multi-participant conversational speech [J]. Computer Speech & Language,2017,42: 81-99.

[4]Chetupalli S R,Ganapathy S. Speaker conditioned acoustic modeling for multi-speaker conversational ASR [C]// Proc of InterSpeech. 2022: 3834-3838.

[5]沈逸文,孙俊. 结合Transformer的轻量化中文语音识别 [J]. 计算机应用研究,2023,40(2): 424-429. (Shen Yiwen,Sun Jun. Lightweight Chinese speech recognition with Transformer [J]. Application Research of Computers,2023,40(2): 424-429.)

[6]Fujita Y,Kanda N,Horiguchi S,et al. End-to-end neural speaker diarization with permutation-free objectives [C]// Proc of InterSpeech. 2019: 4300-4304.

[7]Fujita Y,Kanda N,Horiguchi S,et al. End-to-end neural speaker diarization with self-attention [C]// Proc of IEEE Automatic Speech Recognition and Understanding Workshop. Piscataway,NJ: IEEE Press,2019: 296-303.

[8]Liu Y C,Han E,Lee C,et al. End-to-end neural diarization: From transformer to conformer [C]// Proc of InterSpeech. 2021: 3081-3085.

[9]曹洁,余丽珍. 改进的说话人聚类初始化和GMM的多说话人识别 [J]. 计算机应用研究,2012,29(2): 590-593. (Cao Jie,Yu Lizhen. Improved speaker clustering initialization and GMM multi-speaker recognition [J]. Application Research of Computers,2012,29(2): 590-593.)

[10]Kinoshita K,Delcroix M,Tawara N. Integrating end-to-end neural and clustering-based diarization: getting the best of both worlds [C]// Proc of the 46th International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2021: 7198-7202.

[11]Ning Huazhong,Liu Ming,Tang Hao,et al. A spectral clustering approach to speaker diarization [C]// Proc of the 9th International Conference on Spoken Language Processing. Piscataway NJ: IEEE Press,2006: 2178-2181.

[12]Wang Quan,Downey C,Wan Li,et al. Speaker diarization with LSTM [C]// Proc of the 43rd International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2018: 5239-5243.

[13]Park T J,Han K J,Kumar M,et al. Auto-tuning spectral clustering for speaker diarization using normalized maximum eigengap [J]. IEEE Signal Processing Letters,2019,27: 381-385.

[14]Dawalatabad N,Ravanelli M,Grondin F,et al. ECAPA-TDNN embeddings for speaker diarization [C]// Proc of InterSpeech. 2021: 3560-3564.

[15]Wang Hongji,Liang Chengdong,Wang Shuai,et al. Wespeaker: a research and production oriented speaker embedding learning toolkit [C]// Proc of the 48th International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2023: 1-5.

[16]Sell G,Snyder D,Mccree A,et al. Diarization is hard: some experiences and lessons learned for the JHU team in the inaugural DIHARD challenge [C]// Proc of InterSpeech. 2018: 2808-2812.

[17]Sell G,Garcia-Romero D. Speaker diarization with PLDA i-vector scoring and unsupervised calibration [C]// Proc of IEEE Spoken Language Technology Workshop. Piscataway NJ: IEEE Press,2014: 413-417.

[18]Lin Qingjian,Hou Yu,Li Ming. Self-attentive similarity measurement strategies in speaker diarization [C]// Proc of InterSpeech. 2020: 284-288.

[19]Kwon Y,Jung J W,Heo H S,et al. Adapting speaker embeddings for speaker diarisation [C]// Proc of InterSpeech. 2021: 3101-3105.

[20]Wang Jixuan,Xiao Xiong,Wu Jian,et al. Speaker diarization with session-level speaker embedding refinement using graph neural networks [C]// Proc of the 45th International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2020: 7109-7113.

[21]Wang Jie,Chen Zhicong,Zhou Haodong,et al. Community detection graph convolutional network for overlap-aware speaker diarization [C]// Proc of the 48th International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2023: 1-5.

[22]Singh P,Kaul A,Ganapathy S. Supervised hierarchical clustering using graph neural networks for speaker diarization [C]// Proc of the 48th International Conference on Acoustics,Speech and Signal Processing. Piscataway NJ: IEEE Press,2023: 1-5.

[23]Ryant N,Singh P,Krishnamohan V,et al. The third DIHARD diarization challenge [C]// Proc of InterSpeech. 2021: 3570-3574.

[24]Singh P,Ganapathy S. Self-supervised representation learning with path integral clustering for speaker diarization [J]. IEEE/ACM Trans on Audio,Speech,and Language Processing,2021,29: 1639-1649.

[25]Wei Yi,Guo Haiyan,Ge Zirui,et al. Graph attention-based deep embedded clustering for speaker diarization [J]. Speech Communication,2023,155: 102991.

[26]Ng A Y,Jordan M I,Weiss Y. On spectral clustering: analysis and an algorithm [C]// Proc of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic. New York: ACM Press,2001: 849-856.

[27]Liu Hongfu,Liu Tongliang,Wu Junjie,et al. Spectral ensemble clustering [C]// Proc of the 21st ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM Press,2015: 715-724.

[28]吴志敏,刘珍,王若愚,等. 面向移动App流量的多特征集合集成聚类方法研究与应用 [J]. 计算机应用研究,2019,36(10): 3101-3106. (Wu Zhimin,Liu Zhen,Wang Ruoyu,et al. Research and application of multi-feature sets based ensemble clustering method for mobile App traffic [J]. Application Research of Computers,2019,36(10): 3101-3106.)

[29]Zhong Zhun,Zheng Liang,Cao Donglin,et al. Re-ranking person re-identification with k-reciprocal encoding [C]// Proc of IEEE Confe-rence on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2017: 1318-1327.

[30]韩光,葛亚鸣,张城玮. 基于去相关高精度分类网络与重排序的行人再识别 [J]. 计算机应用研究,2020,37(5): 1587-1591,1596. (Han Guang,Ge Yaming,Zhang Chengwei. Person re-identification by decorrelated high-precision classification network and re-ranking [J]. Application Research of Computers,2020,37(5): 1587-1591,1596.)

[31]Carletta J,Ashby S,Bourban S,et al. The AMI meeting corpus: a pre-announcement [C]// Proc of the 2nd International Conference on Machine Learning for Multimodal Interaction. Berlin: Springer,2005: 28-39.

[32]Chung J S,Hun J,Nagrani A,et al. Spot the conversation: speaker diarisation in the wild [C]// Proc of InterSpeech. 2020: 299-303.

[33]Fiscus J G,Ajot J,Michel M,et al. The rich transcription 2006 spring meeting recognition evaluation [C]// Proc of the 3rd International Workshop on Machine Learning and Multimodal Interaction. Berlin: Springer,2006: 309-322.

[34]Nagrani A,Chung J S,Xie Weidi,et al. VoxCeleb: large-scale speaker verification in the wild [J]. Computer Speech & Language,2020,60: 101027.

收稿日期:2024-01-19;修回日期:2024-03-05 基金项目:国家自然科学基金重点资助项目(U1836220);国家自然科学基金面上项目(62176106);江苏省重点研发计划资助项目(BE2020036);江苏省研究生科研与实践创新计划资助项目(KYCX22_3668);江苏大学应急管理学院专项科研项目(KY-A-01)

作者简介:朱必松(1999—),男,江苏盐城人,硕士研究生,主要研究方向为说话人日志;毛启容(1975—),女(通信作者),四川泸州人,教授,博导,博士,主要研究方向为模式识别、情感计算(mao_qr@ujs.edu.cn);高利剑(1993—),男,江西九江人,博士研究生,主要研究方向为声音事件检测;沈雅馨(1999—),女,江苏苏州人,硕士研究生,主要研究方向为声音事件检测.