AI交互决定了隐私的感知、使用和开放

2024-09-24罗枫

摘 要: 在智能化的生活环境中,用户经常感到个人行为数据被泄露,这是为什么呢?这项研究提供了一个新颖的答案:这是由于AI设备采集个人信息并进行数据交互的主观感知。在这项研究中,重点提出了数据发生交互让用户感知到隐私暴露的影响程度。实验阐明了发生效应的原因:第一,更多数据交互(与隐私数据相关或无关)会导致担心和焦虑加剧,从而使用户感到隐私暴露更多,由此带来用户的隐私使用行为。第二,更多的数据交互会降低用户开放家庭隐私空间的意愿,并增加了获得更多资源的意愿。第三,嗅觉气味刺激干预措施,通过缓解担心和焦虑,可以减少数据交互带来的负面作用感知。研究结果为消费者、设备厂商和AI行业进行智能服务的创新提供了借鉴和参考。

关键词: 人工智能;数据交互;心理情绪;隐私感知;嗅觉刺激

中图分类号: F 713.5

文献标志码: A

AI Interaction Determines the Perception, Use and Openness of Privacy

Abstract: In an intelligent living environment, users often feel that personal behavior data is leaked. Why is this ? This study provides a novel answer : this is due to the subjective perception that AI devices collect personal information and perform data interaction. In this study, we focus on the extent to which data interaction allows users to perceive the impact of privacy exposure. The experiment clarifies the reasons for the effect : first, more data interaction ( related to or unrelated to private data ) will lead to increased worry and anxiety, so that users feel more privacy exposure, resulting in users ′ privacy use behavior. Second, more data interaction will reduce users ′ willingness to open home privacy space and increase their willingness to obtain more resources. Third, olfactory odor stimulation interventions can reduce the perception of negative effects of data interaction by alleviating worry and anxiety. The research results provide reference for consumers, equipment manufacturers and AI industry to innovate service models.

Key words: intelligent equipment; data interaction; psychological emotion; privacy perception; olfactory stimulation

0 引言

人工智能(AI)是当今极具潜力的创新,它在让人们享受到更便捷生活的同时,也产生了不可忽视的隐私安全问题。人工智能侵害隐私的后果非常严重,某智能家居品牌约30万名用户数据被泄露,某国际传统家居品牌用户资料被窃取……科技是为了让人的生活更美好,但越来越多的用户基础数据和隐私泄露事件,却时不时刺痛用户的神经。谷歌软件工程师宣布,人工智能聊天机器人的交谈使它已经有了“感知能力”。埃隆·马斯克警告说,超级智能机器可能会“接管世界”。

人工智能发挥效用往往需要大数据作为支撑,从人们衣食住行的选择、购物支付的方式,到人们在家庭生活中的行为,大数据无处不在。2020年“超级碗”的黄金时段,亚马逊为其智能语音助手“Alexa”推出一支广告,Alexa可以智能调控温度、播放音乐、说笑话、播放新闻、删除敏感信息等。而数据库还可以推算出一些个人信息,比如电商平台会根据用户的搜索记录、浏览记录、店铺收藏等来推荐相关商品的广告。在电商领域,淘宝、京东等购物网站利用算法对个体进行个性化商品推荐,以大幅促进销量。当前,人工智能为了增强自身的经济效益会不停地搜集用户信息,例如让用户注册会员时输入自己的手机号、生日、邮箱等信息,也有些软件运营商会在用户知情或不知情的情况下获取手机权限,继而获取用户信息。人们总是关注自己喜好的东西或接受让自己愉悦的资讯,久而久之就将自己置于“信息茧房”之中。

人工智能的日常应用越来越广泛,它既能带来生活的便利,又可能带来安全的隐患,技术赋能“人脸识别”的初衷,并不是让个人隐私“裸奔”。社交媒体用户一方面希望通过信息分享实现心理认同,另一方面又担心自己的隐私遭到泄露。大学生使用智能介质越频繁则越担忧个人隐私暴露,也进一步证实了明显的“隐私悖论”现象,即大学生一方面表示担心自己的个人隐私被泄露,但又主动披露大量的隐私信息。各种人工智能应用都在利用算法推送用户感兴趣的新闻、视频、商品等,人们最终在不断重复和自我演变中强化了隐私偏见和隐私限制。信息的过度采集是一种常见的隐私泄露途径。这些安全隐患如果被攻击者利用,将会侵犯用户在终端和云端的隐私数据。攻击者还可以通过网络设备控制智能家电的温度,或者更改家庭中设置的智能安防,从而造成人身安全的威胁和家庭财产的损失。基于心理感知者的角度,两个最基本的动机便是理解、预测和控制他人的行为,以及与他人建立社会联系,诱发这两个基本动机可以增强个体心智感知的程度。

大多数用户觉得他们没有充分的隐私安全。然而,尽管人们越来越对隐私暴露的后果感兴趣,但是对主要影响人们主观隐私感知的因素却知之甚少。这就提出了三个重要的问题:(1)为什么人们觉得隐私如此珍贵?(2)用户使用和评价他们隐私的行为可能会有什么结果?(3)如果有的话,我们能做些什么来减少这些负面影响呢?文章的四个实验将会去证明,设备之间的数据交互更多和更频繁,受到担忧和焦虑的驱使,用户会感到隐私暴露越多。

1 理论分析和研究假设

随着云计算、物联网、传感网等蓬勃发展,数据流通的领域也越来越广泛,最为重要的内容包括个人数据权和数据财产权,加强个人信息保护在大数据时代显得尤为迫切。无论是家庭私人信息,还是家居交互信息,都是智能家居设备采集、交互、连通的数据来源,也是用户担心和焦虑的核心要素。

1.1 数据交互和隐私感知

如果没有海量数据,无论是家庭中的智能扬声器还是个性化的书本推荐等,人工智能都不会取得惊人的成功。各种人工智能产品需要进入个人的私密空间甚至人体,才能收集或记录个人的行为、轨迹、偏好并通过运算发出指令,在多数场景下人工智能天然与隐私密不可分。酗酒、心理压力太大、长期食用高脂肪食物,或运动情况、睡眠质量、性生活频率等信息都会被生命健康芯片监测。情绪、多巴胺、肾上腺激素等反应,以及缕缕女友头发、亲密拥抱引发的体征与情绪的变化,也都会被生命健康芯片记录和监控。人工智能在经济新领域的应用,例如人工智能驱动的营销和自动驾驶汽车,正在推动越来越多的数据收集,而这些诱人的数据库目标可能增加侵犯隐私的风险。AI带来的隐私风险不仅来自大量个人数据收集,还来自深层神经网络模型,大约52%的数据泄露涉及黑客攻击。

人工智能具备与现实世界进行物理性数据交互的能力,进而可能给人们造成严重的人身和财产损害。但与此相反,人工智能也可以帮助缓解许多此类隐私问题。为了使社交型机器人更了解用户,从而实现高度智能的交互功能,用户需要对其完成初始“隐私设置”,包括输入生理信息、行为偏好、兴趣偏好等各种隐私信息。随着与社交型机器人交互的不断深入,最为私密的心理属性,以及用户最私密的信息都会被采集和深度学习。那些依赖社交活动、零售数据、金融行为、医疗健康、园区管理等敏感数据进行训练和推断的AI场景模型涉及更多的隐私。因此,提出如下假设:

H1:智能设备之间的数据交互越多,用户就越觉得隐私受到暴露或侵犯。

一般情况下,需要数据的一方希望最大限度开放数据,而提供数据的一方则担心自己隐私泄露。当人们感到隐私存在暴露时,特别是健康信息暴露,他们通常会感到焦虑担心,并采取一定的策略规避。移动通信和传感设备等位置感知技术推动了位置大数据的发展,由于内容交叉冗余,往往不能全面地保护用户隐私,在信息论意义上也关系到保护用户的敏感信息。事实上,隐私暴露或隐私泄露的经典定义常常让人联想到情绪和行为,比如“焦虑情绪”“发泄情绪”“潜水行为”“回避行为”。虽然这些先前的研究结果并没有具体说明因果关系,但它们确实表明担心焦虑通常伴随着隐私泄露。因此,提出如下假设:

H2:基本效应(H1)是由担心和焦虑的增加驱动的。

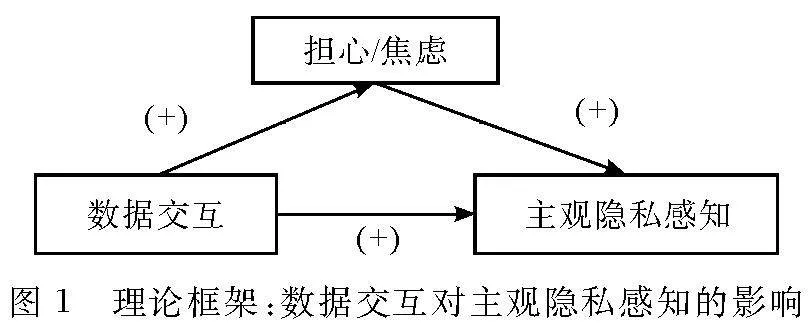

事实上,数据交互经常是因为泄露或者暴露了用户的隐私(可能是智能摄像头,也可能是智能音箱),但也可能是与隐私无关的原因,比如那些与空间有关的(例如智能扫地机清扫房间,智能洗碗机清洁碗筷)或与资源无关的原因(例如智能门铃的数据交互也关注用户的来访数据)。因此,通过增加担心和焦虑,我们预测感知到的数据交互应该让人们感到隐私暴露风险(图1)。

1.2 感知、使用和开放隐私的后果

感知数据交互增多,将会影响用户使用或开放他们隐私的方式,他们倾向于在后续数据交互上,增加隐私保护或减少隐私开放,包括生活数据、社交数据、健身数据等。例如,隐私暴露或被侵害的压力会减少人们使用智能音箱听歌曲的时长。智能硬件和APP软件的数据交互增加了用户对隐私暴露的担心,更多的数据交互会触发自身更多的敏感信息。基于这些发现,我们假定数据采集和数据交互都会涉及用户隐私,隐私暴露风险的感知应该会减少用户开放隐私的意愿。因此,提出如下假设:

H3a:更大量的数据交互会让用户更不愿意开放隐私(空间或数据)。

隐私暴露风险中不太明显的是,为什么感到数据交互更多?虽然不涉及隐私信息,也会有类似的感知效果。例如,智能扫地机的视频采集和智能洗碗机的饮食偏好采集之间进行数据交互也会增加担心和焦虑。因此,我们预测感知更复杂的数据交互(与隐私风险相关或者无关)同样让用户觉得他们的隐私风险更大,更不愿意开放其隐私和空间。此外,人们往往声称自己高度重视自身隐私保护,但若考察他们在行为上的表现,却发现他们往往毫不介意交出个人信息以换取类似小优惠小打折、购物赠品、免费试用等小恩小惠。保护隐私花费的精力和资源的多少,是衡量他们对隐私重视程度的真正标准,而把隐私和资源、便利的服务、更多的功能、访问空间等联合起来看,往往会鼓励用户认同资源是可互换的。因此,正如我们所期望的那样,察觉到更复杂的数据交互会导致用户支付更多的资源来降低隐私风险。因此,提出如下假设:

H3b:感知更复杂的数据交互使得用户更愿意交互更多的资源来降低隐私风险。

总之,当人们意识到更多和更复杂的数据交互时,他们应该感到更多的隐私风险,不太愿意开放访问空间,更愿意付出资源来降低隐私暴露风险。我们首先研究如何感知更多的数据交互,既与隐私相关,又与隐私无关,影响着用户的主观隐私感(实验一)。然后,我们揭示了所提出的驱动这一效应的潜在过程,并测试这种机制是否适用于各种智能设备和不同类型的数据交互(实验二)。接下来,我们选择考察数据交互对隐私暴露的影响,并阐明人们愿意开放多少访问空间的后续后果(实验三)。最后,我们确定了一种简单的干预措施,可以帮助用户减少数据交互带来的负面影响,并调查人们愿意为降低隐私风险而交换多少的资源(实验四)。

2 实验研究

2.1 实验一:数据交互让人觉得隐私风险

在实验一中,我们考察了感知更多数据交互是否会导致用户感到隐私紧张。所有测试者都列出了他们目前正在使用的两个智能设备:一半人列出了两个智能设备会暴露他们的数据隐私,而另一半人列出了两个没有具体关系的智能设备。我们的预测是涉及隐私暴露的智能设备与对照组相比,会使用户感到更多的隐私紧张(H1)。在一个实验中,测试者考虑两个数据交互涉及他们的隐私数据,在另一个实验中,测试者考虑两个彼此交互的隐私数据。与控制组相比,找到那些在非隐私数据交互条件下感到更多的隐私紧张的人,来支持我们的理论。

2.1.1 设计与方法

125名来自作者所在的西南两所高等院校的学生 (平均年龄26.56岁,男性占62.8%)参与了这项研究。有两个人没有完成分析并被排除在外(N=123)。测试者随机分组,分为四种情况:隐私交互、数据交互、一般交互、对照控制。

首先,我们操纵了对数据交互的感知。测试者列出经常使用哪些他们愿意使用的智能设备,并被要求列入他们的其中两个设备,具体说明列出的设备。在隐私交互的情况下,测试者读道:“请列出两个你认为彼此数据交互的设备,他们会采集你的隐私数据。”在对照控制的条件下,测试者简单地列出其中的两个设备。此外,在数据交互的分组中,测试者阅读:“请列出你的两个设备,你觉得设备之间会进行数据交互,因为它们都采集你的信息数据。”在一般交互条件下,测试者被要求列出数据交互的设备,并没有收到具体指示:“请列出你的两个设备是彼此有数据传输的。”

其次,我们测量了主观的隐私感知。测试者报告了他们的隐私是可扩展的、无限的、有限的,他们处在一个隐私紧张状态,以及他们没有足够的隐私,得分在1分至5分之间(1=一点也不,5=非常多),这些指标结合起来形成隐私感知指数(α=0.77)。

然后,作为操纵检验,我们测量了数据交互感知。测试者问:“你觉得你的两个设备之间有多少数据交互?”(1=交互量很小,7=交互量很大)。正如预期的那样,与对照控制组相比,所有三种交互条件都提高了数据交互感知。与对照控制组相比(M=2.34),测试者感知到隐私层面更多的数据交互,隐私交互组(M=5.46;F(1,123)=106.06,p<0.001),数据交互组(M=5.32;F(1,123)=99.27,p<0.001)和一般交互组(M=5.28;F(1,123)=79.04,p<0.001)。

2.1.2 结果

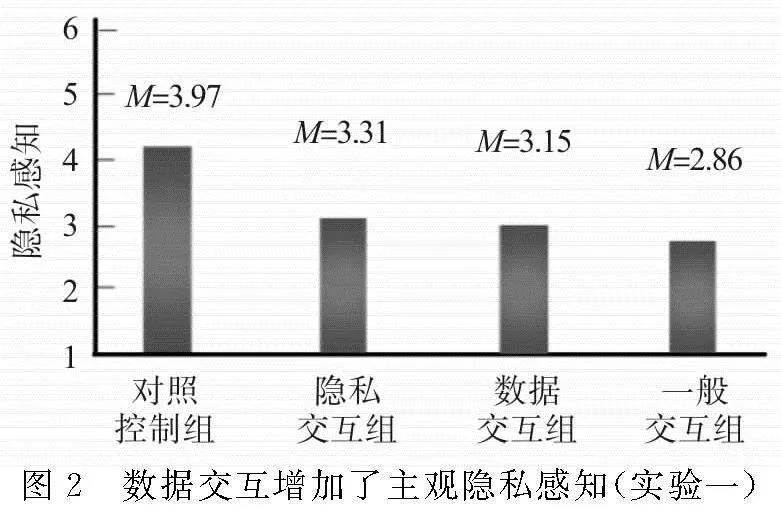

正如预测的那样,主观隐私感知的单因素方差分析表明,数据交互越多,隐私紧张感越强(F(3,123)=4.29, p<0.05,ηp2=0.100;图2)。相比对照控制条件下(M=3.97),测试者在列出两个设备具有隐私交互后,会感觉隐私暴露更多(M=3.31;F(1,123)=4.68, p<0.05,ηp2=0.041),而数据交互组次之(M=3.15;F(1,123)=3.47, p<0.05,ηp2=0.052),一般交互更普遍(M=2.86;F(1,123)=9.83, p<0.001,ηp2=0.088)。主观隐私感知在数据交互条件下没有显著差异(p’s>0.13)。

2.1.3 讨论

实验一的结果支持我们的第一个假设H1。测试者被引导到意识到数据交互越多,隐私感就越紧张。此外,这种效应出现在与隐私要求有关或无关的数据交互中。数据交互对主观隐私感知的影响适应于各种数据交互和数据交互类型,重要的是,多种类型的数据交互让人们感到隐私有限。虽然这些数据交互使人们觉得他们的隐私暴露更多,但这不能解释为什么出现了如此与隐私无关的数据交互模式。然而,压力和焦虑的增加却可以解释结果的全部模式(H2)。接下来,实验二直接测试这一潜在的机制。

2.2 实验二:担心和焦虑的潜在作用

第一,它直接测试的底层要素是压力和焦虑(H2)。在控制数据交互后,我们测量经历过的压力和焦虑,并检查它们是否起到了调节作用。第二,在实验一中,我们改变数据交互类型,数据之间的交互对主观隐私感知都带来了压力和焦虑的增加。实验二提出了我们发现的另一种解释,我们检验了数据交互的影响是否扩大那些根本不需要竞争资源的情况。例如,音乐和视频的数据交互,引起数据交互不是因为它们争夺隐私资源,而是因为一方会淡化另一方的发生。第三,实验二以不同的方式(隐私型、数据型或非资源型)操纵对数据交互的感知,让测试者回忆什么时间,他们经历过和没有经历过的某种数据交互。用这种方法复制我们实验一的过程,结果显示不是由数据交互里面的客观差异造成的。

2.2.1 设计与方法

236名来自西南两所高等院校和省属央企的测试对象(平均年龄为22.7岁,男性占57.3%)参与了这项研究。12个人没有通过测试被排除在分析之外(N=224)。测试者被随机分配到一个2(交互级别:高,低)×3(交互类型:隐私,数据,非资源)的测试环境中。

第一,我们操纵了数据交互类型。在隐私交互的情况下,设备是“智能摄像头”和“智能冰箱”。在数据交互条件里面,设备是“智能音箱”和“扫地机”。在非资源交互条件下,设备是“智能电灯”和“智能门铃”。

第二,我们操纵对数据交互的感知。在高度交互的情况下,当测试者感到前面提到的两个设备进行数据交互时(“智能摄像头”和“智能冰箱”,“智能音箱”和“扫地机”, “智能电灯”和“智能门铃”), 测试者描述其隐私情况。在低交互条件下,当他们觉得这两个设备之间没有数据交互时,测试者描述了其隐私情况。

第三,我们测量了压力和焦虑的感觉。测试者报告:“你现在感觉有多大压力?”以及“你现在觉得有多么焦虑?”都是1分到5分的比例(1=非常少,5=很多),结果这些指标高度相关(r=0.82)。

第四,我们测量了主观隐私感知。为了增加发现的普遍性,我们使用了与实验一中不同的问题。测试者暗示他们同意以下四种说法:“我有很多可用的隐私数据”“我有很多隐私领域可以进行数据交互”“隐私已经很少了”“我隐私感很强”。所有项目都是以5分制进行测量(1=非常不同意,5=非常同意),并结合形成隐私感知指数(α=0.88)。

第五,作为操纵检验,我们测量了数据交互感知。测试者被问道:“你觉得你的两个设备之间有多少数据发生交互?”(1=交互很小,5=很多交互)。正如预期的那样,高交互组(相对于低组)表现出更多的数据交互。相比之下,低数据交互的条件(M=3.17)下,当采集隐私数据的设备(M高=4.87 vs. M低=3.59;F(1,224)=40.01, p=0.001)和采集数据资源的设备(M高=4.46 vs. M低=3.07;F(1,224)=18.16,p<0.001),以及不抢夺数据资源的设备(M高=4.25 vs. M低=2.63;F(224)=14.87,p<0.001)三种情况发生时,测试者也会感知到更多的隐私交互(M=4.58)。

2.2.2 结果

隐私感知。2(数据交互)×3(交互类型)主观隐私感知方差分析仅揭示了交互水平的预期主要影响(F(1,224)=12.08,p<0.001,ηp2=0.043),与数据交互类型无交叉作用(F<1;图3A)。总的来说,在描述了一个他们感到设备之间有数据发生交互的例子后(M=4.12),测试者觉得他们的隐私暴露更多了,而没有交互的情况为(M=3.36)。在隐私数据(M高=4.37 vs. M低=4.01;F(1,224)=4.74, p=0.05,ηp2=0.023)、数据资源(M高=4.16 vs. M低=3.78;F(1,224)=4.33,p<0.05,ηp2=0.021)以及非资源竞争(M高=4.09 vs. M低=3.61;F(1,224)=4.05,p<0.05,ηp2=0.018)的采集情况下,H2得到了验证。

压力和焦虑。2(感知交互)×3(交互类型)的压力和焦虑方差分析,显示了跟主观隐私感知相同的情况(F<1;图3B)。在隐私数据、数据资源以及非资源竞争的采集情况下,感到差异压力和焦虑的假设得到了验证。中介。我们使用了偏差校正,压力和焦虑的间接影响产生95%的置信区间(Hayes 2009),分析显示存在显著间接效应(ab=-0.26;95%CI:-0.37~-0.16)。正如预测的那样,数据发生交互会让他们增加压力和焦虑,随后也会让测试者(隐私交互组、数据交互组和非资源交互组)感觉隐私风险更强烈。

2.2.3 讨论

实验二为预测数据交互影响隐私风险感知提供了进一步的证据。当被引导去感知数据交互时,测试者感到他们隐私空间更小(H2)。而我们在操作采集隐私信息、采集共享信息以及采集一般信息的数据交互的情况时,都会出现交互越多,隐私忧虑就越多。这个实验也为压力和焦虑的潜在作用提供了直接的支持,即感知到更多不同的数据交互(隐私有关或隐私无关),触发了他们的压力和焦虑,虽然没有更高的隐私需求或者共享需求,还是增加了测试者的主观隐私感知(H2)。

2.3 实验三:在数据交互和开放隐私后果之间做出选择

首先,我们使用不同的数据交互操作。根据之前工作的范例(Luce, 1998),我们要求测试者选择一款智能监控设备,设备相关属性(房屋空间安全和造成的信息泄露)是否负相关,当测试者选择属性负相关时,我们预计他们会觉得隐私紧张。其次,我们测试在主观隐私感知上是否具有中介作用,并测量了隐私安全程度,这可以凸显出数据交互和隐私感知之间是由压力和焦虑驱使的。最后,我们研究了用户感知到多方的数据交互,是否会使得他们更不愿意透露隐私信息(H3a)。在选择了一款智能监控设备之后,测试者被告知他们使用这个监控设备需要对房屋内隐私进行扫描和监控,然后问他们愿意开放哪些空间进行监控。

2.3.1 设计与方法

56名来自省属央企,省、地市和区县三级公司的员工以及合约家居客户(平均年龄为30.8岁,男性占49.6%)参与了这项研究,由于智能家居客户存在重叠,所以对实验对象进行了二次筛选,一是满足家庭宽带合约,二是智能设备超过2个。随后,测试者被随机分配到多数据与少数据的交互情境中。

第一,所有测试者都观看了四组监控设备的一系列选项,涉及价格、使用要求、款式和带来的安全,并被要求在这些属性之间进行选择。在多数据交互的情况下,房屋监控安全选项方面评价高低和信息泄露差是一致的。在少数据交互的情况下,只有一个监控设备在房屋安全和信息泄露两个方面有好的评价。第二,测试者报告他们当前的压力和焦虑(r=0.71)和主观隐私感知(α=0.67)。第三,测试者读到他们选择的监控设备需要先进行信息扫描和数据交互,他们必须开启房屋空间进行数据采集和场景配置,这些监控设备才能很好地监控。他们被问到愿意开放或者付出多少资源进行互换,以获得家居设备更好的使用(Kolmogorov-Smirnov Test=0.29,p<0.001)。第四,测试者报告他们同意的程度(1=完全不同意,5=完全同意)。例如:“我经常愿意共享自己的资料或者信息给其他人”“我没法共享任何资料给其他人(逆得分)”和“我已经能够把喜欢的游戏共享给别人了”(α=0.79)。测量题项来自资源测量量表。第五,作为操作检查,测试者被问到:“在多大程度上,这个选择使你觉得存在数据交互?”(1=一点也不,7=非常存在)。

2.3.2 结果

隐私感知。主观隐私感知的单因素方差分析结果为F(1,56)=4.71,p<0.05,ηp2=0.066。在选择更多的数据交互(M=4.60)和较少的数据交互(M=3.72)的选项后,测试者觉得他们的隐私暴露更多了。压力和焦虑。压力和焦虑的单因素方差分析结果跟隐私感知一致,测试者同样感到更多的压力和焦虑。中介。与实验二一样,使用偏差校正测试,体验更多数据交互会增加压力和焦虑(95%置信区间),测试者也会感到隐私风险更大。使用隐私的后果。在诱发更多数据交互的选项(M=1.24)和诱发更少数据交互的选项(M=1.35)之间做出选择后,测试者愿意开放更多的隐私空间。

2.3.3 讨论

实验三演示了数据交互对用户开放隐私空间的影响,经历更多数据交互往往会减少测试者开放隐私空间(监控)。因此,除了影响人们如何看待他们的隐私,数据交互也会影响他们如何利用隐私。

2.4 实验四:嗅觉刺激底层操作

实验四进一步通过直接操作这些感觉探讨压力和焦虑的潜在作用。如果强烈的数据交互让人们增加压力和焦虑,并感觉隐私紧张,那么该如何操纵压力和焦虑来减弱这种效果?之前的研究表明,一种方法是味觉和嗅觉刺激,大脑通过视觉、听觉、嗅觉等感官通道接收来自外界的信息,嗅觉刺激对缓解压力和焦虑具有很好的作用。气味和情绪、记忆有着直接的联系,接触各种不同类别的气味,有助于个体在压力情境下情绪恢复和改善。由此,操纵数据交互的感知后,我们要求一半的测试者在开始前进行嗅觉刺激,然后再测量他们的隐私状况感知。我们预测当数据交互更多的时候,这种嗅觉刺激的任务可以减轻压力,恢复测试者的隐私担忧感。

2.4.1 设计与方法

在西南四所高等院校招募了110人参与这项研究(老师和学生的平均年龄为25.1岁,男性占49.6%)。测试者被随机分配到2(数据交互:交互vs.控制)×2(感官刺激:嗅觉vs.控制)条件中。

第一,我们操纵了数据交互的感知。在数据交互条件下,测试者读到“请列出两个你觉得在家中可能发生数据交互的设备”,在控制条件下,测试者只需要列出两个家居设备。第二,我们控制嗅觉感官刺激。在气味嗅觉刺激的环境中,我们采用了气味王国公司推出的数字气味产品,以此来模拟各类缓解和舒缓气体,包括自然、食物、特殊和日用等四类。在对照条件下,测试者吃了几种不同类的食物,包括香蕉、苹果、草莓、菠萝和芒果,并完成了数字气体的刺激和舒缓。我们预计,嗅觉刺激可以通过压力和焦虑来减少主观隐私感知的忧虑。第三,使用与实验二和实验三相同的测量方法,测试者报告他们的压力和焦虑感(r=0.81),其次是主观隐私感知(α=0.82)。

2.4.2 结果

隐私感知。2(数据交互)×2(感官刺激)ANOVA分析,显示预测的相互作用(F(1,110)=4.83,p<0.05,ηp2=0.044;图4A)。在控制嗅觉刺激的条件下,实验验证了与简单列出两个设备交互相比(M=4.25),考虑两个设备会发生数据交互,测试者会感觉到更多的隐私风险(M=3.38;F(1,110)=4.18,p<0.05,ηp2=0.47)。同时,感官嗅觉刺激减弱了这种效果。此外,数据交互条件下,感官嗅觉刺激会显著降低他们的主观隐私感知(M刺激=4.19 vs. M控制=3.49;F(1,110)=4.05,p<0.05,ηp2=0.037),对照控制条件下没有相应的影响(M刺激=3.86 vs. M控制=4.19;F<1)。

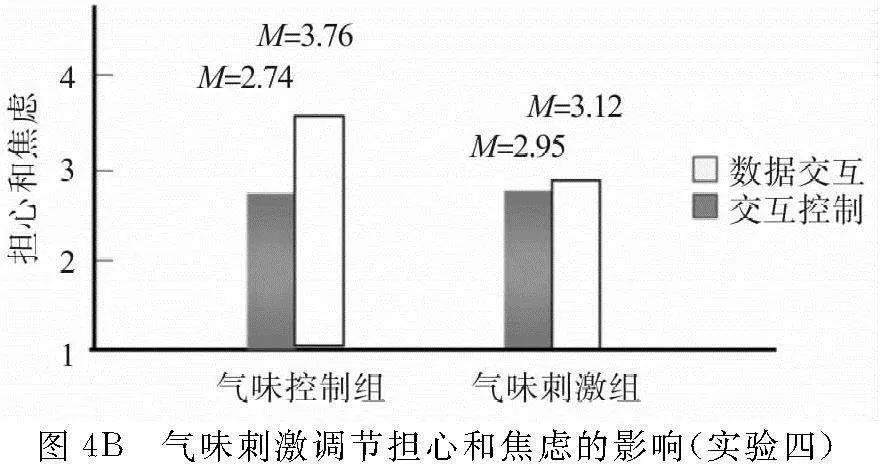

压力和焦虑。压力和焦虑的单因素方差分析结果跟隐私感知一致,测试者(数据交互组和对照组)同样感到更多的压力和焦虑,而气味刺激减弱了这种交互影响(M控制=2.95 vs. M交互=3.12;F<1;图4B)。中介。与实验二、三一样,使用偏差校正测试,在对照条件下,间接效应显著(ab=-0.41 [-0.73,-0.13]),气味嗅觉刺激现在调节了这个效果(β=0.37 [0.06,0.88])。

2.4.3 讨论

实验四为压力和焦虑的潜在作用提供了进一步的证据。当感知更多的数据交互时,鼓励测试者通过气味嗅觉刺激来缓解隐私焦虑。重要的是,当数据交互引起了压力和焦虑时,感官气味嗅觉刺激可以恢复人们的隐私焦虑感知,特别是当数据交互很严重时,这种刺激更是一种简单有效的方法。

3 研究结论

四个实验都集中在一个关键因素上:智能设备之间数据交互感知。研究发现,感知数据交互越多,会使用户感到隐私暴露越多,这是担心和焦虑增加造成的。本文为这一机制提供支持,当数据交互更多的时候,引入担心和焦虑的缓解手段,会减少用户对主观隐私的感知,并减少数据交互对后续的影响。

3.1 理论贡献

本研究主要有四个贡献。第一,我们的研究证明了智能家居设备之间的数据采集、数据交互与主观隐私感知具有因果关系。第二,智能设备之间数据交互感知不仅涉及个人的隐私保护,也涉及人们如何看待、使用和开放他们的隐私。第三,感知到更多的或多种类型的数据交互,无论是否与个人隐私有关,都会增加担心和焦虑,并让人们觉得隐私有暴露的风险。第四,数据交互的风险会阻碍用户全面和深入地使用智能设备,原因在于,更复杂的数据交互感知让人们感觉隐私暴露的风险更大和急迫性更强。研究显示了逆向因果路径,即智能设备之间的数据交互如何影响主观隐私感知,这些发现提示我们后续如何进行智能设备的使用以及如何更好地开放数据和使用隐私。

3.2 实践贡献

首先,用户可能会高度评价隐私风险小的智能设备和服务(不涉及个人信息输入的厨房设备、没有网络交互的智能电风扇等),当他们认为这些设备出现更加复杂的数据交互的时候,他们愿意以资源互换来获得这些设备更深层次的使用和体验。其次,有些情况用户需要开放不同程度的隐私信息和数据,如智能音箱、智能健康仪、智能台灯等,只有引入担心和焦虑的缓解手段,去减轻用户对主观隐私的感知,才能促使用户对智能设备充分使用。紧接着,当出现复杂的数据交互时,在私密的空间或者房间里面,用户往往不太愿意去充分使用智能摄像头或网络连接设备(如智能直播设备或智能门窗),这会阻碍他们对新智能设备购买、使用和体验的行为,只有利用好隐私干扰和缓解手段才能更好地实现设备或产品使用者的保留和挽留。另外,隐私风险对消费者健康也有害,如生活满意度降低和较差的健康结果(例如睡眠困难、不健康的饮食和抑郁)。

为此,营销人员可以鼓励人们“闻一闻理想气味”,或者给这种场景贴上标签而促使焦虑变得不那么明显(例如“智能摄像头让你的家变得更加安全”)。

3.3 未来研究展望

首先,未来的工作可以检查设备数据交互对公共安全行为的影响。事实上,辅助数据为这一观点提供了初步支持。研究发现当感知到数据交互更复杂的时候,测试者往往不太愿意开放更多的房屋空间给各类智能设备(比如安全设备)去采集数据和交互数据。未来的工作可能会探索其他智能设备之间的数据交互如何影响不同的隐私开放带来的公共安全行为。其次,未来的工作需要探索不同用户的情况。例如,有些人可能就会比其他人经历更多的担心和焦虑。这一途径可能有助于识别其他干预措施(例如增强自我效能),这可能会减少设备数据交互的有害影响。

最后,未来的研究还可以检验设备数据的多样性和多组合性,比如智能网络套件。用户不仅关注智能设备的数据交互,还关心不同网络套件之间的数据采集和交互,当多个智能设备集体出现这种情况的时候,隐私暴露和隐私空间的情况都是值得探索的问题。

参考文献:

[1] BRYNJOLFSSON E, LIU M, DOWLATABADI J. Do digital platforms reduce moral hazard? the case of uber and taxis[J]. Management Science, 2023(12):132-142.

[2] CHEN S H, QIU H, ZHAO S F. When more is less: the other side of artificial intelligence recommendation[J]. Journal of Management Science and Engineering, 2021(15):201-226.

[3] 彭兰.导致信息茧房的多重因素及“破茧”路径[J].新闻界,2020(1):30-38,73.

[4] HI HUANG S C, JENNIFER A. It’s the journey, not the destination: how metaphor drives growth after goal attainment[J].Journal of Personality and Social Psychology, 2019, 117(4): 697-720.

[5] SPENCE M. Some thoughts on the washington consensus and subsequent global development experience[J]. Journal of Economic Perspectives, 2021, 35(3):67-82.

[6] 徐敬宏, 侯伟鹏, 程雪梅,等. 微信使用中的隐私关注、认知、担忧与保护:基于全国六所高校大学生的实证研究[J]. 国际新闻界,2018,40(5):160-176.

[7] DUC T C, TRUNG N T. Health vs. privacy? The risk-risk tradeoff in using COVID-19 contact-tracing apps[J]. Technology In Society,2021,67.

[8] 江红艳, 王海忠. 人工智能时代下的消费者权益保护[J].人民论坛,2023,756(5):66-69.

[9] EPLEY N, WAYTZ A, CACIOPPO J T. On seeing human: a three-factor theory of anthropomorphism[J]. Psychological Review, 2007(114): 864-886.

[10] HASHIM J, BAKAR A A. The practice of corporate downsizing during economic downturn among selected companies in malaysia[J]. Asia Pacific Management Review, 2022,11(6):101-118.

[11] 齐爱民, 盘佳. 数据权、数据主权的确立与大数据保护的基本原则[J]. 苏州大学学报(哲学社会科学版), 2015, 36(1):64-70.

[12] 史卫民. 大数据时代个人信息保护的现实困境与路径选择[J]. 情报杂志,2013(12):155-159,154.

[13] 谢尧雯. 基于数字信任维系的个人信息保护路径[J].浙江学刊,2021, 249(4):72-84.

[14] 许天颖. 数据智能化规训:可穿戴设备的隐私风险与保护[J].江西社会科学,2022,42(12):162-170.

[15] SMITH C, ULUS E. Who cares for academics? We need to talk about emotional well-being including what we avoid and intellectualize through macro-discourses[J]. Organization,2019.

[16] HAJIAN S, DOMINGO-FERRER J, FARRAS O. Generalization-based privacy preservation and discrimination prevention in data publishing and mining[J]. Data Mining and Knowledge Discovery, 2014,28(5/6).

[17] CORBET S, GURDGIEV C. What the hack: systematic risk contagion from cyber events[J]. International Review of Financial Analysis,2019,65(C).

[18] 田贤鹏. 隐私保护与开放共享:人工智能时代的教育数据治理变革[J].电化教育研究,2020, 41(5):33-38.

[19] CHATZIMICHALI A, HARRISON R, CHRYSOSTOMOU D. Toward privacy-sensitive human–robot interaction: privacy terms and human–data interaction in the personal robot era[J]. Paladyn, Journal of Behavioral Robotics,2020,12(1).

[20] 王辉, 刘玉祥, 曹顺湘,等.融入区块链技术的医疗数据存储机制[J].计算机科学,2020, 47(4):285-291.

[21] PADMASHREE G S. Governing artificial intelligence in an age of inequality[J]. Global Policy,2021,12.

[22] 杨庆峰. 数据共享与隐私保护:一种技术方案的哲学论证[J]. 自然辩证法研究,2018, 34(5):111-116.