基于双策略图卷积网络的方面级情感分析

2024-03-25孙赫文孟佳娜丁梓晴

孙赫文,孟佳娜,丁梓晴,江 烽

(大连民族大学 计算机科学与工程学院 辽宁 大连 116650)

基于方面的情感分析是一种细粒度的情绪分类任务[1],旨在推断出整句话中某一方面的情绪极性(positive、neutral或negative)。与句子级情感分析不同,一个句子可能有多个方面,不同的方面可能有不同的情感词和情感极性。因此,有必要挖掘与方面词相关的情感词来预测其情绪极性。

近年来,可以捕获句法依赖关系的图神经网络被探索建模方面词和情感词之间的联系。因此,张等人[2]利用GCN学习句法依存图上的节点表示,得到融合句法依存信息的上下文特征用于情感分类。Tang等人[3]通过重塑句法依存树得到一个面向方面词的图结构,并利用关系图卷积网络对重塑后的句法树进行编码判断方面词的情感倾向。

然而,大多数的研究在将句法依赖关系应用到复杂数据集的ABSA任务时,就会面临两个问题。依赖关系解析结果不准确,而且忽略了不同依赖关系所产生的不同影响;对于依赖关系不敏感的数据集,由于非正式表达和在线评论的复杂性,方面词的分类效果往往很差。

针对上述问题,本文提出了一种结合句法信息和词共现信息的图卷积网络方法对方面级情感分析任务。通过使用提出的基于双策略图卷积网络模型的方法可以提升三个公共数据集的情感分类效果。

1 相关工作

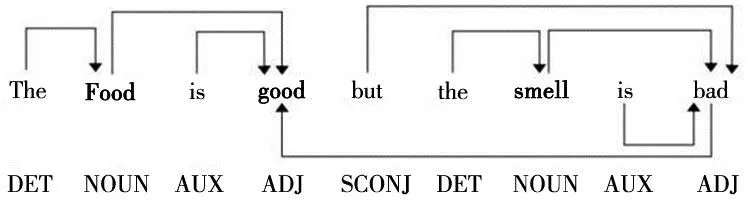

句法依存树在实体抽取、文本分析,命名实体识别、情感分析、智能问答等领域有着广泛的应用[4]。使用依赖解析工具对文本数据进行预处理,构建句法依存图已经成为ABSA任务数据预处理的主流方法。句法依存图展示了句子中各词之间的句法依赖关系,图中每一条边都有自己的标签,不同标签代表不同依赖关系。例如依照句子“The Food is good but the smell is bad”构造的句法依存图如图1。

图1 句法依存图

“DET”标签代表决定词,图中带有“DET”标签的有向边从定冠词“the”指向方面词“Food”,就代表“Food”的决定词是“the”。

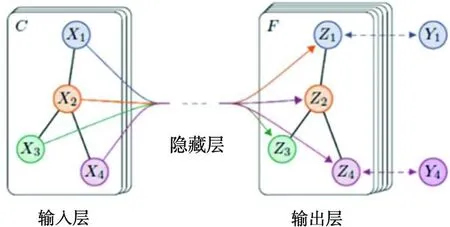

引入句法依存图建模有利于处理长文本数据,解决长距离依赖问题。因此,Dong 等人[5]提出了一种递归神经网络,沿着依赖树自适应地将单词的情感传播到方面。Nguyen等人[6]引入了一个包含句法信息的注意力模型来计算注意力权重。Phan等人[7]利用句法依赖树探讨了句法关系,并运用自注意机制进行句法学习。近两年,在传统卷积神经网络(CNN)和图嵌入的驱动下,GCN作为高效的CNN变体,其可以直接在图上运行[8],其模型如图2。

图2 GCN模型结构图

(1)

式中:Wl为权重矩阵;bl为偏置项;σ为激活函数。

2 本文方法

本文设计了双策略图卷积网络(Dual-SGCN)模型以解决上述问题。首先,本文使用依赖解析器中反映所有依赖关系的概率矩阵来构建一个基于句法的图卷积网络(Syntactic GCN)。这种方法背后的思想是,与依赖解析器的最终离散输出相比,表示单词之间依赖关系的概率矩阵包含丰富的句法信息。其次,利用自注意机制构建了基于词共现的图卷积网络(Word co-occurrence GCN)。这种方法背后的思想是,由自注意力形成的注意力矩阵,可以被视为一个边加权无向图,它反映了单词对之间词共现的频率,无向图的每条边均会被赋予一个词共现标签,记录了训练中被该边连接的单词对出现在同一句子中的频率,进而表示单词对的相关性。

具体而言,给出句子-方面对(s,a),将长度为n的句子评论表示为s={w1,w2…wn},长度m的方面词表示为a={a1,a2…am},它也是整个句子s的子序列。同时,方面词可能是一个单词也可能是多个单词组成的短语。利用BiLSTM提取隐含上下文表示,对于BiLSTM编码器,首先从嵌入查询表E∈R|v|xde中得到句子s的单词嵌入x={x1,x2…xn},其中|V|为词汇量,de表示单词嵌入的维数。然后,将句子的单词嵌入信息输入BiLSTM,生成隐藏状态向量H={h1,h2…hn},其中hi∈R2d是从BiLSTM得到的t时刻的隐状态向量。再将隐藏表示分别输入SynGCN和WcoGCN模块,然后采用BiAffine方法实现有效的信息交流。最后,将SynGCN和WcoGCN模块中所有方面词节点的表示通过池化和连接聚合,形成最终的方面表示。整体模型框架图如图3。

图3 整体模型框架图

2.1 基于句法结构的图卷积网络模型

SynGCN模块以句法编码作为输入。为了对句法信息进行编码,本文利用了依赖解析器中反映所有依赖关系的概率矩阵。与依赖解析器的最终离散输出相比,反应所有依赖关系的概率矩阵可以通过提供所有潜在的句法结构来捕获丰富的结构信息。在这里,本文使用最新的依赖解析模型LAL-Parser[10]。

2.2 基于词共现信息的图卷积网络模型

WcoGCN不像SynGCN,后者一般是依靠额外的句法知识,前者则利用Self-attention并行计算每个单词对的注意分数[11],从而获得邻接矩阵形式的注意力矩阵,表示为Awco∈Rn×n,然后将注意力分数矩阵Awco作为WcoGCN模块的邻接矩阵,表示为

(2)

同时,前文中所获得的注意力矩阵Awco也会被视为一个边加权无向图。图中的每个单词均会与其他单词有一条直接相连的边,这种全连接关系储存在本文所构造的邻接矩阵中,为了体现单词之间的语义相关性,每个单词对之间的连接的边均会被赋予一个词共现标签,它记录了在训练集中被该条边连接的单词对出现在同一句子中的频率。为了避免词共现标签特征过于离散,本文对词共现频率进行分组:当单词对的共现频率等于20和21时,连接该单词对的边将会被标记为f0和f1;当单词对的共现频率范围在[2k,2k+1](1≤k≤5)时,词共现标签则分别对应f2,…,f6,以句子评论“Food was okay,just so so ”为例,其带有词共现标签的加权无向图如图4。

图4 词共现图

因此,利用自注意力机制可以捕获句子中每个词的语义关联词,确定单词对的词共现频率,比句法结构更灵活。WcoGCN可以适应对句法信息不敏感的在线评论。

为了有效交换SynGCN和WcoGCN模块之间的相关特征,本文采用了BiAffine变换作为桥梁。流程如下公式:

(3)

(4)

式中,W1和W2是可训练参数矩阵,最后在SynGCN和WcoGCN模块的方面节点应用平均池化和连接操作。这样,就得到了ABSA任务的最终特征表示:

(5)

(6)

(7)

其中f(·)是在方面节点表示上应用的平均池化函数。将得到的表示γ送入一个线性层,再通过一个softmax函数得到情感概率分布P。

P(a) = softmax (Wpλ+bp)。

(8)

其中,Wp和bp都是可学习权重和偏置。

2.3 正则化器

为了精确化词共现特征,本文参考Li等人[12]设计了两个正则化器来增强WcoGCN模块。因此,在WcoGCN模块的注意力分数矩阵上加入了一个正交正则化器,来减少不相关语义的干扰。此外,WcoGCN模块应该能够学习到不同于句法表示的词共现信息。因此,在SynGCN和WcoGCN之间引入了差分正则化的算法。

每个单词的相关词应该在句子中的不同区域,所以注意力分数的分布应该很少重叠。因此,所有单词的注意力得分向量之间应该是正交的。对于前文中给定的注意力得分矩阵Awco∈Rn×n,正交正则化器的表达式如下:

(9)

式中,I是一个单位矩阵,下标F表示Frobenius范数。所以,AwcoAwcoT各非对角元素最小化,从而维持矩阵Awco正交。

为了从SynGCN和WcoGCN学习到的两种类型特征表示能够体现包含在句法依赖树和词共现相关性中的不同信息。因此,本文在上述两大模块的邻接矩阵间引入了差分正则化器,且该差分正则化器只约束WcoGCN。表达式如下所示:

(10)

3 损失函数

本文模型最终的损失函数计算如公式(11)所示:

(11)

式中:λ1,λ2,λ3为正则化系数;Θ为所有可训练模型参数;lC是标准的交叉熵损失。计算如公式(12)所示:

(12)

式中,S包含所有的句子和方面对,C是不同情绪极性的集合。

4 实验结果与分析

4.1 数据集

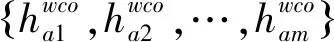

本研究在三个公共标准数据集上开展实验。分别是Rest14,Lap14和Twitter的数据集,Rest14和Lap14来自SemEval ABSA公开挑战赛[13]。此外,Twitter数据集是推文的集合。这三个数据集都有三种情绪极性:积极、消极和中性。这些数据集中的每个句子都用标记的方面及其对应的极性进行了注释。这三个数据集的统计数据见表1。

表1 数据集统计表

4.2 实验细节

对于本文实验,运用预训练的300维Glove[14]向量,从而实现初始化单词嵌入的目标。单词嵌入的维数设为30,然后将它们输入到BiLSTM模型中,该模型的隐藏大小设置为50。为了减少过拟合,对BiLSTM的输入词嵌入应用dropout,其速率为0.7。SynGCN和WcoGCN模块的dropout速率为0.1,SynGCN和WcoGCN层数为2层。全部的模型权值都进行相应的均匀分布初始化。本次研究中所运用的Adam优化器,实际设定的学习速率参数是0.002。Dual-SGCN于50个epoch之中开展训练处理,设定具体的批处理数据是32。将三个数据集的正则化系数λ1和λ2分别设为(0.3,0.2)、(0.2,0.2)和(0.2,0.3),λ3设为10-4。

4.3 基线方法

为了验证本文模型的有效性,将本文模型与一下方面级情感分析方法进行对比分析。

1) RAM[15]:使用多种注意和记忆网络学习句子表征。

2) TNet[16]:设计一个多粒度的注意机制捕获方面和上下文之间的字级交互。

3) ASGCN[17]:首先提出使用GCN学习面向方面的表示来进行面向方面的情感分类。

4) CDT[18]:在依赖树上使用GCN来学习带有句法信息的方面表示。

5) BiGCN[19]:采用层次图结构集成词共现信息和依赖类型信息。

6) R-GAT[20]:提出了一种面向方面的依赖树结构,然后用关系GAT对新的依赖树进行编码。

4.4 实验结果

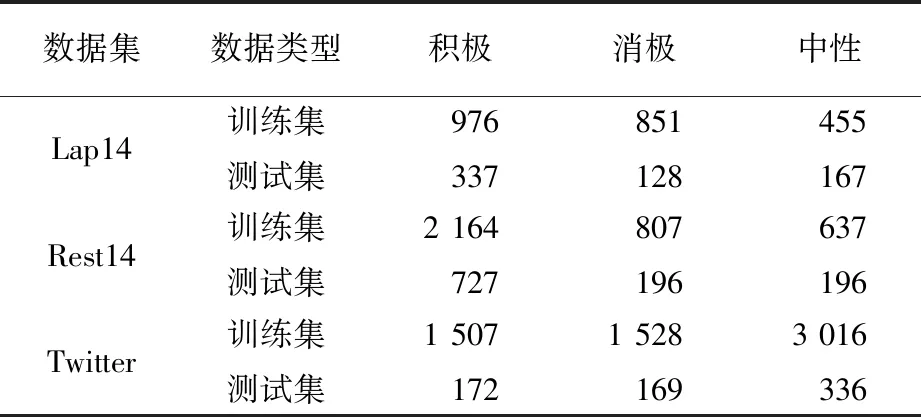

为评估ABSA模型,应用准确率(Acc)、F1值为主要指标。在Rest14、Lap14和Twitter数据集上,本文的Dual-SGCN模型始终优于所有基于注意力和句法的方法。这些结果表明,本文的Dual-SGCN能够有效地整合句法知识和词共现信息。Dual-SGCN与RAM和TNet等以注意为基础的方法进行对比,本文模型依靠句法知识来构建对应的依赖关系,从而规避注意机制导入的噪声。除此之外,以句法为基础的方法,如ASGCN、CDT、BiGCN、R-GAT等,虽然比基于注意的方法有更好的性能,但是其忽略单词对的联系。考虑到非正式或复杂的句子时,仅运用句法知识会造成表现不理想。主要实验结果见表2。

表2 Dual-SGCN及主流ABSA方法在三个数据集的比较 %

4.5 消融实验

为了进一步研究各模块在Dual-SGCN模型中的作用,本次实验进行了消融研究。SynGCN-模型只使用依赖解析器的离散输出来构造GCN的邻接矩阵。相反,SynGCN利用在依赖解析器中生成的概率矩阵作为邻接矩阵。在Restaurant和Laptop数据集上,SynGCN模型的性能优于SynGCN-,这表明丰富的语法知识可以减轻依赖解析错误。WcoGCN模型利用自注意层构造词共现图的邻接矩阵。这个WcoGCN模型在Twitter数据集上的表现优于SynGCN,因为与Restaurant和Laptop数据集相比,Twitter的评论在很大程度上是对语法信息不敏感的。Dual-SGCN w/oRO&RD表示去掉了正交正则化和微分正则化。类似地,Dual-SGCN w/oRO或RD表示只删除一个正则化器。实验结果表明,本文提出的两种正则化方法能够促进Dual-SGCN准确捕获语义相关性。总的来说,Dual-SGCN模型所有模块都被实验证实其发挥的作用。消融实验结果见表3。

表3 消融实验研究结果 %

4.6 最佳GCN层数分析

为了探究GCN层数这一关键超参数对于网络性能的影响,本节设计了模型中图卷积层数从1~8时在三个数据集上的对比实验,实验结果如图5。

(a)GCN层数对准确率的影响

实验结果表明,GCN层数设置为2时,网络的性能达到最优,准确率(Acc)与F1值两项指标均达到最高。图卷积层数的持续增加导致实际性能下降。当图卷积层数相对较少时,节点表示无法实现远距离的传播,限制了信息的传递范围。然而,当层数过多时,由于梯度消失和信息冗余等实际存在的问题,模型变得非常不稳定,导致过拟合的现象加剧。因此,需要在选择图卷积层数时进行权衡,避免使用过多的图卷积层,以免影响模型的性能。正确的层数选择可以在保持信息传递范围的同时避免过拟合的问题,从而提高模型的鲁棒性和泛化能力。

5 结 语

提出一种Dual-SGCN模型架构,以解决基于注意力和基于句法依赖的ABSA任务方法的缺点。Dual-SGCN模型通过SynGCN和WcoGCN模块集成了句法知识和词共现信息。此外,为了有效地捕获单词之间的词共现信息,从而提高语义相关性,本文在两个模块间提出了正交正则化和差分正则化。这些正则化器可以处理句法和词共现相关的项,每个词的重叠较少,并捕获不同于句法结构的特征表示。在三个公共数据集上的实验表明,本文的Dual-SGCN模型优于其他对比模型,提高了准确率。