基于跨模态注意力融合的煤炭异物检测方法

2024-03-01曹现刚李虎王鹏吴旭东向敬芳丁文韬

曹现刚, 李虎, 王鹏, 吴旭东, 向敬芳, 丁文韬

(1. 西安科技大学 机械工程学院,西安 710054;2. 陕西省矿山机电装备智能检测重点实验室,西安 710054)

0 引言

煤炭异物的高效检测是煤炭分选的首要任务,也是提高煤炭入选质量的关键环节[1-2]。原煤生产过程中,煤流中存在矸石、锚杆、锚索、编织袋、木材和铁丝等异物,易引起系统阻塞,甚至造成设备故障与质量事故,因此,在异物进入原煤运输系统后有必要及时检测出异物并将其分离出系统[3-4]。传统的煤炭异物检测方法主要针对异物的不同属性采用机械结构或物理特性工艺进行除杂,存在分选效率低、自动化水平低等缺点,无法满足实际煤矿生产需求。随着智能化技术的快速发展,基于深度学习的煤炭异物检测方法成为智能化选煤领域的研究热点[5-6]。

国内外学者在煤炭异物智能化检测方面展开了大量研究,并取得了一定的研究成果。Wang Yuanbin等[7]基于SSDNet 实现了带式输送机表面异物快速检测,但仅针对图像内单一异物进行检测,泛化性较差。郝帅等[8]提出了一种融合卷积块注意力模型的YOLOv5 目标检测算法,提高了低对比度下大块矸石的检测精度。Zhang Kanghui 等[9]构建了一种语义分割网络,实现了煤中异物目标像素级分割,可提供更准确的位置信息。任志玲等[10]提出了基于改进CenterNet 的输送带异物识别方法,引入深度可分离卷积与组归一化方法,降低了异物误检率。程德强等[11]提出了融合残差信息的轻量级网络,在提高异物识别准确率的同时,提升了识别速度。上述文献均采用彩色图像(RGB 图像)进行特征提取,然而煤炭异物RGB 图像缺乏目标空间与边缘信息,且待检目标与背景之间颜色、纹理相似,对比度低,待检目标存在相互重叠及遮挡等现象,导致煤炭异物特征提取不充分,现有异物检测方法难以取得理想效果。

深度图像(Depth 图像)包含丰富的空间、边缘信息,利用RGB 图像和Depth 图像建立检测模型,可提高目标检测精度,因而得到了广泛应用[12-14]。在实际复杂的煤炭异物检测条件下,将像素点对应的Depth 图像与RGB 图像融合,能够丰富输入特征信息,有效改善煤炭异物的分割、识别效果,为煤炭异物图像中低对比度与互相遮挡目标的检测提供一种可行的解决方案。因此,本文引入Depth 特征,构建RGB 图像与Depth 图像的双特征金字塔网络(Double Feature Pyramid Network,DFPN),丰富异物图像的空间与边缘信息;提出跨模态注意力融合模块(Cross-modal Attention Fusion Module,CAFM),协同优化RGB 特征与Depth 特征,增强网络对特征图中被遮挡异物可见部分的关注度;使用区域卷积神经网络(Region-Convolutional Neural Network,R-CNN)系列检测子网络输出煤炭异物的分类、回归与分割结果。

1 煤炭异物检测方法

基于跨模态注意力融合的煤炭异物检测模型主要由DFPN、CAFM、检测子网络组成,如图1 所示。DFPN 包括RGB 特征提取分支和Depth 特征提取分支:RGB 图像经过复杂度较高的深层卷积网络后,得到不同分辨率的RGB 特征Ci(i=1,2,···,5);Depth图像经过复杂度较低的卷积神经网络后,得到不同分辨率的Depth 特征Di。CAFM 用于提高模型对RGB 图像中遮挡煤炭异物的可见部分的关注程度,充分利用Depth 特征中的几何信息,用Depth 信息辅助RGB 信息,实现双模态特征信息的互补与高效融合,同时采用特征金字塔网络(Feature Pyramid Network,FPN)[15]强化不同尺度融合特征的联系。检测子网络通过R-CNN 输出异物图像的分类、回归与分割结果。

1.1 DFPN

RGB 图像中通常包含丰富的色彩和纹理特征,采用深层特征提取策略能够通过多层非线性映射提取出抽象和高级的语义特征,捕获并表达物体的形状、结构和表面细节等重要信息。Depth 图像包含丰富的浅层空间信息,过度的特征提取会导致过拟合和信息丢失等问题,因此采用浅层的特征提取策略提取Depth 图像的低级特征,用深度边缘与深度纹理等基础特征辅助RGB 图像深层特征,以有效获得2 种特征的互补信息,从而提高检测精度。

为了充分提取RGB 图像和Depth 图像的特征,避免因网络层数过多而引起模型梯度消失或爆炸,选用深度残差网络[16](Residual Network,ResNet)提取不同梯度和分辨率的RGB 图像特征。ResNet 基础结构如图2 所示。Depth 图像特征提取网络的设计参考ResNet 基础结构的卷积块(Conv Block),如图2(a)所示。Conv Block 由主通路和支路组成,主通路由3 个卷积层组成,每个卷积层用于学习输入特征的变换,支路部分包括1 个卷积层和1 个批量归一化(Batch Normalization,BN)层,并通过Shortcut与主通路相连接。通过多层Conv Block 的堆积,完成对不同分辨率的Depth 图像的特征提取。

图2 ResNet 基础结构Fig. 2 ResNet infrastructure

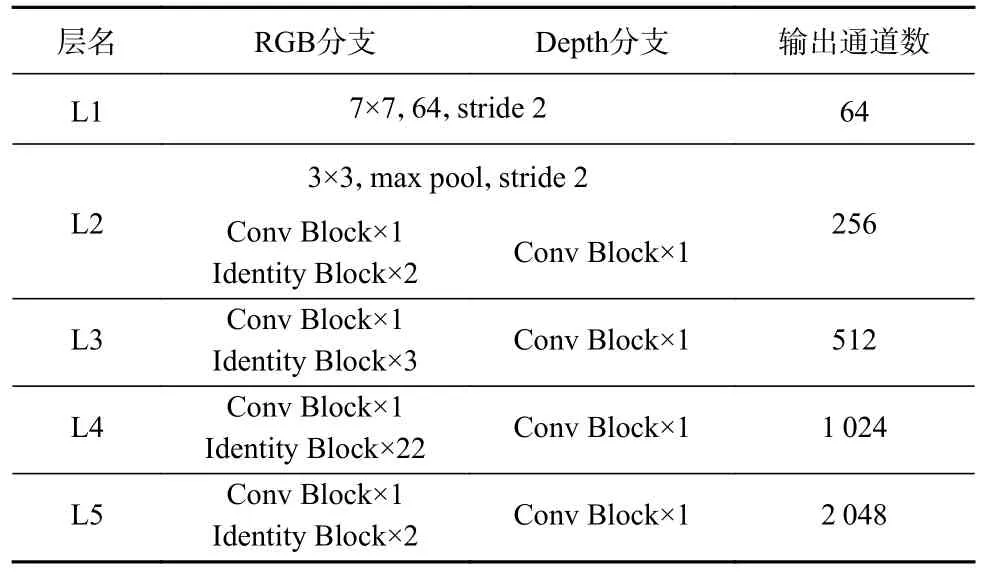

RGB 图像与Depth 图像特征提取网络的总体结构见表1。RGB 分支采用ResNet101 结构,Depth 分支第1 层与RGB 分支相同,后续均为单层的Conv Block。2 个分支每层输出通道数均相同,分别为64,256,512,1 024,2 048。

表1 RGB 图像与Depth 图像特征提取网络总体结构Table 1 The overall structure of feature extraction networks for RGB and Depth images

1.2 CAFM

在传统多模态图像融合策略中,根据作用层级将图像融合等级分为数据层融合、特征层融合和决策层融合[17-18]。在煤炭异物实例分割任务中,由于低维度的单通道Depth 图像缺乏语义信息,仅依靠Depth 图像特征得出的判断结果不够可靠,因此,决策层融合不适用于煤炭异物实例分割任务。数据层融合是指将RGB 与Depth 特征拼接后作为网络输入,可提高目标分割的丰富度,尤其是对比度低而深度差值大的区域,但模型学习到的冗余信息多于特征互补信息,检测精度较低。特征层融合方式能学习到较多特征互补信息,检测精度有一定提升。为了进一步融合2 种图像特征,有必要设计更有效的融合模块。

注意力机制能够过滤干扰检测结果的次要信息,增大遮挡目标可见部分的特征权重,提高检测精度。因此,本文基于注意力机制提出CAFM,其结构如图3 所示。CAFM 由RGB 特征与Depth 特征2 个分支组成。RGB 特征与Depth 特征依次输入各自分支的注意力模块中,强化模型对RGB 特征中煤炭异物可见部分的关注程度,同时充分利用Depth 特征中的几何信息,生成注意力图ARGB与AD,随后将各注意力图与输入特征FRGB逐元素相乘,得到细化后的特征F,实现多模态特征高效融合。

图3 CAFM 结构Fig. 3 Structure of cross modal attention fusion module

根据RGB 图像特征,通过使用坐标注意力[19]模块沿RGB 图像不同方向进行注意力分解,以更好地利用特征图的空间结构信息,使模型更加关注特定空间位置信息。首先将特征图FRGB沿水平坐标方向X和竖直坐标方向Y分别进行全局平均池化操作,得到池化特征图与随后将池化特征拼接后输入大小为1×1 的卷积层进行线性变换和降维,得到特征;沿着空间维度将切分为2 个单独的张量,再利用2 个1×1 卷积将切分后的张量变换到与输入特征图FRGB相同的通道数;对变换后结果进行Sigmoid 激活,再与输入特征FRGB合并,得到RGB 分支的强化特征ARGB。

根据Depth 图像特征,通过改进空间注意力模块对Depth 图像中不同像素之间的空间关系建模,以更好地捕捉距离和位置信息,从而提高Depth 特征表达能力。将输入特征图FD沿通道轴进行全局平均池化与全局最大池化,得到空间池化特征与;将池化特征拼接后输入大小为3×3、扩张率为2 的空洞卷积,对输出结果进行Sigmoid 激活,得到Depth 强化特征对比空间注意力模块的7×7 大核卷积,空洞卷积可在高效聚合上下文信息的同时,有效减少计算参数。

1.3 检测子网络

检测子网络选用双阶段经典检测网络结构,包括区域生成网络(Region Proposal Network,RPN)、ROI Align[20]与Head Architecture。将融合后特征作为RPN 输入,生成候选目标框,经过ROI Align 层对候选目标区域进行准确裁剪和特征提取,最后经Head Architecture 输出异物图像分类、回归与分割结果。

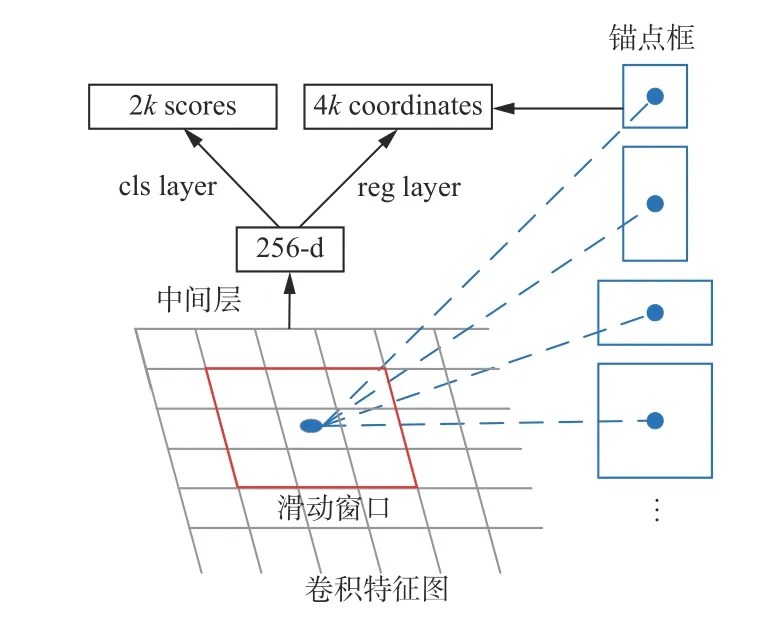

RPN 以滑动窗口的形式在融合特征图上生成区域建议框,其结构如图4 所示。特征图的每个像素点生成3 种比例分别为1∶1,1∶2,2∶1 的锚点框,并输出用于区分类别与位置的特征向量。区域建议框与原图相应位置映射,以交并比(Intersection over Union,IoU)的形式设置阈值,初步筛选超出图像边界的候选框,最终以非极大值抑制等方式筛选出高质量的区域建议框。

图4 RPN 结构Fig. 4 Structure of region proposal network

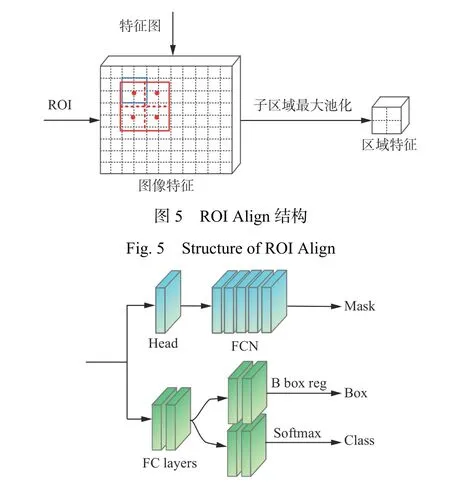

ROI Align 层通过遍历区域建议框,采用双线性插值与池化的方法避免2 次量化操作引起的区域特征错位问题,准确生成固定大小尺寸的特征图。首先将每个感兴趣区域(ROI)按照7×7 和14×14 的像素尺寸平均分割成若干个子区域;然后将每个子区域平均分成4 个小空间,通过双线性插值计算各最小空间内中心点的像素值;最后取这4 个小空间的最大值作为该子区域的像素值,进而准确地固定特征图尺寸。ROI Align 结构如图5 所示。

检测分支结构Head Architecture 与Mask R-CNN对应部分相同,其结构如图6 所示。检测部分在R-CNN 系列分类与回归的基础上,添加全卷积网络(Fully Convolutional Networks,FCN)结构的 Mask 掩膜生成分支,实现煤炭异物图像的像素级分割。

图6 Head Architecture 结构Fig. 6 Structure of Head Architecture

2 实验结果与分析

2.1 数据采集与处理

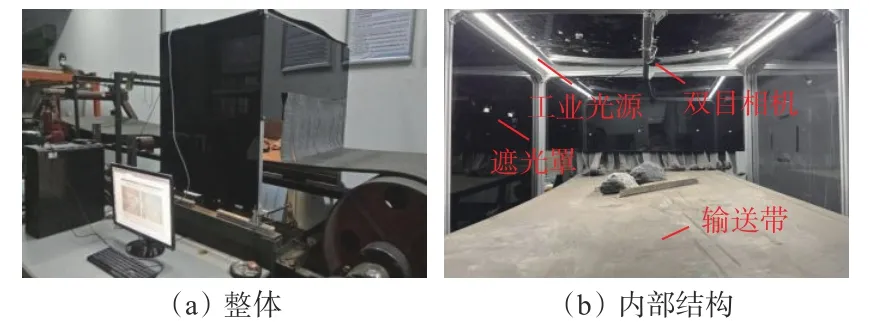

依托多机械臂煤炭异物分拣机器人[3]模拟选煤厂煤炭异物洗选场景,建立煤炭异物视觉检测系统,如图7 所示。煤炭异物视觉检测系统由计算机、双目视觉相机、工业光源、遮光罩和输送带组成。其中相机选用ZED 2i 双目视觉相机,RGB 图像与Depth 图像像素均调整为1 440×1 080;光源与相机呈45°空间关系架设;遮光板包围在桁架结构外,避免外界环境杂散光影响图像采集。

图7 煤炭异物视觉检测系统Fig. 7 Visual detection system for coal foreign object

实验异物样本均来自于中国西北某煤矿,主要包括矸石、编织袋、铁丝与木块,如图8 所示。实验所用煤炭异物数据集共包含7 500 张图像,采用Labelme 软件对RGB 图像手工标注,得到标签图,煤炭与异物标签分别为coal(煤)、gangue(矸石)、iron(铁丝)、bag(编织袋)、wood(木块)。采用3×3 中值滤波器与直方图均衡化算法对Depth 图像进行去噪、空洞填充与平滑处理,以提高Depth 图像对比度。RGB 图、Depth 图和标签图共同组成异物数据集。在异物数据集中随机挑选70%作为训练集,20%作为验证集,10%作为测试集,分别用于模型训练、参数调优与性能评估。

图8 煤炭异物种类Fig. 8 Types of coal foreign object

2.2 网络参数设置

实验在Ubuntu 18.04 系统下进行,训练所用GPU 为Nvidia RTX 2060,实验模型基于Python 3.6 +PyTorch 1.10 搭建。借助COCO 数据集训练的ResNet 预训练模型迁移学习,初始化骨干网络权重,加速模型收敛,采用随机梯度下降优化器进行模型训练,迭代数epoch 为100,batchsize 大小为8;学习率变化采用预热策略,初始学习率设置为0.002,在迭代到总次数的60%时学习率降到初始值的1/10,迭代到总次数的90%时学习率降到60%时的1/10;动量因子与权重衰减系数分别设置为0.9 和0.000 1。

2.3 煤炭异物检测效果定量分析

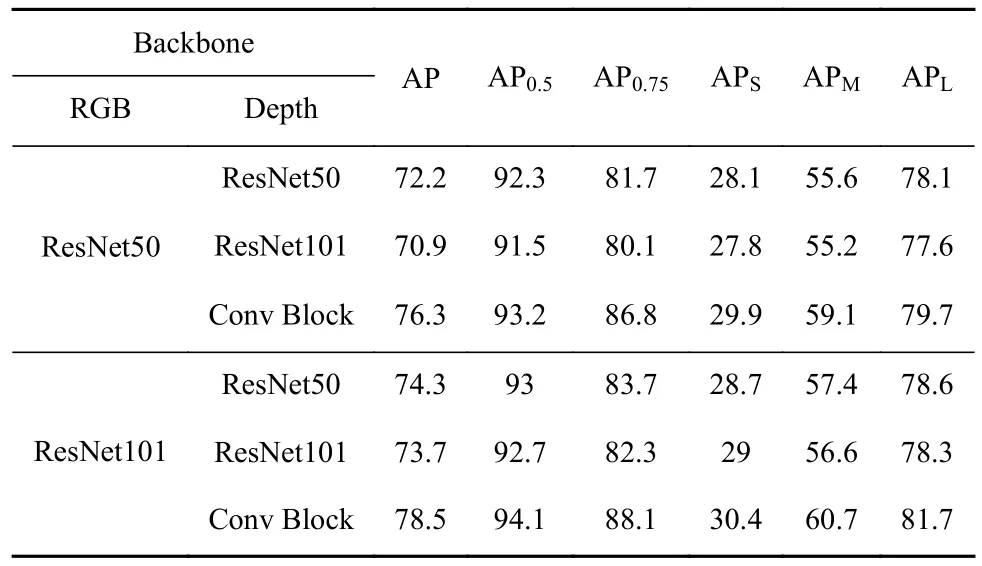

为定量分析本文方法的效果,并确定最佳设计方案,在煤炭异物测试集上进行消融实验。实验中,参考MSCOCO 数据集对实例分割任务的评价标准,选择不同IoU 阈值与不同尺度下的掩膜平均精度对检测结果进行定量判断,设AP 为IoU 阈值范围为0.5~1 时的掩膜平均精度,AP0.5与AP0.75分别为IoU 阈值取0.5 与0.75 时的掩膜平均精度,APS,APM,APL分别为小尺寸(小于32×32 像素)、中尺寸(在32×32 像素与96×96 像素之间)、大尺寸(大于96×96像素)目标的掩膜平均精度。

2.3.1 特征提取消融实验

通过在DFPN 阶段选用不同深度的残差网络来验证最佳特征提取方案,RGB 与Depth 特征层权重比设置为4∶1,实验结果见表2。可看出,RGB 图像特征提取方式相同时,提取Depth 图像特征的ResNet 越深,整体的平均精度越低,这是因为Depth图像中包含丰富的浅层空间信息,过度特征提取会导致过拟合和信息丢失等问题。当Depth 图像特征提取方式相同时,选用ResNet101 提取RGB 图像特征时的整体平均精度高于ResNet50,这是因为在煤炭异物检测场景下,ResNet101 的网络层数更深,能学习到更高级、更复杂的特征表示。Depth 图像特征提取采用Conv Block 时,整体平均精度高于ResNet101和ResNet50。因此,RGB 与Depth 图像分别选用ResNet101 与本文设计的浅层卷积块结构提取特征。

表2 特征提取消融实验结果Table 2 Ablation experiments results for feature extraction%

2.3.2 特征融合消融实验

为验证基于注意力的特征融合方法,通过实验对比仅使用RGB 图像的实例分割方式、数据层融合、特征层融合与CAFM 的检测精度。RGB 与Depth 特征层权重比设置为4∶1,实验结果见表3。可看出,采用CAFM 融合方式时的平均精度高于其他融合方式,这是因为CAFM 相对其他方式能学习到更多特征互补信息,同时强化遮挡物体可见部分的特征,提高遮挡物体可见部分的特征利用率,从而提升算法整体的检测精度。

表3 特征融合消融实验结果Table 3 Ablation experiments results for feature fusion%

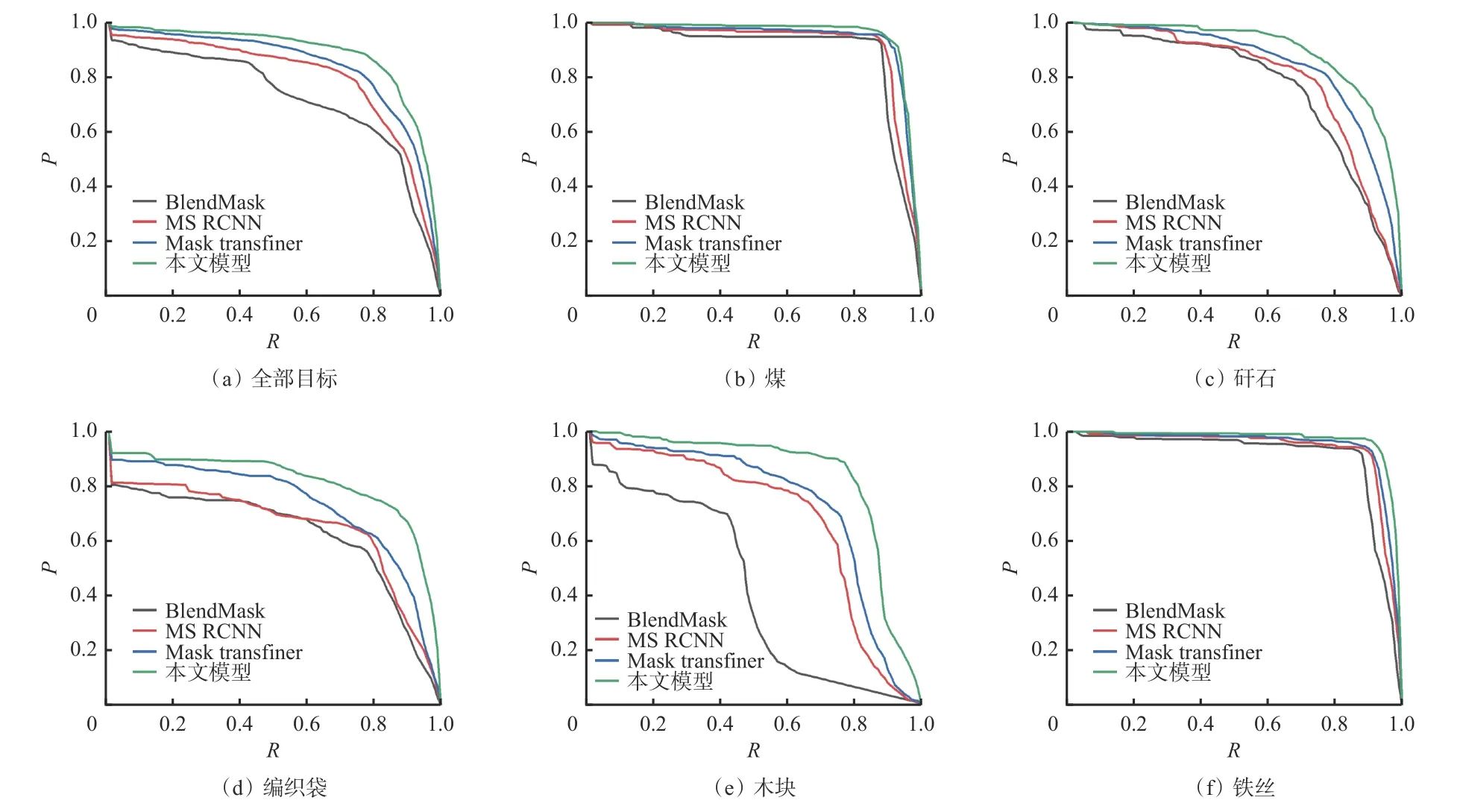

2.4 不同模型性能对比

将本文模型与实例分割领域的单阶段模型SOLOv2[21], BlendMask[22]及双阶段模型Mask-RCNN[23],MS RCNN[24],Mask transfiner[25]进行对比。RGB 图像特征提取网络均选择ResNet101-FPN,实验结果见表4。可看出,相较于单阶段、双阶段的其他实例分割模型,本文模型综合性能最优。在检测精度方面,本文模型的AP 相较两阶段模型中较优的Mask transfiner 高出3.9%。在检测效率方面,本文模型的单帧检测时间为110.5 ms,能够满足异物检测实时性需求。本文模型在检测精度与检测效率上达到了良好的平衡,更适用于煤炭异物检测。

表4 不同模型检测性能对比Table 4 Comparison of detection performance of different models

本文模型与单阶段模型BlendMask、双阶段模型MS RCNN、Mask transfiner 的异物检测性能对比结果如图9 所示(P-R(P为准确度,R为召回率)曲线包络的面积越大,代表精度越高)。由图9(a)可知,本文模型的P-R曲线相比其他模型更靠近右上角,对各类异物的综合检测能力明显优于其他模型;由图9(d)、图9(e)可知,对于编织袋和木块,4 种模型均具有较高的检测精度,其中本文模型性能最优;由图9(b)、图9(c)、图9(f)可知,对于煤、矸石及铁丝目标,其他模型的检测精度较低,而本文模型对这3 类目标的检测效果明显更优。实验结果表明,本文模型能够以空间特征辅助色彩、形状与纹理等特征,准确识别煤炭异物之间及煤炭异物与输送带之间的差异,从而有效提高检测精度。

图9 P-R 曲线对比Fig. 9 Comparison of P-R curves

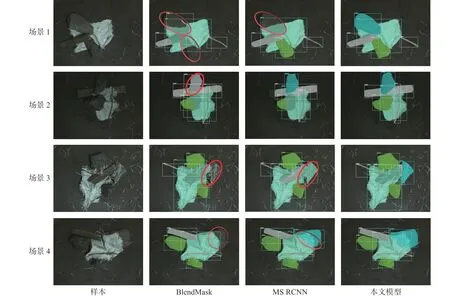

2.5 煤炭异物检测效果定性分析

为验证本文模型的实际检测效果,选择4 组具有低对比度、多遮挡特征的图像进行测试,对比模型选择单阶段模型BlendMask、双阶段模型MS RCNN,测试结果如图10 所示。由场景1、场景2 的对比结果可知,由于原图中包含多个与背景(输送带)颜色相近的异物,导致MS RCNN 与BlendMask 实例分割模型在红圈处出现漏检或误检;而本文模型可以正确检测出图中的低对比度目标并产生高质量的分割掩膜,这得益于引入的Depth 分支提高了分割结果的丰富度。由场景3 的对比结果可知,由于异物之间存在相互遮挡现象,导致BlendMask 未能检测出被编织袋遮挡的矸石,从而在红圈处出现漏检;MS RCNN 模型由于遮挡与对比度低将矸石误检为编织袋的一部分。由场景4 的对比结果可知,由于编织袋的遮挡,导致BlendMask 未能检测出被遮挡的矸石;而本文模型由于使用CAFM 模块,使得模型能够提取目标空间信息且更加准确地把握异物可见部分的特征,从而正确检出被遮挡异物。

图10 煤炭异物检测效果对比Fig. 10 Comparison of coal foreign object detection effects

3 结论

1) 提出了基于跨模态注意力融合的煤炭异物检测方法。通过引入Depth 信息,构建复杂度不同的DFPN,提取不同分辨率的RGB 与Depth 特征。构建了基于坐标注意力与改进空间注意力的融合模块CAFM,通过该模块协同强化并高效融合不同模态特征,实现对低对比度、相互遮挡煤炭异物的精准分类、定位与分割。

2) 实验结果表明:在检测精度方面,本文模型的AP 相较两阶段模型中较优的Mask transfiner 高3.9%;在检测效率方面,本文模型的单帧检测时间为110.5 ms,能够满足异物检测实时性需求。所提方法显著提高了对复杂特征异物的检测精度,有效减少了误检、漏检现象,实现了复杂特征下煤炭异物的精确检测与像素级分割,为提高煤矿分选效率、保障煤矿安全运输提供了理论基础。

3) 基于跨模态注意力融合的煤炭异物检测方法虽有效提高了异物检测精度,但由于DFPN 结构带来了一定的时间损耗,考虑工业化部署中算力限制对模型大小与推理速度的要求,后续将进一步研究模型压缩与推理加速方法,降低模型的计算时间和空间复杂度。