区块链赋能多边缘安全联邦学习模型

2024-02-18姜晓宇顾瑞春张欢

姜晓宇 顾瑞春 张欢

摘 要:联邦学习是一种革命性的深度学习模式,可以保护用户不暴露其私有数据,同时合作训练全局模型。然而某些客户端的恶意行为会导致单点故障以及隐私泄露的风险,使得联邦学习的安全性面临极大挑战。为了解决上述安全问题,在现有研究的基础上提出了一种区块链赋能多边缘联邦学习模型。首先,通过融合区块链替代中心服务器来增强模型训练过程的稳定性与可靠性;其次,提出了基于边缘计算的共识机制,以实现更加高效的共识流程;此外,将声誉评估融入到联邦学习训练流程中,能够透明地衡量每一个参与者的贡献值,规范工作节点的行为。最后通过对比实验证明,所提方案在恶意环境下仍然能够保持较高的准确度,与传统的联邦学习算法相比,该方案能够抵抗更高的恶意比例。

关键词:人工智能; 联邦学习; 区块链; 边缘计算; 共识机制

中图分类号:TP 文献标志码:A 文章编号:1001-3695(2024)01-004-0026-06

doi:10.19734/j.issn.1001-3695.2023.05.0208

Blockchain-empowered multiple edge secure federated learning model

Abstract:Federated learning is a revolutionary deep learning model, and it enables users to train the global model cooperatively without exposing their private data. However, malicious behaviors of some clients can lead to the risk of single point of failure and privacy disclosure, which pose a serious threat to the security of federated learning. In response to the above issues, based on the existing research, this paper proposed a blockchain empowered multi edge federated learning model. Firstly, this paper proposed to use blockchain instead of central server to enhance the stability and reliability of model training process. Secondly, this paper proposed a consensus mechanism based on edge computing to achieve a more efficient consensus process. In addition, incorporating reputation assessment into the federated learning training process, it could transparently measure the contribution value of each participant and standardize the behavior of work nodes. Finally, comparative experiments show that the scheme can maintain high accuracy in the malicious environment, and can resist higher malicious ratio compared with the traditional federated learning algorithms.

Key words:artificial intelligence; federated learning; blockchain; edge computing; consensus mechanism

0 引言

隨着5G以及人工智能技术的飞速发展,移动终端设备产生的数据也呈爆炸式增长,鉴于对数据隐私的关注以及数据共享激励措施的匮乏,导致数据孤岛[1]现象日益严重,数据在各个行业内部以“孤岛”的形式存在,导致数据量分布极不均匀。所以,集中式的机器学习已经不再适用于对不均匀分布的数据进行分析处理。联邦学习(federated learning,FL)是一个革命性的范式,可用于跨持有本地数据集的多个用户进行AI模型的训练,它能够使多个用户共同协作训练模型,并且无须将自身的私有数据共享给其他参与者,从而能够有效解决用户之间直接交换数据导致的隐私泄露和信息劫持的风险[2]。具体而言,在FL框架中,通常是由一个中心服务器以及多个分布式的设备构成,FL允许分布式用户在本地训练机器学习模型,之后用户将本地训练模型的参数共享给中心服务器,在该服务器中聚合生成全局模型[3]。但是中心服务器的存在又面临着新的安全问题,主要表现在两个方面:一方面,单一的中心服务器是十分脆弱的,很容易受到攻击,因此存在单点故障的隐患,如果它受到攻击而无法继续工作,那么联邦学习进程将被迫中断[4];另一方面,其无法排除某些中心服务器自身存在恶意行为,在模型训练过程中,恶意的中心服务器会窃取用户的信息,造成隐私泄露,这类恶意行为导致了服务器缺乏信任[5],影响FL的正常运行。

如何解决以上问题是当前的一个研究热点。区块链具有去中心化的特点,不会因为单个节点的故障而停止工作,同时区块链上的数据不受任何单个实体的控制,所以选择融合区块链技术到联邦学习框架中,来代替中心服务器,从而起到解决单点故障以及避免恶意攻击等作用。区块链是一种新兴的去中心化技术,提供了透明可靠的数据来源和强有力的安全保障[6],智能区块链技术通过同步节点的完整账本,确保链上数据的透明性,能够在多个参与者之间建立一个可靠的信息共享渠道,智能区块链技术通过自动执行预设的智能合约代码[7],确保系统内的工作节点只要遵守协议,就能够得到相应的报酬。

本文在现有研究的基础之上,提出一种区块链赋能多边缘联邦学习模型(blockchain-empowered multiple edge federated learning,BME-FL),使用区块链来解决单点故障问题。在此基础上,加入了边缘计算技术,边缘计算是一种新型的计算模型,是指在靠近数据源头的一侧,采用网络、计算、存储、应用核心能力为一体的开放平台,就近提供最近端服务[8]。传统的计算平台很难独立提供庞大的计算,边缘计算以其分布式的特性使计算能力分散,有助于在大规模分散节点上的操作,实现去中心化计算[9]。通过边缘计算技术,能够进一步提高区块链节点间的共识效率,并且在此基础上,提出了一种声誉机制来规范工作节点的行为,在保证准确度的同时提高了训练速度和安全性。本文的贡献如下:a)提出了多边缘模型下的共识机制,通过少数计算能力强的边缘节点来执行共识过程,而不是广播到每个工作节点并达成共识;b)提出了声誉机制,通过声誉计算能够高效地衡量出每一个工作节点的贡献值,进而找到更为可靠的节点;c)通过实验证明本文方案能够在保证准确度的同时,有效应对恶意攻击,提升联邦学习的安全性。

1 相关工作

随着人工智能决策技术的不断进步,机器学习和深度学习被广泛地应用到许多领域,如自动驾驶汽车、智能医疗、地震预测[10]等。传统的方法是将生成的数据傳输到云中,在云中进行分析,并在高性能服务器上训练模型,亚马逊网络、谷歌云和Azure是比较常见的机器学习服务提供商[11]。然而,数据的隐私正成为用户日益关注的问题。这些数据可以是非常私人的,并且是任何类型的,例如个人身份信息、支付数据和受保护的健康信息等,当这些数据与云共享时,用户隐私很可能会受到窃听攻击,并且在基于云计算的方法中又出现了其他问题。一方面表现为高延迟,因为数据可能传输很远的距离才能到达云中心;另一方面表现为高传输成本,因为通过网络将数据移入和移出云计算都需要巨大的运算开销[12]。为了应对上述挑战,在2016年,谷歌提出了联邦学习[13],其目标是在训练高质量集中式模型的同时,训练数据仍然保存在客户端上。近年来,许多国内外的研究人员在联邦学习领域作出了不同的贡献,如Sun等人[14]提出了一种基于差分隐私(differential privacy,DP)的联邦学习方案,通过DP技术提高了模型聚合时的安全性。但是,由于单点故障的原因,使得集中式的联邦学习服务器受到了越来越多的挑战和质疑,Hegedüs等人[15]提出将数据保留在边缘设备上,无须聚合服务器或任何中心组件。

为了解决集中式服务器的单点故障,联邦学习与区块链系统相结合成为了一个新兴的研究热点,区块链以其高稳定性和高安全性,成为了解决联邦学习框架下单点故障问题的最佳方案。Li等人[16]提出了一种区块链辅助的去中心化联邦学习,能够很好地解决传统FL系统中存在的单点故障问题,但没有处理隐私问题。Wu等人[17]设计了一种基于区块链的框架,该框架是分散的,并且可以在没有主节点的状态下正常运行,具有良好的隐私性和鲁棒性。Short等人[18]提出了一种基于区块链的防御技术,简化了学习过程,并且提出了一种增强联邦学习安全性的技术,此技术针对模型中毒的攻击表现出了更高的性能,具有更高的收敛性。Kim等人[19]分析了区块链框架下FL的端到端延迟,当移动设备参与模型训练过程时,网络延迟会严重影响FL的性能。在确保数据安全的前提下,边缘计算技术被应用到联邦学习框架中,在网络的边缘利用联邦学习技术,充分发挥边缘节点的计算能力,从而实现了更加广泛和高效的联邦学习。Qu等人[20]提出了一种基于雾计算和区块链的联邦学习方案,在该方案中,雾层服务器生成全局更新,在链上只存储更新指针,实现了较低的时间延迟。邢丹等人[21]提出了一种基于区块链和边缘计算的联邦学习框架,该系统具有数据认知功能强大、稳健性良好的优点。

然而,以上研究都没有解决共识效率的问题。在区块链框架下,对每一个封装块达成共识是一个不可避免的过程,考虑到联邦学习过程中有大量节点,因此共识机制的计算和通信成本比较高。传统的共识方案是需要经过所有工作节点共同认证之后,才能够上传至区块链,这种方式安全性良好,但是广播共识非常耗时并且共识效率低,因此,降低成本是非常重要的。本文提出的基于边缘计算的共识机制能够解决共识效率的问题。

2 模型设计实现

2.1 BME-FL总体模型设计

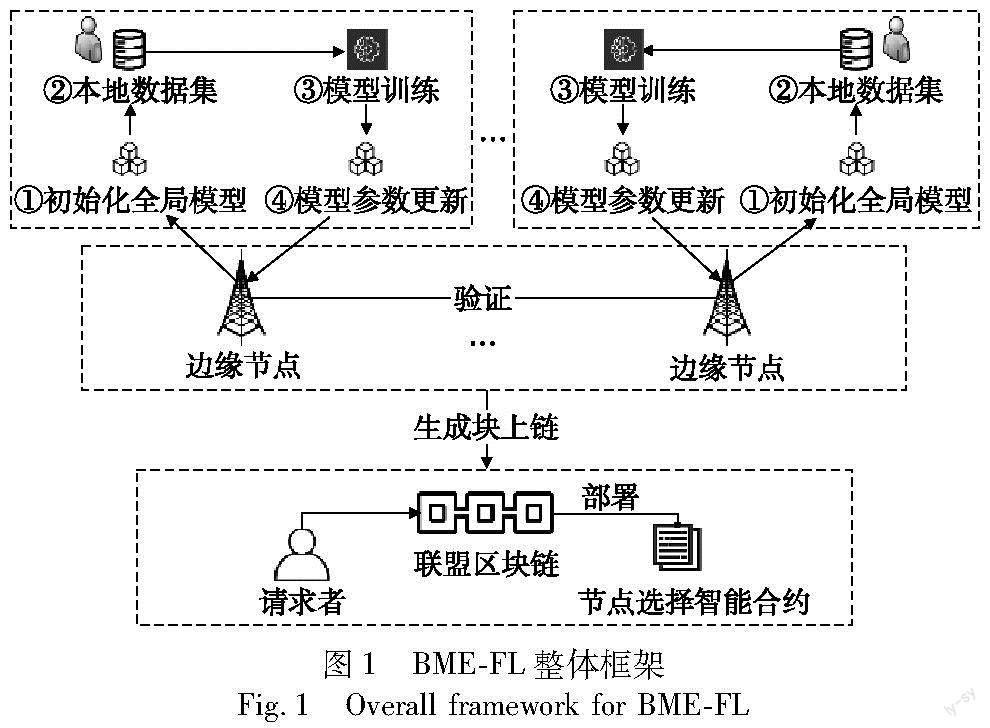

联邦学习使机器学习算法能够跨多个分布式客户端进行训练,无须交换其数据样本。在原始的联邦学习框架中,由一个集中式服务器控制训练过程(包括客户端管理、全局模型维护和梯度聚合),这种方式存在着一定的安全隐患。然而在本文框架中,使用区块链来代替集中式服务器,从而避免其可能会导致的单点故障。如上所述,原有集中式服务器的功能可以由智能合约(smart contract,SC)来实现,并由区块链上的相关交易驱动。为了解决这一问题,本文提出了一个区块链赋能多边缘安全联邦学习框架(BME-FL),该框架无须任何集中式服务器,所有参与节点通过区块链执行联邦学习任务,由区块链来维护全局模型和本地更新。考虑到联邦学习的通信成本,本文提出了一种新型的基于边缘计算的共识机制,使用边缘节点将终端工作节点和区块链融合在一起,并由边缘节点来处理更新验证和区块生成工作。本文框架主要包含三个部分。第一部分是终端节点,主要负责模型训练工作,终端工作节点下载最新的全局模型,并使用本地数据集对其进行更新,生成更新参数,各个节点互不干扰,独立工作,无须共享自身的私有数据。第二部分是边缘节点,主要负责参数验证以及块生成的工作,终端节点生成的参数更新需要先经过边缘节点的验证之后,才能够添加到区块链上。边缘节点具有较多的计算资源,相比于终端节点,其拥有更加强大的计算能力,能够在一定时间内处理更多的数据。第三部分是区块链层,主要负责参数聚合工作。首先初始化全局模型,之后终端节点可以通过访问区块链来获取最新的全局模型,生成的更新参数经过验证后添加到链上,达到阈值时开始进行模型聚合,并将新的全局模型添加到区块链上,链上的历史区块可以用于故障回退,提高了安全性。具体的模型框架如图1所示。

框架具体流程如下:

a)联邦学习任务的模型请求者发布任务请求,并根据终端节点的属性选择参与本次模型训练工作的节点。

b)被选中的节点成为工作节点,工作节点访问区块链获取最新的全局模型。

c)工作节点使用本地数据训练模型,并将生成的模型参数发送给边缘节点进行验证。

d)由多个边缘节点组成的共识层对模型进行验证。

e)验证通过之后,边缘节点将参数更新打包生成新的区块,并加入到区块链上。

f)当区块链上的模型参数更新达到一个阈值的时候,触发模型聚合,生成新的全局模型,并下发给各个工作节点进行下一轮迭代。

算法1 联邦学习算法

算法1描述了联邦学习框架的具体流程,当选为工作节点的客户端使用本地数据集更新全局模型,并提交给共识层的边缘节点进行验证打分,得分标准为模型损失水平,损失度下降则视为作出正向贡献,反之为负面贡献,取验证分数的中位数作为本轮的精度贡献得分。模型聚合工作由链上的智能合约完成,工作节点获取最新的全局模型进行下一轮学习。最后统计工作节点所有的贡献得分,得到最终的声誉值,声誉值同样由正向交互和负面交互两部分决定。算法1中工作节点的选择流程在算法2中作出详细的说明;算法中边缘节點的相关工作以及基于边缘计算的共识流程将在2.2节中详细介绍;声誉值计算公式将在2.3节中具体说明。

算法2 选举算法

输入:候选客户端列表DList={D1,D2,…,DN},参与者个数K。

输出:被选举作为工作者的节点列表Ut。

if 候选客户端数量不足K个 //当候选人不足时,返回失败

return FAIL

end if

for Di∈DList[]

计算当前候选客户端的声誉值R

end for

候选人根据声誉值排序

取前K个客户端组成工作节点列表Ut

在训练之前,首先要选择出参与联邦学习任务的客户端,模型的性能取决于参与工作的节点,因此,节点管理是框架中的关键部分,参与节点不仅可以访问全局模型,还可以上传模型更新来影响全局模型。为了控制权限,本文方案主要会根据客户端的声誉值来选举工作节点。当某个设备出现了不当行为(如提交误导性更新、传播私人模型)时,该设备将会被拒绝参加联邦学习任务。

2.2 基于边缘计算的共识机制

共识机制是任何基于区块链系统的主干。通常,区块链系统的参与者遵循共识机制,就链上区块的内容达成共识[22]。区块在添加到链上之前,必须经过共识机制的验证。由于区块链上共识机制的计算和通信成本比较高,所以本文模型使用了一种基于边缘计算的共识机制。在此设置下,边缘节点负责验证局部梯度和块生成。同时,工作节点执行本地训练,并将模型更新发送给相近的边缘节点,随后边缘节点验证更新并对其评分,合并各个边缘节点的模型精度贡献分数后,中位数将成为此次更新的最终得分。完成得分计算之后,边缘节点将模型更新打包成块,上传到区块链上。由于边缘节点可以通过各种感知设备收集数据,并能够对收集到的数据进行传递以及分析处理,所以在本方案中,将边缘节点自身数据视为验证集来验证局部更新,模型精度贡献作为得分。这是一种十分安全快捷的方法。一方面,边缘节点自身强大的计算和存储能力能够降低共识流程的时间消耗,提高共识效率;另一方面,参与同一个联邦学习任务的边缘节点收集到的数据在具体内容上互不相同,但是在格式和类型上相同,这使得验证分数更加可靠。共识机制的流程如图2所示。

a)工作节点使用本地数据集训练模型生成局部模型梯度,并将模型更新发送给边缘节点。

b)由边缘节点组成的共识层对模型更新进行验证,边缘节点检测自身是否具有足够的计算资源,如果计算资源不足,则将验证任务卸载到其他的边缘节点。

c)如果计算资源充足,则使用自身的数据集作为验证集来计算模型更新精度,并计算贡献分数。

d)计算完成之后,将模型局部更新发送给共识层中的其他边缘节点进行验证。合并各个边缘节点的评分后,取中位数作为最终得分。

e)随后边缘节点生成新区块并在共识层内广播,将生成块交给其他边缘节点进行验证。

f)在获得认可后,即可加入到区块链中,否则将其丢弃。

基于边缘计算的共识机制的优势如下:

a)高效。只有少数边缘节点参与验证更新,而不是广播到每个工作节点并达成协议。边缘节点具有更强的计算能力,相比于终端节点,边缘节点能在更短的时间延迟下完成验证以及块生成。当面临计算能力不足以完成验证工作时,便可将计算任务卸载,交由其他边缘节点完成。

b)反恶意。根据模型精度贡献得分,能够高效地衡量出每一个工作节点的贡献值,从而找到相对诚实可靠的节点;如果某一个边缘节点受到攻击而无法正常工作时,整个联邦学习进程不会因此中断。

c)可拓展。通过边缘计算能够将更多的终端节点联合起来共同训练模型,提高模型精度。

2.3 声誉值计算

联邦学习是一种通常用于知识获取的分布式机器学习,以协作方式改进全局模型,从而保护用户数据的隐私,模型性能的提升和安全性的提升同样重要。不可靠的工作人员可能发起恶意攻击并发送恶意更新,所以需要通过声誉计算来选择诚实工作节点。本文方案不允许低于特定阈值的节点参与联邦学习过程,并从正向以及反向两个方面进行分析,将两部分结合起来,确定工作节点最终的声誉值[23]。

声誉评估分为积极性、精确度贡献、时效性。

a)积极性。其用H表示,积极性越高,表示互动越多,根据交互的内容又分为正向交互p和负面交互n。计算过程如下:

其中:I表示交互总数;Hp表示正向交互比例;Hn表示负面交互比例。

b)精确度贡献。其使用A表示,模型精度的提高程度被视为影响声誉的另一个因素。假设在第t次交互前后,模型的损失分别表示为Lt-1和Lt,则第t次交互时工作节点的精确度贡献计算如式(3)所示。

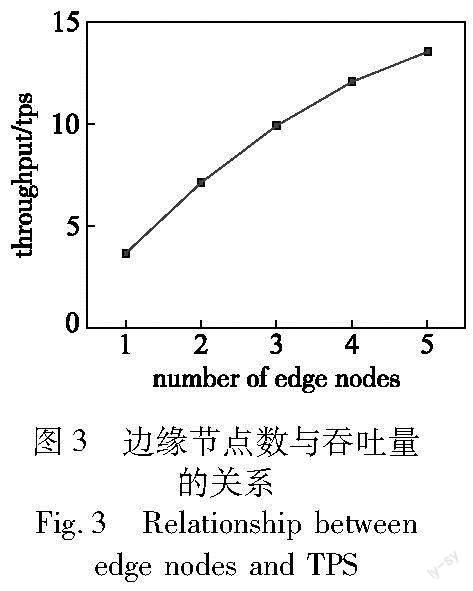

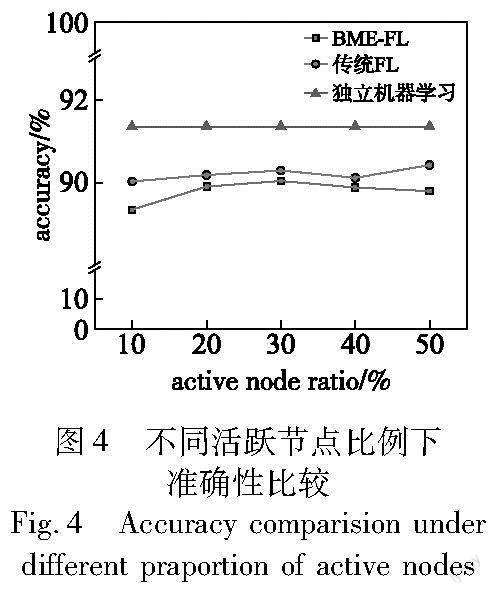

当模型损失降低时,Lt-1>Lt,表示更新后的模型是有用的,At>0,作出了正向的贡献;反之,当模型损失增加时,Lt-1 c)时效性。其用S表示,随着训练过程步步推进,模型不断更新,但是模型精度对声誉值的贡献不总是相同的,认为更近的模型精度贡献应该占有更高的权重。时效性计算如下: 其中:Tc是当前时间,Tt是第t次共享本地模型的时间。这是一个加权函数,其中模型贡献被视为加权因子,共同考虑模型贡献和及时性的重要性。互动时效性也可分为正向价值和负面价值,如式(5)(6)所示。 其中:Ap和An分别表示正向模型精确度贡献和负面模型精确度贡献。考虑到上述因素,那么总体声誉的计算如式(7)所示。 R=Hp×Sp+Hn×Sn(7) 其中:R表示总体声誉。终端节点的正向行为将增加Hp×Sp的值,它总是不小于0;相反,Hn×Sn<0,所以负面行为越多,Hn×Sn的绝对值越大。将这两部分结合起来计算终端节点的声誉值。 2.4 案例分析 本文将以车联网(Internet of Vehicle,IoV)作为案例,对所提方案进行性能分析。 车联网的出现旨在以协作的方式感知、计算和处理环境数据,提高用户的体验质量[24]。为了实现上述目标,需要在实时场景中通过智能设备在路边单元和车辆之间进行数据交换。然而,在此过程中依旧存在许多安全挑战,以往的工作侧重于车辆之间的数据共享,但大量数据会导致冗余传输和网络拥堵,还会出现隐私泄露和数据窜改等安全隐患;此外,如果没有相关约束条件,那么车辆提供的数据质量也会参差不齐,造成资源浪费;最后,在复杂的IoV环境下,交易时延和通信开销也会严重影响共享的实时性和可靠性。 本文方案能够解决上述问题。首先区块链与联邦学习相结合的技术能够有效保护车辆的隐私数据,防止数据遭受窜改,车辆的隐私数据保存在本地,能够降低数据传输成本,减轻通信压力;其次,基于边缘计算的共识机制降低了通信延时,提高了共识效率,边缘计算技术的去中心化能够有效降低网络拥堵,提高可拓展性;最后,声誉值机制确保了用户上传模型的质量,不仅能够激励诚实可靠的用户,还能够惩罚恶意用户,有效应对恶意攻击,保证联邦学习流程顺利进行,减少数据资源的浪费。 3 实验评估 3.1 实验环境 本文方案采用Ubuntu 20.04作为实验的基础操作系统,在区块链方面使用了FISCO区块链网络,这是一个开源的联盟区块链平台,通过其提供的信息端口,可以检查事务以及智能合约的详细情况;同时使用Solidity编程语言编写了智能合约;学习模型使用Python 3.7.6和TensorFlow 1.14.0实现。在数据集方面,使用了FEMNIST[25]数据集,该数据集包含62种不同的字符类别(10种数字,26种小写,26种大写)的像素图片,图片均为28×28像素大小(也可以选择将其转为128×128),樣本数为805 263。 本文方案中的BME-FL框架分为三层,如图1所示。第一层为终端工作节点层,负责本地模型更新;第二层为边缘层,负责验证模型更新以及区块生成工作;第三层为区块链层,负责聚合更新,生成新的全局模型。在实验中恶意攻击类型为高斯随机噪声扰动攻击[26],高斯噪声是指它的概率密度函数服从高斯分布的一类噪声,分布公式如式(8)所示。 3.2 方案对比 本文就以下几个方面对联邦学习相关方案进行对比分析,如表1所示。文献[27]提出了一种基于FL的高命中率数据缓存方案,由于未能集成安全解决方案,所以会出现信任危机以及数据易被窜改的风险;文献[28]提出了区块链框架下的联邦学习方案,分别实现了工作节点的激励以及用户隐私保护,但是存在着系统延时和通信成本较高的问题;文献[29]在基于区块链的FL框架中加入了边缘计算技术,能够缓解系统的延时和成本较高的问题,但是难以保证系统的安全性。本文方案提出多边缘共识机制,由算力强大的边缘节点来执行共识流程,并在此基础上加入声誉机制来规范工作节点的行为,能够在恶意环境下保持较高的性能,保证了方案的安全性。 3.3 实验结果和评估 边缘节点个数同吞吐量的关系如图3所示。吞吐量是指接收器从发送器到达的数据总量与接收器获得最后一个数据包所需时间的比率。从图中可以看出,随着边缘节点个数的增加,系统的吞吐量也呈上升趋势。在本文方案中,由于边缘节点执行验证以及块生成的工作,所以当系统中有更多边缘节点时,吞吐量也会随之上升。但是随着边缘节点个数的增多,会带来更多的通信开销,所以吞吐量整体的上升趋势逐渐变缓。 本文还进行了准确度性能的比较。实验将本文方案与传统联邦学习模型和独立训练框架作为基线进行比较。每个框架将经典图像分类模型AlexNet作为全局模型。根据实验设置,本文将每轮活动节点的比例定义为m%。基本FL的训练节点比例也是m%,同时,独立训练将利用整个数据集。在不同m值的条件下,其性能如图4所示。由于在BME-FL框架中引入了边缘节点共识方案,少数的边缘节点处理更新验证以及块生成工作,所以在准确度性能上与传统的方案相比出现了轻微的损失。但是,本文方案的性能一直接近基本联邦学习框架的效果,并且其可以通过基于边缘计算的共识机制来减少共识消耗;声誉机制能够提高框架的安全性。所以本方案在确保了准确性的前提下,能够有效应对恶意攻击,安全性良好。 最后,比较了BME-FL、传统联邦学习和文献[32]方案在应对恶意攻击时的表现,结果如图5所示。联邦学习框架非常容易受到系统内外攻击者的攻击,从而损害数据隐私和系统稳健性,恶意的攻击者会在联邦学习的各个进程中发起攻击,从节点获取敏感数据,降低联邦学习全局模型的准确性,并使全局模型无法收敛,甚至会导致隐私数据的泄露。 如图5所示,在本次实验中,假设恶意节点进行高斯随机噪声扰动攻击,随着恶意节点比例的上升,后两者的准确性水平都受到了严重的影响,在受到恶意攻击时,两者都没有作出有效的防御措施。本文方案使用了基于声誉值计算的防御措施,根据每个工作节点的行为来计算其各自的声誉值,使正常工作的诚实节点能够获得高声誉值,通过这种手段能够筛选出一部分可靠的工作节点,从而提高应对攻击的能力。 4 结束语 随着人工智能、大数据以及物联网等技术的飞速发展,使得数据量激增以及隐私泄露问题日益严重。于是,联邦学习这种新型的分布式模型训练框架应运而生,但是联邦学习的安全性同样面临着许多的挑战。恶意的联邦学习训练节点会破坏全局模型,而恶意的中央服务器也会泄露节点的私有数据。为了应对这些挑战,本文利用安全稳定的区块链来替代中心服务器,全局模型以及模型更新参数的维护和管理工作由部署在链上的智能合约完成,区块链系统以其不可窜改和去中心化的特点,保证了模型训练过程的安全可靠,能够有效避免恶意中央服务器或恶意节点的影响。本文在区块链系统的基础上,提出了基于边缘计算的共识机制,利用计算能力更强的边缘节点来执行共识过程,并且在共识流程中加入了声誉值机制。本方案从正向价值和负面价值两方面来衡量节点的最终声誉值,不仅能够激励诚实的终端节点,而且可以使恶意节点受到惩罚,从而能够方便地找到更为安全可靠的终端节点。最后本文采用FEMNIST数据集验证了该框架的有效性。实验表明,本文方案在保证准确度的同时,能有效应对恶意攻击。 参考文献: [1]吕腾波,杨震.搭建数据孤岛间的信任桥梁[J].科学中国人,2021(29):46-47.(Lyu Tengbo, Yang Zhen. Building a trust bridge between data islands[J].Scientific Chinese,2021(29):46-47.) [2]Tian Li, Kumar S A, Talwalkar A, et al. Federated learning: challenges, methods, and future directions[J].IEEE Signal Processing Magazine,2020,37(3):50-60. [3]Liu Peng, Xu Xiangru, Wang Wen. Threats, attacks and defenses to federated learning:issues, taxonomy and perspectives[J].Cybersecurity,2022,5(1):1-19. [4]李凌霄,袁莎,金銀玉.基于区块链的联邦学习技术综述[J].计算机应用研究,2021,38(11):3222-3230.(Li Lingxiao, Yuan Sha, Jin Yinyu. Review of blockchain-based federated learning[J].Application Research of Computers,2021,38(11):3222-3230.) [5]Karthik V, Harmon S, Sanford T, et al. Federated learning improves site performance in multicenter deep learning without data sharing[J].Journal of the American Medical Informatics Association,2021,28(6):1259-1264. [6]Nguyen D C, Pathirana P, Ding Ming, et al. Blockchain for 5G and beyond networks:a state of the art survey[J].Journal of Network and Computer Applications,2020,166:102693. [7]孙毅,范灵俊,洪学海.区块链技术发展及应用:现状与挑战[J].中国工程科学,2018,20(2):27-32.(Sun Yi, Fan Lingjun, Hong Xuehai. Technology development and application of blockchain:current status and challenges[J].Strategic Study of Chinese Academy of Engineering,2018,20(2):27-32.) [8]Xia Xiaoyu, Chen Feifei, He Qiang, et al. Cost-effective app data distribution in edge computing[J].IEEE Trans on Parallel and Distributed Systems,2020,32(1):31-44. [9]Yuan Liang, He Qiang, Tan Siyu, et al. CoopEdge: a decentralized blockchain-based platform for cooperative edge computing[C]//Proc of Web Conference.New York:ACM Press,2021:2245-2257. [10]Wang Qianlong, Guo Yan, Yu Lixing, et al. Earthquake prediction based on spatio-temporal data mining:an LSTM network approach[J].IEEE Trans on Emerging Topics in Computing,2017,8(1):148-158. [11]Abdulrahman S, Tout H, Ould-Slimane H, et al. A survey on federated learning: the journey from centralized to distributed on-site lear-ning and beyond[J].IEEE Internet of Things Journal,2020,8(7):5476-5497. [12]Assaf A, Iishamsir A W, Muhammad M. Benefits and risks of cloud computing in e-government tasks:a systematic review[C]//Proc of E3S Web of Conferences.[S.l.]:EDP Sciences,2021:04005. [13]Konecny J, McMahan H B, Yu F X, et al. Federated learning:stra-tegies for improving communication efficiency[EB/OL].(2017-10-30).https://arxiv.org/abs/1610.05492. [14]Sun Lichao, Qian Jianwei, Chen Xun. LDP-FL:practical private aggregation in federated learning with local differential privacy[EB/OL].(2021-05-21).https://arxiv.org/abs/2007.15789. [15]Hegedüs I, Danner G, Jelasity M. Gossip learning as a decentralized alternative to federated learning[C]//Proc of IFIP International Conference on Distributed Applications and Interoperable Systems.Berlin:Springer,2019:74-90. [16]Li Jun, Shao Yumeng, Kang Wei, et al. Blockchain assisted decentralized federated learning (BLADE-FL):performance analysis and resource allocation[J].IEEE Trans on Parallel and Distributed Systems,2021,33(10):2401-2415. [17]Wu Xin, Wang Zhi, Zhao Jian, et al. FedBC: blockchain-based decentralized federated learning[C]//Proc of IEEE International Conference on Artificial Intelligence and Computer Applications.Piscataway,NJ:IEEE Press,2020:217-221. [18]Short A R, Leligou H C, Papoutsidakis M, et al. Using blockchain technologies to improve security in federated learning systems[C]//Proc of the 44th Annual Computers, Software, and Applications Conference.Piscataway,NJ:IEEE Press,2020:1183-1188. [19]Kim H, Park J, Bennis M, et al. On-device federated learning via blockchain and its latency analysis[EB/OL].(2018-08-12).https://arxiv.org/abs/1808.03949v1. [20]Qu Youyang, Gao Longxiang, Xiang Yong, et al. Decentralized privacy using blockchain-enabled federated learning in fog computing[J].IEEE Internet of Things Journal,2020,7(6):5171-5183. [21]邢丹,徐琦,姚俊明.邊缘计算环境下基于区块链和联邦学习的医疗健康数据共享模型[J].医学信息学杂志,2021,42(2):33-37.(Xing Dan, Xu Qi, Yao Junming. Medical and health data sharing model based on blockchain and federated learning in edge computing environment[J].Journal of Medical Informatics,2021,42(2):33-37.) [22]Liu Yi, Zhao Ruihui, Kang Jiawen, et al. Towards communication-efficient and attack-resistant federated edge learning for industrial Internet of Things[J].ACM Trans on Internet Technology,2021,22(3):1-22. [23]Kang Jiawen, Xiong Zehui, Niyato D, et al. Incentive mechanism for reliable federated learning:a joint optimization approach to combining reputation and contract theory[J].IEEE Internet of Things Journal,2019,6(6):10700-10714. [24]Hammoud A, Otrok H, Mourad A, et al. On demand fog federations for horizontal federated learning in IoV[J].IEEE Trans on Network and Service Management,2022,19(3):3062-3075. [25]Caldas S, Tian Li, Konecny J, et al. Leaf: a benchmark for federated settings[EB/OL].(2019-12-09).https://arxiv.org/abs/1812.01097. [26]Kairouz P, Liu Ziyu, Steinke T. The distributed discrete Gaussian mechanism for federated learning with secure aggregation[C]//Proc of International Conference on Machine Learning.2021:5201-5212. [27]Garg N, Sellathurai M, Bhatia V, et al. Online content popularity prediction and learning in wireless edge caching[J].IEEE Trans on Communications,2020,68(2):1087-1100. [28]Weng Jiasi, Li Ming, Luo Weiqi, et al. DeepChain:auditable and privacy-preserving deep learning with blockchain-based incentive[J].IEEE Trans on Dependable and Secure Computing,2019,18(5):2438-2455. [29]Chai Haoye, Chen Yijin, Zhang Ke, et al. A hierarchical blockchain-enabled federated learning algorithm for knowledge sharing in Internet of Vehicles[J].IEEE Trans on Intelligent Transportation Systems,2020,22(7):3975-3986. [30]Lugan S, Desbordes P, Brion E, et al. Secure architectures implementing trusted coalitions for blockchained distributed learning (TCLearn)[J].IEEE Access,2019,7:181789-181799. [31]Lu Yunlong, Huang Xiaohong, Zhang Kecheng, et al. Blockchain empowered asynchronous federated learning for secure data sharing in Internet of Vehicles[J].IEEE Trans on Vehicular Technology,2020,69(4):4298-4311. [32]Dong Yin, Chen Yudong, Ramchandran K, et al. Byzantine-robust distributed learning: towards optimal statistical rates[C]//Proc of International Conference on Machine Learning.2018:5650-5659.