基于属性引导的多源遥感舰船目标可解释融合关联网络

2024-01-20熊振宇崔亚奇董凯李孟洋熊伟

熊振宇,崔亚奇,董凯,李孟洋,熊伟

海军航空大学 信息融合研究所,烟台 264001

近年来,随着天基海洋监视系统的大力发展,星载成像技术作为一种早期预警探测的重要手段受到广泛关注[1]。考虑到海洋环境多变,舰船类型繁多,图像背景信息繁杂,想要从大规模舰船数据库中找到用户感兴趣的舰船目标图像十分困难。除此之外,不同传感器获取的多源遥感目标信息类型多样,如全色遥感图像空间分辨率高,但光谱信息单一,多光谱遥感图像光谱分辨率高,但空间分辨率低,同时利用多源遥感图像能够实现优势互补。对于一张给定的舰船目标图像,多源遥感舰船目标关联模型能够从多源数据库中找到与其类别相同但源于不同类型传感器的图像,即相关联的异源舰船目标图像。因此构建一个高效的多源遥感舰船目标关联模型是当前亟需解决的问题。

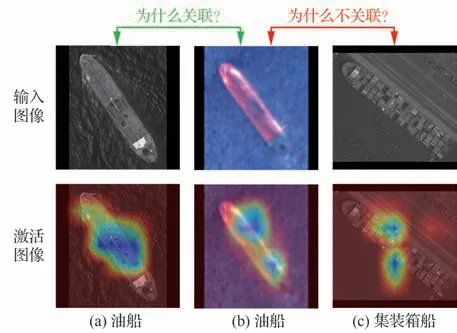

得益于深度神经网络强大的特征表示能力,许多学者将深度学习用于解决遥感图像舰船目标识别任务[2-4]。但是这些算法只能区分舰船有无或进行粗粒度的识别。当前的卫星成像技术能够获取到高分辨率遥感图像以实现舰船目标的细粒度识别[5]。然而关联任务与识别任务不同,网络所学习到的特征不仅需要有足够的判别性,还要在度量空间中有很好的可分性。除此之外,现有的算法只是用于解决同源舰船图像的关联任务,多源图像间由于特征分布不同,存在“异构鸿沟”,使得传统同源关联算法无法适用于多源舰船图像关联任务。近年来有许多工作通过构建多源网络将多源特征映射到共同的空间中进行度量[6-8]。但是这些算法都是用于处理多源遥感场景图像,难以完成基于舰船目标的细粒度关联任务,其主要挑战在于构建的网络需要辨别舰船目标的细微差异。为了让网络聚焦遥感图像复杂场景下的显著性区域,一些工作通过利用域自适应注意力网络[9]、感受野增强模块[10]、细粒度生成网络[11]和视觉注意力模型[12]来提升模型的判别能力。但除了要求模型有足够判别能力,可解释性也是衡量模型优越性的关键因素。大部分现有深度学习算法只是一个“黑盒模型”,仅让训练的网络能够无限逼近或者拟合训练数据的特征分布而无法为最终的输出结果给出合理的解释,使得用户难以信任网络的输出结果,知其然而不知其所以然。如图1 所示,利用DDN 网络[7]对多光谱和全色舰船图像进行关联,并通过Grad-CAM 算法[13]对训练好的网络模型进行特征可视化,从激活图像看出,网络的显示决策不完全依赖于目标的判别性区域。因此,对于关联任务,模型无法解释为什么图1(b)与图1(a)关联而不与图1(c)关联。

图1 输入图像和与之对应的激活图像Fig.1 An input image and its corresponding activation image

为了解决上述问题,本文提出了一种基于属性引导的可解释融合网络用于实现多光谱和全色舰船目标遥感图像间关联。该网络主要分为全局关联模块和可解释模块2 大部分。在全局关联模块中,首先将利用深度神经网络提取图像的高层语义特征,然后设计跨模态度量损失函数对不同模态图像的特征向量进行约束并映射到共同空间中进行度量。一方面采用模态间约束函数让不同模态的同类图像特征在度量空间中距离更近,异类图像距离更远,从而打破不同模态的异构鸿沟,解决不同模态特征难度量问题;另一方面采用模态内约束函数让各自模态内部的同类图像在特征空间中更加聚集,异类图像更加分散,从而保留了各自模态内的判别性语义信息。考虑到诸如夹板、舰首、船尾等舰船目标属性在语义上是人类可以理解的,所以在可解释模块中,首先采用多头注意力模型,帮助网络关注于舰船目标中多个显著性区域,然后将输出的多个注意力特征图与全局模块中的特征图进行融合后转换成融合特征,再利用属性监督函数引导可解释模块训练,帮助模型关注于舰船图像中的判别性属性特征,让模型借助属性标签以量化的形式计算出每个属性区域对最终关联结果贡献度,解析模型的关联决策过程,最后采用知识蒸馏的思想构建蒸馏度量损失函数,减小全局关联模块和可解释模块输出特征距离的差异,让网络实现可解释性的同时不会降低关联精度。考虑到当前没有公开的基于舰船目标的多源遥感图像数据集,本文构建了目前首个多源遥感图像舰船目标数据集,其中包含了6 个舰船类别的全色和可见光遥感图像。利用该数据集对本文算法模型进行有效性验证,实验结果表明本文算法在关联准确率上明显优于现有关联算法,同时直观的可视化量化结果进一步体现了模型强大判别力的同时兼备模型的可解释性。

1 模型方法

本节主要介绍了基于属性引导的可解释融合关联网络的具体结构,网络主要包括全局关联模块和可解释模块2 部分,全局关联模块主要通过深层网络提取特征后,利用跨模态度量损失函数将不同模态映射到共同的空间,拉近具有相同语义信息的舰船目标图像在特征空间中的距离。在可解释模块中利用多头注意力机制让网络关注舰船目标判别性区域,利用属性标签作为监督信息引导网络学习具有舰船属性含义的判别性特征。最后利用知识蒸馏的思想建立2 个模块间的桥梁,使得提出的网络模型同时兼备判别能力和模型可解释性。算法的整体框架如图2所示。

1.1 全局关联模块

对于给定的多源舰船图像数据集D={XP,XM},其中表示N张全色舰船目标图像,表示N张多光谱舰船目标图像。利用卷积神经网络作为特征提取器分别提取多源图像特征,最后一层卷积层(Conv5)输出的特征图分别表示为FP和FM。利用全局平均池化(Global Average Pooling,GAP)方式分别得到全色和多光谱模态特征向量为fP和fM。为了增加模型的判别性,本文提出了一种跨模态度量损失函数,一方面将不同模态的特征向量映射到共同空间中进行度量,另一方面拉近同类的舰船目标在特征空间中的距离,同时让不同类别的舰船目标在特征空间中的距离更远。跨模态度量损失函数的定义为

式中:Linter(fP,fM)表示模态间约束函数。其目的是让不同模态的同类舰船图像在特征空间中的距离更近,异类图像距离更远。模态间约束函数定义为

其中:τPP和τMM分别表示全色和多光谱模态的相似性系数;分别表示全色和多光谱模态内指示器,当与类别相同时,=1(i=1,2,…,N;j=1,2,…,N);当与类别不同时,=0(i=1,2,…,N;j=1,2,…,N)。的取值方式与相同。

当舰船目标图像的特征向量在度量空间中距离越近,关联程度越高;距离越远,关联程度越低。下面计算全局关联模块中特征向量在度量空间中的距离为

式中:D表示距离度量,本文采用欧式距离的度量方式。

1.2 可解释模块

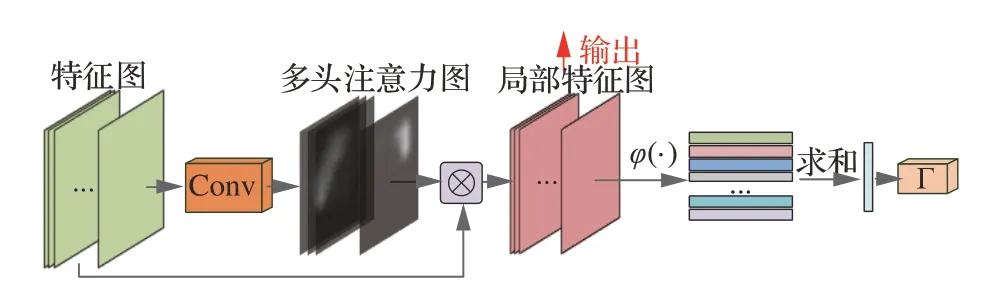

解释模块主要包含多头注意力模型和属性监督函数。多头注意力模型帮助网络关注于舰船目标中多个显著性区域,然后将输出的多个注意力特征图与全局模块中的特征图进行融合后转换成融合特征;属性监督函数引导可解释模块训练,帮助模型关注于舰船图像中的判别性属性特征。具体结构如下:

1)多头注意力模型

图3 多头注意力模型框架Fig.3 A framework of multi-head attention model

式中:M表示特征图的数量;ΨM和ΨP分别表示多光谱和全色模态的二维卷积函数∈AM和∈AP分别表示网络重点关注到多光谱和全色舰船图像中的一个判别性区域。将特征图和多头注意力图通过元素相乘的方式进行融合以得到细粒度区域特征图

式中:φ表示全局平均池化函数;分别表示多光谱和全色模态的局部注意力特征。最后利用分类器对多头注意力模型进行约束,分类器的损失函数采用交叉熵损失表示为Latt。

2)属性监督函数

通过多头注意力模型分别输出多光谱和全色模态的M个局部特征图。按照对应元素相乘的方式分别将rM与rP和全局关联模块中输出的特征图FP和FM进行融合

在多源舰船目标数据集中,对每一张舰船图像添加了属性标签,属性标签采用二值编码的向量表示,第i张图像xi的属性标签可表示为向量,其中代表第k个属性标签,采用布尔数值表示,即=0 表示该舰船图像中不包含该属性=1 表示该舰船图像中包含该属性。R表示舰船目标图像xi中属性的数量。构建属性监督损失函数,利用属性标签引导网络关注舰船目标显著性属性信息,为最终网络的关联决策结果提供可解释的判别依据。属性监督损失函数定义为

式中:dij表示全局模块中图像特征向量的距离;表示可解释模块中图像和特征向量的距离。通过优化蒸馏度量损失保证全局模块和可解释模块间度量距离的一致性,让网络有足够判别能力的同时具备强大的可解释能力。

1.3 损失函数

结合全局关联模块和可解释模块,综合构建基于属性引导的可解释融合网络总损失函数,其中包括跨模态度量损失函数Lmetric,注意力损失函数Latt,属性监督损失函数Lattr和蒸馏度量损失函数Ldis。总损失函数定义为

式中:α、β和λ表示超参数,在训练过程中用于平衡各损失函数在网络中的权重。通过优化总损失函数,让网络能够快速关注到舰船目标的显著性区域,利用属性信息对网络进行约束,帮助网络实现多源舰船目标间精准关联,同时为关联结果提供合理的可解释判别依据。

2 实验结果

2.1 数据集

随着卫星成像技术的不断发展,星载成像手段不断进步,成像类型不断增多,数据量不断增大。为应对人工智能技术对海量数据的需求,目前一些研究者开源了遥感图像数据集[14-16]。但这些数据都单模态遥感场景图像数据,即获取的图像都在于相同的传感器源。为填补多源遥感数据空白,Li 等[6]首次提出了面向遥感场景图像的全色和多光谱数据集,Lu 等[17]提出了遥感图像和文本跨模态开源数据集,Gou 等[18]开源发布了光学图像和语音跨模态数据集。同时本团队近年来构建了可见光和SAR 图像跨模态数据集[19]。但这些数据集都是面向大规模遥感场景图像,无法解决基于目标类的细粒度关联问题。随着卫星传感器技术不断进步,成像质量不断提高,星载传感器能够获取高分辨率遥感图像,本团队首次提出了基于属性信息的可见光舰船目标细粒度识别遥感图像数据集[20],但该数据集仅局限于同一种模态的舰船目标遥感图像。

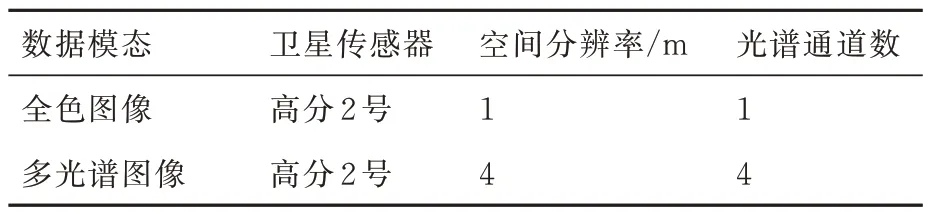

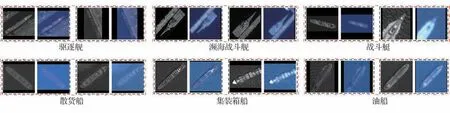

为有效应对当前日益复杂的海上战场环境,本文结合现实需求,构建了目前首个多源舰船图像数据集MRSSID。该数据集共有2 632 组图像切片,每组图像切片由同一时刻、同一区域拍摄的全色和多光谱舰船图像组成,并且不同模态的相同舰船图像是一一对应的。MRSSID 包含了6 个舰船类别,分别是驱逐舰、濒海战斗舰、战斗艇、散货船、集装箱船和油船。如表1 所示,该数据集全色图像的空间分辨率为1 m,多光谱图像的空间分辨率为4 m,并且包含了红、绿、蓝和近红外4 种波段。MRSSID 数据集的样例图像如图4 所示。

表1 数据集描述Table 1 Description of dataset

图4 MRSSID 数据集样例Fig.4 Examples from proposed MRSSID

2.2 实验设置

训练阶段,将MRSSID 数据集的80%图像对作为训练数据集,余下的20%图像对作为测试集。考虑到训练样本不均衡,利用图像翻转、随机剪裁和旋转、改变图像光照等级等策略对图像数据样本进行增强。在训练前,采用补零法将所有图像重新裁剪成224×224 大小。为了验证本文算法的有效性和数据集的适用性,在特征提取骨干网络选择上,采用在ImageNet[21]上预训练后的浅层网络Resnet18[22]和深层网络Resnet50[22]用于获取输入图像的高级特征。Resnet 采用了跳跃连接的残差模块,有效解决了梯度爆炸和深层网络中的退化问题,在当前众多计算机视觉任务中表现出强大的特征提取能力。训练时,首先利用训练数据集对全局关联模块进行训练,然后利用知识蒸馏的思想将其作参数固定后作为目标模型引导可解释模块进行训练。对于训练数据集中的图像,利用其与之对应的属性向量和全局关联模块中输出的特征距离dij作为可解释模块训练过程中的监督信息。训练过程中,采用梯度下降的优化方式,初始学习率和模型训练周期分别设置为0.001 和80,多头注意力参数M设置为12,损失函数中的超参数α、β和λ分别设置为0.5,0,1 和1。

式中:sim(q,i)表示图像有相同的标签的数量。所有实验都是在基于PyTorch 的深度学习框架上完成,实验设备为Ubuntu 16.04,32 GB of RAM,8 Intel(R)Core(TM)i7-6770K CPU,搭载了NVIDIA RTX 2080Ti GPU。

2.3 结果与分析

2.3.1 消融实验结果

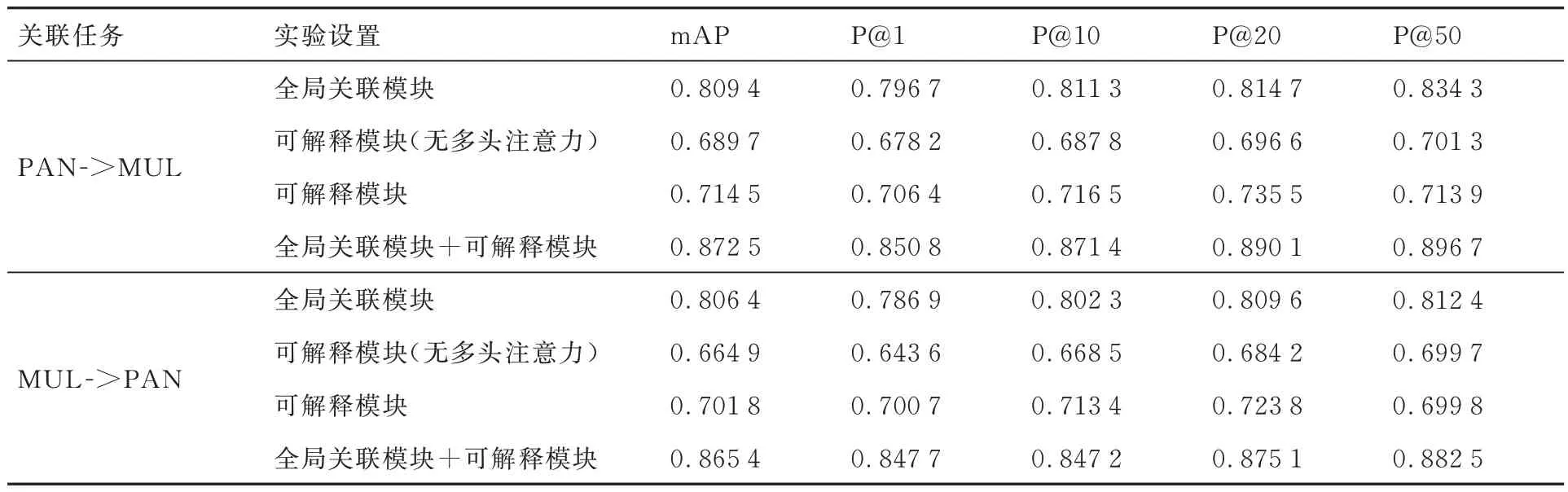

为了验证算法中各个模块的有效性,利用Resnet50 作为骨干网络提取图像特征,采用P@k和mAP 这2 种性能度量指标计算关联精度,实验结果如表2 所示。其中PAN->MUL 表示利用已有的全色舰船目标图像与数据库中的多光谱舰船目标图像进行关联,找到与已有图像相匹配的多光谱舰船目标图像。MUL->PAN 表示利用已有的多光谱舰船目标图像与数据库中的全色舰船目标图像进行关联,找到与已有图像相匹配的全色舰船目标图像。从实验结果可以看出,单纯利用可解释模块算法精度较低,在加上多头注意力模型后虽然关联精度有所提升,但关联效果依然不理想,这是因为多源图像模态异构,不同模态拥有不同的特征分布,不同模态图像间的类间距离小,类内距离大,直接对各自模态提取后的特征进行关联,关联精度低。全局关联模块利用跨模态度量损失函数将不同模态的特征映射到共同的空间中进行度量,提取更具判别性的跨模态特征。为了提取更多粒度舰船图像特征同时增加关联结果的可解释性,本文算法利用知识蒸馏将全局关联模块和可解释模块相结合,进一步提升了多源遥感舰船目标图像的关联精度。

表2 所提算法中各个模块有效性的关联精度Table 2 Evaluation of association accuracy of each module in proposed method

2.3.2 算法判别性验证

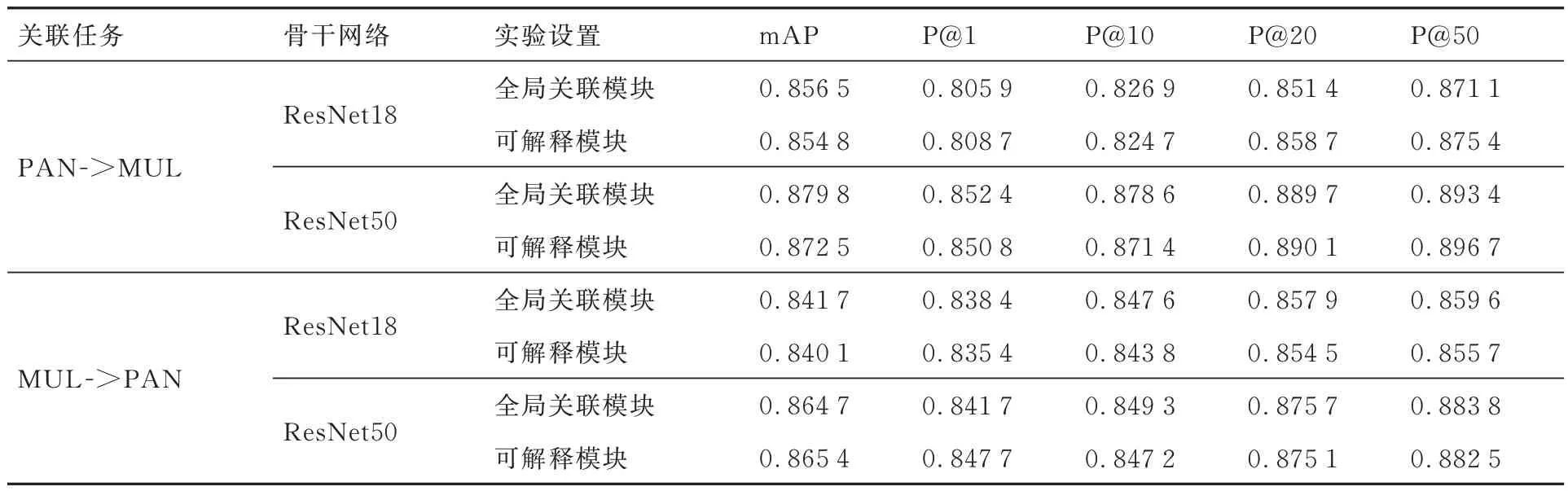

为了验证本文算法的有效性,采用P@k和mAP 这2 种性能度量指标综合衡量本文算法的判别能力,实验结果如表3 所示。从实验结果可以看出,在相同的关联任务下,ResNet50 比ResNet18 效果更好。这表明特征网络层数越深,关联精度越高。在相同的骨干网络和实验设置下,PAN->MUL 任务的关联精度略微高于MUL->PAN。这主要是因为全色图像分辨率高于多光谱图像,网络从全色图像中捕获到更多细节信息,丰富的特征信息帮助网络输出更具判别性的特征向量。除此之外全局关联模块和可解释模块在各项指标下的关联准确率非常接近,关联精度相差不超过1%。这意味着本文所采用的蒸馏学习方法所造成信息间的损失很小,在追求模型可解释性的同时,不会牺牲模型的判别能力。

表3 全局关联模块和可解释模块的关联精度评估Table 3 Evaluation of association accuracy of global association module and interpretable module

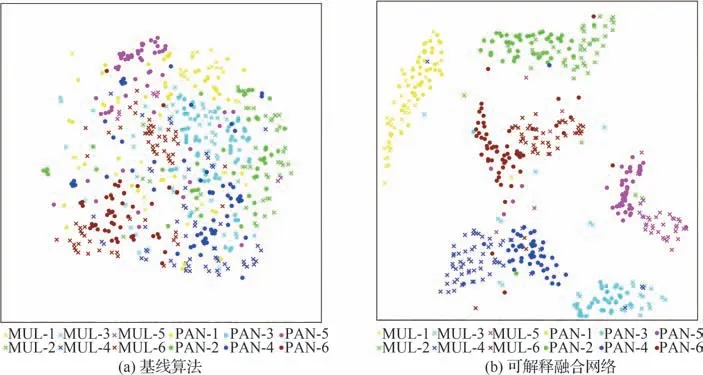

为了更加直观地表现出可解释融合网络的可分性和判别能力,采用t-分布随机领域嵌入[23](t-distributed Stochastic Neighbor Embedding,t-SNE)得到高维特征向量的二维特征表示,其通过主成分分析法(Principal Component Analysis,PCA)将高维特征压缩成二维。特征可视化的结果如图5 所示,其中图5(a)表示基线算法的特征可视化结果,即仅采用ResNet50 对图像提取特征后进行距离度量,图5(b)表示本文提出的可解释融合网络的特征可视化结果。不同颜色分别代表了不同的舰船图像类别,形状为“×”和“●”分别代表了多光谱和全色图像。从试验结果可以看出,相比于基线算法杂乱的特征表示,本文算法表现出良好的可分性和判别性。从全色和多光谱各自模态的分布中可以看出,同类图像距离更近,异类图像距离更远,表明了图像通过融合网路所输出的特征表现出精准的类内紧致性和类间可分性。对于不同模态但具有相同类别的舰船图像,其特征分布在度量空间中表现得更加聚集。对于不同模态不同类别的舰船图像,其特征在度量空间中相距更远。

图5 特征可视化实验结果Fig.5 Experimental results of feature visualization

2.3.3 算法可解释验证

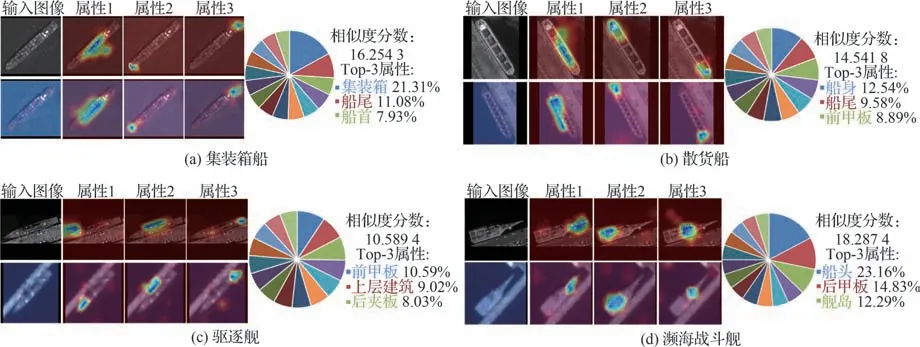

为了进一步验证本文算法的可解释性,利用属性引导的类激活注意力图展示模型的可解释实验结果,实验结果如图6 所示。实验结果分别展示了4 种不同类别关联舰船图像的可解释结果,每个类别的第1 列表示了2 张不同模态的关联图像,余下3 列表示了它们各自排名前3 的属性引导可视化类激活注意力图。从实验结果可以看出可解释融合网络能够精准关注到对应的属性区域。例如在图6(a)的集装箱船关联结果中,网络能够有效关注到2 种不同模态的相同属性区域,如属性1 对应的集装箱属性,属性2 对应的船尾属性和属性3 对应的船首属性。除此之外,对于一些背景信息繁杂,舰船目标小,部分轮廓模糊的情况(图6(c)),提出的可解释融合网络依然能够关注到具有判别性的属性区域,进一步验证了本文算法优越的可解释性能。

图6 属性特征类激活图与量化可视化结果Fig.6 Attribute guided class activation maps and quantitative visualization results

除此之外,计算了每组关联图像的相似性分数,以量化的方式展示出排名前三的属性对最终关联结果的影响百分比,同时以饼图的形式更加直观的可视化了属性对最终决策结果的贡献度。实验结果表明,4 个不同类别的量化结果都对网络的关联结果提供了清晰准确的模型解释。

2.3.4 参数分析

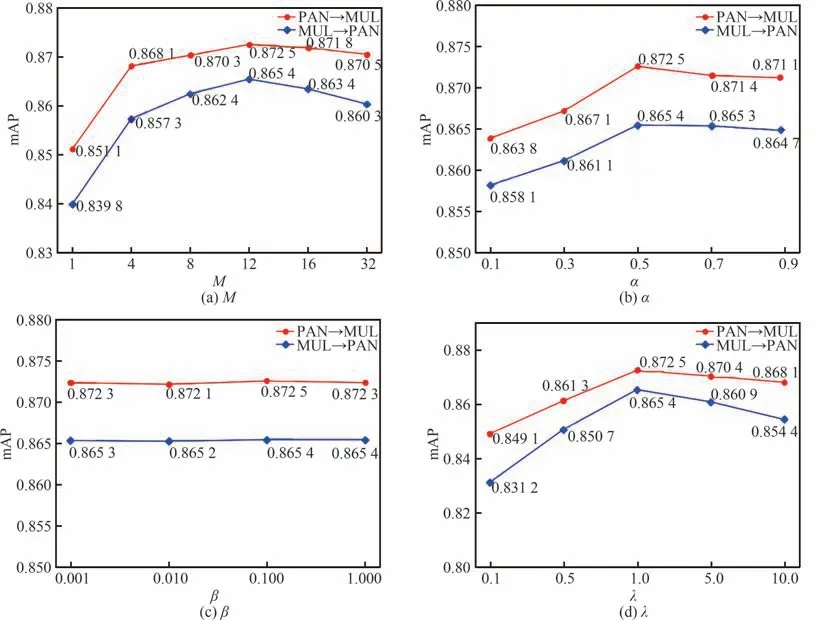

多头注意力模型中的参数M和损失函数中的超参数α、β和λ是可解释融合关联网络中的重要参数,为评估网络中设计的参数对最终关联效果的影响,设计参数分析实验如图7 所示。图7(a)反应了多头注意力中注意力头的数量M对关联精度的影响,从图中可以看出当M取值为12 时,关联精度最高。图7(b)反应了超参数α对关联精度的影响,当α取值较小时,即多头注意力模块在总损失占比较小时,关联精度较低,随着α不断增大,关联精度不断增加,当α设置为0.5 时达到最佳关联效果。图7(c)反映了超参数β对关联精度的影响,从图中可以看出随着β的增加关联准确率几乎不变,即属性监督函数在总损失函数中的占比对关联结果影响较小,该损失主要引导网络输出可解释的关联结果。图7(d)反映了超参数λ对关联精度的影响,当λ取值为1 时,关联精度最高。

图7 参数不同取值下关联精度的变化曲线Fig.7 Curves of retrieval accuracy with respect to different values of parameters

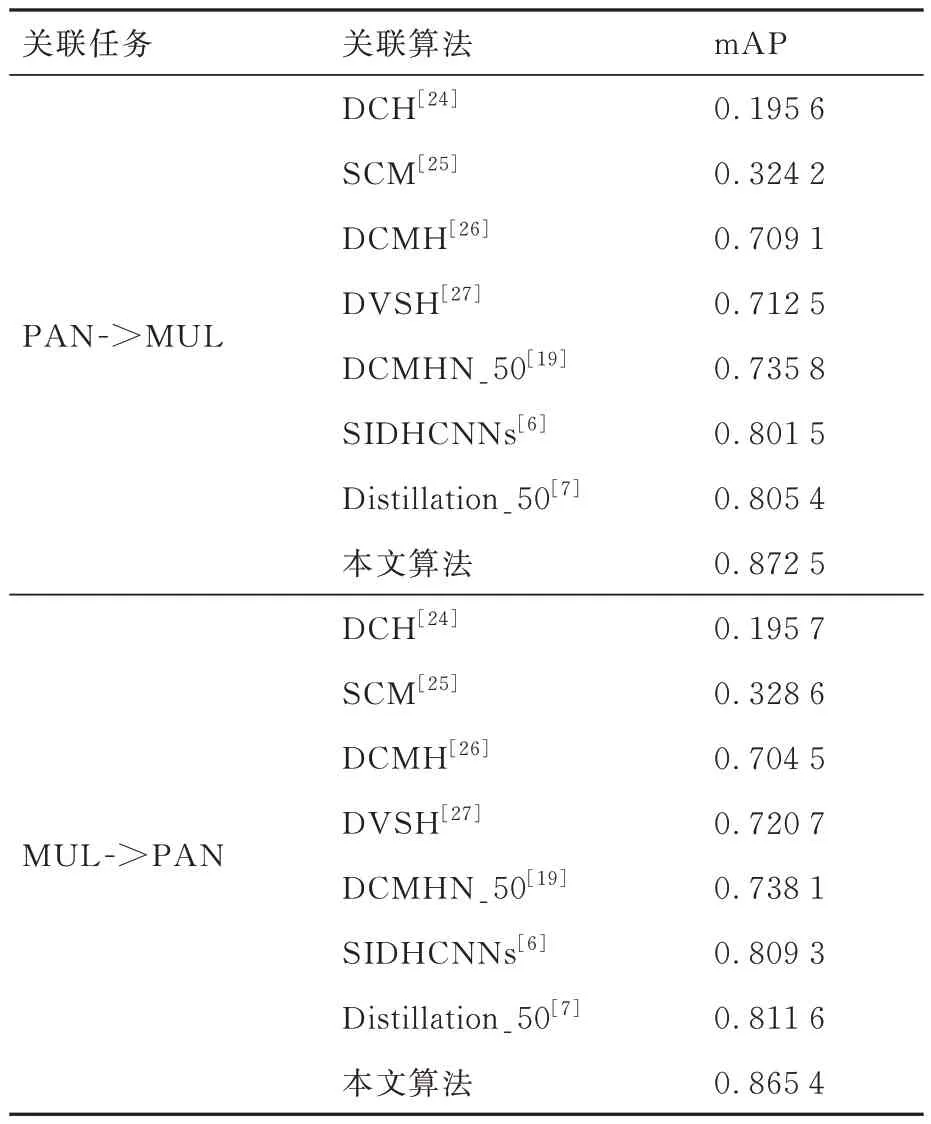

2.3.5 对比实验

为了进一步验证本文算法的优越性,表4 比较了现有关联算法和本文算法的关联精度。其中DCH[24]和SCM[25]算法为经典的多模态关联算法,他们通过生成二值哈希编码来表示不同模态数据的特征。然而,他们都是基于手工特征表示方法,在PAN->MUL 和MUL->PAN 跨模态关联任务中关联精度较差。这主要是因为基于手工特征的哈希表示方法无法有效保留不同模态的语义信息同时难以生成具有判别性的哈希编码。表4 中的其他算法都是基于深度特征的关联算法,从实验结果可以看出他们的关联精度明显优越基于手工特征的关联算法。然而DCMH[26]和DVSH[27]算法主要通过提取深度特征以生成哈希编码来解决自然图像和文本间的跨模态关联任务,遥感图像内容的复杂性限制了所生成深度哈希编码的有效性。DCMHN_50[19]通过构建深度跨模态哈希网络实现SAR 图像和可见光图像间的关联,SIDHCNNs[6]和Distillation_50[7]通过构建共同语义空间完成了多光谱和全色图像间的关联。但这些工作主要是解决大规模遥感场景图像之间的关联任务,难以有效实现对高分辨率舰船目标的细粒度关联。本文算法在2 个跨模态关联任务中达到最佳关联准确率,相较于Distillation_50 分别在PAN->MUL和MUL->PAN 这2 个关联任务中分别高出了6.71%和5.38%。进一步验证了本文算法相较于当前算法在舰船目标跨模态关联任务中的优越性,体现了本文算法不仅能够有很好的特征可解释性,同时具备强大的判别能力。除此之外,相较于其他跨模态关联算法,本文提出的可解释融合关联网络具有很强的泛化能力,网络中的可解释模块是即插即用模块,能够应用于图像与音频关联、图像描述和图文关联等跨模态任务中,便于提升模型的可解释性。

表4 关联精度对比实验结果Table 4 Comparison of association accuracy of different methods

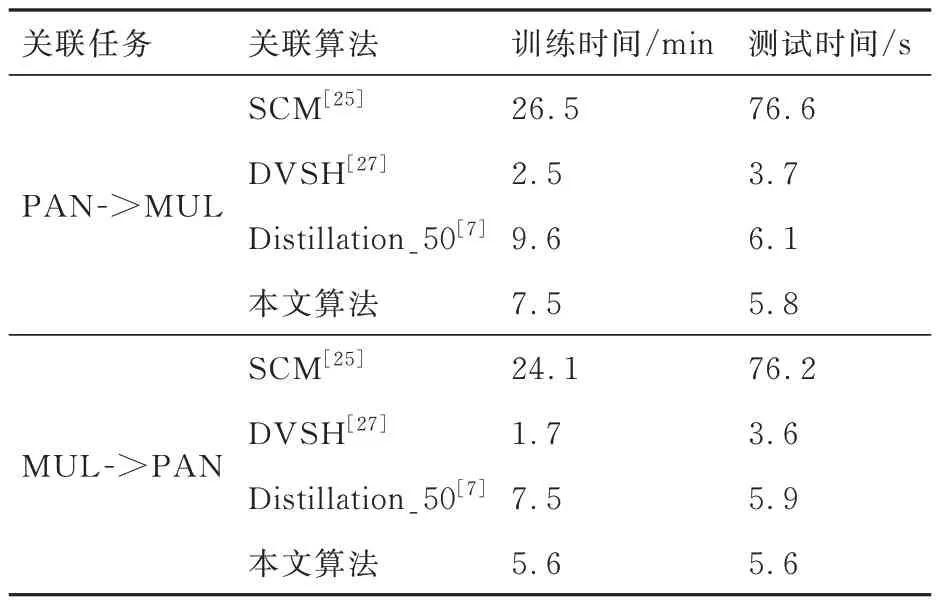

网络的计算效率同样是关联任务中重要的度量标准,通过比较不同基线算法的训练时间和测试时间来评估本文算法的计算复杂度,实验结果如表5 所示。考虑到SCM 算法采用人工特征的表示方法,在2 个关联任务中的耗费时间最长,效率最低,而其他3 种算法基于深度特征,关联速度得到显著提升。DVSH 算法采用哈希编码的表示方法,关联速度最快,但在表4 中,关联精度较低。关联精度提升往往导致更多的计算损耗,本文算法没有复杂的网络结构设计,能够在达到很高的关联准确率前提下将关联时间控制在可以接受的范围。

表5 关联时间对比实验结果Table 5 Comparison of association time of different methods

3 结论

本文提出了一种基于属性引导的可解释融合网络用于实现多光谱和全色舰船目标遥感图像间关联。该网络通过设计跨模态度量损失函数对不同模态图像的特征向量进行约束并映射到共同空间中进行度量;通过利用多头注意力模型,帮助网络关注于舰船目标中多个显著性区域;利用属性监督函数引导可解释模块训练,帮助模型关注于舰船图像中的判别性属性特征,解析模型的关联决策过程;构建蒸馏度量损失函数,让网络实现可解释性的同时不会降低关联精度。

实验中,本文构建了目前首个多源遥感图像舰船目标数据集。利用该数据集对本文算法模型进行有效性验证,实验结果表明本文算法在关联准确率上明显优于现有关联算法,同时直观的可视化量化结果进一步体现了模型强大判别力和可解释性。在后续工作中,对本文提出的多源遥感图像舰船目标数据集进一步扩充,同时对当前的可解释关联框架进一步优化,使其能够完成2 种以上模态数据之间的可解释关联任务。