基于分层深度强化学习的分布式能源系统多能协同优化方法

2024-01-19朱亚军

王 磊,胡 国,吴 海,谭 阔,周 成,朱亚军

(1.南瑞集团有限公司(国网电力科学研究院有限公司),江苏省南京市 211106;2.国电南瑞科技股份有限公司,江苏省南京市 211106)

0 引言

随着能源清洁低碳转型深入推进,新能源在电网中的逐步渗透,用户的能量需求开始多元化,能源利用正朝着多种能源之间的协调和互补形式发展[1-2]。分布式能源系统作为一种直接面向当地用户的能量供应点,其既包含多种能源输入,又可同时满足用户的多种能量需求[3]。因此,研究分布式能源系统的多能协同优化问题,对于促进新能源的消纳具有重要意义。

多能协同运行给分布式能源系统带来的益处显而易见,但随着新能源发电的逐步渗透和不同类型负荷的逐步增多,分布式能源系统中源荷的不确定性以及异质能源网络的时空差异性,给多能协同优化带来巨大挑战[1-2]。目前,许多学者已开展相关研究,文献[4]分析了多能源系统理论与方法研究框架,综述了面向新能源消纳的多能协同运行的关键研究点;文献[5]设计了一个计及用户侧需求响应和热惯性的多能园区优化调度模块,充分挖掘利用了用户侧、冷/热系统、储能资源的多时间尺度灵活调节能力;文献[6]针对风电、光伏出力的不确定性与反调峰特性,利用抽水蓄能和电化学储能的灵活调节特性,实现多种能源互补运行。由此可见,分布式能源系统多能协同优化运行需综合考虑多能源耦合性、源荷多重不确定性、异质能流多时间尺度特性和调控手段差异性等多种因素,在多能互补特性与源荷匹配规律方面还需进行深入细致的研究,进而实现互补系统性能质的提高和高比例可再生能源的提质增效;同时,多能协同运行模型的构建大都采用统一化通用建模方案,其在一定程度上降低了模型复杂度,但无法高效地解决异质能源网络的时空差异性问题。

多能协同优化问题实质上是求解一种序贯决策的问题。由于系统具有非线性、离散性、高维度以及不确定性等特点,导致求解该类问题十分困难。传统的调度方法局限于固定物理模型及参数设定,对数学模型过度依赖,同时,当模型具有高维度、不确定性等特征时,采用精确算法(如分支界定法、动态规划算法等)进行求解效果不理想,甚至无法求解[7];而采用启发式算法(如粒子群算法、遗传算法等)虽然对数学模型依赖程度低,但是易陷入局部最优解[8],难以满足优化需求,同时无法有效处理不确定性问题。目前,许多研究提出了采用强化学习方法解决此类问题,强化学习可以在复杂、不确定的环境中进行交互学习从而得到最优调度策略。文献[9]提出了一种双层强化学习模型以实现多能园区的实时经济调度;文献[10]考虑并网型多能源微网中横向电气热冷各子系统及纵向源网荷储等各环节构建了联合博弈决策模型,并提出了一种基于纳什博弈和强化学习的算法进行求解;文献[11]构建了多能源主体参与可再生能源消纳经济性分析模型,并提出了一种纳什均衡迁移强化学习算法进行求解;文献[12]考虑多储能、可再生能源、能源转换和能源交易,构建了一种工业多能源调度框架,采用基于强化学习的差分进化算法进行求解。然而,随着分布式系统规模增大和可控参数增多,系统控制维度也会增加,这将导致上述研究所采用的强化学习方法中Q 值表的大小会呈指数级增长,则无法避免维数灾难的问题。受神经网络对高维搜索空间的强大探索能力的启发,深度强化学习以一种通用的形式把深度学习的感知力和强化学习的决策能力结合起来,通过高维度的方式感知信息训练模型发出决策,从而解决了高维空间维数灾难的问题[13-14]。目前,部分研究已将其应用于解决智能电网研究问题。文献[15]提出了一种结合深度强化学习与电力系统领域知识的运行优化方法,实现电力系统运行拓扑结构优化的快速计算;文献[16]提出一种基于参数共享机制的多智能体深度强化学习算法,用于求解社区能量管理协同优化问题;文献[17]提出一种基于改进深度强化学习的主动配电网日前最优调度策略,用于解决考虑可再生能源不确定性的主动配电网日前最优调度问题。但是,考虑到分布式能源系统内多种能源网络以及设备的时空层面差异性,多能协同优化问题进一步可认为是一种不同时间响应特性的复合空间的序贯决策问题,可采用分层强化学习方法进行求解[18]。其根据分层思想构建具有多层结构的深度强化学习策略,运用时序抽象表达方法学习细粒度时间的下层动作和粗粒度时间的上层动作, 将复杂问题分解为数个简单问题进行求解。但目前针对应用分层强化学习方法求解此类问题的研究较少,其主要应用于视觉导航[19]、自然语言处理[20]、推荐系统[21]和视频描述生成[22]等应用领域。

针对上述问题,本文首先提出了一种面向分布式能源系统的两阶段多能协同优化模型,将分布式能源系统总控制过程解耦为长时间尺度和短时间尺度的两阶段控制形式,实现了对不同时间响应特性的复合空间进行序贯决策。然后,采用基于双重深度Q 网络(double deep Q-learning network,DDQN)的深度强化学习求解方案,将两阶段多能协同优化模型转换为两阶段的马尔可夫决策过程(Markov decision process,MDP)。基于两阶段控制形式对DDQN 算法进行分层改进,从而提出一种全新的具有高维复合空间动作探索感知思维能力的分层双重深度Q 网络(hierarchical double deep Q-learning network,HDDQN)算法,对不同时间响应特性的复合空间进行探索学习,深度隐式处理系统源荷的不确定性,从而获取多能协同决策最优解,在满足用户用能需求的同时提升了新能源的消纳水平。最后,通过采用某分布式能源系统示范园区算例进行求解分析,算例仿真结果验证了所提模型和求解方法的有效性和优越性。

1 分布式能源系统结构组成

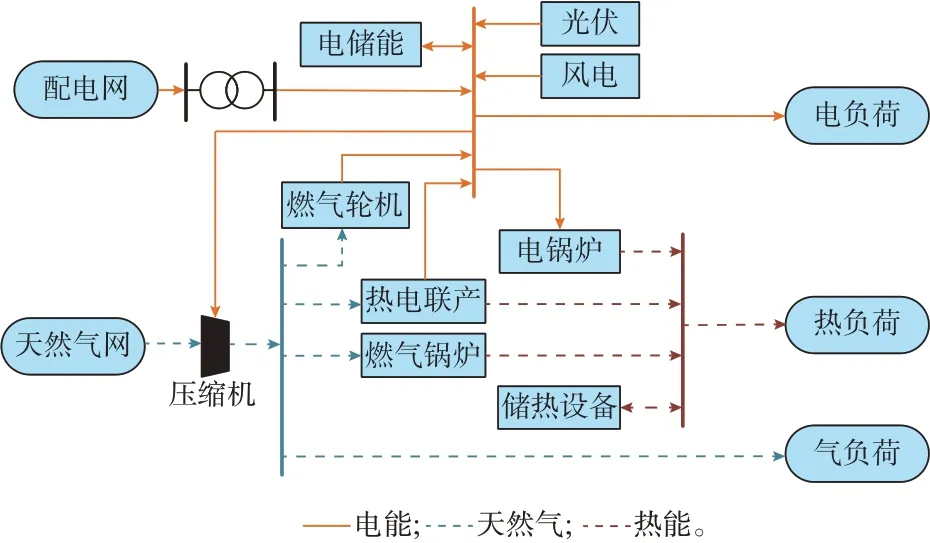

分布式能源系统主要由能量供给侧、能量转换设备、储能设备和能量需求侧组成。本文以图1 所示的分布式能源系统为例进行多能协同优化问题的研究,其中能量供给侧只涉及电力和天然气的输入(由于热源不适宜远距离传输);能量转换设备包括热电联产机组、燃气轮机、光伏装置、风电装置、电锅炉和燃气锅炉;储能设备包括储电装置和储热装置;能量需求侧由电负荷、热负荷和燃气负荷构成。该分布式能源系统相关组件的数学模型详见附录A式(A1),可根据实际工程应用需求对其组件进行增减,本文在这里不进行详细阐述。

图1 分布式能源系统拓扑Fig.1 Topology of distributed energy system

2 两阶段多能协同优化模型

本文所建立的多能协同优化模型采用灵活性平衡理论[23]:当系统负荷、可再生能源功率发生变化时,通过多能协同运行的方式调度各灵活性资源,深度挖掘系统灵活性供给,使得系统灵活性供给和需求之间达到平衡,从而在满足各种用能需求的同时,尽可能消纳更多的可再生能源。

在分布式能源系统中,灵活性需求指的是可再生能源出力和3 种类型负荷需求在单位时间内的变化量,如式(1)所示。灵活性需求具有不确定性,其主要来源于源荷的随机性和波动性。

式中:ΔPt、Δft、Δϕt分别为在t时刻系统的电网、气网和热网的灵活性需求量,其中ΔPt≥0 为电网具有向上灵活性需求,ΔPt<0 为电网具有向下灵活性需求,Δft和Δϕt的灵活性需求方向性定义相同;为在t时刻的净负荷量,由在t时刻的电网负荷大小和风电机组实际出力以及光伏机组实际出力的差值所决定;分别为在t时刻的气负荷量和热负荷量。

在图1 中所示的分布式能源系统中,灵活性资源包括热电联产装置、微型燃气轮机、燃气锅炉、电锅炉、压缩机、储能电池以及储热装置。在满足分布式能源系统模型相关约束条件下,以多能协同方式调度各灵活性资源单位时间的变化量,从而提供灵活性供给,使得系统内灵活性达到平衡。此时,若灵活性无法达到平衡,则通过弃电(限制风电和光伏出力)或切负荷方式被动地使之平衡。因此,分布式能源系统的灵活性平衡具体可表示为:

式中:Npv、Nw分别为光伏和风电的机组数量;分别为第i台光伏和第j台风电机组在t时刻的并离状态,取值为1 表示并网,为0 表示离网分别为第i台光伏和第j台风电机组在t时刻的实际出力。

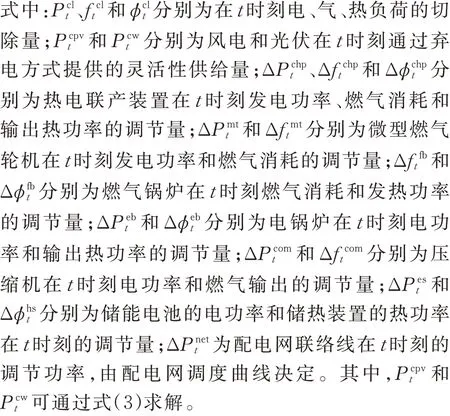

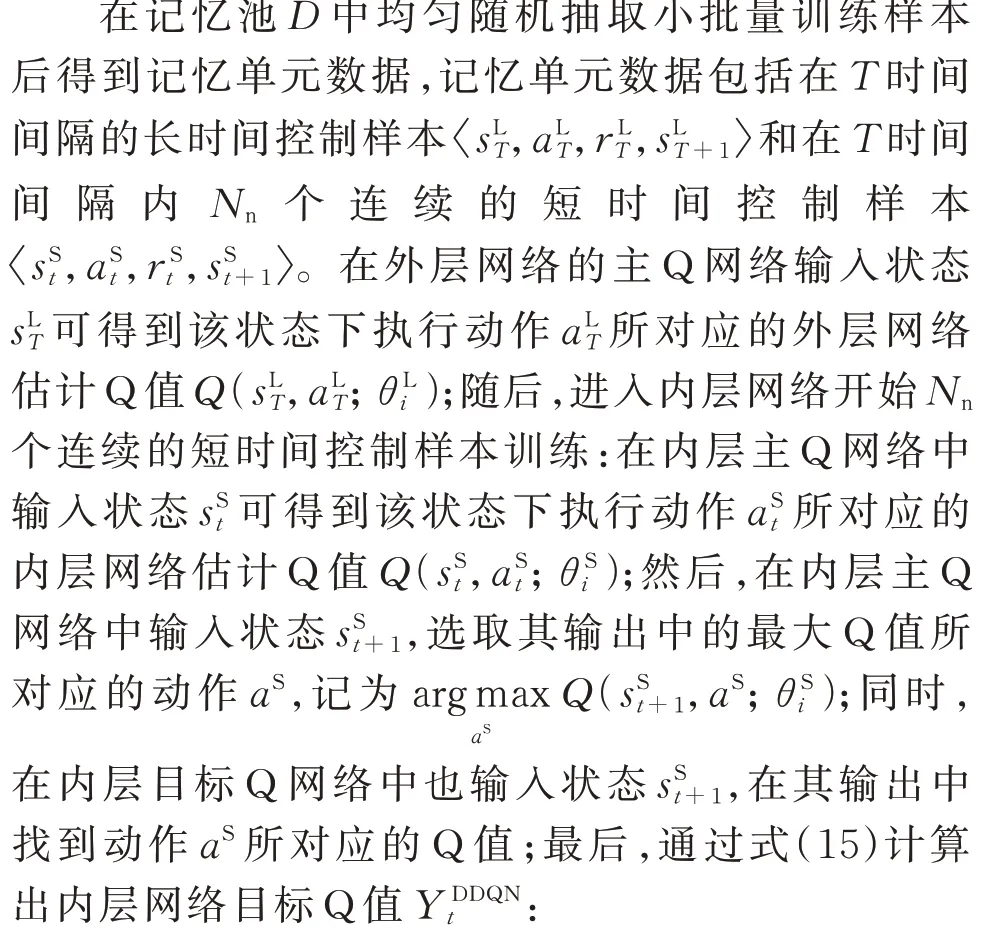

同时,考虑到不同能源网络的响应时间差异性以及能量耦合关系,对分布式能源系统进行解耦,如图2 所示,将总控制过程分为长时间尺度和短时间尺度两阶段控制形式,实现了对不同时间响应特性的复合空间进行序贯决策。具体来说,可以将整个时间段划分为NT个区间,即长时间尺度的划分;每个区间又可以进一步划分为Nn个时间间隔,即短时间尺度的划分。长时间尺度控制应用于动态响应特性较慢的非电能量供应环节,而短时间尺度控制应用于动态响应特性较快的电力供应环节。

图2 分布式能源系统解耦图Fig.2 Decoupling diagram of distributed energy system

式中:GHV为天然气的总热值;ω和λ为压缩机的工况常数;R0为压缩机的压缩比;和分别为燃气轮机在t时刻的发电效率和发电功率。

在长时间尺度控制中,控制目标是最大化满足非电负荷的用能需求,如式(6)所示。

在长时间尺度中,热电联产装置、压缩机、电锅炉、燃气锅炉、储热装置和切除非电负荷的调度在每个时间区间T开始时进行,其中,切除非电负荷调节量由其余5 个调节量和灵活性平衡等式(见式(2))所确定,因此,长时间尺度控制的决策变量为:

进一步,对长时间尺度的决策变量取值范围进行优化:当电网灵活性需求向上时,热电联产装置应增大发电功率,同时减小电锅炉的电功率,即Δ≥0,Δ≤0;当电网灵活性需求向下时,则相反,即Δ≤0,Δ≥0。显然,此优化方法即可提升模型的求解效率,也进一步挖掘系统的灵活性供给。

而在短时间尺度控制中,控制目标由电网灵活性需求方向所决定:当电网灵活性需求向上时,为了避免出现切负荷现象,此时控制目标为最大化满足电力负荷需求;当电网灵活性需求向下时,为了避免出现弃电现象,此时控制目标为可再生能源消纳最大化。因此,短时间尺度的控制目标如式(8)所示。

在短时间尺度中,微型燃气轮机、储能电池、弃电(风电和光伏)和切除电负荷的调度在每个时间间隔t开始时进行。其中,弃电(风电和光伏)和切除电负荷的调节量由其余2 个调节量和灵活性平衡等式(见式(2))所确定。因此,短时间尺度控制的决策变量为:

3 分层深度强化学习求解算法

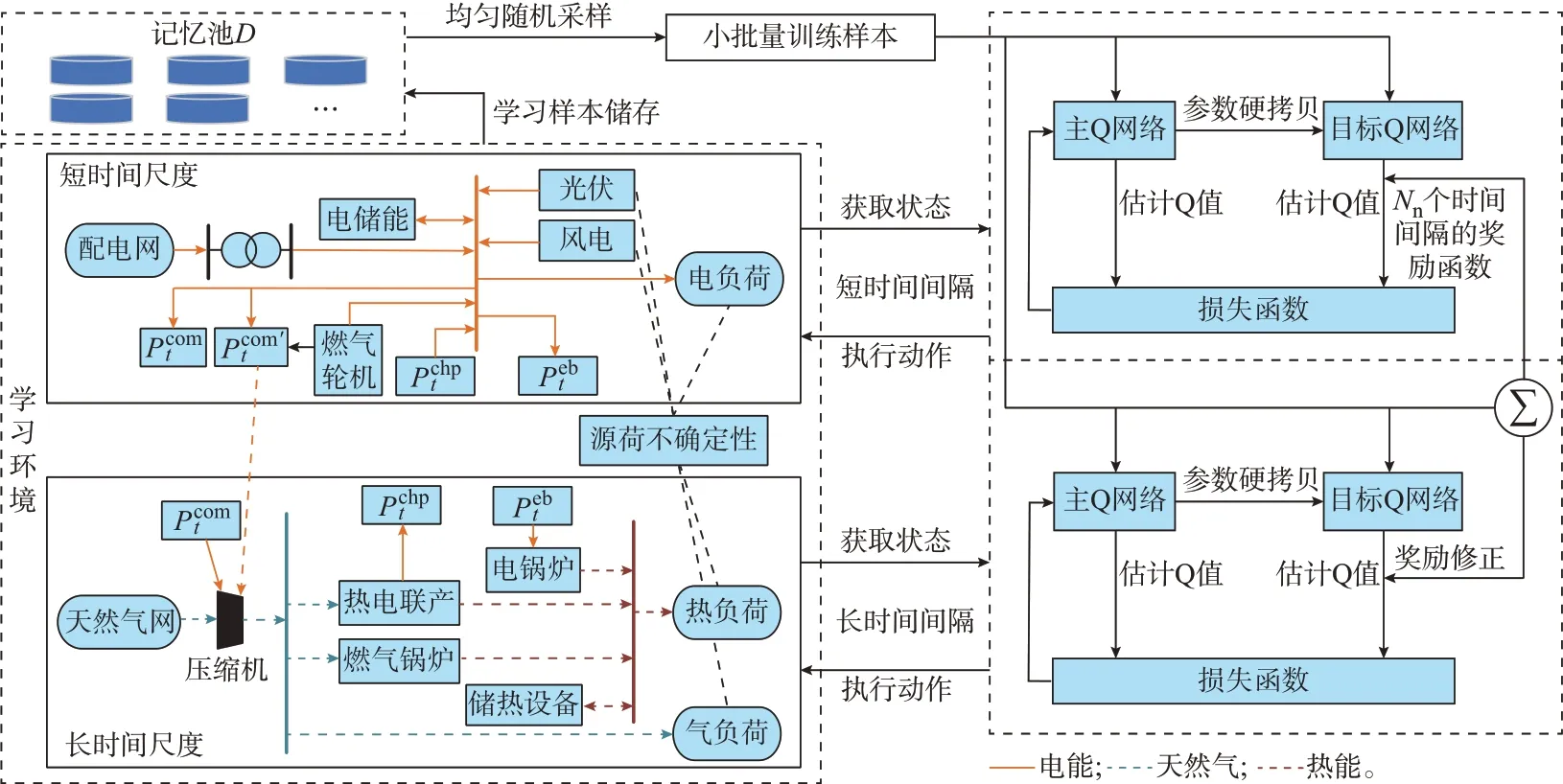

本章首先将两阶段多能协同优化模型表述为两阶段的MDP,结合长时间尺度和短时时间尺度两阶段控制形式的解耦划分,对状态空间和动作空间进行分割,进一步对奖励函数进行修正,形成一个两阶段MDP。然后,采用基于DDQN 算法的深度强化学习解决方案,对DDQN 算法进行分层改进,从而提出一种全新的分层深度强化学习算法,即HDDQN 算法,如图3 所示,用于求解两阶段序贯决策问题:按照两阶段时间尺度不断地与学习环境进行交互训练,依照系统灵活性需求给出灵活性资源最优执行动作集,从而获取多能协同决策的最优解。

图3 HDDQN 算法结构Fig.3 Structure of HDDQN algorithm

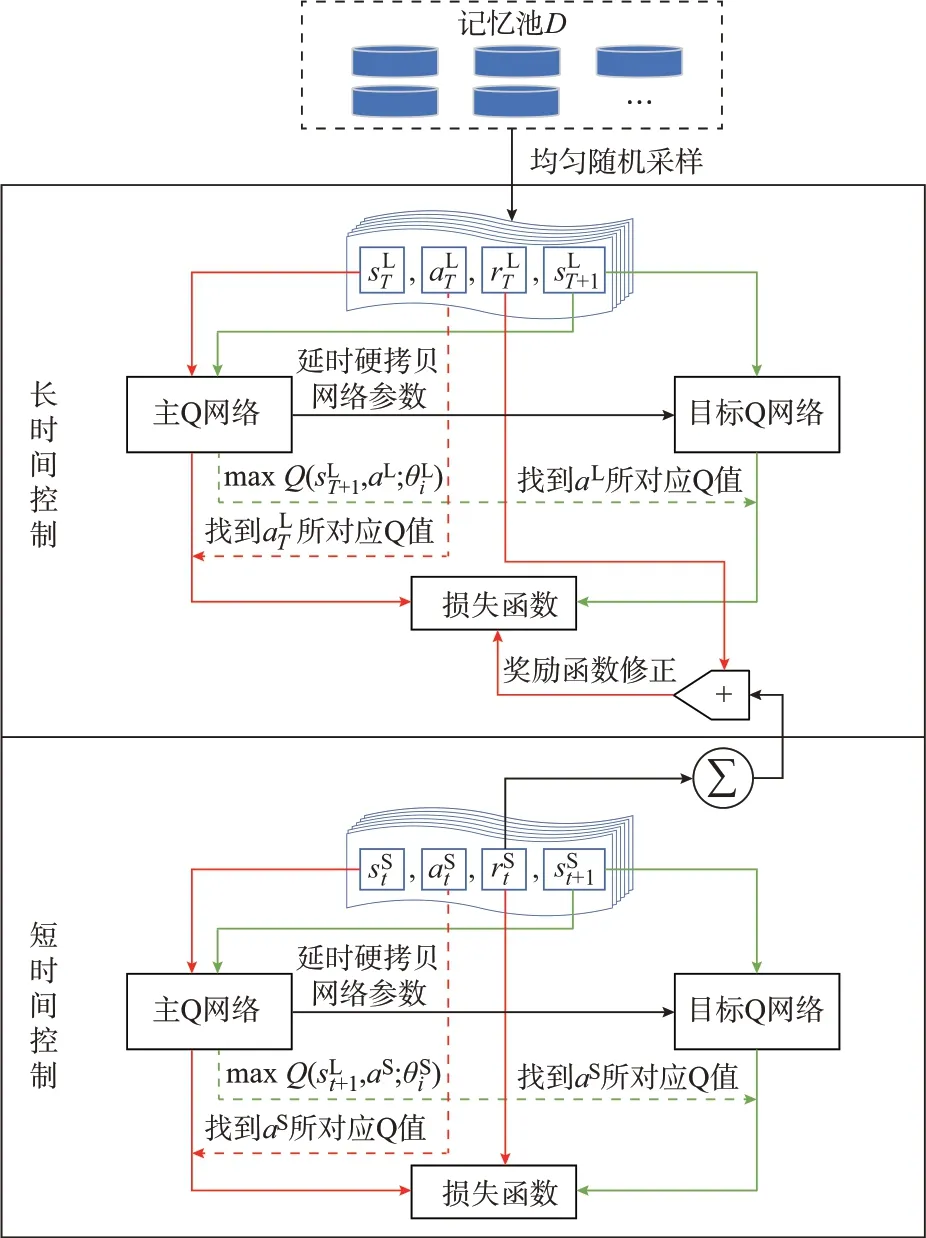

3.1 MDP

在使用分层深度强化学习算法求解两阶段多能协同优化模型之前,需将其转成两阶段的MDP。MDP 是强化学习中的一个重要概念,是应用最广泛的一类随机过程,一般由四元组(状态空间S、动作空间A、状态转移概率P、奖励函数R)定义,用于描述智能体(即灵活性资源)与环境(即系统灵活性需求)之间的交互过程[24]。其中,可通过状态转移概率P(记作p(s'|s,a)表征系统灵活性需求的不确定性(即源荷不确定性),p(s'|s,a)指的是从当前状态s采取动作a转移到下一状态s'的概率[24]。而本文采用分层深度强化学习算法属于一种不依赖于环境模型的无模型强化学习算法,在不学习状态转移概率函数情况下,直接通过与环境的交互获取经验数据,并根据这些数据进行学习和优化。这意味着智能体只知道环境赋予的状态,智能体在选择并执行一个动作后,下一个状态仅由环境决定并反馈给智能体。接下来,本文将结合分布式能源系统两阶段控制解耦方式,对MDP 进行两阶段划分,具体内容如下。

状态空间S由各灵活性资源的运行状态和负荷需求所构成。因此,整个系统在t时刻系统状态st∈S由长时间尺度控制所对应的状态和短时间尺度控制所对应的状态所构成,如下式所示。

综上,通过动作-价值函数Q(s,a)来评估策略π的优劣(策略π表示状态空间S到动作空间A的映射),如式(13)所示。

式中:E[·]为期望函数;k为迭代步数;Tall为迭代总步数;γ(k)∈[0,1]为第k步折扣因子(未来奖励的衰减值);rk为第k步动作后获得的即时奖励;s0和a0分别为状态和动作的初始值。

因此,最优策略就等价于求解最优Q*(s,a),即:

3.2 HDDQN 算法

深度强化学习通过Q 网络(神经网络)拟合Q(s,a)函数,其输入是状态向量,输出是所有可能动作的Q 值,代替传统强化学习的Q-Table 形式,解决了维数灾问题。DDQN 算法[25]是深度强化学习的算法之一,其具有双Q 网络结构,分为主Q 网络Q(s,a;θ)和目标Q 网络Q(s,a;θ'),其中,θ、θ'分别为主Q 网络和目标Q 网络的网络参数,θ用于选取最优动作,θ'用于评估最优动作,这种动作选择和策略评估的解耦方式有效减低了Q 值过估计的风险。

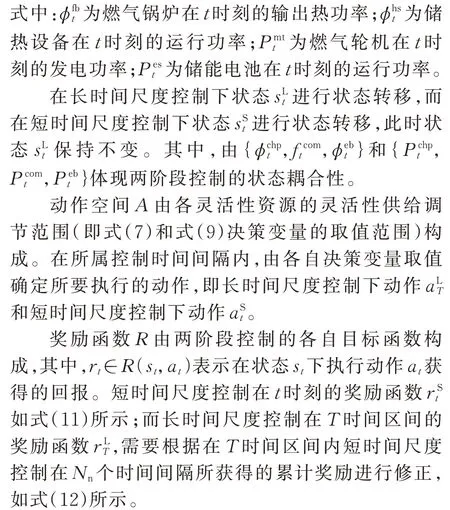

针对两阶段序贯决策问题,本文在DDQN 算法的基础上对双Q 网络结构进行分层改进,形成一种两层嵌套的双Q 网络结构的HDDQN 算法,内层为短时间控制的双Q 网络,外层为长时间控制的双Q网络,如图4 所示。其中,外层的主Q 网络和目标Q网络的网络参数分别为θLi和θL'i;内层的主Q 网络和目标Q 网络的网络参数分别为θSi和θS'i。

图4 HDDQN 算法的Q 网络结构Fig.4 Q network structure of HDDQN algorithm

同时,为了克服样本的关联性和非平稳分布问题,防止出现不收敛情况,HDDQN 算法同样引入了经验回收机制:即在记忆池D中以均匀随机采样方式抽取小批量样本数据进行训练,学习得到经验数据也可以按照时间先后顺序存入记忆池中再利用,若记忆池存满,则覆盖时间最久远的数据,从而增加经验数据的时效性。

如图4 所示,内外层网络具有相同的Q 网络结构,Q 网络参数的训练更新机制具体如下。

而外层网络目标Q 值需等待Nn个连续的短时间控制样本训练完成后,将在T时间间隔内Nn个在内层网络所得到即时奖励rSt进行叠加处理,从而对外层网络在T时间间隔的即时奖励进行修正;随后,便可按照内层网络同样的流程得到外层网络目标Q 值YDDQNT:

式中:aL为长时间尺度最大Q 值对应的动作决策。

上述内容具体描述了内外层网络的估计Q 值和目标Q 值的获取流程。整个训练过程实质上就是将内外层网络的估计Q 值向目标Q 值逼近的过程,由损失函数L()来表述:

式中:α∈[0,1]为学习率,其决定收敛速度。

综上所述,具有两层嵌套的双Q 网络结构的HDDQN 算法可对两阶段时间尺度划分的复合空间进行探索学习,按照时间间隔不断地从学习环境中获取状态,通过Q 网络隐式处理系统源荷的不确定性,按照其输出的Q 值选择执行最优动作集,从而实现系统的两阶段序贯最优决策。

3.3 求解流程

HDDQN 算法的求解流程详见附录B 图B1。

4 算例分析

为了测试本文所提算法应用于两阶段多能协同优化模型的求解性能,本文选取某分布式能源系统示范区的实际运行数据进行仿真分析,HDDQN 算法参数详见附录B。本文所有算例均在Intel i7-10700K(主频为3.8 GHz)、内存32 GB 的计算机上基于PyTorch 软件框架进行仿真分析。

4.1 仿真环境设置

分布式能源系统配置:单机容量1.5 MW 的风电机组共5 组,总计7.5 MW;光伏机组每组0.1 MW,共15 组,总计1.5 MW;电储能容量为2 MW·h;燃气轮机装机容量为3 MW;热电联产装机容量为1.1 MW,最大发热功率为1.3 MW;燃气锅炉最大发热功率为1.4 MW;电锅炉最大发热功率为0.6 MW;储热装置容量为0.6 MW·h。相关设备参数可详见附录B 表B1。

仿真时间尺度划分:将一天24 h 划分为96 个时间区间,每个时间区间划分成3 个时间间隔,即长时间控制的时间尺度为15 min,短时间控制的时间尺度为5 min。

关于HDDQN 算法神经网络的设置,根据经验以及不断的调试验证,所用的神经网络隐含层层数为2 层,神经元个数依次为128 个和256 个,并且以修正线性单元(rectified linear unit,ReLU)函数作为隐含层的激活函数。同时,对于HDDQN 算法中折扣因子γ和学习率α两个参数,通过大量仿真测试发现:折扣因子γ决定未来奖励的衰减,如果γ取值很小,学习系统很容易倾向于遵循当前策略的奖励,从而忽略长远的最优策略;如果γ取值很大,学习系统就不会轻易局限于某一时段的最优策略,将一直进行大范围探索,这将导致收敛速度变慢。另一方面,学习率α决定学习系统的收敛速度,如果α取值过小,收敛速度会很慢,但很容易趋于稳定;如果学习率α取值很大,收敛速度会很快,但不会轻易趋于稳定。综上,经过测试筛选出,折扣因子γ取值为0.9,学习率α值取0.5。

4.2 训练结果分析

采用所选取地区2020 年3 月的分布式能源系统的时序统计历史运行数据样本进行训练,按24 h周期可划分为31 个训练数据集,且根据仿真时间尺度的划分,每个训练集又可分为96 个训练样本,因此总共有2 976 个训练样本。在训练过程中,均匀随机抽取96 个小批量样本,训练步数为30 000 步,并根据式(17)计算损失函数值来确定收敛情况。迭代收敛情况如附录C 图C1 所示,可以看出在迭代初期,损失函数值振幅较大;迭代后期(训练步数大于15 000),损失函数振幅进入收敛区间,整个系统在25 000 次训练后达到最佳收敛效果。

4.3 优化结果分析

为了验证HDDQN 算法对两阶段多能协同优化模型求解的有效性,随机抽取该地区2022 年3 月某天风光荷的时序数据(如附录C 图C2 所示)作为实时数据,将其按照长短时间尺度的划分依次输入HDDQN 算法进行在线学习优化仿真。其求解速度如附录C 图C3 所示,每个时刻的求解时间最大值为0.055 s,最小值为0.025 s(在含有长时间尺度控制的时刻,求解时间相对较大,维持在0.05~0.055 s 之间;而在仅含有短时间尺度控制的时刻,求解时间维持在0.025~0.03 s 之间),每个时刻的求解速度相对误差控制在0.05 s 内,求解时间平均值为0.036 s,整个优化过程的求解过程时间为10.368 s。

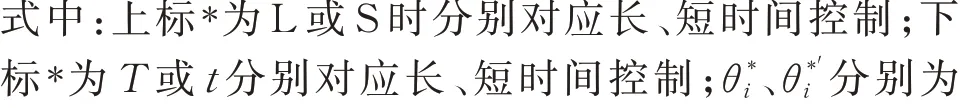

以下为两阶段多能协同优化算例结果。图5 表示分布式能源系统的日用能占比,在用气环节中,燃气总用气量的19%用于产热和发电;在产热环节中,86.7%热能供给来源于天然气,13.3%热能供给来源于电能;在发电环节中,新能源发电占比达到了31.8%,联络线输入占比达到了45.2%,其余33%电能供给来源于天然气。另外,新能源消纳率达到99.7%,切除新能源发电量仅为0.276 MW·h。

图5 日用能占比Fig.5 Daily energy consumption ratio

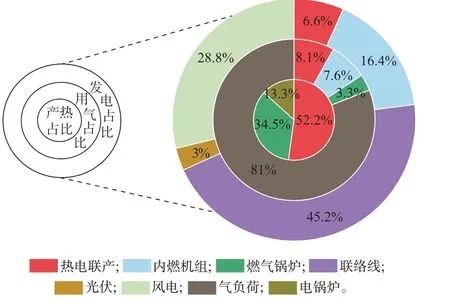

长时间控制优化结果如附录C 图C4 和图C5 所示,耦合变量的输出结果如附录C 图C6 所示,其优化结果完全满足非电负荷的用能需求,未出现限制非电负荷现象;短时间控制优化结果如附录C 图C7(图中净负荷为负荷和可再生能源并网出力的差值,详见式(1))、图C8 和图C9 所示,其优化结果未出现切负荷现象,但存在限制风电出力现象。进一步,对出现限制风电出力的时间段进行灵活性分析,取时间间隔为283 至288 的时间段(即23:30 至24:00)灵活性平衡优化结果,如图6 所示。在286 和288 时刻,由长时间控制的非电网络向电网提供了有效的灵活性供给;但在286 时刻出现了弃电现象(切除了1 台风电机组),迫使电网灵活性达到平衡。

图6 灵活性平衡优化结果Fig.6 Optimal results for flexibility balance

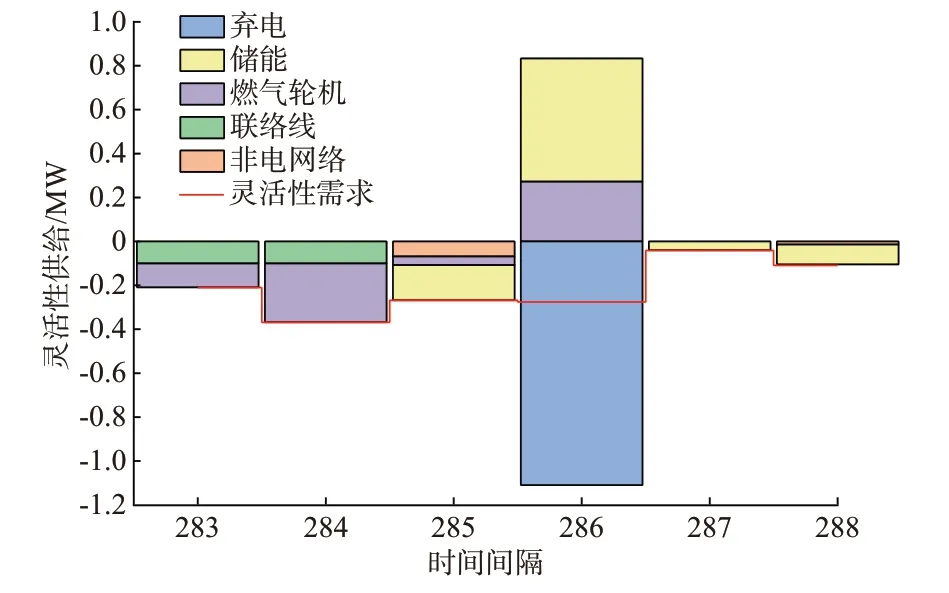

为了验证上述优化结果的合理性,结合图7 展示内容对该时间段分布式能源系统的灵活性需求和灵活性资源进行分析。由图7 可知,系统在286 时刻存在向下灵活性需求,为-0.28 MW;而在不弃电情况下,灵活性供给最大值为-0.07 MW,系统灵活性无法达到平衡。关于此刻灵活性供给不足的原因是,如图7 所示,燃气轮机此刻以最小发电功率运行,无法向系统提供向下灵活性供给;电储能因自身容量约束在此刻的最大充电功率为0.23 MW(且在上一时刻以0.16 MW 充电功率运行,详见附录C 图C8),此时电储能灵活性供给的最大值为-0.07 MW;同时,由附录C 图C6 可知在286 时刻,热电联产处于最小发电功率运行状态,电锅炉处于最大功率运行状态,两者此时都无法向系统提供灵活性供给。因此,当前时刻的灵活性资源中仅有电储能可以向系统提供最大值为-0.07 MW 的灵活性供给,而此时灵活性需求为-0.28 MW,灵活性需求和灵活性供给之间平衡差额为-0.21 MW,故通过弃电方式使系统达到灵活性平衡是合理可行的。

图7 灵活性需求和灵活性资源分析Fig.7 Analysis of flexibility demand and flexibility resources

综上所述,HDDQN 算法对多能协同优化模型快速稳定地求解的同时,能够获得较佳的控制目标,从而验证了两阶段多能协同优化模型和HDDQN算法求解的有效性。

4.4 算法求解性能对比分析

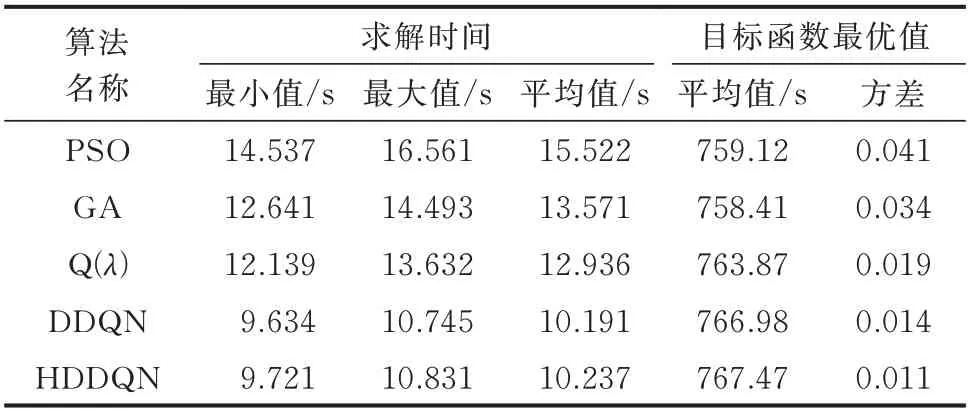

为了验证HDDQN 算法求解性能的优越性,本文选取了粒子群优化(particle swarm optimi-zation,PSO)算法、遗传算法(genetic algorithm,GA)、Q(λ)学习算法和DDQN 算法与所提出的HDDQN算法进行对比分析。对于典型的学习算法,需将模型中的短时间控制和长时间控制两个目标函数进行求和转换为单目标优化问题进行求解;同时,对长时间控制对应的决策变量施加时间间隔约束,保证其只能在对应的控制时刻发生改变,其余时刻保持不变。所有算法的训练数据与本文保持一致,均采用4.3 节的实时数据进行求解,重复求解10 次,取各算法的求解时间的最大值、最小值和平均值以及目标函数最优值的10 次计算结果的平均值和方差等5 个指标进行对比,结果如表1 所示。从表1 中可以看出:在求解速度上,HDDQN 算法和DDQN 算法优于其他算法,且HDDQN 算法略慢于DDQN 算法,两者的平均值相差在0.1 s 以内,HDDQN 算法因分层改进导致求解速度略有损失;在求解质量上,PSO算法和GA 的目标函数最优值的平均值较小且方差较大,期间存在无法求得最优解的情况;HDDQN 算法求解得到的目标函数最优值的平均值和方差均为最优,求解的稳定性明显强于其他算法。

表1 算法性能对比Table 1 Comparison of algorithm performance

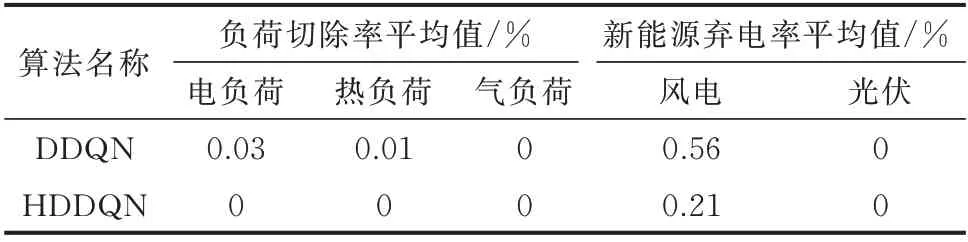

进一步,根据求解质量指标,选取HDDQN 算法和DDQN 算法求解的10 次优化结果的平均值进行对比分析,其分析结果如表2 所示。

表2 优化结果对比Table 2 Comparison of optimization results

从表2 中可以看出:在优化结果上,无论是负荷切除率还是新能源弃电率,HDDQN 算法明显优于DDQN 算法,HDDQN 算法非常适用于两阶段多能协同优化模型的求解。

5 结语

1)首次构建了一种面向分布式能源系统的两阶段多能协同优化模型,采用长时间尺度和短时间尺度两阶段决策方式构建了不同时间响应特性的复合空间序贯决策模型,从而在满足用能需求的同时,提升了新能源的消纳水平。

2)提出了一种HDDQN 算法,该算法针对长时间尺度和短时间尺度两阶段控制模式,在DDQN 算法基础上进行分层改进,用于求解不同时间响应特性的复合空间序贯决策问题,实现分布式能源系统的多能协同优化运行。

3)仿真结果表明,针对于多能协同两阶段序贯决策问题,HDDQN 算法十分适用于其求解,在求解速度和质量上具有较好的表现。

4)本文所提出两阶段多能协同优化模型的不足之处在于没有考虑多能协同运行所涉及的经济性问题。下一步研究工作是将经济性相关因素纳入多能协同优化模型中,并探索所提出HDDQN 算法的更多应用场景。

附录见本刊网络版(http://www.aeps-info.com/aeps/ch/index.aspx),扫英文摘要后二维码可以阅读网络全文。