基于多尺度和跨空间融合的超声乳腺结节分割

2023-11-29赵欣祝倩倩赵聪吴佳玲

赵欣,祝倩倩,赵聪,吴佳玲

基于多尺度和跨空间融合的超声乳腺结节分割

赵欣1*,祝倩倩1,赵聪2,吴佳玲3

(1.大连大学 信息工程学院,辽宁 大连 116622; 2.大连市第五人民医院 超声科,辽宁 大连 116021; 3.大连医科大学附属第一医院 超声科,辽宁 大连 116011)( ∗ 通信作者电子邮箱zhaoxin@dlu.edu.cn)

针对超声成像分辨率低且存在噪声、结节形态与纹理复杂多变导致超声乳腺结节精确分割较为困难的问题,提出一种融合多尺度特征提取和跨空间特征融合的超声乳腺结节端到端自动分割方法。首先,设计一种多尺度特征提取与融合(MFEF)模块,通过融合4条具有不同感受野的卷积路径使网络具有多尺度的特征提取能力。其次,为对高级语义信息进行多尺度观察和信息筛选,在瓶颈层采用尺度感知与特征聚合(SFA)模块,以增强编码阶段的深层特征提取能力。此外,设计跨空间残差融合(CRF)模块,并将它应用在编、解码器间的跳跃连接上。该模块一方面对不同编码层进行跨空间信息融合,实现不同编码层间的信息互补;另一方面进一步提取编码层信息特征,缓解编解码对等层之间的语义差异,从而更好地补偿解码阶段的信息损失。在公开的超声乳腺结节数据集上的实验结果显示,所提方法的DICE系数可达0.888,同主流的深度学习分割模型UNet、AttUNet、ResUNet++、SKUNet相比,提高了0.033~0.094,对比相同数据集中的改进模型如CF2-Net、ESTAN、FS-UNet、SMU-Net,提高了0.001~0.068。所提方法分割结果图的主观视觉效果与专家给出的金标准最接近,能更加准确地分割出乳腺结节区域。

多尺度特征融合;跨空间特征融合;尺度感知与特征聚合;卷积神经网络;超声乳腺结节分割

0 引言

近年来,随着社会生活各方面压力的增加、饮食习惯的改变及其余外在环境因素的影响,乳腺癌已成为威胁全球女性健康的最常见的恶性肿瘤之一。然而,乳腺癌的早期常无典型的症状和体征,很容易被人忽视,从而导致误诊和漏诊常有发生。而乳腺癌的“早发现、早诊断、早治疗”可以大大延缓患者的病情进展,降低患者的治疗难度,进而降低患者的死亡率。目前,临床上常用的无创性乳腺诊断手段包括磁共振成像、X射线、超声成像等。其中,超声成像具有易于使用、无辐射损伤、价格便宜、可任意角度观察、成像速度快等优点,成为乳腺癌早期最主要的筛查手段[1]。然而,乳腺结节形态和质地各异,部分结节与周边组织易混淆,且超声成像存在噪声偏高、对比度低、灰度不均等缺点,给超声乳腺结节的检测带来一定困难。随着医疗行业的快速发展,特别是人工智能技术的高速发展,通过人工智能和计算机辅助手段对医疗数据进行精确挖掘和处理已成为可能。基于人工智能的计算机辅助诊断逐步被用于超声乳腺结节的诊断中。

早期的算法研究多采用传统的机器学习方法进行超声乳腺结节分割。例如,Jiang等[2]采用Adaboost+Haar框架对超声乳腺结节的病灶区域进行目标检测,并使用支持向量机对检测到结节区域进行筛选,最后通过随机游走算法对筛选出的结节进行精细化分割。Shan等[3]通过频域滤波获得图像的相位特征,并在此基础上采用NLM(Neutrosophic L‑Means)方法进行结节边界的精细分割。Luo等[4]在分割前通过人工选择两条对角线来确定结节区域,然后联合使用粒子群算法和优化图论算法分割结节区域。Liu等[5]采用形态学滤波法和自适应阈值法对结节轮廓进行初步定位,再通过活动轮廓方法进一步细化结节轮廓。Lotfollahi等[6]结合Neutrosophic理论提出一种改进的活动轮廓方法进行超声乳腺结节的分割,但该方法需要人为锁定结节的初始轮廓。早期方法的本质是通过人为构建的特征模式检测乳腺肿块的边界,受人为提取特征能力的限制,这些特征的表示能力有限,因此,分割效果并不理想。

近年来,基于深度学习的语义分割方法在图像处理领域非常流行且有效。它利用深度卷积神经网络的自学习特性,在无人工干预的情况下自动地学习出隐含于图像中的复杂的、具有区分能力的特征,将图像分割问题转换成像素的语义分类问题,弥补了早期经典方法的不足,因此,许多学者开始研究采用深度学习技术的超声乳腺结节分割方法,且大多数方法是对经典UNet模型进行改进,以提升结节的分割效果。Zhuang等[7]在传统UNet架构的跨层连接处采用注意力门和卷积增强模型的学习能力,并在瓶颈层使用扩张卷积扩大感受野来增强特征提取能力。Han等[8]采用多尺度特征提取网络和双注意力融合网络分割超声乳腺结节,但复杂的模型结构导致计算和训练负载过大。Byra等[9]仅用选择性核卷积替代传统UNet中的普通卷积,目的是自适应地调整感受野,解决乳腺结节形态多变的分割问题。Vakanski等[10]在池化操作中添加注意力,但这种改进对边界模糊的结节分割效果并不好。Xue等[11]将多层上下文信息与乳腺病灶边界检测相结合,通过细化边界质量来提高分割结果。Li等[12]用多尺度扩张卷积模块应对乳腺结节形状的不规则变化,并采用Focal-DSC(Dice Similarity Coefficient)损失函数解决乳腺结节中类别不平衡问题,但无法应用于其他模式的图像上。Gao等[13]提出将空间-通道注意力应用在编解码器的跨层连接处,实现对乳腺结节区域的关注。Iqbal等[14]为超声乳腺结节分割提出一种基于UNet的多尺度双注意力网络,该模型用多尺度卷积取代UNet中所有的标准卷积,并在上采样操作后引入双注意力机制,自适应地学习高级特征,但对模糊边界的结节分割效果不佳。Punn等[15]通过融合四种不同尺度卷积来适应不同尺寸的超声乳腺结节区域,同时使用混合池化保留更多的结节特征信息;此外,将编码路径相邻空间特征和解码路径对等层空间特征与注意力结合用于关注不同空间维度上的相关性,以更好地识别结节区域。Chen等[16]提出用混合自适应注意力改进UNet,使网络具有在通道和空间上自适应调整感受野的能力,以捕捉不同维度的特征,该方法获得了较好的分割效果。Zhao等[17]结合注意力机制和残差组成的模块应用在编解码对等层上,使网络对浅层特征中的边界细节赋予更高的权重,但该方法无法应对结节特征不规则变化的情况。

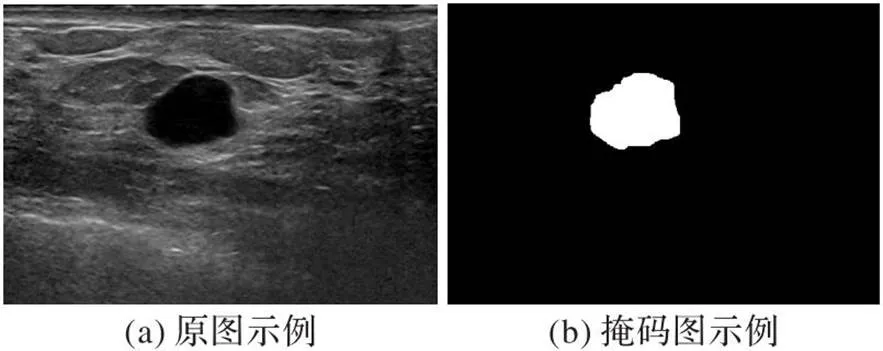

上述工作相较于传统机器学习的分割质量有很大提升,为基于深度学习的超声乳腺结节分割研究提供了借鉴与参考,但超声乳腺结节的分割仍是一项困难的任务。首先,乳腺结节形状多样、大小不一,且存在斑点噪声和超声伪影等干扰因素,增加了病灶的分割难度。其次,有些乳腺结节内部的超声表征与周边组织特征相似,导致网络很难区分结节区域与背景区域,易造成结节区域的误划分问题。例如图1(b)的左边图像中,绿色是结节区域,红色是结节内部与周边组织易混淆的区域。最后,有些结节内部的超声表征虽然可明显区分,但结节边界与周边组织易混淆,给结节边界的精准分割带来一定难度。例如图1(b)的右边图像中,红色区域是该结节边界的模糊段。现有方法准确区分结节目标区域与背景区域,并精准分割结节边界的能力有限,这也是该领域目前的难点问题。

图1 乳腺超声图像

针对上述问题,本文提出了一种融合多尺度特征提取和跨空间特征融合的超声乳腺结节分割网络。首先,利用扩张卷积和分组卷积使网络具有多尺度特征提取能力;其次,在瓶颈层融合多个不同尺度感受野的特征,生成关注度权重图对深层语义进行特征加权,突出与分割结果相关的语义特征,增强编码阶段深层特征的提取和表达能力;此外,为编码器与解码器之间的跨层连接设计了一种具有交叉融合结构的跨空间残差融合(Cross-spatial Residual Fusion, CRF)模块,以缓解编、解码器对等层之间的语义差异,从而更好地补偿解码阶段的信息损失。为对以上方法思想进行保护,在研究阶段已对该方法申请了发明专利[18],本文主要对方法进行了更加深入的理论分析,对部分实施步骤进行了细化和改进,并对实验结果进行了详细的分析和总结。

1 本文方法

1.1 改进的分割网络模型

本文提出的基于多尺度和跨空间融合的超声乳腺结节端到端分割模型结构如图2所示。该模型基于原始UNet模型,采用U型的编解码架构。为提高网络浅层特征的提取和表达能力,模型的编码部分采用多尺度特征提取与融合(Multi-scale Feature Extraction and Fusion, MFEF)模块;为增强瓶颈层的深层特征提取能力,模型采用尺度感知与特征聚合(Scale-aware Feature Aggregation, SFA)模块筛选和强化深层语义特征中的重要信息;为缓解编、解码器对等层之间的语义差异,还设计了CRF模块连接对等层,以缓解语义差异,促进解码阶段的信息还原。

图2 本文模型的网络结构

1.2 多尺度特征提取与融合模块

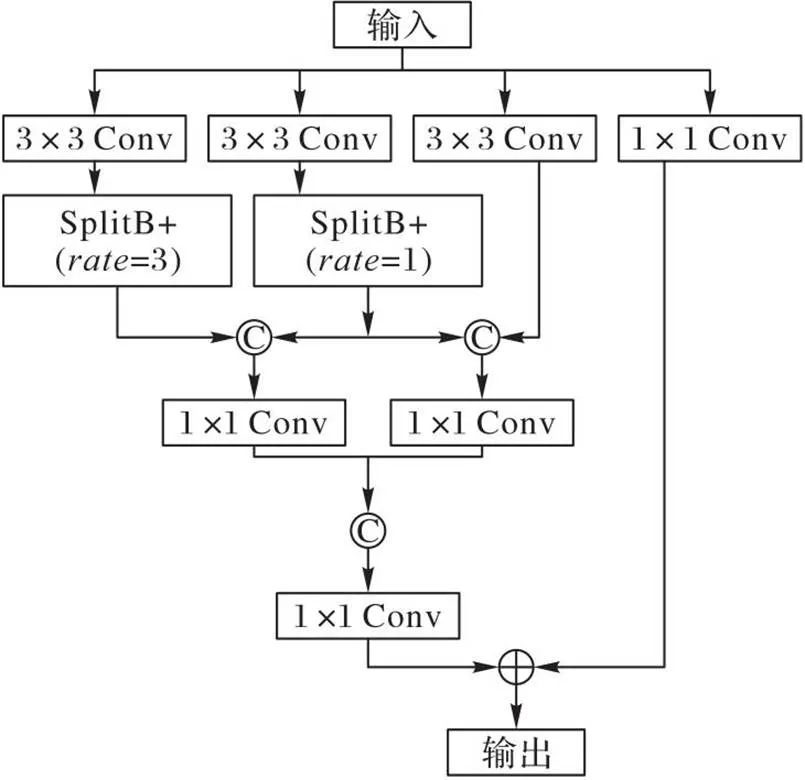

超声影像对比度低且存在伪影干扰,乳腺结节在超声影像下常表现为复杂的形态,如恶性结节常呈现出各种不规则的形状,结节的尺寸大小不一、部分结节与周边组织间的界限不清,这些因素给结节的精确分割带来挑战。传统UNet的编码层采用2个连续的3×3卷积进行特征提取,但这种处理方式只能提取到单一尺度感受野下的特征,对结节特征的不规则变化应变力差。为此,本文设计了MFEF模块,结构如图3所示。

图3 MFEF模块结构

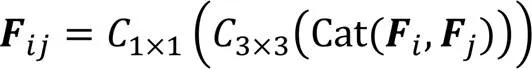

MFEF模块的主体架构包含四条具有不同感受野的卷积支路:第一条支路采用1×1卷积核,具有1×1的最小感受野;第二条卷积支路具有3×3感受野;第三、四条支路在3×3卷积后增加了一个多尺度卷积块,称为SplitB+(如图4(a))。SplitB+使用扩张卷积和通道分组,具有更大的感受野和更强的非线性。整个MFEF模块形成一个多支路与多尺度感受野的嵌套效果,既保证了多尺度特征提取,又增强了模型的非线性。MFEF模块将除第一条支路外的其他三条支路的后端进行两两拼接,目的是融合相邻感受野下的特征信息,以增强信息的互补性。第一条支路卷积没有参与拼接是为了保留一部分输入的原始信息,并通过1×1卷积调整通道数,以满足后续相加操作时的通道要求。

本文SplitB+的设计是对HS-ResNet[19]中SplitB(如图4(b))结构的轻量化改进,主要包括:1)将输入的特征通道分为2组而不是HS-ResNet中的5组,目的是降低分组处理的复杂度和计算量;2)在SplitB中用扩张卷积替代普通卷积,以增大网络的感受野,让网络在特征提取时捕捉更多的局部信息,提升特征提取能力。改进后的SplitB+结构更简洁,并具有多尺度处理能力。

SplitB+首先将输入的特征通道分为2组,如图4(a)的group1和group2所示。其中,group1经过扩张卷积后又分为group3和group4;group4与group2拼接,而后经过扩张卷积,并将得到的特征图与group3拼接,形成最终的模块输出。这种分组后卷积再合并的形式可有效减少模型参数并降低计算量,同时增加了模型连接的复杂性,提升了模块的非线性。

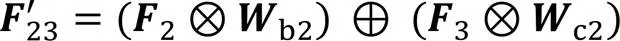

1.3 尺度感知与特征聚合模块

信息进入瓶颈层后,浅层特征被进一步抽象为高级语义特征,特征的抽象性增强,使不同通道的语义特征对最终分割结果的影响力不同,因此,瓶颈层的特征提取除需考虑多尺度感受野外,还应考虑不同语义特征间的重要性差异。而1.2节设计的MFEF模块虽具有多尺度感受野的捕获能力,但对不同尺度的通道特征进行等权重拼接,因此不具备区分通道特征重要性差异的能力。为此,本文在瓶颈层没有使用MFEF模块,而是采用了文献[20]中提出的尺度感知与特征聚合(SFA)模块,结构如图5所示。该模块不仅可对不同感受野下的卷积特征进行权重筛选,还能对不同通道特征进行权重筛选,从而使重要的语义特征具有更加显著的作用,进而提升分割效果。

图5 SFA模块

这种自适应选择的实质是通过权重矩阵突出多尺度感受野下有用的信息,弱化无用的信息,选择后的结果与原始特征进行信息叠加,目的是确保信息不被丢失的同时突出被强化的信息。

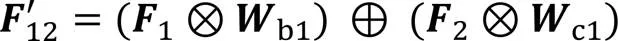

1.4 跨空间残差融合模块

传统UNet通过跳跃连接将编码部分的特征信息传递并拼接到解码部分的对等层,以弥补解码阶段上采样带来的信息损失。然而,编码器的特征属于低级特征,解码器的特征是在经历了多次卷积、池化、反卷积后形成的更高级别的上下文信息,这使被拼接的编、解码器对等层之间的特征信息之间存在较大的语义差异,分割模型应尽可能消除这种语义差异以提升分割效果。为此,本文在跳跃连接处设计了一种跨空间残差融合(CRF)模块,该模块由5个双空间融合(Dual-Spatial Fusion, DSF)模块(如图6(a))通过串联和交叉并联的形式组成,如图6(b)所示。该模块一方面将相邻编码层间的信息进行互补融合;另一方面对编码层信息进行进一步的特征提取,从而缓解编、解码器对等层之间的语义差异。

图6 CRF与DSF模块

2 实验与结果分析

2.1 数据准备

实验数据集来源于Yap等[21]提供的超声乳腺结节公开数据集。该数据集是在西门子ACUSON Sequoia C512系统上采集的,共包含163张超声图像,其中有110张图像含良性结节,53张图像含有恶性结节。标签均由经验丰富的医生标注,原图以及标签图如图7(a)、(b)所示。该数据集的图像尺寸大小均为760×570,实验中将所有图像的大小缩放为统一尺寸256×256,并按7∶1∶2比例划分训练集、验证集和测试集。为了防止模型因数据样本过少而出现过拟合,对训练集中的图像分别进行水平翻转和90°、180°、270°旋转,将训练集中样本数扩大为原来的5倍。

图7 超声乳腺结节图像示例

2.2 实验环境与参数设置

实验使用一块NVIDIA GeForce RTX 2080 GPU显卡,GPU内存为11 GB。在实验阶段,Batch size设置为4,深度学习框架采用TensorFlow,迭代次数设置为200,学习率设置为0.000 1,选择Adam作为优化算法,损失函数采用DICE损失函数,终止条件采用当验证集上的损失值在10个迭代周期内不再减小时,停止训练。

2.3 评价指标

2.4 消融实验

本文通过消融实验验证设计的各个模块及其组合对超声乳腺结节分割任务的有效性。消融实验共5组:第1组只采用原始UNet进行分割;第2组在UNet架构基础上将编码器的每一层分别替换为SplitB和SplitB+;第3组在UNet架构基础上分别单独添加MFEF模块、SFA模块、CRF模块;第4组在UNet架构基础上进行两两混合添加;第5组在UNet架构基础上将三个模块全部添加。消融实验结果如表1所示。

从表1可以看出,采用SplitB+相较于采用SplitB在指标DICE系数、召回率和交并比上均有所提升,这与结构轻量化后更有利于模型的优化训练有关。因此,在MFEF模块中采用SplitB+。第3组实验中的各模型在指标值上相较于传统UNet均有所提升,这说明MFEF模块、SFA模块、CRF模块具有各自的有效性。但从第4组实验可以发现,添加两个模块比单独采用一个模块指标值提升得更多,这说明模块混合使用可以产生优势累加,这种优势累加效果在第5组实验中体现得更明显。第5组实验结果除精度指标外,其他指标相较于第4组结果均有更明显的提升,DICE系数、召回率和交并比分别平均提升0.258、0.307、0.243。尽管第5组的精度指标相比第3、4组的略低,但差距不大,而且所有指标的综合提升更重要。此外,召回率关注的是有多少病变组织被找到,它在医学图像分割领域中是一项非常重要的指标,因此,在精度指标相近的情况下,本文实验更关注召回率的提升。上述分析表明,在UNet架构基础上同时采用MFEF模块、SFA模块、CRF模块所得到的指标评价最好,这一点还体现在分割结果的视觉效果对比上,如图8所示。

表1 网络结构消融性能对比

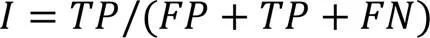

图8是第1~5组实验分割结果在视觉效果上的对比。绿色轮廓是专家给出的结节区标注,红色轮廓表示本文模型的分割结果。从图8中可以看出,单纯使用UNet模型的分割结果存在较多的假阳性,如图中a~e所示的区域。在UNet的基础添加MFEF模块,假阳性显著消失,但分割边界与专家标注边界相比还存在一定差距;添加MFEF、SFA和CRF模块后,有更完整的轮廓,保留了更多乳腺结节边界细节信息,分割结果在形态上与标注图更逼近,具有更佳的性能。

图9是本文模型在训练过程中表现出来的训练损失和验证损失的变化情况。模型在第77个Epoch结束训练,第62个Epoch后模型训练基本达到收敛状态,但该实验没有单纯依靠训练误差的收敛判定模型是否终止,而是将验证误差的变化情况结合进来,即当验证误差在验证集上的损失值在10个迭代周期内不再减小时停止训练,以防出现训练过拟合。从图9可以看到,训练损失是收敛的,且变化曲线比较平滑,验证损失在下降过程中存在跳动,但整体具有下降趋势,且训练终止时能降低到可接受的损失值,这说明本文模型的设计和训练是合理和可行的。

2.5 方法对比实验

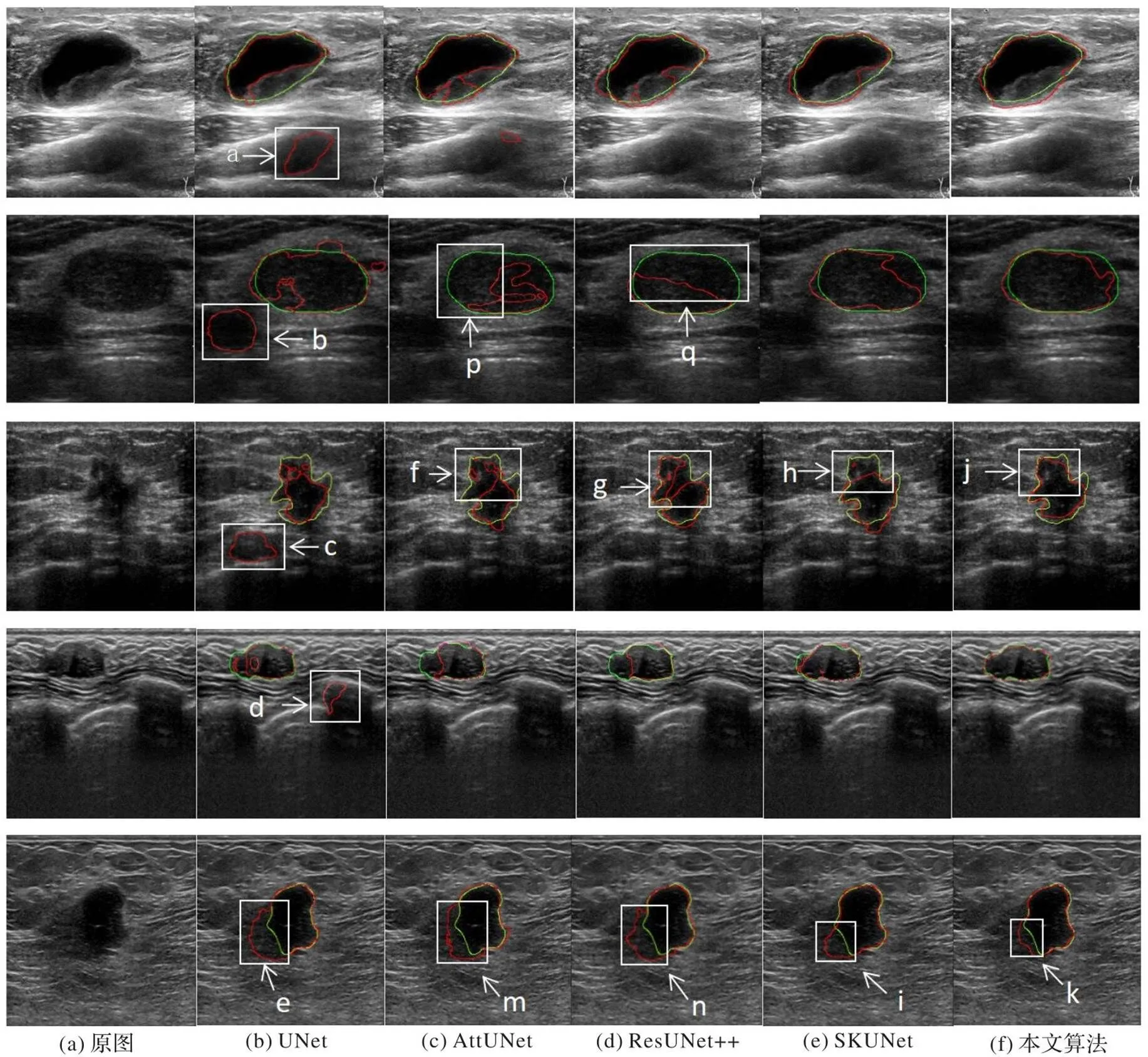

对比实验中,先与下列经典分割模型进行对比:UNet[22]、AttUNet[23]、ResUNet++[24]、SKUNet[9]。采用上述经典模型对超声乳腺结节进行分割的结果如表2中前4行所示。从表中可以看出,本文方法的评价指标在所有对比模型中是最好的,尤其是DICE系数和IoU的提升明显,本文方法的DICE系数达到0.888,与对比的4个同主流模型相比,至少提升了0.033,最多提升了0.094,说明本文方法的分割结果与医生给出的金标准最接近。这一点还体现在分割结果的视觉效果对比上,如图10所示,绿色轮廓是专家给出的结节区标注,红色表示本文模型的分割结果。

从图10中可以看出,UNet模型分割产生大量的假阳性区域,如图10(b)中a~e标识的区域所示,这与UNet采用单一尺度的卷积有关。从图10(c)、(d)两列来看,AttUNet、ResUNet++在跨层连接上采用了注意力机制,使模型能更好地关注结节区域,从而消除了大部分假阳性区域,但随之带来了对结节内部过度关注的问题,如图10(c)、(d)中f、g、p、q标识的区域所示;此外,对于边界模糊的结节,AttUNet、ResUNet++两个模型仍无法准确定位结节边界,如图10(c)、(d)中m、n标识的区域所示,这说明模型对特征捕获还不够精准。SKUNet将注意力机制添加在编解码阶段的每一层而非跨层上,减轻了对结节内部的过度关注,如图10(e)中h标识的区域所示;此外,SKUNet在编解码阶段的每一层引入了多尺度卷积,使得边界模糊的结节周边的假阳性区域有所缓解,但分割出的结节边界仍然不够精准,如图10(e)中i标识的区域所示。相比之下,本文模型的分割结果假阳性区域较少,对边界模糊的结节分割效果与金标准更加接近,如图10(f)中j、k标识的区域所示。这与本文模型在编码层和跨层连接处采用了多尺度特征提取与融合以及瓶颈层采用权重矩阵突出多尺度感受野下有用的信息有关。综上所述,说明本文模型具有优越性与有效性。

图8 消融实验分割结果对比

此外,还与近三年同样实现超声乳腺结节分割模型进行了对比,包括:CF2-Net[25]、ESTAN[26]、FS-UNet[27]、SMU-Net[28],这些模型的评价指标如表2中的5~8行所示,这些数据来自原文献,它们采用的实验数据集与本文一致;由于原文献参数情况不明,因此无法复现这些模型,对未列出的数据用“—”表示原文献中未提供相应指标。由表2可知,本文方法的精度明显高于其他对比方法,DICE系数提高了0.001~0.068,这说明本文方法对结节区域的分割边界更精准,这一结果与图10(f)的分割结果图反映是一致的。CF2-Net基于UNet引入先验知识,但在结节不规则变化时,分割能力差,它的各项指标均低于本文方法。Estan模型的编码器采用扩张卷积提取和融合不同尺度的图像上下文信息,但指标并未取得明显提升。FS-UNet采用注意力关注结节区域,DICE系数和IoU指标与本文方法接近,但它的召回率仍低于本文方法。SMU-Net采用双通道输入,提取和融合前景以及背景显著图特征,使网络更加关注结节区域,在召回率上略高于本文方法,但反映分割区域精准度的精度指标和与真实结节区相似度的DICE系数低于本文方法。

图10 不同模型的分割结果

表2 不同分割方法的比较

3 结语

本文提出一种基于多尺度和跨空间融合的超声乳腺结节分割方法。首先,设计一种多尺度特征提取与融合(MFEF)模块,通过融合不同感受野下的特征信息,使模型对结节特征均具有更强的捕获能力;其次,为了对高级语义信息进行多尺度观察和信息筛选,采用尺度感知和自适应聚合(SFA)模块,以增强编码阶段的深层特征提取能力;最后,设计一种跨空间残差融合(CRF)模块,以缓解编解码对等层之间的语义差异,更好地补偿解码阶段的信息损失。通过消融实验验证了联合使用上述三个模块可获得最佳的分割效果;同时,对比实验结果表明,与常见的经典方法和使用同一数据集的其他方法相比,本文方法的分割结果在DICE系数、交并比、召回率和精度等评价指标方面均为最佳,且分割结果图的主观视觉效果与专家给出的金标准最接近,说明本文方法具有有效性和优越性。

但本文方法仅在公开数据集上进行了训练和验证,缺乏对多站点数据的验证评估。今后工作中,将搜集更多的超声乳腺结节临床数据以扩充训练集和验证集,提高模型的泛化性和鲁棒性。

[1] 司爽,张伟,王慧颖,等. 乳腺X线摄影、超声及磁共振诊断乳腺癌的性能评价[J]. 中国临床医学影像杂志, 2020, 31(1):20-23,29.(SI S, ZHANG W, WANG H Y, et al. Performance evaluation of breast cancer diagnosed with mammography, ultrasound and MRI[J]. Journal of China Clinical Medical Imaging, 2020, 31(1): 20-23, 29.)

[2] JIANG P, PENG J, ZHANG G, et al. Learning-based automatic breast tumor detection and segmentation in ultrasound images[C]// Proceedings of the 9th IEEE International Symposium on Biomedical Imaging. Piscataway: IEEE, 2012: 1587-1590.

[3] SHAN J, CHENG H D, WANG Y. A novel segmentation method for breast ultrasound images based on neutrosophic-means clustering[J]. Medical Physics, 2012, 39(9): 5669-5682.

[4] LUO Y, HAN S, HUANG Q. A novel graph-based segmentation method for breast ultrasound images[C]// Proceedings of the 2016 International Conference on Digital Image Computing: Techniques and Applications. Piscataway: IEEE, 2016: 1-6.

[5] LIU L, LI K, QIN W, et al. Automated breast tumor detection and segmentation with a novel computational framework of whole ultrasound images[J]. Medical and Biological Engineering and Computing, 2018, 56(2): 183-199.

[6] LOTFOLLAHI M, GITY M, YE J Y, et al. Segmentation of breast ultrasound images based on active contours using neutrosophic theory[J]. Journal of Medical Ultrasonics, 2018, 45(2): 205-212.

[7] ZHUANG Z, LI N, JOSEPH RAJ A N, et al. An RDAU-NET model for lesion segmentation in breast ultrasound images[J]. PLoS ONE, 2019, 14(8): No.e0221535.

[8] HAN L, HUANG Y, DOU H, et al. Semi-supervised segmentation of lesion from breast ultrasound images with attentional generative adversarial network[J]. Computer Methods and Programs in Biomedicine, 2020, 189: No.105275.

[9] BYRA M, JAROSIK P, SZUBERT A, et al. Breast mass segmentation in ultrasound with selective kernel U-Net convolutional neural network[J]. Biomedical Signal Processing and Control, 2020, 61: No.102027.

[10] VAKANSKI A, XIAN M, FREER P E. Attention-enriched deep learning model for breast tumor segmentation in ultrasound images[J]. Ultrasound in Medicine and Biology, 2020, 46(10): 2819-2833.

[11] XUE C, ZHU L, FU H, et al. Global guidance network for breast lesion segmentation in ultrasound images[J]. Medical Image Analysis, 2021, 70: No.101989.

[12] LI J, CHENG L, XIA T, et al. Multi-scale fusion U-Net for the segmentation of breast lesions[J]. IEEE Access, 2021, 9: 137125-137139.

[13] GAO C, YE H, CAO F, et al. Multiscale fused network with additive channel-spatial attention for image segmentation[J]. Knowledge-Based Systems, 2021, 214: No.106754.

[14] IQBAL A, SHARIF M. MDA-Net: multiscale dual attention-based network for breast lesion segmentation using ultrasound images[J]. Journal of King Saud University — Computer and Information Sciences, 2022, 34(9): 7283-7299.

[15] PUNN N S, AGARWAL S. RCA-IUnet: a residual cross-spatial attention-guided inception U-Net model for tumor segmentation in breast ultrasound imaging[J]. Machine Vision and Applications, 2022, 33(2): No.27.

[16] CHEN G, LI L, DAI Y, et al. AAU-Net: an adaptive attention U-Net for breast lesions segmentation in ultrasound images[J]. IEEE Transactions on Medical Imaging, 2023, 42(5): 1289-1300.

[17] ZHAO T, DAI H. Breast tumor ultrasound image segmentation method based on improved residual U-Net network[J]. Computational Intelligence and Neuroscience, 2022, 2022: No.3905998.

[18] 大连大学. 基于多尺度和跨空间融合的超声乳腺结节端到端分割方法: 202211177184.X[P]. 2023-01-06.(Dalian University. End-to-end segmentation of ultrasound breast nodules based on multi-scale and cross-spatial fusion: 202211177184.X[P]. 2023-01-06.)

[19] YUAN P, LIN S, CUI C, et al. HS-ResNet: hierarchical-split block on convolutional neural network[EB/OL]. (2020-10-15) [2022-12-15].https://arxiv.org/pdf/2010.07621.pdf.

[20] WU H, WANG W, ZHONG J, et al. SCS-Net: a scale and context sensitive network for retinal vessel segmentation[J]. Medical Image Analysis, 2021, 70: No.102025.

[21] YAP M H, PONS G, MARTÍ J, et al. Automated breast ultrasound lesions detection using convolutional neural networks[J]. IEEE Journal of Biomedical and Health Informatics, 2018, 22(4): 1218-1226.

[22] RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[23] OKTAY O, SCHLEMPER J, LE FOLGOC L, et al. Attention U-Net: learning where to look for the pancreas[EB/OL]. [2022-10-12].https://arxiv.org/pdf/1804.03999.pdf.

[24] JHA D, SMEDSRUD P H, RIEGLER M A, et al. ResUNet++: an advanced architecture for medical image segmentation[C]// Proceedings of the 2019 IEEE International Symposium on Multimedia. Piscataway: IEEE, 2019: 225-230.

[25] NING Z, WANG K, ZHONG S, et al. CF2-Net: coarse-to-fine fusion convolutional network for breast ultrasound image segmentation[EB/OL]. (2020-03-23) [2022-10-13].https://arxiv.org/ftp/arxiv/papers/2003/2003.10144.pdf.

[26] SHAREEF B, VAKANSKI A, FREER P E, et al. ESTAN: enhanced small tumor-aware network for breast ultrasound image segmentation[J]. Healthcare, 2022, 10(11): No.2262.

[27] PI J, QI Y, LOU M, et al. FS-UNet: mass segmentation in mammograms using an encoder-decoder architecture with feature strengthening[J]. Computers in Biology and Medicine, 2021, 137: No.104800.

[28] NING Z, ZHONG S, FENG Q, et al. SMU-Net: saliency-guided morphology-aware U-Net for breast lesion segmentation in ultrasound image[J]. IEEE Transactions on Medical Imaging, 2022, 41(2): 476-490.

Segmentation of breast nodules in ultrasound images based on multi-scale and cross-spatial fusion

ZHAO Xin1*, ZHU Qianqian1, ZHAO Cong2, WU Jialing3

(1,,116622,;2,’,116021,;3,,116011,)

Accurate breast nodule segmentation in ultrasound images is very challenging due to the low resolution and noise of ultrasound imaging, as well as the complexity and variability of the shape and texture of nodules, therefore, an end-to-end automatic segmentation method of breast nodules in ultrasound images based on multi-scale and cross-spatial feature fusion was proposed. Firstly, a Multi-scale Feature Extraction and Fusion (MFEF) module was designed to enable the network to have multi-scale feature extraction ability by fusing four convolutional paths with different receptive fields. Then, for the multi-scale observation and information filtering of high-level semantic information, a Scale-aware Feature Aggregation (SFA) module was used at the bottleneck layer to enhance the deep feature extraction ability in the encoding stage. Besides, a Cross-spatial Residual Fusion (CRF) module was designed and applied to the skip connection between the encoder and decoder to fuse information among different encoding layers in a cross-spatial way and implement information complementarity between different encoding layers, further extract information features of encoding layer and narrow the difference between peer layers of encoder and decoder to better compensate for the information loss in the decoding stage. Experimental results on a public ultrasound breast nodule dataset show that the proposed method achieves DICE coefficient of 0.888, which is 0.033 to 0.094 higher than those of the mainstream deep learning segmentation models UNet, AttUNet, ResUNet++ and SKUNet, and is 0.001 to 0.068 higher than those of the improved models such as CF2-Net, Estan, FS-UNet and SMU-Net in the same dataset. The subjective visualization of the segmentation result of the proposed method is closest to the gold standards provided by experts, verifying that the proposed mehtod can segment the breast nodule area more accurately.

multi-scale feature fusion; cross-spatial feature fusion; Scale-aware Feature Aggregation (SFA); Convolutional Neural Network (CNN); breast nodule segmentation in ultrasound images

1001-9081(2023)11-3599-08

10.11772/j.issn.1001-9081.2022111673

2022⁃11⁃11;

2023⁃02⁃16;

国家自然科学基金资助项目(61971424)。

赵欣(1974—),女,辽宁锦州人,副教授,博士,CCF会员,主要研究方向:人工智能、数字医学图像处理; 祝倩倩(1995—),女,山西朔州人,硕士研究生,硕士,CCF会员,主要研究方向:医学图像处理; 赵聪(1984—),女,辽宁大连人,副主任医师,主要研究方向:甲状腺、乳腺疾病的专科诊断及超声介入治疗; 吴佳玲(1979—),女,辽宁大连人,副主任医师,硕士,主要研究方向:甲状腺、乳腺疾病的超声诊断。

TP 391

A

2023⁃02⁃20。

This work is partially supported by National Natural Science Foundation of China (61971424).

ZHAO Xin, born in 1974, Ph. D., associate professor. Her research interests include artificial intelligence, digital medical image processing.

ZHU Qianqian, born in 1995,M. S. candidate. Her research interests include medical image processing.

ZHAO Cong, born in 1984, deputy chief physician. Her research interests include specialized diagnosis and interventional ultrasound therapy of thyroid and breast diseases.

WU Jialing, born in 1979, M. S., deputy chief physician. Her research interests include ultrasound diagnosis of breast and thyroid diseases.