保留梯度和轮廓的可见光与红外图像融合

2023-11-29韩林凯姚江伟王坤峰

韩林凯,姚江伟,王坤峰

保留梯度和轮廓的可见光与红外图像融合

韩林凯,姚江伟,王坤峰*

(北京化工大学 信息科学与技术学院,北京 100029)( ∗ 通信作者电子邮箱wangkf@buct.edu.cn)

为了解决可见光与红外图像采用基础拉普拉斯融合(Laplacian Blending)时,存在热源物体的轮廓不清晰以及曝光严重区域图像内容缺失的问题,提出一种保留红外轮廓与梯度信息的图像融合方法。首先,对输入图像进行颜色空间转换和自适应形态学去噪,并将两幅图像的梯度对比和红外图像突出目标的轮廓作为像素活动信息的权值;其次,同时分解权值与输入图像,并采用基于相似度的比较调整权重分配;最后,重构图像并转换颜色空间。在主观评价中,所提方法未产生伪影和怪异色彩,图像中的发热目标轮廓清晰;在客观评价指标中,该方法的熵(EN)为7.49,边缘梯度(EI)为74.61,平均梯度(AG)为7.23,与传统多尺度变换方法(包括非下采样轮廓波变换(NSCT)方法和基于非下采样剪切波变换(NSST)多尺度熵方法)和深度学习方法(结合残差网络(ResNet)与零相位分量分析(ZCA)的图像融合方法)相比,它的EN分别提升了0.10、0.58和0.75,EI分别提升了6.65、20.35和37.35,AG分别提升了0.73、2.19和3.55;而且它在Intel i5系列计算机上的处理速度达到5 frame/s,计算复杂度低。

图像融合;图像去噪;权值分配;拉普拉斯分解;轮廓保留

0 引言

可见光图像与红外图像由于成像原理不同,具有不同的优缺点[1]。在夜晚低照度环境下,红外图像可以清晰分辨目标物体与非目标物体,但同时也存在图像背景信息匮乏的缺点。可见光图像具有较为丰富的背景信息,但在不良光照条件下,目标物体与非目标物体的区分度小,难以识别。融合可见光与红外图像可以使结果既拥有可见光图像的丰富信息,又拥有红外图像的突出目标信息,因此,图像融合在医学、交通等领域[2]得到了广泛应用。

现阶段的多光谱图像信息融合分为三个级别:像素级融合、特征级融合和决策级融合[3],本文主要研究像素级融合。像素级融合依赖于多光谱图像的精确配准,在配准有偏差的情况下,像素级融合会产生伪影问题[4]。像素级融合方法的通用流程是:首先分解原始多光谱图像,获得不同带通下的分解系数,再按照一定的规则选取分解系数,最后重构图像。在像素级融合中,研究人员主要关注两个方面:活动水平测量和融合规则制定[5]。活动水平测量即多尺度分解方法,包括塔式分解、小波变换和多尺度几何分析等。Burt等[6]首次将拉普拉斯金字塔(Laplacian Pyramid, LP)变换[7]用于图像融合,并提出了LP图像融合方法,后续研究者针对LP分解的缺点进行了改进。针对LP分解得到的融合图像对比度较差的问题,Toet[8]提出了低通比率金字塔、对比度金字塔和形态学金字塔,通过增加不同带通的对比率来提高融合结果的对比度。Wang等[9]提出将LP分解和自适应稀疏表示结合,能有效减少伪影、噪声对融合结果的影响。随后,研究者又提出了Spline金字塔、中值金字塔、方向对比度可控金字塔和不可分LP等方法[10],解决了LP各层之间信息存在冗余、分解时缺少方向性的不足。

相较于拉普拉斯变换,小波变换的优点是它本身带有方向性,缺点是不同带通之间存在冗余。研究者先后提出了离散小波变换[11]、经验小波变换[12]等一系列改进小波变换,以提升融合效果。Do等[13]提出轮廓波变换,组合拉普拉斯塔形分解和方向滤波器,能实现分解的多分辨率、局域方向的图像表示。非下采样轮廓波变换(Non-Subsampled Contourlet Transformation, NSCT)[14]、非剪切轮廓波变换等多尺度分解方法随后被提出,减少了轮廓波带来的伪吉布斯现象,增加了分解的方向性与局部性。相较于拉普拉斯分解,小波变换和多尺度分解具有冗余小、多方向性等优点,但同时由于它们的计算复杂度高,不适用于有实时性要求的工程。卷积神经网络(Convolutional Neural Network, CNN)和深度学习技术的发展推动了传统图像融合技术的转变,对图像融合阶段的权重分配具有全局的参考价值。生成对抗网络(Generative Adversarial Network, GAN)被广泛应用于图像生成与图像融合。Li等[15]将耦合GAN应用于图像融合,使可见光图像纹理信息和红外图像热辐射信息融合更平稳,同时避免了设计融合规则。多尺度注意力机制使网络能获取更全面的空间信息,Li等[16]将注意力机制应用于GAN,生成器更聚焦红外图像的前景热源信息和背景细节信息,判别器更聚焦突出区域。另外,研究者利用CNN提取原图像的像素活动信息,整合红外图像与可见光图像,参与融合规则的制订。Liu等[17]利用孪生(Siamese)网络整合原图像的像素活动信息,再与原图像一起参与多尺度分解和融合规则的选择。但是将深度学习用于图像融合的计算复杂度更高,需要高性能计算机参与训练,同时需要大规模训练数据集。

相较于深度学习的图像融合方法,传统图像融合方法的速度更快,但在分解原图像的过程中容易丢失图像原始信息;基于深度学习的图像融合方法虽然增加了全局信息,但模型复杂度高,对计算设备的要求也高。针对上述问题,本文提出一种保留红外轮廓与梯度信息的图像融合方法。为了减少未完全配准图像的像素差异,首先预处理可见光图像和红外图像,以降噪和补全信息;其次,为了达到实时性要求,以拉普拉斯分解为底层框架,利用深度学习提取图像特征的思想,保留红外图像轮廓和可见光图像背景梯度信息,从图像中提取特征构成总体权值图,与原图像一起参与拉普拉斯分解和重构,提高图像的融合性能。

1 本文方法

1.1 预处理并获得权重

在采集与传输图像时,会引入随机的椒盐噪声和高斯噪声。权重自适应可以构造不同的形态学结构,最大限度地减少噪声,补全信息。因此,采用权重自适应构造不同形态学结构的方法,增强可见光图像和红外图像的图像信息,减少椒盐噪声和高斯噪声;同时,利用形态学开闭操作,补全信息缺失的区域。串联滤波或并联滤波的效果通常比串并联复合滤波差,因此构造不同的形态学结构时,采用形态开‒闭的级联形式。选择权重时,可以采用自定义结构或者自适应的方式,不同图像所含信息的复杂度不同,自定义权重方法的鲁棒性欠佳,因此选择自适应调整权重。

为了降低计算量和简化计算步骤,在具体实现过程中,计算串联滤波器的处理结果与原始输入图像的差异值,并将计算结果作为权值向量;确定权值后,通过对串联结果加权求和得到去噪后的图像信息。上述预处理操作的流程如图1所示。

图1 原始图像预处理和获得的信息权重

接下来对预处理后的红外图像进行形态学梯度处理和阈值处理。其中,对红外图像进行形态学梯度处理的目的是突出红外图像中高亮区域的外围,得到高亮目标的准确轮廓。形态学梯度指形态学中膨胀图和腐蚀图之差,对它进行阈值处理,使它的显著边缘轮廓为1,以确保在融合过程中不损失高亮目标的轮廓信息。阈值处理的定义如下:

1.2 融合规则

图像与权重分解融合过程如图2所示。

图2 图像与权重分解融合过程

2 实验与结果分析

为了验证本文方法的有效性,分别与传统的多尺度分解方法和基于卷积神经网络的深度学习方法进行对比。传统的多尺度分解方法包括:基于交叉双边滤波(Cross Bilateral Filter, CBF)方法[19]、基于梯度转移融合(Gradient Transfer Fusion, GTF)多尺度方法[20];基于卷积神经网络的深度学习方法包括:基于CNN和LP分解的融合方法[17](简记为CNN+LP)、结合残差网络(Residual Network, ResNet)和零相位分量分析(Zero-phase Component Analysis, ZCA)的图像融合方法[21](简记为ResNet+ZCA)。本文实验对比采用原论文提供的参数,实验使用Matlab 2016与C++ 11编程实现,在Intel Core i5-8250U CPU@1.60 GHz的计算机上运行。

2.1 数据集

实验使用两个数据集:一是从TNO数据集[22]中选取51对热红外图像与可见光图像,二是从文献[23]中选取21对数据扩充数据集。按照时间段将数据集划分为白天和晚上,按照天气环境划分为烟雾、雨雪和正常等环境,按照空间位置划分为室内和室外。

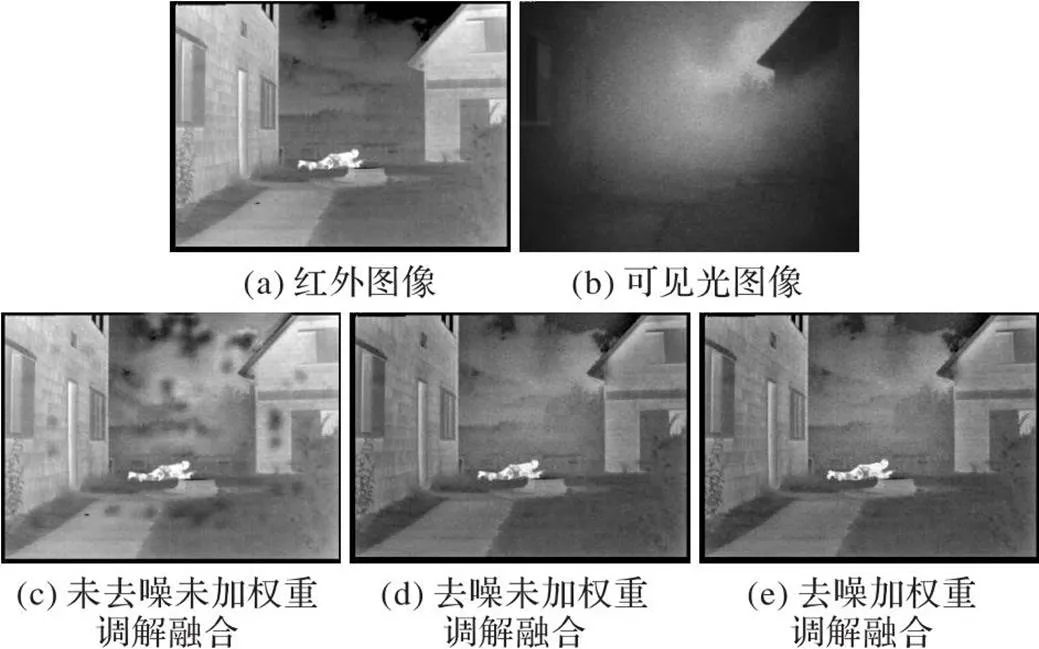

2.2 消融实验定性分析

原始拉普拉斯方法因为噪声的存在会产生图像融合效果不稳定的现象,针对该问题,本文提出减少噪声的改进措施;同时,原始拉普拉斯方法融合结果中存在目标物体轮廓不清晰的问题,因此本文提出权重调解融合系数选择。图3(c)为原始拉普拉斯图像融合结果,可以看出因为噪声导致融合结果产生了大量伪影;图3(d)为未加入权重调解的融合结果,可以看出发热目标人的边缘轮廓不清晰;相较于图3(c)~(d),图3(e)(即本文方法)保留了可见光图像中的背景纹理信息,同时红外图像中人的轮廓更清晰,也没有产生伪影。

图3 本文方法各改进措施对融合结果的影响

2.3 不同方法融合结果定性分析

为了验证本文方法在不同场景下的鲁棒性,设计两组分别在白天和夜晚光照条件下的实验作为对比。

图4为白天环境下的实验结果对比,可以看出:CBF在融合结果中,会产生模块化的伪影;GTF在融合过程,没有考虑保留图像色彩,在有色彩的环境下,重构后失去了图像原有色彩;ResNet+ZCA在卷积过程中,降低了图像的色度;CNN+LP、本文方法在白天环境下较好地完成了图像融合任务。

图5为夜晚环境下的实验结果对比。从图5中看出,CBF在可见光图像存在曝光现象时,融合结果丢失了红外图像中的有用信息,如图5中的图像对1,CBF漏掉了红外图像的行人信息;同时,在保留可见光的物理背景信息时,CBF保留的清晰度差于本文方法。对于保留可见光图像的背景信息和保留红外图像的突出热源信息方面,GTF的完成度较低。当可见光图像在夜晚曝光严重时,CNN+LP方法基本没有融合效果;而在曝光不严重的区域,该方法较好地实现了两者的结合;在背景存在树枝的情况下,该方法保留了可见光图像更充分的信息。利用卷积反卷积实现的ResNet+ZCA,在图像前后的缩放过程中,损失了图像的数值信息,使融合结果偏暗,降低了图像色度。本文方法可以充分保留可见光图像的物理背景信息,对于曝光严重的可见光图像,尽管融合图像在曝光边界存在一定的光晕,但其他部分的融合效果达到预期。相较于CNN+LP,本文方法解决了曝光严重部分的融合缺失问题。在融合结果方面,本文方法的融合结果具有丰富的背景信息,整体视觉效果较好。

图4 白天环境下不同方法的实验结果对比

图5 夜晚环境下不同方法的实验结果对比

2.4 不同方法融合结果定量分析

Zhang等[23]提出了13种客观评价标准,主要分为基于信息论、基于结构相似性、基于图像特征和基于人类视觉感知这四类。为了保证公平性、有效性,本文在这四类中选取以下指标:熵(ENtropy, EN)、边缘梯度(Edge Intensity, EI)、标准差(Standard Deviation, SD)、平均梯度(Average Gradient, AG)、互信息(Mutual Information, MI)、基于梯度的融合性能(Qabf)和Qcb(一种结合对比度敏感滤波、局部对比计算、各向同性局部对比度计算和显著图生成的评价标准)。EN越高,保留的图像细节越多;EI越高,图像边缘信息数越多,且质量越好;SD表示灰度均值的离散程度,值越大越好;AG反映图像的清晰度,代表图像细节处的梯度变化,值越高越好;Qabf和Qcb也是值越高越好。

为了验证本文方法相较于传统方法和较新方法的有效性,除以上对比方法外,增加LP图像融合方法[7]、非下采样轮廓波变换(NSCT)方法[14]、基于非下采样剪切波变换(Non-Subsampled Shearlet Transform, NSST)多尺度熵方法[24]。

由于每组图像的质量不同,图像融合的性能指标有较大差别,本文对每组图像评价标准所得值取平均,结果如表1所示。从表1可以看出,本文方法在EN、EI、AG和Qabf的表现均最高,这得益于本文方法对于梯度信息的保留。相较于NSCT、NSST和ResNet+ZCA,本文方法的EN分别提升了0.10、0.58和0.75,EI分别提升了6.65、20.35和37.35,AG分别提升了0.73、2.19和3.55。ResNet+ZCA虽然也利用了CNN,但该方法中涉及多次卷积反卷积的操作,损失了图像信息,表现比CNN+LP差。

表2为不同方法的时间消耗,可以看出,本文方法的计算时间明显少于CBF、GTF、CNN+LP和ResNet+ZCA。使用Intel i5系列CPU,不利用多线程计算,当处理的图像大小为500×500时,本文方法的处理速度可以达到5 frame/s。

表2 不同方法的时间消耗 单位:s

3 结语

本文提出了一种保留红外图像原始轮廓的图像融合方法。在图像进行多尺度分解之前,首先对原始图像做自适应形态学的图像去噪,改变图像存储格式,并保留红外图像的轮廓信息,从而改善图像信息缺失,降低融合后产生伪影的概率,并保留可见光图像的色度信息。在融合规则的选取上,以匹配度与原始图像保留信息调节系数的选择,保留更丰富的纹理细节。在主观评价方面,本文在测试数据集上的融合结果良好,保留了原始图像的色度且基本不产生伪影,同时保留了红外突出的目标和可见光丰富的纹理细节信息;在客观评价指标方面,本文方法的融合结果表现较好,7个指标中的4个指标都为最优。此外,本文方法所消耗的时间比其他四种对比方法少。

本文方法适合热红外图像与可见光图像的融合,但对近红外图像的融合性能较差。本文方法在处理分解图像层数选择、权重参数下采样两个问题时,主要依据主观经验,缺乏理论支撑。因此,未来将从以下两方面进一步研究:探究更多光谱下的图像融合,研究参数调整对融合结果产生影响的本源机制。

[1] 刘明葳,王任华,李静,等. 各向异性导向滤波的红外与可见光图像融合[J]. 中国图象图形学报, 2021, 26(10): 2421-2432.(LIU M W, WANG R H, LI J, et al. Infrared and visible image fusion with multi-scale anisotropic guided filtering[J]. Journal of Image and Graphics, 2021, 26(10): 2421-2432.)

[2] LI C, ZHU A. Application of image fusion in diagnosis and treatment of liver cancer[J]. Applied Sciences, 2020, 10(3): No.1171.

[3] 周涛,刘珊,董雅丽,等. 多尺度变换像素级医学图像融合:研究进展、应用和挑战[J]. 中国图象图形学报, 2021, 26(9): 2094-2110.(ZHOU T, LIU S, DONG Y L, et al. Research on pixel-level image fusion based on multi-scale transformation: progress application and challenges[J]. Journal of Image and Graphics, 2021, 26(9): 2094-2110.)

[4] KOU F, LI Z, WEN C, et al. Edge-preserving smoothing pyramid based multi-scale exposure fusion[J]. Journal of Visual Communication and Image Representation, 2018, 53: 235-244.

[5] XU H, MA J. EMFusion: an unsupervised enhanced medical image fusion network[J]. Information Fusion, 2021, 76: 177-186.

[6] BURT P J, ADELSON E H. Merging images through pattern decomposition[C]// Proceedings of the SPIE 0575, Applications of Digital Image Processing Ⅷ. Bellingham, WA: SPIE, 1985: 173-181.

[7] BURT P J, ADELSON E H. A multiresolution spline with application to image mosaics[J]. ACM Transactions on Graphics, 1983, 2(4): 217-236.

[8] TOET A. Image fusion by a ratio of low-pass pyramid[J]. Pattern Recognition Letters, 1989, 9(4): 245-253.

[9] WANG Z, CUI Z, ZHU Y. Multi-modal medical image fusion by Laplacian pyramid and adaptive sparse representation[J]. Computers in Biology and Medicine, 2020, 123: No.103823.

[10] 刘斌,谌文江,辛迦楠. 基于四通道不可分加性小波的多聚焦图像融合[J]. 计算机科学, 2019, 46(7): 268-273.(LIU B, CHEN W J, XIN J N. Multifocus image fusion based on four channel non-separable additive wavelet[J]. Computer Science, 2019, 46(7): 268-273.)

[11] DIWAKAR M, TRIPATHI A, JOSHI K, et al. A comparative review: medical image fusion using SWT and DWT[J]. Materials Today: Proceedings, 2021, 37(Pt 2): 3411-3416.

[12] GILLES J. Empirical wavelet transform[J]. IEEE Transactions on Signal Processing, 2013, 61(16): 3999-4010.

[13] DO M N, VETTERLI M. Contourlets[J]. Studies in Computational Mathematics, 2003, 10: 83-105.

[14] ZHOU J, CUNHA A L, DO M N. Nonsubsampled contourlet transform: construction and application in enhancement[C]// Proceedings of the 2005 IEEE International Conference on Image Processing. Piscataway: IEEE, 2005: 1-469.

[15] LI Q, LU L, LI Z, et al. Coupled GAN with relativistic discriminators for infrared and visible images fusion[J]. IEEE Sensors Journal, 2021, 21(6): 7458-7467.

[16] LI J, HUO H, LI C, et al. AttentionFGAN: infrared and visible image fusion using attention-based generative adversarial networks[J]. IEEE Transactions on Multimedia, 2021, 23: 1383-1396.

[17] LIU Y, CHEN X, CHENG J, et al. Infrared and visible image fusion with convolutional neural networks[J]. International Journal of Wavelets, Multiresolution and Information Processing, 2018, 16(3): No.1850018.

[18] WANG J, ZHENG N. A novel fractal image compression scheme with block classification and sorting based on Pearson’s correlation coefficient[J]. IEEE Transactions on Image Processing, 2013, 22(9): 3690-3702.

[19] SHREYAMSHA KUMAR B K. Image fusion based on pixel significance using cross bilateral filter[J]. Signal, Image and Video Processing, 2015, 9(5): 1193-1204.

[20] MA J, CHEN C, LI C, et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]. Information Fusion, 2016, 31: 100-109.

[21] LI H, WU X J, DURRANI T S. Infrared and visible image fusion with ResNet and zero-phase component analysis[J]. Infrared Physics and Technology, 2019, 102: No.103039.

[22] TOET A. TNO image fusion dataset[DS/OL]. [2022-09-10].https://figshare.com/articles/dataset/TNO_Image_Fusion_Dataset/1008029

[23] ZHANG X. Benchmarking and comparing multi-exposure image fusion algorithms[J]. Information Fusion, 2021, 74: 111-131.

[24] 任亚飞,张娟梅. 基于NSST多尺度熵的红外与可见光图像融合[J]. 兵器装备工程学报, 2022, 43(7): 278-285.(REN Y F, ZHANG J M. Infrared and visible image fusion based on NSST multi-scale entropy[J]. Journal of Ordnance Equipment Engineering, 2022, 43(7):278-285.)

Visible and infrared image fusion by preserving gradients and contours

HAN Linkai, YAO Jiangwei, WANG Kunfeng*

(,,100029,)

In order to solve the problems of unclear contours of heat source objects and missing image content in severely exposed regions when visible and infrared images are fused by using basic Laplacian blending, an image fusion algorithm that preserves infrared contours and gradient information was proposed. Firstly, the input image was transformed into color space and denoised by adaptive morphology, and the gradient contrast of the two images and the contour of the highlighted object in the infrared image were taken as the weights of pixel activity information. Secondly, the weights and the input images were decomposed simultaneously, and the weight assignment was adjusted by similarity-based comparison. Finally, the image was reconstructed and the color space was transformed. In subjective evaluation, the proposed algorithm does not produce artifacts and strange colors, and the contours of the heat object in the obtained image is clear. In objective evaluation, the proposed algorithm has an ENtropy (EN) of 7.49, an Edge Intensity (EI) of 74.61, and an Average Gradient (AG) of 7.23, compared with the traditional multi-scale transformation methods (including Non-Subsampled Contourlet Transformation (NSCT) method, the method based on Non-Subsampled Shearlet Transform (NSST) multi-scale entropy) and the latest deep learning method (such as the method combining Residual Network (ResNet) and Zero-phase Component Analysis (ZCA)), it improves EN by 0.10, 0.58 and 0.75, EI by 6.65, 20.35 and 37.35, and AG by 0.73, 2.19 and 3.55; it also achieves a processing speed of 5 frame/s on Intel i5 series computers with low computational complexity.

image fusion; image denoising; weight assignment; Laplacian decomposition; contour preserving

1001-9081(2023)11-3574-05

10.11772/j.issn.1001-9081.2022101553

2022⁃10⁃15;

2023⁃02⁃01;

国家重点研发计划项目(2020YFC2003900); 国家自然科学基金资助项目(62076020)。

韩林凯(1998—),男,山西运城人,硕士研究生,主要研究方向:图像融合、目标检测; 姚江伟(1996—),男,山西太原人,硕士研究生,主要研究方向:图像融合、图像配准; 王坤峰(1982—),男,河南周口人,教授,博士,CCF会员,主要研究方向:计算机视觉、机器学习、多模态人工智能。

TP391

A

2023⁃02⁃06。

This work is partially supported by National Key Research and Development Program of China (2020YFC2003900), National Natural Science Foundation of China (62076020).

HAN Linkai, born in 1998, M. S. candidate. His research interests include image fusion, object detection.

YAO Jiangwei, born in 1996, M. S. candidate. His research interests include image fusion, image registration.

WANG Kunfeng, born in 1982, Ph. D., professor. His research interests include computer vision, machine learning, multimodal artificial intelligence.