基于差分进化的神经网络通用扰动生成方法

2023-11-29高乾顺范纯龙李炎达滕一平

高乾顺,范纯龙,李炎达,滕一平

基于差分进化的神经网络通用扰动生成方法

高乾顺,范纯龙*,李炎达,滕一平

(沈阳航空航天大学 计算机学院,沈阳 110136)( ∗ 通信作者电子邮箱FanCHL@sau.edu.cn)

针对超球面通用攻击(HGAA)算法中通用扰动搜索始终限定在空间球面上,不具有球内空间搜索能力的问题,提出一种基于超球面的差分进化算法。该算法将搜索空间扩大到球面内部,并通过差分进化(DE)算法搜索最优球面,从而生成愚弄率更高、模长更低的通用扰动。此外,分析了种群数量等关键参数对该算法的影响,并且测试了该算法生成的通用扰动在不同神经网络模型上的性能。在CIFAR10和SVHN图像分类数据集上进行验证,该算法与HGAA算法相比愚弄率最多提高了11.8个百分点。实验结果表明,该算法扩展了HGAA算法的通用扰动搜索空间,降低了通用扰动的模长,提高了通用扰动的愚弄率。

对抗攻击;通用扰动;神经网络;超球面攻击;差分进化算法

0 引言

深度神经网络[1-2]在诸多领域已经广泛应用,但随着深度学习技术研究和应用的深入,一些安全问题也逐渐凸显,对大量智能技术应用场景造成重大安全威胁。研究表明,深度神经网络对于一些人眼不可见的微小扰动很敏感,这种扰动通常被称为对抗扰动,生成并在神经网络输入上施加对抗扰动的行为被称作对抗攻击[3]。神经网络对抗攻击打开了神经网络安全性研究的大门,并得到来自工业界和学术界众多专家和学者的重视。目前,面向神经网络的对抗样本攻防、数据投毒攻防、模型投毒攻防、数据隐私防护、模型隐私防护等诸多安全性研究都快速发展,研究场景也从图像分类扩展到图像识别、目标检测、语音伪装、强化学习、智能安防、自动驾驶等领域。这些研究工作对提高神经网络安全性、理解神经网络的内在机制起到了重要作用,同时也助推了神经网络的鲁棒性、可解释等方面的研究开展,对发现神经网络缺陷或者评测神经网络等均有重要意义。

如果一个对抗扰动能使样本集内尽可能多的样本输出结果错误,则该对抗扰动称为通用扰动。本文对现有通用扰动求解算法进行了总结,并针对超球面通用攻击(Hyperspherical General Adversarial Attacks, HGAA)算法中通用扰动搜索只能在空间球面上进行,对球面内扰动不具有搜索能力这一问题,提出基于超球面的差分进化算法,通过差分进化(Differential Evolution, DE)算法搜索球内凹陷的优化点,从而将搜索空间扩大到球面内部,并进一步提高通用扰动的愚弄率。本文在两个数据集(CIFAR10和SVHN)和三个神经网络模型(NiN、VGG11和ResNet18)上评估了所提出的算法。实验结果表明,该算法扩展了HGAA算法的通用扰动搜索空间,降低了通用扰动的模长,提高了通用扰动的愚弄率。此外,对算法的配置参数进行实验分析,给出了参数设置的参考值,同时对算法生成的通用扰动在不同神经网络模型间的攻击迁移能力进行实验验证。

1 相关工作

神经网络模型容易受到添加了对抗扰动的对抗样本的攻击[4-6],导致模型作出错误的预测。基于深度卷积神经网络(Convolutional Neural Network, CNN)的分类器[7-11]也显示出被人类几乎察觉不到的敌对干扰欺骗的现象。这种神经网络的对抗样本可以通过多种方法得到,如利用模型的线性[7]、有限训练数据[8]等。更重要的是,对抗样本可以从一个模型转移到另一个模型(广义),即使第二个模型具有不同的体系结构,并在不同的训练数据集上进行训练[7,11-13]。

从对抗攻击在计算机视觉领域被发现开始,研究者们针对对抗攻击问题进行了大量研究。研究者提出的对抗攻击算法根据攻击场景可划分为:仅访问模型输出结果标签或置信度的黑盒攻击[14-20],攻击时可以对模型内部信息进行访问的白盒攻击[4,21-24];也可以根据攻击者的攻击目的分为有目标攻击[25]和无目标攻击[22,26-27];还可以根据攻击样本的数量划分为单样本攻击和通用样本攻击,其中,单样本攻击[17,23-24]针对每个样本生成不同的扰动,通用样本攻击[25-31]针对整个样本集产生一个通用扰动。

文献[15]中利用残差网络生成与图像无关的通用扰动,可以实现有目标攻击;文献[26]的方法在没有任何样本数据的情况下,通过计算CNN各层输出张量的平均激活值生成通用扰动,并且扰动可以在多个网络体系结构上传递;文献[27]的方法在不了解数据分布的情况下,通过破坏图像的特征空间生成通用扰动;文献[28]中不使用样本数据,而是通过“类印象”的迁移策略来模拟真实样本数据制作通用扰动;文献[29]中通过攻击分层关联传播(Layer-wise Relevance Propagation, LRP)生成的热力图产生通用扰动;文献[30]的方法可以在无法访问目标模型和样本数据的情况下,通过微调预训练模型得到目标模型,在预训练模型上生成通用扰动进而使目标模型失效。由于攻击者获得样本数据是不合理的,因此无法分析每张样本数据的决策边界,导致生成的通用扰动对神经网络模型的愚弄效果往往并不理想。

超球面通用攻击(HGAA)算法[33]限定了扰动搜索时的扰动模长,使扰动搜索在特定模长的球面上进行,实现扰动搜索的降维,从而提高通用扰动生成的愚弄率和可控性。但该算法对扰动模长的限定条件较严格,导致搜索空间始终在球面上,无法搜索到球内凹陷的更好的扰动点,即对于球面内扰动不具有搜索能力。针对此问题,本文提出利用DE算法[34]扩展HGAA算法的扰动搜索空间,搜索扰动模长更小的通用扰动。

本文针对图像分类神经网络的通用扰动生成场景,优化HGAA算法,提出基于超球面的差分进化算法。主要工作如下:

1)提出基于超球面的差分进化算法,通过DE算法搜索球内凹陷优化点,进一步降低通用扰动模长,提高通用扰动性能。

2)分析种群数量等参数对DE算法的影响及其与扰动性能的关系,合理设置参数大小,提高通用扰动的愚弄率。

3)将优化算法在不同神经网络模型上进行测试,验证了算法生成的通用扰动具有较好的性能,并对多种模型同时生效。

2 通用扰动生成方法

2.1 HGAA算法

2.2 DE算法

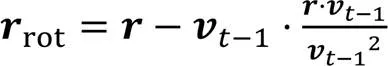

DE算法是一种通过模拟自然进化过程搜索最优解的方法。与遗传算法不同,DE算法在变异操作方面使用差分策略,即利用种群中个体间的差分向量对个体进行扰动,实现个体变异。DE算法独特的变异方式可以有效利用群体分布特性,提高算法的搜索能力,从而避免遗传算法中变异方式不足的问题。差分进化通过反复迭代,使那些适应环境的个体被保存下来。一般包含四个步骤:初始化、变异、交叉和选择。具体算法流程如下:

在变异操作中需要防止越界,即对每个个体判断是否在指定的范围内,如果不满足边界条件,可用初始化种群的随机方法重新生成。

2.3 问题描述

由于HGAA算法对通用扰动模长的限定条件过于严格,导致搜索空间始终在球面上,无法搜索到球内凹陷的更好的通用扰动点,即对于球面内扰动不具有搜索能力。针对此问题,本文提出基于超球面的差分进化算法,扩展HGAA算法的扰动搜索空间,搜索扰动模长更小的通用扰动,问题描述如式(3)、(4)所示:

2.4 基于超球面的差分进化算法

经过一定数量的迭代,就能够找到最优的通用扰动及其对应的模长和愚弄率,根据前文基于超球面的差分进化算法思想描述,明确了基于超球面的差分进化算法的过程,下面算法1给出了该算法的具体描述:

算法1 基于超球面的差分进化算法。

b) FOR=1 toDO

FOR=1 toDO

END

ELSE

END

END

3 实验与结果分析

3.1 实验设置

选用CIFAR10、SVHN作为实验数据集,采用NiN、VGG11、ResNet18神经网络模型进行对抗攻击实验,对本文算法性能和关键参数影响进行实验分析,实验全部在一台搭载有NVIDIA GeForce RTX 2080Ti GPU显卡的工作站完成,采用Python 3.8编程开发环境和Pytorch1.8.0框架。

3.2 评价指标

3.3 实验结果

表1 对比算法在不同数据集、不同模长、不同网络模型下的和

表2 各算法在不同数据集与网络模型下的查询次数与FR对比

图1 不同网络模型生成的通用扰动

在CIFAR10数据集上,选择ResNet18网络模型,将本文算法生成的通用扰动加入到原始样本中,生成的对抗样本如图2所示,图像下方为原始样本的预测标签和对抗样本的预测标签。

图2 CIFAR10数据集的原始样本和加入扰动后的对抗样本及其预测标签

在同一网络模型下不同算法生成的通用扰动是不同的,图3是本文算法与对比算法在CIFAR10数据集上的攻击示例。

图3 CIFAR10数据集上不同算法生成的对抗样本

3.4 扰动跨模型

表3 本文算法通用扰动的跨模型攻击得到的

通用扰动可以很好地推广到其他网络体系结构。这种普遍性可以用这样一个事实来解释:如果深度神经网络独立于它的架构细节,确实学会了检测低层次的模式,如边缘,那么添加一个边缘类噪声很有可能破坏预测。

3.5 关键参数影响

本文算法涉及多个手工配置参数,这些参数的取值会对算法的攻击效果产生一定的影响,因此,对算法涉及的配置参数进行了实验分析,实验中随机选择CIFAR10测试集中1 000个样本作为待攻击数据集,选择ResNet18作为对抗攻击的目标模型,以验证关键参数取值对算法性能的影响。

表4 参数M对算法的影响

表5 参数lb对算法的影响

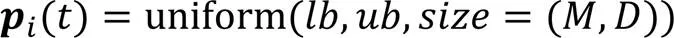

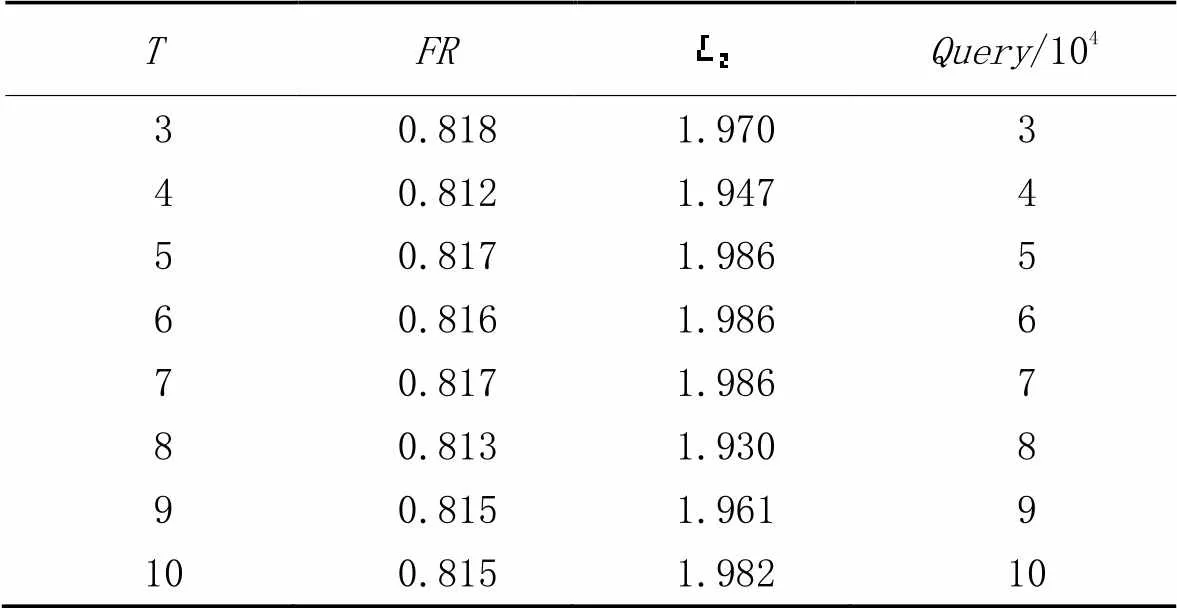

表6 参数T对算法的影响

3.5.4训练样本数量对算法的影响

图4 训练样本数对的影响

4 结语

针对HGAA算法中通用扰动搜索只能在球面上进行,对球面内扰动不具有搜索能力这一问题,提出基于超球面的差分进化算法,通过DE算法搜索球内凹陷的优化点,从而进一步降低通用扰动模长,提高通用扰动的攻击性能。实验结果表明,该算法扩展了HGAA算法的通用扰动搜索空间,降低了通用扰动的模长,提高了通用扰动的愚弄率。另外,对算法的配置参数进行实验分析,给出了参数设置的参考值,同时对算法生成的通用扰动在不同神经网络模型间的攻击迁移能力进行实验验证。DE算法在效率和精度上优于遗传算法,并且与粒子群算法相比不容易陷入局部最优,对于其他启发式算法,也许可以搜索到相同性能的通用扰动,甚至效果要优于DE算法,但目前还没有进行相关的研究分析,因此这也是今后需要开展的一项工作。通用扰动是对抗攻击研究的重要方面,目前的研究还主要集中在分类等典型神经网络应用场景,对不同应用场景的研究依然不足,另外,对抗攻击在物理世界中的应用效果还有待深入研究。

[1] LeCUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[2] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[3] SZEGEDY C, ZAREMBA W, SUTSKEVER I, et al. Intriguing properties of neural networks[EB/OL]. [2022-09-10].https://arxiv.org/pdf/1312.6199.pdf.

[4] BIGGIO B, CORONA I, MAIORCA D, et al. Evasion attacks against machine learning at test time[C]// Proceedings of the 2013 Joint European Conference on Machine Learning and Knowledge Discovery in Databases, LNCS 8190. Berlin: Springer, 2013: 387-402.

[5] BIGGIO B, FUMERA G, ROLI F. Pattern recognition systems under attack: design issues and research challenges[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2014, 28(7): No.1460002.

[6] HUANG L, JOSEPH A D, NELSON B, et al. Adversarial machine learning[C]// Proceedings of the 4th ACM Workshop on Security and Artificial Intelligence. New York: ACM, 2011: 43-58.

[7] GOODFELLOW I J, SHLENS J, SZEGEDY C. Explaining and harnessing adversarial examples[EB/OL]. [2022-09-10].https://arxiv.org/pdf/1412.6572.pdf.

[8] BENGIO Y. Learning deep architectures for AI[J]. Foundations and Trends in Machine Learning, 2009, 2(1): 1-127.

[9] KURAKIN A, GOODFELLOW I J, BENGIO S. Adversarial machine learning at scale[EB/OL]. [2022-09-10].https://arxiv.org/pdf/1611.01236.pdf.

[10] MOOSAVI-DEZFOOLI S M, FAWZI A, FROSSARD P. DeepFool: a simple and accurate method to fool deep neural networks[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 2574-2582.

[11] SZEGEDY C, ZAREMBA W, SUTSKEVER I, et al. Intriguing properties of neural networks[EB/OL]. [2022-09-10].https://arxiv.org/pdf/1312.6199.pdf.

[12] DONG Y, LIAO F, PANG T, et al. Boosting adversarial attacks with momentum[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 9185-9193.

[13] HUANG Q, KATSMAN I, GU Z, et al. Enhancing adversarial example transferability with an intermediate level attack[C]// Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2019: 4732-4741.

[14] PAPERNOT N, McDANIEL P, GOODFELLOW I, et al. Practical black-box attacks against machine learning[C]// Proceedings of the 2017 ACM Asia Conference on Computer and Communications Security. New York: ACM, 2017: 506-519.

[15] SARKAR S, BANSAL A, MAHBUB U, et al. UPSET and ANGRI: breaking high performance image classifiers[EB/OL]. [2022-09-10]. https://arxiv.org/pdf/1707.01159.pdf.

[16] CISSE M, ADI Y, NEVEROVA N, et al. Houdini: fooling deep structured prediction models[C]// Proceedings of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 6980-6990.

[17] CHEN P Y, ZHANG H, SHARMA Y, et al. ZOO: zeroth order optimization based black-box attacks to deep neural networks without training substitute models[C]// Proceedings of the 10th ACM Workshop on Artificial Intelligence and Security. New York: ACM, 2017: 15-26.

[18] SU J, VARGAS D V, SAKURAI K. One pixel attack for fooling deep neural networks[J]. IEEE Transactions on Evolutionary Computation, 2019, 23(5): 828-841.

[19] ILYAS A, ENGSTROM L, ATHALYE A, et al. Black-box adversarial attacks with limited queries and information[C]// Proceedings of the 35th International Conference on Machine Learning. New York: JMLR.org, 2018: 2137-2146.

[20] LI P, YI J, ZHANG L. Query-efficient black-box attack by active learning[C]// Proceedings of the 2018 IEEE International Conference on Data Mining. Piscataway: IEEE, 2018: 1200-1205.

[21] DONG Y, LIAO F, PANG T, et al. Discovering adversarial examples with momentum[EB/OL]. [2022-09-10].https://arxiv.org/pdf/1710.06081v1.pdf.

[22] MOOSAVI-DEZFOOLI S M, FAWZI A, FAWZI O, et al. Universal adversarial perturbations[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 86-94.

[23] CARLINI N, WAGNER D. Towards evaluating the robustness of neural networks[C]// Proceedings of the 2017 IEEE Symposium on Security and Privacy. Piscataway: IEEE, 2017: 39-57.

[24] SHI Y, HAN Y, ZHANG Q, et al. Adaptive iterative attack towards explainable adversarial robustness[J]. Pattern Recognition, 2020, 105: No.107309.

[25] ZHANG C, BENZ P, IMTIAZ T, et al. CD-UAP: class discriminative universal adversarial perturbation[C]// Proceedings of the 34th AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2020: 6754-6761.

[26] MOPURI K R, GARG U, BABU R V. Fast feature fool: a data independent approach to universal adversarial perturbations[C]// Proceedings of the 2017 British Machine Vision Conference. Durham: BMVA Press, 2017: No.30.

[27] MOPURI K R, GANESHAN A, BABU R V. Generalizable data-free objective for crafting universal adversarial perturbations[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(10): 2452-2465.

[28] MOPURI K R, UPPALA P K, BABU R V. Ask, acquire, and attack: data-free UAP generation using class impressions[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11213. Cham: Springer, 2018: 20-35.

[29] WANG Z, HUANG X, YANG J, et al. Universal adversarial perturbation generated by attacking layer-wise relevance propagation[C]// Proceedings of the IEEE 10th International Conference on Intelligent Systems. Piscataway: IEEE, 2020: 431-436.

[30] HUAN Z, WANG Y, ZHANG X, et al. Data-free adversarial perturbations for practical black-box attack[C]// Proceedings of the 2020 Pacific-Asia Conference on Knowledge Discovery and Data Mining, LNCS 12085. Cham: Springer, 2020: 127-138.

[31] OSELEDETS I, KHRULKOV V. Art of singular vectors and universal adversarial perturbations[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 8562-8570.

[32] WU J, ZHOU M, LIU S, et al. Decision-based universal adversarial attack[EB/OL]. [2022-09-10].https://arxiv.org/pdf/2009.07024.pdf.

[33] 范纯龙,李彦达,夏秀峰,等.基于随机梯度上升和球面投影的通用对抗攻击方法[J].东北大学学报(自然科学版),2022,43(2): 168-175. (FAN C L, LI Y D, XIA X F, et al. A general adversarial attack method based on random gradient ascent and spherical projection[J]. Journal of Northeast University (Natural Science), 2022, 43(2): 168-175.)

[34] STORN R, PRICE K. Differential evolution — a simple and efficient heuristic for global optimization over continuous spaces[J]. Journal of Global Optimization, 1997, 11(4):341-359.

Universal perturbation generation method of neural network based on differential evolution

GAO Qianshun, FAN Chunlong*, LI Yanda, TENG Yiping

(,,110136,)

Aiming at the problem that the universal perturbation search in HGAA (Hyperspherical General Adversarial Attacks) algorithm is always limited to the spatial spherical surface, and it does not have the ability to search the space inside the sphere, a differential evolution algorithm based on hypersphere was proposed. In the algorithm, the search space was expanded to the interior of the sphere, and Differential Evolution (DE) algorithm was used to search the optimal sphere, so as to generate universal perturbations with higher fooling rate and lower modulus length on this sphere. Besides, the influence of key parameters such as the number of populations on the algorithm was analyzed, and the performance of the universal perturbations generated by the algorithm on different neural network models was tested. The algorithm was verified on CIFAR10 and SVHN image classification datasets, and the fooling rate of the algorithm was increased by up to 11.8 percentage points compared with that of HGAA algorithm. Experimental results show that this algorithm extends the universal perturbation search space of the HGAA algorithm, reduces the modulus length of universal perturbation, and improves the fooling rate of universal perturbations.

adversarial attack; universal perturbation; neural network; hypersphere attack; Differential Evolution (DE)algorithm

1001-9081(2023)11-3436-07

10.11772/j.issn.1001-9081.2022111733

2022⁃11⁃22;

2023⁃03⁃17;

国家自然科学基金资助项目(61902260); 辽宁省教育厅科学研究项目(JYT2020026)。

高乾顺(1997—),男,山东临沂人,硕士研究生,主要研究方向:深度学习、对抗攻击; 范纯龙(1973—),男,辽宁沈阳人,教授,博士,CCF会员,主要研究方向:神经网络可解释性、复杂网络分析、智能系统验证; 李炎达(1999—),男,辽宁沈阳人,硕士研究生,主要研究方向:深度学习、对抗攻击; 滕一平(1989—),男,辽宁沈阳人,副教授,博士,CCF会员,主要研究方向:隐私保护、深度学习。

TP391

A

2023⁃03⁃31。

This work is partially supported by National Natural Science Foundation of China (61902260), Scientific Research Project of Educational Department of Liaoning Province (JYT2020026).

GAO Qianshun, born in 1997, M. S. candidate. His research interests include deep learning, adversarial attack.

FAN Chunlong, born in 1973, Ph. D., professor. His research interests include neural network interpretability, complex network analysis, intelligent system verification.

LI Yanda, born in 1999, M. S. candidate. His research interests include deep learning, adversarial attack.

TENG Yiping, born in 1989, Ph. D., associate professor. His research interests include privacy protection, deep learning.