基于一致性图卷积模型的多模态对话情绪识别

2023-10-17谭晓聪郭军军线岩团相艳

谭晓聪 郭军军 线岩团 相艳

摘 要:多模态对话情绪识别是一项根据对话中话语的文本、语音、图像模态预测其情绪类别的任务。针对现有研究主要关注话语上下文的多模态特征提取和融合,而没有充分考虑每个说话人情绪特征利用的问题,提出一种基于一致性图卷积网络的多模态对话情绪识别模型。该模型首先构建了多模态特征学习和融合的图卷积网络,获得每条话语的上下文特征;在此基础上,以说话人在完整对话中的平均特征为一致性约束,使模型学习到更合理的话语特征,从而提高预测情绪类别的性能。在两个基准数据集IEMOCAP和MELD上与其他基线模型进行了比较,结果表明所提模型优于其他模型。此外,还通过消融实验验证了一致性约束和模型其他组成部分的有效性。

关键词:多模态;情绪识别;一致性约束;图卷积网络;情感分析

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2023)10-033-3100-07

doi:10.19734/j.issn.1001-3695.2023.02.0064

Consistency based graph convolution network for multimodal emotion recognition in conversation

Tan Xiaoconga,Guo Junjuna,b,Xian Yantuana,b,Xiang Yana,b

(a.Faculty of Information Engineering & Automation,b.Yunnan Key Laboratory of Artificial Intelligence,Kunming University of Science & Technology,Kunming 650500,China)

Abstract:Multimodal emotion recognition in conversations (MERC) is a task to predict the emotional category of the discourse in a dialogue based on its textual,audio,and visual modality.Existing studies focus on multimodal feature extraction and fusion of discourse context without fully considering the utilization of emotional features of different speakers.Therefore,this paper proposed a model of multimodal dialogue emotion recognition based on a consistent graph convolutional network.The model first constructed a graph convolutional network of multimodal feature learning and fusion,and obtained the context features of each discourse.On this basis,the average features of the speaker in the complete dialogue as the constraint to make the model learn more reasonable discourse features,so as to improve the performance of predicting emotion class.The paper compared with other baseline models on two benchmark datasets IEMOCAP and MELD.And the results show that the proposed model is superior to the other models.In addition,the paper verifies the consistency constraints and other components of the model through ablation experiments.

Key words:multimodal;emotion recognition;consistency constraint;graph convolution network;sentiment analysis

0 引言

隨着社交媒体的快速发展,对话中的多模态情绪识别(multimodal emotion recognition in conversation,MERC)受到学术界越来越多的关注,该任务旨在根据对话中话语的文本、语音、图像、模态信息预测其情绪类别。由于对话本身具有多种要素,多模态对话情绪识别需要综合考虑多种模态信息的提取和交互,以及对话中的上下文、说话人等信息的利用。在多模态信息的利用方面,研究者常常关注不同模态特征的表征和融合策略。例如Tsai等人[1]采用基于Transformer的框架对不同模态的特征进行抽取;文献[2,3]提出基于张量融合网络对不同的模态信息进行融合。在对话情绪识别(emotion recognition in conversation,ERC)方面,现有工作主要考虑对话中不同话语和模态表征的关系。例如文献[4,5]提出基于图卷积网络(graph convolution network,GCN)的模型,通过图卷积网络的节点特征传递和学习机制可以解决不同话语的长距离依赖和话语模态特征融合问题,协助完成情绪分类。但该模型对模态进行平等的融合,会产生一定的信息冗余。此外,与传统的独白演讲等情感识别不同,对话中个体的话语关系和语境建模有助于情绪识别。对话中的语境可归纳为历史话语、会话中的时间性或说话人相关信息等。Li等人[6]提出可以从说话人的音频信息中提取个性化信息。Hu等人[5]构建了一种说话人编码器来区分不同的说话人。然而,这些模型在上下文信息提取方面的处理成本较高,或者具有说话人特征学习的局限性。

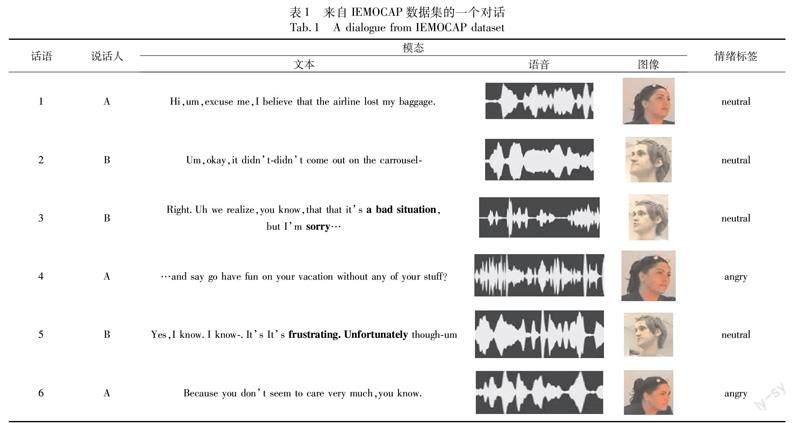

Wang等人[7]指出,对话中每个说话人具有自我依赖关系,即在情感惯性的影响下,说话人倾向于保持一种相对稳定的情绪状态。在表1所示的一段节选对话中有两个说话人,说话人B提出了一个针对说话人A丢失行李箱的补偿方案。虽然说话人B的话语中有“bad”“frustrating”等负面情感词,但他在整个谈话过程中基本保持中性的情绪。本文统计了两个多模态数据集中,说话人在对话中稳定情绪的比例(说话者稳定情绪比例的计算过程为:a)计算某段对话中说话者出现次数最多的情绪类别的话语数目,除以他在整个对话中总的话语数量;b)计算整个数据集中所有说话人所有对话中这个比例的平均值),数据集IEMOCAP[8]比值为68%,MELD[9]比值为72%。可以看出,在一段对话中,同一个说话人的情绪特征呈现一定的整体一致性,即同一个说话人的情绪特征在特征空间中应该具有一定的相似性。

基于以上分析可以看出,利用同一个说话人的情绪特征相似性作为指导将有助于情绪判别。现有研究虽然注意到说话人个性信息对于MERC的作用,但没有充分考虑说话人情绪特征的整体一致性。为此,本文提出了一种基于一致性的多模态图卷积网络(consistency based multimodal graph convolution network,CMGCN)模型。CMGCN根据两个话语是否属于同一对话,以及是否具有模态特征相似性来构建多关系图,采用图卷积网络对不同模态的信息进行信息传递和融合;同时,将话语情绪特征和对应说话人平均情绪特征的相似度作为一致性损失加入模型,以约束模型调整话语的特征学习;最后,利用调整后的情绪特征进行分类。通过大量的实验表明,CMGCN在两个公共数据集上优于基线模型,并且一致性有益于MERC。

1 相关工作

1.1 多模态情绪识别

在多模态情绪分析中,研究的重点是如何提取和融合不同的模态信息。非对齐多模态语言序列模型的多模态Transformer(multimodal transformer for unaligned multimodal language sequences model,MulT)[1]通过端到端方式处理数据对齐、跨模态元素之间的长期依赖关系。基于多模态Transformer的seq2seq模型(multi-modal seq2seq model,MMS2S)[10]使用三个单峰编码器来捕获文本、视觉和声学模态的单模态特性,并使用多头软模态注意来控制不同模态的贡献。张量融合网络(tensor fusion network,TFN)[3]通过矩阵运算来融合特征。对每个模态进行维数展开,然后用不同模态的张量笛卡尔积来计算不同模态之间的相关性。记忆融合网络(memory fusion network,MFN)[11]利用LSTM分别对模态内部进行建模,然后利用delta记忆注意网络和多视图门控记忆对不同模态之间的信息进行建模,可以保存多模态交互信息,得到更好的预测效果。

在模态信息融合方面,可以分为模型无关的融合方法和基于模型的融合方法[12]。其中模型无关的方法较简单但实用性低,可以分为早期融合(特征级融合[13])、晚期融合(决策级融合)、混合融合;其中基于模型的融合方法较多,例如宋云峰等人[14]利用跨模态注意力机制融合两两模态。深度特征融合模型(deep feature fusion-audio and text modality fusion,DFF-ATMF)[15]通过多特征向量和多模态注意机制融合语音模态和文本模态。层次特征融合网络(hierarchical feature fusion network,HFFN)[2]通过双向跳跃连接的LSTM直接连接局部交互,并整合了两层注意机制,以获得多模态的整体视图。此外,对话图卷积模型DialogueGCN[4]使用图卷积网络来获取远距离上下文信息;深度图卷积多模态融合模型(multimodal fusion via deep graph convolution,MMGCN)[5]同样构造了一个图网络来建模不同的模态数据。利用图卷积网络的拓扑结构和节点信息传输的特征,可以很好地解决长距离依赖性和模态融合问题。

1.2 对话情绪识别

随着ERC的应用越来越广泛,出现了较多基于對话形式的情绪识别模型,包括会话记忆网络(conversational memory network,CMN)模型[16]、交互式对话记忆网络(interactive conversational memory network,ICON)模型[17]、对话循环神经网络模型DialogueRNN[18]、以及基于常识知识的对话情绪识别(commonsense knowledge for emotion identification in conversations,COSMIC)模型[19]等。这些方法的主要思路是在文本模态情境下对上下文对话信息进行建模。

研究人员指出,不同说话人的话语应该被区别对待。会话记忆网络CMN[16]通过注意机制对每个说话人的历史话语和当前话语的表征进行整合,进行话语情感分类,从而模拟了说话人个体的状态以及不同说话人状态对当前话语的影响。与CMN类似,交互式会话记忆网络ICON[17]利用两个依赖于说话人的GRU和一个全局GRU来跟踪整个对话过程中情绪状态的变化,并利用一个多层记忆网络来模拟全局情绪状态。DialogueRNN[18]则通过一个具有注意机制的RNN来模拟说话人之间的情绪影响,并使用三个GRU来分别捕获说话人之前的话语信息、上下文和情感信息。此外,深度图卷积多模态融合模型MMGCN[5]增加了说话人身份嵌入,在一定程度上增强了情感表征,但这种嵌入只能区分不同的说话人,而不能区分同一说话人的不同话语之间的关系。

1.3 图卷积网络

图卷积网络由于其具有处理非欧几里德数据的能力,在过去的几年中得到了广泛应用。主流GCN方法可分为谱域法和非谱域法[20]。谱域GCN方法[21]是基于拉普拉斯谱分解理论,只能处理无向图。非谱域GCN方法[22]可以应用于有向图和无向图,但消耗更大的计算资源。近来研究人员提出了在不过度平滑的情况下加深谱域GCN的方法[23]。GCN在MERC任务上也有所应用,例如MMGCN模型使用具有深层的谱域GCN对多模态图进行编码,取得了较好的结果。但是该模型在对上下文进行建模时,仅考虑相同模态下相同对话、不同模态下相同话语的关系,而忽略了相同模态下不同对话、不同模态下不同话语之间的关系。

根据上述分析可以看出,多模态情绪识别侧重于不同模态特征的提取与模态特征融合,而对话情绪识别需要考虑话语上下文的信息。因此,本文模型同时考虑了不同模态特征的学习和交互,以及话语上下文特征的提取,以更好地完成MERC任务。

2 本文模型

2.1 问题定义

给定多模态对话数据集,每个数据集中有若干个对话(dialogue),每个对话包含若干个话语(utterance),则整个数据集有N个话语,每个话语均有语音(a)、文本(t)、图像(v)三种模态信息。ERC的任务是识别出第i个话语ui的情绪类别标签i。

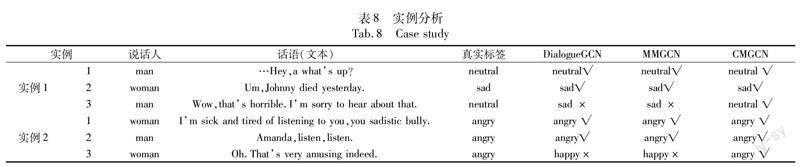

2.2 模型整体结构

本文模型分为三个主要模块,图1所示为模型的总体框架。

a)基于图的特征学习模块。在这个模块中,将数据集中的所有话语作为节点,并根据节点之间的不同关系构建图邻接矩阵,使用图卷积机制来传递每个节点的单模态特征,以对上下文依赖关系进行编码。将一个节点的三个单模态特征相结合,得到其综合的特征。

b)说话人一致性约束模块。在该模块中,计算对话中属于同一说话人的话语的平均特征,令属于说话人的每个话语的特征在特征空间中尽可能接近平均特征。

c)情绪分类模块。在该模块中,利用每个话语的特征来获得情绪类别预测结果。

2.3 图节点的初始特征

对于某个话语节点ui,分别提取其语音、文本、图像三种模态的初始节点特征。对于语音模态,本文使用带有IS10配置的OpenSmile工具包[24]对原始语音数据进行特征提取,再经过全连接网络进行编码得到初始的音频特征向量xa(0)i∈Euclid Math TwoRApd0;对文本模态,采用RoBERTa模型进行提取特征,然后应用BiLSTM对文本中的上下文信息进行编码,得到初始的文本特征向量xt(0)i∈Euclid Math TwoRApd0;对图像模态,采用DenseNet提取人物的面部表情特征,再经过全连接网络进行编码得到初始图像特征向量xv(0)i∈Euclid Math TwoRApd0;这三个初始特征包含了一个话语的内部信息。对于有N个话语的数据集,有初始特征矩阵Χa(0),Χv(0),Χt(0)∈Euclid Math TwoRApN×d0。

2.4 基于图的特征学习

将数据集中每个话语作为一个图节点,构建图G=(υ,ε),其中υ(|υ|=N)表示话语节点,ευ×υ是节点之间的边。

2.4.1 图邻接矩阵的构建

两个节点可以通过不同的边来连接,代表三个模态特征的多重关系。本文根据以下情况计算节点ui、uj之间边的权重:

a)考虑两个节点之间同种模态的特征传递。由于两个节点的同一模态特征在同一个语义空间下,所以无论节点是否来自于同一对话,都可以进行特征传递。两个节点之间边的权重用角相似度衡量。

其中:sim(·)是余弦相似度函数;xmod(0)i,xmod(0)j∈Euclid Math TwoRApd0分别表示第i和j个话语某种相同模态的初始特征,mod{a,t,v}。

b)考虑两个节点之间不同模态的特征传递,可以根据两个节点是否来自于一个对话,分为两种情况:

(a)如果两个节点来自于不同的对话,则不同模态特征不进行传递,这种情况下边的权重为0。这是因为三种模态的初始特征抽取过程中虽然都进行了线性变换,不同模态特征在语义空间中可以认为基本对齐,但不同对话的场景和对话内容差异较大,加大了不同模态之間的鸿沟,因此本文认为这种情况下不应该进行特征传递。

(b)如果两个节点来自于相同的对话,则由于对话的主题和内容一致,不同模态特征也是具有相关性的,需要进行特征传递。两个节点之间边的权重同样用角相似度衡量:

其中:xmod′(0)i,xmod″(0)j∈Euclid Math TwoRApd0分别表示第i和j个话语不同模态的初始特征;mod′,mod″{a,t,v},mod′≠mod″。

根据上述节点之间边的权重计算方法构建邻接矩阵。对于某个节点的某种模态特征,可以构建三种邻接矩阵来进行特征传递和学习。以节点的语音模态a的特征学习为例,如图2所示,分别考虑语音模态a与自身语音模态a、文本模态t和图像模态v的关系,可以构建三种图邻接矩阵,始特征矩阵Χa(0)进行更新。

此外,对于节点的文本模态t的特征学习,构建了三种图邻接矩阵Αtt、Αta、Αtv;对于节点的图像模态v的特征学习,构建了三种图邻接矩阵Αvv、Αva、Αvt。

2.4.2 图节点特征的学习

本文以节点的语音模态a的特征学习为例,说明不同模态的特征学习过程。如图2所示,将三种图邻接矩阵Aaa、Aat、Aav,分别与节点的初始语音特征Xa(0)进行多层的GCN卷积,这里使用四层的GCN进行编码,得到更新后的三种语音特征Xaa(l)、Xat(l)、Xav(l)。具体过程为

2.5 说话人一致性约束

3 实验与分析

3.1 数据集

在IEMOCAP[8]和MELD[9]两个多模态对话数据集进行了实验,两个数据集都包含文本、图像、音频三种模态。如表2所示,本文将数据集大致以8:1:1的比例分为训练集、验证集与测试集。

a)IEMOCAP。该数据集包含12 h的二元对话视频,每个视频都包含一个的二元对话,共有7 433条话语和151个对话。对话中的每一条话语都有六个类别的情感标签,包括快乐、悲伤、中性、愤怒、兴奋和沮丧。

b)MELD。该数据集同样是一个多模态对话数据集,但MELD是一个多元的对话数据集。MELD包含了《老友记》电视剧中1 400多个对话和13 000条话语的文本、语音和图像信息。每个对话中的每一个话语都被标注为愤怒、厌恶、悲伤、快乐、惊讶、恐惧或中性七个情绪类别之一。

3.2 实验设置

本文所有实验在CPU为Intel I9-10900K,显卡为NVIDIA GeForce GTX 3090的实验环境中进行,深度学习框架为PyTorch。本文将初始特征维度d0设置为200,d1设置为100。通过实验比较,将GCN层数设置为4,dropout率设置为0.32。batchsize设置为58,epoch设置为120。使用Adam优化器[25]优化模型参数,学习率设置为0.000 221。超参数α和η分别设置为0.1和0.5;λ1设置为0.000 03,λ2设置为0.01。

3.3 基模型

为了验证模型的有效性,本文模型与以下基线模型进行了比较。其中文本模态的初始特征采用GloVe和RoBERTa两种。

a)DialogueRNN-{GloVe,RoBERTa}[18]。该模型使用了三个GRU来对说话者、来自前面话语的上下文和前面话语的情绪进行建模,三种不同类型的GRU都是以递归的方式连接的。

b)DialogueGCN-{GloVe,RoBERTa}[4]。该模型通过构建图卷积网络对会话进行建模,通过图网络解决了基于RNN的方法中存在的上下文传播问题。

c)MMGCN-{GloVe,RoBERTa}[5]。该模型提出了一种多模态的图卷积神经网络,将对话中一句话对应三个模态的特征和说话嵌入分别进行拼接来构建多模态图,之后通过多层GCN来进行编码,最后拼接GCN编码后的特征和图的节点初始化特征,送入一个全连接层,完成情感分类。

d)COSMIC[19]。该模型以常识知识为基础来进行建模,从而解决对话中话语级别的情感识别问题,其中常识要素包括心理状态、事件、因果关系等。模型由三部分组成:从预训练的Transformer语言模型中提取独立于上下文的特征;从常识知识图中提取常识特征;整合常识知识以设计更好的上下文表示并将其用于最终的情感分类。

e)TUCORE-GCN[26]。该模型提出将对话中的情绪识别视为基于对话的关系提取任务,即提取对话中出现的两个参数之间的关系。通过构建对话图并应用GCN机制结合BiLSTM,结合先前节点信息来预测结果。

4 实验与讨论

4.1 与基模型的比较

本文模型与其他基模型的实验结果如表3所示。可以看出,本文模型在IEMOCAP和MELD数据集上都优于其他模型。對于IEMOCAP数据集,在本文模型结合GloVe预训练向量的条件下,micro-F1达到67.32%,比性能第二的MMGCN提高了1.1%。本文模型结合RoBERTa的micro-F1达到67.92%,比性能第二的MMGCN-RoBERTa增加了0.66%。对于MELD数据集,在GloVe与RoBERTa预处理模型下本文模型的micro-F1分别比性能次优的模型提高了0.74%、0.44%。

本文进一步比较了不同模型的表现。DialogueGCN-{GloVe,RoBERTa}比DialogueRNN-{GloVe,RoBERTa}有更好的性能。分析原因是,DialogueRNN-{GloVe,RoBERTa}只对单个话语序列进行特征学习,而DialogueGCN-{GloVe,RoBERTa}使用GCN框架获取每个话语的上下文信息,从而提高了性能。MMGCN-{GloVe,RoBERTa}在DialogueGCN-{GloVe,RoBERTa}上引入了不同的模态特性,进一步改善了模型。此外,在模型中使用RoBERTa的文本初始向量比GloVe更有效。在使用RoBERTa后,DialogueRNN、DialogueGCN和其他模型的micro-F1在IEMOCAP数据集上增加了约2%,在MELD数据集上增加了约7%。

4.2 一致性约束的实验分析

4.2.1 约束条件的消融分析

为了研究CMGCN中一致性约束的贡献,将模型中的一致性损失去掉,即只用分类损失来指导模型进行参数优化。消融结果如表4所示。

可以看出,一致性约束对于模型性能的影响较大。在去除一致性约束后,模型在两个数据集的性能分别下降了近1%。这证明了一致性约束对于MERC作用较大。本文模型在一致性约束下能更好地捕捉每个说话人的情绪状态,提升模型预测每条话语情绪的能力。

4.2.2 一致性约束中的特征分析

本文进一步分析了使用不同特征计算一致性约束损失对模型的影响。CMGCN使用的是GCN学习更新的特征向量来计算一致性约束损失。而CMGCNitl则使用三个模态的初始特征向量拼接来计算一致性约束损失。表5展示了实验结果,与CMGCNitl相比,CMGCN的micro-F1在两个数据集上分别提高了1.38%和1.49%。分析原因可能是,经过图卷积学习后的节点特征具有更强的表征能力,模型使用这些节点特征作为一致性约束能获得更好的情绪分类。

4.3 鄰接矩阵的消融分析

为了证明CMGCN中邻接矩阵的合理性,本文使用以下方法来计算边权重,构造新的邻接矩阵来进行比较:

a)CMGCNadj_A。在该模型的邻接矩阵Aaa、Att、Avv中,如果两个节点来自不同的对话,则将它们的边权重置为0。其他邻接矩阵的构建方式保持不变。

b)CMGCNadj_B。对于邻接矩阵Amod′mod″,mod′≠mod″,即使两个节点来自不同的对话,也使用角相似度来计算边的权重。

本文在两个数据集上用新的邻接矩阵来测试模型的性能,比较结果如表6所示。与CMGCNadj_A相比,本文模型的micro-F1得分在两个数据集上分别增加了1.11%和1.52%。结果表明,即使两个话语来自不同的对话,它们相同的模态之间也会存在相关性。因此,在这些节点之间传输相同的模态特征是有益的。同时,CMGCNadj_B的micro-F1比CMGCN分别降低了1.07%和2.22%。原因可能是:如果两个节点来自不同的对话,它们不同的模态之间存在语义差距,这种情况下不应该进行特征传递,否则过度的模态特征传播会干扰节点的特征学习。

4.4 不同模态设置对比

为了验证多种模态组合下的实验结果,本文做了单一模态与任意两种模态组合设置下的实验,结果如表7所示。对基于单一模态的情绪识别模型而言,选择某一种模态的初始特征进行DeepGCN特征学习,并用更新后的单一模态特征进行情绪预测;对基于两种模态的情绪识别模型而言,选择其中两种模态的初始特征构建邻接矩阵,从而对两种模态特征进行特征学习。

从表7的结果可以看出,当同时使用三种模态进行情绪预测时,能获得最优的性能,证明了多模态设置的优越性。在单一模态下,图像模态表现最差,原因可能是图像模态中的手势动作或者脸部表情并不能很好地表征当前话语的情绪状态;相较于视觉模态,语音语调的特征提取更能表征情绪状态,所以性能优于基于单一图像模态的模型;三种单一模态中,文本模态表现最好,而在文本模态基础上添加语音和图像模态后,可以比单一的文本模态带来额外的性能改进。

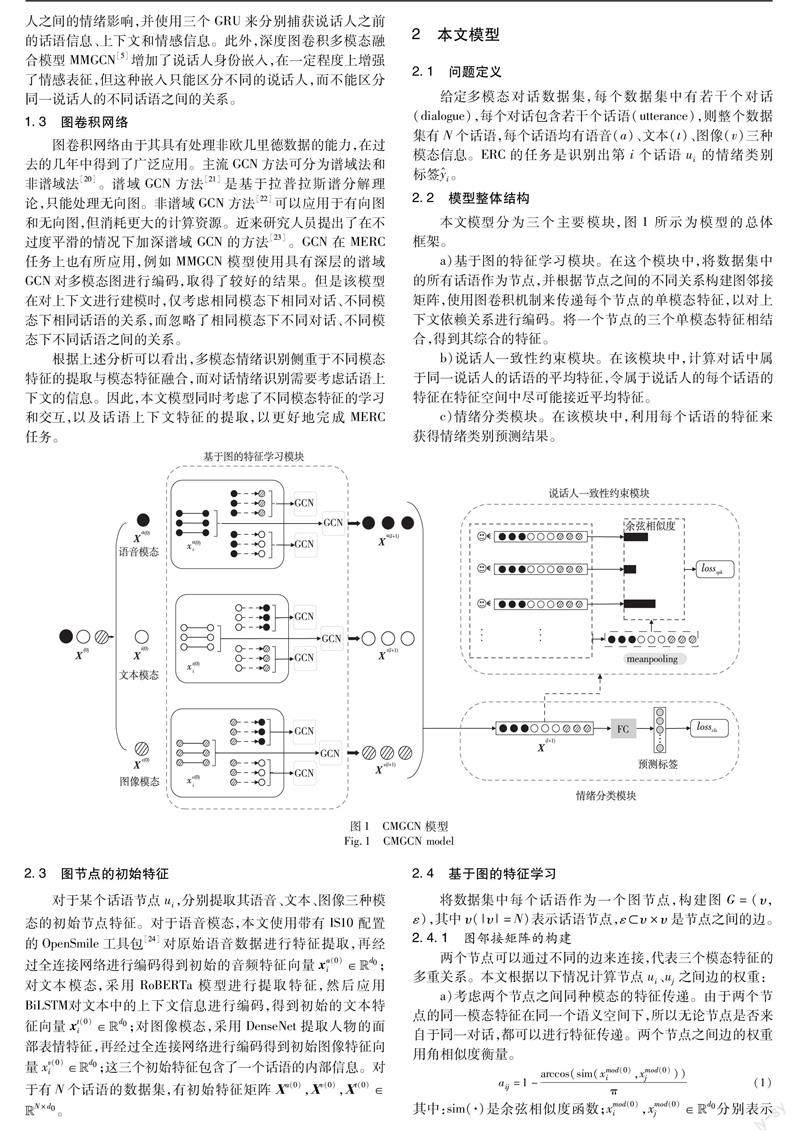

4.5 实例分析

本文对IEMOCAP数据集中两个不同对话进行了实例分析,如表8所示,其中“√”表示分类正确,“×”表示分类错误。DialogueGCN和MMGCN错误地将实例1的第3句话预测为“sad”的情绪类别,原因可能是该话语中含有负向的情绪词。同样地,由于受到“amusing”一词的干扰,DialogueGCN和MMGCN未能正确预测实例2的第3句话语的“angry”情绪。由于本文方法能够感知多模态的语境信息和说话者的整体一致性,从而能正确捕捉到潜在的情绪类别。

5 结束语

本文提出了一种基于一致性约束的MERC图卷积网络,该网络将话语作为图网络的节点,通过GCN的特征传递和交互机制使模型能学习到话语的不同模态上下文特征;同时,利用说话人一致性约束引导模型学习到更符合对话情感逻辑的话语情绪特征,从而提高识别准确性。实验结果表明,本文模型在公共数据集上的性能优于其他对比模型。通过消融实验验证了一致性约束的有效性和重要性。本文方法皆在模态信息完整的情况下进行,未来工作将对模态信息受损下的模态模糊问题的鲁棒性融合问题进行探讨。

参考文献:

[1]Tsai Y H H,Bai Shaojie,Liang P P,et al.Multimodal transformer for unaligned multimodal language sequences[EB/OL].(2019-06-01).https://arxiv.org/abs/1906.00295.

[2]Mai Sijie,Hu Haifeng,Xing Songlong.Divide,conquer and combine:hierarchical feature fusion network with local and global perspectives for multimodal affective computing[C]//Proc of the 57th Annual Meeting of Association for Computational Linguistics.2019:481-492.

[3]Zadeh A,Chen Minghai,Poria S,et al.Tensor fusion network for multimodal sentiment analysis [EB/OL].(2017).https://arxiv.org/abs/1707.07250.

[4]Ghosal D,Majumder N,Poria S,et al.DialogueGCN:a graph convolutional neural network for emotion recognition in conversation[EB/OL].(2019).https://arxiv.org/abs/1908.11540.

[5]Hu Jingwen,Liu Yuchen,Zhao Jinming,et al.MMGCN:multimodal fusion via deep graph convolution network for emotion recognition in conversation[EB/OL].(2021-07-14).https://arxiv.org/abs/ 2107.06779.

[6]Li Jiwei,Galley M,Brockett C,et al.A persona-based neural conversation model[EB/OL].(2016).https://arxiv.org/abs/ 1603.06155.

[7]Wang Yan,Zhang Jiayu,Ma Jun,et al.Contextualized emotion recognition in conversation as sequence tagging [C]// Proc of the 21st Annual Meeting of the Special Interest Group on Iscourse and Dialogue.2020:186-195.

[8]Busso C,Bulut M,Lee C C,et al.IEMOCAP:interactive emotional dyadic motion capture database [J].Language Resources and Evaluation,2008,42(4):335-359.

[9]Poria S,Hazarika D,Majumder N,et al.MELD:a multimodal multi-party dataset for emotion recognition in conversations [EB/OL].(2018).https://arxiv.org/abs/1810.02508.

[10]Zhang Dong,Ju Xingchen,Li Junhui,et al.Multi-modal multi-label emotion detection with modality and label dependence[C]//Proc of Conference on Empirical Methods in Natural Language Processing.2020:3584-3593.

[11]Zadeh A,Liang P P,Mazumder N,et al.Memory fusion network for multi-view sequential learning[C]//Proc of the 32nd AAAI Confe-rence on Artificial Intelligence.2018:5634-5641.

[12]任澤裕,王振超,柯尊旺,等.多模态数据融合综述 [J].计算机工程与应用,2021,57(18):49-64.(Ren Zeyu,Wang Zhenchao,Ke Zunwang,et al.Review of multimodal data fusion[J].Computer Engineering and Applications,2021,57(18):49-64.)

[13]刘继明,张培翔,刘颖,等.多模态的情感分析技术综述 [J].计算机科学与探索,2021,15(7):1165-1182.(Liu Jiming,Zhang Pei-xiang,Liu Ying, et al.Review of multimodal sentiment analysis techniques[J].Journal of Frontiers of Computer Science & Techno-logy,2021,15(7):1165-1182.)

[14]宋云峰,任鸽,杨勇,等.基于注意力的多层次混合融合的多任务多模态情感分析 [J].计算机应用研究,2022,39(3):716-720.(Song Yunfeng,Ren Ge,Yang Yong,et al.Multi-task multimodal sentiment analysis based on multi-level mixed fusion based on attention[J].Application Research of Computers,2022,39(3):716-720.)

[15]Chen Feiyang,Luo Ziqian,Xu Yanyan,et al.Complementary fusion of multi-features and multi-modalities in sentiment analysis[EB/OL].(2019).https://arxiv.org/abs/1904.08138.

[16]Hazarika D,Poria S,Zadeh A,et al.Conversational memory network for emotion recognition in dyadic dialogue videos[C]//Proc of Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies.2018:2122-2132.

[17]Hazarika D,Poria S,Mihalcea R,et al.ICON:interactive conversational memory network for multimodal emotion detection[C]//Proc of Conference on Empirical Methods in Natural Language Processing.2018:2594-2604.

[18]Majumder N,Poria S,Hazarika D,et al.DialogueRNN:an attentive RNN for emotion detection in conversations[C]//Proc of AAAI Confe-rence on Artificial Intelligence.2019:6818-6825.

[19]Ghosal D,Majumder N,Gelbukh A,et al.COSMIC:commonsense knowledge for emotion identification in conversations [EB/OL].(2020).https://arxiv.org/abs/2010.02795.

[20]Velic′kovic′ P,Cucurull G,Casanova A,et al.Graph attention networks [EB/OL].(2017).https://arxiv.org/abs/ 1710.10903.

[21]Zhang Dong,Wu Liangqing,Sun Changlong,et al.Modeling both context-and speaker-sensitive dependence for emotion detection in multi-speaker conversations[C]//Proc of the 28th International Joint Conference on Artificial Intelligence.2019:5415-5421.

[22]Schlichtkrull M,Kipf T N,Bloem P,et al.Modeling relational data with graph convolutional networks [C]//Proc of European Semantic Web Conference.Cham:Springer,2018:593-607.

[23]Li Guohao,Muller M,Thabet A,et al.DeepGCNs:can GCNs go as deep as CNNs? [C]//Proc of IEEE/CVF International Conference on Computer Vision.2019:9267-9276.

[24]Schuller B,Batliner A,Steidl S,et al.Recognising realistic emotions and affect in speech:state of the art and lessons learnt from the first challenge[J].Speech Communication,2011,53(9-10):1062-1087.

[25]Kingma D P,Ba J.Adam:a method for stochastic optimization[EB/OL].(2014).https://arxiv.org/abs/ 1412.6980.

[26]Lee B,Choi Y S.Graph based network with contextualized representations of turns in dialogue[EB/OL].(2021).https://arxiv.org/abs/ 2109.04008.

[27]Li Yujia,Tarlow D,Brockschmidt M,et al.Gated graph sequence neural networks[EB/OL].(2015).https://arxiv.org/abs/1511.05493.

[28]Chen Ming,Wei Zhewei,Huang Zengfeng,et al.Simple and deep graph convolutional networks [C]//Proc of International Conference on Machine Learning.2020:1725-1735.

收稿日期:2023-02-14;修回日期:2023-04-19基金項目:国家自然科学基金地区项目(62162037);云南省科技厅面上项目(202001AT070047,202001AT070046)

作者简介:谭晓聪(1998-),男,广东茂名人,硕士研究生,主要研究方向为自然语言处理、多模态情感分析;郭军军(1987-),男,山西吕梁人,副教授,博士,CCF会员,主要研究方向为自然语言处理、神经机器翻译、多模态情感分析;线岩团(1981-),男,云南芒市人,副教授,博士,CCF会员,主要研究方向为自然语言处理、信息检索;相艳(1979-),女(通信作者),云南大理人,副教授,博士,CCF会员,主要研究方向为自然语言处理、情感计算(sharonxiang@126.com).