稀疏约束的时空正则相关滤波无人机视觉跟踪

2023-02-21田昊东张津浦王岳环

田昊东,张津浦,王岳环, 2*

1. 华中科技大学人工智能与自动化学院,武汉 430074; 2. 多谱信息处理技术国家级重点实验室,武汉 430074

0 引 言

随着无人机(unmanned aerial vehicle,UAV)技术的迅猛发展,以无人机为平台的目标识别与跟踪逐渐成为计算机视觉领域的研究热点(王瑶,2019)。配备了视觉跟踪技术的无人机平台,具有运动灵活、安全性高、体积小和成本低等特点,在导航制导、环境探测和灾难应急等领域得到广泛应用。无人机跟踪任务通常需要持续定位某个特定目标,鲁棒性和实时性是跟踪算法的必然要求。由于无人机应用场景的复杂性和机载平台计算资源的限制,实现准确、稳定和高效的目标跟踪仍是一项具有挑战性的任务。与一般的地面跟踪任务(如视频监控)相比,无人机平台下的目标跟踪任务面临更严峻的挑战(Fu等,2022),主要表现在以下方面:1)快速运动。无人机运动灵活、机动性高,机载相机与待跟踪目标之间容易发生剧烈相对运动,对算法快速捕获目标的能力提出了更高要求。同时相机与目标之间的剧烈运动容易导致成像模糊,给跟踪算法的精确定位带来更大挑战。2)视角变化。某些特定应用场景中,无人机可能环绕目标飞行,机载相机从不同角度捕捉目标的成像姿态,例如车辆的正面和侧面,此时目标外观成像会发生快速变化,若跟踪器无法及时在线学习并更新模型则会导致跟踪失败。3)视觉遮挡。无人机跟踪场景中,目标可能被树木、房屋等外界干扰物部分或完全遮挡,目标特征将被遮挡物污染,容易导致跟踪漂移。4)计算资源稀缺。由于机身体积小,可搭载资源有限,许多无人机仍使用CPU作为处理平台,计算能力受限。如何设计跟踪算法,使其在具有较高精度和鲁棒性的前提下,提高计算效率,满足实时性要求,仍面临很大困难。由于以上因素,高效和鲁棒的视觉跟踪算法对于无人机跟踪任务的广泛应用至关重要。

随着卷积神经网络(convolutional neural networks,CNN)的发展,将CNN应用于目标跟踪成为研究热点。这类方法通常使用大量离线标记的图像训练用于目标跟踪的CNN。基于CNN的跟踪器具有很高的跟踪精度,但由于网络中卷积运算的高度复杂性,通常在高性能GPU上运行,在无人机平台上难以支持;此外,CNN的离线训练需要海量带标签的预处理图像,这些训练数据的获取需要耗费大量精力;同时,深度网络很容易受到各种噪声的干扰从而降低性能(Yan等,2020)。因此,基于CNN的方法在无人机视觉跟踪领域并非理想的选择。

基于判别式相关滤波(discriminative correlation filter,DCF)的跟踪器具有高速和准确的特点,是无人机视觉跟踪的合适选择。DCF类跟踪算法最主要的亮点是通过离散傅里叶变换将空间域中循环相关或卷积的复杂计算转换为频域中的元素点乘运算(Bolme等,2010),这种策略极大提高了DCF类跟踪算法的运行速度,大多数DCF类跟踪算法在单个CPU上的速度达到30帧/s以上,能够满足无人机的实时性要求。

研究人员针对DCF类跟踪算法存在的各种问题提出了相应的解决方案,并取得越来越好的结果。针对尺度变化问题,Danelljan等人(2014a)提出判别式尺度空间(discriminative scale space tracker,DSST)算法,采用位置滤波器和尺度滤波器分别进行目标定位与尺度估计,提高模型的尺度自适应能力。针对边界效应问题,Danelljan等人(2015)提出空间正则相关滤波算法(spatially regularized discriminative correlation filters,SRDCF),使用bowl-shaped结构的空间正则化约束替代传统相关滤波中的常数型L2约束,越靠近中心目标位置,惩罚权重越小,反之权重越大,使学习到的滤波器集中在中心区域,同时扩大背景感知区域,提高了跟踪精度。Li等人(2018)提出空间—时间正则相关滤波算法(spatial-temporal regularized correlation filter,STRCF),在SRDCF的目标函数基础上加入时间正则项,抑制相邻两帧之间的滤波器畸变,提高了模型的鲁棒性。针对特征融合问题,Wang等人(2018)提出多线索相关滤波跟踪算法(multi-cue correlation filter based tracker,MCCT),以HOG(histogram of oriented gradient)特征(Dalal和Triggs,2005)、CN(color name)特征(Danelljan等,2014b)以及CNN特征为出发点,采用多专家方式对3种特征的所有组合进行打分,在每帧中选择当前最优的特征组合。针对目标外观突变问题,Zheng等人(2021)提出自适应混合标签的突变感知相关滤波算法(mutation sensitive correlation filter,MSCF),通过一种突变感知因子动态校正训练标签,在外观突变时表现出更好的适应性。

鲁棒视觉跟踪的另一个关键是特征表达的有效性和可靠性。现有的DCF类算法通常使用样本区域的所有特征训练滤波器,然而在复杂场景中,某些特征可能会分散注意力,例如目标区域发生遮挡以及形变时,这些干扰因素产生的异常特征会污染模型,降低滤波器的可靠性(Sui等,2018)。

本文的主要工作与贡献如下:1)提出一种稀疏约束的相关滤波跟踪算法。通过在目标函数上施加空间弹性网络约束,实现像素级别的特征选择,抑制跟踪过程中的干扰因素。同时,目标函数中集成STRCF的时间正则项,提高了模型抑制畸变的能力。最后采用交替方向乘子法(alternating direction method of multipliers,ADMM)(Boyd等,2011)求解模型。2)提出一种DCF框架下通用的加速策略。根据当前帧的目标位移量,对检测定位阶段的特征矩阵进行等距离循环移位,并将其作为在线学习阶段所需要的特征矩阵,使每帧省去一次在线学习阶段的特征提取操作。消融实验表明,该加速策略在不显著影响跟踪精度的前提下,将跟踪速度提高了约25%。3)在UAV123_10 fps、DTB70(drone tracking benchmark)和UAVDT(unmanned aerial vehicle benchmark: object detection and tracking)3个UAV数据集上与14种主流算法进行对比实验。结果表明,本文算法相比基线STRCF,在精确率和成功率上都有显著提高,且优于大多数现有方法,单个CPU上的跟踪速度为50帧/s。

1 相关工作

1.1 空间—时间正则相关滤波

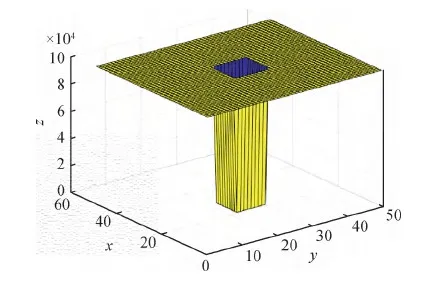

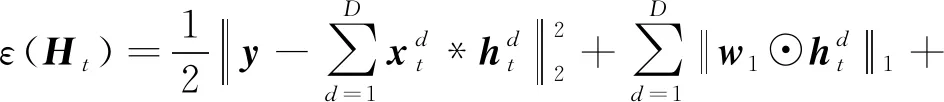

Li等人(2018)提出空间—时间正则相关滤波(STRCF),在SRDCF的基础上加入时间正则项,抑制相邻两帧的滤波器畸变,防止模型退化。通过求解目标函数,在线学习第t帧的最优滤波器Ht。该目标函数为

(1)

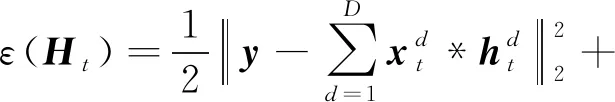

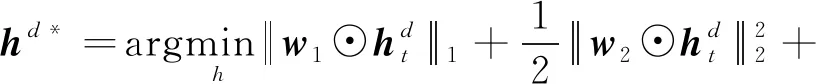

图1 空间正则化权重

空间正则项可以有效缓解传统DCF存在的边界效应问题,提高模型的背景感知能力;时间正则项可以适应较大的外观变化,防止滤波器退化。尽管STRCF取得了出色的性能,但其仍然存在局限性,具体表现为:使用样本区域的所有特征训练滤波器,使得在复杂的跟踪场景中,由遮挡或形变产生的某些干扰特征会分散模型注意力,使用这些干扰特征训练出的滤波器会大幅降低模型的鲁棒性。

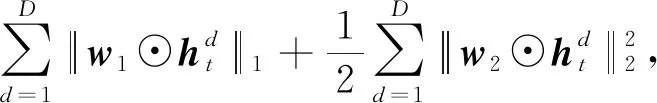

1.2 弹性网络模型

弹性网络是一种使用L1和L2先验作为正则项的线性回归模型(Zou和Hastie,2005),其目标函数为

(2)

弹性网络模型包含Lasso回归和岭回归约束项,Lasso回归筛选出相关的特征,并缩减其他无关特征;同时岭回归缩减所有相关性的特征。通过二者的结合,训练的模型像Lasso回归一样稀疏,但同时具有岭回归的正则化能力。

弹性网络模型的L1和L2正则化权重均为常数,限制了整个样本区域中模型的稀疏性。但是在DCF跟踪框架中,样本区域就是搜索区域,同时包含了目标以及周围的背景(Peng和Lu,2021)。跟踪过程中的干扰因素通常来自目标区域,例如局部遮挡和目标形变,显然应当更加关注目标区域而非整个样本区域的稀疏性。这意味着式(2)的弹性网络约束并不能直接适用于相关滤波的目标函数。

2 本文算法

2.1 跟踪模型

结合STRCF和弹性网络模型的特点,本文构造了稀疏约束的时空正则相关滤波目标函数,定义为

(3)

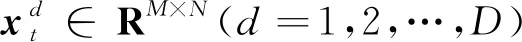

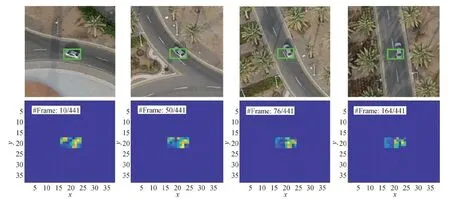

图2为选自UAV123(Mueller等,2016)中的Car4遮挡序列,包含车辆从进入到离开遮挡的完整过程。针对遮挡问题,一个有效的方法是在目标区域进行自适应特征选择。在图2中,数值小为冷色,数值大为暖色。由于bowl-shaped空间正则化的引入,滤波器的非0系数集中在样本中心的目标区域,有助于强调目标区域内的特征信息。图2(a)为无遮挡,目标区域的滤波器系数分布正常;图2(b)为目标顶部遮挡,顶部区域的滤波器系数明显降低,从而削弱遮挡物对模型的干扰;图2(c)为目标底部遮挡,底部区域的滤波器系数明显降低;图2(d)为目标驶出遮挡,整个目标区域的滤波器系数恢复到正常水平。图2表明,本文算法面对遮挡时具有良好的特征选择能力,可一定程度地抑制遮挡物对模型的污染。

图2 各种遮挡情况下滤波器的系数分布可视化

图3显示了车辆形变时滤波器的系数分布。初始时,跟踪框内仅包含目标,此时滤波器的系数分布较为均匀。随着车辆转弯,由于跟踪框的纵横比固定,跟踪框内不可避免地包含部分背景,但是在弹性网络约束下,跟踪框内背景区域的滤波器系数明显减小,目标区域的滤波器系数保持正常水平,滤波器始终具有较好的目标判别能力。

图3 车辆形变时滤波器的系数分布可视化

综上,在目标发生遮挡或形变时,弹性网络约束可以限制干扰区域的滤波器稀疏性,从而削弱该区域的干扰特征对模型的污染,实现像素级别的特征选择,提高模型的鲁棒性。

2.2 优化方法

(4)

对于最小化式(4),可以通过ADMM迭代求解。式(4)的增广拉格朗日形式为

(5)

(6)

(7)

(8)

(9)

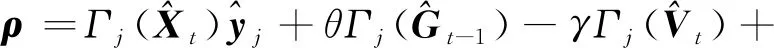

式中,向量ρ的形式为

(10)

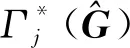

(11)

(12)

(13)

式中,W2=diag(w2)∈RT×T表示对角矩阵。η是软阈值操作,定义为

η(x,λ)=sign(x)max(|x|-λ,0)

(14)

3)拉格朗日乘子更新。求解出以上两个子问题后,更新拉格朗日乘子,具体为

(15)

式中,i和i+1表示迭代次数。

正则化步长γ(初始值为1)更新式为

γi+1=min(γmax,βγi)

(16)

式中,β=10,γmax=10 000。

2.3 目标定位方法

(17)

针对尺度估计问题,借用fDSST(fast DSST)(Danelljan等,2017a)的方法,在原有位置滤波器的基础上,增加一个尺度滤波器。通过位置滤波器确定目标中心位置后,在相同的中心位置上,提取多个尺度等级的样本用于训练尺度滤波器,根据尺度滤波器计算尺度相关得分的最大值,从而确定当前帧的最优尺度。

2.4 加速策略

本文提出一种DCF框架通用的加速策略,通过对检测定位阶段的样本特征矩阵进行循环移位,并将其作为训练阶段的样本特征矩阵,可节省一次特征提取操作,大幅度提高跟踪速度。

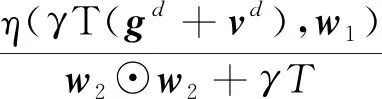

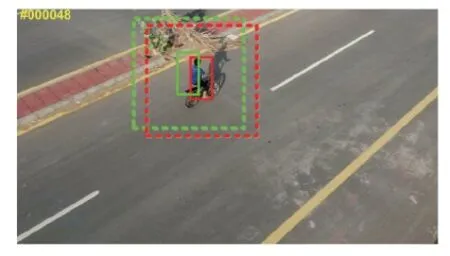

在DCF类跟踪框架中,每一帧的处理流程可分为检测定位与在线学习两个阶段。其中,检测定位阶段旨在以上一帧的目标位置post-1为中心,提取检测定位样本(图4虚线绿框)的特征矩阵,与滤波器相关计算得到当前帧的目标位置post;在线学习阶段旨在以计算出的新目标位置post为中心,提取在线学习所需样本(图4虚线红框)的特征矩阵,进而求解出新一帧的滤波器模型。

图4 目标检测样本(绿框)和在线学习样本(红框)

两个阶段共需要进行两次特征提取与离散傅里叶变换操作。两个样本的中心偏移量(dx,dy)为

(18)

样本图像块如图5所示。其中,图5(a)为检测定位阶段的样本,图5(b)为图5(a)经过(dx,dy)的循环移位得到的移位样本,图5(c)为真实的在线学习所需样本。可以看出,图5(b)与图5(c)仅在边界存在差异,图5(b)左边界失真。在DCF框架中,边界区域受到余弦窗与空间正则项的抑制,对滤波器的判别能力几乎不构成影响,因此可以使用移位样本(图5(b))代替真实样本(图5(c))进行滤波器的在线学习。同时,由于密集采样提取的特征值与像素点具有位置对应关系,因此直接对检测样本(图5(a))的特征矩阵进行(dx,dy)的循环移位,可得移位样本(图5(b))的特征矩阵,并将其用于后续的在线学习。

图5 样本图像块

由于滤波器学习阶段使用样本特征的频域表示,根据傅里叶变换的时移特性,时域信号的循环移位对应频域信号的相位旋转,因此可将检测样本(图5(a))的频域特征值乘以对应的虚指数,直接在频域进行特征转换,进一步提高效率。消融实验结果表明,在对跟踪精度没有显著影响(±0.1%)的前提下,该加速策略可将跟踪速度提高25%。

3 实验结果与分析

3.1 参数设置与实验环境

实验软件环境为MATLAB R2017b,硬件环境为Inter(R) Core(TM) i7-7700HQ CPU,2.80 GHz主频,8 GB内存。

3.2 UAV数据集介绍

为了进行全面评估,实验在3个具有挑战性和权威性的UAV数据集上进行,分别是UAV123_10 fps(Mueller等,2016)、DTB70(Li和Yeung,2017)和UAVDT(Du等,2018)数据集,共243个视频序列。

UAV123数据集全部由无人机在空中拍摄,视角变化大,包含123个视频序列,超过11万帧图像。UAV123_10 fps是从原序列中以抽帧的方式创建的10帧/s的数据集,因此跟踪过程中目标的位置移动、姿态变化更大,带来了更多挑战。DTB70数据集由70个困难的无人机视频序列组成,主要针对无人机拍摄过程中剧烈运动以及目标的大小和纵横比变化问题。UAVDT数据集主要针对各种情况下的车辆跟踪,例如飞行高度、摄像机视角和车辆遮挡等。

3.3 实验结果分析

为了验证本文算法的先进性,在3个UAV数据集上与14种主流算法进行对比实验,分别为MRCF(multi-regularized correlation filter)(Ye等,2022)、MSCF(mutation sensitive correlation filter)(Zheng等,2021)、ARCF(aberrance repressed correlation filter)(Huang等,2019)、STRCF(Li等,2018)、MCCT(multi-cue correlation filter based tracker)(Wang等,2018)、ECO-HC(efficient convolution operators—hand-crafted feature version)(Danelljan等,2017b)、BACF(background-aware correlation filters)(Galoogahi等,2017)、fDSST(Danelljan等,2017a)、Staple(fast discriminative scale space tracker)(Bertinetto等,2016)、SDRCF(Danelljan等,2015)、LCT(long-term correlation tracking)(Ma等,2015a)、DSST(Danelljan等,2015)、KCF(kernelized correlation filter)(Henriques等,2015)、SAMF(scale adaptive with multiple features tracker)(Li和Zhu,2014)。考虑到无人机平台的实现能力,所有跟踪算法均采用手工特征,确保在单个CPU上的效率,一些采用DCF结构但具有CNN特征的跟踪器,例如ASRCF(adaptive spatially-regularized correlation filters)(Dai等,2019)不属于本文研究范畴。对比算法均使用原文献提供的开源代码或结果。

3.3.1 与STRCF算法定性比较

本文方法与STRCF算法对包含视角变化、快速运动、低分辨率、快速形变以及遮挡等挑战的4个视频序列的跟踪结果如图6所示。可以看出,本文方法的跟踪性能明显优于STRCF。

1)视角变化。由于无人机拍摄时自身发生旋转,导致目标成像姿态快速变化。快速旋转时目标的梯度信息变化剧烈,此时HOG特征的表征能力欠佳。本文算法采用HOG + CN组合特征,在快速旋转这种梯度敏感的场景下,弹性网络约束可以减弱HOG特征的影响,加强CN颜色特征对模型的贡献,使模型具有更好的鲁棒性。如图6(a)所示,本文算法相比STRCF具有更高的定位精度。

2)快速运动与低分辨率。从图6(b)可以看出,跟踪目标的尺寸小、分辨率低,在目标特征信息较少的情况下,本文算法依然可以准确跟踪。

3)快速形变。在图6(c)杂技表演序列中,表演者骑车在空中翻转,自身发生快速形变,STRCF无法适应这种快速形变而跟踪失败,本文算法通过弹性网络约束提高特征的可靠性,增强了模型的判别能力,能够更好地定位目标。

4)视觉遮挡。遮挡是视觉目标跟踪的常见问题。在图6(d)Horse视频序列中,在目标进入遮挡、完全遮挡和离开遮挡的过程中,STRCF模型被树木遮挡物污染,跟踪漂移。本文算法通过稀疏约束,自适应地忽略遮挡区域的干扰特征,防止模型学习到错误信息,能够在一定程度上抵抗短期遮挡。

上述分析表明,本文算法与STRCF相比在视角变化、快速运动、快速形变和视觉遮挡等复杂场景下具有更好的鲁棒性与有效性。

3.3.2 与14种算法定量比较

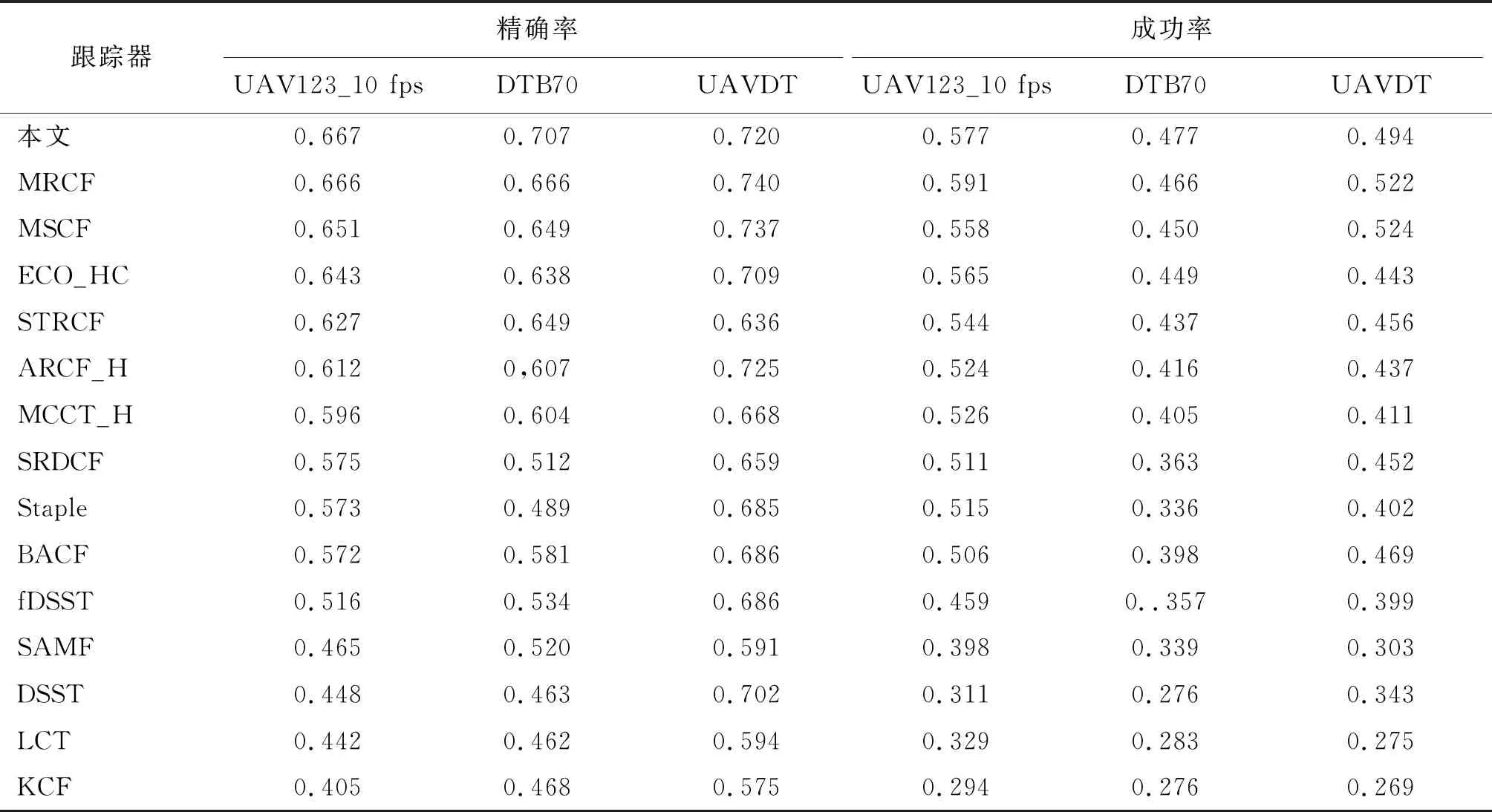

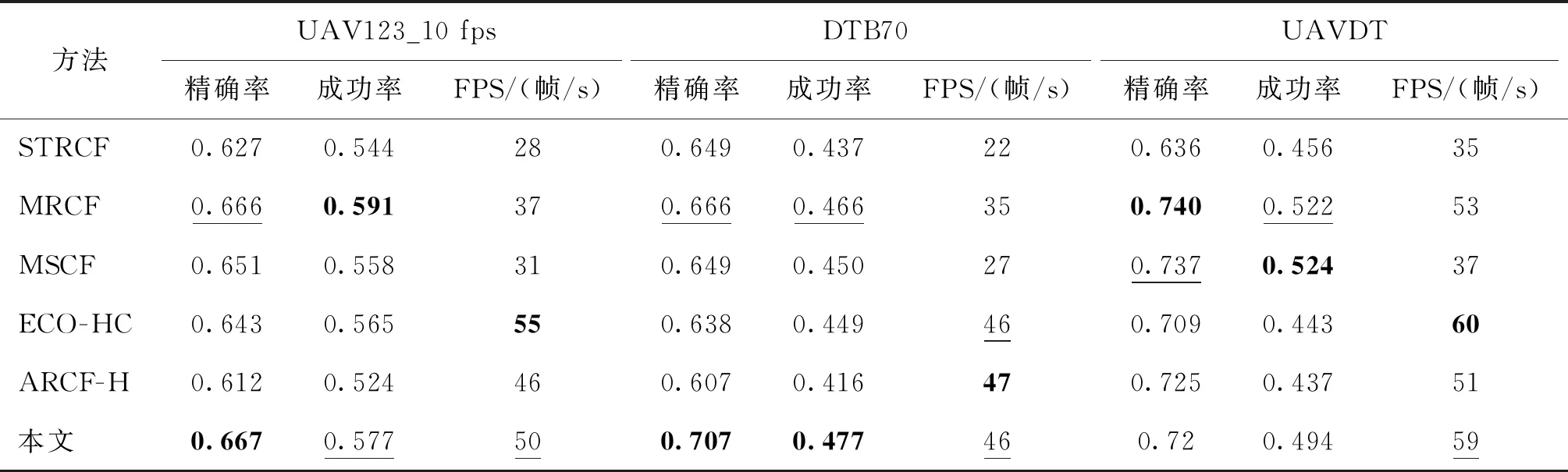

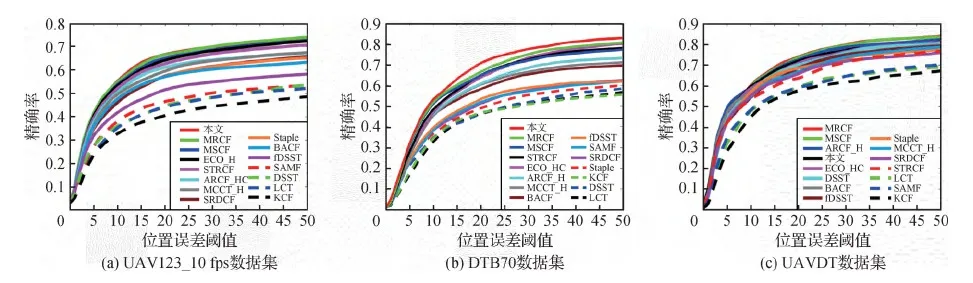

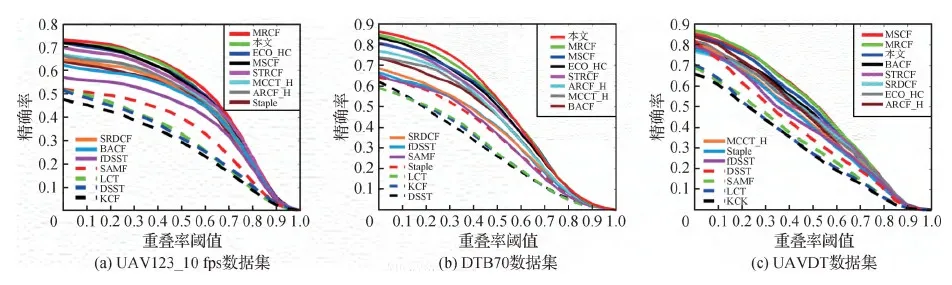

本文方法与14种跟踪算法在3个UAV数据集上的精确率和成功率对比结果如图7、图8和表1所示。跟踪性能最好的6种算法的精确率、成功率(Wu等,2015)与跟踪速率(frames per second, FPS)如表2所示。

表1 15种跟踪器在UAV基准上的精确率和成功率结果

表2 跟踪性能最好的6种跟踪器在UAV123_10 fps、DTB70和UAVDT数据集上的精确率、成功率和FPS结果

图7 15种跟踪器在UAV基准上的精确率曲线

图8 15种跟踪器在UAV基准上的成功率曲线

在UAV123_10 fps数据集上,本文算法的精确率为0.667,在所有算法中位列第1,相比STRCF算法提高了4%。本文算法的成功率为0.577,在所有算法中位列第2,相比STRCF算法提高了3.3%。在DTB70数据集上,本文算法的精确率与成功率分别为0.704和0.477,在所有算法中均位列第1,相比STRCF算法分别提高了5.8%和4%。在UAVDT数据集上,本文算法的精确率为0.720,在所有算法中位列第4,相比STRCF算法提高了8.4%。本文算法的成功率为0.494,在所有算法中位列第3,相比STRCF算法提高了3.8%。通过引入弹性网络约束,本文算法能够自适应地抑制异常情况下的干扰特征,提高模型在复杂场景下的适应能力,使得精度率与成功率均明显优于STRCF。

与14种当前主流算法相比,本文方法在精度与速度上均优于大多数现有方法,证明了本文方法在无人机视觉跟踪领域的优越性。

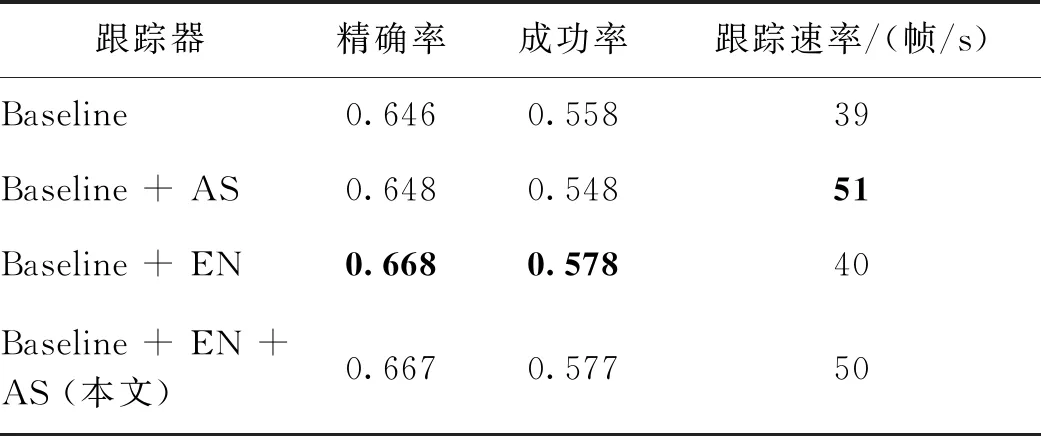

3.4 消融实验

根据2.4节的分析可知,对检测定位阶段的样本进行循环移位会导致移位样本存在边界失真现象,且相邻两帧之间目标的位置移动越剧烈,边界失真现象越显著。为了更好地验证本文提出的稀疏约束与加速策略对跟踪精度与跟踪速度带来的具体影响,采用目标位置移动、姿态变化更剧烈的UAV123_10 fps数据集进行消融实验。

消融实验中的4种方法均使用HOG + CN手工特征。Baseline在原始DCF框架中加入空间正则项与时间正则项,未使用弹性网络(acceleration strategy,AS)和加速策略(elastic net,EN);Baseline + AS表示在Baseline基础上使用加速策略;Baseline + EN表示在Baseline基础上引入空间弹性网络对模型进行区域性稀疏约束;本文算法包含区域稀疏约束项与加速策略。消融实验结果如表3所示。可以看出,使用弹性网络约束的Baseline + EN和本文跟踪器,对比未使用弹性网络约束的Baseline与Baseline + AS跟踪器,精确率和成功率均有提高。使用加速策略的Baseline + AS和本文跟踪器,对比未使用加速策略的Baseline和Baseline+EN跟踪器,跟踪速率(帧/s)明显提高。此外,本文跟踪器与Baseline+EN跟踪器相比,额外引入加速策略,在精确率和成功率仅下降0.1%的情况下,跟踪速率(帧/s)提高了约25%。

表3 消融实验

需要注意的是,UAV123_10 fps数据集采用3帧抽1的方式创建,目标相邻两帧之间的位置移动更大,加速策略中的循环移位操作会带来更多的边界失真,但得益于相关滤波框架中余弦窗与空间正则项的作用,边界对模型的影响受到极大的抑制。消融实验结果表明,加速策略大幅提高了跟踪速度,同时没有显著降低跟踪精确率和成功率。综上,本文提出的弹性网络约束与加速策略可以显著改善DCF类跟踪算法的性能。

4 结 论

针对无人机视觉跟踪任务对准确性、鲁棒性和实时性的高要求,本文提出一种稀疏约束的时空正则相关滤波跟踪算法,通过将弹性网络约束与空间正则项结合,使相关滤波器在遮挡、形变和视角变化等复杂场景下能够自适应地筛选具有区域特性的判别性特征;同时目标函数中集成了时间正则项以缓解畸变导致的模型退化;采用ADMM方法将带等式约束的目标函数转化为两个具有闭式解的子问题,迭代求取局部最优解。此外,提出一种DCF框架下通用的加速策略,通过在频域计算检测定位阶段的样本特征矩阵的循环移位,高效地获取滤波器在线学习阶段的样本特征矩阵,在不显著影响跟踪精度(±0.1%)的前提下,跟踪速度提高约25%,本文算法在单个CPU上的速度约50帧/s。

在UAV123_10 fps、DTB70和UAVDT这3个具有挑战性与权威性的UAV数据集上与14种主流算法进行对比实验。本文算法与基线STRCF相比,在精确率、成功率以及跟踪速度上均具有明显优势;与其他主流的视觉跟踪算法相比,本文算法在精度与速度上同样优于大多数DCF类跟踪算法,证明了本文算法在无人机视觉跟踪领域的优越性。

现有跟踪方法普遍忽视了多通道特征的差异性,对所有特征通道一视同仁,从而限制了多通道特征在不同场景下的适应能力。下一步工作将考虑加入场景感知模块,通过判断不同场景下各个特征通道的可靠性,自适应地调整各个特征通道的权重分布,提高模型在复杂场景下的适应能力。