像素级红外与可见光图像融合方法综述

2022-07-21杨海涛张长弓王晋宇

李 扬,杨海涛,孔 卓,张长弓,王晋宇

1.航天工程大学 研究生院,北京 101400

2.航天工程大学 航天信息学院,北京 101400

图像融合作为一种图像增强技术,通过将不同传感器或者不同位置、时间、亮度等的同一场景的两幅或者多幅图像的所有信息叠加互补,形成对于人类视觉或者后续图像处理更有用的融合图像[1]。传统图像融合方法发展成熟,已经实现了很多优秀的融合算法。深度学习的发展推动了图像融合技术的发展,神经网络强大的特征提取和重构能力使融合结果具有广阔的前景。

随着图像融合技术的研究呈不断上升的趋势,应用领域也遍及遥感图像处理、可见光图像处理、红外图像处理、医学图像处理等,此外还有多曝光图像融合在摄影中的应用、红外与可见光融化在视频监控中的应用、MRI和PET的融合、MRI与CT的融合在医学中的应用等等。

国内外学者专家在该领域已发表多篇综述,例如北方民族大学的周涛等[2]将多尺度融合算法分为多尺度分解和子带融合算法两部分,并对其分别进行了归纳总结。沈英等[3]对红外与可见光方向的论文进行了归纳整理,并根据场景对不同方法进行了实验总结。湖南大学的李树涛等[4]将图像融合按照源图像来源划分为九类典型获取方式,并分别进行了归纳总结。

除了综述性文章,专家学者发表了许多对算法评价的指标的总结性文章。华中科技大学的王海晖等[5]将图像融合质量总结为图像的可检测性、可分辨性和可测量性三方面,并提出一些有意义的建议。Zhang在2020年总结性地对2011年以后发表的算法以信息论指标CE、EN、图像融合指标AG、EI等共十三个指标进行了整体评价[6]。

1 图像融合理论

1.1 图像融合的概念与规则

图像融合技术是20世纪70年代被提出的一种图像处理方法[7]。此后该技术得以快速发展。图像融合的基本逻辑是利用算法将两幅或多幅图像融合作为一幅新的图像,融合结果能利用两幅(或多幅)图像在时空上的相关性及信息上的互补性,并使得融合后得到的图像对场景有更全面、清晰的描述,从而更有利于人眼的识别和高级任务的分类或者识别。

目前普遍认为,图像融合存在三个基本规则[7]:第一,融合后的图像必须保持源图像的明显特征仍然突出;第二,融合过程不可加入人为信息;第三,对噪声等无价值的信息尽可能抑制。

1.2 图像融合的层级划分

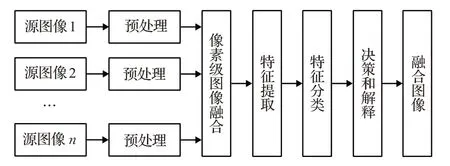

图像的融合根据层级可以划分为三类,以认知为基础的决策级融合、需要提取特征信息的特征级以及以像素为处理单元的像素级融合,如图1。

图1 图像融合层级Fig.1 Image fusion hierarchy

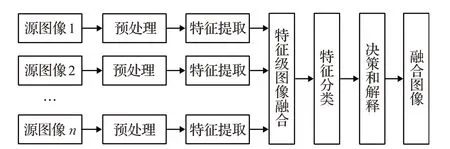

像素级的图像融合是最基础的融合类型,如图2,其对轮廓边缘、纹理和色彩变化的融合能力强,融合图像有利于图像的后续处理分析、判读解译。

图2 像素级融合流程Fig.2 Pixel-level fusion process

像素级融合存在如下问题:融合时间长。由于需要对图像像素处理,算法实现实时融合困难。源图像质量要求高。融合结果对源图像的噪声敏感,源图像过曝或欠曝同样会导致融合结果欠佳。配准要求高。配准精度直接影响融合效果。

特征级融合是将源图像中边缘、建筑、人物等明显特征分离提取,通过分析处理,融合得到新的特征融合图像,如图3。融合时只考虑特征部分区域,因此融合结果的目标识别强度高于源图像。且融合中不处理特征之外的环境细节信息,所以处理速度快、实时性好,且融合过程对像素的依赖性不强,所以对于配准要求不高。但是也存在丢失大量细节特征的问题。

图3 特征级融合流程Fig.3 Feature-level fusion process

决策级图像融合是一种具有层次高、抽象性强的基于认知的融合类型,如图4。决策层的融合计算量相对于其他两个是最小的,且不受源图像的噪声影响。缺点是图像清晰度相对特征级与像素级较差,且对特征级融合有较强的依赖性,由于对此方向研究较少,程序实现困难。

图4 决策级融合流程Fig.4 Decision level convergence process

1.3 常用数据集

图像数据集是图像处理的基础,选择合适的数据集对算法的研究十分关键。对于红外与可见光融合算法,常用的数据集如表1所示。

2 传统图像融合方法

图像融合算法发展迅速,基本可以分为传统方法和基于深度学习的方法两大类。

传统的图像融合算法发展成熟、衍生方法多。大致可以总结为三步:将源图像分解;将分解的图像按照预定的融合规则分别融合;对分层融合的图像进行分解逆变换,得到最终融合图像。

表1 常用融合数据集Table 1 Commonly used fused data sets

2.1 图像分解算法

图像分解算法是图像融合的第一步,图像分解是为了将源图像分割为包含不同特征的几幅图像,进而通过图像融合规则分别进行融合,保证生成的融合图像既有明显的红外特征,也能保留可见光图像中的细节与纹理。

2.1.1 基于空间域的图像分解

其一是加权平均方法。加权平均方法通过对源图像所有像素的灰度值加权平均的方法来产生新的融合图像,这也是最简单直接的一种融合方法,其优点是融合算法简单速度快速且图像的信噪比高于源图像,缺点是最终融合图像对比度低、融合图像对目标凸显明显。

其二是基于最大最小值选取的图像融合方法。在融合过程中,通过比较源图像对应位置处像素的灰度值大小作为依据,按照需要选择其大值或者小值作为融合图像对应位置的像素灰度值。此方法应用场景有限,很少使用。

其三是基于PCA的图像融合方法。这一方法可以简要分为三步。第一步是通过三个或以上波段数据求出源图像之间对应像素的相关系数矩阵,以相关系数矩阵为基础计算对应的特征值与特征向量,最后求出主分量图像;第二步是把高分辨率图像对比度进行拉伸,并将其与第一分量图像比较,将其均值与方差保持一致;第三步是将拉伸后的高分辨率图像作为第一分量,将其加上其他分量进行PCA逆变换。通过三步即可实现融合。

PCA图像融合方法相对于其他空间域方法更适用于多光谱图像融合,但是由于其不会考虑图像各波段的光谱信息,所以会损失一部分低分辨率图像的信息。

2.1.2 基于多尺度变换的图像分解

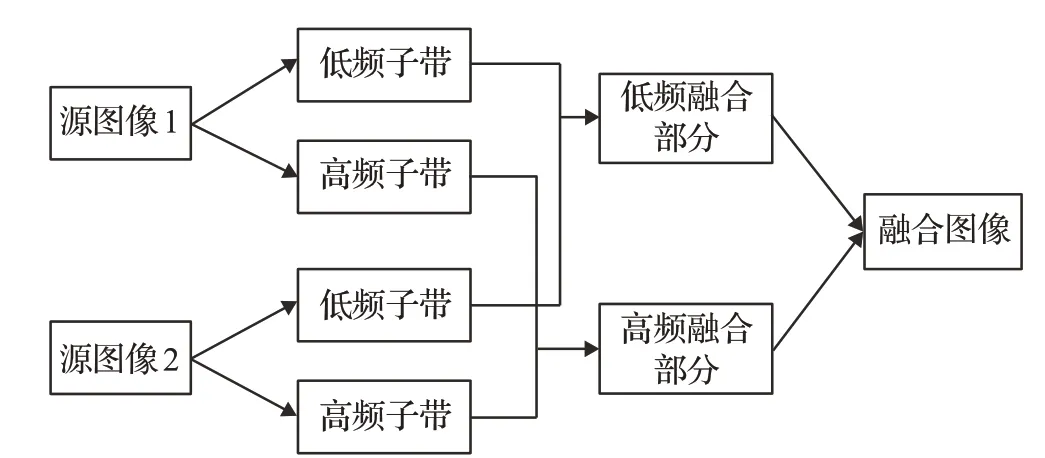

基于多尺度变换的图像融合方法在众多融合方法中,最受关注和欢迎。多尺度变换的融合规则如图5,第一,对源图像进行多尺度分解,将图像分为一系列尺度不同的子图像;第二,设计一种基于多尺度变换的融合规则,对不同尺度的图像进行融合,使得该尺度下的特征能够被保留;第三,对复合的多尺度图像逆变换操作,最终得到融合后的图像。

图5 多尺度分解示意Fig.5 Multiscale decomposition

多尺度融合主要由金字塔分解方法、小波变换、多尺度几何分解三种方法组成,本文梳理了三类方法的主要发展并进行了对比分析。

(1)基于金字塔变换的图像分解

金字塔变换最早由Burt等于1984年提出,他使用的拉普拉斯金字塔和基于像素最大值的融合方法实现了人眼立体视觉的融合[11]。基于像素最大值的方法实际上是指选取局部亮度差异较大的部分作为融合重点。初期的拉普拉斯金字塔变换融合结构受噪声影响过大、分层没有考虑方向性的问题、塔中的各层存在较多冗余等问题,但为图像融合提出了一种行之有效的方法。

Toet[12]根据拉普拉斯金字塔提出的对比度金字塔,解决了拉普拉斯金字塔得到融合图像对比度降低的问题,其核心思想是先通过高斯变换得到多层金字塔,再求出各层之间的比率得到对比度金字塔,从而提升融合图像的对比度。

Burt[13]提出的一种基于梯度金字塔的融合算法,通过对高斯金字塔的各层进行梯度方向滤波,提高了融合算法对噪声的抗性。陈锦等提出一种拼接(Splice)金字塔融合算法[14],该算法在滤波的同时加入了采样的操作,融合图像的清晰度得到提升。胡学龙等[15]将中值滤波运用到图像融合算法当中,由于中值滤波本身具有较高的鲁棒性和自适应性,所融合的图像更加光滑,对噪声抗性更高。2011年,崔颢[16]提出一种基于方向可控金字塔的图像融合方法,加入了递归卷积与抽样的步骤,使得此方法具有了平移不变性和旋转不变性。

近年来,刘斌等[17]改进了对比度金字塔提出一种方向对比度金字塔,该方法通过加入对高频分量的方向滤波操作从而保留了更多的融合图像的细节和方向信息,但也使得算法复杂度上升。Kou等[18]提出了混合平滑金字塔,后者在降低伪影现象的同时很好地处理了算法复杂度和性能之间的关系,但整体融合效果和先进算法相比略微不足。

刘斌等[19]提出一种基于不可分拉普拉斯金字塔的融合算法,该方法首先建立图像的非采样不可分小波塔形分解,根据不可分小波金字塔建立非采样不可分拉普拉斯金字塔。从而解决了拉普拉斯金字塔不能实现平移不变性的问题。以上方法的优点与不足总结如表2。

表2 金字塔变换方法对比Table 2 Comparison of pyramid transformation methods

基于金字塔分解的图像融主要步骤为:对源图像金字塔滤波得到尺度不同的分解图像,再依据融合规则分别融合不同层的分解图像,最后使用金字塔逆分解的方法将图像重构,得到最后的融合图像。该类融合算法优点是考虑了不同空间分辨率下图像的重要部位和特征,并能够相应地融合和保留。缺点是会造成图像的冗余分解,并且在金字塔底端的高频信息在分解后信息损失较大,最终的融合结果细节损失较多。

(2)基于小波变换的图像分解

小波变换具有良好的方向选择性、正交性、可变的时频域分辨率等优点而广受关注,并成为图像融合领域一种十分有用的理论。相对于其他方法,小波变换的特性在直观上更便于理解也更符合人的视觉。

小波变换总结来说可以分为三步:首先对源图像进行小波分解,得到各个方向和频率的金字塔结构;其次根据不同融合策略分别融合子频带;最后对融合好的子频带做小波重构,得到的重构图像就是最终的融合图像。

小波变换是由Mallat[20]在1989年提出的一种方法,方法提出以后受到了广泛关注和应用。1995年,Li等[21]在小波变换基础上提出一种离散小波(DWT)变换的图像融合方法,通过对小波变换的尺度和位移以2的幂次实现离散化,从而降低了图像中噪声的不良影响,但离散的特性也使得其特征表达能力不足[22]。Uytterhoeven和Bultheel[23]提出一种Red-Black小波变换,该方法是一种基于五株型采样的不可提升小波,相对于小波变换算法它不仅能够消除行和列方向的相关性,还能消除对角线方向的相关性,刘斌基于此方法提出一种图像融合方法,融合结果表示光谱质量和空间信息均有较体现,但由于Red-Black小波分解时特征方向受限,使得特征提取不充分。

Kingsbury[24]为了解决离散小波变换不具有平移不变性和方向性的问题,在离散小波的基础上提出了一种双树复小波(dual-tree complex wavelet transform,DT-CWT)变换,该方法具有计算效率高、数据冗余有限的特点,相较于小波变换,DT-CWT可以对图像在多个方向上分解,从而提升了分解能力[25]。Ioannidou基于DT-CWT设计了一种图像融合算法,结合全色图像高频部分和多光谱图像低频部分求得融合图像,取得了良好效果。

Lee等[26]提出一种提升静态小波变换(lifting stationary wavelet transform,LSWT),该方法删除了传统提升小波的奇偶分解部分,并在滤波器系数中加入一定个数的零来延展滤波器。因此,该方法不仅具有初始的低通滤波特性并且具有了平移不变性,对源图像的纹理和细节信息的提取能力也得到了提升。但该方法需要将数据分为两个子集,使得变换后子带信号减半,改变了原数值而不是平移,由此导致了融合结果的失真,降低了准确性[27]。

Bayro-Corrochano[28]提出了四元树小波变换(quaternion wavelet transform,QWT),该方法基于四元数代数、四元数傅里叶变换以及Hibert变换,相较于离散小波和双数复小波变换,具有近似平移不变性、丰富的相位信息和有限数据冗余的优点,用于图像融合中,能够进一步改善融合图像的对比度、细节和边缘结构。Chai等[29]基于QWT分解图像得到高频和低频部分,并以一种基于低频子带相位和幅度以及空间方差的加权平均融合规则来融合低频子带,以一种基于系数对比度和能量的choose-max融合规则来融合高频子带。最后在多焦点图像、医学图像、红外可见图像和遥感图像上进行了算法的有效性验证。

王卫星、曾基兵[30]提出冗余提升不可分离小波变换,该算法将快速提升算法中的分裂转化为复制,避免了数据量变化导致的失真。融合结果的整体效果相对于快速提升算法得到了优化。

Gilles[31]提出一种协同经验小波变换方法,该方法的特点是根据数据的傅里叶特性,对数据的频谱自适应地划分,构造相应的滤波器组。在用于解决多源图像融合时自适应分解不协同的问题时,融合结果得到了较好的改善[32],但仍存在一定的虚假模态现象和混频现象。

宫睿等[33]提出了一种基于可协调经验小波变换(CEWT)的图像融合算法,该算法同时利用两个生成滤波器保证融合图像的谱带和频谱划分相同,避免了频谱混叠现象。该算法在融合结果的边缘以及细节处相对于其他算法有更好的表现。

小波变换方法总结如表3。

表3 小波变换方法对比Table 3 Comparison of wavelet transform methods

(3)多尺度几何分解

多尺度几何分解相对于小波变换和金字塔变换最大的优势在于,多尺度分解在原理上具有方向性和各向异性。对应高维数据有更强的分析能力,缺点是算法复杂度更高。

脊波(Ridgelet)变换是一种适合分析高维奇异性的数学工具,由Candès[34]在1999年时提出。与小波变换比较,脊波有以下几个优势:能够通过Radon变换将线性特征转化为点状奇异特征,克服了小波变换无法提取图像沿边特征的问题;在保持小波变换的频域和空域特性的同时,有很强的方向性,对于图像的边缘有更强的提取能力,可以在融合图像中体现更清晰;并且脊波具有更好的稀疏性,能够把特征集中在较少从的维度中,变换后的信息更加集中。

曲线波(Curvelet)变换由Candes和Donoho[35]在1998年提出,这是一种基于Ridgelet变换改进的分解算法,Curvelet对边缘结构的表示能力更强,从而间接地提高了融合图像的分辨率,并且Curvelet相对于Ridgelet有更小的分析冗余度。Curvelet首次被用于图像融合是由Choi等[36]提出,他们在多光谱图像和全色图像的融合使用了Curvelet变换并得到了较好的结果,融合图像有了更丰富的空间信息和光谱信息。张强等[37]提出的基于Curvelet变换的算法降低了高频噪声对融合图像的影响,最终的融合指标和直观效果相比小波变换更优。

条带波(Bandelet)变换是Pennec和Mallat[38]在2005年提出的一种基于边缘的图像表示方法,该方法的优点是可以自动适应图像的几何正则方向。Bandelet变换的主要思想是将图像的几何特征看作矢量场,通过矢量场描述图像空间结构的灰度变化。杨扬等[39]基于非下采样的Bandelet的方法提出一种图像融合方法,该方法删除了原算法的下采样操作,变换结果包含了部分冗余数据,因此可以为融合步骤提供更丰富的信息。该实验效果相对于WT和NSWT有更好的视觉效果和量化标准,并且降低了伪吉布斯效应的影响。

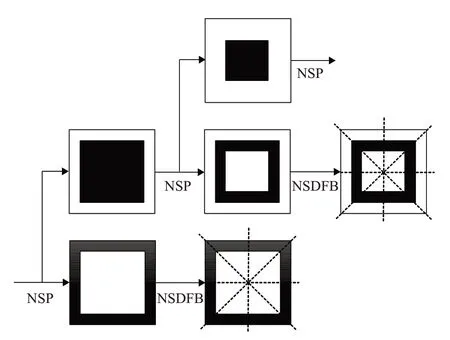

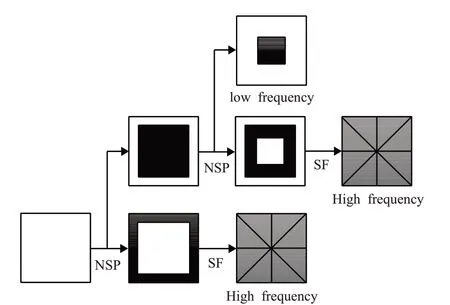

轮廓波(Contourlet)由Laplacian pyramid(LP)和directional filter bank(DFB)两部分组成。其中,LP处理低频带通信号,避免频率混乱;DFB用于处理高频信号,检测图像的方向信息。由于轮廓波变换缺少平移不变性这一重要特点,da Cunha等[40]提出了非下采样轮廓波变换(nonsubsampled contourlet,NSCT),NSCT的分解过程如图6所示,先利用非下采样金字塔滤波(not sampling pyramid,NSP)对源图像分解得到低频子带和高频子带,低频子带继续用NSP处理分解,高频子带则使用非下采样方向滤波器组(non-downsampling direction filter bank,NSDFB),得到不同方向和尺度的子带系数。

NSCT将Contourlet中方向滤波器的下采样替换为非下采样金字塔结构(NSP),将方向滤波器中的下采样转换为非下采样的方向滤波器(NSDFB),从而使算法具有了平移不变性,修复了融合图像出现伪吉布斯效应的问题。

NSCT在图像融合领域应用颇多,Goyal等[41]设计了一种基于NSCT的医学图像融合算法,实现了较高的融合效率和融合效果。与其他方法相结合也是研究人员广泛尝试的融合方法。裴高乐等[42]将NSCT与脉冲耦合神经网络(AR-PCNN)相结合,应用于图像融合处理,得到了质量较高的结果。

图6 NSCT分解流程Fig.6 NSCT decomposition process

但NSCT中使用了固定的方向滤波器,对于复杂的空间结构的处理能力较弱。Guo和Labate[43]在2007年提出了剪切波(Shearlet)变换,剪切波变换的算法复杂度较低,计算效率相对于其他算法较高,且不限制剪切的支撑大小和方向个数,有较强的应用价值。但是剪切波在处理图像后会出现伪吉布斯现象[44]。

针对剪切波的缺点,Easley等[45]于2008年提出了非下采样剪切波变换(non-subsampled Shearlet transform,NSST)变换,NSST的分解过程如图7所示,首先通过NSP分解得到L′个高频子带和1个低频子带,再将得到的高频子带通过改进剪切波滤波(shear filtering,SF)处理得到相应频带的多个分量,NSST将剪切波变换中的下采样变更为卷积,从而有效地抑制了伪吉布斯现象。Wei等[46]基于NSST和鲁棒主成分分析(RPCA)设计了一种图像融合算法应用于红外与可见光图像融合。首先通过RPCA分解源图像得到稀疏矩阵,再通过NSST分解得到子带,将子带融合得到目标图像。实验结果取得了目标更明显、背景更丰富的融合结果。

图7 NSST分解流程Fig.7 NSST decomposition process

Krommweh[47]提出了一种Tetrolet变换,这是一种自适应的四格拼板的Haar小波变换,Tetrolet变换首先把源图像分解为4×4的块,对其分解得到4个低频部分和12个高频部分;再对低频部分进行分解为4×4的小块,以此类推。Tetrolet变换不仅具有哈尔小波变换的多分辨率特征,还拥有比哈尔小波变换更丰富的方向分量,因此可以更好地表示图像的高维特征信息,但会导致融合图像的分辨率降低。苑玉彬等[48]在通过Tetrolet变换与自适应脉冲神经网络结合的方式,解决了融合图像色彩对比度低的问题。

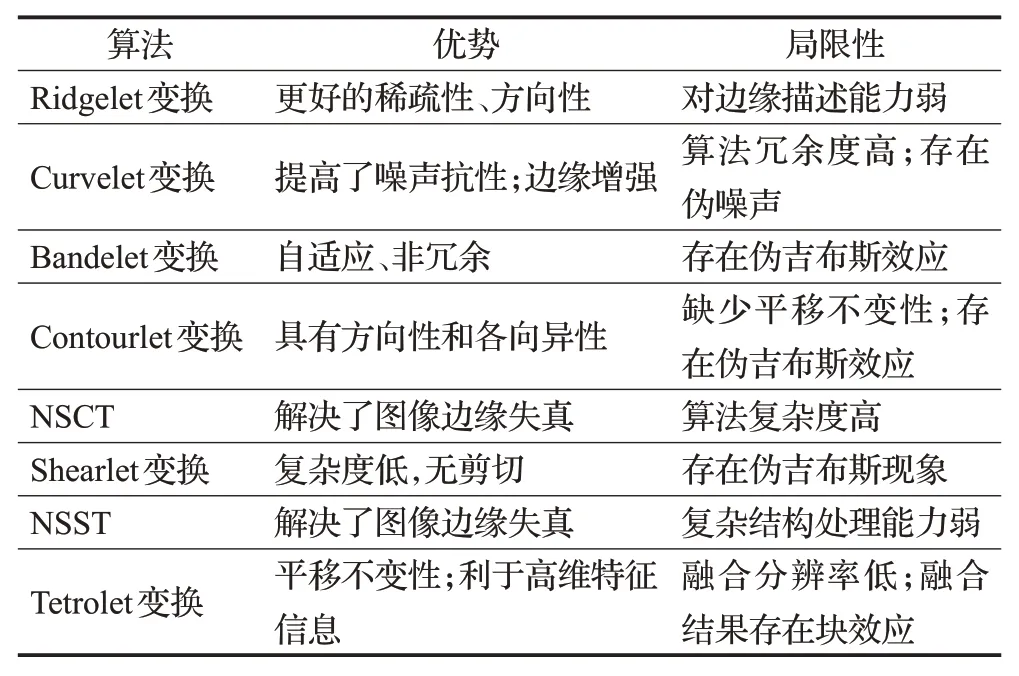

以上总结如表4。

表4 多尺度几何分解方法对比Table 4 Comparison of wavelet transform methods

2.2 图像融合规则

图像融合的第二部是分层融合,这一步需要根据高频和低频子带不同特征设计合适的融合规则。图像融合规则设计与算子选择对于图像融合的结果十分重要,会直接影响融合效果,本节将图像融合规则按照方法归为像素融合规则、区域融合规则以及其他融合规则。

2.2.1 基于像素的融合规则

基于像素的融合方法是通过计算图像中各个像素点来融合图像的,优点是计算速度快、算法简单容易实现,缺点是不考虑相邻像素的关系,容易出现振铃现象等问题。

(1)低频子带融合

基于像素的低频子带融合规则有以下几种。第一,平均融合或加权平均规则,对两幅源图像的每个像素点求平均值或者加权平均值,作为融合图像的值。通常情况下,低频部分的图像都会采用这一方法,但是会导致图像对比度降低,效果较差,Chavan等[49]和Dogan等[50]在融合时采用了该方法。第二是像素绝对值最大融合规则,这一方法关注了源图像的边缘特征,提高了融合后图像的对比度、降低了边缘模糊的问题,相对于平均融合规则,能够保留更丰富的红外与可见光图像的信息,Jin等[51]和沈瑜等[52]在算法中使用了该方法。第三是自适应加权平均规则,会根据给出的规则自动调整像素点的融合权重,这一方法相对于加权平均更加灵活,融合效果更好。Cheng等[53]在论文中使用显著图作为权重融合低频子带,取得了较好的融合结果。

(2)高频子带融合

相对于只需要平滑特征的低频子带融合规则不同的是,高频子带融合时需要保留和融合高频子带中丰富的特征和细节信息。平均融合、加权平均以及自适应平均等方法不能处理相邻像素之间的关系,不能够很好地处理高频子带。

基于像素的高频子带一般的处理方法一般有以下几种方法。第一,系数最大值规则,通过保留图像像素值变化最大的边缘特征来融合高频子带。这一方法对图像边缘信息可以较好地保留,Meng等[54]、Aishwarya和Thangammal[55]、Cheng等[56]和Chen等[57]均在处理高频信息时使用了系数最大值规则,实现了较好的融合效果。第二,像素最大SML值,拉普拉斯能量和(sum of modified Laplacian,SML)是一种能够较好地体现图像的高频特征的值,Liu等[58]使用了该规则融合了高频子带,实验效果较好。第三,像素最大NSML值,是改进的拉普拉斯能量和。Ullah等[59]选择分解图像中NSML值高的子带作为融合图像,这一方法提高了图像的对比度,实现了更好的融合效果。

2.2.2 基于区域的融合规则

基于区域的融合规则相比于基于像素的融合规则加入了对相近像素的区别的考虑,在融合时加入了临近像素点的相关性,提高了融合的效果。

(1)低频子带融合

对于低频子带融合,基于区域的融合规则有以下几种。第一,主成分分析法。PCA的主要作用是突出特征,将源图像数据压缩到更少的维度,通过减少维度提取层数,增大方差,提高特征分量。第二,区域方差最大值。区域方差最大值算法是利用区域方差求取融合图像的像素值,计算两幅源图像低频子带的区域方差,取大作为融合图像该点的像素灰度值,这一方法可有效提高融合质量。Ding等[60]采用了PCA算法融合低频信息,能够在融合图像中较好地体现源图像中特征的轮廓信息。第三,局部能量最大值。Meng等[61]针对平均融合方法导致的伪影问题,使用局部能量最大值的规则融合低频信息,有效地避免了融合图像中出现伪影的问题。第四,Canny边缘检测器。Canny边缘检测器是一种检测图像边缘信息的算法。使用该算法融合低频子带可以保留更多的图像细节信息。Vishwakarma等[62]使用尺度相乘的Canny边缘检测器和Hessian特征叠加的方法来融合低频信息,实验效果较好。

(2)高频子带融合

基于区域的高频子带融合规则主要关注融合图像中重要特征的边缘,通过加强特征边缘强度,达到提高高频特征和融合效果的目的。此类方法主要有以下几种。第一,最大边缘强度融合规则。最大边缘强度融合规则通过保留源图像中高对比度的边缘特征可以在融合图像中体现尽可能多的细节和边缘特征。Anandhi和Valli[63]首先通过NSCT进行分解源图像,然后使用了最大边缘强度融合规则处理分解得到的高频部分,融合结果较好,保留了源图像大部分的边缘信息和纹理信息。第二,导向滤波器。导向滤波器是Liu等[64]基于冗余提升不可分剪切波改进提出的一种保边滤波器,作为融合规则可以较好地保留图像细节并且可以一定程度地避免伪影现象。第三,平均梯度及其改进规则。平均梯度的优势在于能够保留图像的边缘结构,且算法简单快速。但是平均梯度会造成振铃现象,影响最终的融合效果。Cheng等[65]在平均梯度的基础上增加了对角梯度变换,改进后的平均梯度算法可以提取更多的边缘并保留它们。第四,反锐化掩膜融合规则。这一方法通过提高高频子带系数来提高边缘高对比度特征信息,比平均梯度的规则更加简洁。该规则由Vishwakarma等[62]提出,并在该论文中应用,融合效果较好,算法复杂度低。

3 基于深度学习的图像融合方法

在深度学习的发展历程中,许多有价值的深度学习方法都被应用到图像融合算法当中。例如深度神经网络DNN(deep neural network)、卷积神经网络(convolutional neural network,CNN),以及生成对抗网络(generative adversarial net,GAN)等。深度学习的方法在图像融合领域展现了良好的性能。

DenseNet是一种具有密集连接的卷积神经网络。Li等[66]在DenseNet基础上提出了DenseFuse网络模型。这是一种基于残差网络的图像融合算法,能够将图像特征传入更深层的网络中,避免过快地出现梯度爆炸。网络设计了更优的规则以及两个融合层,能够从源图像中继承更多有用的feature,最后通过解码层重构融合图像,得到融合结果。残差块(dense block)可以在编解码网络中保留更多的深度特征,以及在最终融合时保留所有显著特征。此方法相对于现有的算法,在主观评价于客观评价两个方面均有较好的水平。

Huo等[67]提出一种红外和可见图像融合的无监督框架,该架构通过两个共享权重的dense network取得源图像的深层特征,并直接将深层特征叠加作为融合层,最后对融合结果进行五次卷积重建融合图像。这一网络相对于其他融合网络,计算复杂度不高,融合结果与DenseFuse类似,但更着重于Vis和Ir的融合。

生成对抗网络是Goodfellow在2014年提出的一种深度学习网络,GAN网络强大的生成能力是它广受关注的主要原因。2019年,Wei等[68]提出了FusionGAN网络模型,这是首个使用GAN网络完成红外和可见光图像融合任务,其中生成器旨在生成具有主要红外信息和更多可见梯度的融合图像,而判别器旨在强制融合更多可见图像中的细节。这使得最终的融合图像能够同时保持红外图像中的热辐射和可见图像中的纹理。FusionGAN作为一个端到端模型,避免了传统算法设计复杂的活动水平测量和融合规则。融合结果具有清晰的突出目标和丰富的细节,整体结果优于先进的算法。

2020年,Xu等[69]提出一种具有双判别器的DDcGAN,该网络用其中一个鉴别器判断生成图像与Vis图像的真伪,用另一个鉴别器判断Ir与降采样以后的生成图像的真伪。算法效果较好,但训练过程时间长、难度大。

同年Yu等[70]针对现有算法在多光谱与全色图像融合中对全色图像空间信息保留度低的问题,提出一种Pan-GAN网络,这是一种无监督全色图像锐化框架,这一框架由生成器、光谱判别器、空间判别器组成,算法结果优秀,提高了融合图像的空间信息。

Zhang等[71]提出了一种新的融合框架,具有多分类约束的生成对抗网络(GANMcC),该融合框架将图像融合转化为多分布同时估计问题,以更合理的方式融合红外和可见图像。并且采用具有多分类的生成对抗网络来同时估计可见光和红外域的分布,其中多分类判别博弈会使融合结果的分布更加平衡,从而具有显著的对比度和丰富的纹理细节。该融合框架对质量较差的源图像,例如过曝光图像,仍能够取得较好的融合结果。

Zhang等[72]提出了一种压缩分解网络(SDNet)用于多模态数字图像的即时融合。该网络将图像融合分解为强度项和梯度项,使用自适应的决策块,依据像素尺度上的细节丰富度来决定梯度项分布的优化程度,通过强度损失权重值,改变图像不同部位强度信息的大小。该网络具有较好的即时性。

Ma等[73]提出一种基于显著目标检测的红外和可见图像融合网络,称为STDFusionNet,它可以较好地保留红外图像中的热目标和可见图像中的纹理结构。STDFusionNet作为一种端到端模型,可以以隐式方式完成显著目标检测和关键信息融合。算法的速度更快,并且融合结果看起来像高质量的可见光图像,且具有清晰的高亮红外目标。

NestFuse[74]是一种基于通道注意力和空间注意力的融合模型。算法首先对源图像进行多尺度特征提取,通过融合策略来分别融合每个尺度下的特征,最后通过nest-connection解码器重构融合图像。实验表示对于一般源图像,融合结果在可见光的细节部分和红外的目标特征部分均表现良好,但对低质量图像的融合能力不足。

SeAFusion[75]是一种高级视觉任务驱动的图像融合框架。由一个轻量级的融合网络和一个语义分割网络组合而成。融合网络同时接受内容损失和语义损失的调整。整体网络结构较为简单,但提供了一种全新的融合思路,并且实现了较好的融合结果。

以上深度学习类方法总结对比如表5。

表5 深度学习算法对比Table 5 Deep learning algorithm comparison

4 结束语

根据以上综述内容可以总结得到,红外与可见光图像融合在各方面的研究及应用中仍有很大发展潜力,存在以下问题亟待研究和解决:

(1)即时图像融合

融合效果与融合时间始终是相互矛盾的,在实际应用中,视频融合的需求对融合速度的要求严格,因此,实时处理是图像融合未来发展的重要趋势。

(2)结合融合目的的融合方法

目前,大部分算法在尝试提升基于评价指标的融合效果,高评价指标和是否利于后续图像处理,例如语义分割、目标检测、目标识别并不是线性相关的。通过融合目的直接指导图像融合的方法是一个有意义的发展方向。

(3)恶劣条件下的图像融合

目前的图像融合算法对于极端条件的源图像处理能力不高,针对此类图像研究不多。通常需要先进行曝光修正再进行图像融合。因此,如何实现极端条件的快速图像融合是一个需要解决的问题。

(4)跨分辨率的图像融合

在工程应用中,通常红外与可见光的分辨率是不同且相差较大的。目前大部分算法难以胜任。若先对红外进行超分辨率重构则会延长算法运行时间。因此如何直接融合不同分辨率的图像在实际应用中十分重要。

(5)全面、普适的评估准则

恰当、准确的评估准则对于图像融合的算法性能的评估至关重要,目前的算法研究中,作者缺少合适、权威的准则来对比不同算法的性能。