航空发动机状态监视大数据信息化系统应用技术研究

2022-05-30洪丽谷新宇李兴

洪丽 谷新宇 李兴

摘要:工业大数据可广泛应用于企业整个生产、经营、运营等全生命周期过程,对产品使用大数据的连续地监控参数的变化趋势,提高了故障判断的准确率。本文主要是介绍了航空发动机健康监视大数据平台的架构和应用层功能,并在此基础上接入航空发动机日常运行数据,完成日常使用数据的接入、清洗、治理,完成航空发动机大数据的状态监视、趋势判断和寿命预测等功能。

关键词:航空发动机;状态监视;大数据;信息化

一、引言

随着大数据技术在信息化时代的来临,在面临着巨大的经济效益压力的情况下,决策者们认识到了如何运用大数据技术,通过最贴近现实的数据,对未来进行准确的预测,从而作出正确的生产和运营决策。一些具有远见的企业开始采用云计算、大数据等先进技术,建设智能工厂,提高公司的核心竞争力。

大数据的概念来源于大量的数据,但是二者之间存在着巨大的差异。大量数据着重于数据的数量,而不会对其特征进行特殊的研究。而大数据则描述了数据的传播速率、体积和特征等多种特征。当前人们对大数据的最广义的定义是:海量的数据,不能通过一般的软件工具在特定的时间里收集、分析和管理。大数据的特征可以归纳为“4 V”,即:Volume:海量数据,当前最小的大数据单元通常被视为10-20 TB;Variety:资料种类繁多,包含结构化、非结构化、半结构化的资料;Value:数据的价值密度非常低;Velocity:数据生成和处理的速度很快。

二、航空发动机健康管理信息化大数据平台构建

(一)航空发动机大数据存储及管理技术

1.大数据存储需求

存储航空发动机试验过程中多种数采系统采集的稳态数据、动态数据,试验过程中的孔探数据、试车日志及视频等多源、异构数据。

2.大数据存储结构

HDFS采用三种复制方式保证了数据的安全性和可靠性。在數据平台的存储层次上,它能够处理各种结构化、半结构化、非结构化的大量的历史资料,为大规模、长期、大量的历史资料的储存与使用打下了良好的基础。

例如,对于一次试验的稳态和动态数据文件,数据在进入 HDFS 前会被分割成一系列多个数据块,这些数据块被分别存储于一组数据节点中,由中心服务器(Namenode)执行一个档案的运算,并且中央伺服器还将资料区块转换成特定资料结。在中央伺服器的统一安排下,完成对数据块的创建、删除和复制。同时,为保证数据的完整性,每个文件的数据都要有相应的拷贝。

由于试验数据类型的多样性,大数据平台要实现数据访问的多种形式,其中包含了数据间的关联数据、实时数据和文件数据、图片数据、日志数据、音频和视频等。在各种数据访问要求下,该平台为用户的访问提供了一系列的方法和手段: Flume技术允许多个数据传送点以一对一的方式进行信息聚合,比如将来自不同业务结点的相同类型的记录信息汇集成一个文档,实现一对多的信息发布;实时的资料由一个分布的讯息排队 Kafka存取;利用 Sqoop软件对关系数据库进行全量或定时的逐次提取,还可以以文字文档的形式进行大量的输入;通过Data Stage 或 Oracle GoldenGate实现关系型数据库实时同步,实现 T+0 的实时数据操作层(ODS)。

集成数据预处理的图形化工具,提供工作流的调度实现数据接入和数据流转的抽取、转换、装载(ETL)。同时,分布式文件系统 HDFS 通过 FTP Over HDFS 提供文件通过 FTP 传入 HDFS 的通道;通过 Flume 提供海量日志以及文件的聚汇到大数据平台的功能。

在数据进行接入时,数据平台上的数据传输工具支持加载数据缓存功能。当目标接收端出现问题、网络中断或出现阻塞时,支持将加载数据缓存在本地磁盘中,当目标端恢复后继续将数据加载到目标端中。Flume 或者 Kafka 均支持将消息队列缓存在文件系统上,Flume 支持 failover 机制,Kafka 通过对数据的多份备份,均对加载的数据有相应的可靠性机制以保证数据的安全。

(二)信息化大数据平台构建

TDH大数据平台总体上是以 Hadoop为基础的数据平台体系结构,并将其划分为:数据分析与处理、数据查询及分析。基于大数据中心的数据查询与解析,可以对结构化、半结构化数据进行数据采集,提供数据查询、文本检索、离线批量数据分析等功能;不同数据的处理采取互动的方法。在此基础上,利用实时的流程,能够对数据进行实时的分析与处理。该系统实现了对计算资源、存储资源和数据存取资源的一体化管理,有效地调度和利用计算资源、管理库存资源的限额,对资料存取,有严格的使用权限。在安装、配置、监控、报警等方面,运行管理采用统一的平台。平台整体架构如图1所示。

针对大数据平台的数据存储以及数据分析需求,平台的主要部署方案如下:

1.硬件平台

因为数据处理平台要读取、写入 TB到 PB的数据,同时还要进行大量的数据挖掘模型计算,并进行预测结果的发布,这就要求底层的硬件对磁盘的读取、写入、计算速度都有很高的要求。

另外,为满足分布式、动态扩展的需求,需要具备四个以上的结点,其中至少有一个主结点和三个从结点;各节点均须配备2路8核 CPU,128 GB内存,千兆网络卡。

2.操作系统软件

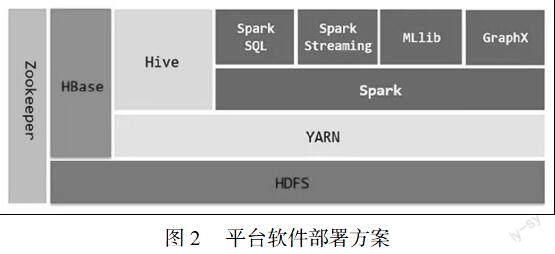

操作系统软件使用 Linux内核操作系统, Hadoop进行大量数据存储和分布式计算, Hive数据清理, Spark数据挖掘引擎, HBase中的预测结果保存,构建高性能、高可用分布式数据收集系统。

(1)利用 Hadoop技术,建立面向 PB的大型数据平台,实现了海量的数据存储和分布运算。

(2)使用 Spark组件,为用户能够在集群中进行交互操作的灵活分布数据集 API。数据挖掘模型采用 Spark onYarn-cluster的方法,构造了一种基于 Spark SQL、 Spark流、 MLlib、 GraphX的大型数据分析引擎。

(3)使用 Hive组件作为数据清理引擎,提供 PB级别的数据预处理、处理和整合服务。

(4)采用 Hbase 组件技术,可以提供海量数据的高效发布。

(5)采用 Zookeeper 组件,提供配置维护、域名服务、分布式同步、组服务等各类应用程序协调服务。

以上服务均使用 docker 技术封装和发布,满足组件快速部署和后续维护需求。

(三)接入结构化数据

在传统的关系数据库如 Oracle,DB2, Mysql, MongoDB等,需要将生成的结构数据移植到 Hadoop平台的 Inceptor表、 Hyperbase表、 Search表中进行数据分析和检索, TDH支持各种结构数据的装载,并提供灵活的、通用的数据格式描述,其中包括数据所含字段、字段的分隔符、字段类型等。

支援传送的带分隔符的元组序列,每一个都具有相同的栏位,并用指定的分隔符隔开。支援的栏位类型有:最多8位元组,浮点数,字符串,日期,时间等。在 Inceptor中定义了相关的表格, Inceptor支持一些常见的简单域,如整形,浮点数,字符串,以及一些复杂的数据类型,如 Map, Array, Struct。

利用 Sqoop产生分布式任务,有效地提取数据,或利用 TDA部件实现数据的准实时插入、更新、删除等数据操作;在 TDH平台上,实时生成的结构化日志或信息被装载到 HDFS、 Search、 Hyperbase、 Kafka等 TDH平台上;数据装入 HDFS,数据处理,数据挖掘,机器学习, Discover。装入 Hyperbase的数据可以在高并行检索中使用 Inceptor进行后模糊或者准确的匹配。载入 Search的资料可以由 Inceptor进行前模糊、后模糊、范围检索、关键词检索、全文检索等。在千兆网络中, Search的存储速度是每秒20000条。

业务系统定义数据格式、数据源(数据库或结构文件)、数据存储(HDFS、搜索、 Hyperbase等)、数据调度模式、数据同步模式等,在 TDH上按照规定的数据装载模式,自动地将数据处理的数据源、中间件(Sqoop, TDA, API/REST API, FTPOverHDFS, JDBC/ODBC, Flume或 Kafka)进行存储和处理等,开始对应的工作流任务或中间件的排程,并监视和记录数据的加载、传输和处理过程。

TDH支持各种结构数据的装入,并支持各种类型的数据格式的灵活、通用,包括数据所含的字段、字段的分隔符、字段类型等。支援传送的带分隔符的元组序列,每一个都具有相同的栏位,并用指定的分隔符隔开。支援的栏位类型有:最多8位元组、浮点数、字符串,日期、时间等。在 Inceptor中定义了相关的表格, Inceptor中支持断点续传、浮点数、字符串以及日期、时间以及 Map;复杂的数据类型,如 Array, Struct。

对于负载平衡,在一种类型的数据装载量很大的情况下,可以通过多个装载的客户端并行装载。Sqoop、 Flume、 Kafka等都是支持多任务并行运行的分布式结构数据收集工具。

Sqoop通过生成和提交 MapReduce程序,实现了对 Task的并行处理;Flume可以通过定义多个代理或多个源通道链接组件,从而实现多个客户端的并行负载;Kafka通过一个定义了并行数据采集程序的 Kafka Producer或多个 Kafka Producer来并行地装载数据。

在万兆网络中,每一个客户端都能支持300 MB/s或更高的加载速率,并能随着集群规模的增长而线性地扩展,直到达到最大的网络传输带宽。装载集群的文字资料总带宽为100 Gb/s或更高。每一台机器装载的最大数据缓冲量为 TB级。最大容量为计算机的存储容量。缓存容量和内存容量呈线性关系。

(四)接入非结构化数据

业务系统生成的各类文档、图片、非结构化的文字等都需要在 TDH上进行存储、检索等处理方法, TDH通過自定义 Flume组件、 API接口,可以将非结构化数据(文档、图像、音视频等多媒体文件)装载到 HDFS或 Hyperbase表中进行处理或高效检索;这样, TDH就可以为0 KB至几 TB的文件提供完全的加载、存储和处理和恢复。

业务系统的数据格式包含数据源(API/REST API、 FTPOverHDFS、 JDBC/ODBC、 Flume等)、数据存储端(HDFS、 Search、 Hyperbase等)、数据调度模式、数据同步模式等,在 TDH上按照规定的数据装载模式,自动地将数据处理的数据源、中间件(API/REST API、 FTPOverHDFS、 JDBC/ODBC、 Flume等)、存储、处理方法等,并对数据的装载、传输、处理过程进行实时监测和记录。

TDH上的各种文本数据,图片,音频的功能;将录像装入到档案中。在 TDH中,可以将无结构性的资料打包为一个对象储存库。在负荷平衡中,一种类型的数据装载数量很大时,可以同时装载多个装载的客户机。Sqoop、 Flume、 Kafka都是支持多个并行运行的分布式体系结构的资料收集。

Sqoop通过创建和递交 MapReduce软件来完成对 Task的平行处理。Flume可以在多个客户机中同时装载多个代理,也可以在分布式体系结构中定义多个代理,也可以使用多个源通道链接部件。Kafka是以平行装入方式,定义了一个同时采集的资料的 Kafka Producer,或是多个 Kafka Producer。将资料存储在 HDFS档案系统中进行存储、分析、挖掘,或是将其存档到 Hyperbase数据库中进行迅速的查询。TDH中的数据装载与传送,具有中断点续传的能力。在故障复原后,在目标接收机的中断点可以持续发送。Kafka中的资料被缓存到磁碟上,其中会将讯息消耗的偏移 offset保存到该伫列中,所以可以将传送中的中断位置进行缓冲,从而确保资料能够继续传送。

万兆网下,每一部服务器都能提供300 MB/s或更高的负载速率,并随着机群的大小而不断地向外扩张,直到达到最大的传输速率。利用对象储存和分散的档案储存功能,可提供1 KB至 PB的资料储存。

(五)接入半结构化数据

TDH支援各种类型的半结构化资料,包括邮件、网页、 XML文件、特定栏位等。利用 Logstash模块实现 TDH中的半结构化数据的装载和加工,并实现了对输入的数据的定制和输出。支持使用 Flume定制的数据界面和简单的数据操作,并把经过加工的资料装入到特定的存储器中;利用 Inceptort SQL对装载在 HDFS中的半结构化数据进行结构化处理,Inceptor可以对 Json、XML/HTML、CSV等进行半结构化的数据进行直接的查询和分析。

在负荷平衡中,一种类型的数据装载数量很大时,可以同时装载多个客户机。Sqoop、 Flume、 Kafka都是支持多个并行运行的分布式体系结构的资料收集。Sqoop通过创建和递交 MapReduce软件来完成对 Task的平行处理。Flume可以在多个客户机中同时装载多个代理,也可以在分布式体系结构中定义多个代理,也可以使用多个源通道链接部件。Kafka是以平行装入方式,定义了一个同时采集的资料的 Kafka Producer,或是多个 Kafka Producer。同时,还能实现多个装入软件之间的多个链接,并实现多个数据的发布和汇集。

(六)高频数据实时传输及存储调度

在数据存贮器的上层,利用 YARN实现了对计算资源的统一调度,实现了对簇的实时生成和销毁,实现了对服务的灵活配置。Inceptor是 SQL的一个通用的 SQL运算引擎,它能够有效地处理各种不同的数据和数据。在资料检索上, Hyperbase提供了一个全域和二级的索引,它可以提供快速的无主关键字的查询,提供了 JSON/BSON的支持,并提供了 Object Store技术, Search可以在 PB的数据级别上进行快速的查找。

另外,还可以为测试数据等实时流量提供低延迟和高吞吐量的实时数据。利用 Kafka的报文排队进行实时的数据流量,实现了不丢失不增加的情况,并提供了一个以微批量和事件为基础的程序设计模式,在保持系统的吞吐量的前提下,将延迟控制在毫秒级别;同时还能确保该算法具有健壮性和可扩展性,适合于其它复杂的、不同的实时数据处理场合。

四、结束语

本文基于飞机发动机运行状況监控大数据的平台,对发动机运行状况进行了分析,得到了发动机转速、振动、温度、压力、流量等参数数据。建立了基于规则的故障诊断模型,通过故障诊断,并对发动机状态恶化的趋势进行了分析;利用零件的剩余使用寿命预报等方法,对其进行故障的预测和诊断。

通过运用大数据进行分析,实现了飞机维修方案的自动化,使维修工作更加有目的性,降低了“过修”、“失修”,节约了维修费用。

作者单位:洪丽 谷新宇 李兴 中国航发南方工业有限公司

参 考 文 献

[1] 邹国伟,成建波.大数据技术在智慧城市中的应用[J].电信网技术, 2013(04).

[2] 栗蔚,魏凯.大数据的技术、应用和价值变革[J].电信网技术, 2013(7).

[3] 中国航发南方工业有限公司 国家重点研发计划年度报告[J].技术报告, 2022.3.

[4] 尉询楷,等.航空发动机预测与健康管理[M].北京:国防工业出版社, 2014.1.