相机与毫米波雷达融合检测农机前方田埂

2021-11-26潘胜权解印山莫锦秋

张 岩,潘胜权,解印山,陈 凯,莫锦秋

相机与毫米波雷达融合检测农机前方田埂

张岩,潘胜权,解印山,陈凯,莫锦秋※

(上海交通大学机械与动力工程学院,上海 200240)

为满足自主作业农机地头转弯的需求,解决单传感器检测获取信息不足的问题,该研究提出了将相机与毫米波雷达所获取数据融合的多传感前方田埂检测方案,利用视觉检测得到田埂形状后辅助滤除毫米波雷达中干扰点进而得到田埂的距离和高度信息。在视觉检测方面,根据前方田埂在图像中的分布特点,提出了基于渐变重采样选取部分点的加速处理方式,并在此基础上利用基于11维颜色纹理特征的支持向量机进行图像分割和基于等宽假设的几何模型特征进行误分类点剔除,然后拟合提取图像中田埂边界。在毫米波雷达检测方面,提出了竖直放置毫米波雷达的检测方式,以克服安装高度与地形颠簸的影响,并获得前方田埂的高度信息。将相机与毫米波雷达获取的数据进行时空对齐后,利用视觉检测结果滤除毫米波雷达干扰点,并将毫米波雷达获得的单点距离信息进行扩展,形成维度上的数据互补,获得前方田埂的形状、距离、高度等更加丰富准确的信息。测试结果表明,在Nvidia Jetson TX2主控制器上,基于视觉的检测平均用时40.83 ms,准确率95.67%,平均角度偏差0.67°,平均偏移量检测偏差2.69%;基于融合算法的检测平均距离检测偏差0.11 m,距离检测标准差6.93 cm,平均高度检测偏差0.13 m,高度检测标准差0.19 m,可以满足自主作业农机的实时性与准确性要求。

农业机械;传感器;数据融合;支持向量机;毫米波雷达;田埂

0 引 言

田埂是区分农田区域与非农田区域或一个农田区域与另一个农田区域的标志。及时准确地获取田埂的位置形状信息是自主导航农机作业的前提,对自主导航农机精准路径规划、不超区规范作业、高效地头转弯等功能起决定性作用。作为自主导航农机三大关键技术之一的主要内容[1],田埂检测越来越受到国内外学者的广泛关注。

田埂可以分为前方田埂和侧向田埂[2],其中前方田埂对自主导航农机转弯起主导性作用。田埂检测的已有研究主要可以分为3类,即基于视觉的检测、基于特征地图的检测和基于测距传感器的检测。基于视觉的检测主要是利用相机获得农田边界的彩色图像,进而得到农田边界线。王侨等[3]将农田边界图像沿水平方向分为8个子区域并求取各子区域灰度跳变特征点,结合稳健回归法线性拟合得到非规整地头的主体延伸线。蔡道清等[4]在超像素分割的基础上利用支持向量机算法对水田田埂图像进行分割后利用霍夫变换提取得到田埂边界。陈兵旗[5]利用Kirsch算子进行微分运算,根据有无长连接成分区分水泥和土质田埂,再分别进行边界线提取。朱淑鑫等[6]在HIS色彩空间利用改进区域分裂算法和Moore边界追踪算法,得到了田间道路边界。Astrand等[7]通过作物行的偏移量和航向角发生异常判断作物行是否结束并到达农田边界。基于特征地图的检测是结合农田完整地图和农机的相对位置判断是否到达农田边界。胡晨[8]在果园地头放置路标,并利用激光雷达得到果园特征地图,从而解决果园作业机器人的地头定位。张永泽[9]利用高精度GPS/BD模块测绘获得地块垄行特征点信息并导入百度地图API,实现植保机器人农田边界转向决策。Zhang等[10]利用无人机搭载相机与GPS模块飞行拼接得到完整农田地图。李延华[11]利用激光雷达和GPS建立果园局部坐标和全局坐标系用于指导机器人在地头处自主转弯。基于测距传感器的检测建立在农田边界线相对农田有明显的凸起特征的前提上,利用超声波、激光等测距传感器感知农田边界。丁筱玲[12]利用激光识别和多自由度运动姿态控制获得地头边缘的位置。陈加栋[13]在无人机平台搭载激光探测系统,通过作物和田埂之间的高度差判断无人机是否到达边界。Vinod等[14]利用声纳进行障碍物与农田边界的检测。

基于视觉的检测具有成本低、信息丰富等优点,但易受光照等条件影响,并且难以获得准确的距离信息;基于特征地图的检测具有准确度较高、环境鲁棒性强的优点,但是成本较高,并且存在定位信号丢失的问题;基于测距传感器的检测成本较低,可以得到农田边界与农机的相对距离,但田埂高度突起要较为明显,并且易受地形起伏的影响。

基于单传感器检测获取的信息较为单一,故越来越多的研究开始聚焦于多传感器融合检测,但其中绝大多数研究主要关注障碍物检测[15-17],并且成本较高,有关低成本传感融合的田埂检测鲜有涉及。根据融合层次的不同,多传感融合可以分为数据级融合、特征级融合和目标级融合[18]。

本文提出一种基于多传感器融合方案,利用相机和竖直放置的毫米波雷达进行数据级融合从而获得前方田埂的详细信息。在视觉检测方面,根据前方田埂在图像中的特点,选取部分重采样点代替全图以加速处理,在此基础上利用基于颜色纹理特征的支持向量机对重采样点进行分类,然后基于几何模型特征的误分类点剔除,快速得到图像中田埂边界线。在毫米波雷达检测方面,根据前方田埂连续存在的特点,将毫米波雷达由传统的水平放置变为竖直放置,以克服安装高度与地面起伏的影响。最后将二者数据进行时空对齐,将毫米波雷达所得数据映射到图像中滤除掉干扰点,再利用图像信息与毫米波雷达信息进行互补,得到前方田埂的形状、距离、高度等更加丰富完善的信息。

1 基于视觉的前方田埂形状检测

由于植被生长与管理方式的不同,田埂区域相对非田埂区域存在一定的颜色与纹理差异,故以颜色纹理特征差异为依据,结合支持向量机(Support Vector Machine, SVM)进行不同区域的图像分类。

1.1 基于颜色纹理特征的SVM前方田埂检测

综合考虑田埂区域与非田埂区域在颜色与纹理上的差异以及计算成本,本文提取了7维颜色特征和4维纹理特征组成11维特征向量,其表达式为

田埂区域相对于非田埂区域有一定程度上的颜色差异,故选择RGB色彩空间内R、G、B三个通道分量的一阶颜色矩作为颜色特征。计算以目标点为中心、×范围内所有点的一阶颜色矩均值。取值过小易受噪声干扰,而取值过大易使颜色特征被均化,故本文取=3,计算公式为

式中p为图像(,)位置处各通道的值。

式中(,)为灰度值对(,)在灰度共生矩阵中出现的频率。

构造完特征后,利用SVM构造超平面使特征空间中不同类样本之间间隔最大[21],要解决的优化问题为

式中为超平面法向量;为超平面位移;为惩罚系数;ξ为松弛因子;y为第个样本的标签;v为第个样本特征向量。

本文于上海市松江区一处未播种的水田中,在晴朗的天气情况下从13∶00到17∶00,以1 h为时间间隔,采集一天中不同时刻的农田原始图像20张,通过人工标注的方式获得田埂样本1 602个,非田埂样本2 356个。随机选择其中的80%为训练集进行SVM模型训练,剩余的20%为验证集进行模型效果的验证。调整相关参数,选择在验证集上表现最好的模型作为输出。图1b为本文训练模型的预测结果,从图中可以看出,田埂区域与非田埂区域基本被准确分割开来。

1.2 基于重采样的加速处理

本文采集的原始图像尺寸为800像素×600像素,在16 GB内存、Intel i7-6700K CPU的计算机上按照本文方法对一幅图像进行预测分割大约需要0.52 s,难以满足自主导航农机的实时性要求。分析图1a的原始农田图像可知,前方田埂在图像中呈现纵向连续分布、横向贯穿全图的特征。基于这一特征,本文提出一种基于重采样的图像加速处理算法。

纵向连续分布指在合适的相机安装角度条件下,单幅图像中只会拍摄到1条田埂,即前方田埂在图像纵向方向是连续分布的,不存在田埂-非田埂-田埂的分布排列。根据这一特点,在图像纵向方向上选取分析间距为d的2个像素点,可以分为如图2a所示3种情况:①2个点都是非田埂点,则二者连线上所有点均是非田埂点;②2个点都是田埂点,则二者连线上所有点均是田埂点;③1个点是田埂点、另一个点是非田埂点,则二者连线之间存在田埂与非田埂的分界线。针对①、②两种情况,无需特别补充判断,针对第三种情况则需利用二分法继续找寻出2点之间的边界位置。

横向贯穿全图是指前方田埂在图像横向方向是贯穿全图存在的,不存在断开的情况。选取合适的横向分析间距d,则可利用2个边界点拟合出二者之间的边界线,如图2b所示。

1.田埂区域 2.非田埂区域 3.非田埂点 4.田埂点 5.边界点

1.Region of ridge 2.Region of non-ridge 3.Non-ridge point 4.Ridge point 5.Boundary point

注:d为纵向分析间距,像素;d为纵向分析间距,像素。

Note:dis the longitudinal analysis spacing, pixel;dis the longitudinal analysis spacing, pixel.

图2 车辆前方田埂图像特征分析

Fig.2 Image feature analysis of ridge in front of vehicle

综合上述2个特点,选取图像中的部分重采样点进行分析即可得到完整的前方田埂位置。考虑到透视效应的影响,图像上部单位像素内包含的信息较多而下部则相对较少。若在纵向方向设计相等的重采样间隔d,d太小无法有效减少待处理数据量,d太大则可能出现上部图像中待分析2点全为非田埂点而2点连线间却存在田埂点的误判情况。本文采用纵向方向重采样间隔d逐渐变化的重采样方式,针对本文采集图像的特点,d取值为

横向方向采用等间隔重采样方式,但不宜过大,以免出现2点无法拟合出实际边界线。本文取d=20像素。

按照上述重采样方法,重采样点选取情况如图3a所示,重采样后需对1 040个像素点进行预测,仅占原始图像像素点总数的0.22%,有效提升检测速度。

1.3 基于几何模型的误分类点剔除

图3b为根据前文所述方法得到的前方田埂边界点位置图,由于误分类点的存在,部分列中出现了2个以上的边界点。根据前述方法可知,同一列中所求得的边界点两两形成二元组,之间连线区域代表田埂。对于部分连线长度过短的二元组,其原因是SVM分类器在非田埂区域对极个别点发生误判,可以按照式(7)进行滤除:

式中1为边界点二元组中靠近图像上部的点所处行坐标;2为边界点二元组中靠近图像下部的点所处行坐标;D为二元组连线长度阈值。

图3c为按上述方法初步滤除误判点后的效果图,大部分误判点都已经被滤除,但仍有少部分无法滤除,为进一步提升视觉检测效果,本文提出进一步利用图像中田埂几何模型特征的方式进行误判点剔除。几何模型是指田埂在图像中呈现一定几何分布特征,现有研究中大多使用条件过强的几何模型假设,难以适用于大多数农田[22-24]。根据调研分析发现,由于目前农田中的田埂大多为人工或机器修筑,故对某一特定田埂而言,不论其形状如何,各个位置都近似等宽及等高,在图像中表现为田埂边界线没有剧烈的曲率变化,故本文提出利用田埂边界线没有剧烈曲率变化的几何模型假设来辅助田埂边界线提取。

当一列中只剩2个边界点后,认为靠近图像上部的点为上边界点,靠近图像下部的点为下边界点。首先利用已经分类正确的边界点拟合出粗略的上边界线方程1rough()和下边界线方程2rough(),如图3d所示。然后对剩余仍存在误判点的列,计算每一个边界点二元组中靠近图像上部的点距1rough()的距离和靠近图像下部的点距2rough()的距离,如式(8)。

式中(i1,j1)为第个二元组中靠近图像上部像素点的坐标;(i2,j2)为第个二元组中靠近图像下部像素点的坐标;d1为第个二元组中靠近图像上部像素点距1rough()在竖直方向距离;d2为第个二元组中靠近图像下部像素点距2rough()在竖直方向的距离。

分别选取d1和d2中最小值对应的点为上下边界点,滤除后结果如图3e所示,可以看出边界点位置基本被准确提取。最后利用所有滤除后的边界点拟合上下边界,如图3f所示。

2 基于毫米波雷达的田埂距离与高度检测

基于视觉的前方田埂检测只能获得前方田埂是否存在及形状等信息,难以得到距离等信息。本文提出一种利用竖直放置的毫米波雷达作为测距传感器获取前方田埂距离、高度信息的检测方案。

相对于激光、超声等测距传感器,毫米波雷达信号穿透性更强、测距范围更大,更适宜在环境复杂的农田中工作[25-27]。毫米波雷达是二维雷达,虽然有一个很小的竖直方向视场角,但无法获取目标高度信息。传统的毫米波雷达使用时通过其较大的本体水平方向视场角测定目标距离、方向,此时毫米波雷达水平固定在一定高度。田埂相对于其他障碍物高度明显偏低,若采用如图4a的水平安装方式检测田埂,由于竖直方向视场角较小,需要将毫米波雷达安装高度设置得非常低。但较低的安装高度极易受到地形起伏影响[28-30],难以有效检测前方田埂。

如图4b所示,竖直放置毫米波雷达相当于将原有的水平视场角与竖直视场角对调,扩大了竖直方向的可视域,使毫米波雷达安装高度更加灵活;水平方向的可视域虽然缩小,但由于前方田埂具有连续存在的特点,毫米波雷达仍可以检测到目标。前方田埂目标点距离计算公式为

式中d为正前方田埂目标点距离,m;ρ为毫米波雷达检测到的田埂距离,m;θ为毫米波雷达检测到的田埂角度,(°)。

同时,根据毫米波雷达返回目标物体质心信息的特点,在已知毫米波雷达安装高度的情况下,还可以额外获得前方田埂的大致高度信息,具体计算公式为

式中h为前方田埂高度,m;h为毫米波雷达相对地面的安装高度,m。

3 基于多传感器数据融合的检测

视觉检测可以获得前方田埂的形状信息,并且可以有效的区分田埂与非田埂区域,但无法得到距离、高度等信息;毫米波雷达检测可以得到正前方的田埂距离与高度信息,但无法获得完整的田埂信息,并难以区分其他非田埂部分产生的干扰点。单独利用某个传感器都难以获得完整的前方田埂信息。因此本文提出一种将相机与毫米波雷达所得数据进行数据级融合的多传感融合解决方案,以补全单一传感器缺失的维度信息,获得更加准确丰富的前方田埂感知结果。

3.1 异构信息时空对齐

进行前方田埂检测时相机、毫米波雷达的采集频率可能不同,可利用时间戳完成时间轴上的对齐。本文中相机的采样频率为10 Hz,毫米波雷达的采样频率为20 Hz,以较低的相机采样频率基准进行时间对齐。

对于相机、毫米波雷达2个不同的传感坐标系,采用将毫米波雷达数据向图像坐标映射的空间对齐方式。毫米波雷达数据利用式(11)向图像坐标系中转换。

相机内参矩阵利用张正友相机标定法即可得到,毫米波雷达坐标系到相机坐标系的转换矩阵利用毫米波雷达反射锥辅助求得。转换矩阵具体计算步骤如下:

2)利用相机拍摄下对应的图片,并人工标注记录反射锥中心在图片中的像素坐标;

3)重复步骤1)、2),记录20组数据;

4)随机选择其中15组数据,以式(12)为目标函数求解毫米波雷达坐标系到相机坐标系转换矩阵参数的非线性优化问题:

本文采用列文伯格-马夸尔特算法对式(12)进行求解;

5)利用剩余5组数据验证得到转换矩阵参数的效果,若满足平均误差要求则保留转换矩阵参数结果;

6)将毫米波雷达旋转90°变为竖直安装,并将步骤5)保留的结果中对应旋转项设置为90°作为最终结果。图5为毫米波雷达数据映射到图像中的结果。

3.2 异维信息互补融合

利用相机得到了前方田埂在图像中的上下边界,将毫米波雷达数据映射到图像后,判断毫米波雷达数据点是否在两边界之间即可滤除掉非田埂部分干扰点。设=(,)为毫米波雷达数据映射到图像后的坐标,如果不满足式(13)则认为点为非田埂干扰点。

式中1()为视觉检测得到的上边界方程;2()为视觉检测得到的下边界方程;R为容差阈值,像素。

综上,利用视觉得到的形状信息可以将毫米波雷达得到的前方田埂单点距离、高度信息中的干扰点进行滤除,利用毫米波雷达可以得到单一视觉检测难以得到的距离高度等几何信息。利用2个二维传感器所得信息进行互补,融合得到了前方田埂的三维信息。

4 试 验

4.1 试验平台

本文使用显微精工XG300高速工业相机配合中联科创VM0612镜头进行图像采集,采集图像的分辨率为800像素×600像素,采集频率为10帧/s。选用的毫米波雷达为大陆ARS404,聚类工作模式。相机与雷达安装在同一竖直轴线,相机在上,竖直放置的雷达在下。雷达安装高度为0.8 m,相机安装高度为1.2 m、向下俯角15°。选用的主控制器为Nvidia Jetson TX2开发板系列产品,编程环境为Ubuntu16.04、OpenCV3.3.1、ROS Kinetic。本文试验数据采集于上海市松江区一片未经播种的水田。

4.2 试验方法

为验证本文提出的竖直放置毫米波雷达检测前方田埂方案的正确性,根据雷达在农机上的常见安装高度与农机行驶过程中因颠簸而产生倾角的范围,将雷达分别安装在距地0.4、0.8、1.2 m的3个不同高度位置处,并在每个高度设置0°、2°、4°的安装俯仰角以模拟农机行驶过程中产生的颠簸。在距前方田埂的3~8 m的范围内以0.1 m为间隔用水平安装和竖直安装2种方式检测田埂,当在真实田埂距离±0.2 m范围内存在雷达得到的目标点,认为雷达检出田埂。

为验证本文所提融合检测算法的正确性,在上海市松江区一片尚未播种的水田采集数据并制作了原始数据集。考虑到过远或过近的距离检测结果对自主导航农机意义不大,故在距离田埂5~10 m的距离处,以0.1 m为距离间隔,利用相机采集50幅田埂原始图像并保存对应时刻雷达得到的目标点信息,同时利用卷尺测量对应位置处雷达中心距田埂的直线距离作为田埂距离真实值。考虑到光照、距离等因素对视觉检测有一定影响,从下午13∶00到下午17∶00,以1 h为时间间隔,在距离田埂约3、11、13、15 m的每个位置利用相机补充拍摄5张田埂图片,共计100张图片。通过人工标注得到每一张图片的田埂上下边界位置,形成具有150张原始图片、300条田埂边界真实位置、其中50张图片包含对应位置雷达目标点与田埂真实距离的原始数据集。对原始数据集利用本文算法进行数据处理,认为雷达所得数据向图像中转化后落在视觉检测得到的上下边界之间的目标点为检测有效,计算融合算法检测成功得到的前方田埂距离和高度与真实距离和高度的均值与方差,若无目标点落在图像田埂区间内,则认为检测结果无效。

4.3 评价指标

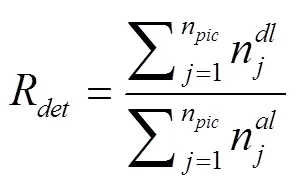

对所拍摄的农田原始图像进行人工标注作为农田边界线的真实值,本文定义检测率为

由于真实边界均为直线,故认为满足如下关系时检测边界有效:

4.4 结果与分析

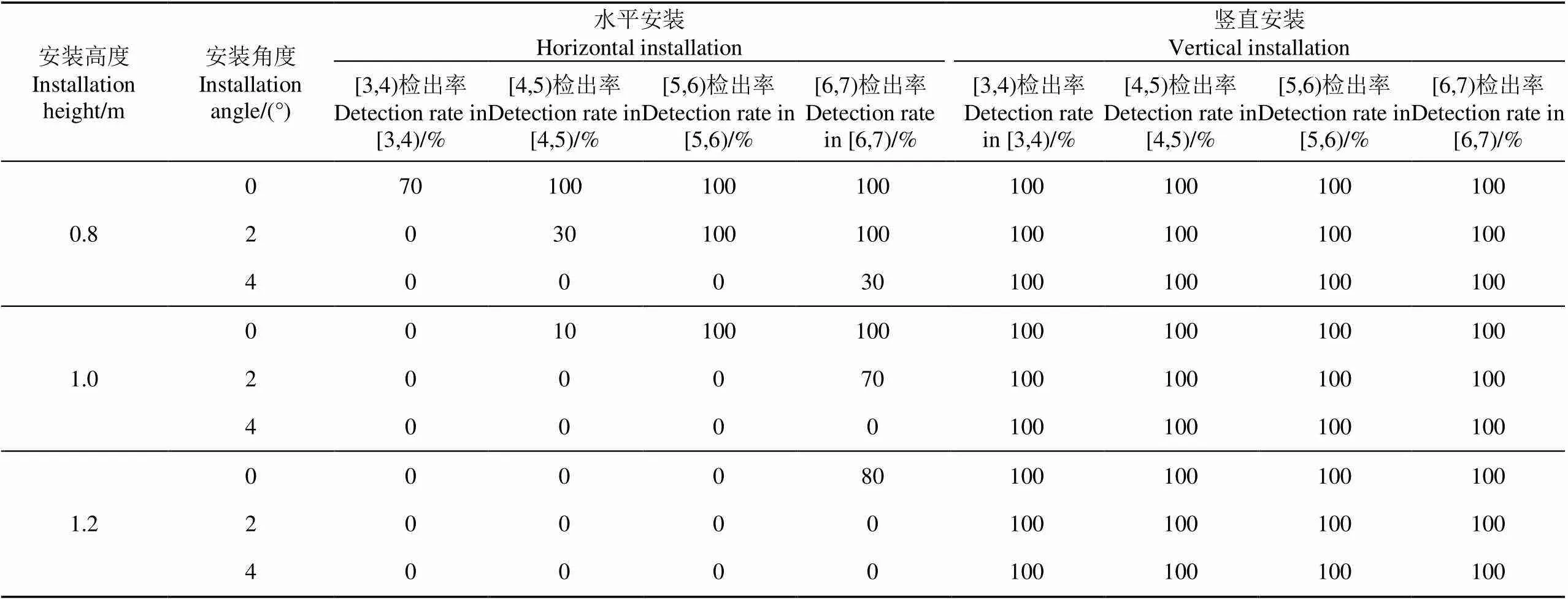

竖直放置毫米波雷达检测前方田埂结果如表1所示,从表1数据分析可知,随着雷达高度升高,水平安装的检测方式受垂直方向可视域较小的限制难以有效检测到近距离的田埂,但竖直安装的方式则不受安装高度的影响。当农机因颠簸产生一个俯仰角度后,水平安装方式极易丢失目标,但竖直安装方式仍能正常工作。说明本文提出的竖直安装雷达的田埂检测方式可以有效克服安装高度与地形起伏的影响,满足自主导航农机的需求。

表1 不同雷达安装方式田埂检测结果

注:[3,4)代表车辆前方田埂位于雷达中心前3~4 m的范围内,其他以此类推。下同。

Note: [3,4) means that ridge in front of vehicle is within the range of 3-4 m in front of the radar center, and so on. The same below.

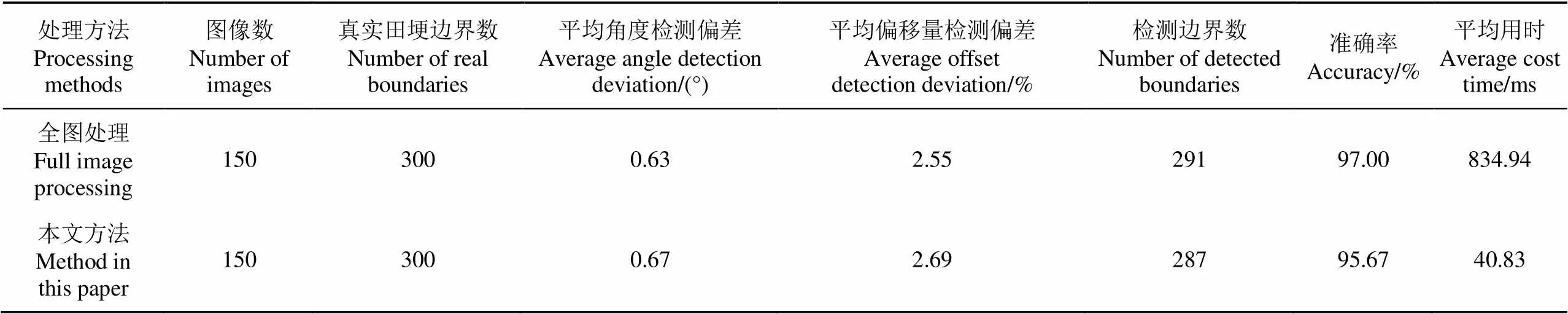

在原始数据集上,分别利用传统的基于全图处理的SVM视觉检测方法和本文提出的视觉检测方法进行检测,取θ=2°、E=1.05%,检测结果如表2所示。从表中可以看出,相对于全图处理的方式,本文方法虽然在准确率、平均角度和平均偏移量上损失了1.33个百分点,0.04°和0.04个百分点,但是检测速度提升了794.11 ms,在满足准确率要求的前提下有效减小了对主控制器的要求,满足自主导航农机的实时性作业要求。

表2 不同处理方式田埂视觉检测结果

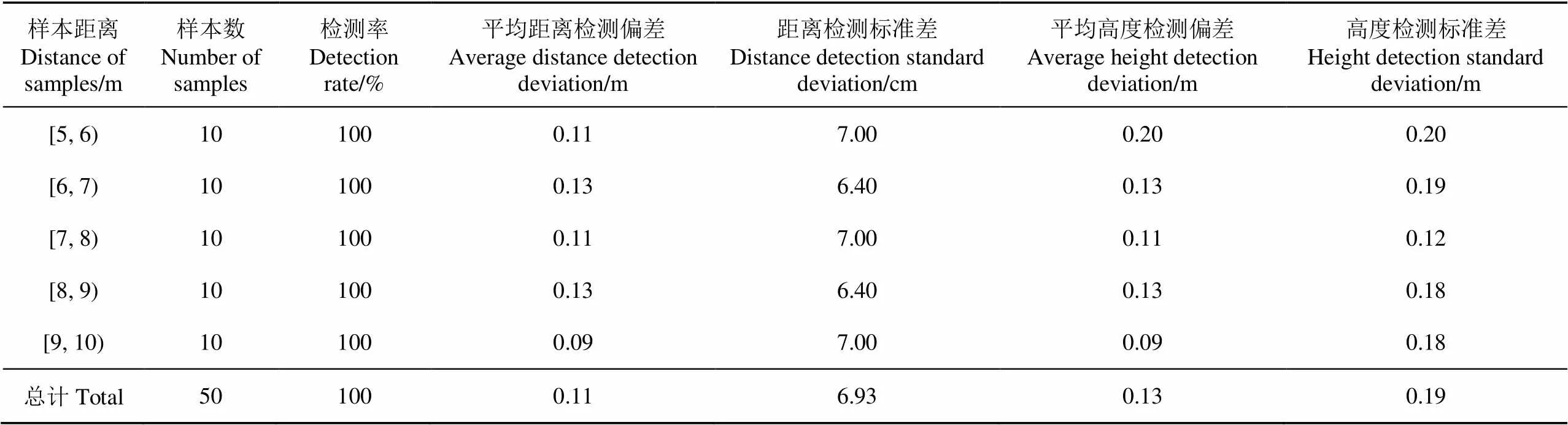

融合检测算法结果如表3所示,从表中分析可知,在不同距离区间内,本文提出的融合检测算法均可有效将视觉检测结果与雷达检测结果相融合,在50次样本验证中,融合检测率为100%,不存在视觉检测结果与雷达检测结果无法匹配的情况。在距离检测方面,不同距离区间内的平均距离检测偏差大致在0.09~0.13 m范围内波动,并且各区间内距离检测标准差在10-2量级,说明检测结果离散程度小,可以满足自主导航农机的作业精度要求。在高度检测方面,不同距离区间内的平均高度检测偏差大致在0.09~0.20 m范围内波动,可以为自主导航农机作业提供有效的前方田埂近似三维信息。

表3 融合算法检测结果

5 结 论

1)提出了基于单目相机与竖直放置毫米波雷达进行融合的多传感融合田埂检测方案,使相机与毫米波雷达的所获取的数据进行互补,利用2个二维度传感器近似得到了三维信息。

2)在视觉检测中使用基于颜色纹理特征的SVM检测和基于渐变重采样的田埂分割加速算法,在Nvidia Jetson TX2上准确率95.67%,平均角度检测偏差0.67°,平均偏移量检测偏差2.69%,平均用时40.83 ms,可以满足农机自主导航的准确性和实时性要求。

3)在雷达检测中,提出竖直放置毫米波雷达的检测方式,有效解决了测距传感器受安装高度与地形起伏影响的问题,同时获得了田埂高度的信息。

4)基于融合信息的检测方法,距离检测偏差0.11 m,高度检测偏差0.13 m,可以满足农机自主导航的准确性要求。

[1] 张漫,季宇寒,李世超,等. 农业机械导航技术研究进展[J]. 农业机械学报,2020,51(4):1-18.

Zhang Man, Ji Yuhan, Li Shichao, et al. Research progress of agricultural machinery navigation technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(4): 1-18. (in Chinese with English abstract)

[2] 张磊,王书茂,陈兵旗,等. 基于机器视觉的麦田边界检测[J]. 农业机械学报,2007,38(2):111-114.

Zhang Lei, Wang Shumao, Chen Bingqi, et al. Edge detection for wheat field based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2007, 38(2): 111-114. (in Chinese with English abstract)

[3] 王侨,刘卉,杨鹏树,等. 基于机器视觉的农田地头边界线检测方法[J]. 农业机械学报,2020,51(5):18-27.

Wang Qiao, Liu Hui, Yang Pengshu, et al. Detection method of headland boundary line based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(5): 18-27. (in Chinese with English abstract)

[4] 蔡道清,李彦明,覃程锦,等. 水田田埂边界支持向量机检测方法[J]. 农业机械学报,2019,50(6):22-27,109.

Cai Daoqing, Li Yanming, Qin Chengjin, et al. Detection method of boundary of paddy fields using support vector machine[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(6): 22-27, 109. (in Chinese with English abstract)

[5] 陈兵旗. 农田作业视觉导航系统研究[J]. 科技导报,2018,36(11):66-81.

Chen Bingqi. Study on vision navigation for field work[J]. Sience and Technology Review, 2018, 36(11): 66-81. (in Chinese with English abstract)

[6] 朱淑鑫,谢忠红,徐慧,等. 基于机器视觉的田间道路检测方法[J]. 江苏农业学报,2013,29(6):1291-1296.

Zhu Shuxin, Xie Zhonghong, Xu Hui, et al. An approach to field path detection based on computer vision[J]. Jiangsu Journal of Agricultural Sciences, 2013, 29(6): 1291-1296. (in Chinese with English abstract)

[7] Astrand B, Baerveldt A J. A vision based row-following system for agricultural field machinery[J]. Mechatronics, 2005, 15(2): 251-269.

[8] 胡晨. 果园作业机器人定位与地图构建研究[D]. 南京:南京农业大学,2015.

Hu Chen. Research on Localization and Map Building for Robot Working in Orchard[D]. Nanjing: Nanjing Agricultural University, 2015. (in Chinese with English abstract)

[9] 张永泽. 植保机器人作业规划及垄行引导技术研究[D]. 济南:济南大学,2017.

Zhang Yongze. Research on Operation Planning and Row Guide Technology of Plant Protection Robot[D]. Jinan: University of Jinan, 2017. (in Chinese with English abstract)

[10] Zhang M, Li L, Wang A, et al. A novel farmland boundaries extraction and obstacle detection method based on unmanned aerial vehicle[C]//ASABE Annual International Meeting. American Society of Agricultural and Biological Engineers, 2019.

[11] 李延华. 自主移动果园作业机器人地头转向与定位研究[D]. 南京:南京农业大学,2016.

Li Yanhua. Research on Headland Turning and Localization for Automatic Robot Operation in Orchard[D]. Nanjing: Nanjing Agricultural University, 2016. (in Chinese with English abstract)

[12] 丁筱玲. 小麦智能精播系统及自主导航机理研究与实现[D]. 济南:山东大学,2018.

Ding Xiaoling. Research and Implementation of Intelligent Wheat Precision Sowing System and Autonomous Navigation Mechanism[D]. Jinan: Shandong University, 2018. (in Chinese with English abstract)

[13] 陈加栋. 无人直升机喷雾作业高度及边界的激光传感探测研究[D]. 镇江:江苏大学,2016.

Chen Jiadong. Laser Sensor Detection of Operation Height and Boundary in Unmanned Helicopter Spraying[D]. Zhenjiang: Jiangsu University, 2016. (in Chinese with English abstract)

[14] Vinod D N, Singh T. Autonomous agricultural farming robot in closed field[C]//IEEE International Conference on Recent Trends in Electronics, Information & Communication Technology (RTEICT). IEEE, 2018: 1-7.

[15] 何勇,蒋浩,方慧,等. 车辆智能障碍物检测方法及其农业应用研究进展[J]. 农业工程学报,2018,34(9):21-32.

He Yong, Jiang Hao, Fang Hui, et al. Research progress of intelligent obstacle detection methods of vehicles and their application on agriculture[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of CSAE), 2018, 34(9): 21-32. (in Chinese with English abstract)

[16] 方华丽,吴晴. 移动机械手主动防碰撞控制系统研究:基于多传感信息融合[J]. 农机化研究,2019,41(11):234-238.

Fang Huali, Wu Qing. Research on active anti-collision control system for mobile manipulator based on multi sensing information fusion[J]. Journal of Agricultural Mechanization Research, 2019, 41(11): 234-238. (in Chinese with English abstract)

[17] Liu M, Chen J, Zhao X, et al. Dynamic obstacle detection based on multi-sensor information fusion[J]. IFAC-PapersOnLine, 2018, 51(17): 861-865.

[18] 孙宁. 基于多源信息融合的智能汽车环境感知技术研究[D]. 镇江:江苏大学,2018.

Sun Ning. Research on Environment Perception Technology for Intelligent Vehicle Based on Multi-Source Information Fusion[D]. Zhenjiang: Jiangsu University, 2018. (in Chinese with English abstract)

[19] 翟瑞芳,方益杭,林承达,等. 基于高斯HI颜色算法的大田油菜图像分割[J]. 农业工程学报,2016,32(8):142-147.

Zhai Ruifang, Fang Yihang, Lin Chengda, et al. Segmentation of field rapeseed plant image based on gaussian HI color algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of CSAE), 2016, 32(8): 142-147. (in Chinese with English abstract)

[20] 李明,黄愉淇,李绪孟,等. 基于无人机遥感影像的水稻种植信息提取[J]. 农业工程学报,2018,34(4):108-114.

Li Ming, Huang Yuqi, Li Xumeng, et al. Extraction of rice planting information based on remote sensing image from UAV[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of CSAE), 2018, 34(4): 108-114. (in Chinese with English abstract)

[21] 梁习卉子,陈兵旗,李民赞,等. 基于HOG特征和SVM的棉花行数动态计数方法[J]. 农业工程学报,2020,36(15):173-181.

Liang Xihuizi, Chen Bingqi, Li Minzan, et al. Method for dynamic counting of cotton rows based on HOG feature and SVM[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of CSAE), 2020, 36(15): 173-181. (in Chinese with English abstract)

[22] 张明杰. 基于航空影像的平坦区田埂界线识别与提取研究[D]. 北京:中国矿业大学,2015.

Zhang Mingjie. Study of Plain Farmland Ridge Boundary Recognition and Extraction Based on Aerial Image[D]. Beijing: China University of Mining and Technology, 2015. (in Chinese with English abstract)

[23] 周俊,姬长英. 基于知识的视觉导航农业机器人行走路径识别[J]. 农业工程学报,2003,19(6):101-105.

Zhou Jun, Ji Changying. Road recognition for agricultural robot guided by machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of CSAE), 2003, 19(6): 101-105. (in Chinese with English abstract)

[24] Hiremath S, van Evert F K, ter Braak C, et al. Image-based particle filtering for navigation in a semi-structured agricultural environment[J]. Biosystems Engineering, 2014, 121: 85-95.

[25] 兰玉彬,王林琳,张亚莉. 农用无人机避障技术的应用现状及展望[J]. 农业工程学报,2018,34(9):104-113.

Lan Yubin, Wang Linlin, Zhang Yali. Application and prospect on obstacle avoidance technology for agricultural UAV[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of CSAE), 2018, 34(9): 104-113. (in Chinese with English abstract)

[26] 吴开华,孙学超,张竞成,等. 基于高度融合的植保无人机仿地飞行方法研究[J]. 农业机械学报,2018,49(6):17-23.

Wu Kaihua, Sun Xuechao, Zhang Jingcheng, et al. Terrain following method of plant protection UAV based on height fusion[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(6): 17-23. (in Chinese with English abstract)

[27] 孙学超. 基于毫米波雷达的植保无人机仿地飞行技术研究[D]. 杭州:杭州电子科技大学,2018.

Sun Xuechao. Research on Terrain Following Technology of Plant Protection UAV Based on Millimeter Wave Radar[D]. Hangzhou: Hangzhou Dianzi University, 2018. (in Chinese with English abstract)

[28] Roviramás F, Saizrubio V, Millot C. Sonar-based aid for the execution of headland turns by a vineyard robot[C]// American Society of Agricultural and Biological Engineers Annual International Meeting, 2016: 1-9.

[29] Andersen J C, Ravn O, Andersen N A. Autonomous rule based robot navigation in orchards[J]. IFAC Proceedings Volumes, 2010, 43(16): 43-48.

[30] Subramanian V, Burks T F. Autonomous vehicle turning in the headlands of citrus groves[C]// ASABE Annual International Meeting, 2017: 1.

Detection of ridge in front of agricultural machinery by fusion of camera and millimeter wave radar

Zhang Yan, Pan Shengquan, Xie Yinshan, Chen Kai, Mo Jinqiu※

(,,200240,)

Detection of the front ridge is an important step for navigation and path planning of autonomous agricultural vehicles. In single sensor detection, it is hard to acquire enough information, such as shape, distance, and height, because of the complex environment in the field. In this study, the novel detection of the front ridge was proposed to integrate the camera and millimetre-wave radar. The camera was used to collect the shape, while the radar was used to collect the distance and height of the front ridge. More detailed information of the front ridge was achieved after fusion of the data acquired by the camera and millimetre-wave radar. In visual detection, the distribution characteristics of the front ridge were used in the images, while the gradient resampling was used to accelerate image processing. Only less than 1% of the total needed to be processed. A support vector machine (SVM) was then applied with 11-dimensional colour-texture features in image segmentation. The 11-dimensional colour-texture features contained three-dimensional colour features in RGB colour space, four-dimensional colour features in HSI colour space, and four-dimensional texture features in gray level co-occurrence matrix, indicating both colour and texture features of the front ridge. Furthermore, the equal-width hypothesis of the geometric feature was used to obtain a more accurate shape of the front ridge. The equal-width hypothesis referred to that there were no sharp curvature changes of the front ridge in the images. Some misjudgement points were filtered in this hypothesis. Millimetre-wave radar was installed vertically in the millimetre-wave radar detection. Compared with the common horizontal one, the vertical installation was used to ensure the installation height and bumpy ground, while the height of ridge at the same time. In fusion detection, the millimetre-wave radar data was transferred to the image coordinate system via coordinate transformation formula and pinhole imaging model. The visual detection was then used to filter interference points in the millimetre-wave radar data. An accurate distance of the front ridge was captured, and the interference points in the millimetre-wave radar data were filtered easily using the coupled camera and millimetre-wave radar. Both camera and millimetre-wave radar were two-dimensional sensors, but after fusion, the three-dimensional information was achieved, like shape, distance, and height of the front ridge. The camera and millimetre-wave radar enhanced each other. The radar was placed at different heights and angles in both horizontal and vertical installation, in order to verify the vertical placement of radar. Tests showed that the horizontal installation was greatly affected by the installation height and terrain turbulence, but the vertical installation effectively overcame these effects. A dataset was recorded to verify the correctness of fusion, including 300 images and 50 groups of fusion data with different distance and shooting angles of the front ridge. The test was performed on the Nvidia Jetson TX2 hardware platform, where the visual detection spent 40.83 ms per image, and the accuracy was 95.67%, the average angle deviation was 0.67°, the average offset deviation was 2.69%. The accuracy was slightly reduced by 1.33%, the average angle deviation was slightly reduced by 0.04°, the average offset deviation was slightly reduced by 0.14 percentage points, but the detection speed was improved by 794.11 ms, compared with the traditional whole image processing. The average deviation of distance detection was 0.11 m in fusion detection, the standard deviation of distance detection was 6.93 cm, and the average deviation of height detection was 0.13 m. Consequently, the standard deviation of height detection was 0.19 m. The fusion detection of the camera and millimetre-wave radar can meet the requirements of real-time and accuracy for autonomous agricultural vehicles.

agricultural machinery; sensors; data fusion; support vector machine; millimeter waves radar; ridge

张岩,潘胜权,解印山,等. 相机与毫米波雷达融合检测农机前方田埂[J]. 农业工程学报,2021,37(15):169-178.doi:10.11975/j.issn.1002-6819.2021.15.021 http://www.tcsae.org

Zhang Yan, Pan Shengquan, Xie Yinshan, et al. Detection of ridge in front of agricultural machinery by fusion of camera and millimeter wave radar[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(15): 169-178. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.15.021 http://www.tcsae.org

2021-06-10

2021-07-18

国家重点研发计划项目(2019YFB1312301)

张岩,研究方向为机电系统集成、机器视觉。Email:zhangyansjtu@sjtu.edu.cn.

莫锦秋,博士,副教授,博士生导师,研究方向为机电系统集成控制。Email:mojinqiu@sjtu.edu.cn.

10.11975/j.issn.1002-6819.2021.15.021

S224

A

1002-6819(2021)-15-0169-10