中国大学生动态情绪面孔库的构建*

2021-10-09刘俊材冉光明胡艳红余晓惠张琼之

刘俊材 冉光明** 张 琪 胡艳红 余晓惠 张琼之 杨 蝶

(1西华师范大学教育学院心理系,南充 637002;2西华师范大学学前与初等教育学院,南充 637002)

1 引 言

面孔是人类人际交往过程中最常见的视觉刺激之一,包含着丰富的社会信息,比如个体的情绪、种族、性别和年龄等(张琪,尹天子,冉光明,2015)。长久以来,对于情绪面孔的研究是学界关注的热点。大量的学者运用行为学、事件相关电位(ERP)和脑成像的方法探究了人类的情绪面孔识别(比如,Fan et al.,2015;Li,Zhu,Ding,Ren,& Luo,2019;Luo,Feng,He,Wang,& Luo,2010)。值得注意的是,在日常生活中,我们面对的面孔是动态而非静态的,因此,准确识别他人的动态情绪面孔对于个体的生存以及人际交往更加重要。

近年来,大量研究者开始对动态面孔表情进行研究,实验结果发现,较静态情绪面孔而言,个体在识别动态情绪面孔时表现出较好的识别能力(Sarkheil,Goebel,Schneider,& Mathiak,2013;Thornton,Mullins,& Banahan,2011),即动态面孔表情的优势效应(张琪等,2015)。研究显示,动作可以提高面部情绪归因的准确性(Wallraven,Breidt,Cunningham,& Bülthoff,2008;Wehrle,Kaiser,Schmidt,& Scherer,2000)。当静态信息受到限制时(如结构、空间或其他信息的缺失),面孔运动的优势作用最为明显(Fiorentini & Viviani,2011;Krumhuber,Kappas,& Manstead,2013)。动态面孔表情优势效应的一种可能解释是一个动态序列由多个静态图像组成,因此,优势效果可以归因于静态信息量的增加。但研究表明,与包含相同帧数的多静态情绪面孔相比,动态情绪面孔的识别效果明显更好(Ambadar,Schooler,& Cohn,2005)。事实上,动态面孔表情优势效应并不仅仅来自于运动信号的存在,还来自于嵌入表情的时间序列中的特征信息,包括运动方向(Bould,Morris,& Wink,2008)、运动速度(Hill,Troje,& Johnston,2005)、嵌入信息的质量(Cosker,Krumhuber,& Hilton,2010)等,都会影响感知者对情绪的识别。

除了在情绪识别准确性方面的促进作用,面孔运动已被证明有助于情绪判断和行为反应。首先,面孔运动有助于对情绪强度和刺激的判断。研究一致表明,动态情绪面孔比静态情绪面孔更强烈和更现实(Biele & Grabowska,2006;Cunningham & Wallraven,2009)。Yoshikawa和Sato(2008)的研究发现了动态情绪面孔的表征动量效应出现:被试最后看到的动态刺激图像比实际呈现的图像具有更强的情绪强度;面孔运动的速度增加越多,对面部表情知觉图像的强化程度越高。其次,观察者在判断表情的真实性时对动态信息也很敏感。有支持性的证据表明,时间动态影响个人的评级、行为意图和观察者的决定(Krumhuber,Manstead,& Kappas,2007)。Namba,Kabir,Miyatani和Nakao(2018)最近的研究发现,与静态情绪面孔相比,参与者更善于区分动态情绪面孔的真实性。最后,面孔运动可以提高面孔模仿能力。研究显示,动态情绪面孔比静态情绪面孔导致更强烈和更频繁的面孔模仿(Sato & Yoshikawa,2007;Krumhuber et al.,2013)。有研究运用面部肌电扫描技术(EMG)发现,感知者在知觉动态情绪面孔时皱眉肌、颧大肌和轮匝肌等的运动程度显著增强(Korb,With,Niedenthal,Kaiser & Grandjean,2014;Sato,Fujimura,Kochiyama & Suzuki,2013),进一步证实动态情绪面孔的呈现的确促进了知觉者的面孔模仿。

伴随着功能性磁共振成像(fMRI)等认知神经科学技术的快速发展,越来越多的学者开始借助该技术来探讨动态情绪面孔识别的神经机制。这些研究总体勾勒出了动态情绪面孔识别的神经机制框架。在动态面孔表情优势效应的神经网络中,存在一个核心的神经网络,即颞—枕相关脑区的连接(Foley,Rippon,Ngoc Jade,Longe,Senior,2012;Haxby,Hoffman,& Gobbini,2000)。由核心神经网络向外延伸的相关脑区被称为扩展的神经网络,该网络被发现正沿着两个方向扩展,一是向颞—枕核心脑区之外的广大皮层相关脑区扩展,Sato,Toichi,Uono和 Kochiyama(2012)的研究用动态自然面孔作为刺激材料发现涉及额下回(inferior frontal gyrus,IFG),而Sarkheil等人(2013)利用变形软件模拟出来的卡通面孔则发现顶下小叶(inferior parietal lobule,IPL)显著激活,二是向皮层下的脑区扩展,主要与杏仁核(amygdala)有关(Sato,Kochiyama,Uono,& Yoshikawa,2010)。核心的神经网络主要负责早期的知觉编码和刺激的运动加工,而延伸网络与个体的面孔模仿、刺激的动态表征等有关(张琪等,2015)。

综上所述,大量的研究者运用行为和认知神经科学的方法考察了个体对他人动态情绪面孔的识别。但以往的研究存在两方面的问题。首先,一部分研究者使用的情绪面孔材料是用变形软件模拟出来的动态卡通面孔,尽管此种材料与静态图片相比在生态效度方面确有较大的改善,但仍与现实刺激存在较大差距,难以生动鲜活地表达情绪。其次,尽管国外已经建立了诸多动态情绪面孔库,比如Cohn-Kanade动态面孔表情库(CK+)(Lucey,Cohn,Kanade,Saragih,Ambadar,& Matthews,2010)、阿姆斯特丹动态面孔表情库(ADFES)(Van der Schalk,Hawk,Fischer,& Doosje,2011)和伯明翰大学3D动态面孔表情库(BU-4DFE)(Yin,Chen,Sun,Worm,& Reale,2008)等,但至今还没有较为完善的中国人动态情绪面孔库。众所周知,情绪刺激材料具有社会文化差异,国外刺激材料不能直接应用于国内研究。以往研究发现人类在识别情绪面孔时会表现出面孔种族效应(Other-race effects),即识别异族面孔比识别本族面孔更困难(Malpass & Kravitz,1969)。中国在政治、经济、历史文化等多方面都与西方国家有显著差异,有必要制备适用于本土研究的情绪刺激材料。因此,有国内研究者初步建立了中国面部表情视频系统(CFEVS)(杜经纶等,2007)。CFEVS的相关研究取得了丰硕的成果,但仍有些方面值得完善。首先,CFEVS纳入了喜悦、悲伤和中性表情视频,而未纳入愤怒、恐惧、厌恶和惊讶等热点研究情绪类型。其次,在视频维度方面,CFEVS只考察了视频的愉悦度和唤醒度,而未评定视频的优势度、吸引力和可信度。最后,CFEVS中的视频持续时间为3秒,这种持续时间较长的视频材料不适合ERP研究。因此,亟待建立更完善的中国人动态情绪面孔库。

2 对象与方法

2.1 对象

招募67名自愿者(男31名,女36名,18~24岁,M=19.6岁)参与动态情绪面孔的表演。招募207名被试(男101名,女106名,17~28岁,M=21.1岁)参与动态情绪面孔的评定。所有被试视力或矫正视力正常,无精神疾病,实验后获得相应实验报酬。参与表演的被试均需面部无明显创伤,并签署肖像权使用协议书。

2.2 视频采集

当前研究拍摄的动态情绪包括愤怒、厌恶、恐惧、高兴、伤心、惊讶和中性7种。每种情绪被试需表演两遍。第一遍,让表演者想象符合某种情绪的情境以唤起这种特定的情绪。在进行表演时,没有告诉表演者应该完成什么样的面部动作,这有助于表现情绪面孔的特异性(龚栩,黄宇霞,王妍,罗跃嘉,2011)。第二遍,通过情感描述性语句、访谈和短视频等诱发情绪(Bänziger & Scherer,2007;Girard,Cohn,Mahoor,Mavadati,& Rosenwald,2013)。拍摄前,表演者需摘掉耳环和项链等。拍摄时,仅采集上半身齐肩素材,要求表演者坐在椅子上表演以减少无关动作,每次表演均要求在3至5秒内完成。所有拍摄的视频用EDIUS7进行统一处理,去除耳朵、头发和脖子等外部特征,只保留眼、鼻、口和面颊等内部特征(彭小虎,罗跃嘉,魏景汉,王国锋,2003;王妍,罗跃嘉,2005)。为了满足ERP和fMRI实验对时间分辨率的不同要求,每段视频剪辑为1秒和3秒两种,存储为MP4格式。

2.3 视频筛选

2.3.1 筛选程序

第一步,课题组4名成员对拍摄的1876段情绪面孔视频进行粗选。粗选的目的是排除4名成员一致认为具备以下特征的视频:(a)明显不能表达情绪,(b)面部特征过于明显,(c)面部存在其他外部特征。第二步,制备评价手册。当前研究采用自我评价模式(SAM)对动态情绪面孔的愉悦度、唤醒度、优势度、吸引力和可信度进行评定。每个等级评定量表中的等级范围为1~9,1代表每个维度的最小值,而9则表示每个维度的最大值。(白露,马慧,黄宇霞,罗跃嘉,2005;张妍,孔繁昌,陈红,向燕辉,高笑,陈敏燕,2010;王秀娟,王娜,韩尚锋,刘燊,张林,2018)。第三步,进行评测的举例讲解,安排被试练习并分析被试的练习效果。确保被试了解视频材料和研究任务,能完全理解整个流程并建立了准确的判断标准和评分尺度。第四步,正式实验,让被试对每段情绪面孔视频的各项指标进行评定。原则上根据即时感受打分,不做长时间思考,每评定60段视频休息一次。第五步,前人研究(王妍,罗跃嘉,2005;Wang & Markhma,1990)和粗选中均发现评分者在进行多种情绪面孔判断时易混淆,因此研究对易混淆的动态视频(比如愤怒、厌恶、惊讶和恐惧)进行了再评价。

2.3.2 数据处理和统计分析

当前研究首先统计了情绪面孔视频的认同率(被试对动态面孔情绪类型认可的概率)。以往的研究认为认同率大于70%的情绪面孔即是该情绪的真正表情(Erwin et al,1992;Rojahn,Gerhards,Matlock,& Kroeger,2000)。但有研究指出大学生对恐惧情绪判断的认同率达到40%就可认为是真实的恐惧表情(乔建中,1998)。因此,当前研究将认同率低于50%的恐惧视频排除,将认同率低于70%的其他情绪类型视频筛除。然后,运用SPSS25.0对情绪面孔视频的各维度评分进行内部一致性信度分析、描述统计、相关分析和性别的差异性检验。

3 结 果

3.1 筛选结果

当前研究最终获得1421段有效的情绪面孔视频。持续时间为1秒的视频701段,包括130段高兴、88段愤怒、99段厌恶、11段恐惧、85段悲伤、162段惊讶和126段中性视频。持续时间为3秒的视频720段,其中高兴130段、愤怒97段、厌恶102段、恐惧10段、悲伤102段、惊讶157段以及中性122段。

3.2 内部一致性信度

当前研究对情绪面孔视频的愉悦度、唤醒度、优势度、吸引力和可信度评分进行了内部一致性信度分析。结果发现持续时间1秒视频的内部一致性信度系数为:0.961(愉悦度)、0.956(唤醒度)、0.976(优势度)、0.973(吸引力)和0.971(可信度),持续时间为3秒的视频五个维度的内部一致性信度系数依次为:0.971、0.983、0.960、0.984和0.970。

3.3 评定结果

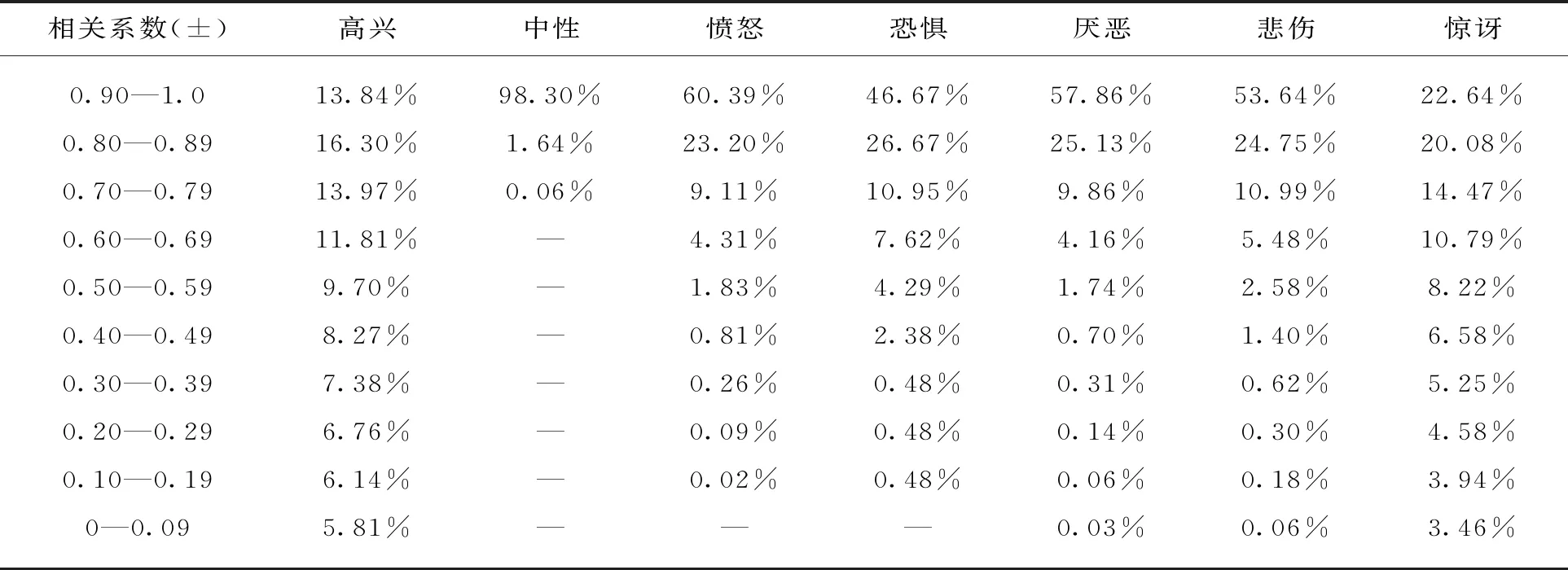

表1呈现了持续时间为1秒和3秒的情绪面孔视频在愉悦度、唤醒度、优势度、吸引力和可信度上得分的平均数和标准差。相关分析结果详见表2(同一情绪类别下的面孔视频评分在不同相关性上的比例)、表3(不同情绪间面孔视频评分在同一维度上的相关性)和表4(1秒和3秒情绪面孔视频在各维度上的相关)。如表5的差异性检验结果所示,个体在评定1秒视频时,男性被试的愉悦度、可信度和优势度评分显著比女性高,而女性被试的吸引力和唤醒度评分显著比男性高。在评定3秒视频时,男性被试的各个维度评分均显著高于女性。

表1 1秒和3秒情绪面孔视频在各维度上的平均数和标准差(s)

表2 同一情绪类型下面孔视频评分在不同相关性上的比例

表3 不同情绪间面孔视频评分在同一维度上的相关

表4 1秒和3秒情绪面孔视频在各维度上的相关

表5 1秒和3秒情绪面孔视频在各维度上的性别差异

4 讨 论

当前课题初步完善了中国大学生动态情绪面孔库(Chinese Undergraduate Dynamic Affective Facial Database,CUDAFD)。研究对每段面孔视频的情绪类型、愉悦度、唤醒度、优势度、吸引力和可信度进行了评定,共纳入1421段有效情绪面孔视频,其中持续时间为1秒的视频701段,持续时间为3秒的视频720段。这保证了学者们有足够数量的情绪面孔视频材料用于科学研究。

内部一致性信度分析表明,被试对视频的评分可信度高,这与以往的研究是一致的(白露等,2005)。相关分析显示,同一情绪类别下的面孔在评分上具有较高的相关性,而不同情绪间的面孔在评分上相关性较低,说明被试评分的效度较高,被试所评价的结果能有效反映动态面孔所传递的情绪。同时,面孔的愉悦度、唤醒度、优势度、吸引力和可信度之间显著相关,这说明五个维度之间存在一定关联。因此,在采用本库中的情绪面孔视频进行某个维度的研究时,需严加控制其他维度。比如,研究者为了研究个体对不同情绪类型动态面孔的识别,选用了一组高兴和愤怒的情绪面孔视频。研究者需要确保高兴和愤怒组中的视频之间在愉悦度上存在显著差异,而在其他维度上差异不显著。此外,当前研究发现评分者性别会影响其评分,这一发现在杜经纶(2007)的研究中也被观察到。性别差异性检验表明,1秒视频的愉悦度、可信度和优势度得分男性显著比女性高,而女性被试的吸引力和唤醒度评分显著比男性高。此外,3秒视频的各个维度评分男性均显著高于女性。

当前研究具有以下三方面的优点。第一,纳入的情绪类型丰富。本库中的动态情绪面孔包括高兴、愤怒、厌恶、恐惧、悲伤、惊讶和中性七种情绪,这弥补了以往视频库中情绪类型偏少的不足(杜经纶等,2007)。第二,视频特征评定的维度多。研究对本库中的动态情绪面孔进行了愉悦度、唤醒度、优势度、吸引力和可信度的评定,丰富的数据为从事科学研究提供了便利,节约了研究时间和成本。第三,视频持续时间符合研究实际要求。纳入本库的动态情绪面孔包括持续时间为1秒和3秒两种,前者较适合于ERP研究,而后者可用于fMRI实验。

同时,本库存在几个方面的不足。首先,正如前文所述,由于恐惧面孔的认同率较低(乔建中,1998),从而导致了该类型情绪面孔视频的数量偏少。为了弥补这一不足,本团队将在未来的研究中增补恐惧面孔视频。其次,被试评测时的情绪状态可能会影响评选结果。因此有必要采用心理量表或其他方法判定被试评测时的精神状态(杜经纶等,2007)。最后,当前视频库中的材料是二维的,与三维视频相比,其动态性和直观性处于劣势。因此,进一步的研究可建设中国大学生三维动态情绪面孔库。

综上所述,本库共纳入1421段有效情绪面孔视频,涉及高兴、愤怒、厌恶、恐惧、悲伤、惊讶和中性七种情绪,并获得了视频材料在愉悦度、唤醒度、优势度、吸引力和可信度上的评分。对视频各个维度评分的统计分析表明,评分可信、评价有效、各个维度间存在显著相关以及显著的性别差异。此外,以往的研究发现中国被试在识别国外的情绪面孔刺激时表现出加工劣势(彭小虎等,2003),而使用本数据库制备的刺激材料将有效解决这一问题。总之,本研究通过严格的录制和筛选过程,完善了中国本土的动态情绪面孔系统。本研究团队将继续完善和改进,争取建立一个更加适用、全面和多样的中国本土化的动态情绪面孔库。