实际噪声下基于时序卷积网络的手机来源识别*

2021-09-24吴张倩苏兆品武钦芳张国富

吴张倩,苏兆品,2,3,4,武钦芳,张国富,2,3,4

(1.合肥工业大学计算机与信息学院,安徽 合肥 230601;2.智能互联系统安徽省实验室(合肥工业大学),安徽 合肥 230009; 3.工业安全与应急技术安徽省重点实验室(合肥工业大学),安徽 合肥 230601; 4.安全关键工业测控技术教育部工程研究中心,安徽 合肥 230601)

1 引言

随着视频、图像和音频等各种编辑软件的普及以及操作的智能化,对多媒体数据进行编辑和修改越来越轻而易举。用户可能对信息进行恶意剪切或篡改,在不尊重事实和他人的基础上谋取私人利益,从而带来潜在的不利因素和恶劣影响。为此,多媒体取证技术[1]旨在能够鉴别多媒体数据是否经过编辑、篡改,以及识别和验证多媒体数据来源。

与视频和图像相比,音频取证隐蔽性更强,且更容易操作。越来越多的人在交流、交易协商时会选择使用语音聊天记录或手机录音取证方式固定曾经发生的客观事实,以期在出现法律纠纷时作为证据进行使用。但是,手机语音是否可以作为有效证据被法庭采纳的一个先决条件是需要确定其真伪,而对手机语音的来源设备识别是语音证据鉴真和形成完备证据链的一个根本前提,已成为近年来多媒体取证领域中的一个研究热点[1]。

2 相关工作

近年来,手机来源识别研究取得了丰硕成果,从对语音信号处理对象的角度,语音信号可以分为对整体语音信号处理和对非语音部分信号处理2大类。

有观点认为,利用语音信号的非语音部分可以降低计算复杂度,且能够排除语音部分的干扰,从而挖掘手机设备的本质特征。在这方面,Hanilci等[2]采用信息论的方法提取非语音部分的特征,利用最大互信息训练的高斯混合模型来表示特定设备的特征。Aggarwal等[3]从噪声估计样本中提取梅尔频率倒谱系数MFCC(Mel Frequency Cepstral Coefficient)。Qi等[4]从背景噪声中提取语音特征,并对比分析了在不同深度学习分类器下的识别性能。Jin等[5]将从噪声中提取的光谱形状特征和光谱分布特征用于手机来源识别。裴安山等[6]将本底噪声作为手机的指纹,提出了一种基于本底噪声的手机来源识别方法。在他们的后续研究中[7],通过使用自适应端点检测算法得到语音的静音段,然后将静音段的梅尔频谱系数的均值作为分类特征。Baldini等[8]在不同频率下用非语音声音刺激内置麦克风,利用手机内置麦克风的固有物理特性构建卷积神经网络对智能手机进行识别和认证。上述针对非语音部分的研究可以有效降低计算开销,但完全无视语音部分,可能会丢失语音部分包含的一些关键设备特征,从而影响识别效果。

因此,主流的研究大都致力于从整体语音信号中提取特征。特别是最近,Luo等[9]提出了一种新的带能量描述符BED(Band Energy Descriptor)特征,并使用支持向量机SVM(Support Vector Machine)进行设备识别。BED主要利用不同生产商在音频采集管道上不尽相同,从而产生可用于音频取证的微小差异。Qin等[10]提出了一种常数Q变换域CQT(Constant Q Transform)的语音特征,并使用卷积神经网络CNN(Convolutional Neural Network)进行训练。在更早期,Hanilci等[11]提取MFCC作为设备特征,并利用SVM作为分类器。紧接着,Hanilci等[12]提出MFCC、线性频率倒谱系数、巴克频率倒谱系数和线性预测倒谱系数4种不同的声学特征,并采用倒谱平均归一化、倒谱方差归一化、倒谱均值和方差归一化3种不同的归一化技术分别处理。Zou等[13]利用高斯混合模型-通用背景模型设计了一种基于MFCC和功率归一化倒谱系数的识别方法。裴安山等[14]指出不同手机的语音频谱特征是不同的,将语音的频谱信息量、对数谱和相位谱特征串联构成原始融合特征。上述已有方法均是从整体语音信号中提取特征,从而可以充分挖掘语音信号中的关键设备信息,均在手机来源识别上取得了较好的识别效果,但计算开销稍大。

总的来说,虽然BED+SVM[9]和CQT+CNN[10]等方法在手机来源识别上取得了不错的效果,但是一个突出的问题是,现有研究大都基于理想而又安静的实验室环境,利用纯净语音或添加人工噪声语音来进行测试分析,而对实际环境噪声语音却鲜有涉及。在音频取证中,充当证据的手机语音信号通常产生于人们交流和交易协商的生活和工作环境中,包含了各种自然环境背景噪声。特别地,自然环境背景噪声复杂多变,在不同天气、地点,背景噪声信号对手机语音信号产生的影响也不同。有时候,强自然环境背景噪声甚至可能会完全掩盖设备本身的噪声。在对这些手机语音进行特征提取时,如何降低自然环境背景噪声对手机设备本身噪声的干扰是一个难点问题。当自然环境背景噪声较小或人工背景噪声具有一定先验知识时,传统方法提取的语音特征,如MFCC、BED和CQT等都可以较好地反映出设备的噪声特征。但是,当背景噪声较大且较复杂的时候,传统方法提取的特征不能有效抵抗背景噪声的干扰, 无法满足司法领域的实际需求,必然导致识别准确率下降。因此,如何在实际环境噪声干扰下提取出设备关键特征,是需要解决的第1个难点问题。此外,SVM和CNN这些分类器没有充分利用音频信号的时序特征,在串行信号的处理上,例如在一个关键性质“记忆力”上很难充分发挥价值,因此选取一个契合时序信号的分类器、充分挖掘语音时序特征是需要解决的第2个问题。

基于上述分析,为了满足司法领域音频证据的鉴真需求,提高实际环境噪声下手机来源识别的准确率,本文首先利用线性判别分析LDA(Linear Discriminant Analysis)[15]优化一个语音混合特征,并以此混合特征为输入,基于时序卷积网络TCN(Temporal Convolutional Network)[16]进行训练和分类,提出一种基于LDA和TCN的手机来源识别方法,最后基于各种实际环境噪声语音库对所提方法进行了大量测试和验证。

3 基于LDA和TCN的手机来源识别

3.1 基于LDA的混合语音特征提取

语音信号的不同特征能从不同侧面反映语音的不同信息,因此可以使用融合特征来更加全面地表达语音信号。本文在已有工作基础上,通过大量测试和分析,选取并尝试将BED和CQT这2个特征结合起来,利用LDA优化[15]从混合特征中降维出LQBED(LDA based CQT and BED),以获得更全面的语音特征信息,从而在整体上提高特征的分辨力。

假设BED的特征维数为n,CQT的特征维数为m,则组合后的特征维数为n+m。虽然组合特征能更全面地反映语音特征,但特征值维数较大,其中可能包含很多对设备特征没有贡献或者贡献较小的特征值,即存在一定相关性或冗余性,会带来巨大的计算开销,因此需要对这个混合特征进行降维,去除其中的冗余信息。在机器学习中,LDA[15]是一种典型的模式识别和降维方法。其基本思想是将高维模式样本投影到最优判别向量空间中,以提取分类信息并压缩特征空间的维数。投影后,保证样本有最大的类间距离和最小的类内距离,使得同一类数据尽可能紧凑,不同类的数据尽可能分散。LDA可以充分利用先验知识,计算速度快。特别地,当数据满足高斯分布时,LDA的降维效果非常显著,而基于语音信号的手机来源识别主要是根据语音信号中含有的设备元器件(主要是麦克风)自身噪声的微小差异来进行识别。通常,电路各元器件自身噪声和相互作用产生的影响主要就是高斯噪声。因此,本文选择LDA对混合特征进行降维,提取出LQBED特征。

基于LDA的LQBED语音特征提取过程如图1所示,具体描述如下所示:

步骤1针对每一类别,计算305维特征的均值向量得到ai,计算所有样本的均值向量a。

步骤2构造类间散布矩阵SB和类内散布矩阵SW:

(1)

(2)

步骤5取前k大的奇异值对应的特征向量组成投影矩阵W。k是输出特征的维数,最大为特征类别的个数减1,本文设置为46。

步骤6计算样本集中每个样本x在新的低维空间的投影Z=WTx。

Figure 1 Procedure of extracting the LQBED feature图1 LQBED过程提取过程

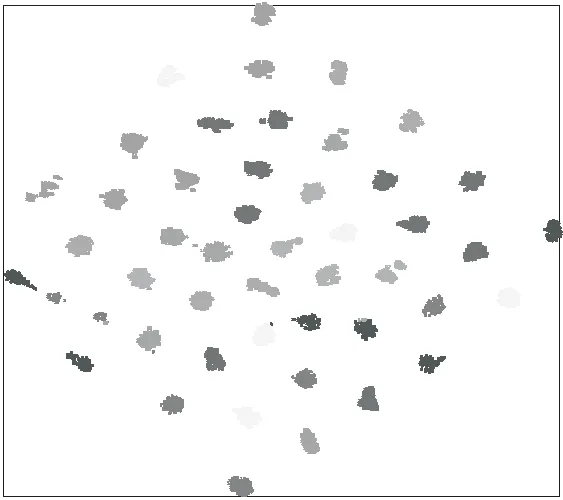

Figure 2 t-SNE visualization of the LQBED feature图2 LQBED分类能力的t-SNE可视化

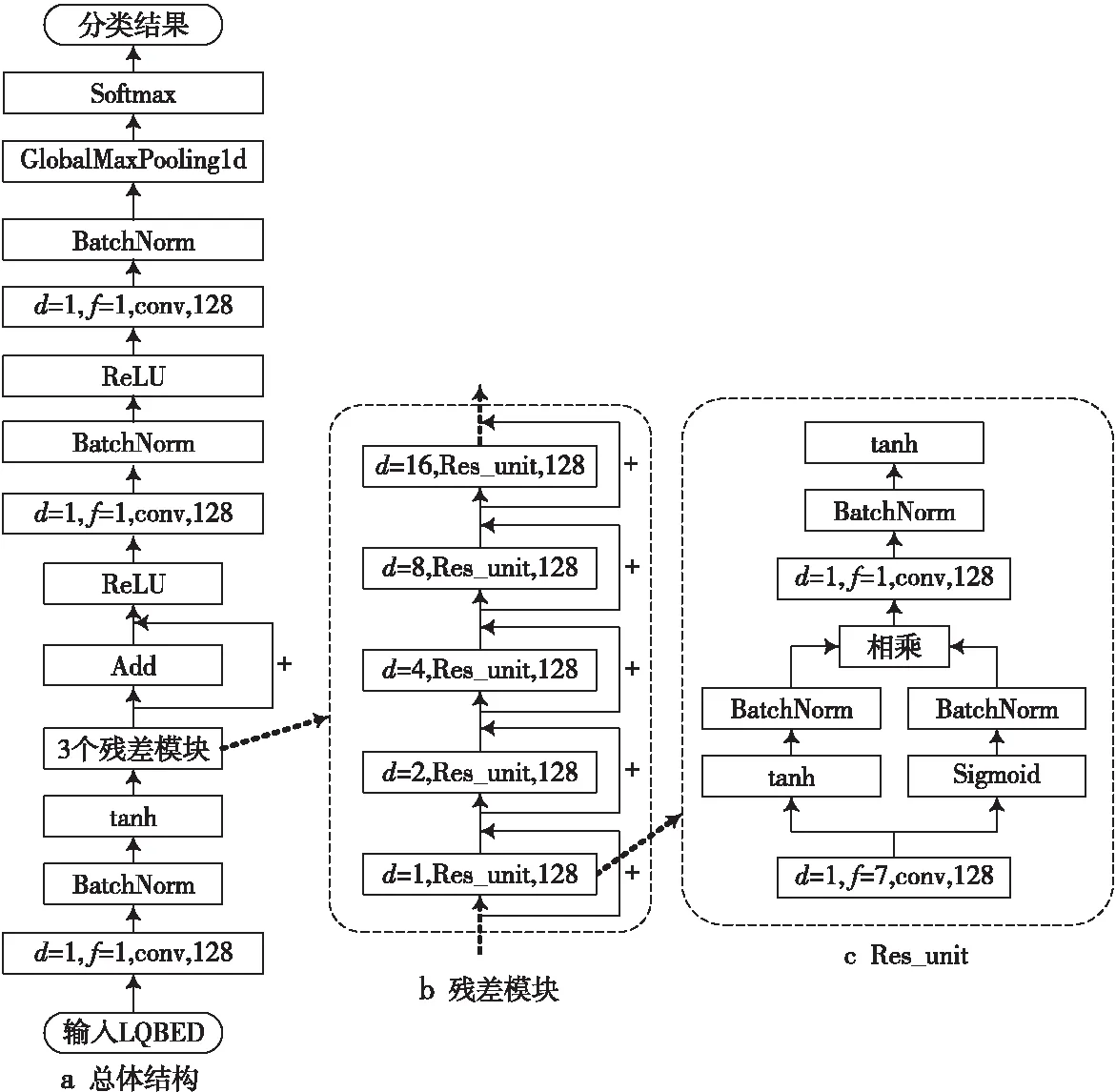

Figure 3 TCN structure used for source cell-phone identification图3 用于手机来源识别的TCN结构

为了更加直观地表征LQBED的分类能力,图2给出了LQBED分类能力的t-SNE(t-distributed Stochastic Neighbor Embedding)可视化结果[17]。t-SNE 方法不仅能够关注原有数据的局部性特征,而且也保留了原始数据的全局特性,可以全面反映特征的分类能力。从图2可以看出,簇与簇之间的区别非常明显,这是因为LQBED保留了CQT和BED中的关键信息,同时又去除了不必要的冗余,减少了冗余信息的干扰,从而可以达到较好的可分性,也为后续的训练和分类节省了计算开销。

3.2 基于TCN的识别框架

语音信号具有典型的时间序列性,在机器学习中,循环神经网络通常被列为解决序列问题的首选工具。Bai等[16]研究成果表明,作为CNN家族中的一个成员,时序卷积网络TCN在各种领域的测试数据上,都得到了比传统循环神经网络更为准确的结果,成为新的序列数据分析方面的佼佼者。

TCN主体包括一维全卷积网络和因果卷积,同时采用扩张卷积和残差模块来获取较长历史信息,非常契合音频信号的时序特性。此外,由于扩张卷积和残差模块的独特特性,可以构建更深层的网络,从而可以提取更多的历史语音信息而不必担心梯度消失和梯度爆炸。因此,本文根据音频信号特征,选取并设计相应的TCN作为分类器,来进一步学习深度语音特征,然后利用深度特征进行手机来源的识别。

本文设计的用于手机来源识别的TCN结构如图3所示。为了保证技术的可重复性,下面将详细介绍框架中的一些具体技术细节。

首先,整体架构如图3a所示。输入为语音的LQBED特征,对于T帧的语音信号,zt∈R46是从语音第t帧中提取的特征。输入Z∈RT×46是所有帧LQBED特征的串联。输入特征经过一维卷积过滤后进入残差模块进一步学习:

Y1=σ1(W1·Z0)

(3)

其中,Z0是网络最初的输入特征,W1是第一层网络需要学习的参数,σ1是非线性激活函数tanh。

其次,在TCN架构中引入的残差模块共包括3个,每一个残差模块组成相同,如图3b所示。每个残差模块深层网络被分解成若干个残差学习单元Res_unit,每一个Res_unit中的卷积核个数是128。在每一个残差模块中,本文采用扩张卷积,其中最关键的参数为扩张率(d)在连续多个Res_unit中以2的指数形式增加,即d=2n,n=0,1,2,3,4,从而能够在不显著增加参数数量的情况下扩大感受野。在TCN中,每个Res_unit的输出通过添加到下一个Res_unit的输入而简单合并。令Yl代表第l层Res_unit的输出,则:

Yl=Yl-1+F(Wl,Yl-1)

(4)

其中,Wl是第l层Res_unit需要学习的参数,F是在Res_unit中的非线性变换。

此外,每个Res_unit的具体结构如图3c所示。将输入信号进行卷积之后分别利用不同的激活函数(Sigmoid、tanh)进行线性变换,并将结果相乘。Sigmoid的值在0~1,与tanh相乘,相当于给每一维特征加权,提高学习到的特征性能和模型泛化能力。然后再次经过一维卷积和tanh激活函数之后输出:

F(Wl,Yl-1)=

σ1(Wl2·(σ1(Wl1·Yl-1)·σ2(Wl1·Yl-1)))

(5)

其中,σ2是Sigmoid非线性激活函数,Wl1和Wl2分别代表第l层Res_unit中第1层conv和第2层conv的参数,Wl=Wl1+Wl2。在经过N个Res_unit的学习后,累加不同输出,经过残差模块3非线性变换(ReLU函数)后得到YN:

(6)

YN+1=σ3(WN+1·YN)

(7)

YN+2=WN+2·YN+1

(8)

式(6)中,第1个Res_unit的输出是Y2,TCN中的所有后续Res_unit均要在Y1的基础上进行计算。本文利用网络学习不同语音信号中有区别的语音特征, 整个模型的表示能力在很大程度上取决于第1层网络参数W1确定的Y1。在图3a中,本文在残差模块之后又添加了2层卷积层,即式(7)和式(8)。

对于预测,本文应用全局平均池化,将数据由三维降到二维,减少训练参数的同时,提高模型的泛化能力,最后附加一个神经元数量等于类数量的Softmax层。

(9)

YN+3=GlobalMaxPooling1d(YN+2)

(10)

需要指出的是,图3的整体网络中还多次利用了加速神经网络训练的BatchNorm算法[18],以提高收敛速度和稳定性。

4 实验结果与分析

4.1 实际噪声语音库的建立

为了测试本文所提方法在自然环境噪声下的鲁棒性,本节首先构建了一个具有实际环境噪声的语音数据库。该语音数据库由来自表1所示的10个品牌、47种型号手机设备的MP3格式的音频信号组成,采样率为44 100 Hz或48 000 Hz,比特率为64 kbps或128 kbps。每种型号下的手机语音信号均收录于不同性别的人在不同生活噪声环境下的语音(包括日常对话、电影对话、无线电广播等)。

Table 1 Model and ID of each mobile phone表1 实验手机的品牌和型号

本文将每种型号收录到的语音信号平均分割成3 s,最终每种型号的手机共收集700条语音片段,其中600条用于训练,其余100条用于测试,从而构建了一个包含32 900条语音样本的语音数据库。其中,训练库包括28 200条语音,测试库包括4 700条语音。本文涉及到的相关实验均是在该语音数据库上进行测试和分析。

4.2 参数设置和评价指标

对于TCN,训练周期是一个关键参数。本文经过大量的测试发现,当训练周期达到30时TCN的精度和损失基本不变。因此,为了保证充分的学习,本文最终将训练周期设定为30,网络学习率设置为0.01,损失函数为Categorical Crossentropy。其他的一些参数已在图3的网络结构中给出。

为了充分评估所提方法的性能,本文引入如下4种在机器学习中常用性能指标[6]:

(1)准确率(Accuracy):使用最普遍也是最直观的性能指标,表示预测正确的样本占所有样本的比例,表示一个分类器的区分能力。

(2)召回率(Recall):指在所有实际为正例的样本中,被预测为正例的样本比例。

(3)精确率(Precision):指在所有被分类为正例的样本中,真正是正例的比例。

(4)F1分数(F1-score):为精确率和召回率的调和平均数。

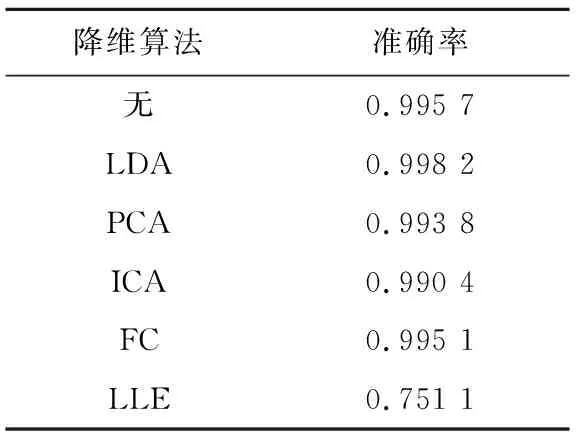

4.3 不同降维算法的对比

为了验证LDA从混合特征中提取LQBED的有效性,第1个实验将对比分析不同的降维算法。在深度学习中,除了LDA,常用的降维算法还有主成分分析PCA(Principal Component Analysis)、独立成分分析ICA(Independent Component Analysis)、因子分析FC(Factor Analysis)和局部线性嵌入LLE(Locally Linear Embedding)等[19],不同的降维算法适用不同的应用场景。

表2给出了基于TCN和不同降维算法下得到的平均识别准确率。由表2可以看出,LDA降维之后获得的识别性能最佳,尤其比不降维还略有提升。这是因为,LDA可以充分利用先验知识,计算速度快,特别是当数据满足高斯分布的时候效果显著,而语音信号中含有的设备噪声主要就是高斯噪声。

4.4 不同特征的对比

为了验证本文采用的LQBED特征的有效性,本节将LQBED与性能较好的BED和CQT进行对比分析。基于表1所示的47种不同手机型号,在TCN识别框架中检测上述3种特征的性能。

Table 2 Average accuracies under different dimensionality reduction algorithms表2 不同降维算法下得到的平均识别准确率

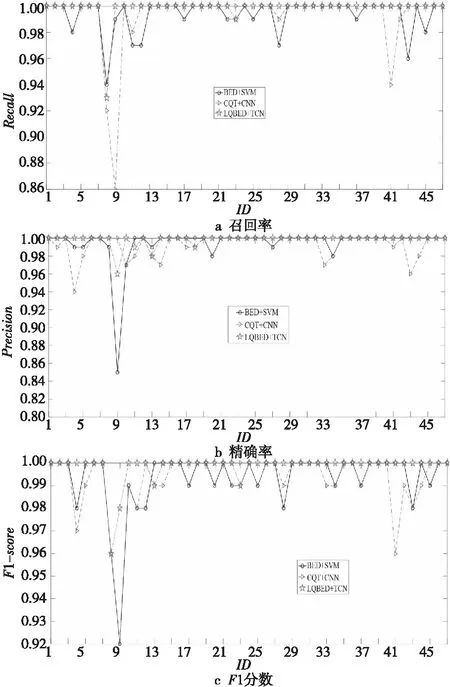

图4给出了3种特征在47种手机型号(对应1~47)上召回率、精确率和F1分数结果。可以看出,在图4a中,除了ID=8和ID=23,LQBED在其余不同ID上的召回率值均优于BED和CQT的。在图4b中,除了ID=9,ID=13和ID=18,LQBED在其余不同ID上的精确率值都要好于BED和CQT的。在图4c中,除了ID=8和ID=23,LQBED在其余不同ID上的F1分数值均好于BED和CQT的。虽然在上述3个指标上,LQBED在少数几个型号手机的数据上的表现不尽人意,但从整体上来看,LQBED优势明显,在绝大多数型号的手机上,LQBED在召回率、精确率、F1分数3个指标上的值都能接近1。

Figure 4 Experimental results of different features on different metrics图4 不同特征在不同指标上的实验结果

此外,表3给出了基于TCN和3种特征在47种手机型号数据上的平均识别率。可以看出,基于相同的TCN框架,LQBED平均识别率为99.82%,好于BED和CQT的平均识别率,分别提升了0.29和0.46个百分点,这意味着LQBED特征进一步降低了错判率,这在司法领域实际应用中显得尤为重要。究其原因,LQBED保留了CQT和BED中的关键信息,同时又去除了不必要的冗余,减少了冗余信息尤其是环境噪声的干扰,可在一定程度上提高TCN的学习效率。

Table 3 Average accuracies under different features表3 不同特征下得到的平均识别准确率

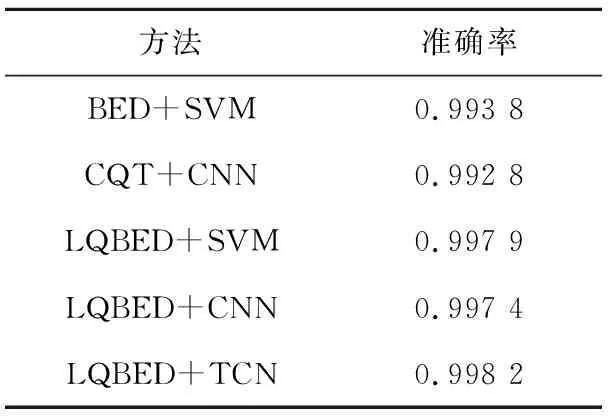

4.5 不同识别方法的对比

基于构建的实际环境噪声下的手机语音数据库,本节将所提的基于LQBED和TCN的手机来源识别方法(后称LQBED+TCN),与文献[9,10]中最新的BED+SVM和CQT+CNN方法进行对比实验分析。

图5给出了3种识别方法在47种型号手机数据上召回率、精确率和F1分数结果。可以看出,在图5a中,在ID=8时,本文所提的LQBED+TCN的召回率值好于CQT+CNN的,但略差于BED+SVM的;在ID=23时,LQBED+TCN的召回率值与BED+SVM的不相上下,均略差于CQT+CNN的;但是,LQBED+TCN在其余不同ID上的召回率值均明显优于BED+SVM和CQT+CNN的。在图5b中,在ID=9时,LQBED+TCN的精确率值略差于CQT+CNN的,但明显好于BED+SVM的;在ID=11时,LQBED+TCN的精确率值好于CQT+CNN的,略差于BED+SVM的;在ID=13和ID=18时,LQBED+TCN的精确率值与CQT+CNN的相当,均略差于BED+SVM的。不过,需要指出的是,LQBED+TCN在其余不同ID上的精确率值都要显著好于BED+SVM和CQT+CNN的。在图5c中,在ID=8时,3种方法的F1分数值旗鼓相当;在ID=13时,LQBED+TCN的F1分数值与CQT+CNN的不相上下,均略差于BED+SVM的;在ID=23时,LQBED+TCN的F1分数值与BED+SVM的相当,均略差于CQT+CNN的。但是,LQBED+TCN在其余不同ID上的F1分数值都要明显好于BED+SVM和CQT+CNN的。从整体上来看,在绝大多数的手机ID上,LQBED+TCN在召回率、精确率和F1分数3个指标上的值都非常接近1,平均召回率分别提高了0.45和0.55个百分点,平均精确率分别提高了0.41和0.57个百分点,平均F1分数分别提高了0.49和0.55个百分点。

Figure 5 Experimental results of different identification methods on different metrics图5 不同识别方法在不同指标上的实验结果

此外,表4给出了不同识别方法在47种型号手机数据上的平均识别准确率。可以看出,本文LQBED+TCN方法的平均识别率最高,达到了99.82%,相比BED+SVM和CQT+CNN分别提高了0.44和0.54个百分点。而且,需要特别指出的是,与表3中的BED+TCN和CQT+TCN相比,BED+SVM和CQT+CNN的性能均有所下降。而且,与LQBED+TCN相比,LQBED+SVM和LQBED+CNN的性能也稍有下降。上述实验结果表明了本文选取和设计TCN用于手机来源识别的优势,LQBED+TCN获得了更高的识别准确率,进一步降低了出错率。这是因为,语音信号具有典型的时间序列性,而TCN采用的一维卷积是在时间维度上进行训练和学习,更加有利于捕捉时序上的依赖关系。

Table 4 Average accuracies of different identification methods表4 不同识别方法的平均识别准确率

最后,为了更加全面直观地反映LQBED+TCN的性能,图6给出了LQBED+TCN的详细混淆矩阵[20]。混淆矩阵中的每一行代表该类样本的预测结果,不同位置的值代表被预测成相应ID的个数,可以非常容易地显示出多个类别是否有混淆,即一个类别被预测成另一个类别。由图6可以看出,LQBED+TCN在绝大部分型号的手机数据上的识别准确率均达到了100%,最低准确率也有93%。在47个手机ID上,只有9个ID上有分类错误,其余ID全部分类正确,且除ID=7外其余ID上的识别率均不低于97%。

Figure 6 Confusion matrix obtained by LQBED+TCN图6 LQBED+TCN的混淆矩阵结果

上述实验结果表明,LQBED+TCN提升了在实际环境噪声下的手机来源识别性能,对于在司法领域的语音证据鉴真的应用更有实际价值。究其原因,LQBED+TCN可在一定程度上获得更加全面的语音特征,利用LDA去除了其冗余性,降低了说话人(年龄、性别等)、场景、内容(日常对白、唱歌、广播等)和实际环境噪声等因素的干扰,同时基于TCN进一步学习深度语音特征,对实际环境噪声下的手机语音信号具有更好的适应性。

5 结束语

为解决司法领域中实际环境噪声下的手机来源识别问题,本文首先提取含有实际环境噪声的语音混合特征,然后基于LDA对混合特征进行降维得到LQBED特征,最后选择并设计TCN进一步学习语音深度特征并进行分类,提出一种基于LDA和TCN的实际环境噪声下的手机来源识别方法LQBED+TCN。根据10个品牌、47种型号的手机设备,本文构建了一个包含32 900条语音样本的实际环境噪声下的语音数据库。在该语音库上的测试结果显示,本文所提LQBED+TCN对实际环境噪声具有较好的综合识别性能,平均识别率达到了99.82%,且在召回率、精确率和F1分数值上也优于已有方法,进一步降低了错判率,对司法领域中语音证据的鉴真具有一定的实际价值。

但是,本文工作只是针对司法领域实际需求,利用TCN在手机来源识别上的一个初步尝试,仍有许多工作需要进一步深入研究。首先,由于实验条件的限制,本文收录的手机型号覆盖范围还不够广泛,因此语音库仍需要进一步扩充;其次,本文创建的语音数据库均是MP3格式,还需要考虑其它的手机语音格式;而且,还需要考虑语音信号受到信号处理攻击下的鲁棒性;最后,还需进一步考虑改善和挖掘TCN的优势。