基于深度学习的尺度自适应海面目标跟踪算法

2021-01-16钟雨轩岳琪琪李小毛

吴 翔, 钟雨轩, 岳琪琪, 李小毛

基于深度学习的尺度自适应海面目标跟踪算法

吴 翔1, 钟雨轩2, 岳琪琪1, 李小毛1

(1. 上海大学 机电工程与自动化学院, 上海, 200444; 2. 上海大学 计算机工程与科学学院, 上海, 200444)

相比于普通场景的目标跟踪, 无人艇海面目标跟踪具有目标尺度变化大、目标抖动剧烈和视角变化大等独特挑战。针对此, 文中提出了基于深度学习的尺度自适应海面目标跟踪算法, 以样本中心点是否落在真实目标框内对样本进行分类, 直接回归中心点到目标框上下左右的距离预测目标框的位置和尺度。同时, 建立了海面目标跟踪算法评估平台, 以验证所提算法的有效性。试验结果表明, 文中算法相比基于锚框的算法跟踪位置精度提升了4.8%, 成功率提升了11.49%, 有效解决了目标尺度自适应问题。

无人艇; 尺度自适应; 深度学习; 目标跟踪

0 引言

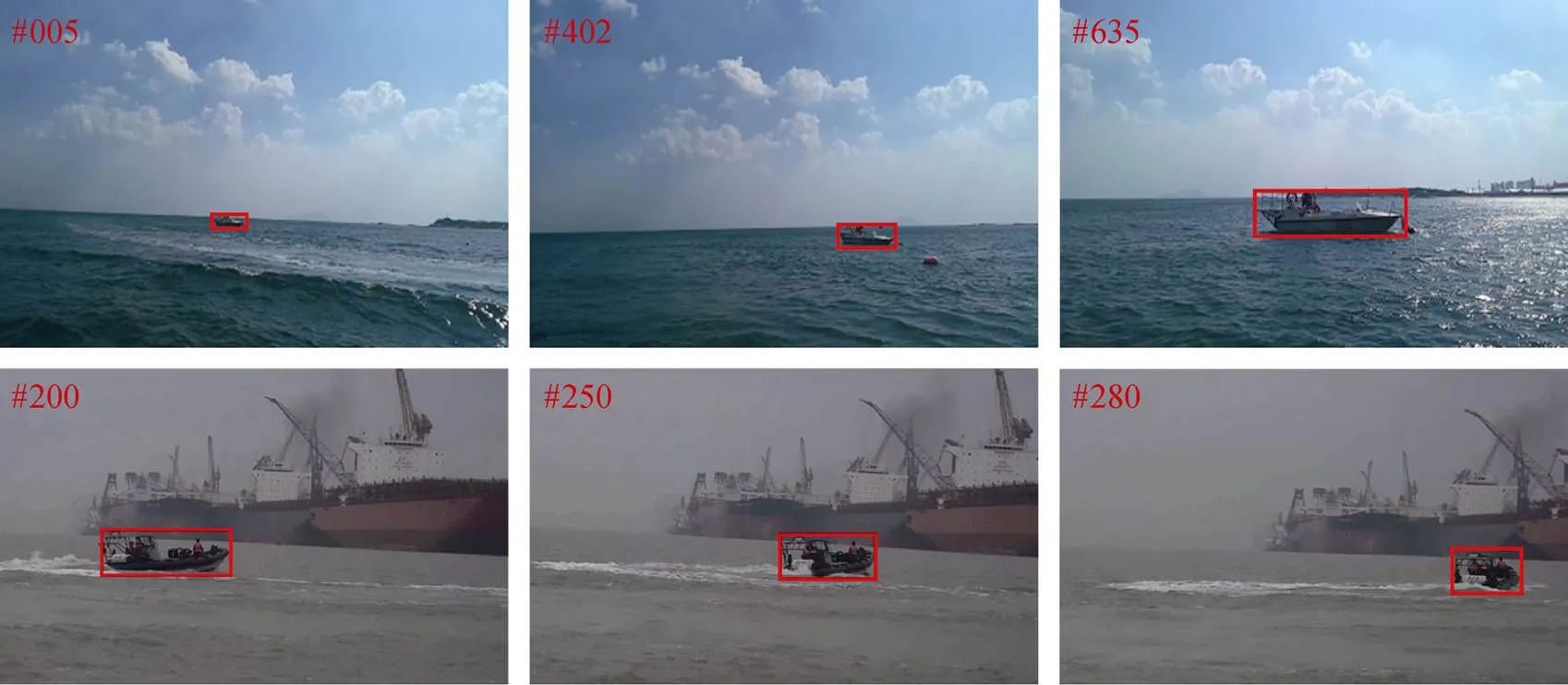

无人艇是一种能够自主航行的水面运动平台, 在军用和民用等领域都发挥着巨大作用。视觉感知是无人艇环境感知的重要组成部分, 能为无人艇提供丰富的海面目标外观信息。海面目标跟踪作为视觉感知的重要研究任务, 对于海面目标行为分析等方面有着重要意义[1]。海面目标跟踪任务的定义为: 根据海面图像序列第1帧中海面目标的信息, 该任务负责在之后的每一帧图像中定位出该目标[2-3]。不同于普通场景的目标跟踪任务, 海面目标跟踪虽背景较为简单, 但具有目标尺度变化大(见图1)等特点。

图1 目标尺度变化

目前较流行的目标跟踪算法有基于相关滤波器跟踪算法和基于孪生网络跟踪算法。基于相关滤波器跟踪算法通过循环样本集训练一个二维滤波器来寻找图像中目标的位置, 并根据循环矩阵在傅里叶域对角化的性质, 将复杂的时域运算转化到傅里叶域元素间的点乘运算, 大大减少了运算量, 提高了跟踪算法效率[4]。在基于相关滤波器的跟踪算法中, 解决目标尺度问题的算法包括判别式尺度空间跟踪(discriminative scale space tracking, DSST)算法[5]、多特征尺度自适应(scale adaptive multiple feature, SAMF)算法[6]、核相关滤波器与检测建议(kernelized correlation filter with detection proposal, KCFDP)算法[7]、可伸缩核相关滤波器(scalable kernel correlation filter, SKCF)算法[8]、积分边界中心相关滤波器(integrating boun- dary and center correlation filter, IBCCF)算法[9]等, 该类目标跟踪算法大部分使用手工特征, 或使用应用于分类任务的预训练网络提取特征, 无法形成端到端的训练。

2016年, Bertinetto等[10]首次将孪生网络用于视觉目标跟踪领域, 提出SiamFC跟踪器, 该跟踪器采用第1帧作为模板, 在后续帧中通过相似性匹配寻找目标位置, 通过采样3种不同尺度样本分别与模板帧作相似性匹配以获得最佳尺度。Li等[11]将目标检测领域的区域建议网络(region proposal network, RPN)[12]引入到跟踪器中, 提出SiamRPN跟踪器, 该跟踪器对每一个候选区域设置尺度以及长宽比不同的框, 将其称为锚框(anchor), 对锚框进行分类和回归, 更好地预测了目标尺度, 提高了跟踪器的速度和定位精度。基于锚框的目标跟踪算法虽然获得了很好的效果, 但是其对尺度的预测效果受锚框的限制, 需要仔细调节与之相关的超参数, 对于已经训练好的网络, 锚框的尺寸和长宽比是固定的, 因此不适用于尺度变化较大的场景。

文中使用基于深度学习的算法, 能够提取到特征表达能力更强且更适用于目标跟踪任务的深度特征。同时, 文中提出的尺度自适应目标跟踪算法是不依赖于锚框的, 由候选区域的中心点是否在真实目标框(groundtruth, GT)内判断正负样本, 然后直接回归点到GT上下左右的距离, 更适用于海面目标尺度变化大的场景。同时, 为了验证文中算法的有效性, 搭建了海面目标跟踪算法评估平台, 选取尺度变化大的视频序列进行定性和定量分析, 试验结果表明文中算法能够更好的应对目标大尺度变化。

1 方法提出

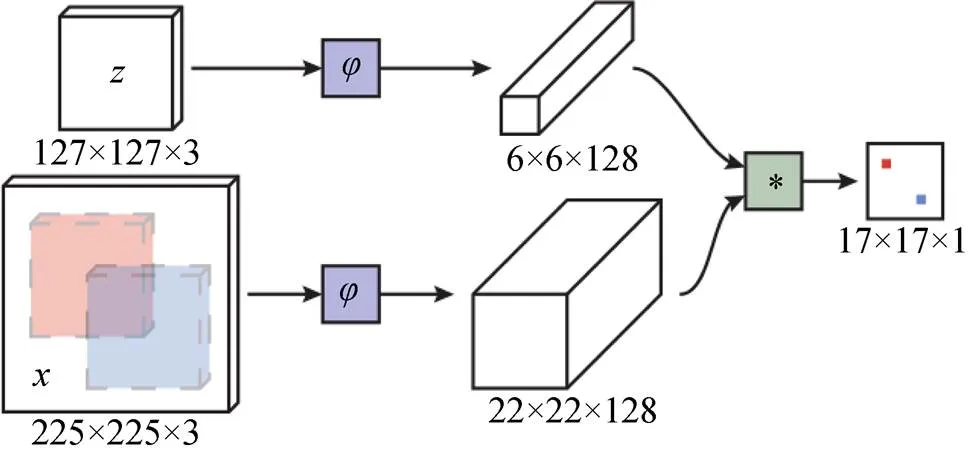

1.1 孪生网络目标跟踪算法

图2 孪生网络结构图

1.2 问题分析

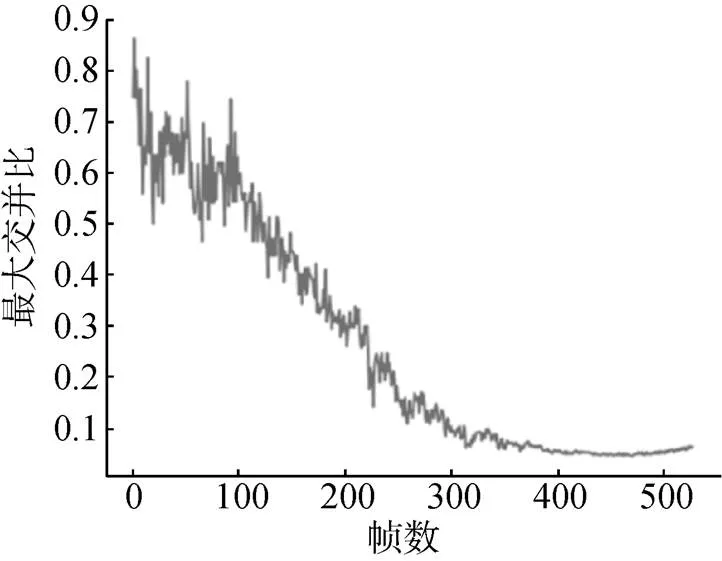

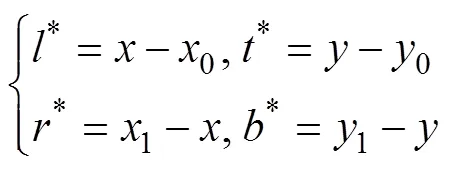

将SiamRPN跟踪器应用于海面目标跟踪数据集, 发现其表现效果并不好。在分析其原因之前, 首先简单介绍SiamRPN跟踪器的目标跟踪过程。SiamRPN跟踪器共有17×17个候选区域, 对于每一个候选区域设置尺度以及长宽比不同的锚框, 在训练过程中根据锚框与GT的交并比(intersection-over-union, IOU)大小对锚框分类, 设置分类标签, 将与GT的IOU大于0.6的锚框设置为正样本, 其余设置为负样本, 最后再将锚框向GT回归。如上所述, 基于锚框的目标跟踪算法的训练过程注定其表现效果对锚框的尺寸、长宽比和数目非常敏感, 与锚框相关的超参数需要针对不同对象大小或长宽比进行仔细的调节。而且目标跟踪的对象为视频序列, 由于海面船只目标跟踪数据集的特点, 即跟踪的船只目标尺度在整个序列中变化较大, 注定锚框的设置不能很好地适应每一帧目标。图3是锚框与GT的可视化图, 图4表示海面目标数据集中一个尺度变化大的序列SingleShip05视频中, 锚框与GT最大的交并比帧数的变化曲线图, 从图中可以看出, IOU值越大比例越少, 说明对于大多数图像其锚框的设置并不是很合理, 也表明基于锚框的算法在处理形变较大的候选对象时比较困难, 而且设置的锚框数量越多, 网络的维度也越大, 增加了计算量。文中提出的目标尺度自适应算法是基于无锚框(anchor-free)的, 对候选区域的分类是基于点的, 可以保证正样本的中心点一定落于GT内, 然后直接回归点到目标框上下左右的距离来确定目标的位置和尺度, 更适用于海面目标大尺度变化的场景。

图3 SingleShip05视频中锚框与GT可视化图

图4 SingleShip05视频中锚框与GT最大交并比变化曲线

1.3 尺度自适应海面目标跟踪算法

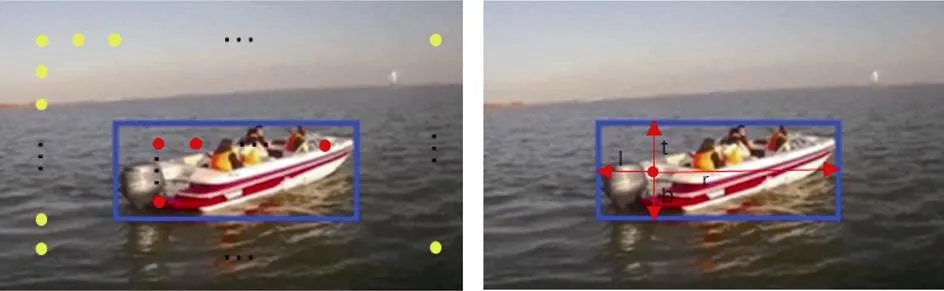

图5 标签设计示意图

Fig. 5 Diagram of label design

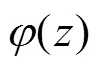

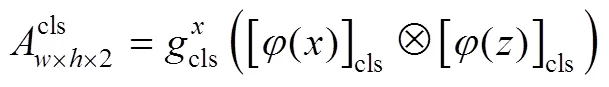

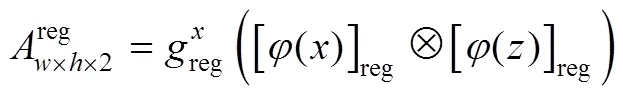

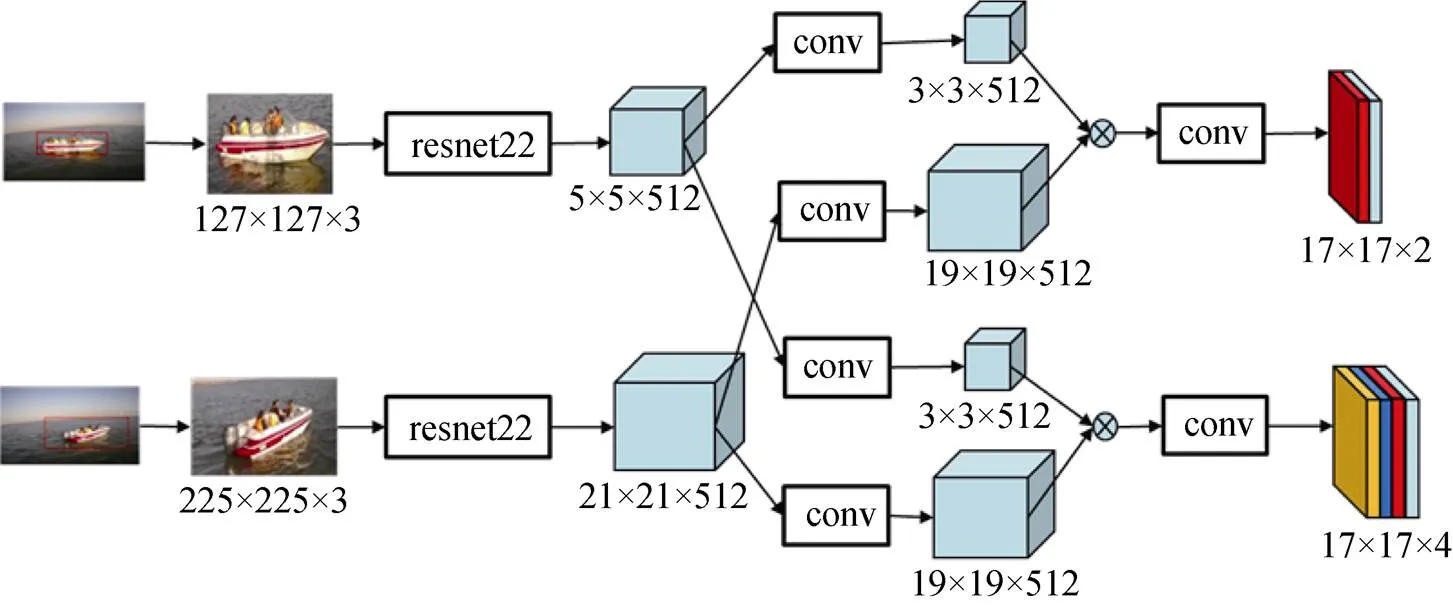

1.3.1 网络结构

图6 文中算法网络结构图

1.3.2 损失

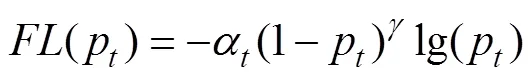

分类分支采用焦点损失(focal loss)[14], 表示为

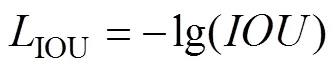

回归分支采用交并比损失(IOU loss), 表示为

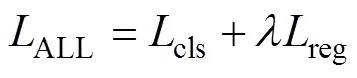

总的损失为

1.3.3 网络训练

如图7所示, 上下2行对应为1个训练图像对, 每个图像对都是从同一个视频序列中随机获得。对图像进行预处理, 第1行图像大小为127 px×127 px, 第2行图像大小为255 px×255 px, 若大小超过了原图像的大小, 则用图像红绿蓝三通道的平均像素值填充图像。

图7 训练图像对

Fig. 7 Training image pairs

1.3.4 跟踪过程

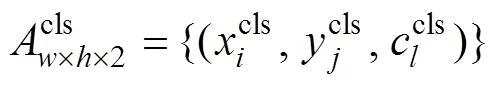

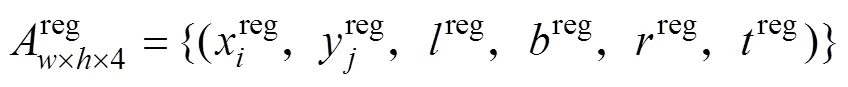

文中算法目标跟踪过程的输入与SiamFC相同。模板分支固定为第1帧, 因此只需要计算1次, 将当前帧搜索图像块输入网络, 网络前向传播获得分类和回归的结果。将分类输出和回归输出分别表示为

2 试验与分析

2.1 目标跟踪算法评估准则

以安装在水面无人艇上的环境感知摄像机拍摄的真实图像序列作为文中算法性能评估的测试数据集, 并按照OTB100目标跟踪数据集[2-3]公开的统一标准进行人工标注。采集的海面数据集包含30个图像序列, 其中包括目标被遮挡、目标平面外旋转、目标超出视野、目标尺度变化和背光等情况。

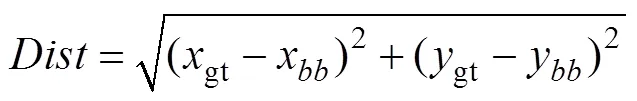

基于上述测试数据定性分析文中算法的有效性, 定量评估文中算法的成功率和精确度。通常利用精确度和成功率曲线图对跟踪算法的性能进行排名, 用曲线与横纵坐标所围成的面积来量化表示, 其取值范围为0~1, 越接近1代表算法的跟踪效果越好。精确度曲线图的横坐标为中心距离阈值, 纵坐标为中心距离小于对应横坐标阈值帧数与视频总帧数的比值。中心距离定义为跟踪算法得到的目标框的中心坐标与GT的中心坐标之间的欧式距离, 即

从式(10)可以看出, 精确度评估只考虑了目标框的位置而没有考虑目标框的尺度, 常用于评估目标尺度固定的跟踪算法的精度。因此进一步使用成功率曲线图评估算法性能。成功率曲线图的横坐标为重叠率阈值, 纵坐标为重叠率超过对应的横坐标阈值的帧数与视频总帧数的比值。重叠率数值越大表示计算结果越理想。

使用一次性通过评估(one-pass evaluation, OPE)和时间鲁棒性评估(temporal robustness eva- luation, TRE)来评估文中算法的性能。OPE在视频的第1帧利用真实的目标位置对跟踪算法进行初始化, 使用跟踪算法得到后续帧中目标的位置。TRE评估首先将整个跟踪序列去除掉目标不存在的图像帧, 然后将剩下的图像帧平均分为若干段, 将每个时间段的初始位置设定为跟踪的初始帧, 跟踪器被初始化并运行直到序列结束。

2.2 试验验证

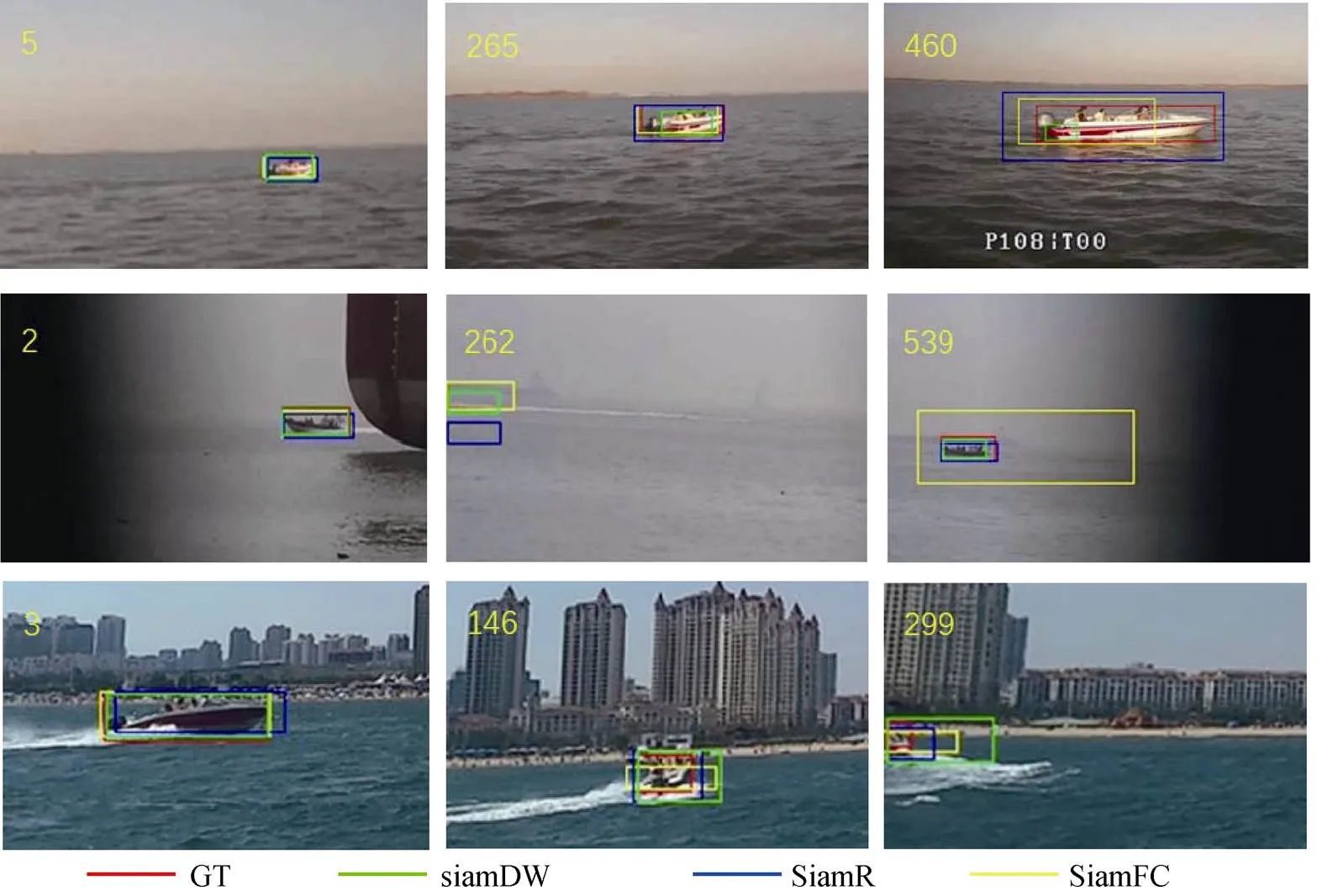

选择SiamFC和SiamDW[15]2个跟踪算法与文中算法进行对比(SiamDW算法在SiamRPN算法的基础上对基础特征提取网络进行了改进, 与文中算法的基础特征提取网络相同, 因此选择该算法进行对比)。图8为不同目标跟踪算法和GT的可视化结果, 图中红框表示GT; 黄框表示SiamFC算法的跟踪结果; 绿框表示SiamDW算法的跟踪结果; 蓝框表示文中算法的跟踪结果。从图8第1、2行可以看出, 相较于SiamFC算法和SiamDW算法, 文中算法能够较好地处理目标尺度由小变大和由大变小的情况, 且位置精度能够得到保障。从第2行可以看出, 文中算法能够很好地处理超出视野的情况, 而SiamFC这种通过尺度采样预测目标最佳尺度的算法在超出视野的情况下尺度预测效果很差。

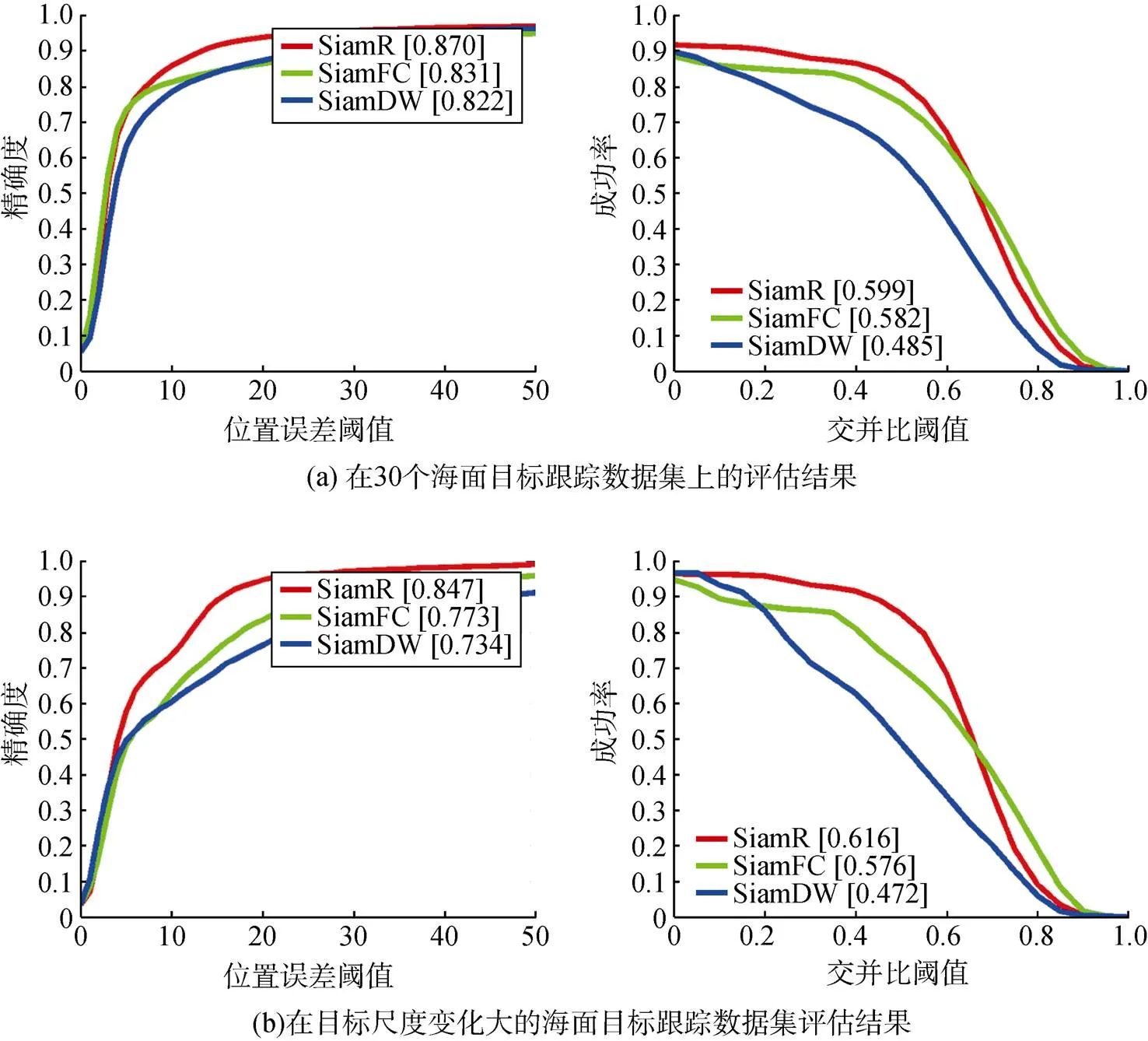

图9为采用OPE评估的跟踪算法精确度和成功率曲线, 其中图9(a)为在30个海面目标跟踪数据集上的评估结果, 图9(b)为在挑选的目标尺度变化大的海面目标跟踪数据集上的评估结果, 图中SiamR表示文中算法。从图9(a)中可以看出, 文中算法表现性能较好, 精确度达到87%, 成功率达到59.9%, 分别比SiamDW算法提升4.8%和11.49%。3种算法的精确度差别不大, 但在成功率方面SiamDW算法较低, 主要原因是对于目标大尺度变化情况, 基于锚框的目标跟踪算法效果较差。从图9(b)中可以看出, 在目标大尺度变化的数据集上, 文中算法比其他2种算法的效果提升更多, 也进一步证明了文中算法能够更好地适应海面目标尺度变化大的情况。

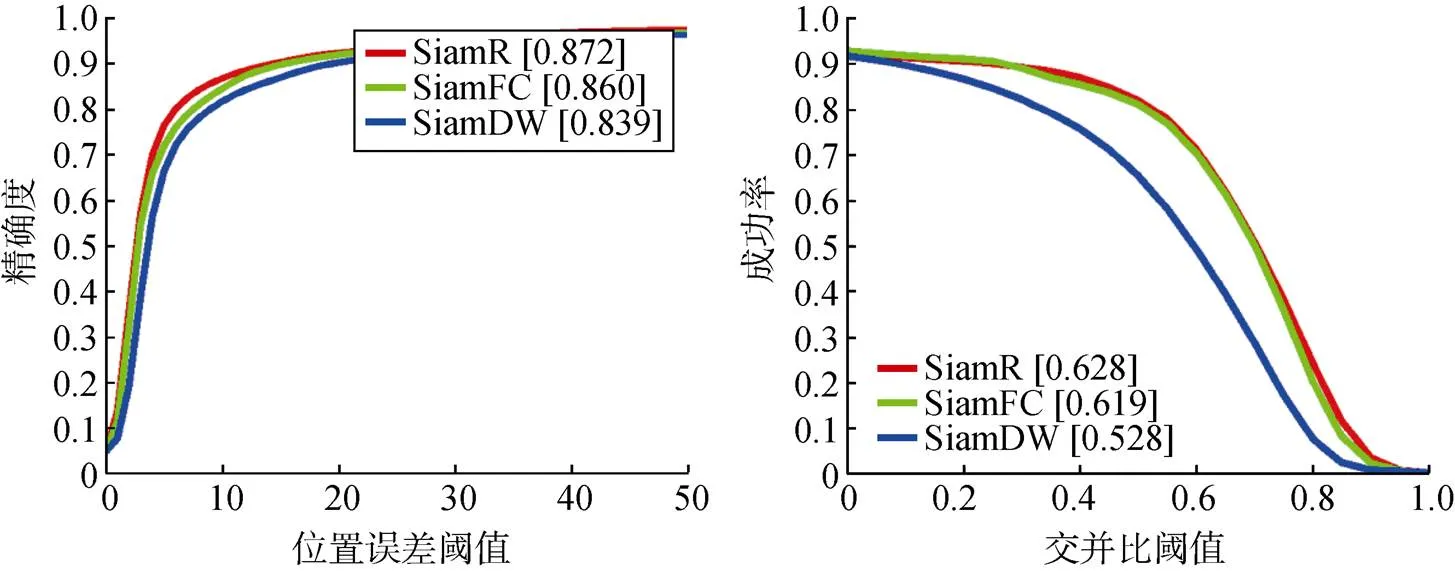

图8 目标跟踪效果可视化图

图10为在30个海面目标跟踪数据集上通过时间鲁棒性评估的跟踪算法精确度和成功率曲线, 从图中可以看出, 文中算法的鲁棒性较好, 但与SiamFC算法的差距较小, 其主要原因是, 将图像帧分为若干段后, 处于后面时间段的序列所包含的图像帧较少, 在图像帧较少的序列中目标尺度变化很小, 无法凸显文中算法的优越性。

图9 OPE评估精确度和成功率曲线

Fig. 9 Precision and success rate curves of OPE

图10 TPE评估精确度与成功率曲线

Fig. 10 Precision and sucess rate curves of TPE

3 结束语

基于深度学习的尺度自适应海面目标跟踪算法提出一种新的尺度自适应方法, 该算法采用孪生网络结构, 直接回归候选区域中心点获得最终目标框, 而不再依赖于锚框, 更适用于目标尺度变化较大的海面船只目标跟踪。为了验证文中算法的有效性, 在基于真实应用场景建立的无人艇海面目标跟踪测试序列中进行了定量和定性分析。试验表明, 相比基于锚框的算法, 文中算法能够更有效地解决海面目标跟踪场景中目标尺度自适应问题, 跟踪精度达到87%, 跟踪成功率达到59.9%。

[1] 彭艳, 陈加宏, 李小毛, 等. 时空上下文融合的无人艇 海面目标跟踪[J]. 中国科学: 技术科学, 2018, 48(12): 1357-1372.

Peng Yan, Chen Jia-hong, Li Xiao-mao, et al. Sea Surface Object Tracking for USV with Spatio-Temporal Context

Fusion[J]. Scientia Sinica Technologica, 2018, 48(12): 1357-1372.

[2] Wu Y, Lim J, Yang M H. Online Object Tracking: a Benchmark[C]//IEEE Conference on Computer Vision and Pattern Recognition. Portland, OR, USA: IEEE, 2013: 2411-2418.

[3] Wu Y, Lim J, Yang M H. Object Tracking Benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[4] Henriques J F, Caseiro R, Martins P, et al. High-Speed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[5] Danelljan M, Hager G, Khan F S, et al. Discriminative Scale Space Tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[6] Li Y, Zhu J. A Scale Adaptive Kernel Correlation Filter Tracker with Feature Integration[C]//European Conference on Computer Vision. Zurich, Switzerland: ECCV, 2014: 254-265.

[7] Huang D, Luo L, Wen M, et al. Enable Scale and Aspect Ratio Adaptability in Visual Tracking with Detection Proposals[C]//Proceedings of the British Machine Vision Conference. Swansea, UK: BMVC, 2015.

[8] Montero A S, Lang J, Laganiere R. Scalable Kernel Correlation Filter with Sparse Feature Integration[C]//2015 IEEE International Conference on Computer Vision Workshop (ICCVW). Santiago, Chile: IEEE, 2015: 587- 594.

[9] Li F, Yao Y, Li P, et al. Integrating Boundary and Center Correlation Filters for Visual Tracking with Aspect Ratio Variation[C]//IEEE International Conference on Computer Vision. Shenzhen, China: IEEE, 2017: 2001-2009.

[10] Bertinetto L, Valmadre J, Henriques J F, et al. Fully- convolutional Siamese Networks for Object Tracking[C]// European Conference on Computer Vision. Amsterdam, Netherlands: ECCV, 2016: 850-865.

[11] Li B, Yan J, Wu W, et al. High Performance Visual Tracking with Siamese Region Proposal Network[C]// IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 8971-8980.

[12] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[13] Tian Z, Shen C, Chen H, et al. FCOS: Fully Convolutional One-Stage Object Detection[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). South Korea: IEEE, 2020.

[14] Lin T Y, Goyal P, Girshick R, et al. Focal Loss for Dense Object Detection[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2020, 42(2): 318-327.

[15] Zhang Z, Peng H. Deeper and Wider Siamese Networks for Real-Time Visual Tracking[EB/OL]. [2019-03-28]. https://arxiv.org/abs/1901.01660?context=cs.

1. 杨向锋, 熊淑贞, 石磊. 声自导鱼雷目标跟踪误差仿真与分析[J]. 水下无人系统学报, 2020, 28(5).

2. 王香, 张永林. 基于RBF神经网络的AUV路径跟踪分数阶滑模控制[J]. 水下无人系统学报, 2020, 28(3).

3. 霍宇彤, 郭晨, 于浩淼. 欠驱动AUV三维路径跟踪RBF神经网络积分滑模控制[J]. 水下无人系统学报, 2020, 28(2).

4. 程帅, 张秦南, 王立文. 一种机动目标运动要素估计算法[J]. 水下无人系统学报, 2020, 28(1).

5. 王斌, 温泉, 范世东. 基于Huber M-CKF的UUV目标跟踪算法[J]. 水下无人系统学报, 2020, 28(1).

6. 李鑫, 黄茹楠, 丁宁. 输入受限的自主水下航行器自适应反演控制[J]. 水下无人系统学报, 2019, 27(6).

7. 桑宏强, 于佩元, 孙秀军. 基于航向补偿的水下滑翔机路径跟踪控制方法[J]. 水下无人系统学报, 2019, 27(5).

8. 杜金香, 许恒博, 祝鹏. 一种角度加权的最小二乘目标定位算法[J]. 水下无人系统学报, 2019, 27(5).

9. 姚金艺, 曾庆军, 周启润, 等. 全驱动AUV系统路径跟踪设计与实现[J]. 水下无人系统学报, 2019, 27(4).

10. 李娟, 张建新, 杨莉娟, 等. 未知环境下UUV动态目标跟踪导引方法[J]. 水下无人系统学报, 2019, 27(3).

11. 张思宇, 何心怡, 张驰, 等. 水下多目标跟踪技术现状与展望[J]. 水下无人系统学报, 2018, 26(6).

Scale Adaptive Sea Surface Target Tracking Algorithm Based on Deep Learning

WU Xiang1, ZHONG Yu-xuang2*, YUE Qi-qi1, LI Xiao-mao1

(1. School of Mechatronic Engineering and Automation, Shanghai University, Shanghai 200444, China; 2. School of Computer Engineering and Science, Shanghai University, Shanghai 200444, China)

Compared with target tracking in common scenes, sea surface target tracking presents unique challenges such as changes in the target scale and perspective as well as intense dithering of targets.Accordingly, a scale-adaptive sea surface target tracking algorithm based on deep learning is proposed. The algorithm classifies samples according to whether the central point of the sample falls to the ground truth and then regresses the distances from the target location to the four sides of the bounding box to predict the position and scale of the target.An evaluation platform for the sea surface target tracking algorithm is also establishedto verify the effectiveness of the proposed algorithm. Experimental results show that compared with the anchor-based algorithm, the tracking accuracy of the proposed algorithm is improved by 4.8% and its success rate is improved by 11.49%, thus effectively solving the problem of target scale adaptation.

unmanned surface vessel; scale adaptation; deep learning; target tracking

吴翔, 钟雨轩, 岳琪琪, 等. 基于深度学习的尺度自适应海面目标跟踪算法[J]. 水下无人系统学报, 2020, 28(6): 618-625.

U664.82; TP273.2

A

2096-3920(2020)06-0618-08

10.11993/j.issn.2096-3920.2020.06.005

2020-10-15;

2020-12-02.

国家重点研发计划资助项目(2017YFC0806700); 科技部重点研发计划项目(No.2018YFF0103400); 上海市科学技术委员会科研计划项目(No.17DZ1205001)

吴 翔(1991-), 男, 在读硕士, 初级工程师, 主要研究方向为无人艇自动控制.

(责任编辑: 陈 曦)