基于神经网络与数据融合的行人检测方法*

2020-12-08黄茂飞谈东奎胡旭东顾家鑫

朱 波, 黄茂飞, 谈东奎,胡旭东,顾家鑫

(合肥工业大学汽车工程技术研究院,合肥 230009)

前言

行人作为交通参与者中的弱势群体,常常是最易受到车辆碰撞而被伤害的群体。 据统计,全球范围内行人与骑自行车者占交通事故死亡总人数的26%[1]。 随着高级驾驶辅助系统(advanced driving assistance system, ADAS)的发展,自动紧急制动系统(autonomous emergency braking,AEB)的应用越来越普遍。 但现有的AEB 系统多采用毫米波雷达或摄像头等单一传感器对目标进行识别,由于毫米波雷达对行人的识别难度较大,而摄像头对距离等数据探测不够准确,造成现有AEB 系统对行人的检测效果不够理想。

近年来,国内外专家和学者在行人识别与检测方面做了大量研究并取得了丰富的成果。 文献[2]中提出了一种基于深度神经网络的行人和骑车人联合检测方法,实现了行人和骑车人的联合检测与有效识别。 文献[3]中提出了一种基于运动分析的运动行人检测方法,提高了行人检测的实时性。 文献[4]中通过改进的HOG 与Sobel-LBP 融合算法实现了行人的快速检测。 文献[5]中提出了一种视觉和毫米波雷达信息融合的行人识别算法,能获取更加精确的行人特征且提高了对行人的识别率。

本文中提出一种基于神经网络与数据融合的行人检测方法。 该方法首先根据本车车速划定可变潜在危险区,即划定毫米波雷达与Mobileye 的目标检测范围,然后通过Mobileye 与毫米波雷达分别对可变潜在危险区内的目标进行检测,并对毫米波雷达识别的目标通过神经网络算法筛选出疑似行人目标,再将其与Mobileye 识别的行人目标进行匹配和数据融合。 经实车试验验证,该算法能够实现对行人的准确识别以及对行人位置进行准确估计。

1 毫米波雷达、Mobileye 单一传感器行人检测

1.1 可变潜在危险区划定

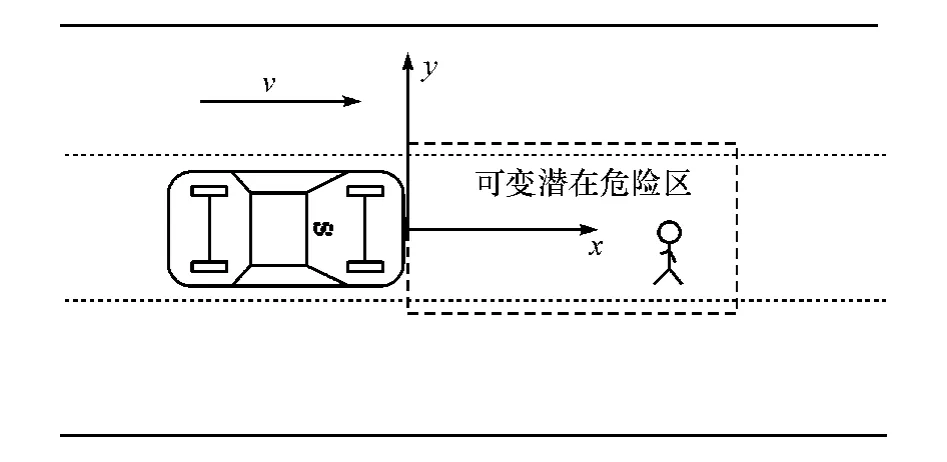

为了描述行人的位置,首先建立毫米波雷达坐标系,如图1 所示,以毫米波雷达中心为原点,车辆行驶方向为x轴正方向、与车辆轴线垂直指向驾驶员左侧为y轴正方向。

图1 毫米波雷达坐标系

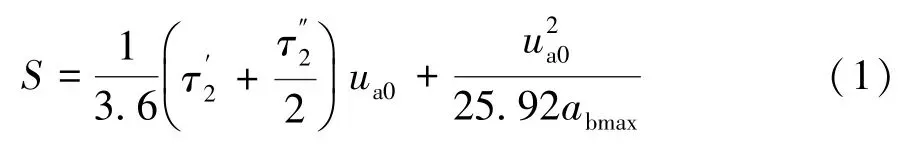

为了减少后续目标筛选与计算工作量,不同于现有方法中划定一个固定且较大的探测区域,本文中根据本车车速划定可变潜在危险区,即范围随车速变化的可能对行车安全造成威胁的有行人的区域。 根据汽车制动距离S和驾驶员反应时间tR等可以确定可变潜在危险区的x向(纵向)长度L,汽车的制动距离S可通过式(1)计算[6]:

据统计驾驶员的制动反应时间为 1.14 ~1.38 s[10],为保证安全,取tR=1.38 s;再考虑特殊情况下路面附着能力较低以及制动后的安全距离等因素,对可变潜在危险区的纵向长度多预留10 m 的距离,以确保行人安全。 可变潜在危险区的纵向长度L(m)通过式(2)计算:

可变潜在危险区y向(横向)宽度根据车辆宽度D确定,考虑传感器测量误差与横向安全距离,可变潜在危险区y向宽度为±(D/2+1) m,本文中使用的车辆宽度D=1.794 m,取可变潜在危险区y向宽度为±1.9 m,即

1.2 基于毫米波雷达的行人检测

本文中使用的雷达能够通过CAN 总线配置过滤器来输出某一范围内的目标,根据1.1 节中可变潜在危险区的范围配置毫米波雷达的输出目标范围。 首先通过真实目标初选[11]和目标有效性检验[12]筛选出毫米波雷达检测到的有效目标,再在有效目标中筛选出疑似行人目标。

多层神经网络在诸多分类问题中都有很好的性能表现[13],而毫米波雷达可通过CAN 总线输出目标的x、y向相对速度、目标长度、目标宽度和雷达散射截面积等数据。 其中,若保持车辆静止对行人进行检测,则可获得行人的绝对速度,行人的绝对速度可作为行人的运动特征。 在车辆实际运行过程中可通过车辆CAN 总线或其他传感器获取车辆的运动速度,结合毫米波雷达测得的目标相对车辆的运动速度进行计算,则可获取目标的绝对速度;而雷达散射截面积是目标在雷达波照射下所产生回波强度的一种物理量,它与目标的形状、结构和材料等因素有关。 通过目标x、y向绝对速度、目标长度、目标宽度和雷达散射截面积等参数再利用神经网络分类算法可筛选出疑似行人目标,从而提高后续行人目标匹配准确性和减少后续处理的数据量。

1.2.1 神经网络结构

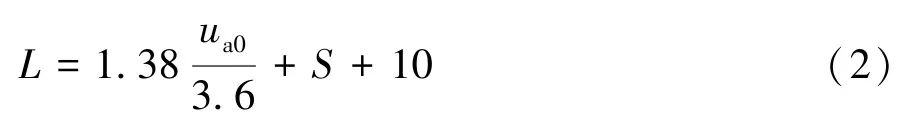

本文中采用输入层、单个隐含层和输出层组成的3 层神经网络,神经网络结构如图2 所示。 其中:x1,x2,…,x5分别表示目标x向绝对速度、目标y向绝对速度、目标长度、目标宽度和雷达散射截面积等5 个输入参数;y1和y2分别表示目标类型为行人和其他类型。

图2 神经网络结构

根据多次试验验证隐含层节点数取7,激活函数采用Sigmoid 函数:

式中f(x)为隐含层输出,范围为(0,1),x为隐含层输入。

本文中将毫米波雷达目标分为行人和其他目标两类,所以输出层节点设置为2。 输出层激活函数采用Softmax 函数:

式中:Si为当前元素的指数与所有元素指数和的比值;Vi为前级的输出;C为类别总数。

1.2.2 样本采集

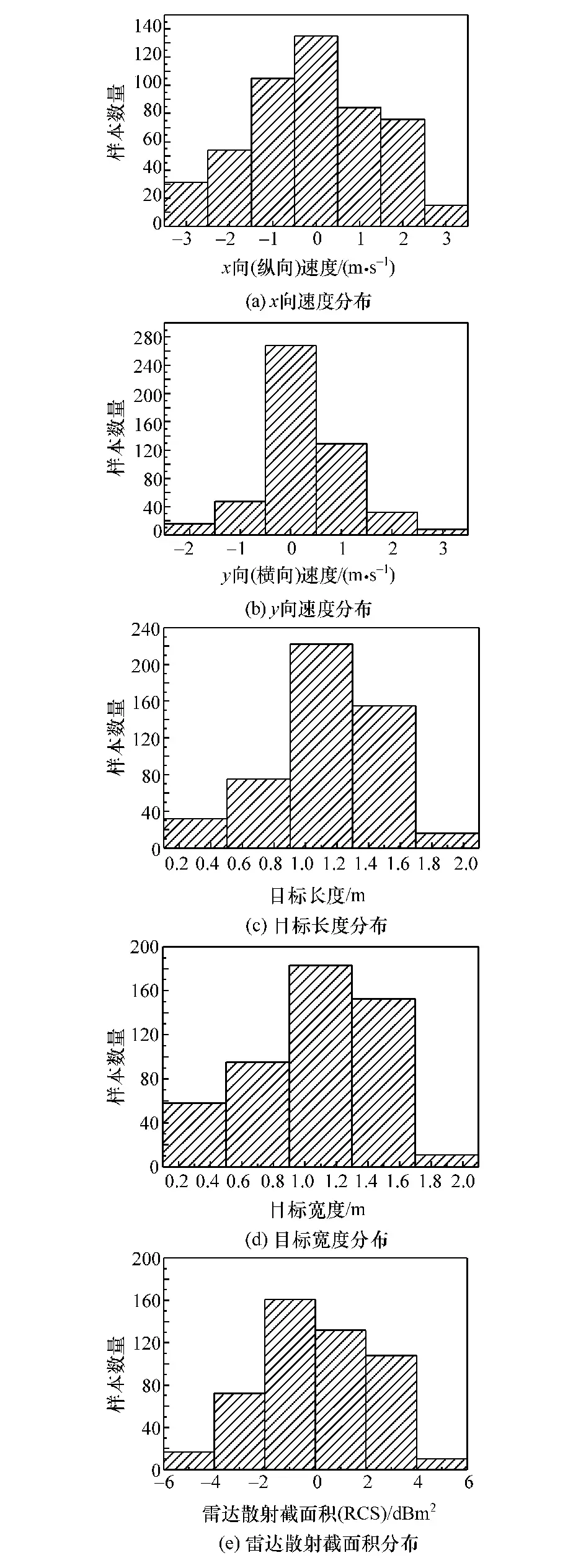

行人碰撞一般多发生在城市街道,我国交通法规规定城市道路车速不超过60 km/h,超速10%予以警告。 取ua0=66 km/h,并代入式(1)和式(2),求得L=74.78 m。 在x方向 74.78 m、y方向±1.9 m范围内,保持车辆静止,采集不同体型、不同行走状态的行人以及不同交通工具或障碍物的雷达探测数据作为训练样本。 本文中采集样本数量为1 000个,其中行人样本500 个,其他样本500 个,图3 为行人样本各特征的分布情况。

图3 行人样本特征分布

1.2.3 离线训练模型

量化共轭梯度下降法(scaled conjugate gradient,SCG)具有收敛速度快、无须设置学习率等参数的特点, SCG 神经网络不仅改进了BP 网络容易陷入到局部极小、不适用于大规模神经网络以及需要调节多个影响网络性能的参数等多个缺点,还具备识别误差较小的优越性[14]。

所以本文中采用量化共轭梯度下降法对网络进行训练。 将样本的70%作为训练集,15%作为验证集,剩余的15%作为测试集。

1.2.4 模型训练结果

训练集分类结果如表1 所示,训练集样本总数为700 个,其中行人样本359 个,正确将其分类为行人的样本数为352 个,错误将其分类为其他类型样本数为7 个,训练集行人目标分类正确率为98.1%。

表1 训练集分类结果

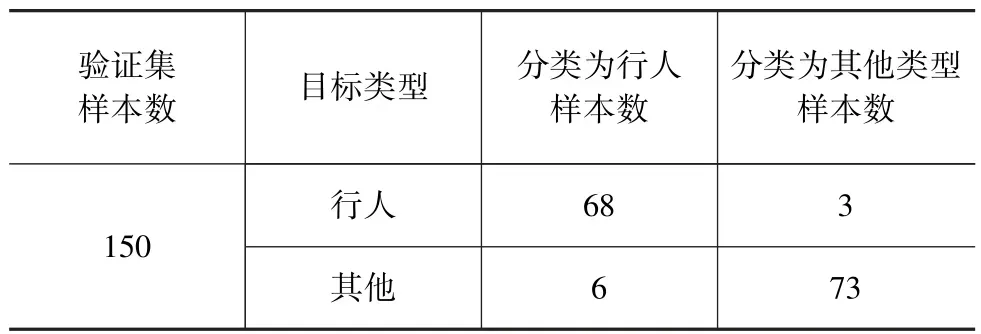

验证集分类结果如表2 所示,验证集样本总数为150 个,其中行人样本71 个,正确将其分类为行人的样本数为68 个,错误将其分类为其他类型样本数为3 个,验证集行人目标分类正确率为95.8%。

表2 验证集分类结果

测试集分类结果如表3 所示,测试集样本总数为150 个,其中行人样本70 个,正确将其分类为行人的样本数为68 个,错误将其分类为其他类型样本数为2 个,测试集行人目标分类正确率为97.1%。

表3 测试集分类结果

SCG 神经网络训练结果表明,在1 000 个样本中,总体分类正确样本数为926 个,总体分类正确率为92.6%;其中行人样本数为500 个,正确分类样本数为488 个,行人样本分类正确率为97.6%。

1.3 基于Mobileye 的行人检测

Mobileye 是由以色列Mobileye 公司生产的一款单目视觉摄像头,其具有强大的图像处理算法,能够准确识别行人、车辆等目标,主要通过CAN 通信来输出检测信息。 基于Mobileye 的行人检测主要包括报文解析和目标筛选等步骤。

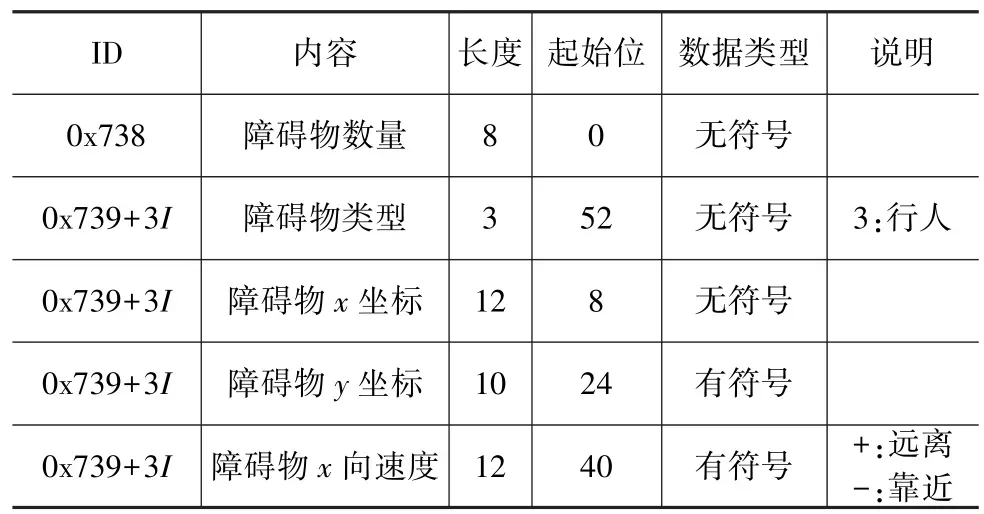

1.3.1 Mobileye CAN 报文解析

本文中采用的Mobileye 版本可通过CAN 总线输出目标的数量、类型、速度以及目标的位置等信息,相关CAN 报文如表4 所示。

表4 Mobileye 报文

1.3.2 Mobileye 检测目标筛选

由于Mobileye 检测范围固定,无法配置调整,所以需要在检测到的所有目标中筛选出位于潜在危险区内的行人目标。 是否位于潜在危险区根据1.1 节中潜在危险区的范围确定,是否为行人目标通过CAN 报文中的障碍物类型确定。

2 毫米波雷达与Mobileye 数据融合

2.1 空间融合

由于毫米波雷达与Mobileye 安装位置不同,两传感器检测到的行人坐标分别是相对于毫米波雷达坐标系和Mobileye 坐标系,为了后续对数据进行融合,首先需要对两传感器进行空间融合,即进行坐标转换。 考虑行人碰撞关注车头与行人之间的距离,本文中将Mobileye 坐标转换到毫米波雷达坐标系。

由于Mobileye 安装标定过程中通过标靶和自带标定程序标定车头中间位置,所得目标的坐标即为车头坐标系坐标。 所以在标定过程中以毫米波雷达中心作为Mobileye 标定位置,Mobileye 输出坐标即为毫米波雷达坐标系坐标,空间融合过程示意图如图4 所示。

图4 空间融合

2.2 时间融合

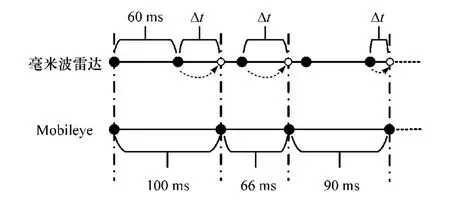

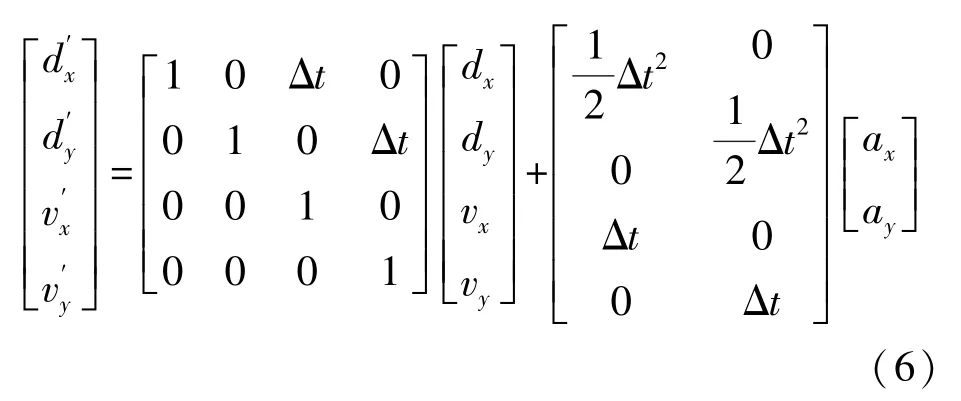

为了保证毫米波雷达与Mobileye 在时间上的同步,需要对两传感器的信息进行时间融合。 本文中采用的毫米波雷达数据采样周期为60 ms, Mobileye采样周期为 66 ~ 100 ms。 由于 Mobileye 为变动周期,以Mobileye 周期为系统的数据更新周期,并通过毫米波雷达最近的一个采样时间点的数据预测某一系统数据更新点时毫米波雷达的数据,时间融合示意图如图5 所示。 利用式(6)预测系统数据更新时刻毫米波雷达的数据:

图5 时间融合

2.3 行人目标匹配

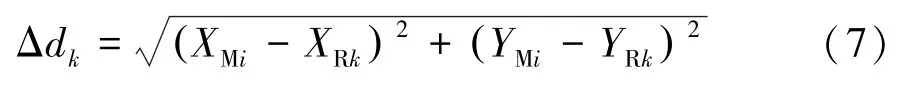

根据Mobileye 手册,其x向测量误差小于10%或2 m(两者中间的较大值)。 首先在Mobileye 检测到的某一行人目标(XMi,YMi)(i= 1,2,3…)的x向误差范围内初步匹配毫米波雷达所探测到的疑似行人目标(XRk,YRk)(k= 1,2,3…);然后通过x向(纵向)运动速度方向一致再次筛选(Mobileye可通过报文输出目标纵向速度),纵向运动速度方向一致是指毫米波雷达和Mobileye 检测到的同一行人目标的纵向运动方向应一致,即同为远离(纵向速度为正值)、同为靠近(纵向速度为负值)或同为静止(纵向速度为0);最后通过最小距离原则进行准确匹配,即

式中:Δdk为毫米波雷达和Mobileye 检测到的目标之间的距离,取Δdk最小时对应的目标(XRk,YRk)作为Mobileye 检测到的行人目标(XMi,YMi)的匹配目标。

2.4 行人检测数据融合

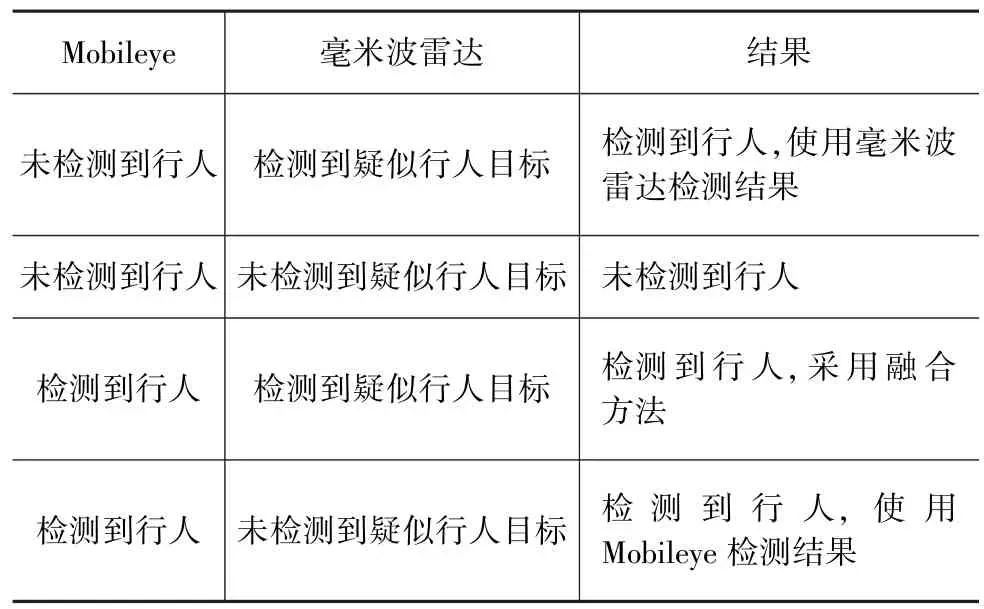

2.4.1 融合策略

由于Mobileye 与毫米波雷达测量原理不同,检测结果会有所差异,各种情况下的结果采用表5 的方法。

表5 融合策略

2.4.2 基于卡尔曼滤波的数据融合

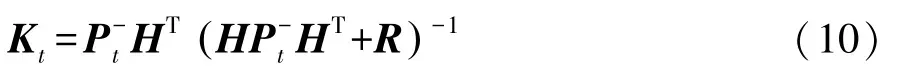

当Mobileye 与毫米波雷达同时检测到行人目标并匹配成功时,为了获得更准确的行人位置信息,需要对两传感器的检测数据进行融合。 卡尔曼滤波具有的递推特性既可以让系统对当前状态进行估计,也可以对未来的状态进行预测,因而卡尔曼滤波是信息融合常用方法之一[15]。 运用卡尔曼滤波对两传感器检测的行人目标进行数据融合,取[d,v]T为状态向量,预测方程为

式中:为t时刻状态向量的预测值;F为状态转移矩阵;B为控制矩阵;at-1为t-1 时刻控制量(加速度)。 令。

协方差矩阵传递公式为

式中:为t时刻的预测状态协方差矩阵;Pt-1为t-1 时刻的状态协方差矩阵;F为状态转移矩阵;Q为过程噪声协方差矩阵。

卡尔曼增益计算公式为

式中:Kt为t时刻的卡尔曼增益;H为观测矩阵;R为测量噪声协方差矩阵。 本文中采用两传感器数据融合分别表示毫米波雷达与Mobileye 的测量噪声协方差,其表示卡尔曼滤波器对两种传感器的信任权重,数值越小表明对该传感器的信任权重越大。

最优估计值的计算公式为

协方差矩阵Pt的更新公式为

式中Pt为t时刻的状态协方差矩阵。

2.4.3 数据测量(融合)效果评价指标

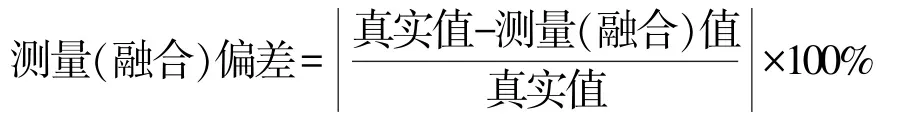

对于毫米波雷达与Mobileye 对行人位置检测数据的测量(融合)效果通过“测量(融合)偏差”这一指标来评价,该值越小表示测量(融合)效果越好,“测量(融合)偏差”计算公式为

3 试验验证

3.1 试验平台

试验平台如图6 所示,主要包括某款轿车、某款主流中远程毫米波雷达、Mobileye 630 以及dSPACE/MicroAutoBoxⅡ,通过 MATLAB/Simulink 搭建系统的算法模型,并在ControlDesk 软件中观测和记录试验数据。

图6 试验平台

3.2 单个行人目标识别与检测

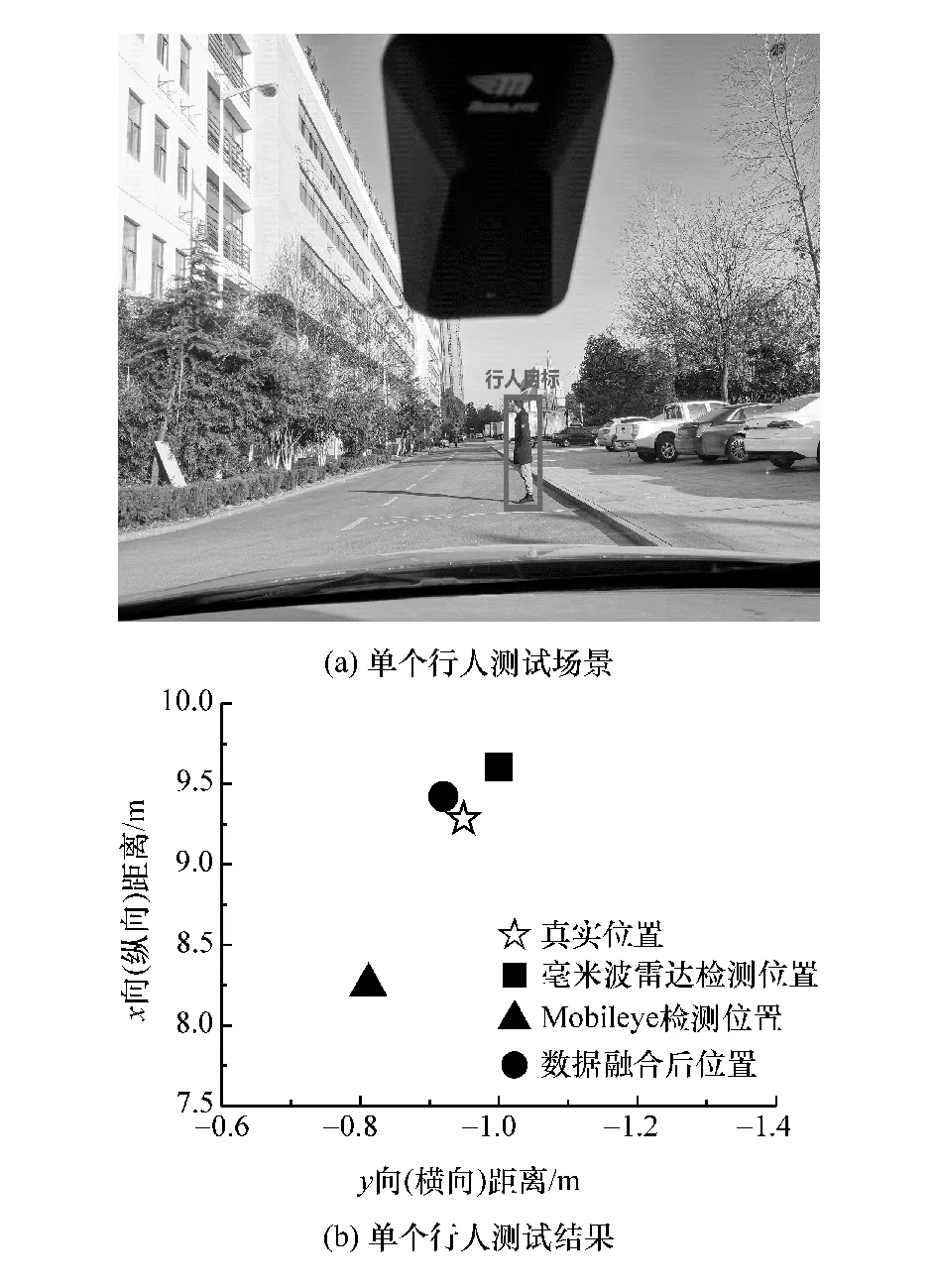

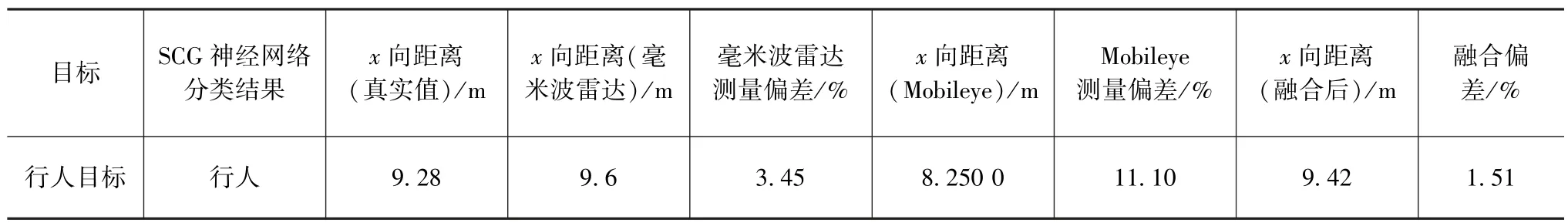

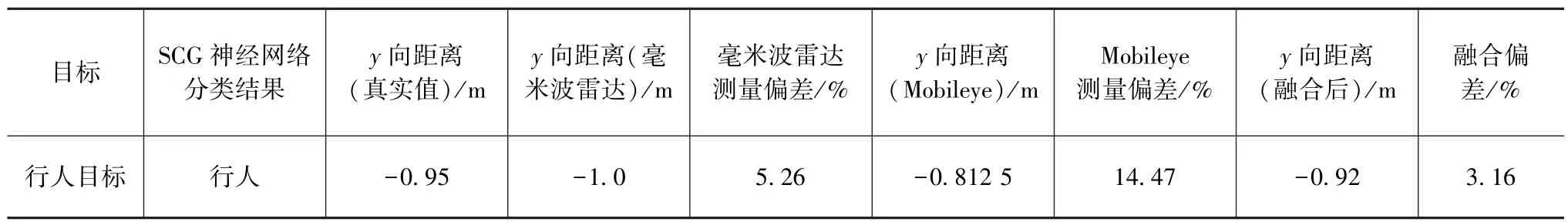

在单个行人场景下对算法进行测试,如图7(a)所示,检测结果见图7(b),检测数据如表6 和表7所示。

单个行人目标识别与检测结果表明,本文的方法能够通过神经网络准确判断毫米波雷达检测到的目标为行人,并且能与Mobileye 检测到的行人目标进行准确匹配,最后通过卡尔曼滤波进行数据融合,能够在一定程度上减小行人位置的检测误差。

图7 单个行人目标识别与检测

表6 单个行人检测x 向距离

表7 单个行人检测y 向距离

3.3 多行人多目标识别与检测

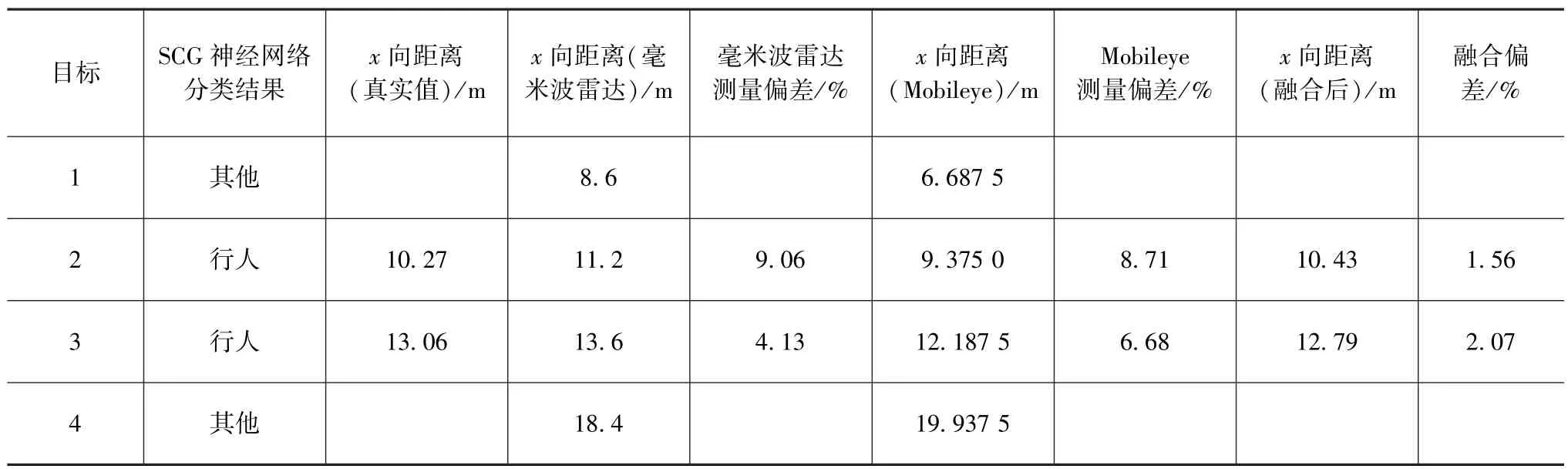

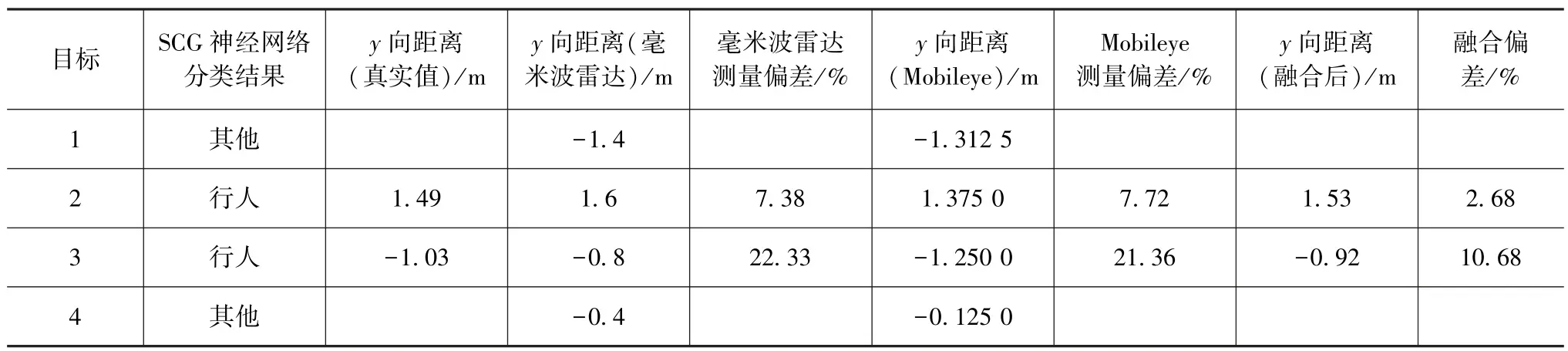

多行人多目标检测场景如图8(a)所示,由近及远1、2、3、4 号目标分别为电动车、行人、行人和汽车,本文中主要关注对象为行人,暂不对其他类目标进行融合处理,检测结果如图8(b)所示,检测数据如表8 和表9 所示。

多行人多目标识别与检测试验结果表明:本文的方法能够在多类型目标中准确判断出毫米波雷达探测到的目标2 和目标3 为行人,并与Mobileye检测到的行人目标进行正确匹配;采用卡尔曼滤波算法对两传感器检测到的行人位置数据进行融合,x向(纵向)距离融合偏差最大为2.07%,y向(横向)距离融合偏差最大为10.68%,能满足AEB 等高级驾驶辅助系统对检测精度的要求;对比单一传感器对应测量值表明,采用本文中两传感器数据融合的方法能有效降低对行人位置检测的误差。

图8 多行人多目标识别与检测

表8 多行人多目标检测x 向距离

表9 多行人多目标检测y 向距离

4 结论

(1)利用SCG 神经网络对毫米波雷达检测到的目标进行分类,可有效筛选出目标中的疑似行人目标,提高了将其与Mobileye 检测到的行人目标进行匹配的可靠性;

(2) 利用卡尔曼滤波算法对毫米波雷达和Mobileye 检测到的行人位置数据进行融合可有效提高对行人位置检测的精度,保证行人检测数据的准确性。