基于多模型卷积神经网络的乳腺癌病理医疗图像良恶性诊断

2020-04-11孙福权丛成龙孔超然姜玉山多允慧

孙福权,丛成龙,张 琨,孔超然,姜玉山,多允慧

1(东北大学 信息科学与工程学院,沈阳110819)2(东北大学秦皇岛分校 数学与统计学院,河北 秦皇岛066004)

1 引 言

乳腺癌是导致女性病亡的主要原因之一.2013年的卫生局发布的统计结果显示,在中国女性癌症死亡原因中,乳腺癌位居第六.于此同时,乳腺癌也成为了中国女性发病率最高的癌症[1].美国癌症协会发布的统计结果显示,乳腺癌正向着年轻化的趋势发展[2].疾病及时准确的诊断对后期治疗起着至关重要的作用,虽然近年来医疗影像技术发展十分可观,但病理学图像诊断依然在最终确诊、分级和分期方面发挥着巨大的作用.

目前,对乳腺癌病理图像辅助诊断的研究主要有手工提取特征的传统图像处理和基于深度学习的图像处理两种方法[3,4].由于深度学习有着极强的特征自动抽取能力,可以解决传统机器学习对手工提取特性的依赖,近年来,针对深度学习的乳腺癌病理图像诊断的研究陆续开展.深度学习是大数据驱动下的智能,对数据量具有一定的要求.2015年,Spanhol等人和巴西巴拉那的P&D实验室发布了本文中使用的BreakHis数据集[5].针对BreakHis数据集的研究一直不断进行,文献[5]中作者利用四种机器学习方法和六种特征描述对数据集进行研究,取得80%-85%的准确度.文献[6]在Breakhis数据集上进行了放大倍数独立的研究,在单任务和多任务问题上取得了83.25%和82.13%的准确度.文献[7]对病理图像直接提取DeCAF特性,将提取的特征送入分类器,在乳腺癌病理图像上取得了86.3%的准确度.中国学者He等人采用一种改进的卷积神经网络方法,实现了91%的准确率.

本文以结合迁移学习的VGG16[8]、Inception-V3[9]和ResNet-V2-152[10]为基线,对乳腺癌病理学图像进行良恶性诊断.良恶性诊断属于二分类问题,由于二分类问题存在非此即彼的特性,单一模型诊断容易出现误诊,本文采用迁移学习[11]策略先对VGG16、Inception-V3和ResNet-V2-152进行参数微调,再利用多数投票融合算法对三个模型结果进行集成融合[12].即三个模型模仿三个医生,集成多个“专家”进行决策,将个体分类器的分类结果进行投票以进一步提高诊断准确度.为进一步证明该方法的有效性,又运用该方法对BreakHis进行了放大类别独立的研究,虽然在诊断准确度上放大类别独立问题较放大类别单一问题有所下降,但仍然具有很高的准确度.

2 相关工作

2.1 深度学习介绍

深度学习[13]受神经网络启发,具有很强的特征学习能力.浅层结构抽取简单细节,深层结构学习更加抽象的特征,以高度挖掘图像本质信息.作为一种逐层分解算法,深度学习由于其极强的特征表达能力、泛化能力和几何不变性在计算机视觉领域得到了广泛认可.以Alex[14]为引导的一系列卷积神经网络如VGGNet、GoogleNet[15]和ResNet[16]等相继提出,在ILSVRC大赛中取得优秀成绩并在计算机视觉领域得到改进应用.深度学习算法的设计人员一直在保证不发生梯度消失和梯度弥散等问题的前提下对网络进行更深更宽的探索[17].完整的用于完成分类任务的深度学习算法主要包含输入层、卷积池化层和softmax分类器三个模块.

输入层:负责载入图像,可以看成原始图像和特征提取器的连接媒介,本文所有的输入图像固定为224×224或299×299.

卷积池化层:负责特征表示和特征向量降维,主要是用一个采样器从输入数据中采集关键数据内容.Feature map经过卷积运算并加入偏置量后会被送入到激活函数中,以此实现非线性特征的提取.池化层可以在保留主要特征的同时降低维度和计算量,以防止过拟合提高模型泛化能力.

分类器:分类器一般由全连接神经网络层和softmax函数构成.softmax的函数形式如公式(1)所示,因为对数似然函数中log可以抵消exp,所以我们通常将softmax定义成如公式(2)所示的指数形式

(1)

(2)

(3)

2.2 病理图像数据及预处理

本文采用公开数据集BreakHis进行研究,BreakHis由Spanhol等人于2015年公布.该数据集包含了82名患者的7909张病理学图像,其中良性图片2480张,恶性图片5429张,如图1所示.在良性和恶性类别图像下又分别包含了四个子类.所有的疾病类型下又包含了40X、100X、200X和400X的放大类别,本文的研究主要在200X的数据上展开.图2中的A、F、TA和PT指的是良性子类疾病:腺病、纤维肿瘤、叶状瘤和管状腺瘤.DC、LC、MC和PC指的是恶性子类疾病:导管癌、小叶癌、胶样癌和乳突癌.

图1 200X良恶性病理图像Fig.1 200X benign and malignant histopathology images

图2 BreakHis整体数据分布柱状图Fig.2 Histogram of the overall data distribution of BreakHis

从图2可以看出,恶性图像明显多于良性图像,数据存在严重的数据量不均衡问题.为解决数据不均衡带来的恶性病理样本过度学习问题,本文先对数据进行均衡化处理.并通过随机裁剪和旋转的方式对所有数据进行简单扩充.在扩充前将88%的数据划分出来充当训练集,其余数据用于测试.并对训练集数据进行三次有放回抽取,每次抽取训练数据的95%,抽取出的三个子集分别作为三个基分类器的训练数据,以进一步增加基础模型之间多样性.

3 模型结构

对于乳腺癌病理学图像的良恶性诊断问题,本文利用深度学习模型融合的方法进行研究.为进一步验证本文方法在良恶性诊断问题上的可行性.本文又将所有放大类别的图像同时当做训练集和测试集,进行不依赖放大类别的实验处理.

对于本文的二分类问题,假设真实函数为f,每个基础分类器用h表示,则基础分类器的错误率可表示为:ε=P(hi(x)≠f(x)).利用少数服从多数的融合策略对基础分类器进行融合.在基础分类器完全独立的情况下,由Hoeffding不等式可得出融合模型的错误率,如公式(4)所示.其中H(x)表示融合模型的分类结果,f(x)表示真实结果.

(4)

由公式(4)可以看出,个体分类器数目T的增加会使融合模型的分类错误率成指数函数下降,并趋向于零.模型融合过程中,基础模型之间的结构差异性越大且性能表现差异越小时,融合模型才能表现出更好的性能.但往往并不单纯如此,基分类器个数过多时,同样会带来过拟合的问题,甚至分类结果不增反降.只有设计恰当数目且好而不同的基分类器,并解决个体分类器之间多样性和准确性之间的冲突,才能让融合模型博采众长.

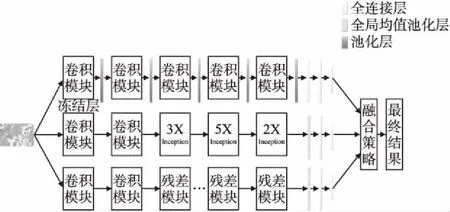

图3 模型整体结构图Fig.3 Network architecture of the model

本文提出的计算机辅助诊断模型选用了三个体诊断器进行融合,整体结构如图3所示,结构图从上到下依次为VGG16、Inception-V3和ResNet-v2-152,并将三个分类器结合了不同的迁移学习方法.三个诊断器的个体表现性能相差不大,所以在融合策略方面不必进行加权,直接采用多数投票算法,相当于三个个体诊断器分别模仿三个医生,集成多个“专家”进行决策.

本文利用三个异构深度学习模型进行研究,第一个基础分类器以VGG16为基线,VGG16的训练参数较残差网络和Inception网络多很多,对训练造成困难,容易出现过拟合问题.于是本文对VGG16采用ImageNet数据集进行预训练,将预训练参数迁移到乳腺癌病理问题的VGG16上,并引入冻结层,将第一个卷积模块进行冻结.本文中应用在病理学图像诊断上的VGG16可以分为特征提取模块和分类器两大部分,而特征提取模块又可分为冻结层和微调层,冻结层用来提取病理学图像浅层特征,微调层可提取更加深层次更加抽象的特征以供分类器准确分类.

深度学习模型可以看成是现实的反应,在不考虑梯度消失弥散等问题的前提下,模型越深越宽则越接近现实镜像,对样本数量的需求也会随着模型复杂度的增加而增长.迁移学习作为一种训练策略可以解决样本数量不足问题,提高泛化性和鲁棒性.本文第二个和第三个基础分类器采用Inception-V3和ResNet-V2-152,将其结合迁移学习,将ImageNet上训练得到的参数迁移到目标领域上去,并利用Breakhis数据将对模型进行微调.最后将三个异构个体学习器进行融合.

4 实验结果分析

4.1 200X子集问题实验结果

对于BreakHis数据集,可以从两个方面对其进行评估.一方面可以从患者方面进行,可由公式(5)和公式(6)进行表示,其中Nrp表示每位患者的病理图像中被正确分类的数目,Nnp表示每位患者的病理图像总数,Nallp表示患者总人数.

(5)

(6)

另外一方面可以直接从图像的级别进行评估,这也是本文实验采用的方法,对比实验中的部分文献只从患者的级别进行了评估.图像级别的评估公式如(7)所示,其中Nall表示测试图像总数,Nr表示被正确分类的图像数目.

(7)

为证明本文方法在乳腺癌病理图像诊断方面的有效性,将本文方法与同样在BreakHis上开展的研究进行对比,对比结果展示见表1和表2.本文在这一部分的实验是在BreakHis 200X数据集上展开,表中展示的准确度都是基于患者级别或图像级别.其中PFTAS+QDA、PFTAS+SVM和PFTAS+RF由Spanhol等在文献[5]中提出,Alex方法识别病理图像是文献[18]中的成果,Single-task CNN是文献[6]中单任务部分基于放大倍数独立的研究.DeCAf是文献[7]中作者以Alex为基础提取DeCAF特性而得出的方法.He指的是中国学者何雪英等采用一种改进的卷积神经网络得出的算法.

表1 准确度对比结果

Table 1 Accuracy comparison

方 法 准确度(%)PFTAS+QDS84.20PFTAS+SVM85.10PFTAS+RF83.50Alex83.10Sing-Task CNN84.63DeCAF86.30He91.00本文方法97.64

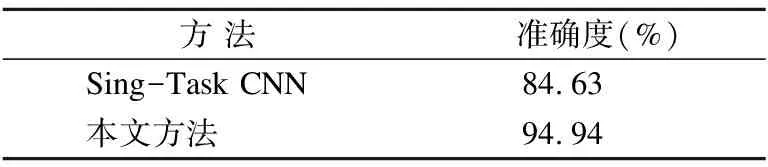

表2 放大倍数独立问题准确度对比

Table 2 Comparison of accuracy of independent

magnification problems

方 法准确度(%)Sing-Task CNN84.63本文方法94.94

4.2 放大类别独立问题实验结果

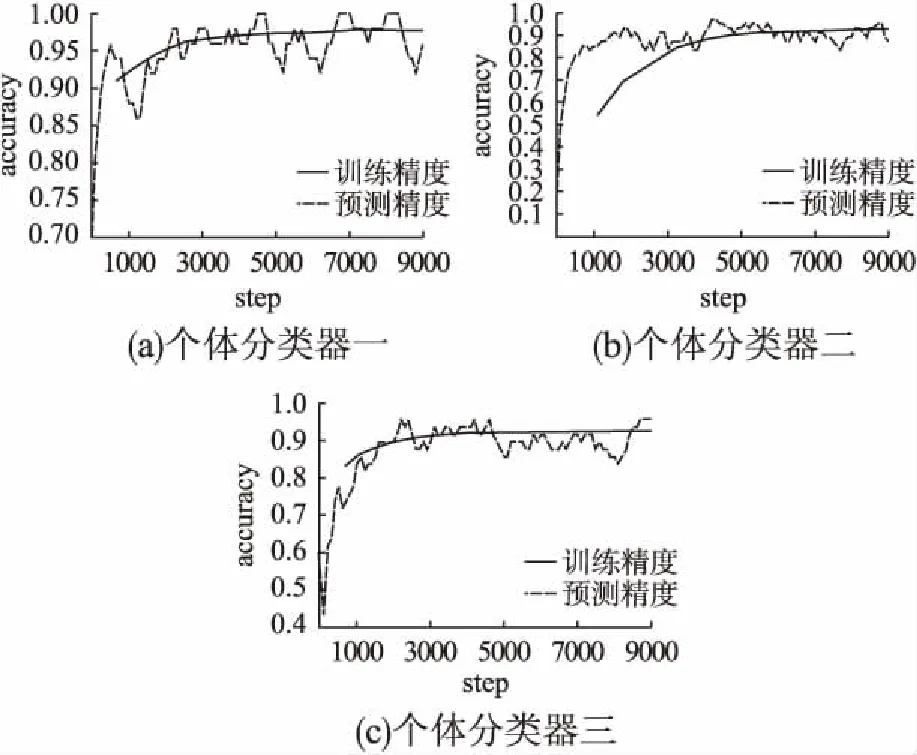

上述研究建立在BreakHis 200X数据集上,除次之外本文又以此方法进行了放大类别独立的研究,针对放大类别独立的研究相对较少,对比实验的结果见表2.同时单一模型的训练测试准确度变化趋势结果见图4.

图4 个体分类器在放大类别独立问题上的准确度曲线图Fig.4 Precision curve of individual classifier in amplifyingcategory independence problem

综上可知,相比手工提取特征结合机器学习的传统医疗图像处理方法,深度学习方法在处理简易度和准确度上展示出了优越性,具有很高的分类诊断准确性.在BreakHis数据集上,放大类别独立问题的分类准确度与200X数据子集问题的分类准确度相比有所下降,但是依然有着很高的准确性,深度学习模型学到了更多医疗图像信息.同时,模型融合的集成方法可以让算法到站在巨人的肩上有效地提高模型准确度.医疗图像数据具有数据质量低和数据不精确的特点,采集自不同设备的医疗图像又差异明显,因此医疗图像处理面临巨大挑战,同时医疗诊断结果关系到患者的生命健康,对于像计算机辅助诊断和临床辅助诊断这些辅助专家治疗系统要具备很高的准确度,如果在医疗辅助诊断领域恰当运用模型融合集成方法,进行多个“专家”决策,将会有效提高辅助诊断模型诊断准确性,为医生减轻负担的同时也为患者送去福音.

5 结 论

针对传统图像处理分类的准确度不高的问题,本文利用深度学习多模型融合的方法对三个异构模型识别结果进行融合,有效提高了乳腺癌良恶性诊断的准确度和客观性,在放大200倍的病理学图像上实现了97.64%的准确度,同时在放大类别独立的诊断问题上实现了94.94%的准确度.但个体分类器的多样性和准确性之间存在着一定程度的冲突,一般情况下多样性的增加会带来准确度的牺牲,所以在模型融合集成学习方法的研究中,要让设计的个体分类器之间“好而不同”,融合模型才能“博采众长”,即融合模型的性能才会高于个体分类器性能,这是下一步完善研究的方向之一.如果对乳腺癌的病理学图像进行细分诊断,诊断出良恶性疾病的子类疾病,则更有利于医生进行更精准的治疗,相比良恶性二分类诊断,细分多分类诊断面临的挑战要更艰巨,研究也更有价值,这也是我们下一步要进行的研究.