人工智能的民事主体资格探究

2020-03-01陈嘉敏

陈嘉敏,朱 健

(广东财经大学 法学院,广东 广州 510320)

一、研究背景

2010年11月7日,机器人“帕罗”在日本获得了户籍,这意味着“帕罗”成为了一位日本公民;2017年11月4日,机器人“涩谷未来”获得了东京的居住权,从这两件事可以推断出日本在一定程度上承认了人工智能的民事主体资格。美国将谷歌的无人驾驶系统视为“驾驶员”,沙特更是直接赋予了机器人“索菲亚”国籍。从这些国家的举动可以看出,它们似乎是将人工智能作为民事上的法律主体,因为无论是公民身份、居住权还是“驾驶员”身份的主体都是自然人,或者说,至少是民事上的法律主体。

那么人工智能是否可以成为民事上的法律主体呢?随着人工智能技术的愈发成熟,这一问题在我国学术界上引起了一番热议。有部分学者对此持赞同意见。如袁曾教授,他认为“人工智能具有独立自主的行为能力,有资格享有法律权利并承担责任义务,人工智能应当具有法律人格[1]”。吴汉东教授也提出“智能机器人本质是为机器,但亦有人的属性,对智能机器人的尊重就是对人类自身的尊重”的观点[2]。有的学者则不赞同人工智能成为民事法律主体。如许春明教授,他认为目前的人工智能仅仅只是一种高级的算法,即使人工智能的产出不直接受人类控制,但是也不能说明其存在独立的意识,即便是被授予公民身份的“索菲亚”,也同样没有突破自主意识这一瓶颈[3]。除此之外,李爱君教授、孙占利教授也从法律价值、权利能力、责任能力等多个角度论述了人工智能不应被赋予法律主体资格①。

不论是持赞同意见还是持否定意见,学者们都从不同的角度对此问题进行了一番论述。在本文,笔者亦将对人工智能是否应当被认定为民事法律主体进行分析论证,从人工智能的概念入手,通过叙述人工智能的发展阶段及对其分类,探讨强人工智能是否有成为法律主体的可能性,分析当前认为应当赋予人工智能主体地位的立足点及其缺陷,进而尝试运用法理学和民法的相关知识论证当前人工智能不应当被赋予民事法律主体资格。

(一)人工智能的概念

人工智能集合了计算机科学、逻辑学、生物学、心理学和哲学等众多学科,在语音识别、图像处理、自然语言处理、自动定理证明及智能机器人等应用领域取得了显著成果[4]。但是实际上,至今为止,各界对人工智能仍未形成统一的定义。美国麻省理工大学的温斯顿教授认为:“人工智能就是研究如何使计算机去做过去只有人才能做的智能工作[5]”。钟义信教授则指出,人工智能就是指人类所制造的智能,也就是机器的智能[6]。McCarthy认为,“人工智能不仅仅意味着对人类智能的复制,同时也涉及超过人的各种计算性的能力[7]”。上述定义并无优劣之分,仅仅体现了学者们对人工智能不同的关注视角,而笔者认为要对“人工智能”下定义,首先要对其进行拆分,申言之,即何为“人工”,何为“智能”。“人工”指的是依靠人类的脑力、体力创造。“智能”是感知、学习、理解的能力,含括智慧、智力、意识等等。因为意识是人类特有的活动,此处不宜采用“意识”来解释“智能”。由此,笔者认为人工智能是由人类创造的、带有人类智慧和智力的载体。

(二)人工智能的发展历程

“人工智能”这一概念最先是在1956年美国的达特茅斯会议上被提出来,在此之前,奥利弗·塞弗里奇(Oliver Selfridge)和艾伦·纽厄尔(Allen Newell)已经在“学习机器讨论会”的会议上分别提出了对于计算机模式识别与下棋的研究,这被认为是人工智能的雏形[8]。达特茅斯会议是符号主义学派兴起的标志,同时,此次会议不仅确定了人工智能未来的发展方向,还确定了人工智能最初的发展途径以及发展目标[9]。这一时期的人工智能还未大范围使用,并且因为计算量巨大且复杂,人们并不看好人工智能的发展前景。由此,人工智能进入到了第一次低谷。到了20世纪70年代,以仿生学为基础的研究学派逐渐火热,神经网络由于BP算法的广泛应用获得了高速发展[4]。但是由于技术发展的问题,在当时无法实现深度学习,还未能达到进一步发展的要求。随后,1997年“深蓝”的成功面世,又激起了人们对人工智能发展的展望。互联网以及分布式计算的技术跨越了人工智能的发展障碍,使得深度学习和增强学习成为了可能[10]。人工智能开始被大范围应用,包括图像、语音、文字和数据挖掘等领域,如拍照翻译功能。现如今,GPU的不断深入发展,使得人工智能事业更上了一层楼。

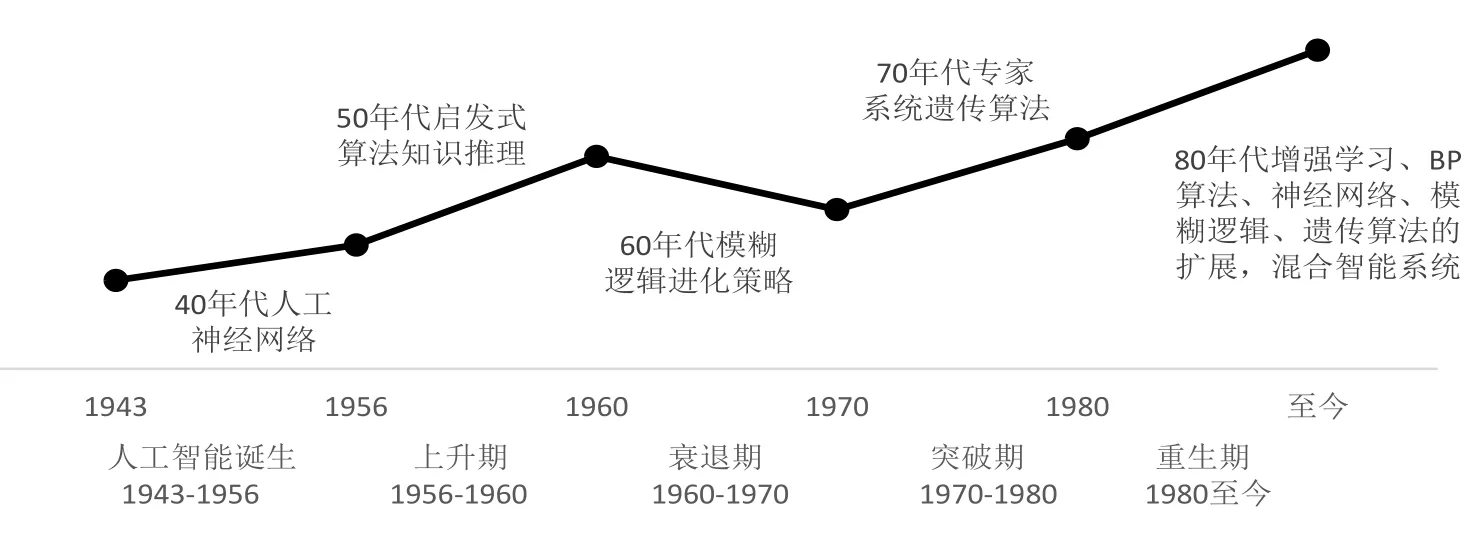

由上可见,人工智能自出现以来,大致经历了三起两落,如图1所示[11],在人工智能发展的过程中,虽然碰到了一定的挫折与打击,但是总的而言,人工智能还是呈现出一种螺旋式上升的状态,目前,人工智能处于重生期之中,同时这也是一个蓬勃发展的时期,截至2018年,中国人工智能的市场规模已达238.2亿元[12]。

图1 人工智能的发展历程

(三)人工智能的分类

为了对人工智能能否被赋予民事主体资格这一问题进行更好的讨论,当前人工智能的发展按其“智力水平”可以划分为三个级别,分别是:弱人工智能、强人工智能和超人工智能。

1.弱人工智能。弱人工智能是指最早出现的,功能较为单一的,并且专门用于某一特定领域的人工智能,例如超级计算机“深蓝”、机器人“小冰”、在线广告服务、网络人工服务等等。弱人工智能不具有独立思考的能力,没能开启属于自己的“思维”模式,属于人工智能体系里较为低级的发明,只能拥有其预先确定的观察数据的能力,不能提供超出其预定操作范围的查询。

2.强人工智能。强人工智能是指基本可以像人类一样独立地依靠自身完成一切需要智力完成的任务和能够依靠自己的能力来解决各种不同领域的复杂问题的人工智能。强人工智能属于人工智能体系里的高级发明,能够独立地进行思考,申言之,强人工智能是一个通过适当编程仿真大脑进行智能工作从而达到与人类能力等同的人工智能。

3.超人工智能。超人工智能的智力和能力已经远超所有人类,超人工智能可以独立完成原本只能依靠人类自身完成的所有工作,甚至可以完成人类自身能力所不能完成的工作,是一种可以取代人类的人工智能。超人工智能在人工智能发展阶段属于顶级,可以超越人类的科学进行自我发展,不受人类控制。超人工智能的出现可能会给人类社会带来毁灭性的灾难,其有可能会为了达成自己的某些目的而消灭人类,给人类社会带来诸多威胁。

二、人工智能被赋予民事主体资格的可能性

由于弱人工智能仅能起到辅助作用,只能作为工具而存在,没有作为法律主体的可能性,而超人工智能的出现仍然遥遥无期甚至是否会出现还是个未知数,目前以及未来相当长一段时间内人工智能的发展技术主要集中在强人工智能,因此本文仅在强人工智能的范围内进行讨论人工智能是否应当被赋予民事主体资格。笔者认为人工智能应当被赋予民事主体资格的理论构建基础点有以下两个理由:第一,民事主体资格范畴具有“类型化”特征;第二,民事主体体系具有开放性特征。

(一)民事主体资格范畴具有“类型化”特征

民事主体资格是指某种实体可以成为民法主体具有的最基本的法定条件,民事主体资格是一个范畴,而范畴作为一个概念系统,包含着各种各样的要素,这些构成要素的关系结构体现着范畴的本质,申言之,民事主体资格的本质在于其各个构成要素之间的关联。民事主体资格范畴的构成要素包含:“某种实体”“可以成为”“民事主体”等[13]。卡尔·拉伦茨曾说过:“只有当列举——描绘其特征的——全部要素得以清晰界定者,始能称为严格意义的‘概念’[14]”。申言之,即该范畴所包含的要素可以被穷尽列举之时就可以得出一个最终的概念。接下来,笔者将会对民事主体资格范畴的三大构成要素进行分析。首先,“某种实体”中的“实体”,它是一个类型化的概念,因为实体是无法被穷尽列举的,自然人、法人、其他组织无疑是实体,动物、植物、建筑物等等也是属于实体的范畴。其次,“可以成为”的情景亦无法穷尽列举,比如自然人从出生即享有民事权利能力可以成为民事主体;具有完全民事权利能力的自然人可以通过自己的意思表示成为民事权利义务的主体;无民事权利能力的自然人或者限制民事权利能力的自然人可以通过法定代理人的意思表示而成为民事权利义务的主体;具有完全民事权利能力的自然人可以根据自己的过错(可以分类)或者法律的规定(多种规定)成为民事责任的主体等。由此可得,“可以成为”包含以上所述的“直接成为”、“通过法定代理人的意思表示成为”“根据自己的过错成为”“根据法律的规定成为”等等,申言之,“可以成为”亦是一个类型化的要素。最后,“民事主体”,即民事法律关系的主体,而民事法律关系的内容包含权利义务(责任),也就是说民事主体可以分为权利主体、义务(责任)主体。梁慧星先生认为“权利是得享受特定利益之法律上之力”[15],权利即是得到法律承认并受其保护的利益。权利的内容与种类并非一成不变,同样无法被穷尽列举,权利是一种类型而不是一个概念,自然而然权利主体也不可能被作为一个概念看待而应该是一种类型。义务(责任)同理可证。综上,民事主体资格的范畴基于“某种实体”、“可以成为”、“民事主体”这三大构成要素的类型化特征而具有了类型化的特征。

(二)民事主体体系具有开放性的特征

从历史上考察,民事主体体系是一个在变化着的、具有开放性的体系。在罗马法时期,只有具备相应的身份才能作为法律主体,从一些罗马法学家的作品中,我们可以推断出“身份”指的是权力、权利和义务三者融合的结果,与其本身所属的单位有着莫大的关系[16],根据权力、权利和义务的结合,大致可以分为以下五种身份:奴隶、自由人、非市民、市民、家父。在当时,奴隶是交易的对象,不是民事上的法律主体,不享有法律上的权利,也即是作为客体而存在。当时的主体资格与身份挂钩,不同的身份是成为不同的权利义务主体的资格要件。随着基督教的传播和近代启蒙运动的兴起,受个人主义思想的影响,民事主体制度也做出了相应的调整。1804年《法国民法典》第8条规定:“所有法国人均享有民事权利。”此条款表明当时的法国已经承认所有的法国人都享有民事权利,标志着民事主体由身份走向契约的开始,但是此时的权利主体仅限于法国人,外国人并不一定能够享有民事权利。“人人生而平等”的思想最早实现于1811年的《奥地利普通民法典》第16条②。由该条文,可以得出全部自然人都已经得到法律了认可,所有的自然人都可以成为民事主体。

随着时代的发展,立法者基于政治、经济和社会的原因,赋予了“法人”等组织体民事主体资格,从此非自然人便进入到了民事主体的体系范围之内。“法人”等组织体作为民事主体,可以自主地参与到各种民事法律关系当中,同时能够独立地享有权利与承担义务。由此,不难看出,民事主体制度的发展经历了非所有自然人都是法律上的“人”到不仅包括所有自然人还包括其他组织体的存在,简而言之,即民事主体制度的发展经历了“人可非人”到“非人可人”的过程[17],在这一过程,我们可以看出,民事主体的类型是由自然人——法人的扩展,同时也可以看出民事主体的范围由部分本国自然人——本国所有自然人——外国人逐渐延伸,从而可以得出民事主体体系并不是一个封闭的体系,而是一个变化着的、开放的体系。

赞同者试图从民事主体资格范畴具有“类型化”特征以及民事主体体系具有开放性来说明人工智能成为民事主体是具有可能性的,并且为了一劳永逸地解决人工智能生成物的权属、人工智能侵权责任分担、以及法律职业替代的问题,进而得出人工智能应当被赋予民事主体资格的结论。但若仅仅如此,动物也具有成为民事主体的可能性,再加诸各种表面理由,就会导致任何实体都可能且应当成为民事主体,到那时,民事主体的范围将会被无限扩大。同时,笔者认为现如今的法律仅将自然人和部分自然人的组织体作为民事主体,不应只是基于如此简单的理由,如果将“类型化”与开放性作为民事主体资格学理建筑的立足点,恐怕会根基不稳。

三、人工智能被赋予民事主体资格的不妥之处

在对人工智能被赋予民事主体资格有何不妥这一问题进行讨论之前,笔者认为需要对人工智能的法律性质进行界定。在我国,对于人工智能是否能够成为民事主体这一看法,目前是比较保守的。2017年国务院发布了《国务院关于印发新一代人工智能发展规划的通知》,国家层面表现出来的态度是鼓励和支持创新人工智能,利用人工智能的前沿技术来促进社会的发展,并且是将人工智能的发展放入了国家战略层面当中。2018年我国发布了《人工智能标准化白皮书2018》,里面更是直接地将人工智能定义为一种系统③,从这里我们可以看出在我国国家层面上,人工智能是作为客体而存在。

在学界里,学者们对于人工智能的法律性质暂无统一定论,主要可以分为两大类,分别是主体说和客体说。客体说里的工具说认为人工智能是人类为生产生活应用而创设的技术,人工智能本质上不带有目的性、不能自发地去积累知识,更是缺乏人类独有的心性和灵性,究其根本,人工智能只能作为为人类服务的工具而存在。主体说的分支较多,可以划分为代理说、电子人格说、有限人格说等等。代理说将人工智能作为所有人的“代理人”,作为被代理人的所有人要承受代理行为所带来的后果。电子人格说提议创造一个新的民事主体——“电子人”,并且主张精密的自主机器人可以作为“电子人”,从而成为民事主体之一。有限人格说认为由于人工智能已经具有独立的意思表示能力,可以成为民事主体,但又因为人工智能承担的法律责任的能力是有限的,因此只能赋予其有限的人格。在主体说里的分支学说中,无论是代理说、电子人格说还是有限人格说的立足点都是以人工智能已经有独立表达自身意思的能力为基础。主体说的分支都是认为人工智能能够独立进行意思表示,就应该成为民事主体,享有相应的权利,承担相应的义务。笔者认为这是一个悖论,这是因为人工智能是基于算法而存在的,但无论算法多么精准,都无法逃避算法是人为操作与植入的,也即人工智能生来就是带有制造者的烙印,无论其如何独立也无法独立于设计者或者算法提供者,基于这一点,主体说就不攻自破了。因此,笔者较为认可客体说中“工具说”的观点,这是因为人工智能在发明之初就已经明确其目的是更好地服务于人类,为人类的生活带来便利,也即人工智能作为一种服务于人类、促进人类发展的工具才最能体现其存在的意义。并且,我国乃至世界各个国家建立法律制度。其本质都是为了维护作为一个独立法律主体的人的权利和其要承担的义务。在“人类中心主义”之下构建的法律制度中,只有人类才能成为法律主体,一切非人类之有机物和无机物,均为人类权利之客体,人工智能也不应例外,即使人工智能超越“奇点”达到超人工智能的要求[18]。上述种种皆是从表面得出人工智能不应被赋予民事主体资格之论,而笔者认为,欠缺作为民事主体的基本特征和法理基础是人工智能被赋予民事主体资格最大的阻碍。

(一)“自由意志”是建构民事主体的基础

近现代的民事主体主要包括自然人以及法人等组织体,其建构深受康德与黑格尔的“自由意志”理论的影响。民事主体是由法律所认可的,不是由法律所创造的。那自然人和法人等组织体是如何被法律认可从而成为法律主体的呢?根据康德和黑格尔的“自由意志”理论体系,“自由意志”是自然人得到法律认可的基础,只有具备了“自由意志”的自然人才能成为法律上的主体,不具备“自由意志”的自然人不能独立地行使权利、承担义务。因为只有在“自由意志”的支配下,自然人才能在理性法则的约束下谋求自己的利益,从而为自己的行为负责。进一步说,“自由意志”是选择能力的基础,而选择能力是作为主体而具有的最重要的特征。无论是何种目标、利益和欲望,都是以选择能力为前提的,选择能力塑造了主体。申言之,自然人之所以能够成为民事主体,是因为自然人拥有“自由意志”并可以依据自己的自由意志做出选择。而法人等组织体之所以能够成为民事主体,是因为法人等组织体的主体身份究其根本还是落实到自然人身上。组织体实际上是自然人的集合,是一群人的欲望的结合体,它是通过自然人的有机结合组成决策机关来形成统一的意志,这与自然人个人通过说话表达自身的意思在本质上是一样的。德国社会学家斐迪南·滕尼斯认为:“它(集会)之所以能作为一个选择意志的统一的主体采取行动,仅仅是因为它本身包含着作为自然人的人,本身确定和假定他们多数一致的肯定或否定作为选择意志——不是这些意见一致者的、也不是他们所有人的选择意志,因为这二者总是只能产生很多的选择意志,而是在这种想象之外和之上的、统一的、人格的本质的(集会的)选择意志。当然,通过这种行动,集会就置于与自然人同等地位,平起平坐了[19]”。说到这里,人们不禁怀疑既然都是自然人的行为,自然人已是法律主体了,为何还要让法人等组织体成为民事主体,这是否是多此一举。这时候,不得不说在人类经济交易与社会发展的过程中,一群人办事总比一个人办事要容易一些,为了降低成本、扩大收益,“法人”这一思想产物便应运而生了。由此可得,法人等组织体能够得到法律的认可而成为民事主体,其根本原因是因为自然人是组织体的组成要素,自然人的“自由意志”延伸至组织体的决策与行动中,组织体有自我选择的能力,而且组织体的权利与义务最终也是落实到自然人之上,所以法人等组织体可以成为民事主体。而某些缺乏“自由意志”的自然人,诸如智力发展存在障碍的人士,则是源于法律的恻隐之心,且在行为能力方面,法律也对其做出了相关规定,以保护自然人更好地发展。

综上,自然人与法人等组织体在被法律认可为民事主体时具有一致性,即自然人与法人等组织体都具有“自由意志”。虽然在实证法上,“自由意志”不足以成为建构民事主体的唯一理由,但起码这是基础要件,在实证法上,必须结合人类经济交易的发展以及社会交往的需要等现实情况,才能够成为得到法律认可的充分条件。

人工智能就如同上述所说,生来即有“成见”,无法摆脱人类设计的算法,也即无法脱离人类的意志而存在,没有真正的独立意思表示能力。人工智能缺乏自由的意志,而缺乏自由意志就没有选择的能力,因此,人工智能是一种不自由的存在,其并不具备让法律认可其为法律主体的基础要件。还有声称人工智能具有“理性”的人们,似乎是忘记了理性是建立在感性的基础之上的,鉴于人类心性的复杂程度,目前仍然没人能够说清人类心性与感性是如何产生的,没有感性的人工智能是无法真正做到“理性”的。由此,笔者认为没有自由、没有理性的人工智能,只能是作为物而存在,只能作为工具来成就人类,只能作为自由意志选择的对象,而不是作为主体而存在。

(二)人工智能被赋予民事主体资格会打破平等原则

民主、自由、平等、博爱是构成美好生活的基本要素,而人工智能在不自由的情况之下,赋予其民事主体资格是否会打破平等原则呢?罗尔斯与康德把人的平等归于人的道德性。康德认为,道德性是人之平等的根本原因。在康德看来,每个人都是有道德意识的,也即每个人都能意识到自己的行为是否道德,但却并不是每个人都会遵守道德法则。无独有偶,罗尔斯在继承康德伦理哲学的同时,提出了道德人格能力是人类实现平等的基础,包括善观念能力和正义感能力,同时也强调了这是一种能力而不是实现。而人工智能作为一种生来并不具备道德性的存在,后天也没有办法拥有道德性这一能力,假如赋予了人工智能法律主体地位,即人工智能享有了与人类同等的地位,那么在法律上、道德上都应该被人类平等地对待。但人类创造人工智能的目的是更好地为人类服务,人工智能本质上与人类地位就有差别以及不平等之分,申言之,人工智能无法与人类处于平等的法律地位。再有,世间万物,要么有一种价格,要么有一种尊严,能用价格衡量的必定是可以取代的,而尊严是无法用价格衡量的,没有任何物能与尊严产生等价关系。世间只有人才具有尊严,因为只有人才能遵守道德法则,具有道德性。而人工智能是可以用价格去衡量的,可以被买卖,可以被等价物所替代,由此可以看出,人工智能是没有尊严的,没有尊严的事物是不会遵守道德法则的,申言之,不具有道德性的人工智能无法与人类产生平等的关系。

如果赋予人工智能法律主体资格,那法律上所强调的“法律面前人人平等”之原则岂不是变成了空谈?面对这个问题,有学者提出了可以赋予人工智能“机器伦理”的想法。所谓的“机器伦理”即是“在人工智能中嵌入符合伦理原则的相关程序,使其能够为使用者提供伦理帮助或者使人工智能自身面对一些伦理问题时做出相应的伦理决策,这是一种内在于人工智能的伦理”。“机器伦理”主张将道德行为进行数字化,从而使得道德行为可以作为代码输入到人工智能的芯片之中,进而使得人工智能具有与人类一样的道德性,以达到实现人工智能与人类平等相处的目标。在笔者看来,“机器伦理”就像理想国、乌托邦一样的存在。首先,“机器伦理”是建立在道德可计算的基础之上的,机器伦理主张人类心理可计算,依据特殊的规则对其进行计算[20],可“道德”本就是一个模糊的概念,如何能对一个模糊的概念进行精准化计算?即使真的采用了道德行为数字化,人工智能又能够理解道德准则背后的人文意义吗?其次,“机器伦理”把人工智能作为道德主体,而道德主体不仅需要知道做什么事情是对的,做什么事情是错的,还要有承担道德义务的能力,人工智能是没有心智的存在,任何事情对其都没有利害对错之分,只有是否符合程序规定之分,人工智能无法理解道德谴责,也无法承担道德上的义务。欠缺自由意志人工智能不具有成为道德主体的能力。最后,“机器伦理”赋予了人工智能道德性,与人类达到平衡的状态,也即人工智能与人类是平等,那么人工智能对于人类做出的命令是可以拒绝的,那么一个拒绝人类合理要求的人工智能有什么存在意义呢?

综上,笔者认为人工智能是不应当拥有道德人格能力或者道德性的,人工智能缺乏道德性,则无法在法律上与其他法律主体达到平等的状态,若是强行把人工智能认定为民事主体,则会打破私法领域里的平等原则,从而使得美好生活的愿望落空。

(三)人工智能被赋予民事主体资格的后果:法律不再是法律

法律之所以会产生,是因为人是自由的,而自由人在享有自身权利的同时不可避免地侵犯到他人的权利。凡权利必有边界,每个人让渡自己部分权利,形成社会契约,产生社会秩序,处于共生状态的人们不得不遵守大家之间彼此的约定。但是在社会分工之后,人们之间的共生状态基本不存在了,由于利益的不一致,大家都想以最少的付出换取最多的成果,自发秩序已经无法产生作用了,这个时候就需要一个大家公认的秩序(法秩序)进行社会交往,比如民法中的平等有偿、诚实守信建立起来的交易秩序。作为欲望主体的人类是法律规范调整的对象,而法人等组织体更是自然人欲望的延伸体现,欲望越强烈,便越需要法律的约束。法律上的权利是人追求自身欲望的正当化,权利是欲望在法律上的代名词,自由欲望的主体也就是有着各种各样权利诉求的主体[21]。人类具有心性,是感性、理性、欲望的结合体,是世界上最神秘的存在,人类研究本身的构造本来就存在难度,而心性更是一种无法被科学解释的存在,是复杂的,难以肢解的。人工智能是基于人类的认识不断深入而发展起来的,对于人类未知的领域,人工智能自然而然也无法发动自身去探索。因此,人工智能是缺乏心性的,不会产生欲望,更不会产生任何的权利诉求。人工智能因为自身缺少对欲望的追求,因而也无法成为利益的享有者、并进一步的成为法律主体[22]。如果人工智能没有享有其作为法律主体应该享有的权利,却要求人工智能承担具有主体地位的法律义务,这样只会造成权利义务失衡的局面。

法律创造出来的法秩序依靠国家暴力机器对人们进行威慑,具有双重功能,即惩罚和保护。惩罚意味着不利的法律后果,判断法律行为结果主要有两个标准:一是行为给社会造成的影响;二是该结果具有法律意义[23]。人工智能作为一种没有欲望的存在,任何事物于其都没有利害之分,所以对于人工智能来说,对其进行法律上的惩罚毫无必要,因为监狱、看守所等暴力手段对其根本不起震慑作用,更不用提赔偿损失等民事责任了,也谈不上人工智能会认识该行为对社会造成的影响。退一步讲,人工智能如果发展到一定阶段而拥有了“欲望”,在面对法律的苛责时,人工智能又是如何承担现行法律专门为人类打造的惩罚措施的呢?此时,法律的惩罚功能则变得形同虚设了。如果赋予人工智能有限的人格使其成为法律主体,在其违反法律义务之时,仅是让其承担有限的责任诸如赔偿损失之类,其他法律责任则由人工智能的拥有者或者使用者所承担,即实际上真正承担法律不利后果的并不是人工智能本身。因为赔偿损失并不会对人工智能本身造成任何实质性的影响,钱财对人工智能而言只是一堆符号与废纸,钱财的实际拥有者是其背后的使用者或者所有者,如此一来,人工智能被认定为民事主体这一举措并没有任何意义。

惩罚不是法律的最终目的,教育才是法律的终极目标。人类对法律是可知可识可理解的,而人工智能只能做到可知可识而不能做到可理解,不能理解法律,也就必然不会对法律有着尊重的态度,更不必谈敬畏。缺乏对法律的尊重与敬畏,又如何能要求人工智能去遵守法律、维护法律秩序,也即法律存在的价值会被大打折扣。

综上,创制法律是为了规范人类的行为,法律是根据人类的特有属性而创制的,它只能在人类中适用,强行在人工智能当中运用,只会造成“水土不服”。笔者认为现行的法律并没有赋予人工智能以主体地位的空间,否则法律就不再是法律了,而是一堆散落在墙角无用的文件。在法律不再起作用的时候,也即意味着法律的价值已然穷尽,整个人类世界的秩序也终将会被打破。

四、结语

结合以上所述的几点理由之外,笔者认为发明人工智能并不是为了让人工智能与人类等同或者说是取代人类,发明人工智能最初以及最后的目的应当且只能是为了解放人类的双手,与人类智能进行互补,让人类过上美好的生活。因此,笔者认为作为“好帮手”的人工智能是不应当被认定为民事主体的,至少现阶段是不适宜的。正如吴汉东教授所认为:“凡是可以描述的、重要的、有固定规则和标准答案的工作岗位,都有被智能机器人取代的可能[24]”。同时,根据卡内基梅隆大学(Carnegie Mellon University)的机器人科学家汉斯莫拉维茨(Hans Moravec)做出了大胆而有根据的预测:“2040年后,机器人将成为人类思想的继承者,甚至到2050年超过人类[25]”,从而表明了人工智能在将来拥有广阔的发展空间,待未来人工智能拥有了与人类同样的心性之后,并不排除人工智能能够拥有法律上的主体地位,但就现阶段而言,当前在立法上赋予人工智能机以法律主体地位的立法条件并不成熟。其次,人工智能发展迅速,其未来是我们无法预料的,即使法律曾经有过超前立法,但是从总体上来看,法律明显是滞后的,不可能通过法律来规制将来发生的事情,从这一点上看,也不应当赋予人工智能以法律主体地位。最后,笔者还想强调一点,法律作为人类主体特有的调整人与人之间关系的社会规范,它可以说是保护人类最后的防线,如果人类为了一时的方便,而将人工智能作为法律主体纳入保护的范围,其不仅将面临着国内法的重新规划,还有全球国际法的重构,我们无法预料将来人工智能会发展到哪个阶段,如果现阶段在法律上赋予人工智能主体地位,没有在一定程度上对人工智能这一类新生事物进行法律限制,那么人类将会失去保护自身至高无上地位的法律武器。

注释:

①参见李爱君.人工智能法律行为论[J].政法论坛,2019,37(3):176-183.李爱君教授从法律价值层面和法的结构层面对人工智能是研发者、制造者和使用者的法律行为,从而可以看出李爱军教授是不赞同人工智能成为民事法律主体的。参见孙占利.智能机器人法律人格问题论析[J].东方法学,2018(3):10-17.孙占利教授认为对于智能机器人的法律人人格问题,仍需要遵循“最小化原则”和“程序化原则”,尽力将已经存在的法律适用到人工智能时代,尽量在最小程度上对人工智能制订新的法律,尽可能通过程序性的技术改造来适用已有的法律,以清楚法律障碍或者明确关系,进而提出“工具论”仍然是当前解释和适用法律的方式。

②1811年的《奥地利普通民法典》第16条:“每个生物学意义上的人都享有与生俱来因为被看作法律上的人的权利。奴隶制、奴役以及以奴隶制和奴役为依据的权力行使,禁止之。”

③利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。