增强现实环境下的CPS虚拟装配系统研究与实现

2019-05-24韩峰,张衡,朱镭,刘虎

韩 峰, 张 衡, 朱 镭, 刘 虎

(1.西安工业大学 光电学院,西安 710021;2.西安应用光学研究所,西安 710065)

引言

在产品设计过程中,经常用虚拟装配技术对设计结果进行可装配/拆卸性验证,虚拟装配是在虚拟环境下对计算机数据模型进行装配关系分析的一项计算机辅助设计技术[1]。与传统的装配设计方式相比,虚拟装配在获取最佳装配工艺、减少设计成本、缩短设计开发周期等领域有着不可比拟的优势[2]。

随着“工业4.0”概念的提出,人类将进入以智能制造为主导的第4次工业革命。“工业4.0”的核心理念是信息系统与物理系统的深度融合[3]。“工业4.0”的理念在未来将应用于各个研究方向,开发和设计出一系列应用系统[4]。CPS系统被定义为一个集感知系统、计算系统、通讯系统和控制系统为一体的复杂系统,强调信息系统和物理系统的深度融合,从而改变人与物理世界的交互方式[5-6]。在未来“工业4.0”的概念下,装配仿真过程将向着智能化、多元化的方向发展,虚拟装配逐渐表现出了一些限制:1) 使用者在产品装配过程中,沉浸感不强,缺乏真实感;2) 针对装配单元的交互操作均是在虚拟的环境下通过鼠标键盘进行,缺乏对现实世界的感知与交互能力;3) 无法实时显示装配过程,仅是通过设置装配约束,展示装配结果,无法判断装配的可操作性和合理性。

增强现实技术是将计算机产生的虚拟物体或信息与真实环境进行合并,并对景象加以增强和扩充的技术[7]。将增强现实技术引入到CPS系统中,是实现CPS信息系统与物理系统深度融合的重要方式。哥伦比亚大学提出了一种ARMAR(augmented reality for maintenance and repair)系统[8-11],将三维模型与发动机物理单元融合,指引工人完成发动机的修复工作;沈克等人提出了一种增强现实环境下的物体识别与虚拟交互方法[12],将虚拟信息与物体融合显示;高康等人提出了一种增强现实环境下的虚拟装配平台[2],通过零件的表面的顶点和法向量建立虚拟零件与实物的联系,实现虚拟装配操作。

本文所开发的基于增强现实技术的CPS虚拟装配系统通过计算机视觉技术建立虚拟模型与实物装配单元的配准关系,将虚拟模型图像与相机采集的装配单元图像进行融合,从而实现虚拟零件装配到真实零件的过程,图像融合的结果实时立体输出在视频眼镜中并立体显示,增加了融合结果的真实性,达到CPS系统信息世界与物理世界深度融合的目的。

1 计算机视觉原理

基于增强现实技术的CPS虚拟装配平台建立在物理环境基础上,通过虚拟模型图像和物理装配单元图像融合的手段实现虚拟装配仿真。在装配过程中,虚拟三维模型图像与物理装配单元图像融合的关键是建立正确的配准关系。常用的方法为将虚拟三维模型的空间坐标系与实物装配单元的空间坐标系进行统一。追踪定位技术识别物理装配单元和相机在物理空间中的位置坐标,反馈给虚拟空间,在虚拟空间建立同样的相对位置关系从而实现两种坐标系的统一。

计算机视觉中的双目视觉图像定位技术是近些年来发展和完善起来的一种新型定位方式,其原理是利用视觉传感器得到的图像作为信息,通过三维重建技术把被测对象表面点二维投影坐标转换成三维世界坐标,从而对目标场景进行精确地追踪和定位[13]。

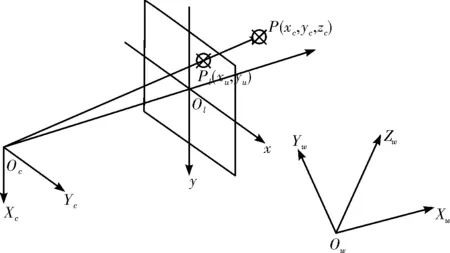

在计算机视觉系统中,相机的成像原理可以近似为小孔成像原理,成像模型如图 1所示。

图1 相机成像模型Fig.1 Camera imaging model

物理空间世界坐标系为Ow-XwYwZw,摄像机坐标系为Oc-XcYcZc,空间点P(xw,yw,zw)与图像点Pl(u,v)之间存在(1)式的坐标变化关系。

(1)

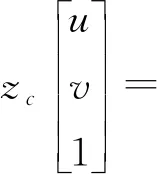

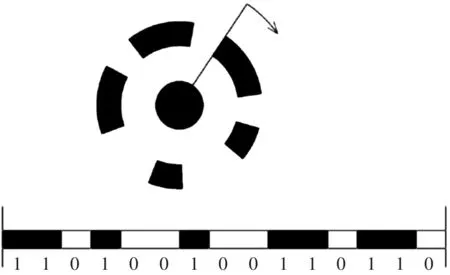

识别物理空间特征标记点主要利用双目视觉技术,其原理如图2所示,图中,P为空间中任意一点,p1和p2分别为点P在相机C1和相机C2上的成像点,O1和O2是相机C1和C2的光心。假设相机C1和C2已经标定,设它们的投影矩阵分别为Ml和MR,根据相机的投影变化原理有(2)式:

(2)

其中(ul,vl,1)和(ur,vr,1)分别表示点P在左右相机的投影点p1和p2点的坐标,[xpypzp1]表示空间点P的物理坐标。利用最小二乘法对上述两个方程进行求解,对空间点P进行估计。

图2 双目视觉技术Fig.2 Binocular vision technology

多位学者基于计算机视觉原理开展了相关研究,并验证了原理的可靠性和准确度。比如支健辉研究了外界因素对算法原理准确性的影响[14];王婧等人将计算机视觉原理应用于动态位移测量[15];赵珊等人基于计算机视觉原理提出了在振动环境中动态测量结构件位移变形的方法[16]。

2 虚拟装配平台的搭建

2.1 物理场景构建

基于增强现实技术的CPS虚拟装配系统的物理场景构建主要包括建立物理空间坐标系和设计视频眼镜结构两个方面。建立物理空间坐标系,所有的物理设备和装配单元的位置信息都将统一在该坐标系下,是实现图像配准融合的基础。视频眼镜结构是根据虚拟装配系统的要求,设计了一种集图像采集与立体显示为一体的装置。

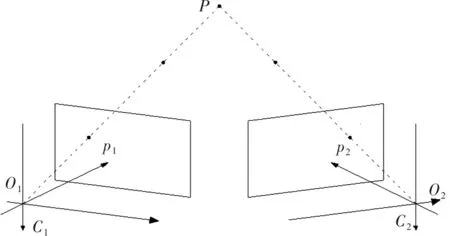

在本系统的物理场景中,空间坐标系是依据场景中放置的特征标记点建立的。特征标记点如图 3所示,为一种同心圆环结构,其外部同心圆环区域平均分成15份,采用二进制编码,黑色为“1”,白色为“0”,便可得到15位的二进制数。外环黑白相间的不同的排列组合可以组成不同编码的特征标记点。

图3 特征标记点Fig.3 Feature markers

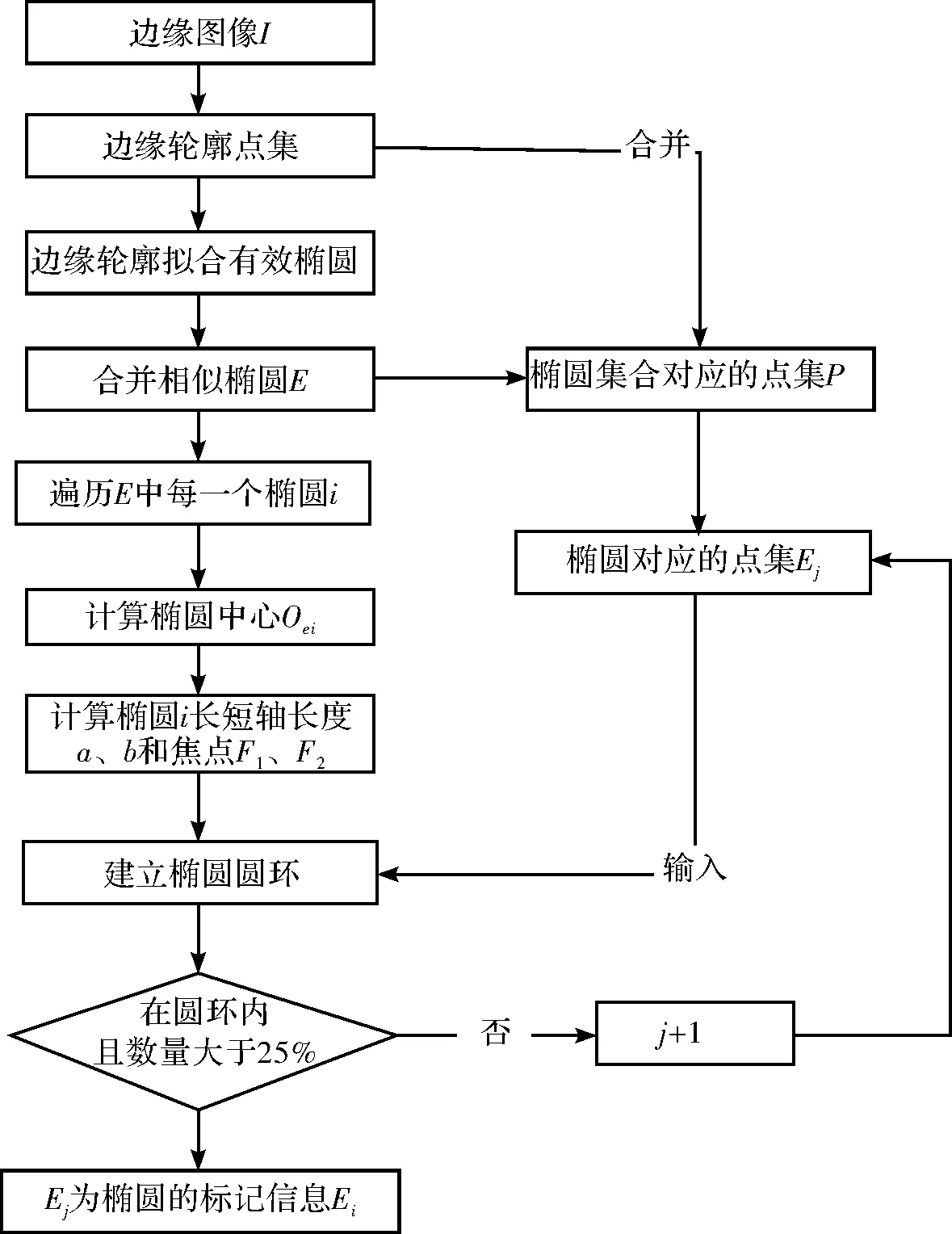

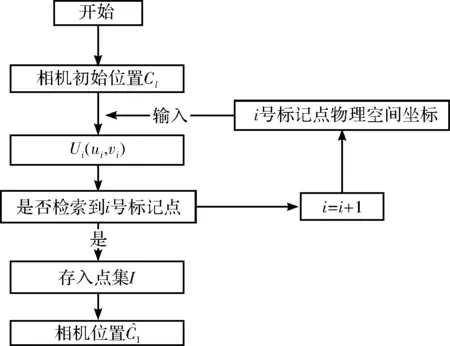

特征数码点的识别利用图像处理技术,对于采集到的图像进行灰度处理和边缘提取,正对图像中提取的点集信息进行数据拟合处理,提取特征标记点坐标,具体算法如图4所述。

图4 标记信息确定流程图Fig.4 Flow chart for marking information determination

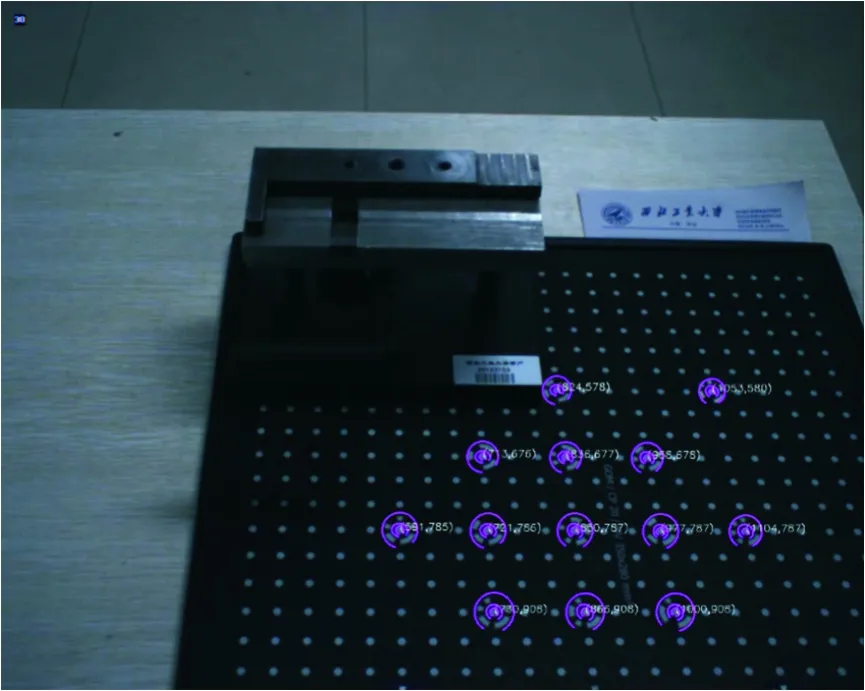

经过上述算法过程可以精确测得图像中特征标记点的图像坐标,试验验证结果如图5所示。从图中可得,上述算法识别的特征标记点结果可靠。

图5 特征数码点识别结果Fig.5 Results of feature digit recognition

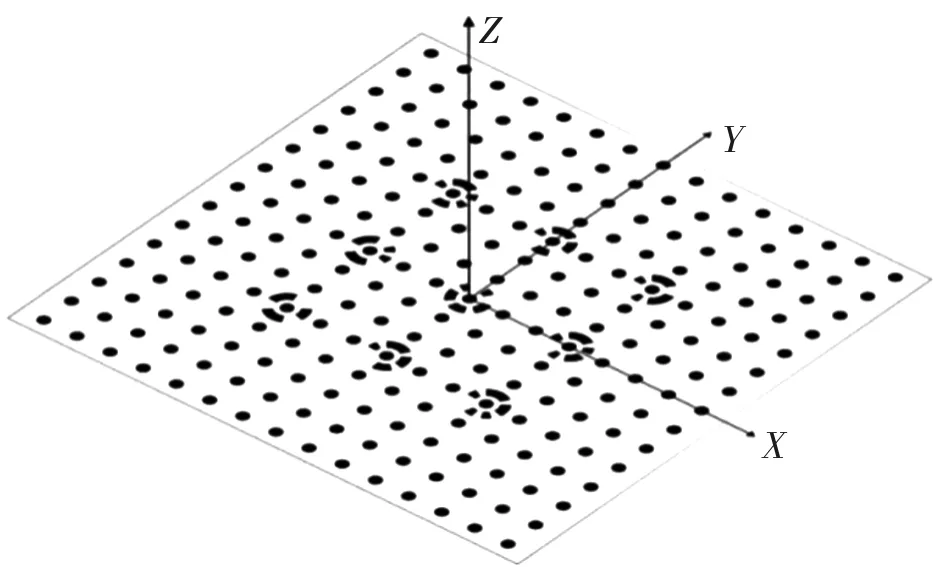

图6 空间坐标系Fig.6 Spatial coordinate system

在物理场景中,利用该特征数码点建立物理空间坐标系如图6所示。所有的特征标记点在同一平面内线性排列,中心标记点为物理坐标系的原点,其余特征标记点构成坐标系的X轴和Y轴,垂直于该平面为Z轴。在该坐标系中,不同特征标记点的物理坐标均可实测获得。

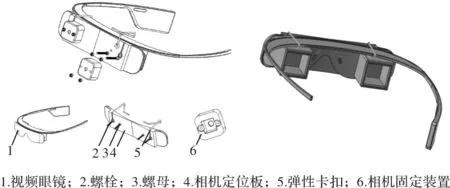

在虚拟装配系统中,使用者佩戴视频眼镜进行装配操作,视频眼镜结构相当于人的眼睛,在满足系统功能的要求上还需符合人体工学的设计,具体如图7所示。

图7 视频眼镜结构Fig.7 Structure of video glasses

视频眼镜结构由图像采集部分和立体显示两部分组成。图像采集部分,在视频眼镜前端按照人类瞳孔位置信息安装布局有两个微型摄像头,采集装配场景的双目图像,实现立体图像采集的功能;立体显示部分,在视频眼镜结构的内部根据立体成像原理安装有两个微型投影显示器,左显示器和右显示器。左右显示器通过中间挡板被物理隔离,以至于左显示器的图像传输至人的左眼,右显示器的图像传输至人的右眼,从而实现立体成像原理,达到系统立体显示的目的。

2.2 虚拟装配交互界面

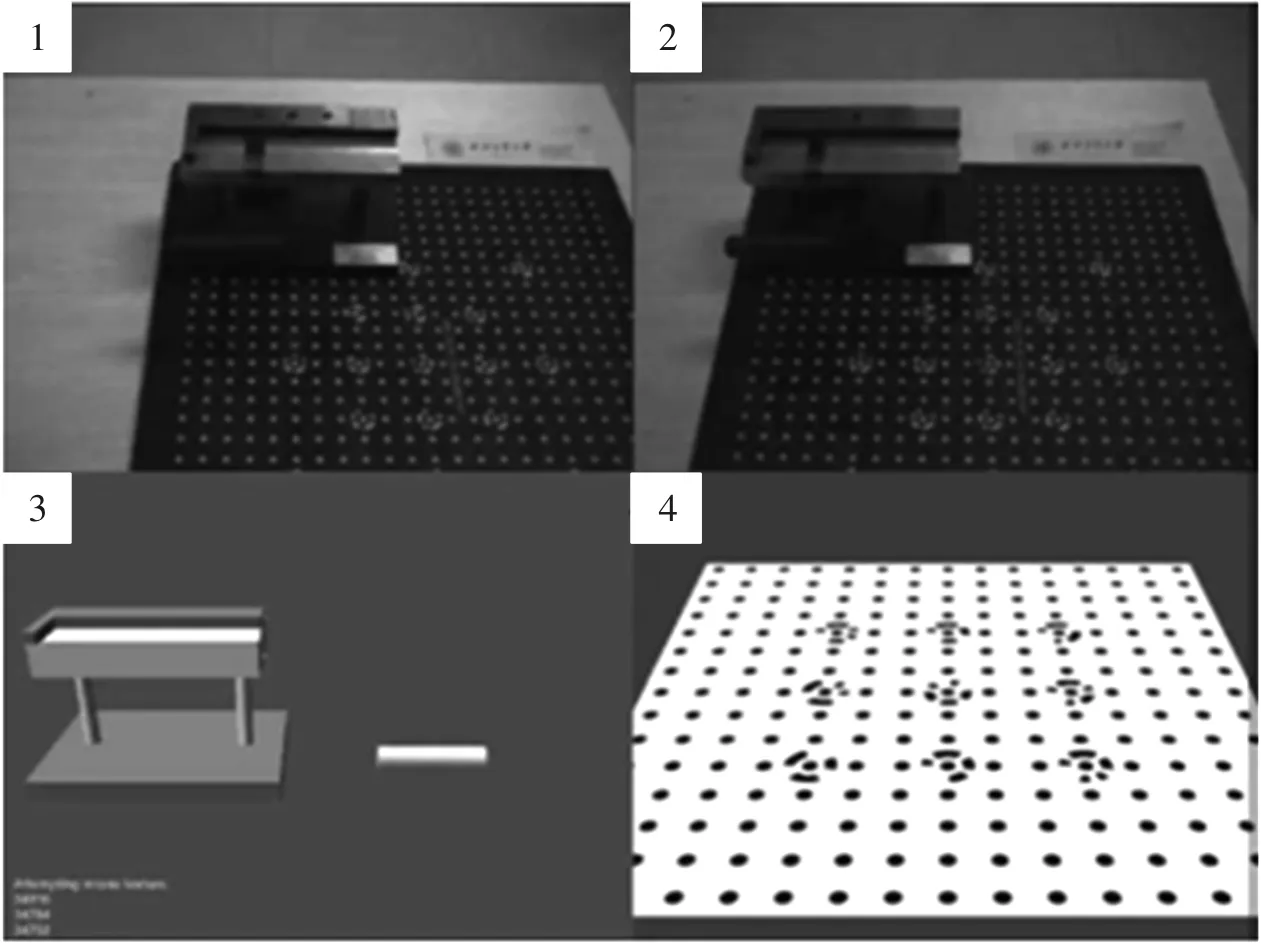

本文搭建的虚拟装配界面是利用Unity3D游戏引擎软件进行设计与开发,利用VS2010编写追踪定位算法,并以动态链接库的方式嵌入在Unity3D中,后台运行。搭建的虚拟装配交互界面如图8所示,上方1号和2号视图为视频眼镜装配结果的显示窗口,3号视图为虚拟装配模型显示视图,4号视图为虚拟空间场景视图。程序开始运行前,快速定位算法会建立正确的配准关系。操作者在3号窗口中首先选择物理装配单元的三维模型,将其放置在虚拟场景中,通过平移旋转等交互操作,使其在模型空间的位置与物理空间位置一致;其次,选择虚拟物体的三维模型,在4号窗口中对三维模型进行可视化装配操作完成装配,装配过程实时输出至1、2窗口立体显示。

图8 虚拟装配交互界面Fig.8 Virtual assembly interaction interface

3 眼镜结构快速定位算法

实现增强现实环境下的虚拟装配系统,关键是完成虚拟物体三维模型投影图像与物理场景观察图像的配准融合。在本文设计的系统中,三维模型投影图像投影视点与物理场景观察视点是否一致是决定两幅图像能否正确融合的基础。根据系统物理场景的构建方式,观察者佩戴视频眼镜进行装配操作。由于眼镜结构的不透明性,观察者视觉上观察到的场景图像是眼镜双目相机采集并传输至眼镜显示端的图像,因此在物理场景中,观察视点的空间位置信息即为视频眼镜结构双目相机的空间位置信息。

为实现图像正确融合,本文设计了一种眼镜结构的快速定位算法,实时定位物理空间中视频眼镜结构相机的位置,反馈至虚拟空间使模型投影视点与相机观察视点一致。传统的定位方法是利用双目相机采集物理空间图像,通过识别物理空间特征标记信息定位双目相机的位置。该方法简单易行,结果准确可靠,但是计算量大,识别特征标记点需要遍历图像中的每一个像素,无法满足系统实时性的要求。本文在双目视觉原理的基础上提出了一种眼镜结构的快速定位算法,通过减小特征点的识别区域提高定位算法的效率,具体如图9所示。

图9 视频眼镜结构定位算法Fig.9 Structure localization algorithm for video glasses

该算法需要在视频眼镜结构上设置多个光源特征标记;在物理空间安装两部过曝光状态的相机采集装配场景图像。由于两部相机处于过曝光状态,因此采集的装配场景的图像中只有光源特征标记,可以快速识别光源特征标记,从而获得视频眼镜结构的初始位置矩阵Cl。

以Cl为视频眼镜结构中相机的初始位置矩阵。视频眼镜结构相机均已标定,内部参数矩阵为Mc,利用相机投影变换原理在视频眼镜采集的图像中计算物理空间特征标记点Xi的图像坐标,如(3)式所示:

(3)

(4)

4 应用场景验证

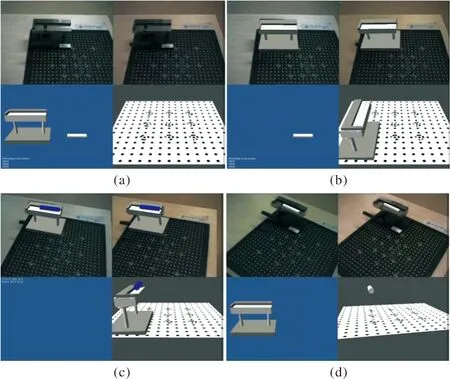

为验证本文提出的增强环境下的CPS装配系统方案的可行性、可靠性及有效性,作者在实验室环境依据上文搭建的软硬件平台进行了验证实验。计算机采用CPU 3.30 GHz,内存为4.0 GB;相机采用Balser-1300GC、130万像素级别的彩色工业相机和M5018-MP镜头。软件系统搭建使用VS2010和Unity4.5版本。使用者佩戴视频眼镜以缓慢的速度围绕着工作平台运动。视频双目摄像头的图像采集速率为30 fps,基本满足视频流输出的要求;开发相机接口,保证双目摄像头采集图像的同步性。交互装配过程如图 10所示。

图10 交互装配过程Fig.10 Interactive assembly process

在该操作界面中,布满特征标记点的黑色标记板决定了物理空间坐标系的位置,白色标记板决定了虚拟空间的坐标系,如图 10 (a)所示。实物装配单元刀具夹在物理空间位置固定,使用者佩戴视频眼镜需通过操作鼠标键盘将虚拟刀具模型装配到刀具夹上。在装配过程开始阶段,首先建立配准关系;在虚拟空间,刀具的空间位置与其在物理空间一致,利用眼镜结构快速定位算法定位视频眼镜位置信息反馈至虚拟空间,通过观察眼镜显示窗口刀具夹的三维模型与其实物的重合程度判断配准关系是否建立正确,如图 10(b)所示。操作者通过操作鼠标键盘等交互方式完成虚拟的刀具装配模型装配在实物刀具夹装配单元的装配仿真过程,交互操作过程如图 10 (c)所示。交互操作之后,虚拟的刀具将装配在物理空间的刀具夹上,并通过视频眼镜实时输出显示,能使操作者真正感受到虚拟对象与物理对象的融合,从而实现信息物理世界的联合,融合结果如图 10 (d)所示。

5 结论

本文基于追踪定位技术开发了增强现实环境下的CPS虚拟装配,实现了虚拟三维模型与物理装配单元的装配仿真过程。结合视频眼镜结构的设计,通过图像融合的方式实现了CPS系统信息世界与物理世界深度联合的要求,初步改变了人与物理世界的交互方法,为进一步开展CPS工程研究提供了基础。此外,针对CPS系统实时性的要求,本文提出了一种眼镜结构的快速追踪定位算法,通过降低特征点图像检索区域提高了系统的效率。