基于关键标记点高频分析的模糊人脸图像鉴别

2018-03-27李月龙刘延昌肖志涛张欣鹏

李月龙,刘延昌,肖志涛,耿 磊,张 芳,吴 骏,张欣鹏

1(天津工业大学 计算机科学与软件学院,天津 300387) 2(天津工业大学 电子与信息工程学院,天津 300387) 3(天津市光电检测技术与系统重点实验室,天津 300387)

1 引 言

近年来,人脸识别技术越来越多的受到国内外研究者的关注,并取得了较大的研究进展.但这些研究工作一般是在图像质量较高的人脸数据集上进行的,实际应用中人脸图像往往会因为光照变化、姿态变化、遮挡、模糊等因素造成质量的降低,图像质量的降低往往会导致人脸识别精度下降[1].图像模糊产生于图像的获取、传输和压缩等各种过程之中,是最常见的一种图像失真类型,由图像模糊造成的人脸图像质量降低对人脸识别的影响非常明显,同一张人脸的模糊图像和清晰图像可能得到不同的识别结果[2,3].可以对模糊人脸图像进行鉴别,结合鉴别结果决定是否重新采集或者在后期的图像处理过程中加入针对图像模糊的一些处理方法,进而保证了待识别人脸图像的质量,最终达到提高人脸识别精度的目的[4].

以往有一些专门对一般性的模糊图像进行鉴别的研究.Su等人用图像奇异值分析来鉴别图像的模糊,该方法认为图像奇异值的大小与其包含的细节信息多少有关,存在较大奇异值的图像被判断为模糊[5].Marziliano等人先用Sobel算子提取图像边缘,然后以图像边缘平均宽度的大小为标准来鉴别模糊图像[6].

专门对模糊人脸图像进行鉴别的研究较少.Sang等人提出了专门针对模糊人脸图像进行鉴别的方法,该方法先将图像转到频率域,然后按照一定的阈值保留低频信息,将低频信息转成图像,比较其与原图像的欧氏距离,来判断原图是否模糊[7].

另外,多数对模糊人脸图像进行鉴别的研究只考虑了图像的特征,没有结合人脸的一些特性来设计鉴别方法.李月龙等人结合人脸的特性,提出眼睛、眉毛、鼻子、嘴这几个面部组件决定人脸是否模糊.并根据所有组件的模糊情况鉴别人脸图像是否模糊[8].直接提取一个大的组件会混入很多干扰信息,对鉴别结果造成了影响.

如何排除干扰信息,对图像模糊进行精细分析成为了一个很关键的问题.近年来,涌现出了大量的人脸标记点提取方法,人脸标记点提取精度越来越高,使得基于人脸标记点提取对图像模糊进行精细分析成为可能.另外,模糊图像包含的高频信息比清晰图像存在一定程度的缺失,两者的离散余弦变换系数矩阵也因此表现出不同的数据特征,很好地提取并利用这种差异可以进行模糊图像与清晰图像的区分.

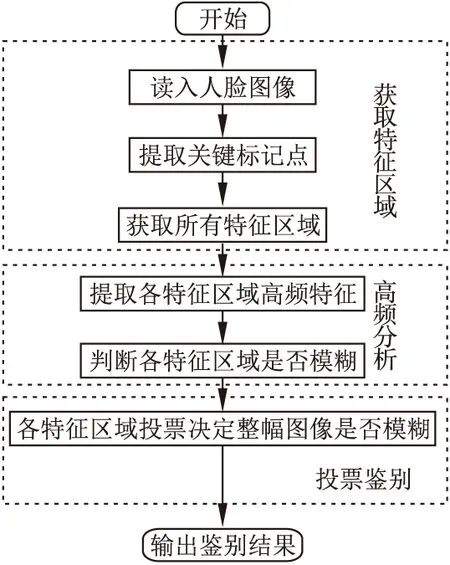

图1 本文方法流程图Fig.1 Flow chart of our method

鉴于以往对模糊人脸图像进行鉴别的研究比较少,现有的一些研究方法只考虑了图像的特征,没有很好地结合人脸的一些特性,因而鉴别的结果并不是很精确,本文提出了一种基于关键标记点高频分析的模糊人脸图像鉴别方法.该方法的总体流程如图1所示.考虑到图像模糊最直接地反应在图像细节信息上的特点,本文方法从人脸上最能体现细节信息的标记点入手.对人脸图像提取关键标记点,以各关键标记点为中心提取一系列特征区域,事实上这些特征区域的模糊情况可以决定整幅图像的模糊情况.对每个特征区域进行高频信息分析,提取能很好的代表特征区域是模糊还是清晰的特征,并引入分类器判断各特征区域是否模糊;最后,依据每个特征区域的判断结果,采用投票方式决定整幅人脸图像是否模糊,使得鉴别结果更加客观合理.文中根据该方法,设计了8种具体的鉴别策略,实验结果证明了该方法的有效性.

2 人脸图像关键标记点高频分析

2.1 人脸标记点提取

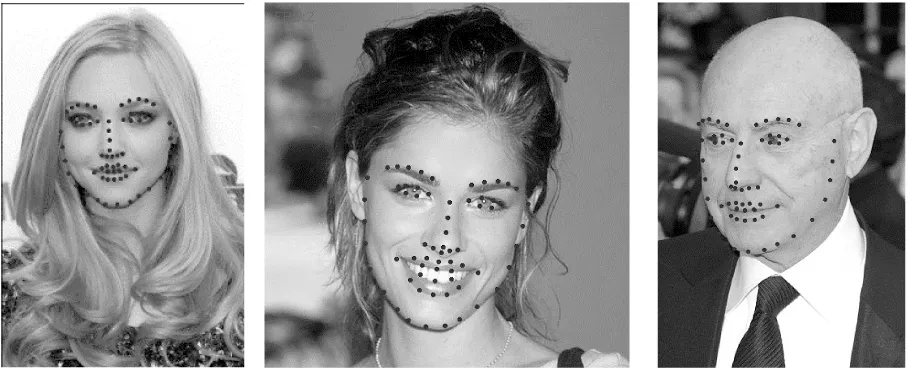

人脸标记点提取即用一定的方法,提取一系列有序的点来标记人脸轮廓,是描述人脸轮廓的主要形式[9].图2给出了对三张人脸图像提取标记点后的示例[10].眼睛、眉毛、鼻子、嘴的标记点是人脸标记点的核心部分,本文称为人脸关键标记点.

图2 提取标记点的人脸图像Fig.2 Faces with extracted landmarks

近年来,涌现出了大量的人脸标记点提取方法,标记点提取精度越来越高.Dollar等人于2010年首次提出级联形状回归模型来预测物体的形状,在人脸数据集上达到了很好的效果[11];Zhu等人提出的由粗到精的形状搜索方法,通过不断缩小搜索空间来匹配到最佳的人脸形状[12];Sun等人将卷积神经网络应用到人脸标记点的提取上,用一个三层的深度卷积神经网络来匹配人脸的标记点[13].

Cristinacce等人提出的约束局部模型通过在每个标记点周围构建局部模型来确定每个标记点的响应曲面,然后再结合形状模型对当前形状进行拟合,并更新形状模型参数,反复迭代直至每个标记点都匹配到合适的位置[14].随后,Baltrusaitis等人又提出了适合各种头部姿态的三维约束局部模型[15,16],使得标记精度更准确.

本文用三维约束局部模型对人脸标记点进行提取.最理想的方法是对每一幅人脸图像提取标记点,为节省运算量,文中用平均脸的标记点来代替每一幅人脸图像的标记点.

2.2 图像高频分析

2.2.1 离散余弦变换(Discrete Cosine Transform,DCT)

图像有空间域和频率域两种表示方式.一些在空间域里不明显的特征,转换到频率域却能很明显的表现出来,使得图像更容易被处理.

离散余弦变换是一种常用的空间域与频率域变换方式.变换过程速度快且能完整地保留图像信息,而且变换得到的系数矩阵中频带信息表现出非常好的分布规律[17].N×N的图像块函数t(i,j)的二维DCT[18]如公式(1)所示.

(1)

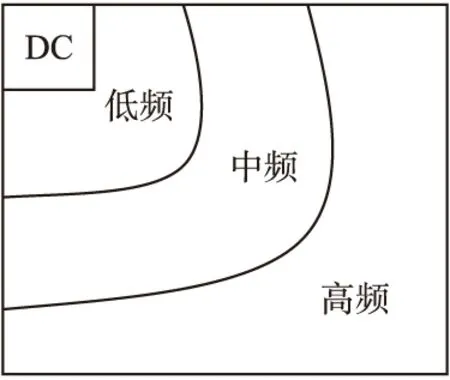

图3 DCT频带信息分布示意图Fig.3 Distribution of DCT frequency band

图像经过DCT后,T(0,0)常被称为直流系数,其他为交流系数,交流系数分低频、中频和高频.DCT系数矩阵的能量主要集中在其左上角,为图像的低频信息;而图像的高频信息则主要集中在右下角[19].高频信息相对于中低频信息,DCT系数绝对值较小.DCT系数矩阵频带信息分布示意图如图3所示.

2.2.2 图像高频分析

从空间域变换到频率域,图像内部比较平滑的区域,对应的是低频信息;图像灰度变化比较快的区域,例如图像边缘,对应的是高频信息.模糊图像整体比较平滑,因而高频信息有一定程度的缺失;清晰图像细节较明显,有很多灰度变化较快的区域,因而高频信息较丰富.

本文考虑利用高频信息来鉴别图像是否模糊.由于高频信息主要分布在DCT系数矩阵的右下角加之高频信息与中低频信息没有明显的界限,可以按照一定的保留比例从右下到左上按之字形取DCT系数矩阵中的数据.这个保留比例在下文中称为高频DCT系数,保留下来的DCT系数矩阵的数据称为高频DCT特征.例如,当高频DCT系数为0.5时,高频DCT特征为系数矩阵的右下部分的数据.

模糊图像的高频DCT特征与清晰图像相比,由于存在一定程度的缺失因此在数值的取值范围上存在一定的差异,可以依据这种差异来训练分类器进行分类.探索一个合适的高频DCT系数,使得取到的模糊图像与清晰图像的高频DCT特征区分度最大,决定分类效果的好坏.

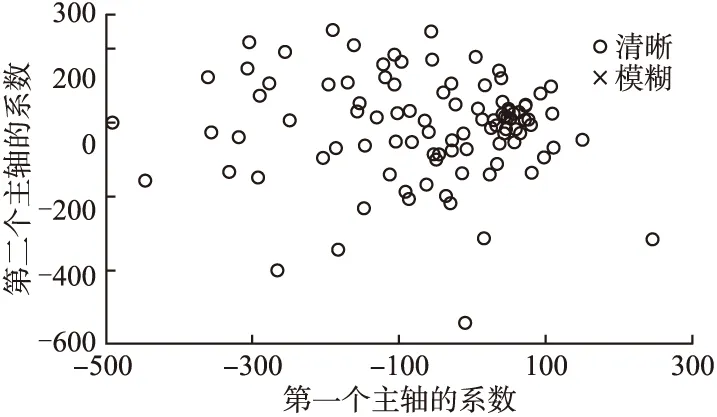

将图像的高频DCT特征进行主成分分析(Principal Component Analysis,PCA),利用PCA良好的主要特征提取能力进行数据降维,得到图像高频DCT特征对应的PCA特征,取前两个主轴上的系数为X轴坐标与Y轴坐标绘制代表图像的一个点.取模糊和清晰图像各100幅,绘制出一系列的点,如图4所示.

由图4能看出,模糊图像与清晰图像对应点的分布呈现出明显不同:模糊图像对应的点多集中在一个很小的区域里,而清晰图像对应的点则分布的比较分散.进一步说明了模糊图像与清晰图像高频DCT特征的可区分性.

2.3 人脸图像关键标记点高频分析

对模糊人脸图像进行鉴别可以结合人脸的一些特性,关键标记点能够很好地刻画人脸图像的细节信息,因此可以从关键标记点入手对图像进行精细分析.

以每个关键标记点为中心取特征区域,如果这些特征区域是模糊的,整幅人脸图像必然是模糊不清的;如果这些特征区域是清晰的,人脸的轮廓就清晰可见,整幅人脸图像也是清晰的.因此,以关键标记点为中心的特征区域的模糊情况可以代表整张人脸的模糊情况.

图4 PCA特征前两个主轴系数行成的点Fig.4 Points formed by the first two PCA axis coefficients

对特征区域进行高频分析,以模糊图像与清晰图像的高频DCT特征差异为分类依据,训练对应每个特征区域的分类器判断该特征区域是否模糊.最后根据每个特征区域的判断结果,以投票方式决定整幅人脸图像是否模糊是一种可行的方法.

基于关键标记点高频分析的模糊人脸图像鉴别方法算法描述如下.其中设定训练集中的人脸图像总数为M;关键标记点的个数为N并记为1号到N号;每幅人脸图像中取到的特征区域个数为N并记为1号到N号;计数变量i初值为1.

1.训练阶段

Step1.对训练集中的全部人脸图像,以各自的i号关键标记点为中心取各自的i号特征区域,记为Aj,j=1,2,…,M.

Step2.对每个特征区域Aj,用离散余弦变换将其转换得到其DCT系数矩阵,即Dj=dct(Aj),j=1,2,…,M.

Step3.对每个特征区域的DCT系数矩阵Dj,按照同样的比例提取高频DCT特征,即HDj=highdct(Dj),j=1,2,…,M.根据所属的人脸图像是模糊的还是清晰的,对各高频DCT特征HDj加标签.清晰记为“0”,模糊记为“1”.

Step4.以所有i号特征区域的带标签的高频DCT特征为输入,训练对应i号特征区域的分类器Ci.

Step5.计数变量i加1,若i小于特征区域个数N,返回Step1,直到训练出对应每一号特征区域的N个分类器.

2.测试阶段

Step1.读入一幅待测人脸图像.

Step2.根据关键标记点的位置取以每个关键标记点为中心的特征区域,记为Aj,j=1,2,…,N.

Step3.对每个特征区域Aj,用离散余弦变换将其转换得到其DCT系数矩阵,即Dj=dct(Aj),j=1,2,…,N.

Step4.对每个特征区域的DCT系数矩阵Dj,按照同样的比例提取高频DCT特征,即HDj=highdct(Dj),j=1,2,…,N.

Step5.用训练的对应每个特征区域的分类器对各个HDj进行分类,即Rj=classify(HDj)∈﹛0,1﹜,j=1,2,…,N.“0”代表清晰,“1”代表模糊.

Step6.统计分类结果,即R=∑Rj.取R与设定好的阈值T进行比较,若R大于阈值T则将图像判断为模糊,否则为清晰.

文中用总体鉴别率和模糊图像误判率来衡量鉴别结果的准确性,此处给出这两个评价标准的定义.

1.总体鉴别率(Identification Rate of Total Images,IRTI):用来衡量被测的模糊图像与清晰图像总体的鉴别结果.记被正确鉴别的模糊和清晰图像数量为TIIs(Ture Identification Images),被测图像总数为TIs(Total Images),总体鉴别率的计算方法如公式(2)所示.

(2)

2.模糊图像误判率(Rate of False Clear Images,RFCI):由于模糊图像鉴别过程更为关注模糊图像被误判断为清晰图像的情况,所以文中以模糊图像被误判为清晰图像的比例来衡量模糊图像的鉴别结果.记判断为清晰的模糊图像数量为FCIs(False Clear Images),被测模糊图像总数为BIs(Blurring Images),模糊图像误判率的计算方法如公式(3)所示.

(3)

3 实验及结果分析

实验中用到的人脸图像来自公开的FRGC(Face Recognition Grand Challenge)数据集[20],该数据集的采集环境与实际应用中人脸图像的采集环境类似,因而存在大量的因模糊产生的低质量图像.前期通过主观评价方法,在保证样本多样性的前提下选取模糊和清晰图像各1000幅组成子集,在子集上进行训练、测试.从子集中选出模糊和清晰图像各选100幅组成训练集,其余为测试集.为了更简捷地实现本文制定的鉴别策略,实验前对人脸图像进行人脸检测并去除了背景,处理完的图像均是128×128像素.用到的模糊和清晰图像示例如图5所示,其中第一行为模糊图像,第二行为清晰图像.

图5 模糊和清晰图像示例Fig.5 Samples of blurring and clear images

3.1 验证总体鉴别率

为验证总体鉴别率,本文设计了八种具体的鉴别策略进行试验并比较.

R_RF_V(Region_Random Forests_Voting):以单个特征区域的高频DCT特征为输入,选择随机森林分类器进行分类鉴别,最终鉴别结果由所有特征区域的分类结果投票产生;

RCPCA_RF(Region Combination Principal Component Analysis_Random Forests):对单个特征区域的高频DCT特征的组合进行处理得到的PCA特征,选择随机森林分类器进行分类鉴别;

IPCA_RF(Image Principal Component Analysis_Random Forests):对整幅图像的高频DCT特征进行处理后得到的PCA特征,选择随机森林分类器进行分类鉴别;

R_SVM_V(Region_ Support Vector Machine _Voting):以单个特征区域的高频DCT特征为输入,选择支持向量机分类器进行分类鉴别,最终鉴别结果由所有特征区域的分类结果投票产生;

RCPCA_SVM(Region Combination Principal Component Analysis_ Support Vector Machine):对单个特征区域的高频DCT特征的组合进行处理得到的PCA特征,选择支持向量机分类器进行分类鉴别;

IPCA_SVM(Image Principal Component Analysis_ Support Vector Machine):对整幅图像的高频DCT特征进行处理得到的PCA特征,选择支持向量机分类器进行分类鉴别;

I_CR(Image_Center Radius):由图4可以看出,模糊图像对应的点比较集中,而清晰图像对应的点则较分散.以模糊图像对应点的中心为圆心,最远的模糊图像对应的点到上述中心的距离为半径作圆.认为落在圆内的点对应的图像是模糊的,落在圆外的点对应的图像是清晰的.对整幅图像的高频DCT特征进行处理后得到的PCA特征使用上述策略进行鉴别;

RC_CR(Region Combination_Center Radius):对单个特征区域的高频DCT特征的组合进行处理得到的PCA特征进行与I_CR类似的鉴别策略.

其中R_RF_V、R_SVM_V是严格按照关键标记点高频分析的方法进行分类鉴别;RCPCA_RF、RCPCA_SVM、RC_CR利用了人脸标记点提取与图像高频分析进行分类鉴别;IPCA_RF、IPCA_SVM、I_CR只利用了图像高频分析进行分类鉴别.

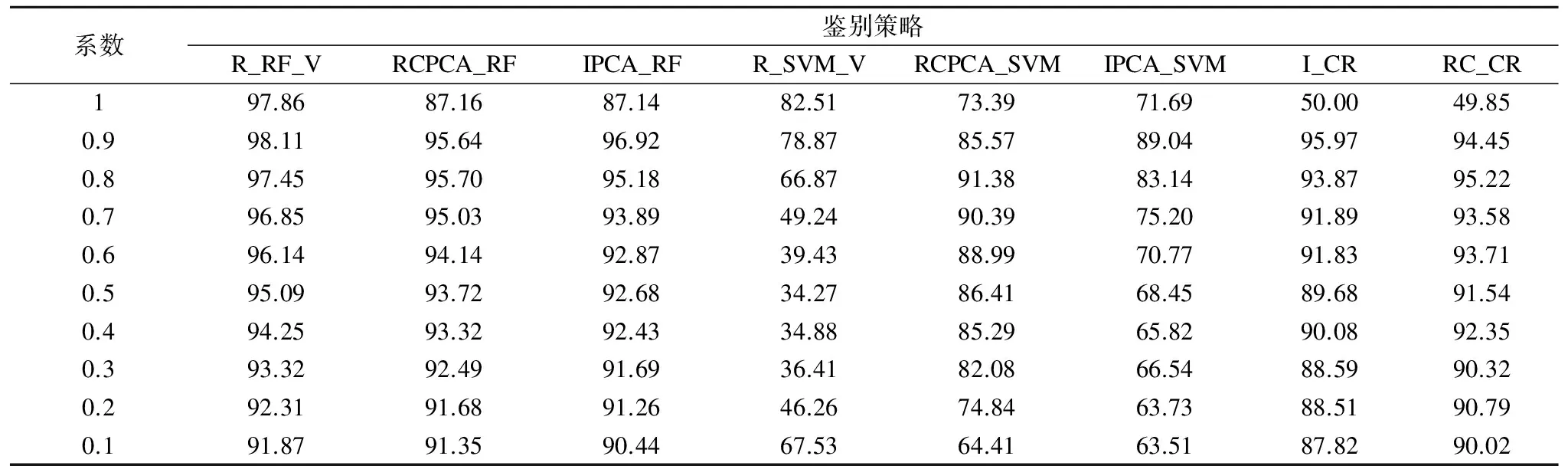

实验时以关键标记点为中心取11×11像素大小的特征区域.对各鉴别策略分别求出从0.1到1的10个高频DCT系数的总体鉴别率.为避免偶然性,每个高频DCT系数下进行10次实验,对10次实验得到的总体鉴别率求均值作为最终的总体鉴别率.实验结果如表1所示.

实验结果显示:

1)使用随机森林分类器的三种鉴别策略的总体鉴别率最高,各高频DCT系数下的总体鉴别率几乎都在90%以上;I_CR和RC_CR这两种鉴别策略的总体鉴别率也较高,各高频DCT系数下的总体鉴别率几乎都在85%以上;使用SVM分类器的三种鉴别策略总体鉴别率较低,最低的总体鉴别率降至了34%.

2) RCPCA_RF、RCPCA_SVM、RC_CR这三种利用了人脸标记点提取与图像高频分析的鉴别策略比对应的只利用图像高频分析的IPCA_RF、IPCA_SVM、I_CR 的总体鉴别率高.严格按照关键标记点高频分析的方法制定的两种鉴别策略中,R_RF_V比对应的利用了人脸标记点提取与图像高频分析的鉴别策略RCPCA_RF 的总体鉴别率高,R_SVM_V却比对应的利用了人脸标记点提取与图像高频分析的鉴别策略RCPCA_SVM 的总体鉴别率低,比对应的只利用图像高频分析的IPCA_SVM的总体鉴别率也低.

3)在高频DCT系数相同时,与其它7种鉴别策略相比,R_RF_V总体鉴别率最高;当高频DCT系数为0.9时,R_RF_V的总体鉴别率为98.11%,达到最高.

4)随着高频DCT系数的增加,各种鉴别策略下总体鉴别率几乎都有先升后降的趋势.

实验结果分析:

1)实验证明模糊图像和清晰图像的高频DCT特征确实存在差异,并且可以用来对模糊图像进行鉴别,并且能达到很高的鉴别精度.

2)分类器能够充分提取到样本之间的差异,因而使用分类器的策略比未使用分类器的策略鉴别精度高.严格按照关键标记点高频分析的方法制定的鉴别策略有最高的鉴别精度,但不同的分类器对鉴别结果有很大影响,本实验中支持向量机分类器的分类效果明显不如随机森林分类器,尤其是在鉴别策略R_SVM_V中,由于支持向量机分类器对各特征区域高频DCT特征的分类效果很差,导致了R_SVM_V的总体鉴别率非常低.

3)利用了人脸标记点提取与图像高频分析的鉴别策略比对应的只利用图像高频分析的鉴别策略的总体鉴别率高,是因为前者对人脸图像上高频信息集中地位置进行了更有针对性的提取,避免了一些干扰信息的混入,提取到的特征对模糊图像和清晰图像更具区分性.

表1 各高频DCT系数下各鉴别策略的总体鉴别率(%)

Table 1 IRTI of all strategies and all DCT coefficients (%)

系数鉴别策略R_RF_VRCPCA_RFIPCA_RFR_SVM_VRCPCA_SVMIPCA_SVMI_CRRC_CR197.8687.1687.1482.5173.3971.6950.0049.850.998.1195.6496.9278.8785.5789.0495.9794.450.897.4595.7095.1866.8791.3883.1493.8795.220.796.8595.0393.8949.2490.3975.2091.8993.580.696.1494.1492.8739.4388.9970.7791.8393.710.595.0993.7292.6834.2786.4168.4589.6891.540.494.2593.3292.4334.8885.2965.8290.0892.350.393.3292.4991.6936.4182.0866.5488.5990.320.292.3191.6891.2646.2674.8463.7388.5190.790.191.8791.3590.4467.5364.4163.5187.8290.02

表2 各高频DCT系数下各鉴别策略的模糊图像误判率(%)

Table 2 RFCI of all strategies and all DCT coefficients (%)

系数鉴别策略R_RF_VRCPCA_RFIPCA_RFR_SVM_VRCPCA_SVMIPCA_SVMI_CRRC_CR10.339.318.3820.7124.9827.440.040.620.90.303.592.1822.5926.3613.661.471.460.80.193.322.7938.1312.2415.542.093.590.70.144.173.3757.7210.1114.201.362.920.60.134.203.0364.318.4432.631.983.790.50.113.562.5880.1013.0035.811.122.390.40.093.762.0778.8414.8940.041.093.090.30.192.931.8880.2418.4735.530.721.710.20.392.601.5169.6332.6341.360.502.010.10.662.181.2751.1146.6353.040.361.11

4)随着高频DCT系数的增加,模糊图像与清晰图像的高频DCT特征的区别越来越明显,所以总体鉴别率越来越高;但当高频DCT系数过大时,由于中低频信息的混入,使得模糊图像与清晰图像的高频DCT特征的区别受到干扰,所以总体鉴别率会下降.

3.2 验证模糊图像误判率

对于模糊图像的误判情况(模糊图像被判断为清晰图像),在验证总体鉴别率的实验中,对模糊图像误判率进行了统计.实验结果如表2所示.

实验结果显示:

1)R_RF_V的模糊图像误判率最低,各高频DCT系数下的模糊图像误判率都在1%以下.其次是I_CR和RC_CR这两种鉴别策略,各高频DCT系数下的模糊图像误判率都在4%以下.接下来是其他两种基于随机森林分类器的鉴别策略,各高频DCT系数下的模糊图像误判率几乎在5%以下.基于SVM的三种鉴别策略较差,甚至达到了80%.

2)IPCA_RF、I_CR 这两种只利用了图像高频分析的鉴别策略比对应的利用了人脸标记点提取与图像高频分析的RCPCA_RF、RC_CR的模糊图像误判率低.而对于支持向量机分类器,RCPCA_SVM这种利用了人脸标记点提取与图像高频分析的鉴别策略比对应的只利用图像高频分析的IPCA_SVM的模糊图像误判率低.

3)严格按照关键标记点高频分析的方法制定的两种鉴别策略中,R_RF_V是所有鉴别策略中模糊图像误判率最低的,R_SVM_V是所有鉴别策略中模糊图像误判率最高的.

4)I_CR鉴别策略下,高频DCT系数为1时模糊图像误判率异常的低.

5)在高频DCT系数相同时,与其它7种鉴别策略相比,R_RF_V的模糊图像误判率几乎都是最低的;当高频DCT系数为0.4时,R_RF_V的模糊图像误判率为0.09%,达到最低(这里不考虑(4)中描述的特例,这个特例是一个伪最低值,将在实验分析中具体说明).

6)除了基于支持向量机的三种鉴别结果较差的鉴别策略之外,其他鉴别策略的模糊图像误判率较稳定,随着高频DCT系数的增大模糊图像误判率没有大幅度变动.

实验结果分析:

1)实验证明利用图像高频分析的方法对模糊图像进行鉴别是有效的,严格按照关键标记点高频分析的方法制定的鉴别策略有更准确的鉴别结果.然而,最终的鉴别结果都受到所选择的分类器的影响,例如本实验中随机森林分类器的分类效果较好,而支持向量机分类器的分类效果就很不理想.

2)相对于清晰图像,模糊图像的高频DCT特征表现出很强的数值稳定性.因而I_CR和RC_CR这两种基于中心半径来分类模糊图像与清晰图像的鉴别策略表现出很强的优越性,甚至达到了高于简单地使用随机森林分类器的IPCA_RF和RCPCA_RF这两种鉴别策略的鉴别精度.然而I_CR和RC_CR的鉴别结果还是不如R_RF_V这种对图像模糊进行精细分析的鉴别策略.

3)利用了人脸标记点提取与图像高频分析的鉴别策略的模糊图像误判率不如只利用了图像高频分析的鉴别策略,然而在验证总体鉴别率时却好于后者,可见该类策略对清晰图像有更好的鉴别结果.同时也说明了相对于严格按照关键标记点高频分析的方法制定的鉴别策略,该类策略的不稳定性.

4)相对于清晰图像,模糊图像的高频DCT特征表现出一定的数值稳定性,所以一些鉴别结果较好的鉴别策略下,高频DCT系数的变动对模糊图像误判率的影响不是很大.

5)I_CR鉴别策略高频DCT系数为1时,由于直流系数及一些低频信息的引入使得鉴别方法失效,所有图像被判断为模糊的,故模糊图像误判率很低.

6)总体鉴别率受到模糊图像鉴别情况与清晰图像鉴别情况两个方面的影响,结合表1的数据分析发现,基于关键点高频分析的方法对模糊图像比清晰图像有更精确的鉴别结果.

综合3.1节与3.2节的实验发现,基于关键标记点高频分析的方法提取出了模糊图像与清晰图像的差异,制定合理的鉴别策略可以用来进行很好地分类,尤其是对模糊图像有更准确稳定的分类效果.同时,实验证明了最合理的高频DCT系数为0.9,此时模糊图像与清晰图像的高频DCT特征区分度最好,总体鉴别率最高,模糊图像的鉴别结果也较精确.

3.3 对特征区域大小的探索

考虑到特征区域的大小与高频DCT特征的获得也有关系,进而对最终的鉴别结果产生影响,实验中对特征区域的最佳大小进行了探索.受到标记点与图像边界距离的限制,能取到的特征区域大小(以像素为单位)有7种,分别为:3×3、5×5、7×7、9×9、11×11、13×13、15×15.

对7种大小的特征区域分别用鉴别策略R_RF_V求出从0.1到1的10个高频DCT系数的总体鉴别率.为避免偶然性,每个高频DCT系数下进行10次实验,对10次实验得到的总体鉴别率求均值作为最终的总体鉴别率.

将上述实验结果,绘制成折线图后,比较发现5×5、7×7、9×9这三种特征区域的总体鉴别率折线图变化规律相差较小;11×11、13×13、15×15这三种特征区域的总体鉴别率折线图变化规律相差较小,图6给出3×3、5×5、11×11这三类具有代表性的特征区域的总体鉴别率折线图.

图6 三种代表性特征区域总体鉴别率折线图Fig.6 IRTI line graph of three representative feature regions

观察发现,11×11的特征区域总体鉴别率折线图增长率较稳定,当11×11的特征区域的高频DCT系数为0.9时,总体鉴别率达到最高.就特征区域的大小对模糊图像误判率的影响也做了探索,综合两方面的性能,特征区域的大小选择11×11是较合理的.

3.4 与其他方法进行比较

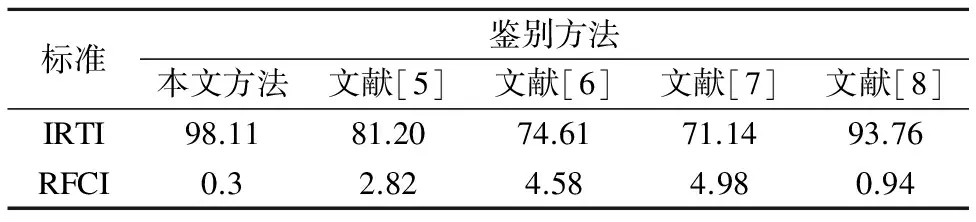

为进一步证明本文提出方法的有效性,用本文方法的鉴别策略R_RF_V与文献[5]、文献[6]、文献[7]和文献[8]提出的鉴别方法在同等实验条件下做了比较实验.表3列出了对总体鉴别率和模糊图像误判率的比较数据.

表3 模糊图像鉴别结果对比(%)

Table 3 Comparison of blurring image identification (%)

标准鉴别方法本文方法文献[5]文献[6]文献[7]文献[8]IRTI98.1181.2074.6171.1493.76RFCI0.32.824.584.980.94

比较发现,本文方法在总体鉴别率和模糊图像误判率上均明显好于文献[5]、文献[6]和文献[7].相对于文献[8],总体鉴别率提升了4%,模糊图像误判率也有所下降.总体而言,本文方法是相对较好的,证明了基于关键标记点高频分析方法的有效性.

4 总 结

人脸图像的模糊对人脸识别具有负面影响,对模糊人脸图像进行鉴别能够指导图像的采集以及后期的处理识别,进而降低图像模糊对人脸识别的影响.以往对模糊人脸图像进行鉴别的研究比较少,现有的一些研究方法只考虑了图像的特征,没有很好地结合人脸的一些特性,因而鉴别的结果并不是很精确,本文提出了一种基于关键标记点高频分析的模糊人脸图像鉴别方法.文中通过对根据该方法设计的8种具体鉴别策略的实验结果的比较分析,结合与他人提出的鉴别方法的鉴别结果进行比较,证明了该方法的合理性及有效性.对模糊人脸图像模糊程度的量化是后续进行研究和改进的重点.

[1] Zou Guo-feng,Fu Gui-xia,Li Zhen-mei,et al.Face image quality evaluation method based on the fusion of two level evaluation indexes [J].Journal of Shandong University(Engineering Science),2016,46(2):6-13.

[2] Yin Miao-yuan.Face image illumination and sharpness noreference assessment and application [D].Chongqing:Chongqing University,2015.

[3] Wang Zhi-ming.Review of no-reference image quality assessment [J].Acta Automatica Sinica,2015,41(6):1062-1079.

[4] Gao Xiu-feng,Zhang Pei-ren,Li Zi-qing.Standardization of face image sample quality [J].Journal of Chinese Computer Systems,2009,30(1):95-99.

[5] Su B,Lu S,Tan C L,et al.Blurred image region detection and classification [C].International Conference on Multimedia,Scottsdale,Arizona,USA,2011:1397-1400.

[6] Marziliano P,Dufaux F,Winkler S,et al.A no-reference perceptual blur metric [C].International Conference on Image Processing,Rochester,New York,USA,2002:57-60.

[7] Sang J,Lei Z,Li S Z,et al.Face image quality eva-luation for ISO/IEC standards 19794-5 and 29794-5 [C].International Conference on Advances in Biometrics,Alghero,Italy,2009:229-238.

[8] Li Yue-long,Liao Sheng-cai,Yi Dong,et al.Independent components based blur face identification[J].Journal of Computer-Aided Design & Computer Graphics,2014,26(11):1997-2006.

[9] Li Yue-long,Jin Yan,Wang Jian-ming,et al.Face feature points extraction:a review [J].Chinese Journal of Computers,2016,39(7):1356-1374.

[10] Belhumeur P N,Jacobs D W,Kriegman D J,et al.Localizing parts of faces using a consensus of exemplars[C].IEEE Conference on Computer Vision and Pattern Recognition,Washington,District of Colombia,USA,2011:545-552.

[11] Dollar P,Welinder P,Perona P,et al.Cascaded pose regression [C].IEEE Conference on Computer Vision and Pattern Recognition,San Francisco,California,USA,2010:1078-1085.

[12] Zhu S,Li C,Loy C C,et al.Face alignment by coarse-to-fine shape searching [C].IEEE Conference on Computer Vision and Pattern Recognition,Boston,Massachusetts,USA,2015:4998-5006.

[13] Sun Y,Wang X,Tang X,et al.Deep convolutional network cascade for facial point detection [C].IEEE Conference on Computer Vision and Pattern Recognition,Portland,Oregon,USA,2013:3476-3483.

[14] Cristinacce D,Cootes T F.Automatic feature localisation with constrained local models [J].Pattern Recognition,2008,41(10):3054-3067.

[15] Baltrusaitis T,Robinson P,Morency L,et al.3D co-nstrained local model for rigid and nonrigid facial tracking [C].IEEE Conference on Computer Vision and Pattern Recognition,Providence,Rhode Island,USA,2012:2610-2617.

[16] Saragih J,Lucey S,Cohn J F,et al.Face alignment through subspace constrained meanshifts [C].International Conference on Computer Vision,Kyoto,Japan,2009:1034-1041.

[17] Chen Rui,Wang Jing,Huang Hua-jun,et al.Multifocus image fusion based on block DCT transform [J].Journal of Chinese Computer Systems,2016,37(2):321-326.

[18] Haghighat M B A,Aghagolzadeh A,Seyedarabi H.Multifocus image fusion for visual sensor networks in DCT domain [J].Computers & Electrical Engineering,2011,37(5):789-797.

[19] Chu Heng,Zhu Wei-le.Image fusion algorithms using discrete cosine transform [J].Optics and Precision Engineering,2006,14(2):266-273.

[20] Phillips P J,Flynn P J,Scruggs T E,et al.Overview of the face recognition grand challenge [C].IEEE Conference on Computer Vision and Pattern Recognition,San Diego,California,USA,2005:947-954.

附中文参考文献:

[1] 邹国锋,傅桂霞,李震梅,等.融合二级评价指标的人脸图像质量评价方法[J].山东大学学报(工学版),2016,46(2):6-13.

[2] 尹渺源.人脸图像的光照和清晰度质量无参考评价及应用[D].重庆:重庆大学,2015.

[3] 王志明.无参考图像质量评价综述[J].自动化学报,2015,41(6):1062-1079.

[4] 高修峰,张培仁,李子青.人脸图像质量评估标准[J].小型微型计算机系统,2009,30(1):95-99.

[8] 李月龙,廖胜才,易 东,等.基于独立组件的模糊人脸图像鉴别[J].计算机辅助设计与图形学学报,2014,26(11):1997-2006.

[9] 李月龙,靳 彦,汪剑鸣,等.人脸特征点提取方法综述[J].计算机学报,2016,39(7):1356-1374.

[17] 陈 睿,王 晶,黄华军,等.Alsharif.基于分块DCT变换的多聚焦图像融合[J].小型微型计算机系统,2016,37 (2):321-326.

[19] 楚 恒,朱维乐.基于DCT变换的图像融合方法研究[J].光学精密工程,2006,14(2):266-273.