基于全局特征与局部特征的图像分级匹配算法研究及应用

2016-09-08朱奇光王梓巍

朱奇光 王梓巍 陈 颖

1.燕山大学,秦皇岛,0660042.河北省特种光纤与光纤传感重点实验室,秦皇岛,066004

基于全局特征与局部特征的图像分级匹配算法研究及应用

朱奇光1,2王梓巍1陈颖1

1.燕山大学,秦皇岛,0660042.河北省特种光纤与光纤传感重点实验室,秦皇岛,066004

移动机器人基于拓扑地图导航时要求图像特征提取与匹配算法具有高的精度和鲁棒性、良好的实时性,针对此,提出了基于全局特征和局部特征的图像分级匹配算法。首先对输入的待匹配图像应用改进的形状上下文算法提取全局特征与图像库中图像进行遍历粗匹配,得到与当前待匹配图像相似度最高的3幅图像并构建临时图像库;然后利用改进的SIFT算法提取输入图像局部特征与临时图像库中3幅图像的局部特征进行精确匹配,最终得到与待匹配图像相似度最高的图像作为匹配结果输出。所提出的图像分级匹配算法将基于全局特征的改进形状上下文算法和基于局部特征的改进SIFT算法相结合,从而达到优势互补的目的。实验结果表明,该算法在机器人基于拓扑地图导航过程中有效地提高了图像匹配效率,缩短了运行时间。

移动机器人;图像匹配;改进形状上下文;改进SIFT

0 引言

在未知的环境中机器人依靠自身携带的传感器创建环境模型是当前机器人研究领域的一个热点问题[1]。拓扑地图是目前常用的一种环境模型。拓扑地图中,最重要的是节点的创建与识别。机器人将提取的具有较强识别性的环境特征与拓扑节点绑定,在进行环境特征互相匹配时,需要有效地识别不同拓扑节点,最终实现机器人拓扑地图的创建和导航。

通过研究基于图像特征进行图像匹配的文献发现,大部分学者均是将彩色图像转换为灰度图像,仅仅利用亮度信息提取图像特征[2]。在实际应用中应充分将亮度特征与颜色、纹理和形状等特征相结合,提高图像匹配的精确度和鲁棒性。刘佳等[3]提出了基于多分辨率小波分解的改进尺度不变特征变换(scaleinvariantfeaturetransform,SIFT)[4]图像匹配算法,改进后的算法提高了匹配精度,具有较好的定位效果,但是实时性较差,不满足机器人导航的要求;Lu等[5]提出了基于颜色矩的改进SIFT图像匹配算法,该改进算法提高了图像匹配的速度,但颜色特征丢失了空间的位置信息,且颜色特征受光照变化影响较大,鲁棒性较差;陈抒瑢等[6]提出全局纹理特征与SIFT特征相结合的图像匹配算法,该算法对图像尺度、旋转、光照、视角等变化具有很强的鲁棒性,但是计算量较大,无法满足机器人导航的实时性要求;Zhong等[7]提出了融合局部形状信息与SIFT特征的图像匹配算法,改进后的算法能有效地降低错配概率,获得良好的仿射不变性,但是其计算量过大,降低了算法的匹配效率;高晶等[8]提出了一种基于曲率尺度空间提取关键点的角点检测的图像匹配算法,在噪声干扰、尺度缩放、亮度变化的情况下具有较好的匹配效果,但是图像特征匹配的速度有待提高。

移动机器人基于拓扑地图导航时要求图像特征提取与匹配算法具有高的精度和鲁棒性,且有较好的实时性,针对此,提出了基于全局特征和局部特征的图像分级匹配算法。该算法将图像匹配分为粗匹配和精匹配两个阶段,融合全局特征和局部特征,从而达到优势互补的目的。

1 改进的图像匹配算法

1.1改进的图像匹配算法粗匹配

在图像匹配过程中,相比于纹理特征和颜色特征,形状特征是一种高级别的视觉信息,它所描述的视觉信息层次更高,范围更大[9]。

形状上下文特征是一种经典的轮廓描述子,该描述子从轮廓点的空间位置出发,利用对数极坐标直方图对图像中的物体轮廓分布情况进行统计以实现图像匹配[10]。但是原始的形状上下文描述子并不能准确地反映轮廓的全局特征,它只能计算出每个区域内所含特征点的数量,着重描述整体轮廓分割后的局部轮廓,缺少全局信息。同时对平面进行分割时涉及参数(距离与角度)的确定,降低了算法的适应性。最重要的是形状上下文算法忽略了轮廓点之间的重要信息——顺序关系。

针对形状上下文算法存在的问题,本文采用改进的形状上下文算法。采用改进的形状上下文算法可得到以vi为参考点的由N个点构成的轮廓空间,利用轮廓的顺序关系将所有的上下文信息组合起来形成一个特征序列。

改进的形状上下文算法前期处理与原始形状上下文算法一致,得到以采样点vi为原点的其余N-1个点在极坐标系中的相对极坐标l(vi,vj):

l(vi,vj)=li,j=(vi,vj)j=1,2,…,N;j≠i

(1)

因为轮廓点在形状中具有自然的顺序关系,根据此顺序关系将式(1)表示的所有相对坐标数据li,j改写成序列Li:

Li=(li,i+1,li,i+2,…li,N,li,1,…,li,i-2,li,i-1)T

(2)

式(2)即改进的形状上下文描述子。

与原始的形状上下文描述子相比,改进的形状上下文描述子在包含轮廓点上下文信息的同时,还可以利用轮廓点的先后顺序关系,准确地描述形状的全局信息;对二维平面不需要进行分割,从而免除了确定若干分割参数的麻烦,减小算法计算量,同时提高了算法的通用性。

为了保证改进的形状上下文描述子具有尺度不变性,对其进行局部归一化处理。将每个轮廓点的形状上下文描述子Li按顺序进行排列,组成(N-1)×N的矩阵:

A=A(V)=[L1L2L3…LN-1LN]

(3)

分别对矩阵A的每一行进行归一化:

(4)

若所有的轮廓点都计算其形状上下文特征,则会导致对轮廓的描述过于精细,对形状变形过于敏感。为了平衡描述子在准确性和敏感性之间的矛盾,提高其鲁棒性,我们对改进的形状上下文描述子进行平滑化处理[11]。

改进的形状上下文描述子可表示为

(5)

式(5)包括N-1个序列,将此序列划分为若干个互不相交的子序列:[1,t],[t+1,2t],[2t +1,3t],…。其中t是设定的正整数。然后分别对于每一个子序列计算其分量的均值:

(6)

其中,c=1,2,…,W,c表示划分后第c个子序列的序号,W=(N-1)/t。由此W个均值构成了平滑化处理后的改进上下文描述子:

(7)

改进的上下文描述子经过平滑化处理后提高了鲁棒性,同时降低了描述子维度,有效提高了算法运行效率。两个轮廓首先进行形状匹配,然后再进行相似性度量。形状匹配问题的实质就是通过计算形状之间的匹配代价(对应点之间的欧氏距离),然后应用动态规划算法寻找两个轮廓点序列之间最佳对应关系(匹配代价最小)。相似性度量时,分别计算轮廓的形状复杂性,然后再求取形状复杂性之间的欧氏距离。

1.2改进的图像匹配算法精确匹配

针对SIFT算法因计算量大而导致在图像匹配阶段实时性较差的问题,本文提出了改进的SIFT算法。该算法通过减法聚类剔除冗余的特征点,将得到的特征描述子二值化,根据hash函数生成索引,以汉明距离进行相似性度量。改进后的算法实时性较好,匹配效率较高。

原始SIFT算法大量的特征点中含有许多相似度非常高的特征点,在图像匹配中作用非常小,却增加了后续运算的复杂度。在改进的SIFT算法中,应用减法聚类剔除冗余的特征点。

减法聚类是一种密度聚类的算法,可以快速查找数据的数目和中心[12]。假设检测出n个特征点组成的集合{x1,x2,…,xn}。改进的SIFT特征点检测步骤如下:

(1)首先根据下式计算特征点集合中每个特征点的密度,得到密度指标M(xi):

(8)

其中,r1为邻域半径,d(xk,xi)为xk与xi的欧氏距离。根据文献[13]及多次实验验证可知取r1=1.6为最优值,实验效果最理想。

(2)将寻找到的密度指标值最大的特征点作为首个聚类中心,然后除去该特征点的密度,再计算其他特征点的密度指标值Mk(xi)。

(9)

其中,r2=1.5 r1。

(3)按照上述步骤再次寻找密度指标的最大值,并把该特征点作为聚类中心,直到没有新的聚类中心产生,则迭代终止。

SIFT算法的128维特征描述子匹配能力较强,但其数据量过大。改进SIFT算法对特征描述子进行二值化处理,保留特征描述子信息的同时大幅度减小数据量,从而提高了算法运行速度[14]。

将减法聚类运算处理后的特征点所生成的特征描述子进行二值化,把128维特征向量转化为128位的二进制字符串。假设128维特征向量S=(S0,S1,…S127)。

(1)首先根据下式计算同一向量中Si(Si是特征描述子某一维的数值)和Si+1差的绝对值:

(2)根据Qi值,按下式计算128位二进制特征向量中每位数值bi,得到二值化的特征描述子b={b0, b1,…,b127}:

(11)

式(11)中R为差值的阈值,其作用是将式(10)所得的差值均匀分成两部分。本文取R=14。

针对改进的特征描述子本文利用hash值作为索引,以汉明距离度量特征描述子之间的相似度。改进后的特征匹配方法提高了检索效率。

首先根据hash函数计算出代表特征点的128位二进制字符串的hash值。令

Ni=bi×8×20+bi×8×21+…+bi×8×27

(12)

其中i=0,1,…,15,并且N16= N0。同时:

(13)

hash函数定义如下:

H(h0,h1,…,h15)=h0×20+h1×21+…+h15×215

(14)

其计算结果即hash值,变化范围为0~65 535。

在匹配阶段首先对待查询图像执行改进的特征点检测步骤并生成描述子,将生成的二值化特征描述子根据式(14)计算其hash值并在hash库中进行检索。

ni代表图像i与当前查询图像之间相似特征描述子的数量,初始化ni=0。计算两个特征描述子之间的汉明距离,若小于阈值则ni←ni+1,表示两个图像之间存在一对匹配成功特征。当待匹配图像所有的特征均在hash库中进行了检索,则根据ni最大值决定匹配成功的图像。

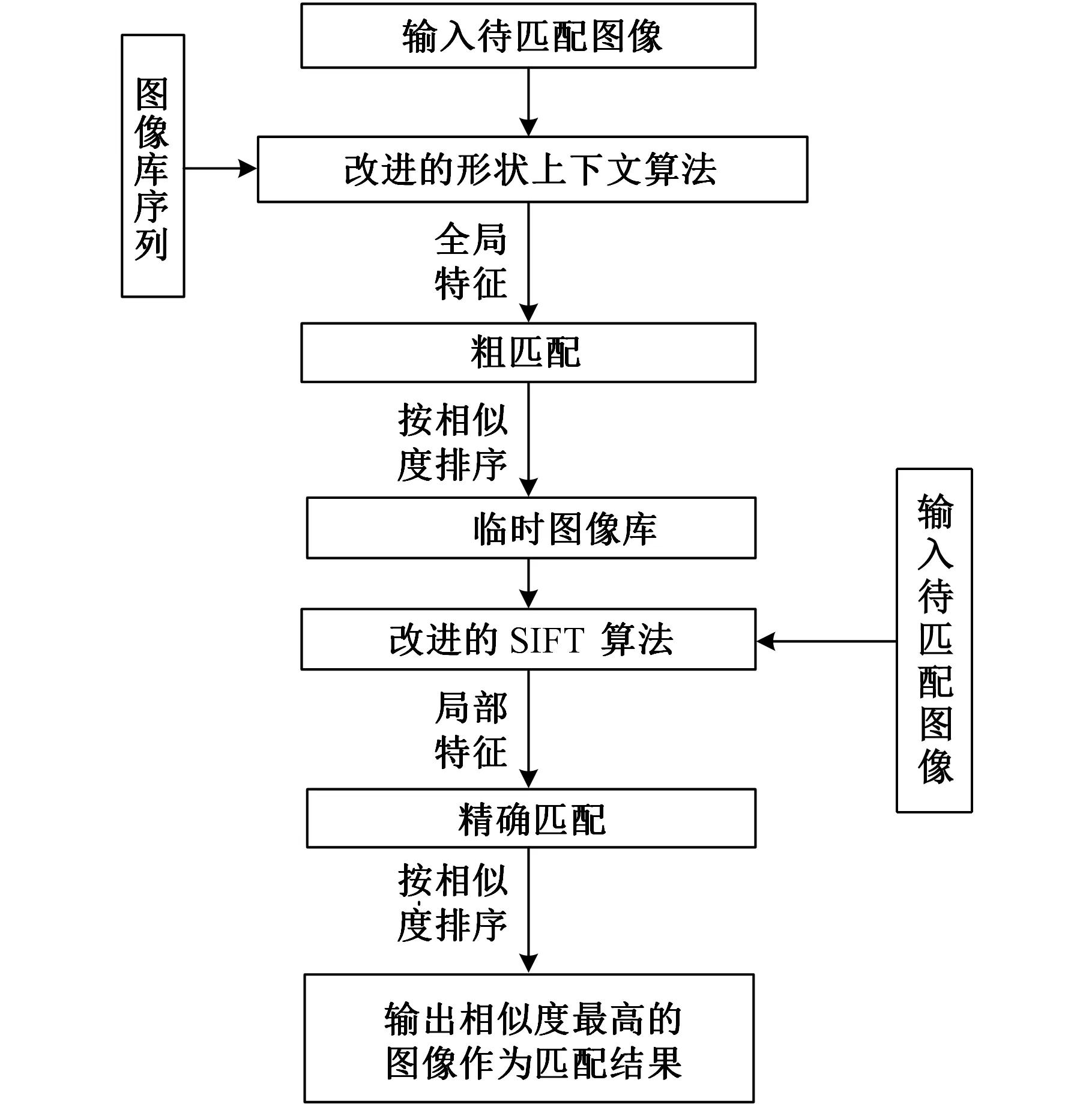

1.3图像分级匹配算法总体流程

移动机器人基于拓扑地图导航时,节点识别采用基于全局特征与局部特征的图像分级匹配算法。该算法总体流程如图1所示。

图1 算法流程图

首先对输入的待匹配图像应用改进的形状上下文算法提取全局特征与图像库中图像进行遍历粗匹配,得到与当前待匹配图像相似度最高的3幅图像并构建临时图像库;然后利用改进的SIFT算法提取输入图像和临时图像库中3幅图像的局部特征,并进行精确匹配,最终得到与待匹配图像相似度最高的图像作为匹配结果输出。

2 实验与仿真研究

本文实验和仿真研究采用Pioneer3TM平台,其中视觉系统的单目摄像头为CanonVC-C50i,其垂直方向旋转范围为±30°,水平方向旋转范围为±100°,最大分辨率为704pixel×576pixel。实验仿真部分均基于配置为i3-2310MCPU2.10GHZ、内存2GB的PC机,并以MATLAB8.1为平台进行。移动机器人平台和视觉摄像头分别如图2和图3所示。

图2 移动机器人平台 图3 视觉摄像头

2.1实验参数的设定

改进的形状上下文算法主要涉及三个参数的设定:轮廓采样点数N;平滑化处理参数t;形状描述子长度W。

改进的形状上下文算法轮廓采样点数的设置与许多常见形状轮廓描述子相同,取N=100。经过多次仿真实验验证,当N=100时,能够得到一个运算速度和准确率平衡的实验结果。

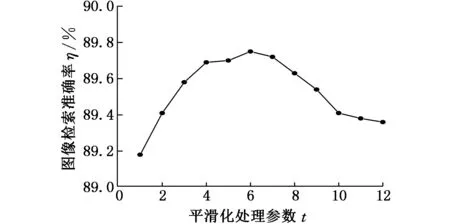

若改进的算法采纳所有采样点的数据,则对形状的描述过于精细,从而降低了算法对局部形变的鲁棒性。为了在精确性与鲁棒性之间取得良好的折中,本文采用平滑化处理技术对采样点进行处理。根据本文所提出算法在实验所需的图像库中进行检索,得到如图4所示的图像检索准确率η与平滑化处理参数t的关系。由图4可知,当t=6时,图像检索准确率η最高,实验效果最佳。

图4 图像检索精度与平滑化处理参数的关系

本文算法的形状描述子特征向量维数W=(N-1)/t,即特征向量的维数由采样点数量和平滑化参数确定。根据N=100,t=6,可得W=16。由于每个特征向量都描述一个二维坐标数据,因此改进后的形状描述子特征向量实际维数为2W=32。与形状上下文描述子特征向量60维[15],内距离形状上下文描述子[16]特征向量90维相比,改进的算法特征向量维数较低,运算效率较高。

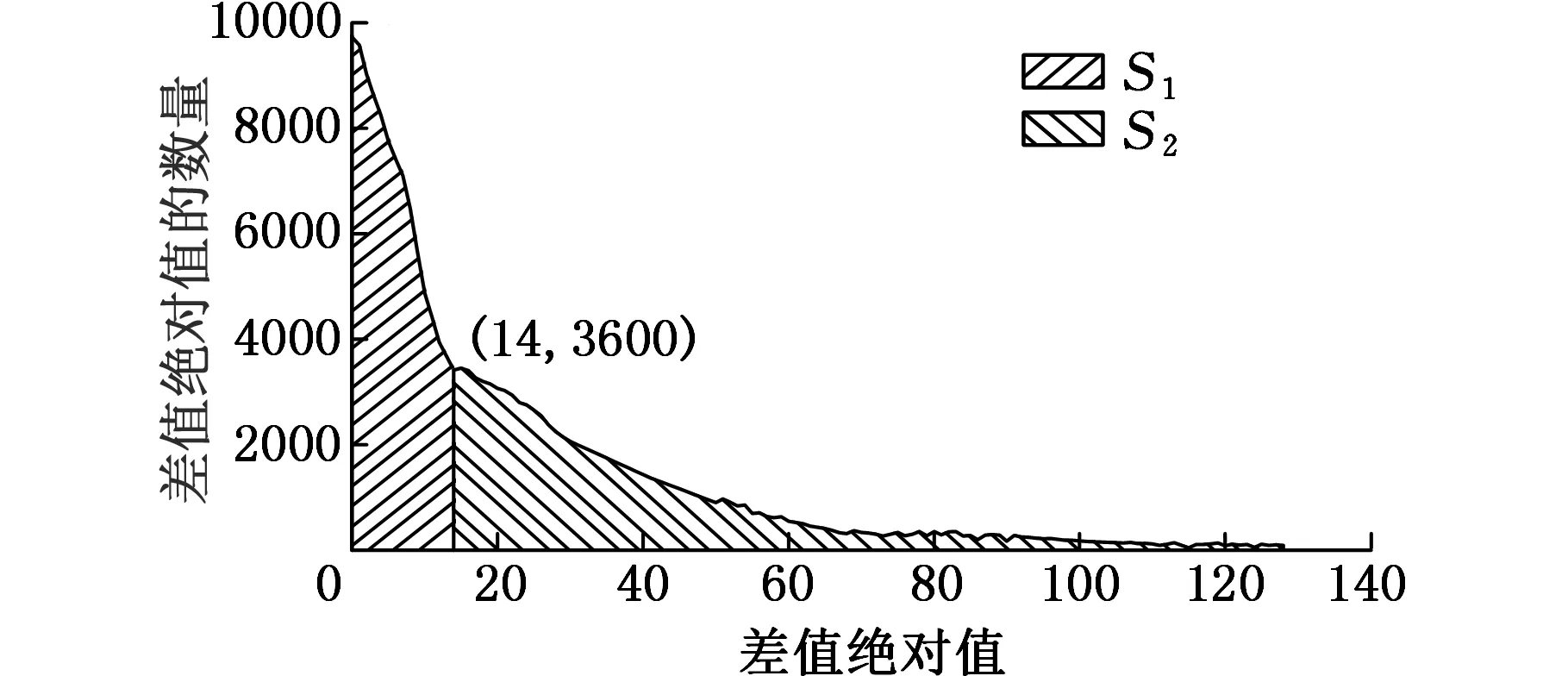

改进的SIFT算法的主要参数是阈值R。R的作用是将式(10)所得的差值均匀分成两部分。实验随机选取图像库9幅图像作为实验图像,统计同一特征符128维数值间相邻数值差的绝对值信息。通过对实验数据(图5)进行分析可知:S1区域共包含96 535个差值,S2区域共包含96 557个差值。即R=14时,可以将所有差值的绝对值分成数量相等的两组。

图5 差值绝对值的数量分布图

2.2图像匹配实验

改进的形状上下文算法几何意义明确、易于计算、描述性强,图像的匹配效果较好。相对于原始的形状上下文算法,改进算法避免了直方图计算、参数选取等问题,保留了较为准确的轮廓点相对位置信息,通过轮廓点的顺序关系增加了描述子的全局形状信息。根据2.1节可知改进后的形状上下文描述子维数为32。与形状上下文描述子特征向量60维、SIFT描述子特征向量128维相比,改进的形状上下文图像匹配算法描述子维数较低,运算效率较高。与使用SIFT算法相此,改进的形状上下文算法将待匹配与图像库进行粗略遍历匹配,缩减了大量运算时间,避免了精确遍历匹配整个图像库,提高了算法的运行效率,有利于机器人实时性导航。

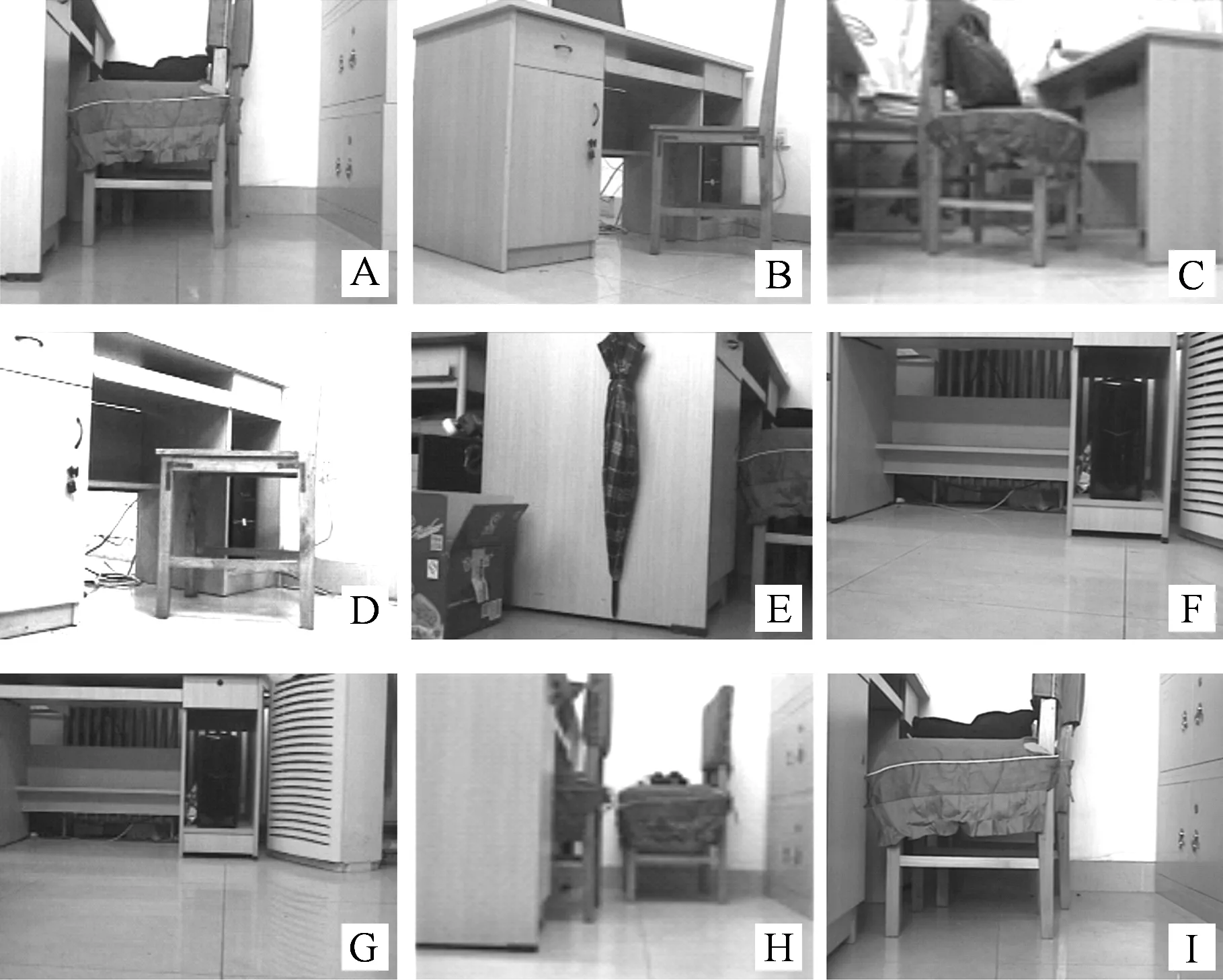

图像粗匹配实验采用由Pioneer3TM视觉系统的单目摄像头在笔者实验室拍摄的大量环境图像中的9幅作为图像库,分别标记为A、B、C、D、E、F、G、H、I,如图6所示。

图6 实验图像库

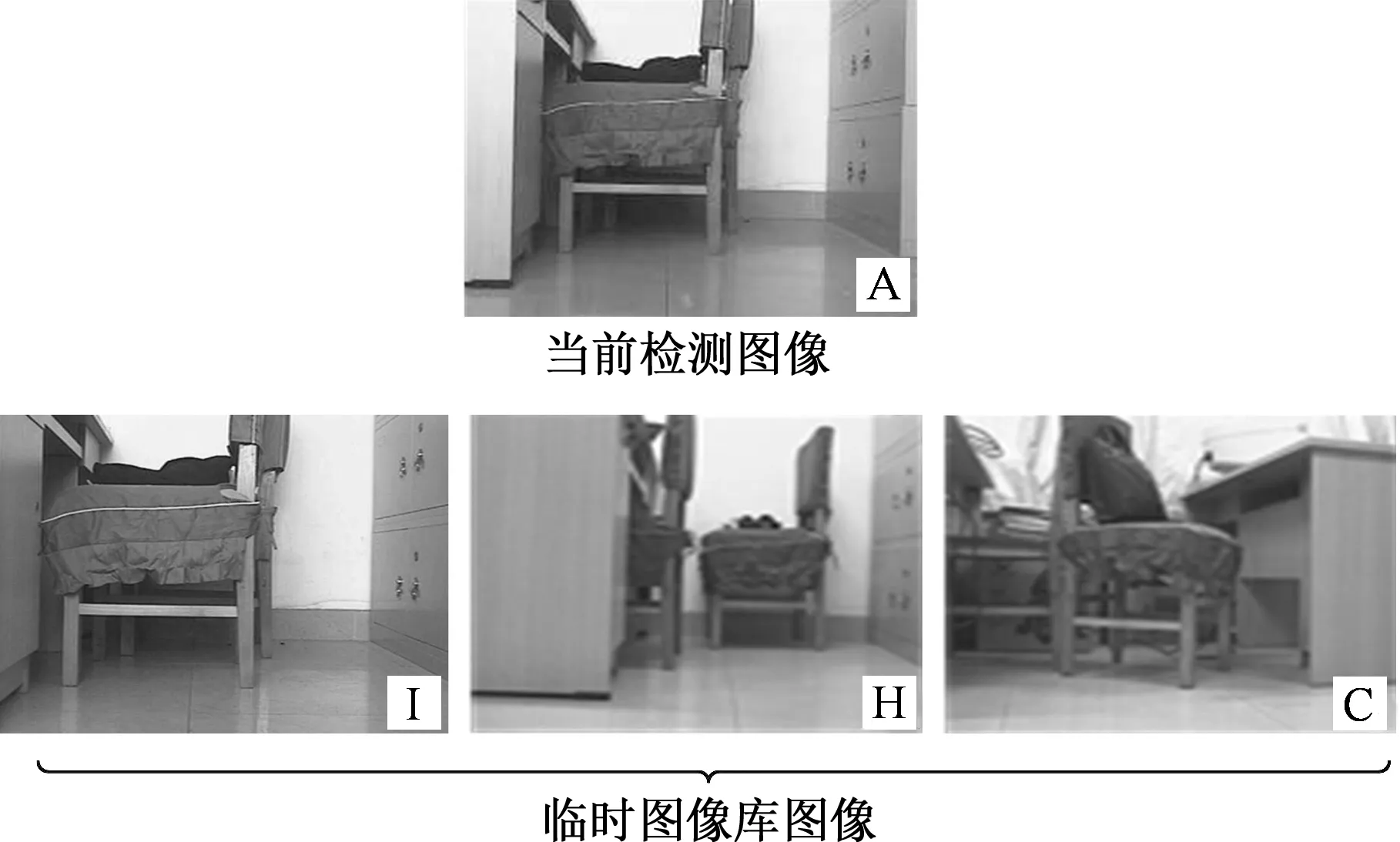

假设A为待匹配图像,表1为仅使用本文所提出的改进SIFT算法将待匹配图像与图像库遍历匹配得到的实验数据;表2为使用改进的形状上下文算法将待匹配图像与图像库进行遍历粗匹配得到的实验数据,图7为粗匹配返回的图像构建的临时图像库。根据表1和表2可知:仅使用改进的SIFT算法进行图像匹配所需时间为11.914s;若使用本文提出的图像分级匹配算法,所需时间为改进的形状上下文算法匹配的时间与待匹配图像A应用改进的SIFT算法遍历匹配临时图像库时间之和,即0.707s+1.892s+1.576s+1.389s=5.564s。

表1 改进SIFT算法图像匹配实验数据

表2 改进的形状上下文算法图像匹配实验数据

图7 粗匹配返回结果

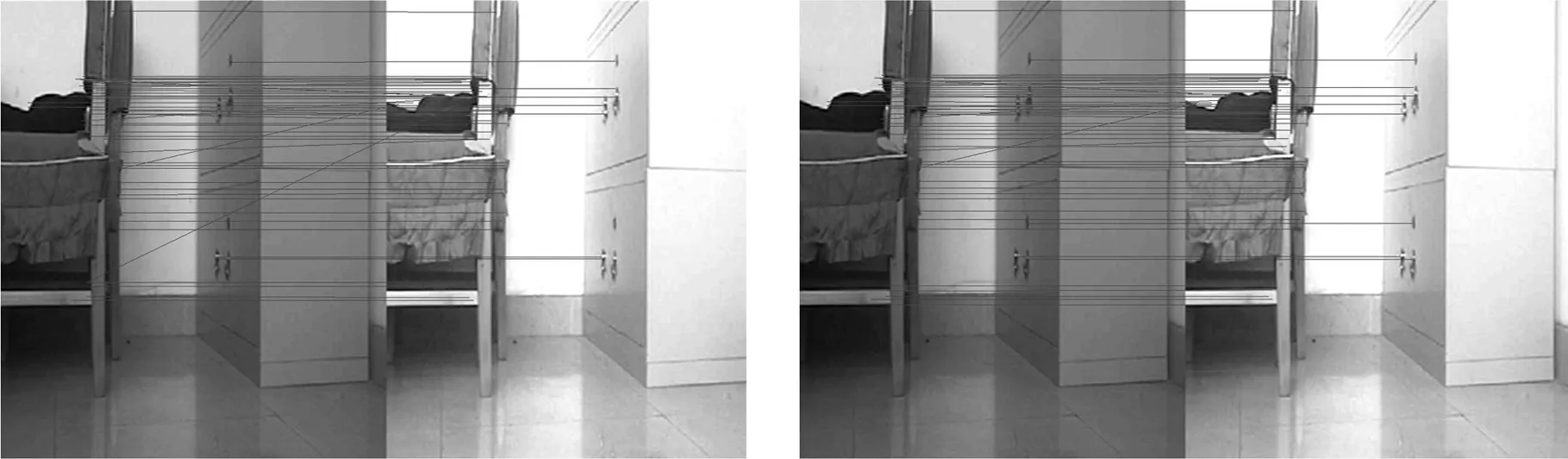

(a)SIFT算法 (b)I-SIFT算法图8 尺度和视角变换

(a)SIFT算法 (b)I-SIFT算法图9 光照变换

(a)SIFT算法 (b)I-SIFT算法图10 加入混合噪声

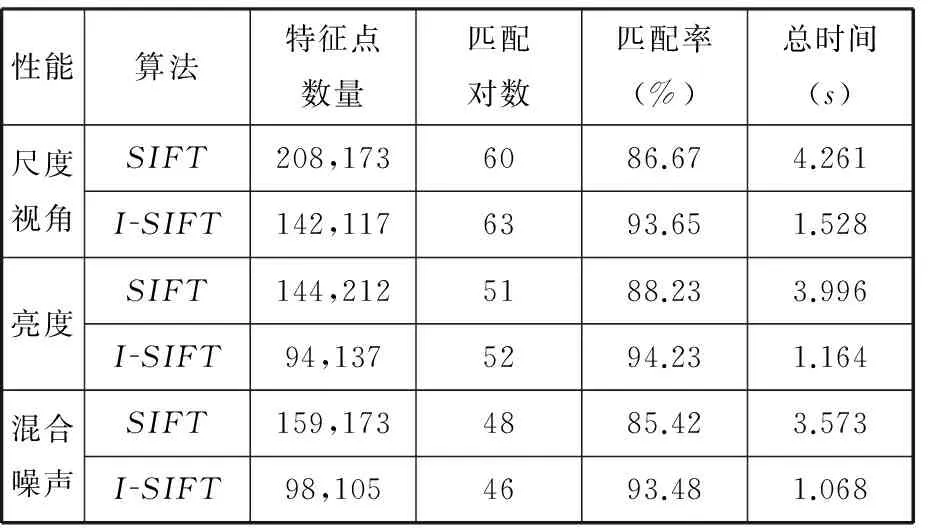

本文提出的基于全局特征和局部特征的图像分级匹配算法在精确匹配阶段采用改进的SIFT算法(I-SIFT算法)。为了验证I-SIFT算法的性能,随机挑选机器人真实运行环境里的三组图像,在尺度与视角变换、光照变换、加入混合噪声三种情况下进行对比试验。图8两分图中的图像是前后移动0.5m,同时左右旋转20°拍摄的;图9两分图中的图像是机器人在不同光照环境下拍摄的;图10两分图中左侧为移动机器人视觉摄像头正常拍摄的图像,右侧为加入混合噪声的图像,混合噪声由均值为0、方差为0.01的高斯噪声和噪声密度为0.5椒盐噪声组成。图8~图10是I-SIFT算法与原始的SIFT算法进行对比实验的匹配结果,表3为实验所得数据。

表3 改进 SIFT与原始SIFT算法图像匹配性能比较

表3中SIFT代表原始的SIFT算法。特征点数量代表样本图像和待匹配图像的特征点数量,匹配对数即两幅图像成功匹配的对数,匹配率为正确匹配对数与匹配对数的比值,总时间即整个匹配过程的总时间。根据表中数据,与SIFT相比,I-SIFT中各组图像特征点数量减少30%~40%;匹配对数基本维持不变;匹配率增长6%~12%;匹配时间降低60%~70%。原因在于本文在提取完特征点之后采用减法聚类算法,将存在于大量特征点中的冗余点进行了剔除。同时二值化后的特征描述符依据hash函数生成索引值,采用汉明距离进行相似性度量,由于计算机本身以二进制作为内部运算逻辑,在运算过程中有很大的优势,且避免了度量阶段计算欧氏距离所需的开平方运算,从而提高了算法的运行速度,降低了误匹配率。

2.3图像分级匹配算法性能分析

基于局部特征的改进SIFT算法鲁棒性较好、精度高,对旋转、光照、尺度等环境改变不变性较好,但是描述子维度高,匹配耗时大,不适合对图像库进行遍历匹配。基于全局特征的改进形状上下文算法描述的信息层次更高、范围更大,融入了轮廓的顺序关系,简化了描述子的定义和计算过程,匹配效率非常高。但是对形状的轮廓比较敏感、易受噪声影响,且轮廓点是均匀提取,对形状的描述还有局限。本文提出的图像分级匹配算法将基于局部特征的改进SIFT算法和基于全局特征的改进形状上下文算法相结合,从而达到优势互补的目的。

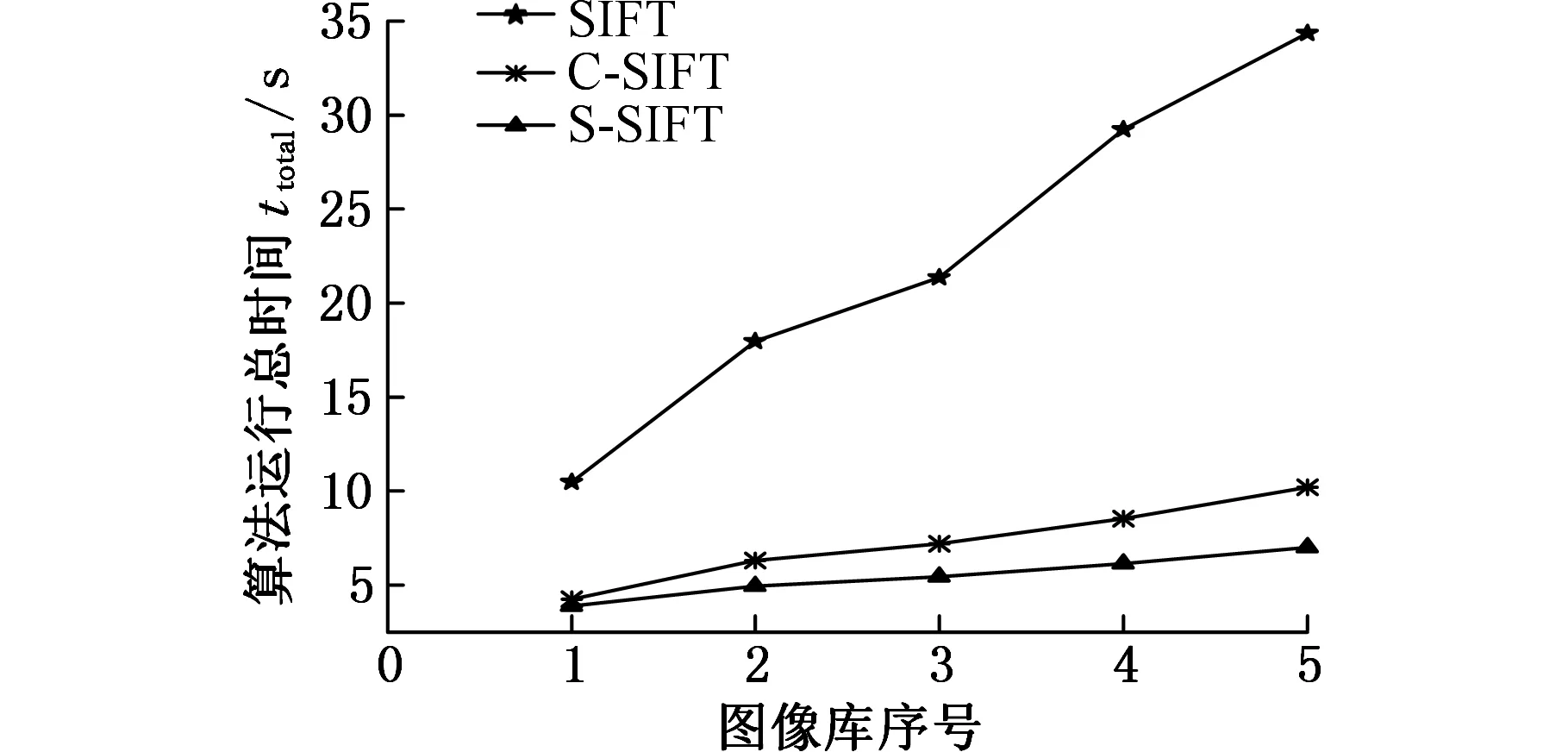

为了验证本文所提出的基于全局特征和局部特征的图像分级匹配算法的优势,构建5个分别由4幅、8幅、12幅、16幅、20幅环境图像组成的图像库,依次利用原始SIFT算法、基于颜色矩的改进SIFT图像匹配算法(该算法首先根据颜色矩将图像库进行排序,再由基于Sobel算子和迭代搜索的改进SIFT算法对排序后的图像序列进行精确匹配)、本文算法进行图像匹配。每组实验均进行10次,然后取平均值作为实验结果。实验结果如图11所示。其中,SIFT代表原始的SIFT算法,C-SIFT代表基于颜色矩的改进SIFT图像匹配算法,S-SIFT即本文提出的基于全局特征和局部特征的图像分级匹配算法。

(a)匹配总时间

(b)平均匹配正确率图11 SIFT、C-SIFT和S-SIFT在不同图像库的性能对比

移动机器人在基于拓扑地图导航过程中,应用本文所提出的图像匹配算法,在时间和匹配正确率方面均优于上述两种算法。随着图像库中图像数量增加,三种算法的运行总时间均增加,平均匹配正确率均下降。但本文所提出算法运行总时间上升趋势缓慢且运行速度较快,平均匹配正确率保持在90%以上。

3 结语

针对移动机器人基于拓扑地图导航时对图像特征提取与匹配算法的要求,提出了图像分级匹配算法,将基于全局特征的改进形状上下文算法和基于局部特征的改进SIFT算法相结合,实现了拓扑地图节点的识别,最终实现机器人基于拓扑地图的导航。实验结果表明该算法在基于图像匹配的移动机器人导航研究中是有效的。

[1]王殿军.双目视觉在移动机器人定位中的应用[J].中国机械工程,2013,24(9):1155-1158.

Wang Dianjun. Application on Binocular Vision System of a Mobile Robot[J]. China Mechanical Engineering,2013,24(9):1155-1158.

[2]陈卫东,张兴家,朱奇光,等. 基于混合特征的移动机器人图像匹配算法[J]. 中国机械工程, 2015,26(9): 1137-1141.

Chen Weidong, Zhang Xingjia, Zhu Qiguang, et al. An Image Matching Algorithm for Mobile Robot Localization Based on Hybrid Features[J]. China Mechanical Engineering, 2015, 26(9): 1137-1141.

[3]刘佳, 傅卫平, 王雯,等. 基于改进SIFT算法的图像匹配[J]. 仪器仪表学报, 2013, 34(5):1107-1112.

Liu Jia,Fu Weiping, Wang Wen, et al. Image Matching Based on Improved SIFT Algorithm[J]. Chinese Journal of Scientific Instrument, 2013, 34(5):1107-1112.

[4]Lowe D G. Distinctive Image Features from Scale- Invariant Keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[5]Lu B, Whangbo T K. A SIFT-Color Moments Descriptor for Object Recognition[C]// 2014 International Conference on IT Convergence and Security (ICITCS). Beijing, 2014:1-3.

[6]陈抒瑢, 李勃, 董蓉,等. Contourlet-SIFT特征匹配算法[J].电子与信息学报, 2013,35(5): 1215-1221.

Chen Shurong, Li Bo, Dong Rong, et al. Contourlet-SIFT Feature Matching Algorithm[J]. Journal of Electronics & Information Technology, 2013,35(5): 1215-1221.

[7]Zhong Jinqin, Tan Jieqing, Gu Lichuan. SIFT Feature Matching Algorithm with Local Shape Context [J]. International Journal of Applied Mathematics & StatisticsTM, 2013, 46(16):93-101.

[8]高晶, 吴育峰, 吴昆,等. 基于角点检测的图像匹配算法[J]. 仪器仪表学报, 2013, 34(8): 1717-1725.

Gao Jing, Wu Yufeng, Wu Kun, et al. Image Matching Method Based on Corner Detection[J]. Chinese Journal of Scientific Instrument, 2013, 34(8):1717-1725.

[9]周瑜, 刘俊涛, 白翔. 形状匹配方法研究与展望[J]. 自动化学报, 2012, 38(6):889-910.

Zhou Yu, Liu Juntao, Bai Xiang. Research and Perspective on Shape Matching[J]. Acta Automatica Sinica, 2012, 38(6):889-910.

[10]鲍文霞, 梁栋, 程志友,等. 一种基于图理论的非刚体形状匹配算法[J]. 仪器仪表学报, 2009, 30(10):2027-2032.

Bao Wenxia, Liang Dong, Cheng Zhiyou,et al. Graph Theory Based Non-rigid Shape Matching Algorithm[J]. Chinese Journal of Scientific Instrument, 2009, 30(10):2027-2032.

[11]史思琦. 基于轮廓特征的目标识别研究[D].西安:西安电子科技大学, 2012.

[12]李洪波. 基于减法聚类和快速紧密性函数的 SF-FCM[J]. 控制与决策, 2011, 26(7): 1074-1078.

Li Hongbo. SF-FCM Based on Fast Close Function and Subtractive Clustering[J].Control and Decision, 2011, 26(7): 1074-1078.

[13]Alitappeh R J, Saravi K J, Mahmoudi F. Key Point Reduction in SIFT Descriptor Used by Subtractive Clustering[C]// Information Science, Signal Processing and their Applications (ISSPA), 11th International Conference on IEEE. Montreal, 2012:906 - 911.

[14]毋立芳, 侯亚希, 周鹏,等. 基于最大位平均熵的SIFT描述子二值化及相似度匹配方法[P]. 中国专利: 103617431A, 2014-03-05.

[15]Belongie S J, Malik J, Puzicha J. Shape Matching and Object Recognition Using Shape Contexts[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(4):509-522.

[16]Haibin L, Jacobs D W. Shape Classification Using the Inner-distance[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2007, 29(2):286-299.

(编辑卢湘帆)

InvestigationandApplicationonImageHierarchicalMatchingAlgorithmBasedonGlobalFeatureandLocalFeature

ZhuQiguang1,2WangZiwei1ChenYing3

1.YanshanUniversity,Qinhuangdao,Hebei,066004 2.TheKeyLaboratoryforSpecialFiberandFiberSensorofHebeiProvince,Qinhuangdao,Hebei,066004

Aimingattheproblemsthattheimagefeatureextractionandmatchalgorithmshouldhavehighaccuracy,goodperformanceinreal-timeandrobustnesswhenthemobilerobotnavigatedbasedontopologicalmap,thepaperproposedanewimagehierarchicalmatchingalgorithmbasedontheglobalfeatureandlocalfusion.First,theimprovedshapecontextalgorithmwasappliedtotheinputimagestobematchedtoextracttheglobalfeatureswhichwerematchedroughlywiththeimagesinthedatabase,obtaining3imagesthathadthehighestsimilaritytothecurrentimagewhichconstitutedatemporaryimagedatabase.Then,theimprovedSIFTalgorithmwereusedtoextractlocalfeatureoftheinputimageswhichwerematchedaccuratelywiththelocalfeatureofthe3imagesinthetemporaryimagedatabase,finallyobtainingtheimagewithhighestsimilarityasthematchresults.TheimagehierarchicalmatchingalgorithmbasedontheglobalfeatureandlocalfeaturecombinedtheimprovedshapecontextalgorithmbasedonglobalfeaturesandtheimprovedSIFTalgorithmbasedonlocalfeatures,soastoachievethepurposeofcomplementaryadvantages.Theexperimentalresultsshowthatthisalgorithmcaneffectivelyimprovethematchingefficiencyandreducetherunningtimewhenthemobilerobotsnavigatebasedontopologicalmap.

mobilerobot;imagematching;improvedshapecontext;improvedSIFT

2016-04-22

国家自然科学基金资助项目(61201112);河北省自然科学基金资助项目(F2016203245);河北省普通高等学校青年拔尖人才计划资助项目(BJ2014056)

TP391

10.3969/j.issn.1004-132X.2016.16.015

朱奇光,男,1978年生。燕山大学信息科学与工程学院副教授。主要研究方向为机器人智能控制及应用。发表论文30余篇。王梓巍,男,1992年生。燕山大学信息科学与工程学院硕士研究生。陈颖,女,1980年生。燕山大学电气工程学院教授。