目标驱动的显著性检测算法

2016-07-18殷世琼齐美彬

殷世琼,齐美彬

(合肥工业大学 计算机与信息学院,安徽 合肥 230009)

目标驱动的显著性检测算法

殷世琼,齐美彬

(合肥工业大学 计算机与信息学院,安徽 合肥230009)

摘要:现有的显著性检测算法主要是由数据驱动的,是通过底层特征来检测能吸引用户注意的所有显著性区域,而在具体的图像理解过程中,用户往往关注某一种或几种特定目标。文章提出了一种目标驱动的显著性检测算法,得到用户感兴趣的显著性区域。该算法是用图像中像素点与目标图像的平均色之间的差异来表示单个像素点的显著值。结果表明,目标驱动显著性检测算法可以快速地检测出与目标图像相似的显著目标。

关键词:生物视觉机制;目标驱动;显著性检测

0引言

人类的视觉可以很容易地分辨出视野中的重要信息,由此可以通过检测图像中的显著性区域来优先分配分析和处理图像所需的资源,以简化处理图像信息的工作量,并提高处理图像的准确性。因此,针对互联网上日益增长的图像资源,对图像进行显著性检测的意义重大。检测后的结果可以广泛应用于图像分割、目标识别、自适应压缩和图像检索等多种计算机视觉领域。

显著性检测(saliency detection)算法主要是检测图像中的显著性区域。图像显著性目前还没有较为明确的定义,可以抽象地理解为显著性区域就是图像中视觉关注的焦点、人眼较为感兴趣区域,或者是局部视觉明显的区域等。一般来说,这些区域是图像中能够代表整幅图像主要信息的区域。图像的显著性本身是一个相对的概念,为了衡量图像的显著性,文献[1]提出了显著特征图(saliency map),简称显著图。显著图是一个表征图像视觉关注区域的二维分布,其中灰度值越大,则表示该区域的显著性越强,更能吸引人眼视觉注意。

众所周知,人类的注意过程可分为吸引注意(attract attention)的预注意过程和人主观加以关注(pay attention)的集中注意过程2种模式。在人类的实际观察过程中,这2种模式是同时存在、相互作用的,它们共同成就了人类的观察能力。

文献[1-2]将视觉机制分为快速的、下意识的、自底向上的、数据驱动的显著性提取和慢速的、目标依赖的、自顶向下的、目标驱动的显著性提取。但在实践中,目前大多数视觉注意计算模型主要集中在自下而上方面,尚缺乏目标驱动注意(即自上而下注意)的计算[3]。

本文提出了一种目标驱动显著性检测(target-driven saliency detection,TD)算法,该算法参考人类主观加以关注的集中注意力的过程,由用户选定目标图像,决定显著值的评价标准,然后基于生物视觉机制选取特征,用全局对比来计算显著图。由此可以筛选出更加符合用户主观选择的显著区域,从而可以进一步筛选图像资源。

1相关工作

本文算法主要关注基于视觉特征的显著性分析算法,该类算法大多是基于生物视觉形成机制,利用亮度、颜色、边缘[4]等底层特征属性来分析图像的显著性。基于生物视觉机制的显著性算法可以宽泛地分为局部和全局2大类。

基于局部对比度的方法利用了图像区域相对于局部邻域的稀有度。文献[1]提出了非常有影响力的生物启发模型。在此基础上,文献[2]利用多尺度图像特征的中心-外周拮抗的差异,定义了经典的图像显著性区域计算模型。文献[5]提出了基于图的视觉显著性检测算法,将文献[2]算法计算的显著图和其他显著图结合后,再进行归一化处理,然后得到图像的显著区域。这类算法可以较为准确地检测出显著区域所在的大致位置,但是该类方法倾向于在边缘处产生高显著性,故而得到的显著图较为模糊。

此外,基于全局对比度的显著性区域计算方法是对整副图像来计算图像的显著性。文献[6]定义了基于某个像素和其余像素点对比度的像素级的显著性。文献[4]提出了用某个像素和整个图像的平均色的色差来定义显著值。文献[7]提出了基于直方图对比度和基于局域对比度的显著性检测方法,简单高效地得到图像显著图。该类方法计算的显著图较为清晰,据此分割出的区域包含的非相关信息较少。

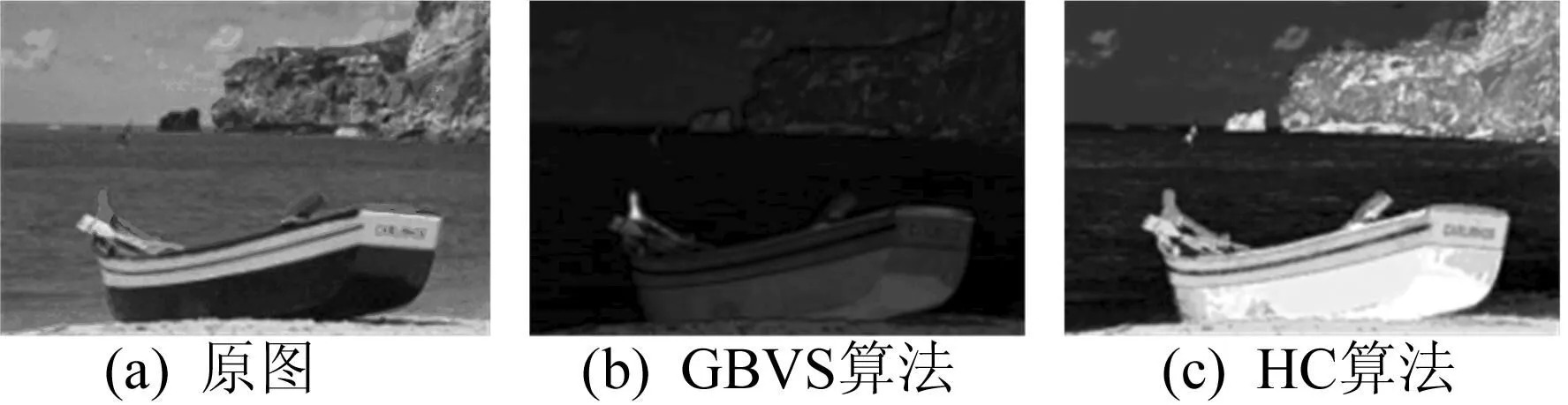

上述算法都属于快速的、下意识的、自底向上的、数据驱动的显著性检测算法。而在实际应用中,用户的主观选择对于显著性检测也有很重要的影响,由底层特征自发地检测出的吸引注意的显著区域,未必就符合用户的需求,如图1所示。图1中,GBVS算法为基于图形的视觉显著性算法,HC算法为基于直方图的对比算法。

图1 不同数据驱动算法计算的显著图

由图1可知,2种算法计算出的显著图,其结果均判定海滩上船只或海中央突出的崖壁较为显著,然而用户关注的区域可能是碧蓝壮阔的大海,对于海面上的物体会主观性地选择忽略。这种数据驱动的算法检测出的区域在用户主观上反而是非显著区域,这将极大地影响后续的图像处理。

因此本文参考人类主观加以关注的集中注意力的过程,提出了一种目标驱动的显著性检测算法。

2目标驱动的显著性检测算法

本文提出的目标驱动的显著性检测算法参考了生物视觉机制,基于全局对比度计算显著性区域。该算法先学习目标图像的亮度和颜色特征值作为计算像素显著值的评判标准;然后计算测试图像每个像素点与目标图像的平均色之间的差异,得到目标驱动的显著图。检测流程如图2所示。

图2 目标驱动的显著性检测算法流程

2.1视觉特征选择

生物视觉在目标图像理解中被广泛应用[8],生物视觉相关研究认为,视觉系统对视觉信号的对比度很敏感。文献[9]的实验证明了人眼视觉系统接收彩色图像信息后,最终转换至DKL空间[10]。而在DKL空间内,图像信息会被分解为亮度(lum)通道、红绿(red-green)通道和黄蓝(yellow-blue)通道3个通道。

本文选择在最接近人类视觉的L*a*b*色彩空间下计算像素间的差值。该颜色空间是一种颜色-对立空间,其中,维度L(L*)表示颜色的亮度L*∈[0,100],L*=0表示黑色,而L*=100表示白色;a和b则表示颜色对立维度,a*,b*∈[-128,127],a*代表红色(或品红色)和绿色通道,a*若为负值则表示绿色,若为正值则表示红色,b*代表黄色和蓝色通道,b*若为负值则表示蓝色,若为正值则表示黄色。

2.2计算目标图像的平均色

目标驱动的显著性检测算法需要先学习目标图像的特征,选用特征表征目标图像非常重要。本文算法基于图像的颜色统计特征计算图像像素的显著值。具体来说,就是一个像素的显著值用它和目标图像平均色的差值来表征。因此,本文先计算目标图像的平均色I0,即对目标图像IT求平均,具体公式为:

I0=means(IT)

(1)

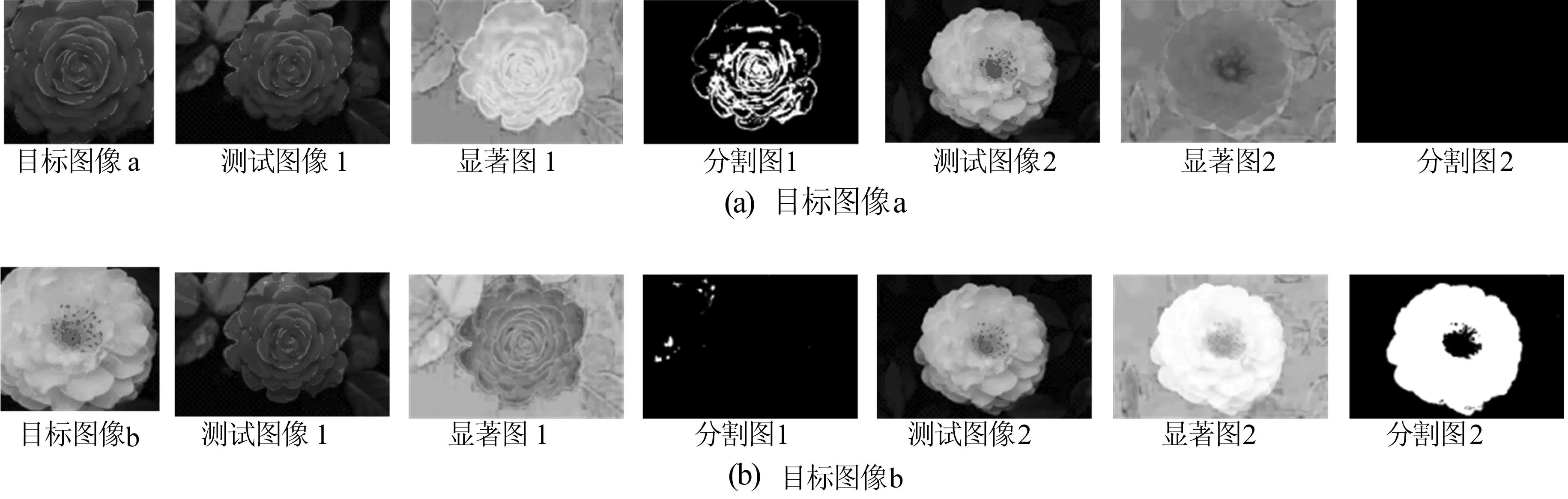

为了减少目标图像中所包含的背景信息对检测结果的影响,本文在计算目标图像的平均色I0时,需要先对目标图像进行预处理。输入目标图像,对该图像进行简单的分割后建立对应的模板图像,如图3所示。

图3 目标图像及对应的模板图像

由图3可知,若模板图像中某像素点显示白色,则在目标图像中对应位置的像素点为前景像素。反之,若模板图像中某像素点显示黑色,则在目标图像中对应位置的像素点为背景像素,该像素点的图像信息不加入计算。依据上述划分,在L*a*b*色彩空间中计算均值。目标图像的统计直方图如图4所示,由图4可以看出,在计算目标图像的平均色时,目标在单个通道上的统计直方图中会集中分布在某峰值附近。

图4 目标图像的统计直方图

对于代表目标图像的特征值,可以选用单通道统计直方图中峰值附近的3组数据加权平均表征该通道特征值,以进一步集中表示目标图像的特征值。

对于较为复杂的图像,可以采用混合高斯模型求取特征值。

2.3计算目标驱动的显著图

图像I中像素Ik的显著值S(Ik)定义为:

(2)

其中,I0为目标图像的平均色;D(Ik,I0)为像素Ik和目标图像的平均色I0在L*a*b*空间下的距离度量,具体计算公式为:

(3)

(4)

(5)

(6)

其中,D(Lk,L0)为L分量的显著值;maxL为L*分量内的最大值;minL为L*分量内的最小值;D(ak,a0)为a分量的显著值;maxa为a*分量内的最大值;mina为a*分量内的最小值;D(bk,b0)为b分量的显著值;maxb为b*分量内的最大值;minb为b*分量内的最小值。

为了在阈值分割时能够更精确分离显著的像素点和非显著的像素点,本文在计算像素点显著值时,选择每幅图像实际的各分量的最值作为计算像素特征差异的参数。即(4)~(6)式中,max与min均为测试图像实际计算出的| Lk-L0|、| ak-a0|、| bk-b0|的取值区间的最值,而非直接代入其理论最值。

直接代入各分量理论最值计算的结果如图5a所示,即取maxL-minL=100,maxa-mina=255,maxb-minb=255计算的显著图。归一化处理后得到的结果如图5b所示,由图5b可以看出,得到的结果更能区分显著像素点和非显著像素点。

很明显,图像I中的像素Ik若与目标图像的平均色I0越相似,差异越小,该像素的显著值就越大;反之,像素Ik若与目标图像的平均色I0的差异越大,其显著值就越小。由此可得到目标驱动的基于全局对比度的图像显著图。

图5 选择不同最值计算显著图的效果

3实验数据与分析

本文实验在Matlab 2012a平台上进行,计算机配置为Intel i5-4200U双核处理器及4 G内存,系统为32位Win7系统。

在corel标准测试集上测试本文算法模型。该图像集共有10类图像,每类有100幅图像,随机选取图像作为目标图像,在测试集中检测出与目标图像最相近的图像。算法的部分实验结果如图6所示。

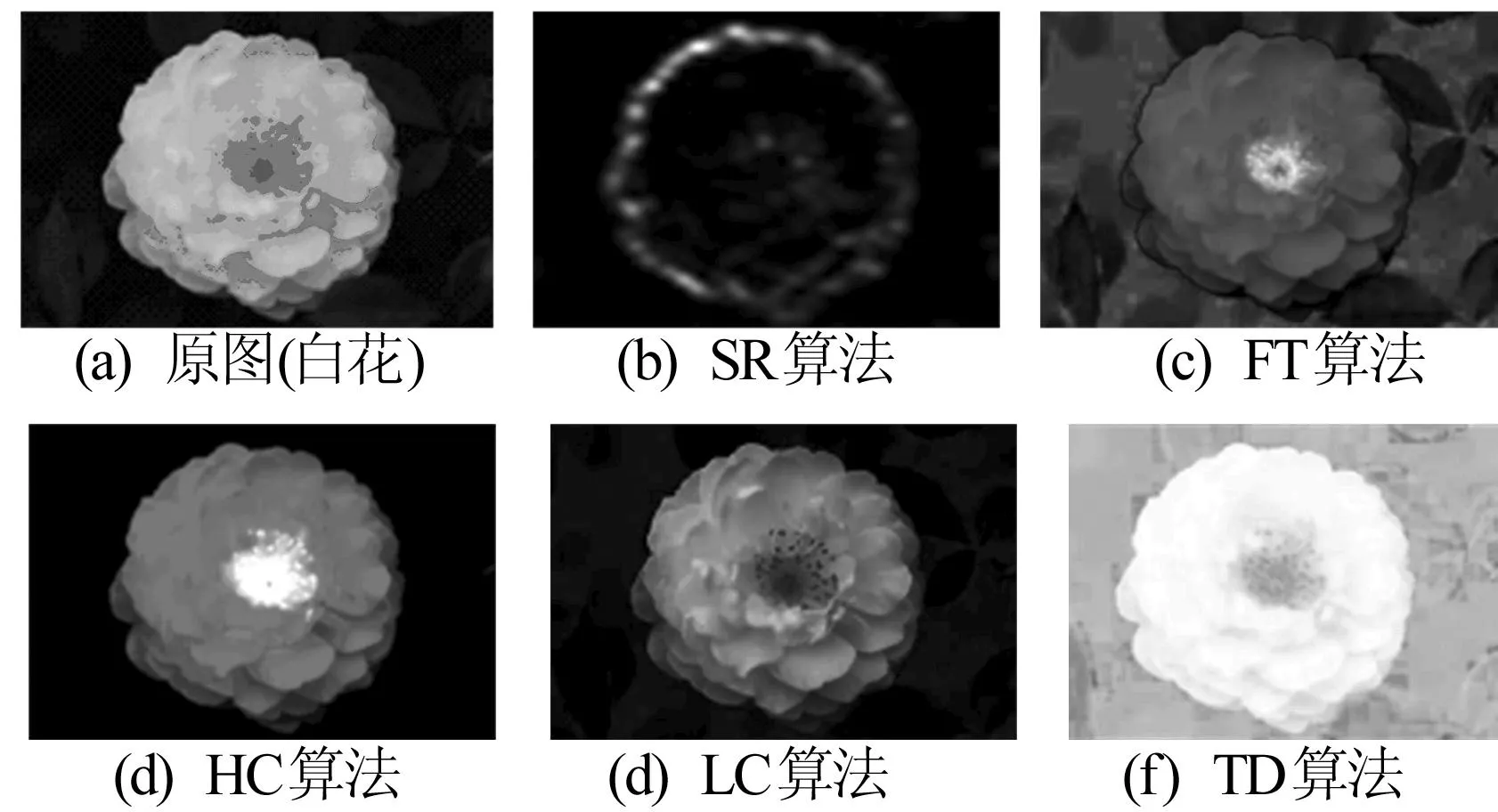

图6 基于目标图像的TD显著图和分割图

由图6可以看出,对于同一副图像,由于目标图像不同,主观加以关注的显著区域不同,计算得到的显著图也不同。数据驱动的几种显著性检测算法和本文检测算法的检测结果如图7、图8所示。图7中,SR算法为谱残算法;FT算法为频率调谐凸区域检测算法。

由图7、图8可知,虽然两幅图中都检测到了花朵的位置,但是几种算法检测出红色花朵的显著性要比白色花朵显著性高;在关注白色花朵时,由本文算法检测出的显著性远大于红色花朵,从而赋予了每个像素点带有主观性的显著值。

本文算法与其他算法在corel标准测试集上计算的平均用时见表1所列。表1中,CA算法为上下文感知的显著性检测算法;GB算法为基于图形的视觉显著性算法。

图7 数据驱动的显著性检测算法与本文算法实验结果1

图8 数据驱动的显著性检测算法与本文算法的实验结果2

算法t/s代码类型IT算法[2]0.611MatlabGB算法[5]1.614MatlabSR算法[11]0.064MatlabFT算法[4]0.016C++HC算法[7]0.019C++CA算法[12]53.100MatlabTD算法0.067Matlab

4结束语

本文依据生物视觉机制和全局对比度显著性分析算法原理,融合先验知识,提出了一种目标驱动的视觉显著性检测算法,该算法能够依据用户的主观意愿,快速检测出与用户主观上加以关注的目标相似的显著性区域,从而有利于对图像资源进行有选择的筛选。但是,目标图像本身包含各种信息,本文算法只用了简单的亮度和颜色对比的视觉特征来表述目标图像,在检测图像显著性区域时,对于不同类别的图像存在误检现象。因此下一步将采用多种目标表述方式,检测出更加符合主观意愿的显著图。

[参考文献]

[1]Koch C,Ullman S.Shifts in selective visual attention:towards the underlying neural circuitry[J].Human Neurobiology,1985,4(4):219-227.

[2]Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[3]黎万义,王鹏,乔红.引入视觉注意机制的目标跟踪方法综述[J].自动化学报,2014,40(4):561-576.

[4]Achanta R,Hemami S,Estrada F,et al.Frequency-tuned salient region detection[C]//IEEE Conference on Computer Vision and Pattern Recognition,2009:1597-1604.

[5]Harel J,Koch C,Perona P.Graph-based visual saliency[C]//Proceedings of the Twentieth Annual Conference on Neural Information Processing System,2006:545-552.

[6]Zhai Y,Shah M.Visual attention detection in video sequences using spatiotemporal cues[C]//Proceedings of the 14th ACM International Conference on Multimedia,2006:815-824.

[7]Cheng M M,Zhang G X,Mitra N J,et al.Global contrast based salient region detection[C]//IEEE Conference on Computer Vision and Pattern Recognition,2011:409-416.

[8]宋皓,徐小红.基于生物视觉通路的目标识别算法[J].合肥工业大学学报:自然科学版,2012,35(4):481-484.

[9]King-Smith P E,Grisby S S,Vingrys A J,et al.Efficient and unbiased modifications of the QUEST threshold method:theory,simulations,experimental evaluation and practical implementation[J].Vision Research,1994,34(7):885-912.

[10]Derrington A M,Krauskopf J,Lennie P.Chromatic mechanisms in lateral geniculate nucleus of macaque[J].Journal of Physiology,1984,357(1):241-265.

[11]Hou X,Zhang L.Saliency detection:a spectral residual approach[C]//IEEE Conference on Computer Vision and Pattern Recognition,2007:1-8.

[12]Goferman S,Zelnik-Manor L,Tal A.Context-aware saliency detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(10):1915-1926.

(责任编辑闫杏丽)

Target-driven saliency detection method

YIN Shi-qiong,QI Mei-bin

(School of Computer and Information,Hefei University of Technology,Hefei 230009,China)

Abstract:The existing saliency detection methods are mainly driven by data,and detect all the salient regions which can attract users’ attention by low-level features. However,the users always pay attention to one or several kind of targets in the specific image understanding process. In this paper,a target-driven saliency detection method is proposed to get the salient regions that users are interested in. The pixel saliency is defined by using a pixel’s color difference from the average image color of the target image. The experimental results demonstrate that the proposed method can quickly detect the salient object that is similar to the target image.

Key words:biological visual system;target driven;saliency detection

收稿日期:2015-03-09

基金项目:国家自然科学基金面上资助项目(61371155);安徽省科技攻关计划资助项目(1301b042023)

作者简介:殷世琼(1990-),女,安徽肥东人,合肥工业大学硕士生; 齐美彬(1969-),男,安徽东至人,博士,合肥工业大学教授,硕士生导师.

doi:10.3969/j.issn.1003-5060.2016.06.010

中图分类号:TP391

文献标识码:A

文章编号:1003-5060(2016)06-0767-05