一种高效低时延的多视点分布式视频编码

2015-10-24郭继昌巩家昌

郭继昌,许 颖,巩家昌

(天津大学电子信息工程学院,天津 300072)

一种高效低时延的多视点分布式视频编码

郭继昌,许 颖,巩家昌

(天津大学电子信息工程学院,天津300072)

分布式视频编码是一种可以将编码端复杂度转移到解码端的视频编码方式.多视点分布式视频编码在视点内部大都采用运动补偿内插法来降低时间冗余,但是因为运动补偿内插法的解码顺序与视频顺序不一致,从而导致视频解码出现时延.因此,基于运动补偿外推法提出了一种高效低时延的多视点分布式视频编解码方法.此外,一般运动补偿外推法的重构质量要低于运动补偿内插法.在使用运动补偿外推法降低时间冗余的基础上,使用视差矢量内插法降低视点间冗余,经过融合算法提高重构质量.实验证明,所提出的这种高效低时延的多视点分布式视频编码,在重构质量相当的情况下,解码时间降低了0.3,s.

分布式视频编码;多视点;低时延;运动补偿外推法;重构质量

分布式视频编码(distributed video coding,DVC)是1976年由Slepian和Wolf[1]、Wyner和Ziv[2]以信息编码理论方式提出的,典型的编码算法有斯坦福大学提出的Wyner-Ziv视频编码[3]、加州大学伯克利分校提出的PRISM视频编码[4]以及欧洲DISCOVER组提出的DISCOVER视频编码[5].这些分布式视频编码都是在编码端对各个视频帧进行独立编码,编码方式类似于传统的帧内编码.在解码端,利用相邻解码帧之间时域的高度相关性,对解码帧进行运动估计,通过运动补偿插值法获得边信息,然后利用边信息和从编码端传送过来的辅助校验信息进行解码,最后获得高质量的重构帧.

针对多视点分布式视频编码,Ouaret等[6]和Guo等[7]提出的多视点分布式视频编码系统中,视点分为关键视点和非关键视点,仅非关键视点采用DVC编解码方法,没有充分利用多个视点间的相关性;Huang等[8]提出的多视点分布式视频编码系统中,视点也分为关键视点与非关键视点,在非关键视点内部通过外推法获得边信息,虽然没有充分利用视点间的相关性,但在一定程度上降低了系统时延;Kodavalla等[9]提出的多视点分布式视频编码中,时间边信息的获取是通过运动补偿内插法(MCI),系统存在一定的解码时延;武晓嘉等[10]提出了一种多视点立体视频分布式压缩感知编解码模型,这种模型可以利用压缩感知降低采样率,利用分布式信源编码将编码端的复杂度转移到解码端.但在这种模型中,非关键帧的时间边信息采用运动补偿内插法,在解码端产生一定的解码时延.

笔者提出的多视点分布式视频编码是基于DISCOVER结构的,编码端独立编码,解码端联合解码.在解码端采用运动补偿外推法(MCE)来降低时间冗余,且运动补偿外推法的解码顺序与显示顺序一致,大大降低了视频的解码时延.在视点间采用视差矢量内插法来降低视点间冗余,经过融合算法,提高了重构帧质量.总之,这种高效低时延的多视点分布式视频编码方法,采用运动矢量外推法降低解码时延,采用边信息融合算法提高视频的重构质量.在重构质量有限降低的情况下,大大降低了系统时延.

1 运动补偿内插法存在的问题

运动补偿内插法[11-13]是一种获取时间边信息的有效方法,但是它存在一个很大的缺陷,即它的解码顺序与显示顺序不一致.图1是单个视点GOP=9时的解码顺序示意.

图1 单个视点GOP=9的解码顺序示意Fig.1 Sketch map of monoview GOP=9 decoding order

如图1所示,这个视频的显示顺序是从左至右的,两端的帧(关键帧,K帧)为已解码帧,视频的解码顺序是:1号、2号帧通过运动补偿内插法内插得到3号帧的时间边信息,解码重构3号帧;然后3号帧(非关键帧,WZ帧)作为已解码帧,与1号帧内插得到4号帧的时间边信息,解码重构4号帧;1号帧与4号帧内插得到5号帧的时间边信息,解码重构5号帧,以此类推.帧内的标号是采用运动补偿内插法解码的顺序.

运动补偿内插法采用双向运动估计、运动补偿,所以通过运动补偿内插法得到的时间边信息质量比运动补偿外推法高一些.但是这是以牺牲解码时延为代价的,解码时延包括传输时延和解码关键帧的时延.

2 多视点分布式视频编码系统

图2是基于DISCOVER结构[5]的多视点分布式视频编码系统框图,编码端首先将各视点中的视频序列分为两类.一类称为关键帧(K帧),采用传统的H.264/AVC(类似I帧)进行编码和解码重构.另一类称为非关键帧(WZ帧),WZ帧采用分布式视频编码方法对其进行编码:首先,将每一个WZ帧进行基于块的DCT变换,将变换后的系数进行量化;然后按照量化系数进行比特面排序后送到信道编码器中,进行信道编码产生校验比特;最后编码器部分将校验比特发送到解码端.在解码端,首先通过H.264/AVC对K帧解码重构;根据已经解码的前2个K帧通过运动补偿外推法生成时间边信息,并根据与之相邻的2个视点的K帧经过视差矢量内插法获得视点间边信息,将视点间边信息与时间边信息进行融合获得最终的融合边信息;将边信息和原始WZ帧的差异看作是虚拟信道中的相关噪声,利用Laplacian模型能够很好地估计残差的分布;接下来采用和编码端相同的变换方法对边信息依次进行反量化,得到WZ帧变换系数的估值;利用虚拟噪声模型计算出信息比特送入信道解码器,信道解码器根据编码端传过来的校验比特对边信息进行校验;然后根据虚拟信道模型和边信息系数实现非关键帧重构,最后通过IDCT变换得到WZ帧,和已解码K帧一起通过多路复用得到最终解码视频流.

图2 多视点分布式视频编码系统示意Fig.2 Multi-view distributed video coding system diagram

3 边信息生成

3.1 时间边信息

在同一个视点内部,帧与帧之间具有极高的相似性,在3个连续的帧中,物体的运动基本位于一条直线上.因此,WZ帧中的时间边信息可以通过运动补偿外推法获得,参考帧是当前帧的前2帧.笔者采用的运动补偿外推法有以下2个步骤.

(1)通过参考帧进行运动估计.

通过参考帧进行的运动估计是运用3DRS算法[14]进行运动匹配的,选择这种算法的原因是可以运用特征点计算运动矢量,从而可以预测一个运动区域,使得在运动物体边界部分不会出现重影.记Xt和Yt分别表示第n个视点t时刻的帧信息、解码端解码出的边信息.记t-2和t-1为已解码的前2帧信息.

记X帧中位置(x,y)的像素值为X(x,y),mv(xi,yi)是由t-2帧中位置(xi,yi)处指向t-1帧的运动矢量.随后运动矢量通过一个加权矢量中值滤波器[15]进行平滑处理.记S={mv(xi,yi),i=1,2,…,M};M表示候选运动矢量的个数.

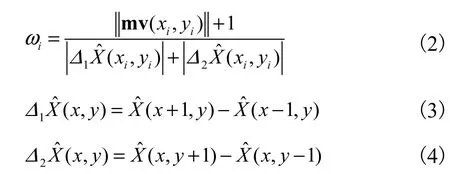

式中iω为候选运动矢量的权重,iω的计算式为

式中Δ1(xi,yi)、Δ2(xi,yi)分别表示帧的像素位置(xi,yi)的横向、纵向梯度的一范数.

式(2)中分子加1是为了防止出现mv(xi,yi)为0时,导致式(1)恒为0,不能达到选择候选运动矢量的目的.

(2)基于运动矢量的外推法得到当前帧.

因为帧间的时间相关性较大,在相邻帧中运动物体可以认为是在一条直线上运动,可以由已经解码的前两帧根据式(1)中求得的运动矢量解码出t时刻帧的时间边信息为

式中mvx、mvy分别为运动矢量mv的横向分量、纵向分量.

运动补偿外推法如图3所示.

图3 运动补偿外推法Fig.3 Motion compensation extrapolation method

3.2视点间边信息

多视点视频序列中含有大量的冗余数据,在多视点视频系统中,视点间边信息的生成主要依赖于视点间的相关性,视点间边信息通过视差矢量内插法获得.经过视差补偿预测[16-18],获得视差矢量MV.视点间边信息获得如图4所示.定义I[ n,t,x,y]表示第n个视点在t时刻所在帧中(x,y)位置处的像素值,则第n个视点的像素值可以通过已解码的第n-1和n+1个视点内插得到,即

式中:MVl,x、MVl,y分别为左视点到中间视点视差矢量MVl的横向分量、纵向分量;MVr,x、MVr,y分别为右视点到中间视点视差矢量MVr的横向分量、纵向分量.则第n个视点t时刻帧的视点间边信息为

图4 视差矢量内插法Fig.4 Disparity vector interpolation method

3.3边信息融合

WZ帧中最好的边信息是指预测最准确的边信息.在不同运动场景下时间边信息与视点间边信息的重构质量不同,在运动剧烈的情况下视点间边信息的重构效果好,运动平缓的情况时间边信息的重构效果好,如果能够充分利用两种边信息的优点,将两种边信息进行融合,可以大大提高WZ帧的重构质量.

假设GOP=2,笔者提出的多视点分布式视频编码的帧排列方式如图5所示.

中间视点(2号视点)的WZ帧的视点间边信息通过视差矢量内插法由左右视点(1号视点、3号视点)内插获得,时间边信息通过中间视点内部已解码的前两帧通过运动补偿外推法获得.当前帧可以通过融合函数将视点间边信息与时间边信息进行融合,笔者所提的边信息融合算法是参照文献[19]进行改进的.

图5 多视点视频编码的帧排列方式Fig.5 Multiview video coding frame arrangement

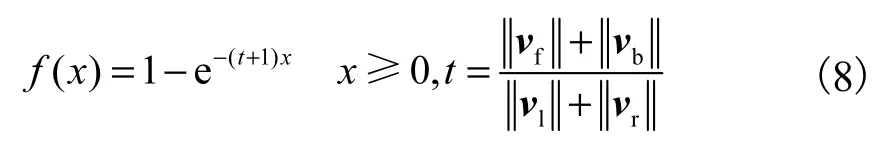

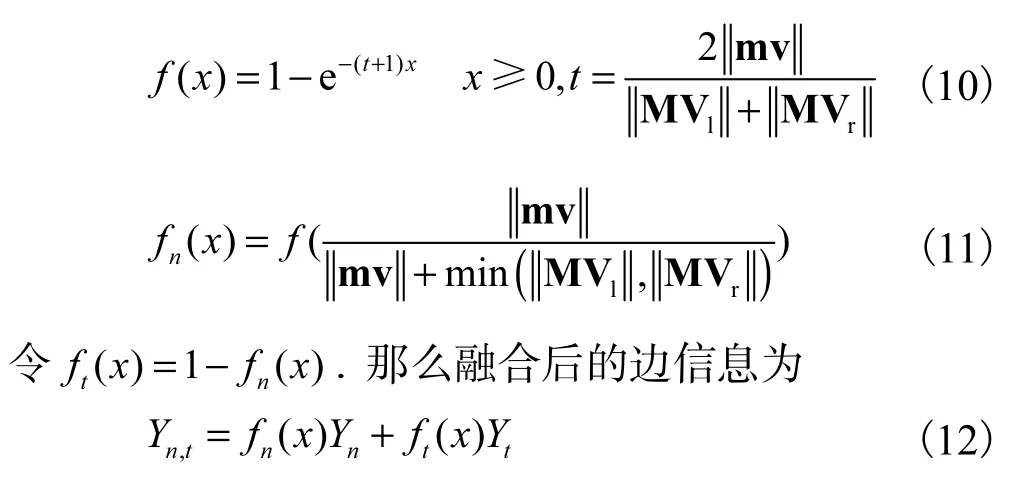

[19]中的融合函数为

定义

式中:vf和vb分别为前向、后向运动矢量;vl和vr分别为左、右视差矢量.

因为本文在视点内部采用运动补偿外推法获取时间边信息,只有一个方向的运动矢量,且在运动剧烈视频中视点间边信息质量相对较好,所以希望视点间边信息在融合边信息中所占的比例大一些,因此选择f(x)(随着x的增大,f(x)无限接近于1)作为视点间边信息的权重.记视点间边信息为Yn,时间边信息为Yt,mv为运动矢量,MVl和MVr分别为左、右视点到中间视点的视差矢量,第n个视点在t时刻的融合后的边信息为Yn,t.

改进的融合函数为

图6是根据所提的边信息生成方法对“Breakdancers”标准序列中cam1第6帧的重构结果. 由图6可以看出,时间边信息中运动较剧烈的中间部分重构质量较差,运动平缓的边缘部分重构质量较好;视点间边信息中运动剧烈的边缘中间部分重构质量较好,运动平缓的边缘部分重构质量较差;融合边信息重构图像的整体质量有所提高.

图6 多视点分布式视频编码的边信息重构结果Fig.6Side information reconstruction results map based on multi-view distributed video coding

4 仿真结果

4.1运动补偿外推法与运动补偿内插法的解码时间比较

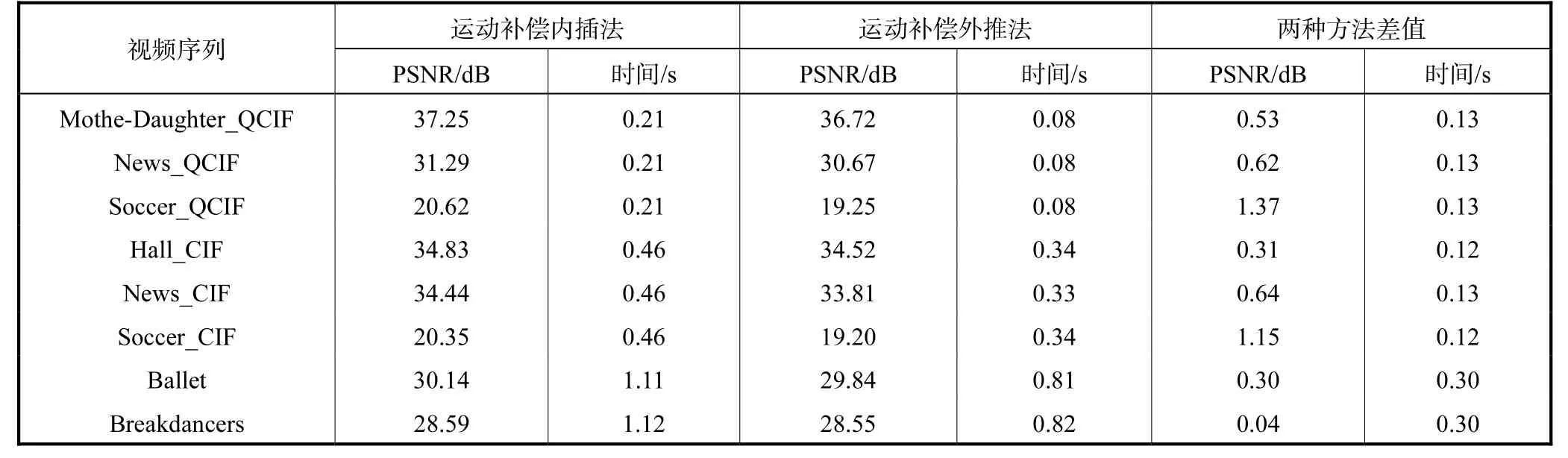

笔者提出的基于运动补偿外推法的多视点分布式视频编码系统的目的是在保证重构质量有限降低的情况下,尽可能多地降低系统的解码时延.为了验证所提的运动补偿外推法比运动补偿内插法的解码时延短,进行了一系列针对WZ帧的解码时间的仿真实验.分别选择3个QCIF标准视频序列(“Mother-Daughter”、“News”、“Soccer”)、3个CIF标准视频序列(“Hall”、“News”、“Soccer”)和2组3视点视频序列(“Ballet”、“Breakdancers”)的前50帧进行解码时间的比较,为了降低整体的运行时间,将2组3视点视频序列降维到512×384.实验用计算机主要参数为:Intel(R)core(TM)i5-2400,CPU@3.10,GHz 3.09,GHz.实验结果如表1所示.

由表1可以看出,采用运动补偿外推法的WZ帧的重构质量均略低于采用运动补偿内插法的重构质量.但在解码时间上,QCIF标准视频序列下采用运动补偿外推法的WZ帧的解码时间比采用运动补偿内插法的解码时间少0.13,s;CIF标准视频序列下,采用运动补偿外推法的WZ帧的解码时间少0.12,s;多视点视频序列下,采用运动补偿外推法的WZ帧的解码时间少0.30,s.

4.2单个视点运动补偿外推法与运动补偿内插法的

重构帧质量比较

为了验证笔者提出的外推法生成时间边信息与运动补偿内插法生成时间边信息的性能,在图2所示的系统中,分别采用运动补偿外推法和运动补偿内插法[13],对比研究解码重构视频的PSNR.仿真实验采用了运动程度由低到高的“Hall”、“Mother-Daughter”、“Foreman”、“Carphone”、“Coastguard”和“Soccer”6个QCIF格式(176×144)标准测试序列的100帧,Y∶U∶V为4∶2∶0,其中设定的GOP大小为2.实验中使用峰值信噪比(PSNR,单位为dB)来衡量解码恢复图像的客观质量.

表1 运动补偿外推法与运动补偿内插法非关键帧解码时间比较Tab.1 Decoding time comparison of decoding WZ frame between motion compensation extrapolation method and motion compensated interpolation method

由图7所示的6个序列测试结果图可以看出,在运动剧烈程度较低的时候,所提的运动补偿外推法与运动补偿内插法重构WZ帧的质量基本不差,如“Hall”序列,外推法与内插法的PSNR基本一致.随着运动剧烈程度的增加,外推法的重构质量比内插法的重构质量要低一些,如“Soccer”序列,外推法重构帧PSNR比内插法重构帧PSNR低1.5,dB左右,这是因为运动补偿内插法的时间边信息是从前、后两个方向进行运动估计、运动补偿的,外推法仅从一个方向进行了运动估计、运动补偿,所以重构质量外推法要比内插法差一些.

4.3多视点运动补偿外推法与运动补偿内插法的重构帧RD比较

上述实验比较了在单个视点中外推法、内插法生成时间边信息重构帧质量.由于多个视点中,WZ帧的边信息还包括视点间边信息,在采用不同生成时间边信息的方法时,融合后的边信息也不同,所以为了比较多视点运动补偿内插法与外推法的重构帧质量比较,选取了2组3视点标准测试序列“Ballet”、“Breakdancers”(1,024×768,100帧),帧率为15帧/s. 将3视点“Ballet”、“Breakdancers”标准测试序列的中间视点的K帧采用H.264(I帧)编解码,WZ帧分别采用基于运动补偿外推法的多视点分布式视频编码、基于运动补偿内插法的多视点分布式视频编解码,在不同比特率下,对中间视点的100帧进行平均RD比较,实验结果如图8所示.由图8可以看出,本文采用的外推法PSNR与内插法PSNR基本相当,最大差值不足0.2,dB,经过融合的边信息PSNR值均要高于单纯时间边信息重构帧的PSNR,并且采用两种方法的多视点分布式视频编码的WZ帧重构质量相差很小.

图7 运动补偿外推法与运动补偿内插法重构非关键帧客观质量比较Fig.7 Reconstruction objective quality comparison of WZ frame between motion compensation extrapolation method and motion compensated interpolation method

图8 多视点运动补偿外推法与内插法的中间视点帧RD比较Fig.8 RD comparison between multi-view movement extrapolation method and interpolation method

5 结 语

笔者提出了一种高效低时延的多视点分布式视

频编码,在视点内部采用运动补偿外推法获得时间边信息,经过与视点间边信息融合后获得融合后的边信息,再经过反量化重构得到解码信息.实验证明,所提的编码系统,WZ帧的重构质量接近于内插法重构的WZ帧质量,而且将运动补偿外推法应用于多视点分布式视频编码中,可以大大降低系统时延.运动补偿外推法在运动剧烈的视频情况下,获取时间边信息与内插法获取时间边信息的重构质量有一定差距,仍有改进的空间;此外,如何改进候选运动矢量来提高时间边信息重构质量,是下一步的研究重点.

参考文献:

[1]Slepian D,Wolf ,J. Noiseless coding of correlated information sources[J]. IEEE Transactions on Information Theory,1973,19(4):471-480.

[2]Wyner A D,Ziv J. The rate-distortion function for source coding with side information at the decoder[J]. IEEE Transactions on Information Theory,1976,22(1):1-10.

[3]Aaron A,Zhang R,Girod B. Wyner-Ziv coding of motion video[C]// Conference Record of the Thirty-Sixth Asilomar Conference on Signals,Systems and Computers. Pacific Grove,USA,2002:240-244.

[4]Puri R,Majumdar A,Ramchandran K. PRISM:A video coding paradigm with motion estimation at the decoder[J]. IEEE Transactions on Image Processing,2007,16(10):2436-2448.

[5]Artigas X,Ascenso J,Dalai M,et al. The discover codec:Architecture,techniques and evaluation [C]// Picture Coding Symposium. Lisbon,Portugal,2007: 1103-1120.

[6]Ouaret M,Dufaux F,Ebrahimi T. Iterative multiview side information for enhanced reconstruction in distributed video coding [J]. EURASIP Journal on Image and Video Processing,2009,2009:591915-1-591915-7.

[7]Guo X,Lu Y,Wu F,et al. Distributed multi-view video coding[C]//Proc SPIE 6077,Visual Communications and Image Processing 2006. Korea,2006: 60770T-8.

[8]Huang X,Brites C,Ascenso J,et al. Distributed video coding with multiple side information[C]// IEEE Picture Coding Symposium. Chicago,USA,2009:1-4.

[9]Kodavalla V K,Mohan P G K. Multi-view distributed video coding[C]// 2012 International Conference on Devices,Circuits and Systems(ICDCS). Coimbatore,India,2012:614-618.

[10]武晓嘉,郭继昌,姜 丹,等. 一种多视点立体视频分布式压缩感知编解码模型[J]. 天津大学学报,2012,45(10):895-902.

Wu Xiaojia,Guo Jichang,Jiang Dan,et al. A distributed compress sensing codec model in multi-view stereo video[J]. Journal of Tianjin University,2012,45(10):895-902(in Chinese).

[11]Abou-Elailah A,Farah J,Cagnazzo M,et al. Improved side information generation for distributed video coding[C]// 2011 3rd European Workshop on Visual Information Processing(EUVIP). Carins,Qld,Australia,2011:42-49.

[12]Verbist F,Deligiannis N,Jacobs M,et al. Probabilistic motion-compensated prediction in distributed video coding[J]. Multimedia Tools and Applications,2013,66:405-430.

[13]Monteiro P,Ascenso J,Pereira F. Perspective transform motion modeling for improved side information creation[J]. EURASIP Journal on Advances in Signal Processing,2013,2013(1):189.

[14]Heinrich A,Bartels C,van der Vleuten R J,et al. Optimization of hierarchical 3DRS motion estimators for picture rate conversion[J]. IEEE Journal of Selected Topics in Signal Processing,2011,5(2):262-274.

[15]Zhang Y,Zhao D,Liu H,et al. Side information generation with auto regressive model for low-delay distributed video coding[J]. Journal of Visual Communication and Image Representation,2012,23(1):229-236.

[16]Shimizu S,Kitahara M,Kimata H,et al. View scalable multiview video coding using 3-D warping with depth map[J]. IEEE Transactions on Circuits and Systems for Video Technology,2007,17(11):1485-1495.

[17]Avci A,De Cock J,Lambert P,et al. Efficient disparity vector prediction schemes with modified P frame for 2D camera arrays[J]. Journal of Visual Communication and Image Representation,2012,23(2):287-292.

[18]Merkle P,Smolic A,Muller K,et al. Efficient prediction structures for multiview video coding[J]. IEEE Transactions on Circuits and Systems for Video Technology,2007,17(11):1461-1473.

[19]Jiang Dan,Guo Jichang,Wu Xiaojia. Low-complexity distributed multi-view video coding for wireless video sensor networks based on compressive sensing theory[J]. Neurocomputing,2013,120(23):415-421.

(责任编辑:孙立华)

An Efficient Low-Delay Multi-View Distributed Video Coding

Guo Jichang,Xu Ying,Gong Jiachang

(School of Electronic Information Engineering,Tianjin University,Tianjin 300072,China)

Distributed video coding(DVC)is a video coding solution for shifting coding complexity from encoder to decoder. Multi-view distributed video coding(MDVC)mainly uses the motion compensation interpolation(MCI)to reduce the temporal redundancies inside the viewpoint. But the decoding order of MCI is inconsistent with the video sequence,which leads to decoding delay. Based on motion compensation extrapolation(MCE),an efficient lowdelay MDVC was proposed. In addition,the general MCE reconstruction quality is lower than that of the MCI method. On the basis of the MCE,the disparity vector interpolation was employed to reduce the interview redundancies,while fusion algorithm was applied to improve the reconstruction quality. Results show that the decoding time of the presented method is reduced by 0.3 s in the case of reconstruction quality of equal quality.

distributed video coding;multi-view;low-delay;motion compensation extrapolation;reconstruction quality

TN391

A

0493-2137(2015)12-1111-07

10.11784/tdxbz201403068

2014-03-21;

2014-06-20.

教育部高等学校博士学科点专项科研基金资助项目(20120032110034).

郭继昌(1966—),男,博士,教授.

郭继昌,jcguo@tju.edu.cn.

网络出版时间:2014-09-29. 网络出版地址:http://www.cnki.net/kcms/doi/10.11784/tdxbz201403068.html.