机器人抓取中的图像特征点提取算法及DSP实现

2015-06-07吴裕斌曹丹华

胡 攀,吴裕斌,曹丹华

(华中科技大学光学与电子信息学院,湖北武汉 430074)

机器人抓取中的图像特征点提取算法及DSP实现

胡 攀,吴裕斌,曹丹华

(华中科技大学光学与电子信息学院,湖北武汉 430074)

在视觉引导的机器人抓取技术中,需要快速提取不同视角图像的特征点集,实现基于特征的姿态估计。传统的特征点提取算法十分耗时,并难以在基于DSP的嵌入式图像处理平台上实现。针对工业应用场景,提出了一种基于简化SURF和不变矩的特征点提取算法,引入了一个4维的局部不变矩作为特征描述子。算法针对DSP平台进行了优化,测试达到了7帧/s的运行速度,并满足一定程度的光照和仿射不变性。

特征点提取;机器人抓取;嵌入式平台;局部不变矩;光照不变性;仿射不变性

0 引言

视觉伺服系统中,固定眼引导的机器人在抓取流水线上目标物体时,需要对不同视角多相机所拍摄物体图像的特征点集进行匹配。然而,视角的不同使得物体表面产生了光照变化和仿射形变,提取满足一定光照和仿射不变性的特征点集,是后续特征匹配和姿态估计成功的关键。

特征点提取算法包括特征点定位和特征点邻域描述两个步骤。SIFT[1]通过高斯金字塔实现了尺度不变的特征点定位,并使用梯度直方图对每个特征点构建了一个128维的描述子。SURF[2]通过模板缩放取代图像缩放实现了快速金字塔构建,并采用Haar小波对每个特征点进行了64维的描述。还有ASIFT[3],PCA-SIFT[4],Harris-Affine[5]等。这些算法都具备复杂的特征点定位过程和高维度的特征描述子,虽然对复杂图像具备较好的鲁棒性,却难以满足工业应用的速度要求,并难以在基于DSP的嵌入式图像处理平台实现。

为了在DSP上实现工业场景图像的快速鲁棒的特征点提取,在特征点定位过程中使用了简化的SURF算法:仅使用3层相互间具有较大尺寸变化的模板,保证了一定的尺度不变性。同时,将本来用于描述全局图像的不变矩用于局部的特征点邻域描述中,在Jan Flusser不变矩[6]的基础上引入局部光照变化模型和高斯权重来保证光照和仿射不变性,最终构建了一个仅有4维的描述子,极大地减少了运算量。最后,针对DSP平台进行了软件编码、编译器、硬件等多个层次的优化。通过对不同视角的真实图像和模拟图像进行实验,验证了光照和仿射不变性,并测得算法速度相比PC有1倍的提升,能够达到机器人抓取中的速度和精度要求。

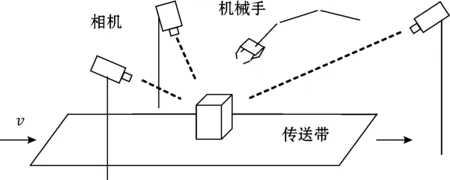

1 系统原理

固定眼机器人系统对目标物体采用会聚式拍摄。多目相机中一个为主相机,其余为从相机。各个相机计算出自身拍摄图像的特征点集,经过总线传输到主相机中进行特征匹配,结合多相机标定所得的内外参数,获取物体深度信息后,便能实现目标物的姿态估计(F矩阵),从而引导机械手臂进行抓取。系统示意图如图1所示。

图1 系统原理图

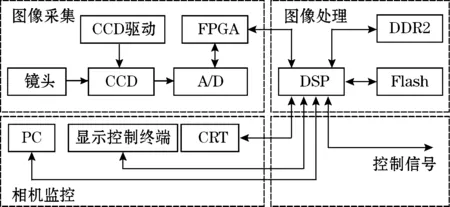

图2 DSP嵌入式图像处理平台硬件框图

图1中相机均为基于DSP的嵌入式图像处理平台,如图2,平台由图像采集、图像处理、相机监控3个部分组成。

2 DSP嵌入式图像处理平台

高速面阵CCD采集图像信息,经A/D转换成一定格式的数字信号送到DSP中处理;FPGA为CCD及系统提供控制时序;DDR2(128 M)及NAND FLASH(64 M)为系统提供必要的存储空间;PC及基于C8051F040的显示控制终端进行相机参数设定和运行状态监控。DSP在图像处理完成后,输出结果图像及控制信号,控制机械手臂抓取。

系统选用的TMS320DM6437型DSP是一款专门用于高速图像处理的定点媒体处理器,主频最高700 MHz,内部包括8个可并行运算的功能单元。系统将其主频配置为597 MHz,并分配了80 K的IRAM和48 K的L1DSRAM。

3 特征点提取算法

对于机器人抓取中的特征点提取算法,为了提高精度,需要尽可能保证不同视角图像的特征点集具备较高重合率,减少描述子受光照和仿射形变的影响;为了提高速度,需要简化特征点定位过程,降低描述子维度,减少后续运算量。

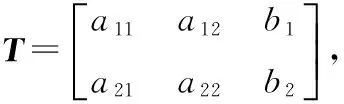

3.1 仿射变换模型

由于相机与空间物体的相对视角变化,物体表面各局部平面在成像时会产生形变,这种形变满足仿射变换模型。变换公式为

f(x,y)=f′(a11x+a12y+b1,a21x+a22y+b2)

(1)

经过SVD分解为

(2)

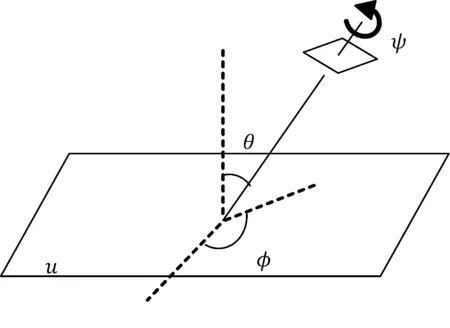

如图3所示,u为物平面;ψ为镜头的轴向转动角;θ为镜头光轴与物平面法线夹角,即经度角,其中,t=1/cosθ;φ为物平面法线与镜头光轴所成平面与竖直平面夹角,即纬度角;λ为缩放带来的系数;|A|=a11a22-a12a21,为具体缩放值;dx=b1/|A|为x方向位移;dy=b2/|A|,为y方向位移。

图3 仿射变换模型

3.2 特征点定位

如式(3)所示,传统SURF算法寻找尺度空间Hessian行列式的极大值点作为特征点,通过不同尺寸的盒子滤波器对图像进行滤波并构建金字塔。常用的滤波器尺寸组合为:第一组(9,15,21,27),第二组(15,27,39,51),第三组(27,51,75,99),如此这样,至少3组。

(3)

然而,在机器人抓取场景中,不同视角相机所拍摄的图像尺寸相同,相机离物体的距离也基本一致。这样不论是图像还是物体本身,都不存在特别明显的尺度变换。于是,仅使用尺寸为15、27、51的3个滤波器进行运算,在构建金字塔时,既可以保证尺度空间的跨度,也能较使用多组多层滤波器在速度上成几倍的提升。

同时,抓取场景中的图像存在背景单一的特点,特征点会集中于作为图像前景的目标物体表面上。通过图像二值化将前景标出,在进行尺度空间Hessian极大值判定时,仅针对前景像素点进行特征点判定;并对每个检测出的特征点,标记其邻域点为非特征点,下次遍历时直接跳过这些标记点,这样在极大值检测时,又减少了大量运算量。

3.3 特征点邻域描述

传统的特征点提取算法使用梯度直方图或者Haar小波进行邻域描述,它们具备很高的维度,并需要计算邻域的主方向来保证旋转不变性。不变矩[7]能通过计算全局的灰度分布特征来降低维度并避免旋转运算[8-9],其一般是对整幅图像进行不同阶数的积分。通过构造具备一定仿射不变性的积分邻域,并推导具备光照和仿射不变性的不变矩,便可将不变矩用于局部域中,得到低维且有效的特征描述子。

离散状态下,对于灰度分布为f(x,y),大小M×N(宽×高)的图像,其(p+q)阶矩定义为

(4)

(p+q)阶中心矩定义为

(5)

在式(1)的基础上,引入局部光照变化模型,假设特征点邻域内灰度变化为

f(x,y)=cf′(a11x+a12y+b1,a21x+a22y+b2)+ε

(6)

然后,在特征点描述时,将不变矩的积分域换为以特征点为圆心的固定大小的圆形邻域,这样在图像轴向旋转情况下特征点邻域将保持不变。圆形邻域半径为

(7)

式中:Spre为前景图像面积,在机器人抓取场景中,前景即为目标物体;N为图像中提取的特征点数目。

同时,引入高斯积分权值来减小仿射变换时图像局部形变对圆形模板积分域的影响,见式(8):

(8)

如此,将式(4)、式(5)分别修正为式(9)、式(10):

(9)

(10)

这样便消除了b1,b2及ε因子。然后在Jan Flusser仿射不变矩的基础上消除c因子,可以得到如下4个光照和仿射不变矩:

(11)

(12)

(13)

(14)

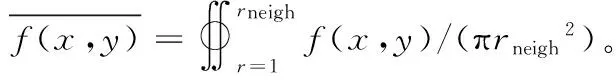

3.4 算法总体框架

算法对灰度图像进行运算,步骤见图4。为了降低输入图像噪声,在特征点提取前,对图像进行了高斯滤波;为了提取响应突出且稳定的点,同时也减少后续特征点邻域描述的运算量,对空间极大值检测出的点进行阈值处理:去掉响应值小于200的特征点,并去掉|Lxx(x,y,σ)/Lyy(x,y,σ)|及|Lxx(x,y,σ)/Lyy(x,y,σ)| 的值大于10的点;为了证明提取的特征点集准确有效,算法后续进行了两幅不同视角图像的特征点集匹配,通过匹配的准确性来衡量光照和仿射不变性:先基于欧氏距离进行朴素模式匹配,然后使用RANSA算法[10]进行匹配校正,最终得出两幅图像的仿射变换矩阵。

图4 算法框图

3.5 算法的DSP实现

(1) 将浮点数据转为定点数据,尽量使用位运算;

(2) 使用TI的intrinsic operations,尽量采用SIMD指令;

(3) 开启-o3选项,优化软件流水线;

(4) 查看asm文件,迭代进行上述3步骤直到耗时收敛;

(5)使用DMA实现高速数据搬运和图像采样;

(6)开启Cache并分配频繁访问变量到IRAM。

4 实验结果

实验使用图2所示平台拍摄了3组不同物体(卷笔刀、遥控器、工字型工件)的灰度图像,分辨率为640×480。首先对每个物体采集了10张不同光照强度下的图像及45张不同空间姿态的图像,然后对原图进行人为仿射变换来获取模拟图像。如图5所示,依次为光照强、光照弱、视角变换和模拟变换4种图像示例。

图5 实验测试图片示例

4.1 光照不变性实验

为验证特征点集具备光照不变性,对图5中不同光照强度的图像进行特征点集匹配,将匹配点和真实点的像素坐标距离小于一定阈值(实验选用像素距离4作为阈值)的点视为正确匹配,得到算法在光照变化下的匹配情况。如图6所示,横坐标代表光照强度的变换(以图像全局灰度中值变化的百分比来表示),纵坐标代匹配分数百分比。可以看出,在整幅图像灰度中值变化-40%~40%的范围内,算法提取的特征点集达到了85%以上的匹配分数。

图6 光照变化下的匹配分数

4.2 仿射不变性实验

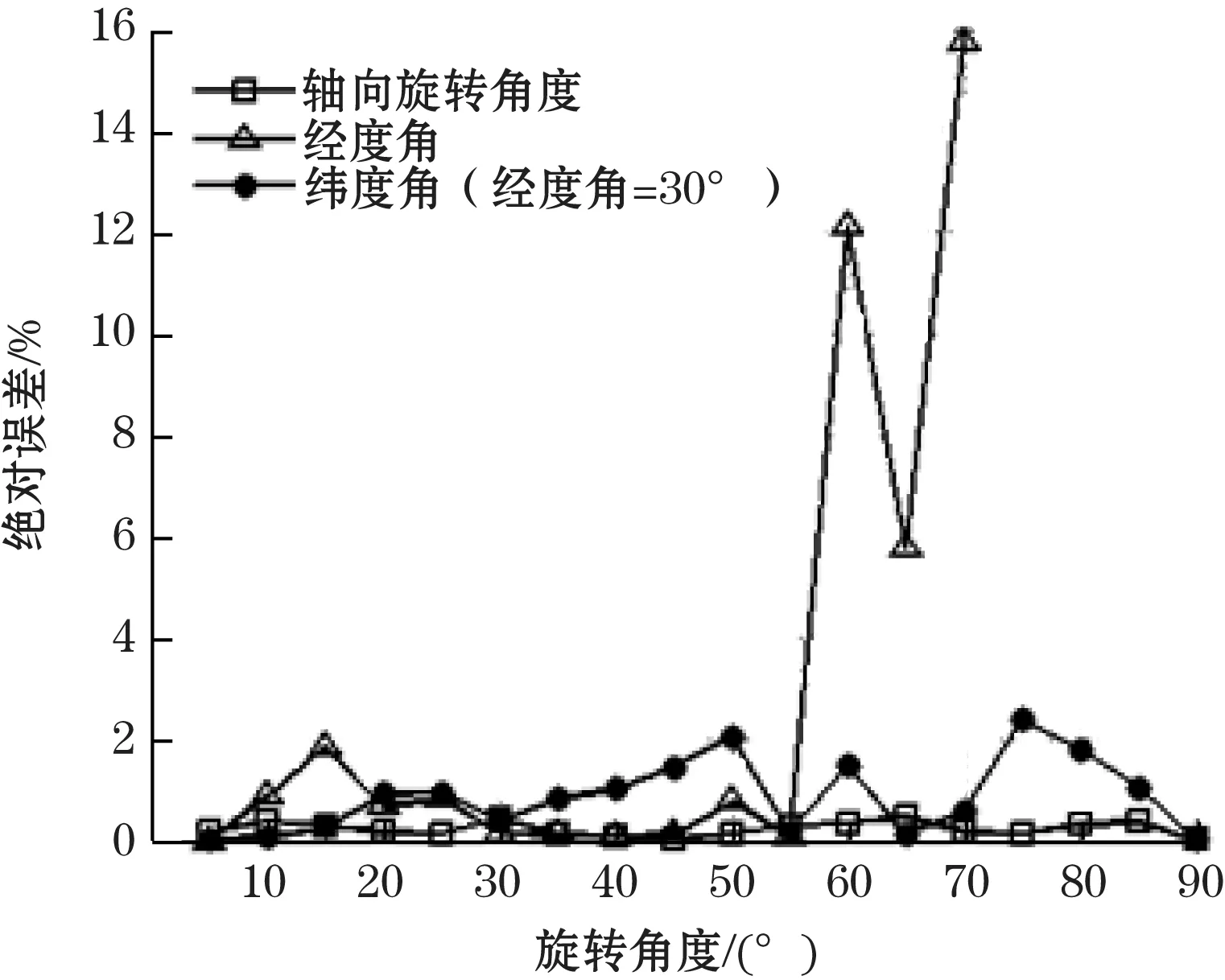

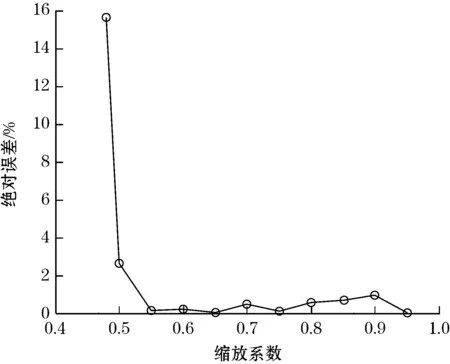

由2.1节可知,仿射变换由仿射变换矩阵唯一表示。通过分解仿射矩阵可以得到物理意义上对应的6个参数:ψθ,φ, |A|,dx,dy。由于SVD的分解不唯一,只有单一参数变换下才可以由仿射变换矩阵逆推出唯一的参数。为验证特征点具备仿射不变性,对原图使用只包含单一变化参数的仿射变换来生成模拟图。将模拟图和原图匹配得出仿射矩阵,并从中解析出变换参数值,和真实值进行误差比较,便可得到误差情况。图7表示3个旋转角度的绝对误差,图8表示缩放系数的相对误差。由于平移情况下模拟图像和原图的匹配精度很高,误差基本为零,故没有给出图片。

图7 旋转变换下各旋转角度的绝对误差

图8 缩放变换下的相对误差

从图7可以看出,在旋转变换情况下,算法在相机轴向角(ψ)旋转时保持了较好的不变性:在5°~90°的范围内,角度绝对误差都在0.5°以下;在经度角(θ)旋转情况下,0~55°以内可以保证2°以内的绝对误差;在纬度角(φ)旋转情况下(经度角旋转30°),0~90°以内可以保证2°以内的误差。从图8可以看出,在缩放变换情况下,算法在物体图像存在0.5~0.95的缩放比例(面积)下仍保持了较高匹配精度,相对误差控制在2%以内。

4.3 综合实验

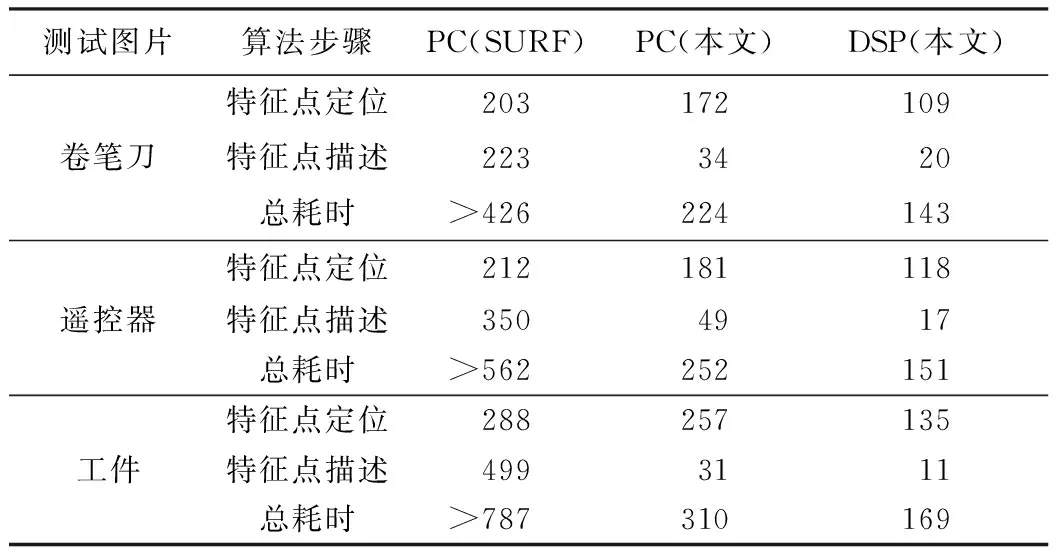

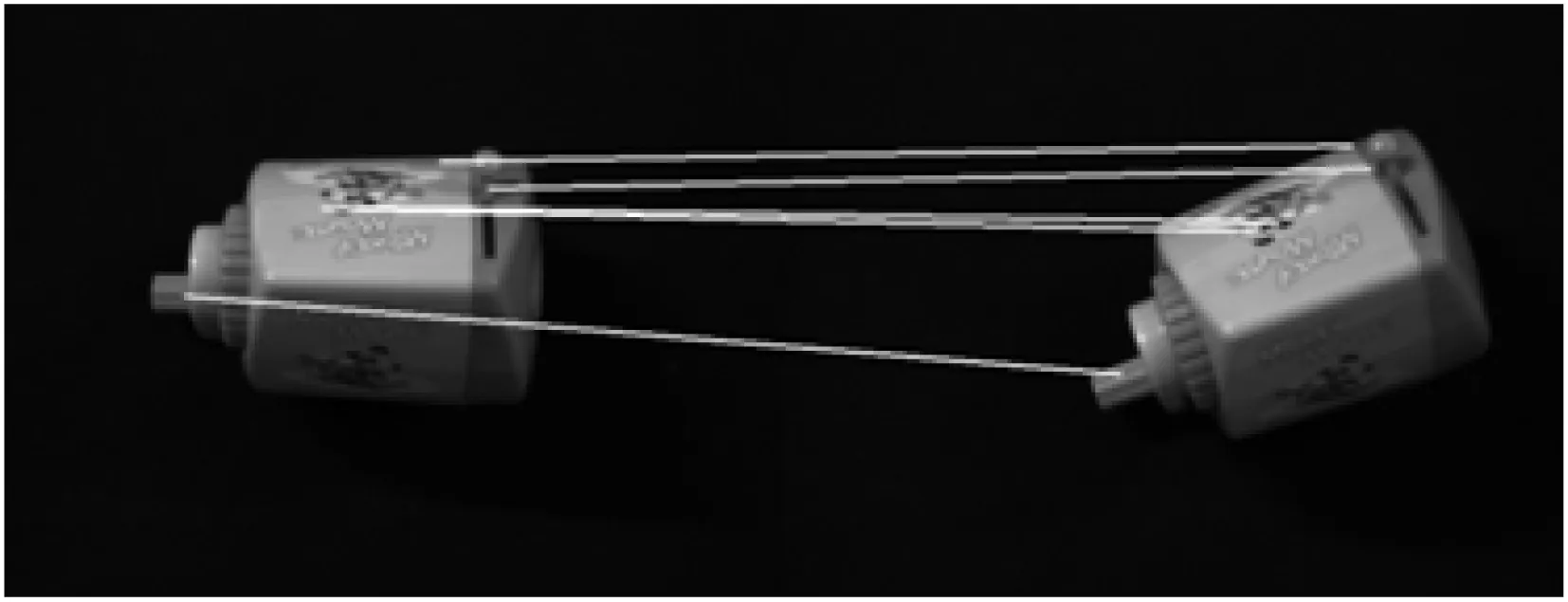

最后,将不同姿态的真实图像(包括了视角不同导致的光照变化和仿射变换影响)和原图匹配来进行综合实验。图9给出了通过仿射矩阵计算所得的原图上特征点到匹配图上对应点的连线图(为使图像清晰只标示了1/10的连线)。可以看出算法对3种物体均能得出正确的仿射变换矩阵,能够满足机器人抓取场景中对特征点集的鲁棒性需求。表1给出了算法时间对比,可以看出,算法较传统特征点提取算法SURF(OpenCV实现)有近1倍的速度提升,从PC(Intel Core i5 2.67GHz处理器)移植到DSP平台上并优化后,速度又提升近1倍,达到7帧/s的处理速度。

表1 算法运行时间 ms

图9 不同姿态图像的匹配

5 结束语

本文针对固定眼机器人抓取系统的应用需求,提出了一种能够在基于DSP的嵌入式图像处理平台上快速可行的特征点提取算法。算法的创新性在于针对应用场景简化了特征点定位过程,推导出了光照和仿射不变的局部不变矩,用于特征点邻域描述。最终测得算法速度达到7帧/s,具备较好的光照和仿射不变性,能够满足机器人抓取系统的要求。

[1] LOWE D G.Distinctive image features from scale-invariant keypoins.International Journal of Computer Vision,2004,60(2):91-110.

[2] BAY H,ESS A,TUYTELAARS T.Speeded-up robust features.Computer Vision and Image Understanding,2008,110(3):346-359.

[3] MOREL J M,YU G S.ASIFT: A new framework for fully affine invariant Image comparison.SIAM Journal on Imaging Sciences,2009,2(2):1-31.

[4] YE K,SUKTHANKAR R.PCA-SIFT: a more distinctive representation for local image descriptor.Proceedings of the Conference on Computer Vision and Pattern Recognition,2004,2:504-513.

[5] MIKOLAJCZYK K,SCHMID C.Scale & affine invariantinterest point detectors.International Journal of Computer Vision,2004,60 (1):63-86.

[6] RAHTU E,SALO M,HEIKKILA J,et al.Generlized affine moment invariants for object recognition.Pattern Recognition,2006(2):634-637.

[7] 毕明德,孙志刚,李叶松.基于机器视觉的布匹疵点检测系统.仪器技术与传感器,2012(12):37-40.

[8] 徐贵力,徐静,王彪,等.基于光照模糊相似性融合不变矩的航天器目标识别.航空学报,2014,35(3):857-867.

[9] 徐贵力,钟志伟,王彪,等.具有几何和光照不变性的不变矩构建研究.航空学报,2014,34(7):1698-1705.

[10] 常青,张斌,邵金玲.基于SIFT和RANSAC的特征图像匹配方法.华东理工大学学报(自然科学版),2012,38(6):747.

Interest Point Extraction Algorithm for Robotic Grasp and Implementation on DSP

HU Pan,WU Yu-bin,CAO Dan-hua

(School of Optical and Electronic Information,Huazhong University of Science and Technology,Wuhan 430074,China)

Quick extraction of the image feature point set in different perspectives was needed in robust grasp technology to realize pose estimation based on characteristics. Traditional image interest point extraction methods are time-consuming,and it is hard to perform in real-time and duplicate to implement on DSP embedded platform. Aiming at industrial applications,a new interest point extraction method based on SURF and moment invariants was proposed. The local moment invariants were introduced to resist illumination change and affine transform,which constructs only a 4-dimensional descriptor. And the DSP-specified optimization was conducted systematically. Experiments show that the algorithm can process nearly 7 images per second on the DSP platform,with the stability under changing illumination and affine transformation.

interest point extraction;robotic grasp;embedded system;local moment invariants;photometric invariance;affine invariance

2015-01-01 收修改稿日期:2015-07-03

TP29

A

1002-1841(2015)11-0085-04

胡攀(1989—),硕士研究生,主要研究领域为机器视觉、图像处理。E-mail:pan_89@yeah.net