基于视觉重要区域的立体图像视觉舒适度客观评价方法

2014-11-22姜求平枫蒋刚毅彭宗举

姜求平 邵 枫蒋刚毅 郁 梅 彭宗举

(宁波大学信息科学与工程学院 宁波 315211)

1 引言

3维/立体视频技术能够提供多感知性,深度沉浸和临场体验,极大地提升观看者的视觉体验质量(Quality of Experience, QoE)。视觉舒适度(Visual Comfort, VC)是影响立体视频 QoE的重要因素之一。目前对立体视频/图像的评价主要考虑内容失真对图像质量的影响,而较少考虑立体视频内容制作等因素导致的视觉不舒适度。因此,建立有效的立体视频/图像的视觉舒适度客观评价模型对 3维内容制作和后期处理具有十分重要的意义。

在观看立体视频时,过大的双目视差,双眼不对称,以及立体失真等因素都会导致视觉疲劳,引起视觉疲劳的根本原因是由于立体视频本身的制作原理导致观看者双眼焦点调节和辐辏的严重冲突[1,2]。一般来说,立体图像的视差是决定人眼感知深度大小的重要因素,视差过大使得立体视频/图像的深度感增强,而当感知深度大小在大脑的Panum融合区之外时,就会导致双眼调节和辐辏的冲突,进而产生眼部甚至身体上的一系列疲劳症状。主观实验表明,随着立体视频/图像视差的增大,观看时的视觉舒适度会降低[35]-。同时,图像的空间频率也影响着人眼的深度感知和双目融合极限[6]。Schor等人[7]利用高斯差分函数(Difference of Gauss, DoG)处理得到不同空间频率的立体图像,探究了图像的空间频率对双目融合极限的影响,图像的空间频率越低,双目的融合极限就越高。对于具有较大视差的立体图像,空间频率越低,观看的视觉舒适度越高[8]。应当注意到,不同立体图像具有不同的空间频率特征,导致视觉舒适程度也不一致。

传统的视觉舒适度客观评价方法主要基于全局的视差统计特性预测视觉舒适度,例如整幅视差图像的均值、方差、分布范围等特征[911]-。然而,根据人眼立体视觉注意力特性,人眼只对部分视觉重要区域的视觉舒适/不舒适比较敏感,如果以此全局的视差统计特征来预测视觉重要区域的视觉舒适程度,会导致无法精确预测得到客观评价值。文献[12]在传统舒适度评价算法的基础上,提出一种基于相对视差和前景对象尺寸的立体图像视觉舒适度客观评价方法。该方法首先利用mean-shift分割法对视差图进行分割,有效地提取出对象的轮廓,然后计算到邻近对象间的相对视差和前景对象的尺寸,并将其作为舒适度感知特征,最后结合传统的全局视差统计特征,可以较大程度地提高视觉舒适度预测的准确性。然而,该方法并未考虑空间频率特征对人眼深度感知的影响,此外,该方法也未考虑立体视觉显著/重要区域对视觉舒适度评价的影响。因此,如何在评价过程中有效地根据视觉重要区域来提取视觉舒适度特征信息,使得客观评价结果更加符合人类视觉系统,是立体图像视觉舒适度客观评价需要研究解决的问题。

2 基于视觉重要区域的立体图像视觉舒适度评价方法

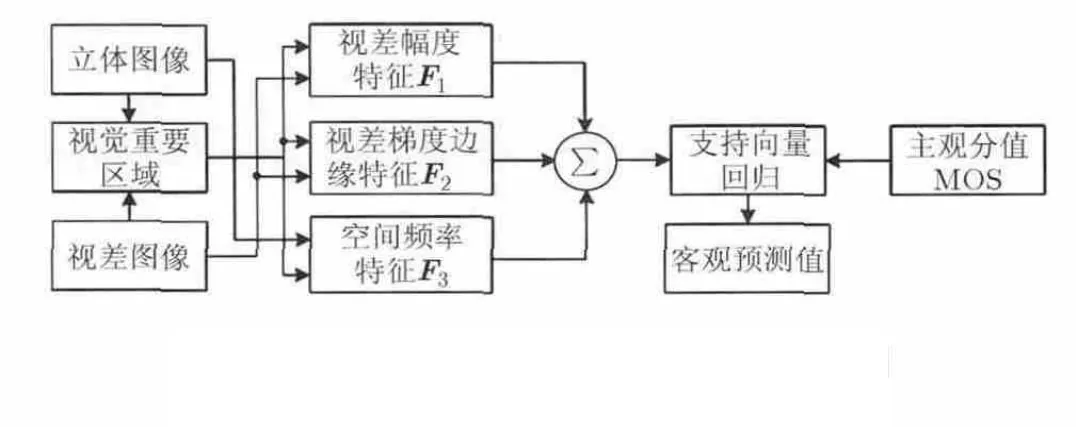

根据人眼立体视觉注意力特性,人眼只对部分视觉重要区域的视觉舒适/不舒适比较敏感,为了更准确地预测立体图像视觉舒适度,如何在评价过程中有效地根据视觉重要区域来提取出视觉舒适度特征信息十分关键。本文提出了一种基于视觉重要区域(Visual Important Regions, VIR)的立体图像视觉舒适度客观评价模型,其框架图如图1所示。首先,利用平面图像显著图模型和视差信息得到视觉重要区域;然后,提取视觉重要区域的视差幅度特征、视差梯度边缘特征和空间频率特征,并以这些特征的组合作为反映立体图像舒适度的感知特征信息;最后,通过支持向量回归(Support Vector Regression, SVR)预测得到客观评价值,避免了对人类视觉系统的相关特征与机理的复杂模拟过程。由于获得的立体图像的特征信息具有较强的稳定性,且能较好地反映图像的视觉舒适度变化情况,有效提高了客观评价情况与主观感知的相关性。

2.1 视觉重要区域提取

图1 立体图像视觉舒适度客观评价模型框图

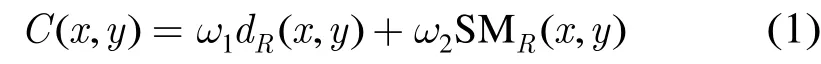

现有的研究表明,立体图像的视差特征和空间频率都会影响视觉舒适度。立体图像视觉重要区域由两部分构成:2维图像的视觉显著图和深度显著图。图像显著图利用人眼视觉注意力模型计算图像的显著度,其代表性算法有Itti算法[13],Hou算法[14],GBVS算法[15]等。本文采用GBVS算法计算得到右视点图像的视觉显著图,记为,并采用线性方式将视觉显著图和右视差图像进行结合,得到立体显著图,记为

为了检测立体显著图的VIR,采用阈值法提取出掩模图像,VIR掩膜图像定义为

2.2 视差幅度特征提取

一般来说,观看立体视频导致双眼的焦点调节和辐辏的冲突是产生视觉疲劳的主要原因。当人眼观看现实世界的场景,人眼的焦点调节和辐辏机制是一致的,而观看立体视频时,若左右视点的视差大小在融合区域内,尽管经过大脑融合仍可形成清晰的单视图像,但此时人眼的焦点调节处于屏幕上,而辐辏却处于因人脑融合而产生的“跃出”屏幕或“陷入”屏幕的虚拟立体图像上,造成焦点调节和辐辏的不一致,与人类长久形成的视觉生理特性相违背。为了减小这种因焦点调节和辐辏的冲突而引起的视觉疲劳,应该将立体图像感兴趣区域的视差大小控制在 Percival舒适区域(Percival’s Zone of Comfort, PZC)范围内[17],因此本文提取视觉重要区域的视差均值μ,视差方差δ,最大交叉视差υ和视差范围τ共 4个特征,作为立体图像视差幅度特征矢量,记为,各特征的计算公式如下:

图2 立体图像视觉重要区域分割结果

(1)VIR视差均值μ:

(2)VIR视差方差δ:

2.3 视差梯度边缘特征提取

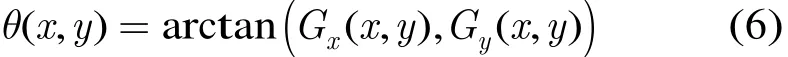

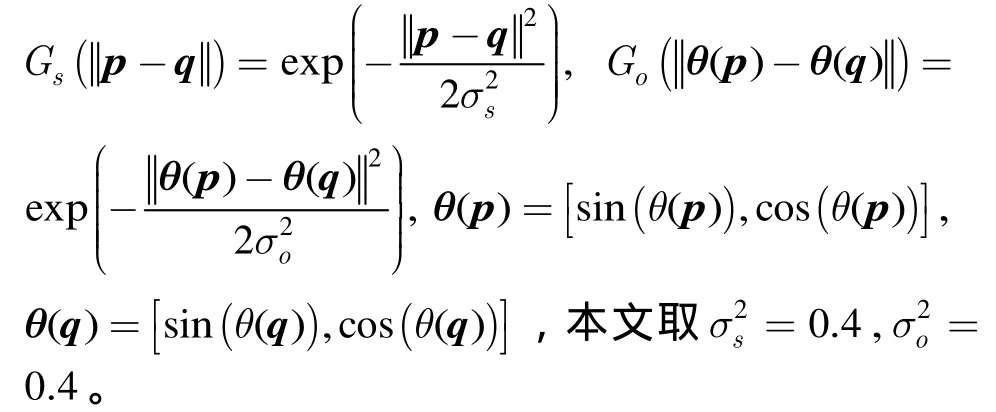

基于视觉重要区域的视差边缘特征具有良好的稳定性,且能很好地反映立体图像视觉舒适度。本文通过计算右视差图像的视差梯度幅值图像和梯度方向图像,利用空间域高斯函数和梯度方向距离的高斯函数对视差梯度幅值进行加权,得到视差梯度边缘图像,最终利用VIR掩膜加权得到视觉重要区域的视差梯度边缘特征征的具体计算公式如式(5)~式(8):,作为立体图像视差梯度边缘特征记为F2,该特

2.4 空间频率特征提取

立体图像的空间频率与人眼对视差的融合极限成反比,立体图像的低空间频率所致的模糊会增大人眼对焦点调节和辐辏冲突的融合范围。本文通过计算右视点图像的水平方向频率值,垂直方向频率值,对角方向频率值,得到的空间频率图像,然后提取视觉重要区域的空间频率均值η,空间频率方差ρ,空间频率范围ζ和空间频率敏感因子λ共4个特征,作为立体图像空间频率特征矢量记为 F3,,该特征矢量具体计算过程如下:

(2)VIR空间频率均值η:

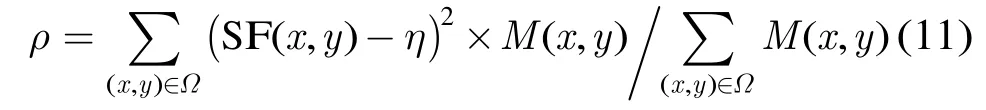

(3)VIR空间频率方差ρ:

2.5 立体图像视觉舒适度感知特征融合

本文在VIR掩膜图像的基础上,提取基于VIR的视差幅度特征矢量 F1、视差梯度边缘特征矢量F2和空间频率特征矢量 F3,然后将特征矢量 F1,F2,F3连接起来形成一个新的特征矢量,作为待评价立体图像的特征矢量X,即有

接着,通过 SVR训练得到视觉舒适度预测函数,基于SVR的立体图像视觉舒适度感知特征融合过程主要包含以下两个阶段。

2.5.1 训练阶段 (1)随机选择立体图像集合中(9×n)/10对立体图像构成训练样本数据集合,记为,其中,n表示立体图像集合中立体图像的对数,q表示训练样本数据集合qΩ中包含的立体图像的对数,表示训练样本数据集合qΩ中的第对立体图像的特征矢量,MOSk'表示训练样本数据集合qΩ中的第对立体图像的平均主观评分值(Mean Opinion Score, MOS),。

(2)构造k'X 的回归函数,其中,w为权重矢量,为w的转置矩阵,b为偏置量,为径向基核函数,,为训练样本数据集合qΩ中的第对立体图像的特征矢量,γ为核参数,用于反映输入样本值的范围,本文取γ=54。

(3)利用支持向量回归对训练样本数据集合qΩ进行训练,使得经过训练后回归的函数值集合与MOS集合之间的误差最小,拟合得到最优的权重矢量wopt和最优的偏置量bopt,从而构造最优支持向量回归训练模型。

2.5.2 测试阶段 (1)立体图像数据库中剩下的n/10对立体图像构成测试样本数据集合,记为tΩ,t表示测试样本数据集合tΩ中包含的立体图像的对数。根据支持向量回归训练模型,对测试样本数据集中每一对立体图像进行测试,预测得到该子集中每一对立体图像的客观视觉舒适度评价值。对于该组子集中第 i对立体图像的客观视觉舒适度评价预测值,将其记为,其中,Xi表示该组子集中第i对立体图像的特征矢量。

(2)重复以上过程N次,将得到的N组客观参量的平均值作为最终该视觉舒适度客观评价模型的评价性能,本文取N=200。

3 实验结果与分析

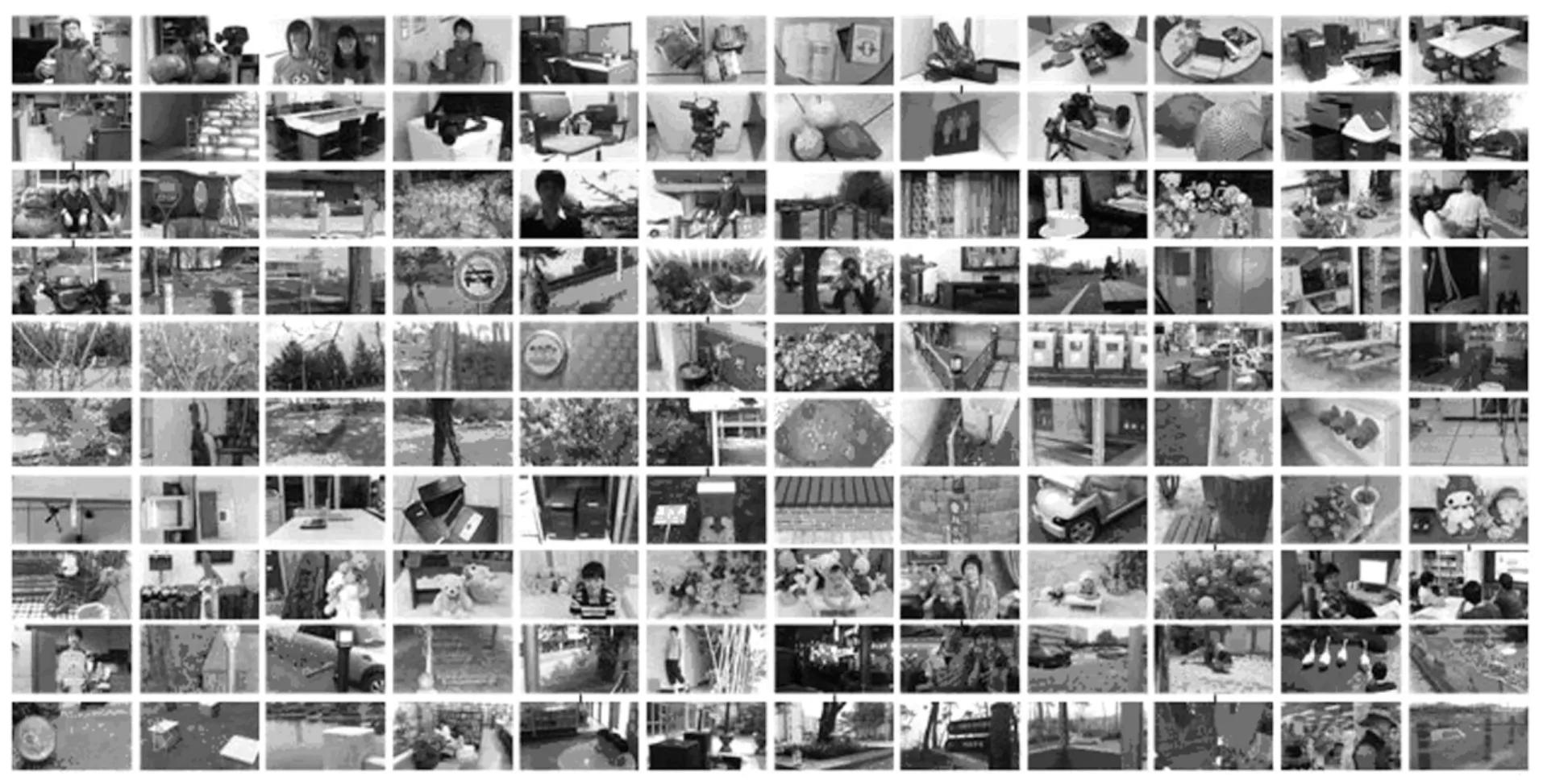

为验证该客观评价模型的性能,采用韩国先进科学学院提供的立体图像库作为立体图像样本数据集合[19]。该立体图像库由120幅分辨率为1920×1080的立体图像组成,该数据库包含了各种室内场景和室外场景图像,其右图像如图3所示。同时,该数据库提供了每幅立体图像的 MOS, MOS值越大表示立体图像的视觉舒适度越高。该立体图像库的主观测试按照ITU-R BT.1438规定的标准进行,实验中采用Redrover SDM-400 3维显示器,主观实验人数为18人,观看者的观测距离为显示器高度的3倍,测试环境均符合ITU-R BT.500-11标准。实验中要求观察者根据自身的生理症状或者疲劳反应(例如眼睛疲劳,全身不适,头痛,聚焦困难,恶心等症状)的严重程度,对立体图像按照5个等级(5表示非常舒适,4表示舒适,3表示一般舒适,2表示比较不舒适,1表示非常不舒适)进行主观打分,然后通过统计分析得到每幅立体图像的 MOS值。此外,该测试库采用深度估计软件计算得到右视差图像,视差分布范围为0~285个像素点。

本文采取 10折交叉验证方法来评估立体图像视觉舒适度感知特性的预测性能。所谓10折交叉验证,就是随机地将立体图像样本数据集合等分成10个互不相交的子集,将其中的9份立体图像子集作为训练样本集,构造支持向量回归训练模型,剩余的1份立体图像子集作为测试样本集,根据训练模型,预测测试样本集中所有立体图像的视觉舒适度客观评价分值 Q。由于在主观质量评价实验中会引入一系列非线性因素,为避免非线性因素对客观评价模型性能的影响,需要将模型的客观评价分值 Q做非线性拟合,本文采用5参数Logistic函数进行非线性拟合,从而预测得到客观模型预测值MOSp。

图3 立体图像数据库右视点图像

然后计算得到客观预测值 MOSp与平均主观评分值 MOS的相关性来度量客观模型的性能,在本文中采用 Pearson相关系数(Pearson Linear Correlation Coefficient, PLCC), Spearman相关系数(Spearman Rank-order Correlation Coefficient,SRCC), Kendall相关系数(Kendall Rank-order Correlation Coefficient, KRCC)和均方根误差(Root Mean Squared Error, RMSE)4组客观参量,其中,PLCC, RMSE反映客观评价模型预测值的准确性,SRCC和KRCC反映客观评价模型预测值的单调性和一致性;PLCC, SRCC, KRCC越大,RMSE越小说明客观评价预测值与平均主观评分值的相关性越好。

3.1 客观性能评价

表 1给出了本文方法与文献[9]和文献[12]方法在相同测试库上的各项性能指标,由表中数据可以看出,本文方法的PLCC在0.87以上,SRCC在0.83以上,均方根误差RMSE接近0.39,均优于文献[9]和文献[12]的各评价指标。此外,表1还给出了采用本文所提取的视差幅度特征矢量F1、视差梯度边缘特征矢量 F2、空间频率特征矢量 F3不同特征组合的评价性能指标。由表中数据可以看出,只采用两个特征矢量组合得到的评价预测值与主观评分值间的相关性并不是最佳的,并且视差幅度特征矢量 F1对评价性能的影响比视差梯度边缘特征矢量F2和空间频率特征矢量 F3更大,而结合 F1,F2和F3得到的评价性能最佳,说明本文的特征描述方法有效。

表1 不同方法视觉舒适度客观评价模型评价性能指标比较

3.2 各特征对性能的影响

图4(a),图4(b)和图 4(c)分别给出了只采用两种特征矢量组合得到的客观评价值与 MOS值的散点图,从图中可以看出,只采用视差梯度边缘特征矢量F2与空间频率特征矢量F3组合得到的散点图最分散,与主观评价值之间的吻合度最低,而采用视差幅度特征矢量 F1与视差梯度边缘特征矢量F2组合或者视差幅度特征矢量F1与空间频率特征矢量F3组合得到的散点图较为集中,说明视差幅度特征矢量F1对评价性能的影响最大。图4(d),图 4(e)和图 4(f)分别给出了文献[9]和文献[12]以及本文方法的散点图,从图中可以看到,本文评价方法的客观评价值Q与MOS值的散点图较为集中,更加符合人眼的主观感知。

4 结束语

图4 采用不同方法得到的客观视觉舒适度评价预测值与MOS值的散点图

本文根据人眼的视觉注意力机制,提出了一种基于视觉重要区域的立体图像视觉舒适度客观评价方法。该方法通过利用图像显著图模型和视差信息得到视觉重要区域,然后提取视觉重要区域的视差幅度特征,视差梯度边缘特征和空间频率特征,作为反映立体图像舒适度的感知特征信息,并通过支持向量回归预测得到客观评价值。实验结果表明,该方法能够精确地预测人眼对立体图像的视觉舒适程度。接下来,我们将在本文的基础上,考虑建立更为精确的立体显著图模型,从而进一步提高预测的准确性。

[1] Lambooij M, Ijsselsteijn W A, and Heynderickx I. Visual discomfort and visual fatigue of stereoscopic displays : a review[J]. Journal of Imaging Science and Technology, 2009,53(3): 030201-1-030201-14.

[2] Kim D, Choi S, Sohn K, et al.. Effect of vergenceaccommodation conflict and parallax difference on binocular fusion for random dot stereogram[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(5):811-816.

[3] Jung Y J, Sohn H, and Ro Y M. Visual discomfort visualizer using stereo vision and time-of-flight depth cameras[J]. IEEE Transactions on Consumer Electronics, 2012, 58(2): 246-254.[4] Jung Y J, Kim D, Sohn H, et al.. Subjective and objective measurements of visual fatigue induced by excessive disparities in stereoscopic images[J]. SPIE, 8648, 2013: DOI:10. 1117/12.2005818.

[5] Tam W J, Speranza F, Yano S, et al.. Stereoscopic 3D-TV:visual comfort[J]. IEEE Transactions on Broadcasting, 2011,57(2): 335-346.

[6] Patterson R. Human factors of stereo displays: an update[J].Journal of the Society for Information Display, 2009, 17(12):987-996.

[7] Schor C, Wood I, and Ogawa J. Binocular sensory fusion is limited by spatial resolution[J]. Vision Research, 1984, 24(7):661-665.

[8] 王勤, 王琼华, 刘春玲. 视差与空间频率对自由立体显示器观看舒适度的影响[J]. 光电子·激光, 2012, 23(8): 1604-1608.Wang Qin, Wang Qiong-hua, and Liu Chun-ling. Effects of parallax and spatial frequency on visual comfort in autostereoscopic display[J]. Journal of Optoelectronics, 2012,23(8): 1604-1608.

[9] Lambooij M, IJsselsteijn W A, and Heynderickx I. Visual discomfort of 3-D TV: assessment methods and modeling[J].Displays, 2011, 32(4): 209-218.

[10] Choi J H, Yun M J, Kim A R, et al.. Visual comfort measurement for 2D/3D converted stereo video sequence[C].2012 3DTV-Conference: The True Vision - Capture,Transmission and Display of 3D Video (3DTV-CON 2012),Zurich, Switzerland, 2012: 1-4.

[11] Kim D and Sohn K. Visual fatigue prediction for stereoscopic image[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(2): 231-236.

[12] Sohn H, Jung Y J, Lee S, et al.. Predicting visual discomfort using object size and disparity information in stereoscopic images[J]. IEEE Transactions on Broadcasting, 2013, 59(1):28-37.

[13] Itti L, Koch C, and Niebur E. A model of saliency based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1998, 20(11): 1254-1259.

[14] Hou X D and Zhang L. Saliency detection: a spectral residual approach[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Minnesota, USA,2007: 1-8.

[15] Harel J, Koch C, and Perona P. Graph-based visual saliency[J]. Advances in Neural Information Processing Systems, 2007, 19: 545-552.

[16] Wang J L, Silva M, Callet P L, et al.. A computational model of stereoscopic 3D visual saliency[J]. IEEE Transactions on Image Processing, 2013, 22(6): 2151-2165.

[17] Percival A. The zone of comfort: predicting visual discomfort with stereo displays[J]. Journal of Vision, 2011, DOI:10.1167/11.8.11.

[18] 马恒, 贾传荧, 刘爽. 基于空间频率的图像融合方法[J]. 计算机工程与应用, 2005, 41(31): 215-218.Ma Heng, Jia Chuan-ying, and Liu Shuang. Image fusion based on spatial frequency[J]. Computer Engineering and Applications, 2005, 41(31): 215-218.

[19] Sohn H, Jung J Y, Lee S, et al.. Korea Advanced Institute of Science and Technology. IVY Lab Stereoscopic Image Database[OL]. http://ivylab.kaist.ac.kr/demo/3DVCA/3DVCA.htm, 2013.