一种鲁棒的基于图像对比度的局部特征描述方法

2014-11-18颜雪军赵春霞

颜雪军赵春霞 袁 夏

(南京理工大学计算机科学与工程学院 南京 210094)

1 引言

图像局部特征描述子是近年来计算机视觉领域的研究热点之一,被广泛地应用于图像匹配,目标跟踪,图像检索等视觉应用中[13]-。局部特征描述方法为局部特征点构建鲁棒的邻域信息表示,对尺度、旋转、视角等图像变换,以及噪声、遮挡等因素具有很强的适应性。局部特征描述子研究一个基本问题是:如何在特征点邻域内寻找到相关信息并对其进行有效的编码[4],本文将着重探讨局部特征描述子的构建方法。

目前,研究者已经提出多种局部特征描述方法来定量化描述特征区域的形状和纹理特性。最为典型的特征描述子是Lowe提出的SIFT特征[1],其在特征点邻域内构建 3维梯度方向直方图,产生128维描述向量。SIFT描述子对图像尺度变换与旋转具有不变性,而且对光照变化,噪声等也有较强的适应能力。Mikolajczyk等人[5]在2005年对各种描述子作了全面的分析后发现,采用梯度信息的SIFT[1]和GLOH明显优于其它描述子。但同时研究者们发现计算构建梯度信息是特征描述子构建中较为耗时的步骤,而利用灰度信息构建特征描述子也是一个有效途径。文献[6]提出了基于CS-LBP的局部特征区域描述方法,CS-LBP仅考虑了像素间比较的符号差,因此计算速度更快。Gupta等人[7]提出一种基于三值编码CS-LTP的特征描述子。此外,近年来基于灰度强度序列的特征描述子还有LIOP描述子[8],MRRID描述子[9]等等。虽然这类局部特征描述方法在计算效率上一般都优于 SIFT方法,但特征描述向量维数也都达到128维甚至更高。

Calonder等人[10]通过比较像素对强度来构建BRIEF(Binary Robust Independent Elementary Features)特征描述子,BRIEF采用位向量的方式编码,存储效率明显提高。但位向量编码方式导致BRIEF只能用Hamming距离来计算特征间距离,很难对搜索速度进行优化。此外,Takacs等人[11]发现采用BRIEF描述子的ORB[12]在匹配性能明显弱于 SIFT方法。文献[4]提出了对比度上下文直方图(Contrast Context Histogram, CCH),该描述子在计算速度以及特征维数方面都明显优于 SIFT描述子,但在匹配性能上略弱于SIFT。本文针对CCH存在的性能问题,提出一种新的基于对比度的局部特征描述方法,即独立元素对比度直方图(Independent Elementary Contrast Histogram,IECH)描述子。实验结果表明,本文方法匹配性能较CCH有明显的提高,与SIFT性能相当。

2 IECH描述子设计

本文先介绍与分析CCH描述子[4]和BRIEF描述子[10]的构造方法,并在此基础上,提出本文的独立元素对比度直方图(IECH)描述子的构造方法。

2.1 CCH描述子

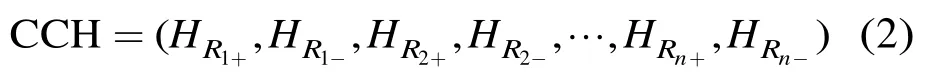

CCH描述子在极坐标下对局部特征的环形区域进行划分。图1所示为文献[4]中建议的划分方式,以中心点Pc为中心,在极径方向将区域划分成4个环形(或圆形),再在极角方向按照 8个方向进行划分。因此,区域被划分成32个互不相交的子区域。在每个子区域中统计2维正负对比度直方图:

n为子区域个数,最终的向量维数为2n×,按照文献[4]中采用的区域划分方式,CCH描述子的维数为64维。为消除线性光照变化的影响,需要归一化成单位向量。

2.2 BRIEF描述子

BRIEF特征描述子表现为一个特定长度的位向量,考虑邻域像素块,则位向量的值可以通过式(3)计算:

2.3 IECH描述子构造方法

本文采用 DoG检测算法获得特征点局部特征像素区域。为使得构建的描述子具有旋转不变性,IECH描述子需要将区域旋转至特征主方向上。采用本文2.1节CCH所采用的划分方式(图1)将像素块分割成32个子区域。按照Huang的建议,在采用4个环形区域( 3r= )的情况下,像素块的半径为,即特征区域大小为4141×。

在每个子区域中,统计IECH直方图:

图1 以Pc为中心的64维CCH描述子局部区域划分方式

式(5)采用与式(1)相同的统计方法,但对比度计算方法不同。在CCH中,计算的是区域i内所有像素的灰度强度iI与中心像素Pc之间的对比度强度。我们认为,CCH的对比度计算依赖Pc像素的灰度稳定性,Pc的细微变化都会造成最终CCH描述向量的数值变化。而在图像变换以及噪声的影响下,特征检测算法无法保障Pc的稳定性。此外,为了获取更多的像素块空间信息,计算区域i内所有像素与随机选择的像素点集合b的灰度强度Ib之间的对比度强度,并进行直方图统计。

最后,将直方图统计结果构建成如式(6)所示IECH描述向量:

然后将式(6)归一化成单位向量来消除线性光照变换的影响。

IECH描述子在构建过程中引入了BRIEF描述子中相似的像素对选择方法,但两者之间存在明显的差异。按照2.2节关于像素点对集合(,)a b的定义,在IECH中,点集a为区域内像素点的遍历,点集b采用 BRIEF算法采用的随机采样策略在区域内采样产生。在半径为20.5的像素区域内,IECH实际需要的点对数为。当集合b中的元素全部为邻域中心点Pc时,IECH描述子退化成CCH描述子。

3 实验结果与分析

为验证本文算法的性能,本节在 VS2008环境下实现对SIFT, SURF, CCH和IECH的对比实验。实验采用Mikolajczyk数据集[5]和一个小型图像数控库。匹配结果采用查全率-查错率(Recall vs.1-Precision, RP)曲线来评价算法性能,特征相似性采用欧式距离来度量,采用最近邻准则(Nearest Neighbor)来决定特征之间的匹配结果。

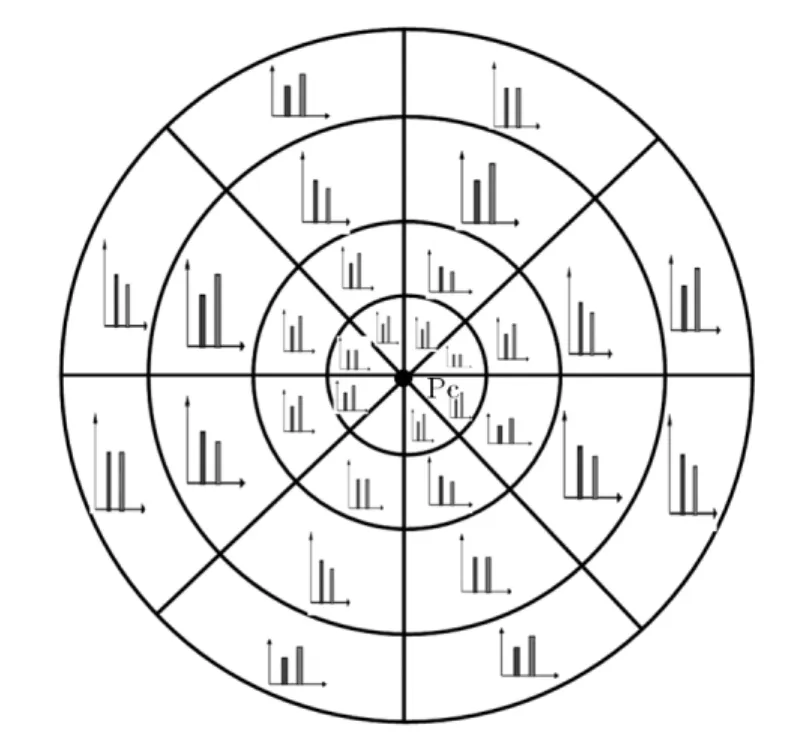

3.1 IECH中的测试点集的选择

如第2.3节所述,在IECH中使用的像素点对集合(,)a b中,点集b通过采样选取。参考 BRIEF算法,本文采用如下的采样策略:

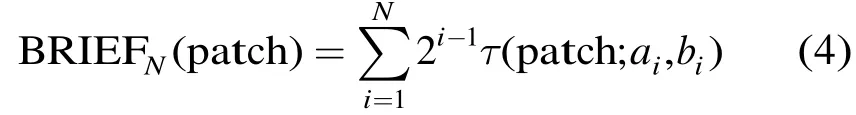

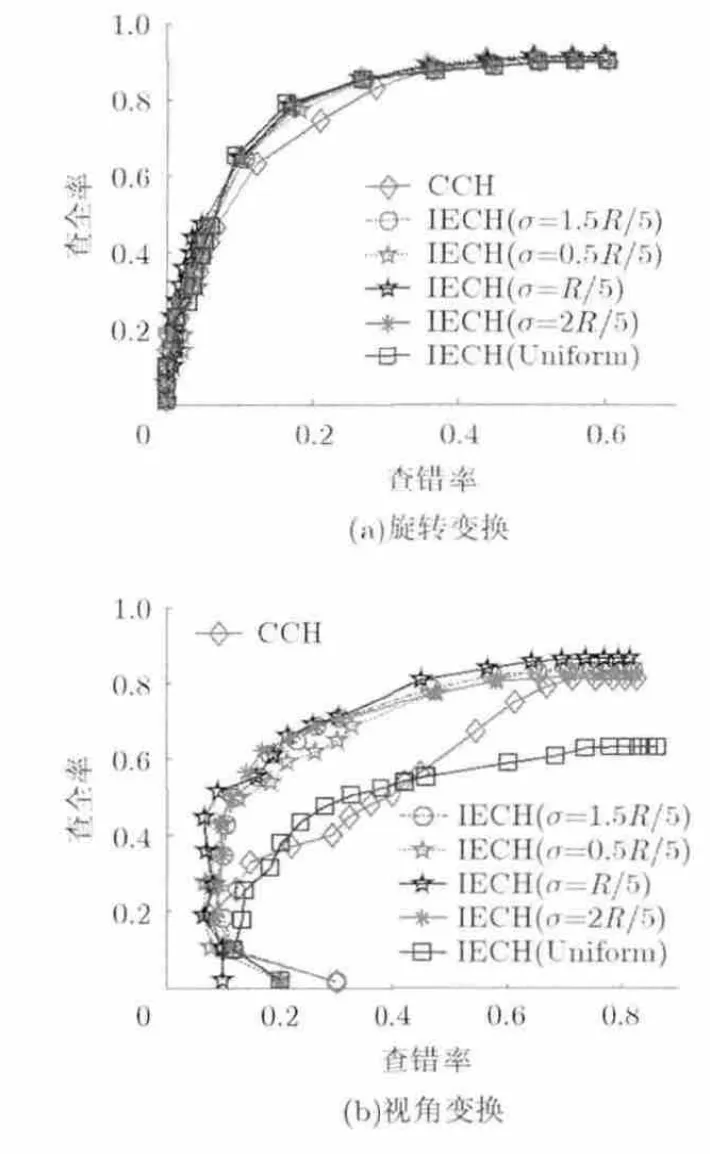

此外,在策略(2)中,采用多个σ值来评价其对IECH描述子性能的影响。选取旋转变换和视角变换两组图像来做测试,结果如图2所示。在采用高斯采样的方法中, 除时性能略差外,其它基本相当。采用均匀分布采样的IECH在两组图像测试中呈现完全不同的结果,在旋转变换中效果最好,在视角变换中弱于采用高斯采样的方法。如图 2(a)在图像旋转变换中,特征区域经主方向旋转之后几乎完全相同,点集b对的覆盖范围越大,越能提高生成特征的独特性。如图2(b)在视角变换中,特征点邻域包含的灰度信息并不一致,均匀采样的IECH虽然具有较好的独特性,但会加大一致特征间的距离,增加误匹配的风险。结合图2的结果,在后续的实验中,采用策略(2)且取的高斯采样来产生点集b。

3.2 图像匹配实验

Mikolajczyk数据集[5]中的测试图像包含尺度,旋转,视角,模糊,光照和JPEG压缩共6种图像变换,能较为全面地评价描述子在各种图像变换下的性能。对比算法采用标准的 SIFT, SURF[13]和CCH。实验中,SIFT特征维数为 128维,SURF,CCH和IECH均为64维。

在尺度和旋转变换中,New Nork图像只包含纯旋转,Bark图像包含4倍因子左右的尺度变换。如图3所示,在纯旋转的New Nork图像中,低查错率的情况下,CCH和SURF方法的响应率明显低于SIFT方法和IECH方法。在尺度变换中,4种方法的性能较为接近。

图4给出自然场景Trees和人工场景Bikes两组模糊变换图像的特征描述方法匹配结果。如图 4(a)和图4(b)所示,CCH方法在两组测试图像中均弱于IECH和SIFT方法,而在Trees数据集上,SIFT也要明显好于本文提出的 IECH。模糊变换会将图像本身的边缘纹理信息弱化,这种弱化在自然场景中更为明显,造成像素点区域的灰度强度在很小的范围内变化。较远像素间的对比度值不能较好地表现这种信息,而 SIFT采用的梯度统计方法考虑的相邻像素间的灰度值变化。SURF在模糊变换中优于CCH描述子,这与SURF采用的Haar小波分量与梯度一样考虑的是相邻像素间灰度变换有关。

在图5(a)的光照变换和图5(b)的JPEG压缩变换实验中,4种方法都显示了较好的匹配性能。

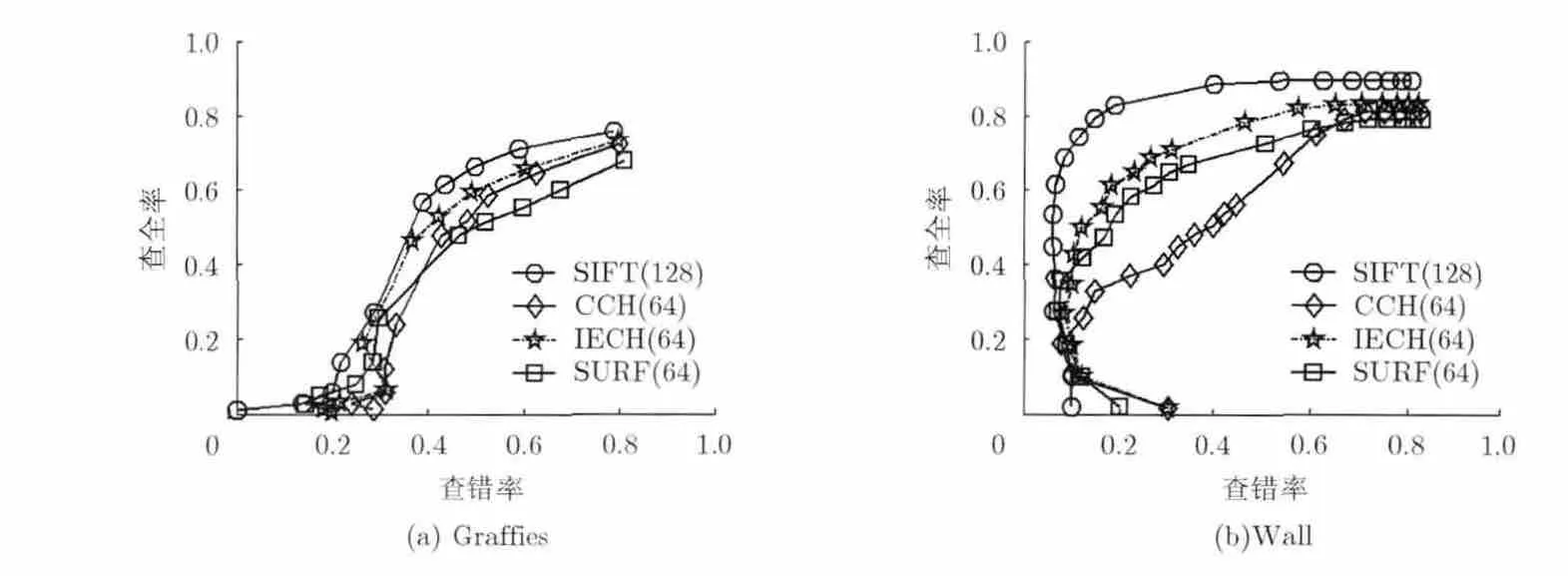

在视角变换中,我们测试4种描述子在大约50度视角变换下的结构图像(Graffies)和纹理图像(Walls)中的性能。由于在结构图像中,最近邻匹配策略产生的RP曲线不存在水平曲线,所以本文在Graffies数据集中采用最近邻-拒绝域的匹配策略,结果如图6(a)所示,SIFT和IECH的结果优于CCH和SURF。在图6(b)的纹理图像中,IECH比CCH方法的性能有明显改进,但也低于SIFT。SURF描述子在纹理图像中与本文方法较为接近。正负对比度在获取纹理信息方面存在一定的不足,而梯度和Haar小波响应能更好地表现纹理信息。

图2 点集b的选择对特征描述方法性能的影响

图3 旋转与尺度变换效果图

图4 模糊变换效果图

图5光照变换和JPEG压缩效果图

图6视角变换效果图

总的来说,本文的IECH描述子在多种图像变换中较 CCH描述子有明显的提高,尤其克服了CCH描述子在低查错率下响应率低,纹理和模糊图像性能较差的问题。在与SURF描述子的对比中,IECH描述子的表现优于SURF或相当的匹配性能。IECH描述子性能跟SIFT方法较为接近,虽然在各种图像变换中IECH性能都无法优于SIFT方法,但考虑到 SIFT的高维特征能保留更多的区域信息以提高其性能,IECH描述子在采用64维特征时能获得较好的匹配性能,在存储受限的应用中具有较高的实用价值。

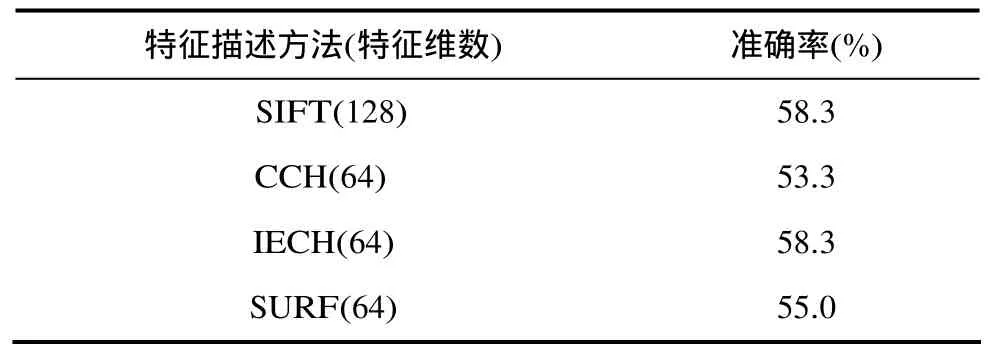

3.3 图像检索实验

本文在一个小型的图像检索数据库[14]中测试SIFT, SURF, CCH以及IECH的检索性能。该数据库包含10个场景30幅图像。检索性能采用统计得分的方法计算,依次将每张图像作为被检索图像,其余作为测试图像。查找与被检索图像最相似的两张图像,如果检索到的两张图像与被检索图像为同一组图像,则得2分;只有一张图像与被检索图像在同一组则得1分;否则,不得分。描述子的检索性能可以用其得分除以总分(60)得到。

采用阈值来决定特征之间的匹配,当两个特征之间距离小于阈值的时候,认为是一对匹配。阈值匹配有利于提高特征匹配速度,当特征距离小于阈值时直接返回其匹配,不需要遍历该图像所有的特征。表 1给出了 SIFT, SURF, CCH和本文方法IECH在图像检索实验中的检索准确率,本文方法在图像检索实验中可以达到与 SIFT相同的检索准确率,这是因为IECH本身与SIFT性能较为接近。CCH和SURF在图像变换实验中明显弱于SIFT和IECH方法,在图像检索中容易引入更多的误匹配,因此在检索准确率上要低于其它两种方法。

表1 图像检索准确率

3.4 算法运行时间测试

对检索实验中所有图像进行描述子生成与匹配来估算特征描述方法的计算效率。将特征生成次数归一化到1000次,特征匹配次数归一化到1000000次后的各算法运行时间如表2所示。IECH和CCH的特征生成速度要明显快于SIFT和SURF方法,这是由于SIFT包含反切计算,而IECH和CCH只需进行像素间的对比度计算。SURF描述子生成单位像素两个方向的Haar响应需要14次加减运算。IECH和CCH在单位像素上计算对比度值只需要1次减法运算。这也是IECH和CCH生成速度快于SURF的原因。IECH在计算速度上略慢于CCH(每1000个特征慢15 ms)。CCH与IECH的差别在于计算对比度的方法不同,时间复杂度完全相同。这是由于在IECH中,计算对比度所需的查找表很难整个装入CPU的Cache中,计算过程中容易产生Cache命中失败需要访问内存的问题,因此速度上会慢于CCH描述子,而且单位特征0.015 ms的时间差距在大多数应用中可以忽略。在特征匹配速度的对比中,64维的SURF, CCH和IECH方法在匹配速度上明显快于128维的SIFT。

表2 特征描述生成与匹配时间

3.5 IECH性能分析

以上实验表明,IECH相比于CCH具有明显的性能优势。本文认为这是由于CCH的对比度计算过度依赖Pc像素的灰度值,Pc的细微变化都会造成CCH描述向量的数值变化。在IECH中,计算对比度的像素点由Pc换成一个像素点集合,因此单一像素点的灰度变化对IECH影响相对较小。

本实验在描述子生成过程中添加噪声,评估CCH和IECH描述子在不同噪声水平下的性能。图7(a)的实验中,直接对图像添加高斯白噪声,噪声不仅对描述子生成有影响,也会影响特征点的定位精度。图7(a)给出了IECH(深色虚线)和CCH(浅色实线)在不同噪声水平下的匹配性能,相同的噪声水平采用相同颜色的曲线表示,如图 7(a)所示在同等噪声水平下,IECH均优于CCH描述子。

为进一步验证灰度强度变化对描述子性能的影响,对原始图像来产生局部特征点,对像素块添加均匀分布的随机噪声,然后分别产生IECH和CCH描述子,结果如图 7(b)所示。结果表明,IECH的优势更为明显,在添加了在[8,8]- 范围内随机采样的白噪声情况下,IECH性能都略优于未添加噪声的CCH。

以上实验表明,IECH对噪声以及像素块灰度变化的影响更为鲁棒,而CCH由于对比度计算依赖中心像素灰度,使得特征点定位误差和噪声等因素都容易造成CCH性能的下降。

4 结束语

图7 IECH性能分析

本文借鉴 BRIEF描述子中随机采用像素对的思想和CCH描述子低维数,计算快速的特点,提出了一种鲁棒的低维数局部特征描述方法,即 IECH描述子。实验结果表明,IECH采用低维数(64维),具有更快的生成速度,且能够达到与 SIFT相当的匹配性能。与SURF和CCH描述子相比,IECH描述子在各种图像变换中均表现出优于或相当的匹配性能,IECH描述子在低查错率下具有更高的响应率,并且在噪声,模糊变换,纹理图像等图像变换中的表现更为鲁棒。图像检索实验也验证了本文算法的有效性。在未来的工作中,我们将把IECH算法应用到移动机器人平台上,实现机器人的实时视觉导航和视觉定位与地图创建(SLAM)等视觉应用的特征匹配中。

[1] Lowe D. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004,60(2): 91-110.

[2] Barreto J P andVasconcelos F. sRD-SIFT: keypoint detection and matching in images with radial distortion[J]. IEEE Transactions on Robotics, 2012, 28(3): 752-760.

[3] Tian Qi, Zhang Shi-liang, Zhou Wen-gang, et al.. Building descriptive and discriminative visual codebook for large-scale image applications[J]. Multimedia Tools and Applications,2011, 51(2): 441-477.

[4] Huang C R, Chen C R and Chung P C. Contrast context histogram: an effcient discriminating local descriptor for object recognition and image matching[J]. Pattern Recognition, 2008, 41(10): 3071-3077.

[5] Mikolajczyk K and Schmid C. A performance evaluation of local descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(10): 1615-1630.

[6] Heikkila M, Pietikainen M, and Schmid C. Description of interest regions with local binary patterns[J]. Pattern Recognition, 2009, 42(3): 425-436.

[7] Gupta R, Patil H, and Mittal A. Robust order-based methods for feature description[C]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, San Francisco, 2010: 334-341.

[8] Wang Z, Fan B, and Wu F. Local intensity order pattern for feature description[C]. Proceedings of the IEEE International Conference on Computer Vision, Barcelona, 2011: 603-610.

[9] Fan B, Wu F, and Hu Z. Rotationally invariant descriptors using intensity order pooling[J]. IEEE Transactions on Pattern analysis and Machine Intelligence, 2012, 34(10):2031-2045.

[10] Calonder M, Lepetit V, Strecha C, et al.. Brief: binary robust independent elementary features[C]. Proceedings of the European Conference on Computer Vision, Heidelberg, 2010:778-792.

[11] Takacs G, Chandrasekhar V, Tsai S, et al.. Rotation invariant fast features for large-scale recognition[C]. SPIE Optical Engineering Applications. International Society for Optics and Photonics, 2012: 84991D-84991D-10.

[12] Rublee E, Rabaud V, Konolige K, et al.. ORB: an efficient alternative to SIFT or SURF[C]. Proceedings of the IEEE International Conference on Computer Vision, Barcelona,2011: 2564-2571.

[13] Bay H, Tuytelaars T, and Van Gool L. Surf: speeded up robust features[C]. Proceedings of the European Conference on Computer Vision, Heidelberg, 2006: 404-417.

[14] Ke Y and Sukthankar R. Test image dataset. http://www.cs.cmu.edu/~yke/pcasift/, 2004, 4.