多维题组效应Rasch模型*

2014-02-02詹沛达王文中王立君李晓敏

詹沛达 王文中 王立君 李晓敏

(1浙江师范大学心理系, 金华 321004) (2香港教育学院评估研究中心, 香港)

1 引言

在实际心理或教育测验中, 经常出现多个项目共用相同刺激(stimulus)的情况, 这种受共同刺激影响和制约的项目集合通常被称为题组(testlet)(Wainer & Kiely, 1987)或项目束(item bundle)(Rosenbaum, 1988)。使用题组可以节约考生阅读材料的时间, 提高测验的效率, 提供逻辑关系更强的材料(Bradlow, Wainer, & Wang, 1999; Wainer,Bradlow, & Du, 2000; DeMars, 2006; Wainer,Bradlow, & Wang, 2007; Huang & Wang, 2013)。目前, 如全国硕士研究生入学统一考试、CET、TOEFL、GRE、PISA等均涉及了大量的题组, 可以说测验已经出现了由采用大量的独立多选题向采用题组的过渡趋势(Wainer et al., 2007), 对题组进行研究的必要性日显重要。

当测验存在题组时, 由于嵌在题组内的项目共用相同的题组刺激, 这时题组项目反应间就存在一定的相依性, 即局部项目依赖性。若直接使用标准项目反应模型(standard item response model)去拟合存在局部项目依赖性的反应数据会导致诸多问题,如:高估测验精度(低估测验的标准误)、项目参数的偏差估计、增加测验等值误差、 DIF检验不合理等(Wang & Wilson, 2005a; Wang & Wilson, 2005c;Li, Bolt, & Fu, 2005; Marais & Andrich, 2008;Fukuhara & Kamata, 2011; DeMars, 2012; He, Li,Wolfe, & Mao, 2012; Jiao, Kamata, Wang, & Jin,2012; Huang & Wang, 2013; 吴锐, 丁树良, 甘登文,2010; 郑蝉金, 郭聪颖, 边玉芳, 2011; 刘玥, 刘红云, 2012)。此外, 当局部项目依赖性适中或题组项目占全部测验项目的比例较小时(Wainer, 1995), 也可将整个题组看成一个多级评分的超级项目(super item) (Sireci, Thissen, & Wainer, 1991), 并采用多级评分模型去拟合超级项目的反应数据(Cook, Dodd,& Fitzpatrick, 1999; Marais & Andrich, 2008)。虽然该方法能在一定程度上减轻局部项目依赖性对参数估计精度和信度的影响, 但仍存在如:无法区分在超级项目上得分相同的反应组合、低估测验信度、不适用于基于题组的计算机化自适应测验等一系列问题。之后, 为了从题组中获得更详细的信息且更合理地处理题组效应, 研究者们相继开发出了一系列题组反应模型(testlet response models), 如:双参数逻辑斯蒂克贝叶斯题组模型(two-parameter logistic Bayesian testlet model, 2-PLBTM) (Bradlow et al., 1999)、三参数逻辑斯蒂克贝叶斯题组模型(3-PLBTM) (Wainer et al., 2000)、Rasch题组模型(Rasch testlet model, RTM) (Wang & Wilson, 2005c)等。近期, 随着如高阶题组模型(higher-order testlet model) (Huang & Wang, 2013)、多水平题组模型(multilevel testlet model) (Jiao et al., 2012)等一些新的题组反应模型的提出, 题组反应模型可处理的测验情况丰富了, 功能增强了, 为题组反应模型在实际测验中的应用和推广做出了贡献。

但至今, 人们对题组的认识仍局限于一份阅读材料或已知条件后配上若干个项目(如:英语测验中的阅读理解题、数学测验中的分步证明题等)这样一种常见的简单的直接的捆绑式题组(bundledtestlet)形式。通常, 一个项目是无法被同时捆绑在两个阅读材料或已知条件之下的, 所以同一个项目也不会同时被归入两个捆绑式题组之中, 进而导致被试对捆绑式题组中的不同项目间的反应也仅依赖于被试对该题组材料的整体认知上, 即在捆绑式题组中的项目反应仅受到了题组材料这1种共同刺激的影响。回顾国内外关于题组的已有研究, 也均假设题组项目反应仅受到1个共同刺激的影响。然而在实际测验中项目反应可能同时受到多个共同刺激的影响, 而这又是已有题组反应模型所无法处理的。

对此, 本文首先诠释了“题组(testlet)”的本质(见 2.1), 并基于此提出了项目内多维题组效应(见2.2.2)。为了实现对项目内多维题组效应的处理, 本研究又基于Rasch模型同时开发了二级评分和多级评分的多维题组效应 Rasch模型(见 2.3), 并采用ConQuest (Wu, Adams, Wilson, & Heldane, 2007)来实现新模型的参数估计(见 3)。全文共设计了 2个包含项目内多维题组效应的模拟测验(见4.1和5.1),并对比研究了新模型、Rasch题组模型(RTM)和分部评分模型(PCM) (Masters, 1982)三者在处理模拟测验数据时的差异, 以探究新模型对项目内多维题组效应的分析处理情况。

2 多维题组效应Rasch模型的开发

2.1 “题组(testlet)”的本质

Wainer和Kiely (1987)指出“题组是与某单一内容域相关的一组项目(A testlet is a group of items related to a single content area)”。Bradlow 等(1999)将题组描述为“基于一个共同刺激的一组选择题(Coherent groups of multiple choice items based on a common stimulus)”。Wang 和 Wilson (2005c)将题组描述为“受到一个共同刺激影响的项目束(A bundle of items that share a common stimulus)”。Wainer等(2007)在Testlet Response Theory and its Applications

一书中将题组描述为“一个被共同管制的测验项目包(A packet of test items that are administered together)”。Brandt (2008)将题组描述为“一个测验中包含共同建构元素的项目集合(A subset of items in a test that have a common structural element)”。Ip (2010)将题组描述为“关于某单一主题的项目集合(An aggregation of items on a single theme)”, 等等。从这些描述中可以提取出两个核心元素:(1)项目集合、(2)共同刺激。如图 1所示, 从项目集合到题组的转变, 其关键在于该项目集合是否存在共同刺激以及该共同刺激是否对被试的项目反应产生了影响, 而对于项目集合以及共同刺激的形式并不局限于捆绑式题组中的形式。换句话说, “集合”并不只是形式上的集合, 它更是一种概念上的集合; 集合中的项目并不一定要捆绑在一起。同样, “共同刺激”也不仅限于一篇阅读材料(内容), 它还可以是相同的单元内容(如:数学测验中考查“四则运算”单元的所有项目)、相同的题型(如:英语测验中所有的听力题)、相同的知识点(如:科学测验中所有考查“重力”的项目)、相同的先验猜测概率(如:数学测验中所有的四择一选择题), 等等。

图1 项目集合与题组的关系

为了更好地说明题组和题组项目的关系, 这里举一个关于家庭和家庭成员的例子:将家庭看作题组, 将家庭成员看作题组项目。当孩子没有和父母住在一起的时候, 我们能说他们不是一个家庭吗?答案显然是否定的, 因为他们之间存在一个共同刺激—— 血缘关系。其实, 家庭成员间的这种共同刺激是多样的, 它既可以是血缘关系也可以是婚姻关系、认养关系等等。同理, 一个项目集合之所以能被称为题组, 并不是因为这些项目被捆绑在了一起, 而是因为它们之间存在一个共同刺激, 且这种共同刺激的形式也是多样的, 可以是单元、题型、知识点甚至是评分者。但在已有研究中, 研究者们只关注到了相对明显的捆绑式题组, 而忽略了题组的本质。

总结前人研究并综上所述, 本研究认为:当多个项目间存在共同刺激且被试对这些项目的反应受到该共同刺激影响时, 这些项目组成的集合就可被称为题组—— “题组(testlet)”的本质是一个存在共同刺激的项目集合。

2.2 题组效应

题组效应是指当被试对题组项目的反应依赖于被试对题组刺激(共同刺激)的整体认知时, 项目反应间存在的一种相依性(詹沛达, 王文中, 王立君, 2013), 即题组效应会导致项目反应间出现局部项目依赖性; 把图 1中“被试对项目集合的反应受到共同刺激的影响”和“项目反应间出现局部项目依赖性”结合起来, 就构成了题组效应。

2.2.1 项目内单维题组效应

如上文所述, 已有关于题组反应模型的研究均假设题组项目反应仅受到(目标能力θ

外)1个共同刺激的影响, 如图2(a), 7个项目被归纳到2个题组之中; 被试在每个项目上的反应仅受到1个题组效应的影响, 且不同的题组效应间相互独立(Wang &Wilson, 2005c; Wainer et al., 2007; DeMars, 2012;Huang & Wang, 2013)—— 即假设从目标能力中抽离出1个干扰因素(题组效应)就能够满足广义局部独立性假设。则可将这类题组效应称为项目内单维题组效应(within-item unidimensional testleteffect)。2.2.2 项目内多维题组效应

实际测验中某项目可能因为与不同的项目共用了不同的刺激而被同时划分到不同的题组之中,进而被试在该项目上的反应就会同时受到多个共同刺激的影响, 即同一项目反应中包含了多种题组效应, 如图 2(b)。与项目内单维题组效应不同, 该情况假设从目标能力中抽离出有限个题组效应才可满足广义局部独立性假设。则可将这类题组效应称为项目内多维题组效应(within-item multidimensional testlet-effect)。

图2 项目内单维/多维题组效应示意图。θ表示被试能力, γ表示题组效应, □表示项目

此外应明确的是无论是项目内单维题组效应还是项目内多维题组效应, 它们都属于项目内多维度(within-item multidimensionality) (Adams, Wilson,& Wang, 1997)。

2.3 多维题组效应Rasch模型

与项目内单维题组效应(见 2.2.1)相对应, 将仅包含一个题组效应参数的题组反应模型统称为单维题组效应模型(unidimensional testlet-effect models)。单维题组效应模型包括现有的全部题组反应模型(如:RTM 可重新命名为单维题组效应Rasch模型)。通常也将单维题组效应模型视为双因子模型(bi-factor model) (Gibbons & Hedeker,1992)的约束模型(Li, Bolt, & Fu, 2006; Wainer et al., 2007; Rijmen, 2009; DeMars, 2006, 2012)。因此本研究将双因子模型与单维题组效应模型视为同物, 不再赘述。

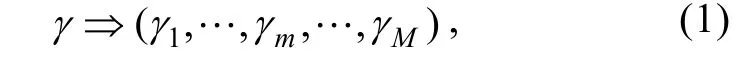

题组反应模型的核心观念是应用题组效应参数把不可忽略的题组效应与目标能力进行分离, 进而实现对目标被试能力或项目参数更为准确的估计(詹沛达等, 2013)。因此, 当同一项目反应中包含了项目内多维题组效应时, 就需要将不可忽略的多个题组效应从目标能力中抽取出来, 进而需要将单维题组效应参数拓广至多维题组效应向量, 有:

因为Rasch模型具有数据的线性特性、模型参数具有充分统计量、参数估计对样本量需求较小、被试与项目共用同一量尺、参数分离等优势(王文中, 2004; Wang, Wilson, & Adams, 1997; 晏子,2010; Bond & Fox, 2007)而被称为“心理科学领域内的客观测量”, 所以本研究以 Rasch模型为基础,提出了可处理项目内多维题组效应的多维题组效应Rasch模型(multidimensional testlet-effect Rasch model, MTERM)。二级评分的 MTERM (记为dMTERM)的条件反应可描述为:

p

和p

分别表示被试n

在项目i

上答对和答错的概率,θ

为被试n

的能力参数,b

为项目i

难度参数。当被试的项目反应受到某潜因素的影响且该影响随着被试的不同而不同时, 可将该潜因素称为随机效应(random-effect), 则被试能力即可被看作一种随机效应(Wang & Wu, 2011)。与随机效应对应的是固定效应(fixed-effect), 即被试的项目反应受到某潜因素的影响不会随着被试的变化而变化(Wang & Wilson, 2005b), 则项目参数即可被看作一种固定效应。自Bradlow等(1999)提出2-PLBTM起, 题组效应就被看作一种随机效应; 与之相对应,项目内多维题组效应就可被看作项目内共存的多种随机效应。

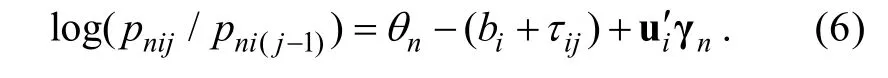

由于实际的心理与教育测验通常是一种既包含二级评分项目(选择题、填空题等)也包含多级评分项目(应用题、问答题等)的混合式测验, 所以题组内也可能既包含二级评分项目也包含多级评分项目(Wang, Bradlow, & Wainer, 2002)。Wang等(2002)在二级评分的3PLBTM和GRM (Samejima,1969)中分别加入题组效应而将两者结合, 提出了多级评分的广义贝叶斯题组模型(general Bayesian model for testlets)。Wang 和 Wilson (2005c)同时提出了二级评分和多级评分的RTM。Li, Li和Wang(2010)将 GPCM (Muraki, 1992)与广义题组模型(general testlet model) (Li et al., 2006)相结合提出了广义多级评分题组模型(general polytomous testlet model)。Huang和Wang (2013)也同时提出了二级评分和多级评分的高阶题组模型。为满足现实测验的需求, 本研究将 dMTERM (见公式(3))与 PCM(Masters, 1982)相结合提出多级评分的MTERM (记为 pMTERM):

p

和p

分别表示被试n

在项目i

上得j

分和(j

‒1)分的概率,b

为项目i

第j

个步骤难度参数(step difficulty parameter)。取:

b

为项目i

的全局难度(overall difficulty)或定位参数(location parameter),τ

为项目i

的第j

临界参数。此时, 公式(4)可重新描述为:

τ=τ

)的李克特式项目或评定量表项目, 公式(6)可转换为:

3 多维题组效应Rasch模型的参数估计

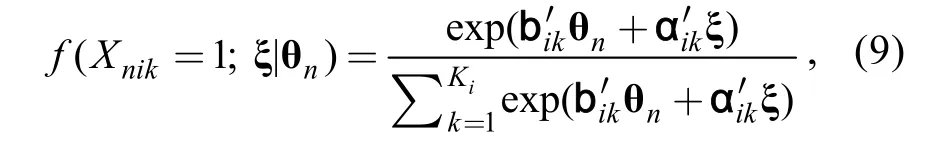

目前, 有不少用于实现多维项目反应模型参数估计的软件, 如:ConQuest (Wu et al., 2007)、WinBUGS (Spiegelhalter, Thomas, & Best, 2003)、Mplus (

Muthén & Muthén, 2012)、IRTPRO (Cai, De Toit, & Thissen, 2011)、BMIRT (Yao, 2003)等。不同的软件有不同的适用范围, 比如:ConQuest仅限于分析Rasch框架下的项目反应模型, 而Mplus

仅限于分析项目反应函数满足累积 logits分布的模型(Agresti, 2010):可适用于2-PLM或GRM, 但不适用于3-PLM、PCM或GPCM (Huang & Wang, in press)。据2.3可知, MTERM可看成RTM的拓广模型,所以本研究使用ConQuest来实现MTERM的参数估计是一个直接且合理的选择。此外, 亦可使用WinBUGS、基于R或Matlab的自编程序来实现参数估计。而由于pMTERM (见公式(3))是基于PCM建构的, 所以Mplus

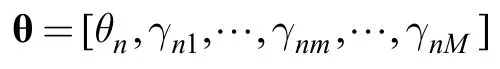

不适用于本研究。多维随机系数多项逻辑斯蒂克模型(multidimensional random coefficients multinomial logit model, MRCMLM) (Adams et al., 1997)是ConQuest的基础, 因此欲使用 ConQuest来实现MTERM 的参数估计就必须进行一系列设定, 以使多维随机系数多项逻辑斯蒂克模型转化(约束)为MTERM。

多维随机系数多项逻辑斯蒂克模型假设, 被试的项目反应受到L

个测验潜因素(Latent factor)的影响, 则L

维测验潜因素向量 θ=(θ,θ,...,θ

)可被认为是一个从多元密度函数g

(θ;α)中随机抽取的代表性样本; 其中α是一个用于描述分布情况的参数向量/矩阵。本研究限定MTERM的多元密度函数g (

)符合正态分布(见公式(7)), 所以有 α≡(μ, Σ)。多维随机系数多项逻辑斯蒂克模型规定被试n

在项目i

上做出第k

类别(category)反应的概率为:

X

=1表示被试n

在项目i

上做出类别k

的反应(否则为0);K

表示项目i

中作答类别的数量; ξ是各项目中各类别对应的难度参数矩阵; b是项目i

上类别k

的得分向量, 可以通过得分矩阵(Scoring matrix)B来获得; α是项目i

上类别k

的设计向量,用于描述ξ中各元素间的线性关系, 可以通过设计矩阵(Design matrix)A来获得。关于多维随机系数多项逻辑斯蒂克模型更详细的内容, 读者可参阅Adams等(1997)和Wu等(2007)等文献。将公式(8)重新描述为:

u,u,...,u

), 当u

=1表示项目i

存在题组效应m

;u

=0表示项目i

不存在题组效应m, m

=1,2,...,M

; 并设定类别指标变量v

(i

=1,2,...I

;j

=1,...,J

-1), 当v

=v

=...=v

=‒1表示项目i

存在第j

类别反应。M

和I

分别表示测验中题组效应数量和项目数量。在多维随机系数多项逻辑斯蒂克模型中对α和b进行自定义:

且有:

依据公式(10)有:

j

=1, 则有:

经过一系列设定(公式(11)~(14)), 可将多维随机系数多项逻辑斯蒂克模型转化(约束)为MTERM,因此可直接使用 ConQuest软件实现参数估计, 而无需重新编写复杂的参数估计程序(基于 MTERM的ConQuest程序可参见本文附录)。这就为新模型在实际应用中的使用和推广带来了极大的方便。

虽然 ConQuest软件已经被用于分析多种Rasch框架内的项目反应模型, 但还没有被用于分析包含项目内多维题组效应的数据。因此, 有必要先探究ConQuest软件是否能为MTERM提供较好的返真性(recovery)。本研究在实验1和实验2中分别设计了两个不同的模拟测验。实验1的主要目的是为探究ConQuest软件是否能为MTERM提供较好的返真性(见4.1)。在模拟测验二中, 设计了一个更加复杂且更接近现实的模拟测验(见 5.1), 并分别采用MTERM、RTM和PCM对模拟测验数据进行了对比分析。

4 实验1

4.1 模拟测验设计

4.1.1 模拟测验设定

(1)模拟测验目标潜质为被试总能力θ

;(2)共包含40题。前10题为非捆绑式题组项目。第11题~第40题包含了3个捆绑式题组;

(3)共考查2个单元内容, 且考虑到内容平衡问题, 将2个单元内容按如下方案设定:第1题~第5题、第31题~第35题和第1个捆绑式题组均考查单元1的内容, 共包含20题; 其余题目考查单元2的内容, 同样包含20题。

基于对上述测验的分析(见图 3), 认为该测验共包含2类题组效应, 每类题组效应中又包含2~3个题组效应, 即, 捆绑式题组效应(bundled testleteffect, 记为 A):γ

、γ

、γ

, 单元题组效应(unit testlet-effect, 记为 B):γ

、γ

, 共 5 个题组效应。

图3 实验1模拟测验设计示意图

4.1.2 被试能力和题组效应参数设定

表1 实验1各项目包含的项目内多维题组效应

4.1.3 项目参数设定

因为 MTERM 同时包含二级评分模型和多级评分模型, 所以模拟测验的项目参数设定将分为两部分进行:

(1)二级评分项目的难度参数整体分布满足b

~U

(‒2, 2);多级评分项目的步骤难度参数整体分布满足b

~U

(‒2.5, 2.5), 均包含3个分数级别(0分,1分,2分), 且各项目的第1临界参数分布满足τ

~U

(‒1, 0)。以上项目参数整体分布的设定范围与实证研究中普遍存在的项目参数分布相符, 且各项目参数是独立生成的, 当然, 如果需要也可以引入多元正态分布(van der Linden, Klein Entink, & Fox, 2010)。

4.2 被试作答模拟

模拟被试作答时, 首先根据参数“真值”和所选用的模型来计算被试n

在项目i

上得j

分的概率P

。其次生成一个随机数r

(0≤r

≤1), 则得分被定义为:r

小于或等于累计概率所对应的最高分数h

, 即:

4.3 评价指标

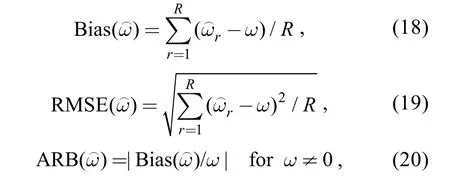

本研究采用平均偏差 Bias指标、均方根误差RMSE、相对偏差的绝对值(the absolute value of relative bias, ARB)做为参数返真性的评价指标, 模拟作答及ConQuest软件分析过程循环R

=50次以减小实验误差:

4.4 实验1结果与结论

4.4.1 实验1结果

实验1结果见表2(限于篇幅原因只列出了部分实验结果), 表中分别列出了dMTERM (见公式(3))和pMTERM (见公式(4))的参数估计返真性结果。整体看, dMTERM和pMTERM的参数估计返真性都很好。其中, 基于dMTERM对随机效应参数(被试能力参数和题组效应参数)的估计, Bias指标值介于[‒0.055, 0.011]之间, RMSE 指标值介于[0.033,0.105]之间, ARB指标值介于[0.001, 0.044]之间。对于项目参数的估计, Bias指标值介于[‒0.022, 0.035]之间, RMSE指标值介于[0.061, 0.090]之间, ARB指标值介于[0.001, 0.256]之间。根据ARB指标值, 大多数参数估计值是可以被接受的。基于 pMTERM对随机效应参数的估计, Bias指标值介于[‒0.013,0.008]之间, RMSE指标值介于[0.031, 0.076]之间,ARB指标值介于[0.001, 0.044]之间。而对于项目参数的估计, Bias指标值介于[‒0.034, 0.024]之间,RMSE指标值介于[0.043, 0.105]之间, ARB指标值介于[0.001, 0.992]之间。根据ARB指标值, 大多数参数估计值也是可以被接受的。

4.4.2 实验1结论

由实验 1结果得知:ConQuest软件能够为MTERM 提供较好的参数估计返真性—— 它为实验2中对比MTERM、RTM和PCM在处理包含项目内多维题组效应数据时的表现提供了前提保证。

5 实验2

5.1 模拟测验设计

5.1.1 模拟测验设定

(1)模拟测验目标潜质为被试总能力θ

;(2)共包含50题, 分为听力(第1题~第20题)、阅读(第 21题~第 48题)和写作(第 49、50题)三类题型。第1题~第10题为非捆绑式题组项目。第11题~第48题包含了4个捆绑式题组。第49、50题为独立的写作题;

(3)共考查 2个单元内容, 考虑到内容平衡问题,将2个单元内容按如下方案设定:第1题~第5题、第11题~第15题、第2个捆绑式题组和第41题~第44题均考查单元1的内容, 共包含24题; 其余题目(除49、50外)考查单元2的内容, 同样包含24题。第49、50题均涉及2个单元的内容;

(4)该模拟测验既包含二级评分项目也包含多级评分项目。第 1题~第 40题均为二级评分项目,第 4个捆绑式题组为三级评分项目(如:一篇阅读材料下面配上多道填空题或问答题), 第 49、50为6级评分项目。

5.1.2 被试能力和题组效应参数设定

表2 模拟测验一结果

图4 实验2模拟测验设计示意图

生成。那么结合5.1.1中的题型设定, 表3给出了模拟测验二中各项目包含的项目内多维题组效应及评分方式。

表3 实验 2各项目包含的项目内多维题组效应及评分方式

5.1.3 项目参数设定

(1)测验前 40题为二级评分项目, 其参数分布同4.1.3;

(2)第41题~第48题的步骤难度参数分布设定为满足U

(‒0.5, 2.5)且第1临界参数分布满足τ

~U

(‒1, 0);(3)第49、50题的步骤难度参数分布设定为满足U

(0.5, 2.5), 定位参数设定为b=b

=1.5且它们的第1临界参数均取自τ

~U

(‒1, 0), 于是有:第2临界参数τ

=τ

+|τ

|/2、第 3 临界参数τ

=τ

+|τ

|/2、第 4 临界参数τ

=τ

+|τ

|/2、第 5 临界参数τ

=τ

+|τ

|/2, 最终有:τ

+τ

+τ

+τ

+τ

=0。5.2 被试作答模拟及评价指标

实验2中的模拟被试作答以及评价指标同实验1中大体一致(见4.2)。所不同的是, 为了能更好地呈现出MTERM、RTM和PCM在处理模拟作答数据时的差异, 在实验2中还添加了1个相对评价指标:即绝对差异均值(the mean of the absolute value of differences, MAD):

ζ

为某评价指标值, X表示某评价指标的数量。5.3 实验2结果与结论

5.3.1 实验2结果

实验2结果见表4 (限于篇幅原因只列出了部分实验结果), 表中分别列出了 MTERM、RTM 和PCM的参数估计返真性结果。

从单个模型的结果看, 其中MTERM对随机效应参数(被试能力参数和题组效应参数)的估计,Bias指标值介于[‒0.085, 0.026]之间, RMSE指标值介于[0.029, 0.104]之间, ARB指标值介于[0.008,0.213]之间。对于项目参数的估计(二级评分项目难度参数、多级评分项目定位参数和临界参数), Bias指标值介于[‒0.038, 0.031]之间, RMSE指标值介于[0.039, 0.149]之间, ARB指标值介于[0.001, 0.752]之间。整体而言, 基于MTERM的参数估计返真性很好, 且根据 ARB指标值, 绝大多数参数估计值是可以被接受的(第43题、第46题和第48题的临界参数接近于0, 导致τ

、τ

和τ

的ARB指标值较大, 下同)。

表4 模拟测验二结果

RTM对随机效应参数的估计, Bias指标值介于[‒0.048, 0.561]之间, RMSE 指标值介于[0.076,0.566]之间, ARB指标值介于[0.038, 1.091]之间。而对于项目参数的估计, Bias指标值介于[‒0.311,0.382]之间, RMSE指标值介于[0.038, 0.386]之间,ARB指标值介于[0.001, 5.339]之间。整体而言,RTM 对随机效应参数的估计表现较差, 由于忽略了γ

和γ

这两类题组效应, 导致 RTM 对θ

和γ

都出现了较大的正偏差估计。而RTM对项目参数的估计表现较好, 且根据 ARB指标值, 大多数项目参数估计值也是可以被接受的。这说明, 如若测验中存在捆绑式题组效应以外的其他题组效应时,仅将捆绑式题组效应进行分离仍会出现一定的参数偏差估计, 且对随机效应参数的估计影响较大,进而导致对被试能力的不准确估计。PCM 对随机效应参数的估计, Bias指标值为0.012, RMSE指标值为0.019, ARB指标值为0.012。而对于项目参数的估计, Bias指标值介于[‒0.039,0.501]之间, RMSE指标值介于[0.036, 0.504]之间,ARB指标值介于[0.037, 20.389]之间。整体而言,PCM 对随机效应参数的估计表现较好, 而对项目参数的估计表现较差, 且根据 ARB指标值, 大多数项目参数估计值也是不可以被接受的(尤其是那些被归属于某个捆绑式题组之中的项目, 其参数估计值偏差更大, 精度更差)。这说明, 采用忽略潜在的题组效应的PCM去分析测验数据时往往会导致项目参数的偏差估计:当“真值”为正数时会产生负偏差, 为负数时会产生正偏差; 即参数估计存在收缩效应(shrunken effect)。这与 Wang和 Wilson(2005b; 2005c)的结论一致。

通过MAD指标值可对3个模型的数据分析结果进行横向对比。对于Bias指标, 三模型的MAD指标值分别为 0.017、0.086和 0.183。对于 RMSE指标, 三模型的 MAD指标值分别为 0.065、0.114和0.197。而对于ARB指标, 三模型的MAD值分别为0.052、0.254和0.717。这说明MTERM的参数估计在Bias、RMSE和ARB这3个指标上的表现均是最好的, RTM的参数估计表现次之, 表现最差的是PCM的参数估计。

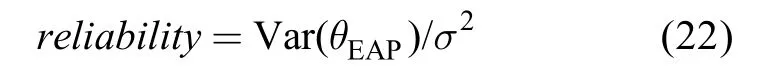

由于 ConQuest软件采用 MMLE, 则测验信度可描述为:

5.3.2 实验2结论

由实验2结果表明:(1)当测验存在项目内多维题组效应, 采用忽略题组效应的标准项目反应模型会导致对项目参数的偏差估计, 高估测验的信度。仅采用RTM把明显的捆绑式题组效应进行分离而忽略其他潜在的题组效应, 同样会导致参数的偏差估计; 其中对被试能力参数估计的偏差大于对项目参数的估计偏差, 另外测验的信度仍会被高估。(2)MTERM相对于RTM和标准项目反应模型更具普适性, 即便当被试作答数据不存在题组效应或只存在项目内单维题组效应时, 测验分析采用 MTERM也能得到较好的参数估计结果。

表5 辅助实验结果

6 总结与展望

随着当今心理与教育领域测验的发展, 测验已经出现了由采用独立多项选择题向采用题组的过渡趋势。为了满足实际测验的需要, 对题组进行研究的必要性日显突出。本文首先对“题组(testlet)”的本质进行了诠释, 并基于此提出了项目内多维题组效应的概念。在认识到关于题组反应模型的已有研究均假设题组项目反应仅受到1个共同刺激的影响而无法处理项目内多维题组效应后, 本研究基于Rasch模型同时提出了二级评分和多级评分的MTERM, 新模型亦可看作是对 RTM 的多维度拓广。全文共设计了2个模拟实验, 实验1结果认为:ConQuest软件能够为 MTERM 提供较好的参数估计返真性, 其为在模拟测验二中对比 MTERM、RTM和PCM在处理包含项目内多维题组效应数据时的表现提供了前提保证。由实验2结果可知:(1)当测验存在项目内多维题组效应, 仅采用 RTM 把明显的捆绑式题组效应进行分离而忽略其他潜在的题组效应, 会导致参数的偏差估计, 其中对被试能力参数估计的偏差大于对项目参数的估计偏差,甚或高估测验信度。(2) MTERM相对更具普适性,即便当被试作答数据不存在题组效应或只存在项目内单维题组效应, 测验分析采用MTERM也能得到较好的参数估计结果。整体来看, MTERM合理、有效, 达到了实验目的。

本研究中的测验分析基于使用3.4GHz的Inter Core i7-3770处理器、8GB的DDR3 1333MHZ内存的个人电脑。每次循环需耗费15分钟~45分钟时长, 该分析速度可适用于分析绝大多数的真实测验数据。

当然, 本研究还存在着些许值得今后进一步探讨的地方, 如:(1)虽然 MTERM 是基于“心理科学领域内的客观测量”—— Rasch模型开发的, 但Rasch模型对测验编制质量和数据质量要求很高,除 PISA、TMISS等国际大型考试外, 现实中已有的测验编制质量和数据质量通常是无法达标的。为了能更好的去拟合现实测验中已有的数据, 今后可尝试对 MTERM 多参数拓广至多维题组效应双参数模型甚至是三参数模型。(2)近期, 多水平题组模型、高阶题组模型等一些新的单维题组效应模型的提出, 为测验编制和分析人员提供了新的理论和模型支持。今后还可尝试将已有的单维题组效应模型拓广至多维题组效应模型, 为题组反应模型在实际测验中的应用和推广做出更大的贡献。(3)目前, 已经有一些基于单维题组效应模型的 CAT研究报告(如: Keng, 2008; Murphy, Dodd, & Vaughn, 2010;Chien & Shin, 2013), 今后亦可尝试探讨或开发基于多维题组效应模型的CAT。

致谢:

感谢两位外审专家对本研究提出的修改意见,你们的付出为提升本文质量提供了极大的帮助。Agresti, A. (2010).Analysis of ordinal categorical data

(2nd ed.). New York: John Wiley & Sons.Andrich, D. (1978). A rating formulation for ordered response categories.Psychometrika, 43

(4), 561–573.Adams, R. J., Wilson, M., & Wang, W.-C. (1997). The multidimensional random coefficients multinomial logit model.Applied Psychological Measurement, 21

(1), 1–23.Brandt, S. (2008). Estimation of a Rasch model including subdimensions.IERI Monograph Series: Issues and Methodologies in Large-scale Assessments,1

, 51–69.Bond, T. G., & Fox, C. M. (2007).Applying the rasch model:Fundamental measurement in the human sciences

(2nd ed.).Mahwah, N.J.: Erlbaum.Bradlow, E. T., Wainer, H., & Wang, X. (1999). A Bayesian random effects model for testlets.Psychometrika, 64

(2),153–168.Cai, L., Du Toit, S. H. C., & Thissen, D. (2011). IRTPRO:Flexible, multidimensional, multiple categorical IRT modeling [Computer software].Chicago, IL: Scientific Software International.

Chien, Y., & Shin, C. D. (2013).An Adaptive-within-testlet Item Selection Method with Both testlet Level and Test Level Content Balancing in CAT

. 2013-05-01, Retrieved from https://www.pearsonassessments.com/hai/Images/tmrs/Research_Report_An_Item_Selection_Procedure_for_testle ts_CAT.pdfCook, K. F., Dodd, B. G., & Fitzpatrick, S. J. (1999). A comparison of three polytomous item response theory models in the context of testlet Scoring.Journal of Outcome Measurement, 3

(1), 1–20.DeMars, C. E. (2006). Application of the bi-factor multidimensional item response theory model to testlet-based tests.Journal of Educational Measurement, 43

(2), 145–168.DeMars, C. E. (2012). Confirming testlet effects.Applied Psychological Measurement, 36

(2), 104–121.Fischer, G. H. (1973). The linear logistic test model as instrument in educational research.Acta Psychologica, 37

,359–374.Fukuhara, H., & Kamata, A. (2011). A bifactor multidimensional item response theory model for differential item functioning analysis on testlet-based items.Applied Psychological Measurement, 35

(8), 604–622.Gibbons, R. D., & Hedeker, D. R. (1992). Full-information bi-factor analysis.Psychometrika, 57

(3), 423–436.Hoogland, J. J., & Boomsma, A. (1998). Robustness studies in covariance structure modeling: An overview and a meta-analysis.Sociological Methods & Research, 26

,329–367.He, W., Li, F., Wolfe, E. W., & Mao, X. (2012, Apirl).Model selection for equating testlet-based tests in the NEAT design: An empirical study

. Paper presented at the 2012 Annual NCME Conference.Huang, H.-Y., & Wang, W.-C. (2013). Higher-order testlet response models for hierarchical latent traits and testlet-based items.Educational and Psychological Measurement, 73

, 491–511.Huang, H.-Y., & Wang, W.-C. (in press). Multilevel higher-order item response theory models.Educational and Psychological Measurement

.Ip, E. H. (2010). Empirically indistinguishable multidimensional IRT and locally dependent undimensional item response models.British Journal of Mathematical and Statistical Psychology, 63

, 395–416.Jiao, H., Kamata, A., Wang, S., & Jin, Y. (2012). A multilevel testlet model for dual local dependence.Journal of Educational Measurement, 49

(1), 82–100.Keng, L. (2008).A Comparison of the performance of testlet-based computer adaptive tests and multistage tests

(Unpublished doctorial dissertation). The University of Texas at Austin.Linacre, J. M. (1989).Many-facet Rasch measurement

. Chicago:Measurement, Evaluation, Statistics, and Assessment Press.Li, Y., Bolt, D. M., & Fu, J. (2006). A comparison of alternative models for testlets.Applied Psychological Measurement, 30

(1), 3–21.Li, Y., Bolt, D. M., & Fu, J. (2005). A test characteristic curve linking method for the testlet model.Applied Psychological Measurement, 29

(5), 340–356.Liu, Y., & Liu, H.-Y. (2012). When should we use testlet model? A comparison study of bayesian testlet randomeffects model and standard 2-PL bayesian model.Acta Psychologica Sinica, 44

(2), 263−275.[刘玥, 刘红云. (2012). 贝叶斯题组随机效应模型的必要性及影响因素.心理学报, 44

(2), 263–275.]Li, Y., Li,S., & Wang, L. (2010).Application of a general polytomas testlet model to the reading section of a large-scale English language assessment

(ETS Report RR-10-21). Princeton, NJ: Educational Testing Service.Muraki, E. (1992). A generalized partial credit model:Application of an EM algorithm.Applied Psychological Measurement, 16

(2), 159–176.Masters, G. N. (1982). A rasch model for partial credit scoring.Psychometrika, 47

(2), 149–174.Marais, I., & Andrich, D. (2008). Formalizing dimension and response violations of local independence in the unidimensional Rasch model.Journal of Applied Measurement,9

(3), 200–15.Mislevy, R. J., Beaton, A. E., Kaplan, B., & Sheehan, K. M.(1992). Estimating population characteristics from sparse matrix samples of item responses.Journal of Educational Measurement, 29

, 133–161.Murphy, D. L., Dodd, B. G., & Vaughn, B. K. (2010). A comparison of item selection techniques for testlets.Applied Psychological Measurement, 34

(6), 424–437.Muthén, L. K., & Muthén, B. O. (2012).Mplus user’s guide

(7th ed.). Los Angeles, CA: Muthén and Muthén.Rosenbaum, P. R. (1988). Item bundles.Psychometrika, 53

(3),349–359.Rijmen, F. (2009).Three multidimensional models for testlet-based tests: Formal relations and an empirical comparison.

(ETS Report RR-09-37). Princeton, NJ:Educational Testing Service.Samejima, F. (1969). Estimation of latent ability using a response pattern of graded scores.Psychometrika Monograph Supplement, 17

, 1–100.Spiegelhalter, D. J., Thomas, A., & Best, N. (2003). WinBUGS version 1.4 [Computer Program]. Cambridge, UK: MRC Biostatistics Unit, Institute of Public Health.

Sireci, S. G., Thissen, D., & Wainer, H. (1991). On the reliability of testlet-based tests.Journal of Educational Measurement, 28

(3), 237–247.van der Linden, W. J., Klein Entink, R. H., & Fox, J.-P. (2010).IRT parameter estimation with response times as collateral information.Applied Psychological Measurement, 34

,327–347.Wainer, H. (1995). Precision and differential item functioning on a testlet-based test: The 1991 Law School Admissions Test as an example.Applied Measurement in Education,8

(2), 157–186.Wang, W.-C. (2004). Rasch measurement theory and application in education and psychology.Journal of Education & Psychology, 27

(4), 637–694.[王文中. (2004). Rasch測量理論與其在教育和心理之應用.教育與心理研究, 27

(4), 637–694.]Wilson, M., & Adams, R. J. (1995). Rasch models for item bundles.Psychometrika, 60

, 181–198.Wainer, H., & Kiely, G. (1987). Item clusters and computerized adaptive testing: A case for testlets.Journal of Educational Measurement,24

(3), 185–202.Wang, W.-C., & Wilson, M. (2005a). Assessment of differential item functioning in testlet-based items using the Rasch testlet model.Educational and Psychological Measurement,65

(4), 549–576.Wang, W.-C., & Wilson, M. (2005b). Exploring local item dependence using a random-effects facet model.Applied Psychological Measurement, 29

(4), 296–318.Wang, W.-C., & Wilson, M. (2005c). The rasch testlet model.Applied Psychological Measurement,29

(2), 126–149.Wang, W.-C., & Wu, S-L. (2011). The random-effect generalized rating scale model.Journal of Educational Measurement,48

, 441-456.Wainer, H., & Wang, X. (2000). Using a new statistical model for testlets to score TOEFL.Journal of Educational Measurement, 37

(3), 203–220.Wu, M. L., Adams, R. J., Wilson, M., & Heldane, S. A. (2007).ACER ConQuest: Generalized item response modeling software (Version 2.0) [computer software]. Melbourne:Australian Council for Educational Research.

Wainer, H., Bradlow, E. T., & Du, Z. (2000). Test-let response theory: An analog for the 3PL model using in testlet-based adaptive testing. In W. van der Linden & C. A. W. Glas(Eds.),Computerized adaptive testing: Theory and practice

(pp. 245–269). London: Kluwer.Wang, X., Bradlow, E. T., & Wainer, H. (2002). A general Bayesian model for testlets: Theory and applications.Applied Psychological Measurement, 26

(1), 109–128.Wainer, H., Bradlow, E. T., & Wang, X. (2007).testlet response theory and its applications

. New York, NY:Cambridge University Press.Wu, R., Ding, S.-L., & Gan, W.-D. (2010). Test equating with testlets.Acta Psychologica Sinica, 42

(3), 434−442.[吴锐, 丁树良, 甘登文. (2010). 含题组的测验等值.心理学报,42

(3), 434–442.]Wang, W.-C., Jin, K.-Y., Qiu, X.-L., & Wang, L. (2012). Item response models for examinee-selected items.Journal ofEducational Measurement, 49

(4), 419–445.Wang, W.-C., Wilson, M., & Adams, R. J. (1997). Rasch models for multidimensionality between items and within items.Objective Measurement: Theory Into Practice, 4

,139–155.Yao, L. (2003). BMIRT: Bayesian multivariate item response theory [Computer software]. Monterey, CA: CTB/McGraw-Hill.

Yen, W. M. (1993). Scaling performance assessment:Strategies for managing local item dependence.Journal of Educational Measurement, 30

(3), 187–213.Yan, Z. (2012). Objective measurement in psychological science: An overview of rasch model.Advances in Psychological Science, 18

(8), 1298–1305.[晏子. (2010). 心理科学领域内的客观测量—— Rasch模型之特点及发展趋势.心理科学进展, 18

(8), 1298–1305.]Zheng, C.-J., Guo, C.-Y., & Bian, Y.-F. (2011). Using testlet DIF procedures to detect testlet DIF in Chinese passage-based reading testing.Acta Psychologica Sinica,43

(7), 830−835.[郑蝉金, 郭聪颖, 边玉芳. (2011). 变通的题组项目功能差异检验方法在篇章阅读测验中的应用.心理学报, 43

(7),830–835.]Zhan, P.-D., Wang, W.-C., & Wang, L.-J. (2013). Testlet response theory: An introduction and new developments.Advances in Psychological Science, 21

(12), 2265−2280.[詹沛达, 王文中, 王立君. (2013). 项目反应理论新进展之题组反应理论.心理科学进展, 21

(12), 2265−2280.]